作为每天和 VSCode 朝夕相处的开发者,代码补全、文档查询、bug 调试是日常工作的核心环节,但传统开发模式中,这些操作往往伴随着频繁切屏、网络延迟或隐私泄露风险。直到用 OpenStation 部署本地大模型并集成到 VSCode 后,才发现开发效率能实现质的飞跃 ------ 既保留了 VSCode 的轻量化体验,又获得了专属本地大模型的智能辅助能力。

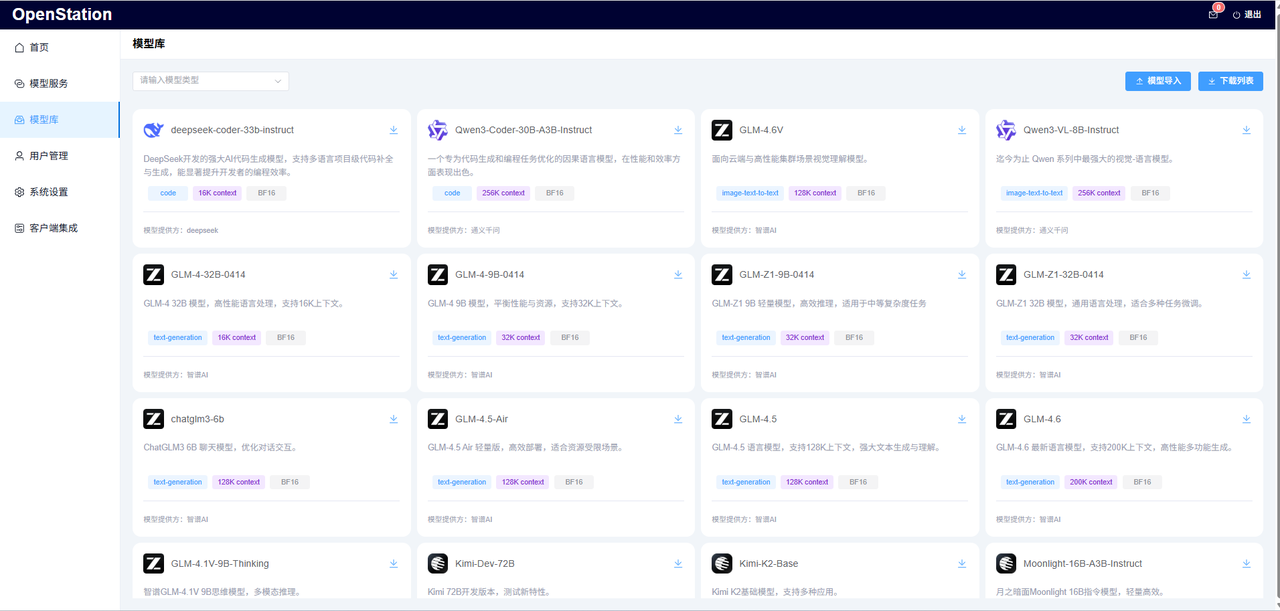

1. 模型选择环节,OpenStation 的模型库完全覆盖了开发场景的需求

常用的 Qwen3 系列,从 0.6B 到 80B 参数量应有尽有,小参数量模型适合实时代码补全,大参数量模型则能处理复杂逻辑优化;DeepSeek-V3 在代码生成场景表现尤为突出,用它辅助编写算法模块时,逻辑完整性和语法准确性都远超通用模型;而 ZhipuAI 的 GLM4 系列,多轮对话上下文保持能力强,查询技术文档或行业术语时,输出精准度很高。所有模型支持断点续传下载,下载后自动完成平台适配,无需手动配置依赖环境。

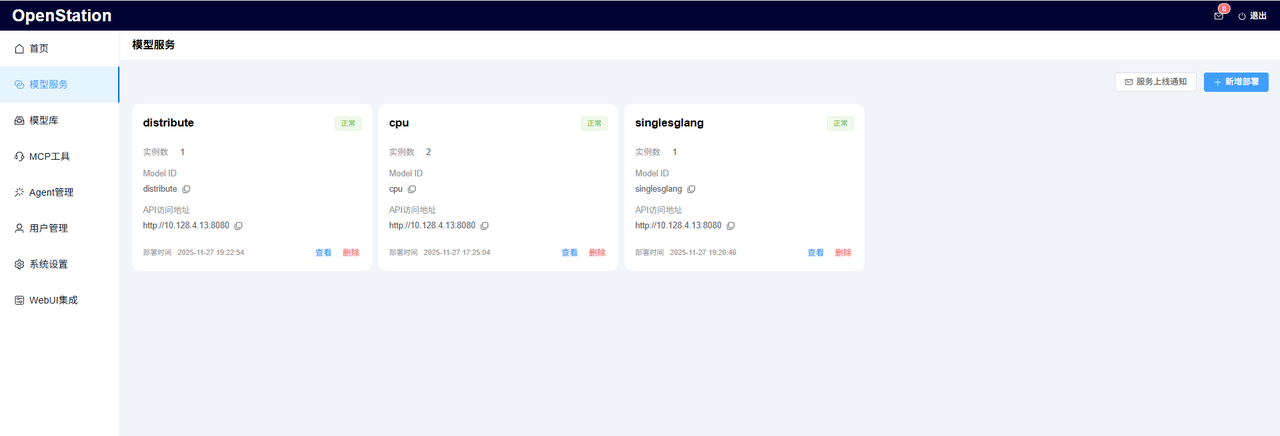

2. 部署模式的多样性让不同开发场景都能找到适配方案

- 日常编码辅助时,可以选择 Single 单机部署模式,推理引擎选用 SGLang(GPU),启动速度快且推理延迟低,代码补全几乎秒响应;

- 开发团队协作项目时,可以采用 Distributed 分布式部署,跨多个节点部署大参数量模型,平台自动实现负载均衡,确保多开发者同时调用时的稳定性;

- 在无 GPU 的测试服务器上,CPU-Only 部署模式就能满足需求,虽然推理速度稍慢,但足够支撑简单的代码检查和逻辑验证。

3. 节点选择的灵活性进一步提升了资源利用率

- 单机部署时,可精确选择节点中的某一张加速卡,剩余资源可正常处理其他开发任务;

- 分布式部署时,支持跨节点选择不同节点的加速卡,平台自动完成张量并行部署,无需手动编写分布式脚本;

- CPU 部署则更灵活,任意节点只需满足基础硬件要求,就能快速启动服务,适合临时测试场景。

4. 部署后管理简洁高效

服务上线后,OpenStation 界面会清晰展示实例状态、Model ID、API 访问地址和部署时间,比如我部署的 Qwen3-1.7B 实例,API 地址为http://10.128.4.13:8080,Model ID 为 qwenD。运维过程中,可随时查看实例运行状态,支持一键删除无用实例,避免资源占用。遇到问题时,通过平台提供的日志功能,能快速定位 GPU 驱动、推理引擎等环节的故障,无需登录服务器排查。

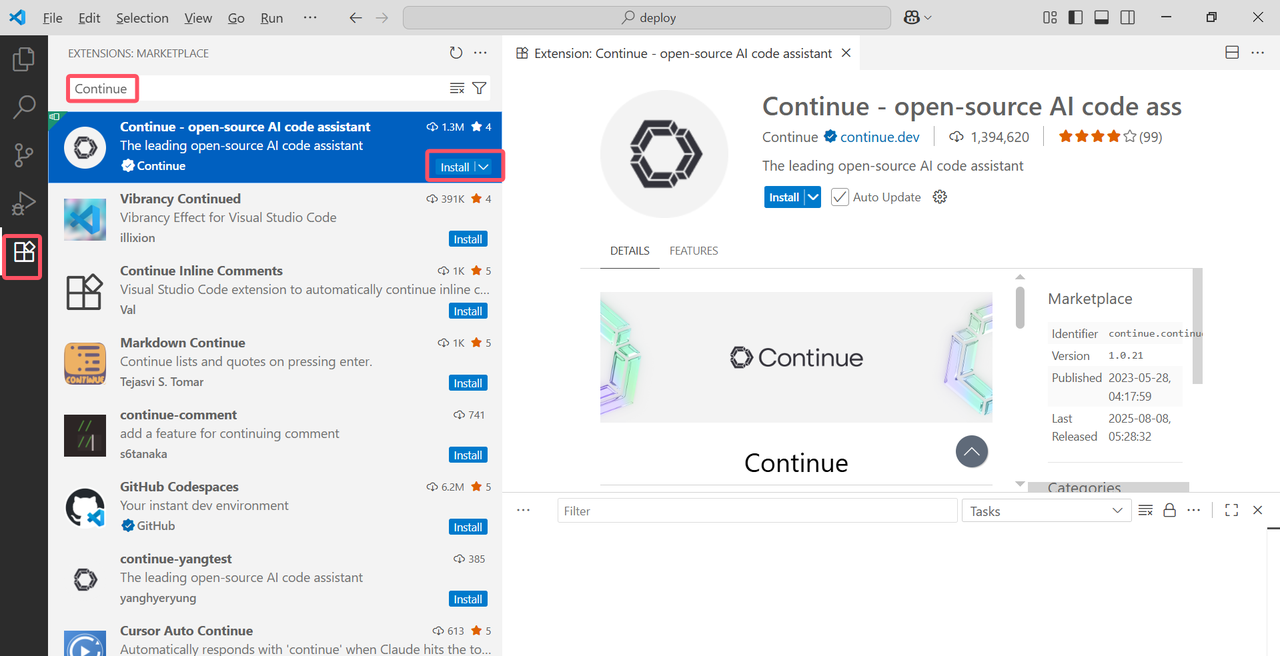

5. 对接VS Code客户端

有了模型服务,接下来要让 VSCode 能调用它。试了几个插件,最终选了 Continue(开源、轻量、支持自定义模型 API),配置步骤比想象中简单:

- 安装插件:在 VSCode 的扩展商店搜索 "Continue",点击安装。

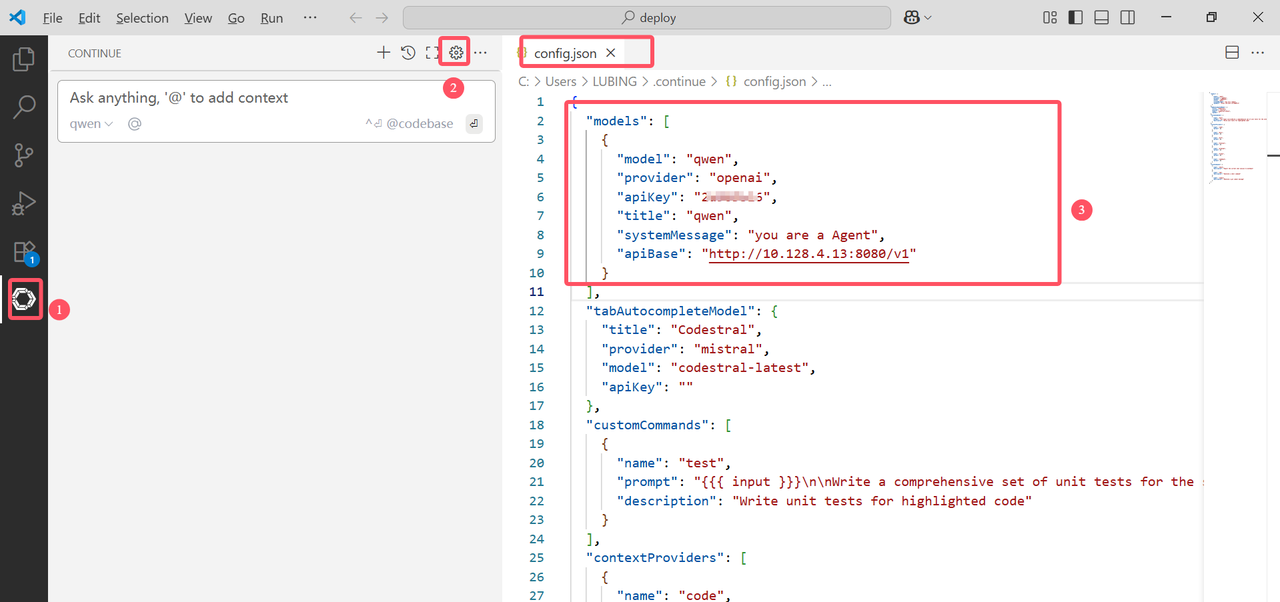

- 配置模型连接:按照图中顺序依次点击图标,会打开config.json配置文件。重点改以下红色框中的几个字段(参考OpenStation平台中模型服务信息进行修改):

6. OpenStation 快速部署指南

项目地址 :https://github.com/fastaistack/OpenStation

-

在线安装(支持Ubuntu22.04 / 20.04 / 18.04系列及Centos7系列)

curl -O https://fastaistack.oss-cn-beijing.aliyuncs.com/openstation/openstation-install-online.sh

#其中,--version latest 表示安装OpenStation平台的最新版本,如果选择安装历史版本,可以传入历史版本号,比如--version 0.6.7)

bash openstation-install-online.sh --version latest

也可直接下载在线安装包(openstation-pkg-online-latest.tar.gz),上传至Linux服务器后执行:

tar -xvzf openstation-pkg-online-latest.tar.gz

cd openstation-pkg-online-latest/deploy

bash install.sh true- 离线安装(仅支持Ubuntu 22.04.2/20.04.6/18.04.6)

点击「离线 OpenStation 安装包下载 」,参考上述**OpenStation项目地址**中离线安装文档。

部署完成后,登录页面如下:

7. 总结

OpenStation 与 VSCode 的协同,本质是将本地大模型的智能能力无缝融入编码全流程。OpenStation 解决了本地大模型 "部署难、管理繁" 的技术痛点,提供了灵活的部署模式和丰富的模型生态;Continue 插件则搭建了大模型与 VSCode 的沟通桥梁,实现了 "编辑 - 辅助 - 调试" 的闭环。对于开发者而言,这种组合既保证了代码的隐私安全,又显著提升了编码效率,让我们能从重复劳动中解放出来,聚焦于核心逻辑设计和架构优化,是 AI 时代提升开发效率的必备方案。