本文档为伪分布式大数据环境(1台虚拟机:hadoop)中Hive组件的功能测试教程,涵盖Hive依赖服务启停、服务状态验证、Hive CLI及Beeline连接测试、核心SQL功能验证等核心场景。严格遵循视频操作流程,详细说明每个步骤的操作要点、执行命令及预期结果,助力高效完成Hive组件可用性及数据查询分析功能验证。

一、前期准备:环境基础信息

测试前需确认环境配置符合要求,避免因基础环境问题导致测试流程中断:

- 虚拟机配置:1台虚拟机(命名为hadoop),已完成伪分布式部署

- 系统账号:优先使用hertz账号(密码:hertz);特殊操作需使用root账号(密码:1)

- 工具准备:Mobaxterm远程连接工具(已安装并可正常使用)

二、Hive测试详细步骤

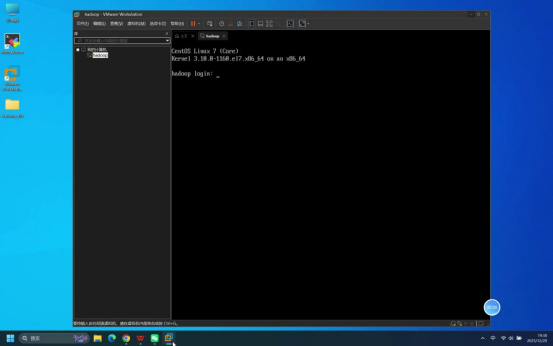

步骤1:确认虚拟机启动状态

操作说明:启动虚拟机,等待系统加载完成,直至出现登录页面。

预期结果:虚拟机正常启动,显示系统登录界面,无启动报错。

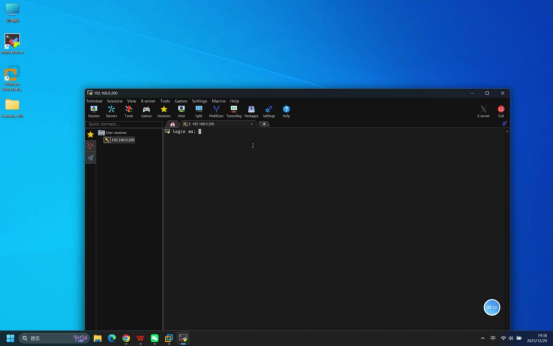

步骤2:使用Mobaxterm连接虚拟机

操作说明:打开本地Mobaxterm工具,按照伪分布式部署教程中的详细步骤建立与虚拟机的远程连接。

核心操作要点:

- 新建远程连接,选择SSH连接方式

- 输入虚拟机IP地址(需提前确认正确)

- 选择登录账号类型(默认为普通用户)

预期结果:Mobaxterm连接成功,进入连接等待登录状态。

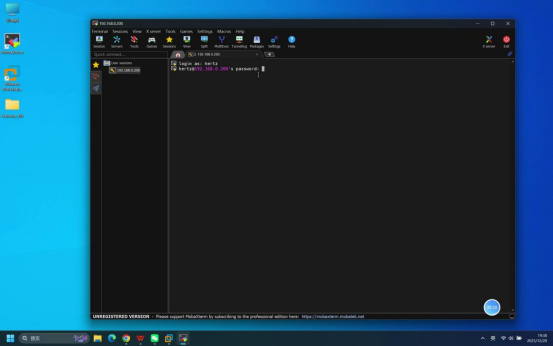

步骤3:输入账号密码完成登录

操作说明:在Mobaxterm连接成功后的登录界面,依次完成账号和密码输入。

具体操作:

- 当终端显示账号输入提示时,输入:hertz

- 回车后,终端显示密码输入提示,输入:hertz(密码输入时默认不显示明文)

- 再次回车确认

预期结果:登录成功,终端界面显示当前登录用户及主机信息(如[hertz@hadoop ~]$)。

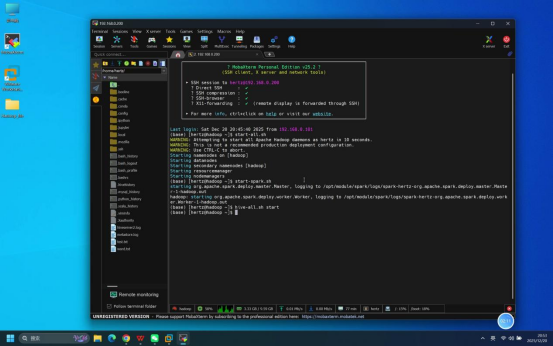

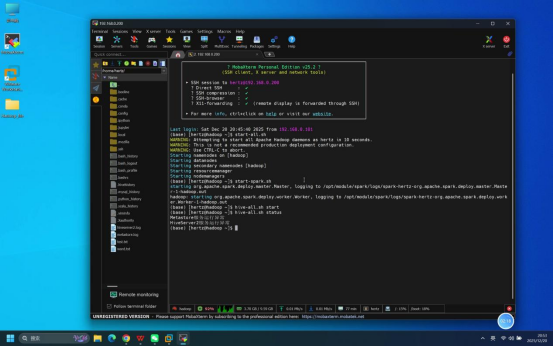

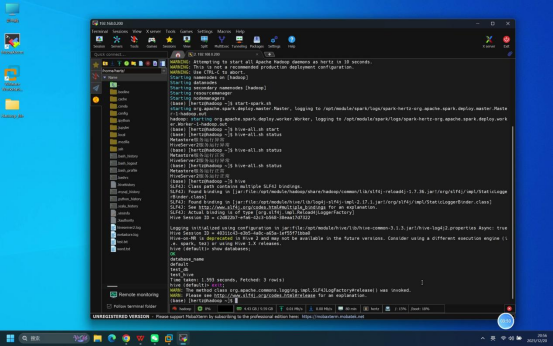

步骤4:启动Hive相关服务

操作说明:在登录成功的Mobaxterm终端中,按依赖顺序启动相关服务(先启动基础依赖服务,再启动Hive服务)。

具体命令:

- 启动Hadoop服务:start-all.sh

- 启动Spark服务:start-spark.sh

- 启动Hive服务:hive-all.sh start(一键启动Hive metastore和HiveServer2服务)

说明:启动过程中若出现权限提示,直接回车确认即可;需等待前一个服务启动完成(无报错)后,再执行下一个启动命令。

预期结果:所有服务启动无报错,终端依次显示各服务的启动日志信息。

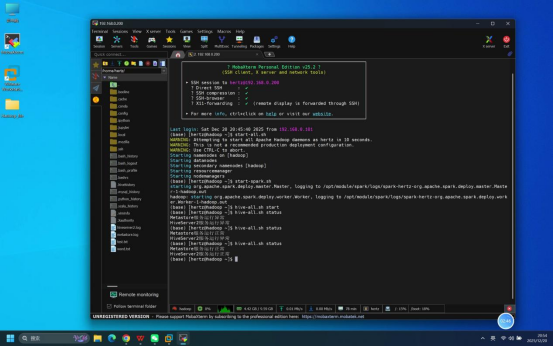

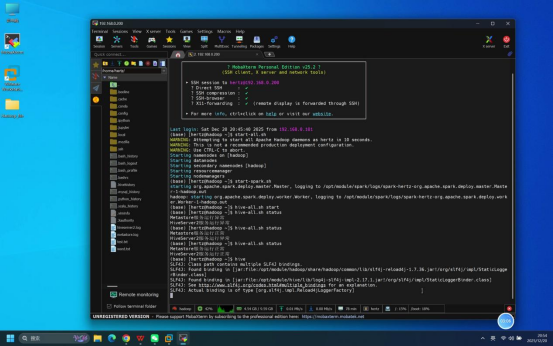

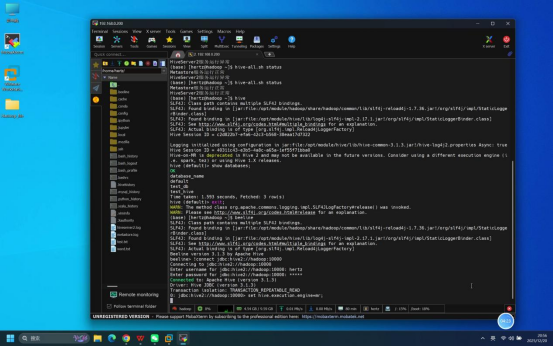

步骤5:验证Hive服务状态

操作说明:在终端中执行Hive服务状态查询命令,观察服务启动后的状态变化(首次查询可能异常,等待片刻后再次查询)。

具体操作:

- 第一次查询:输入命令:hive-all.sh status

- 等待片刻(约30秒-1分钟,让服务完成初始化)

- 第二次查询:再次输入命令:hive-all.sh status

预期结果:

- 第一次查询:终端显示metastore、hiveserver2服务状态为异常(未完全初始化完成)

- 第二次查询:终端显示metastore、hiveserver2服务状态为正常(运行中),无异常提示。

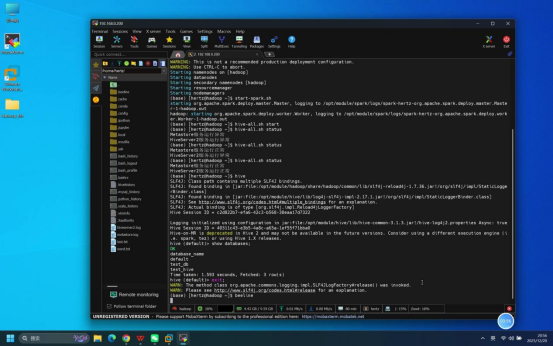

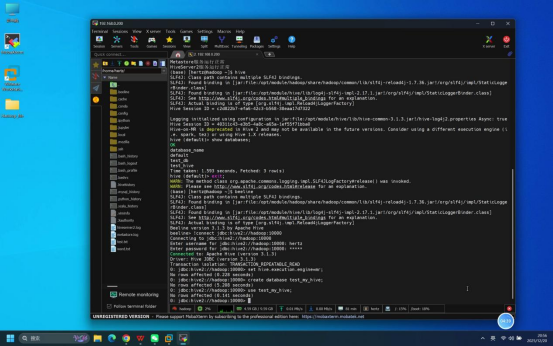

步骤6:Hive CLI连接及基础操作

操作说明:通过Hive CLI(命令行界面)连接Hive,执行基础命令验证连接可用性。

具体操作:

- 启动Hive CLI:在终端输入命令:hive

- 查询数据库:进入CLI后,输入命令:show databases;

- 退出Hive CLI:输入命令:exit;

预期结果:

- hive命令执行无报错,成功进入Hive CLI环境,终端显示"hive> "提示符

- 执行show databases;命令后,正常显示Hive中的数据库列表(默认包含default数据库)

- 执行exit;命令后,正常退出Hive CLI,返回终端默认交互界面。

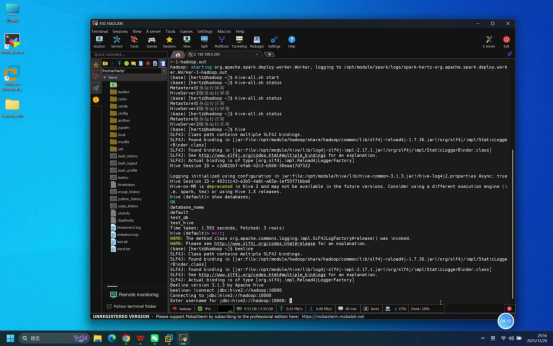

步骤7:Beeline连接HiveServer2

操作说明:通过Beeline工具连接HiveServer2服务,建立JDBC连接。

具体操作:

- 启动Beeline:在终端输入命令:beeline

- 建立JDBC连接:进入Beeline后,输入命令:!connect jdbc:hive2://hadoop:10000

- 输入账号密码:按提示输入登录账号(hertz)和密码(hertz),回车确认

预期结果:

- beeline命令执行无报错,进入Beeline交互环境,显示"beeline> "提示符

- JDBC连接建立成功,无连接超时或拒绝连接错误,终端显示连接成功提示信息。

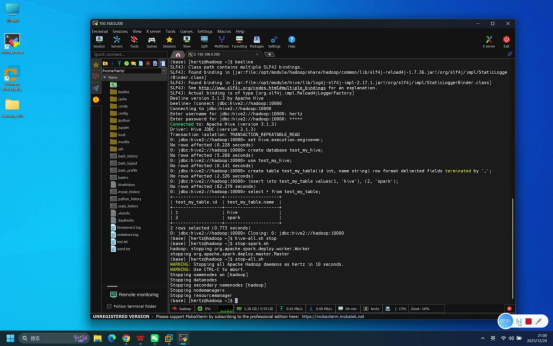

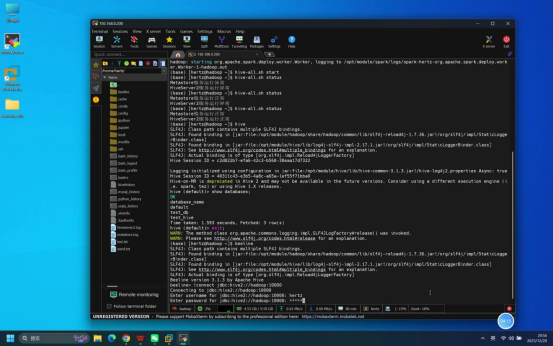

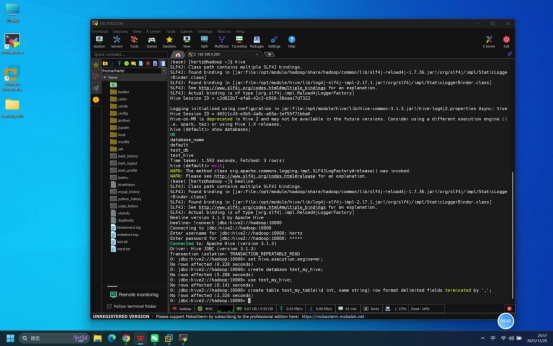

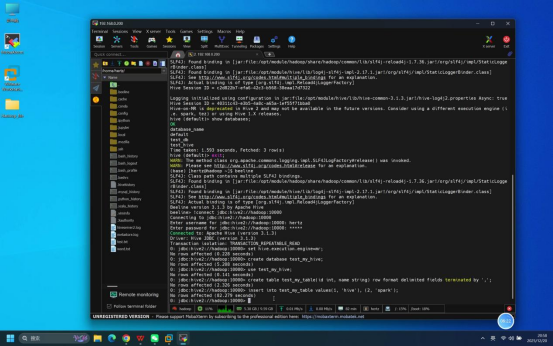

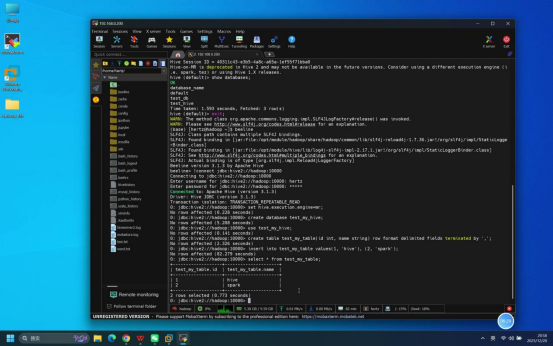

步骤8:SQL功能验证

操作说明:在Beeline连接成功后,执行SQL命令,验证Hive的核心数据操作功能。

参考SQL操作:

- Hive执行引擎设置:set hive.execution.engine=mr;

- 创建数据库:create database test_my_hive;

- 使用数据库:use test_my_hive;

- 创建数据表:create table test_my_table(id int, name string) row format delimited fields terminated by ',';

- 插入测试数据:insert into test_my_table values(1, 'hive'), (2, 'spark');

- 查询数据:select * from test_my_table;

预期结果:所有SQL命令执行无报错,执行查询命令后能正常返回对应结果,数据插入、查询等功能正常。

步骤9:关闭Hive相关服务

操作说明:测试完成后,在终端中按与启动相反的顺序关闭所有相关服务,避免资源占用或数据损坏。

具体命令:

- 关闭Hive服务:hive-all.sh stop(一键关闭Hive metastore和HiveServer2服务)

- 关闭Spark服务:stop-spark.sh

- 关闭Hadoop服务:stop-all.sh

预期结果:所有服务均正常关闭,无报错提示。