周末帮朋友部署一套 AI 应用,他要用 Dify 搭工作流,接 DeepSeek 做推理。我说两天够吗?他说上次自己搞花了整整一周。

结果从开始到跑通,我看了下表,14 分 37 秒。

传统部署为什么慢

先说说那"两天"是怎么消耗的。

Dify 本身依赖不少:PostgreSQL、Redis、Weaviate 向量库,还有一堆微服务。官方给了 Docker Compose,但真跑起来,光是调 YAML 里的环境变量就得半天。网络不通排查两小时,证书问题再来两小时,存储挂载出幺蛾子又是一晚上。

这还没算 DeepSeek 的 API 对接,以及后续的域名、HTTPS、负载均衡。

本质上,你不是在部署一个应用,你是在从零搭一个小型基础设施。

15 分钟发生了什么

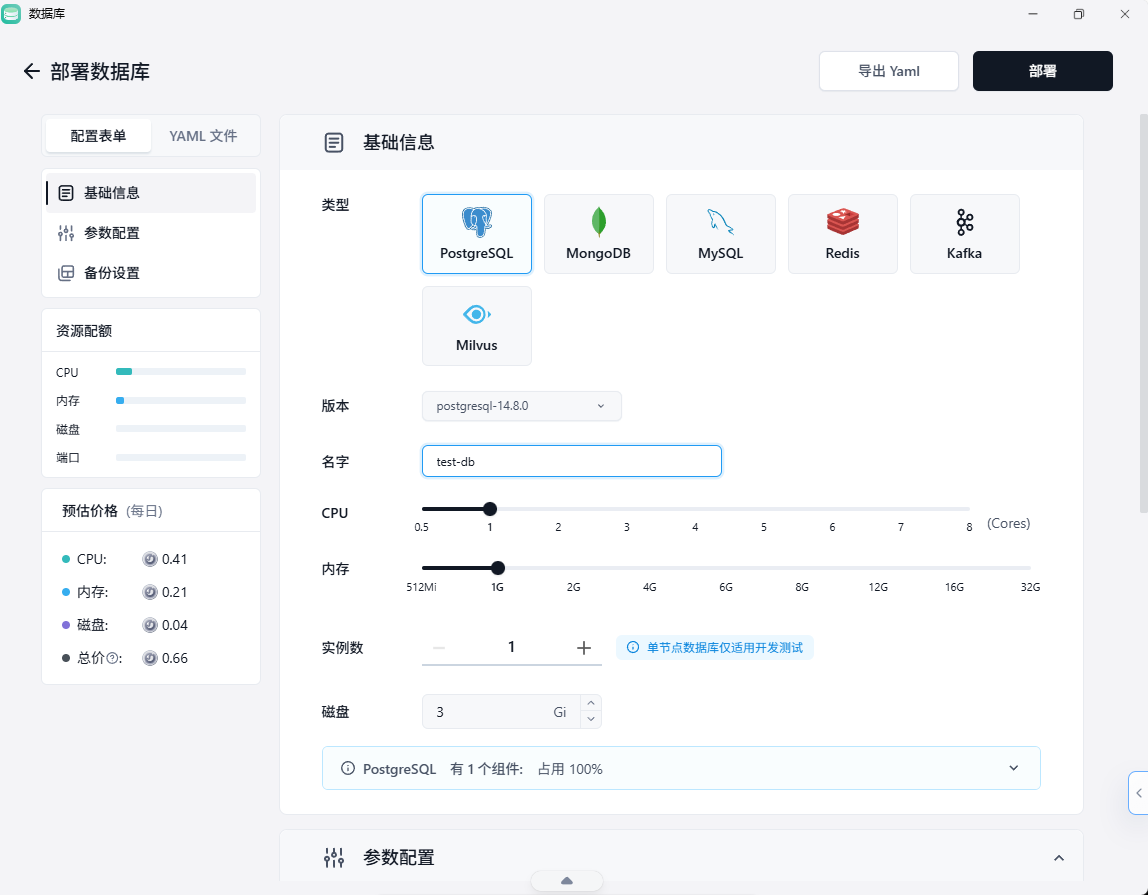

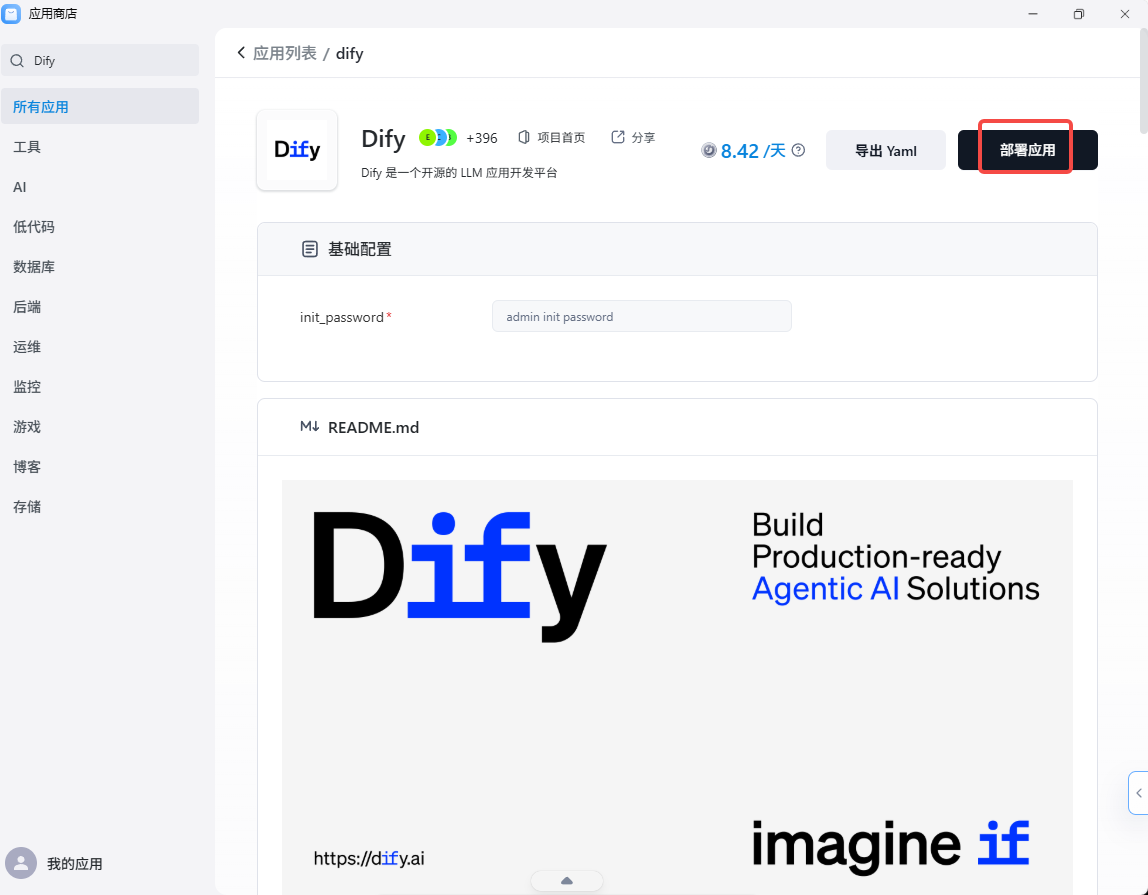

在 Sealos 应用商店点开 Dify,填了两个参数:实例规格和存储大小。点击部署。

系统自动做的事:拉镜像、创建数据库实例、配置网络策略、分配公网域名、挂 HTTPS 证书。

三分钟后,Dify 控制台可以访问了。

进去之后,在模型供应商里选 DeepSeek,粘贴 API Key,保存。又花了两分钟测试一条工作流。

剩下十分钟,我在喝咖啡。

这说明什么

这不是 Sealos 有多神奇,而是 "应用即声明" 这种范式终于成熟了。

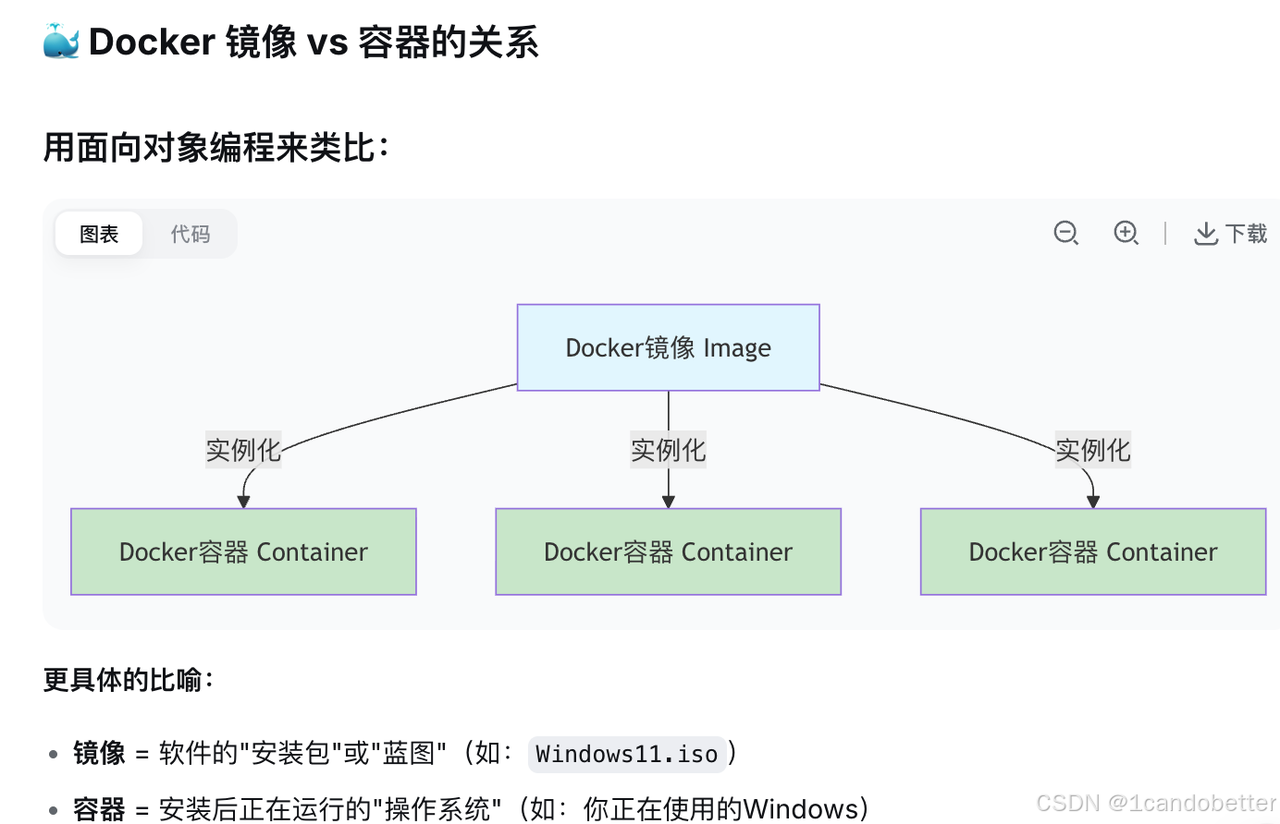

过去十年,我们一直在"写脚本"和"点界面"之间来回切换。Kubernetes 把基础设施变成了声明式,但学习曲线劝退了大多数人。

现在的趋势是,有人把 K8s 的复杂性藏到后面,只把"你需要什么"这一层留给用户。数据库要多大、应用几个副本、域名叫什么------填完这些,下面的编排、调度、运维全自动。

Dify + DeepSeek 这套组合之所以能 15 分钟跑通,不是因为我技术好,是因为那些本该由 YAML 和终端命令完成的工作,被提前封装好了。

一个现实的考量

有人会问:封装层越厚,是不是越不可控?

合理的担忧。但我的判断是:对 80% 的场景,封装带来的效率提升远大于灵活性损失。剩下 20% 真正需要定制的,底层能力也没被阉割------Sealos 终归还是 Kubernetes,想摸到 Pod 级别随时可以。

这和"用框架还是手写"是同一个问题。大多数时候,你要的是快速出结果,而不是证明自己能从零造轮子。

朋友后来问我:你那 14 分钟,最大的瓶颈是什么?

我说,是等镜像拉下来那两分钟。其他时间,主要在等 DNS 生效。

他沉默了一会儿,说上周他光排查 Docker 网络就排查到凌晨三点。