文章目录

- 前言

-

- 一、OpenResty与Nginx的关系

- 二、核心升级点:OpenResty对Nginx的7大关键增强

-

- [1. 编程能力升级:从"静态配置"到"动态脚本驱动"](#1. 编程能力升级:从“静态配置”到“动态脚本驱动”)

- [2. 性能优化:LuaJIT加持,接近C语言性能](#2. 性能优化:LuaJIT加持,接近C语言性能)

- [3. 中间件交互:从"间接代理"到"直连协同"](#3. 中间件交互:从“间接代理”到“直连协同”)

- [4. 扩展能力:从"C模块依赖"到"生态化插件"](#4. 扩展能力:从“C模块依赖”到“生态化插件”)

- [5. 配置动态化:从"重启生效"到"热更新"](#5. 配置动态化:从“重启生效”到“热更新”)

- [6. 业务处理能力:从"请求转发"到"全流程管控"](#6. 业务处理能力:从“请求转发”到“全流程管控”)

- [7. 资源利用率:从"单角色"到"多职责集成"](#7. 资源利用率:从“单角色”到“多职责集成”)

- 三、典型使用场景:OpenResty的核心价值落地

-

- [1. API网关(最核心场景)](#1. API网关(最核心场景))

- [2. Web应用防火墙(WAF)](#2. Web应用防火墙(WAF))

- [3. 边缘计算与数据预处理](#3. 边缘计算与数据预处理)

- [4. 轻量级微服务与接口开发](#4. 轻量级微服务与接口开发)

- [5. 流量管控与限流熔断](#5. 流量管控与限流熔断)

- 四、场景选择指南:何时用Nginx,何时用OpenResty?

- 五、总结:OpenResty的核心价值

前言

在高并发、低延迟的互联网架构中,Nginx早已成为静态资源托管、反向代理的基础设施标配。但随着业务场景的复杂化,传统Nginx的静态配置、扩展依赖C模块等局限性逐渐凸显。OpenResty的出现,并非对Nginx的颠覆,而是以"Nginx+LuaJIT"为核心的深度扩展,将一款高性能服务器升级为全功能的动态应用平台。本文将从底层架构、核心升级点、典型使用场景三个维度,带你彻底读懂OpenResty与Nginx的差异,以及何时该选择这款"增强版Nginx"。

一、OpenResty与Nginx的关系

很多人误以为OpenResty是Nginx的"分叉版",实则不然。根据OpenResty官方定义,它是一个基于Nginx核心构建的"动态Web平台",集成了增强版Nginx内核、LuaJIT(高性能Lua编译器)、数十个精心优化的Lua库及第三方Nginx模块。核心关系可总结为三点:

-

基础同源:完全复用Nginx的事件驱动模型、反向代理、负载均衡等核心能力,兼容所有Nginx配置文件(如nginx.conf),迁移成本几乎为零;

-

扩展增强:并非修改Nginx核心代码,而是通过嵌入Lua脚本引擎,为Nginx新增动态业务处理能力;

-

生态集成:将常用的Nginx第三方模块(如ngx_http_rewrite_module)、Lua库(如redis/mysql客户端)打包集成,开箱即用,无需手动编译。

简单来说:OpenResty = Nginx + LuaJIT + 生态库,是Nginx的"超集"而非"替代品"。

二、核心升级点:OpenResty对Nginx的7大关键增强

传统Nginx的核心优势是"快"和"稳",但短板也很明显:业务逻辑处理依赖外部服务、扩展需编写C模块(开发门槛高、编译繁琐)、配置静态化(修改后需重启服务)。OpenResty的升级核心,就是围绕"动态化""低门槛扩展""全链路协同"三大目标,实现了7个维度的关键增强。

1. 编程能力升级:从"静态配置"到"动态脚本驱动"

这是OpenResty最核心的升级。Nginx仅支持通过C模块扩展业务逻辑,开发人员需掌握C语言、Nginx内核原理,且模块编译后需重启服务才能生效;而OpenResty原生支持Lua脚本,可在Nginx请求处理的全流程嵌入自定义逻辑,无需重启服务即可热更新。

具体来说,OpenResty将Nginx的请求处理流程拆解为11个阶段(如rewrite、access、content、log等),开发者可通过xxx_by_lua_block指令在任意阶段插入Lua代码。示例如下(实现简单的接口鉴权):

nginx

location /api/user {

# 访问阶段执行鉴权逻辑

access_by_lua_block {

local token = ngx.req.get_headers()["Authorization"]

if not token or token ~= "valid_token" then

ngx.exit(403) -- 鉴权失败返回403

end

}

# 内容阶段返回数据

content_by_lua_block {

ngx.say('{"code":200,"msg":"success"}')

}

}这种方式的优势的是:开发效率提升10倍以上(Lua语法简洁,无需编译)、逻辑动态更新(修改Lua脚本后立即生效)、低侵入性(不修改Nginx核心)。

2. 性能优化:LuaJIT加持,接近C语言性能

很多人担心嵌入脚本会降低性能,但OpenResty选择的LuaJIT(Lua的即时编译器)彻底解决了这个问题。OpenResty维护的LuaJIT 2分支,通过JIT编译将热点Lua代码直接转换为机器码,性能接近纯C实现,甚至在部分场景下超越标准LuaJIT。

3. 中间件交互:从"间接代理"到"直连协同"

传统Nginx无法直接操作数据库、缓存等中间件,如需实现"查询缓存返回数据"的逻辑,必须通过反向代理转发到后端服务(如Java/Python接口),增加了网络开销和架构复杂度。

OpenResty通过内置的Lua库(如lua-resty-redis、lua-resty-mysql、lua-resty-kafka),支持直接与中间件交互,无需依赖外部服务。示例如下(从Redis查询数据并返回):

nginx

location /api/cache {

content_by_lua_block {

local redis = require "resty.redis"

local red = redis:new()

-- 连接Redis

red:set_timeout(1000) -- 超时1ms

local ok, err = red:connect("127.0.0.1", 6379)

if not ok then

ngx.say("连接Redis失败: ", err)

return

end

-- 查询数据

local res, err = red:get("user:1001")

if res then

ngx.say('{"code":200,"data":"', res, '"}')

else

ngx.say('{"code":404,"msg":"数据不存在"}')

end

}

}这种直连方式的优势是:减少网络跳转(降低延迟20-50%)、简化架构(无需额外后端服务)、支持非阻塞I/O(继承Nginx事件模型,不会因中间件交互阻塞进程)。

4. 扩展能力:从"C模块依赖"到"生态化插件"

Nginx的扩展依赖C模块开发,不仅门槛高,还存在版本兼容问题(新Nginx版本可能不兼容旧模块)。OpenResty构建了完整的Lua生态,提供了数十个开箱即用的扩展库,覆盖缓存、安全、序列化、加密等常见场景,开发者可通过Lua脚本快速实现扩展,无需编写一行C代码。

核心扩展库包括:

-

数据交互类:lua-resty-redis(Redis客户端)、lua-resty-mysql(MySQL客户端)、lua-resty-kafka(Kafka生产者/消费者);

-

安全类:lua-resty-jwt(JWT令牌生成/验证)、lua-resty-string(加密/解密)、lua-resty-waf(Web应用防火墙核心);

-

工具类:lua-resty-json(JSON序列化/反序列化)、lua-resty-cookie(Cookie操作)、lua-resty-rate-limit(限流工具)。

此外,OpenResty还支持自定义Lua模块开发,可将通用逻辑封装为模块复用,进一步降低开发成本。

5. 配置动态化:从"重启生效"到"热更新"

传统Nginx的配置修改后,必须通过nginx -s reload重启服务才能生效,虽然reload是平滑重启(不中断现有连接),但在高并发场景下仍可能导致短暂的请求波动。OpenResty支持Lua脚本热更新,修改Lua代码后无需重启服务,立即生效,完全不影响现有连接。

动态配置的典型场景:

-

限流规则调整(如双11期间临时提高某接口限流阈值);

-

路由规则更新(无需重启Nginx即可调整请求转发逻辑);

-

鉴权策略修改(如新增白名单IP)。

6. 业务处理能力:从"请求转发"到"全流程管控"

Nginx的核心定位是"服务器/代理",仅能实现简单的请求转发、静态资源返回,复杂业务逻辑(如数据脱敏、参数校验、响应格式化)必须依赖后端服务。OpenResty可在请求到达后端前、响应返回客户端前的全流程插入业务逻辑,实现"边缘业务处理",减轻后端服务压力。

典型的全流程处理场景:

-

请求入站阶段:参数校验(过滤非法参数)、鉴权(JWT验证/IP白名单)、限流(防止过载);

-

转发阶段:动态路由(根据用户身份转发到不同后端集群)、请求改写(修改请求头/路径);

-

响应出站阶段:数据脱敏(隐藏手机号/身份证号)、响应格式化(统一JSON结构)、缓存存储(将响应结果存入Redis)。

7. 资源利用率:从"单角色"到"多职责集成"

传统架构中,Nginx(代理)、后端服务(业务处理)、缓存客户端(Redis操作)是独立的组件,需要部署多台服务器或进程,资源利用率较低。OpenResty可集成这三大角色的能力,一台服务器即可实现"代理+业务处理+缓存交互",资源利用率提升30-50%,尤其适合边缘节点、轻量级部署场景(如嵌入式设备、小型网关)。

三、典型使用场景:OpenResty的核心价值落地

OpenResty并非"全能替代"Nginx,而是在特定场景下更具优势。以下是其最典型的5大使用场景,结合实际业务案例说明何时选择OpenResty而非原生Nginx。

1. API网关(最核心场景)

API网关是OpenResty最经典的应用场景。在微服务架构中,网关需要承担路由转发、鉴权、限流、监控、日志收集等核心职责,这些需求恰好匹配OpenResty的动态化、高并发、易扩展能力。

相比传统网关(如Spring Cloud Gateway),OpenResty作为网关的优势:

-

性能更高:QPS支持10万+,响应延迟低至1-2ms(传统网关延迟通常在10ms以上);

-

资源占用少:单进程支持数十万并发连接,内存占用仅为Java网关的1/5-1/10;

-

动态配置:路由、限流、鉴权规则可热更新,无需重启网关。

实际案例:阿里云API网关、京东网关(jd-gateway)均基于OpenResty构建,支撑日均数十亿请求的转发处理。

2. Web应用防火墙(WAF)

WAF需要实时拦截恶意请求(如SQL注入、XSS攻击、CC攻击),核心需求是"低延迟""可自定义规则""高并发承载"。传统WAF要么基于硬件(成本高),要么基于软件(延迟高),而OpenResty恰好解决了这两个问题。

OpenResty实现WAF的核心逻辑:

-

通过

access_by_lua_block阶段拦截请求; -

利用lua-resty-waf库解析请求参数、URL、请求体;

-

匹配自定义规则(如SQL注入特征、恶意IP),拦截非法请求。

实际案例:Cloudflare的部分边缘安全防护能力基于OpenResty构建,可在毫秒级拦截恶意请求,支撑全球海量访问。

3. 边缘计算与数据预处理

边缘计算的核心是"在靠近用户的边缘节点处理数据",减少核心服务器压力和网络延迟。OpenResty轻量、高性能的特性,使其成为边缘节点的理想选择,可在边缘完成数据过滤、解析、脱敏、缓存等预处理操作。

典型场景:

-

短视频/直播:在边缘节点解析用户请求,根据用户网络质量动态返回不同清晰度的视频地址,降低核心CDN压力;

-

物联网(IoT):在边缘网关解析设备上报的JSON数据,过滤无效数据后再转发到核心平台,减少传输带宽占用;

-

A/B测试:在边缘节点根据用户ID/设备类型动态转发请求到不同版本的后端服务,无需核心服务参与。

4. 轻量级微服务与接口开发

对于简单的接口需求(如查询缓存数据、返回静态JSON、简单数据聚合),无需部署复杂的Java/Python后端服务,可直接用OpenResty编写Lua脚本实现,开发效率高、部署简单、性能优异。

典型场景:

-

用户信息查询接口(从Redis/MySQL直接获取数据并返回);

-

健康检查接口(自定义逻辑判断后端服务状态);

-

数据聚合接口(从多个缓存/数据库查询数据,聚合后返回)。

5. 流量管控与限流熔断

在高并发场景(如秒杀、双11),需要对接口进行限流、熔断,防止后端服务过载。OpenResty通过lua-resty-rate-limit等库,可轻松实现多种限流策略(如令牌桶、漏桶、固定窗口),且支持动态调整限流阈值。

示例:实现每秒限制100个请求的令牌桶限流:

nginx

location /api/secKill {

access_by_lua_block {

local rate_limit = require "resty.rate_limit"

-- 初始化令牌桶:每秒生成100个令牌,桶容量100

local lim, err = rate_limit.new("secKill_limit", 100, 100)

if not lim then

ngx.exit(500)

end

-- 根据客户端IP限流

local key = ngx.var.remote_addr

local allowed, err = lim:is_allowed(key)

if not allowed then

ngx.exit(429) -- 限流返回429

end

}

content_by_lua_block {

ngx.say('{"code":200,"msg":"秒杀请求受理中"}')

}

}四、场景选择指南:何时用Nginx,何时用OpenResty?

OpenResty虽强,但并非所有场景都需要。以下是两者的适用场景对比,帮你快速决策:

| 场景类型 | 推荐使用Nginx | 推荐使用OpenResty |

|---|---|---|

| 静态资源托管(HTML/CSS/JS/图片) | ✅ 原生支持,性能最优 | ✅ 兼容,但无额外优势 |

| 基础反向代理/负载均衡 | ✅ 配置简单,满足需求 | ✅ 兼容,可扩展动态路由 |

| API网关(动态路由/鉴权/限流) | ❌ 需依赖外部服务,扩展复杂 | ✅ 原生支持,性能优异 |

| 动态业务逻辑处理(参数校验/数据脱敏) | ❌ 需转发到后端服务 | ✅ 边缘处理,降低延迟 |

| WAF/安全防护 | ❌ 扩展能力弱 | ✅ 自定义规则,低延迟 |

| 轻量级接口开发 | ❌ 无法直接操作中间件 | ✅ 快速开发,部署简单 |

核心原则:简单场景用Nginx(足够轻量),复杂动态场景用OpenResty(功能更强)。现有Nginx用户可逐步迁移,无需一次性替换------OpenResty完全兼容Nginx配置,可先在部分场景(如API网关)试点,再全面推广。

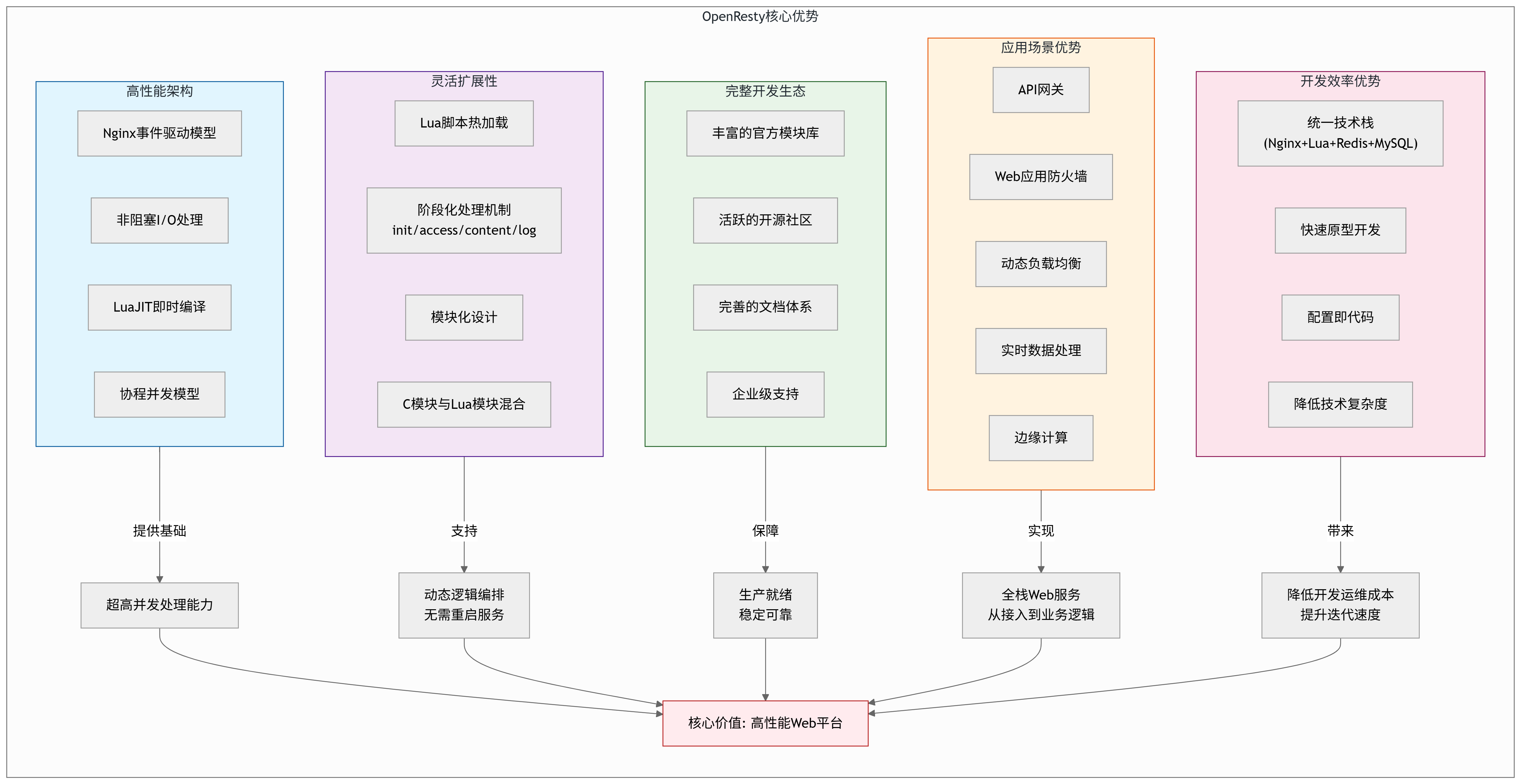

五、总结:OpenResty的核心价值

OpenResty对Nginx的升级,本质上是将一款"高性能服务器"升级为"动态应用平台",其核心价值并非"更快"(虽性能略有提升),而是"更灵活""更强大""更易扩展"。通过LuaJIT的嵌入和生态的构建,OpenResty让Nginx从"被动转发请求"转变为"主动处理业务",成为高并发架构中连接用户与后端服务的核心枢纽。

如果你的业务正面临"动态配置需求""高并发接口压力""复杂网关场景"等问题,那么OpenResty无疑是比原生Nginx更优的选择------它既能复用你已有的Nginx知识和配置,又能快速解锁动态业务处理能力,让架构更简洁、性能更优异。