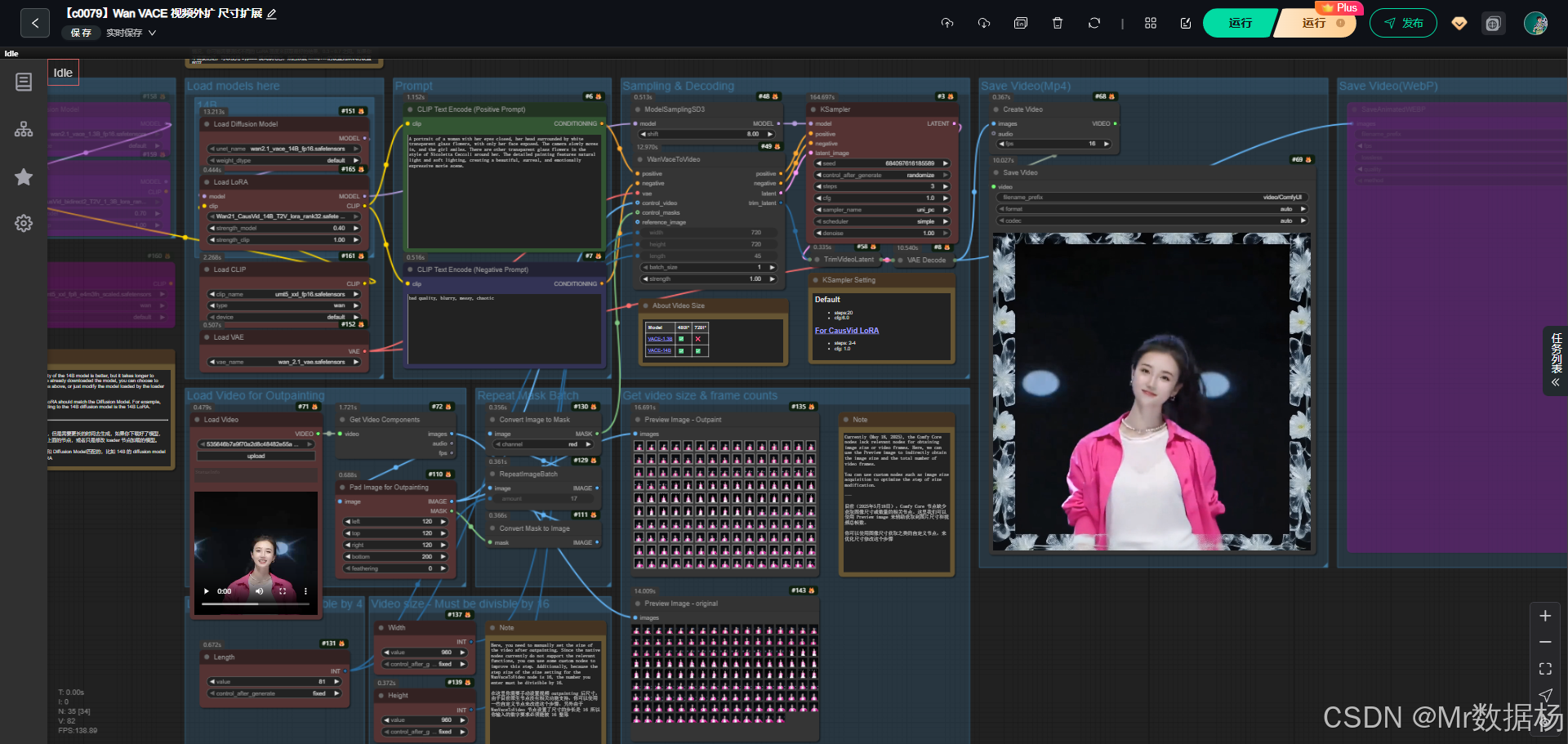

今天给大家演示的是一个基于 Wan2.1 VACE 系列的 ComfyUI 视频生成工作流,整个流程通过加载扩散模型与 LoRA 结合文本提示,生成高质量的视频片段,并支持对输入视频进行扩展与再创作。

在效果层面,这个工作流能够将一段简单的输入视频素材,转化为带有艺术感和电影氛围的动态影像,直观展示了文本到视频的生成能力,同时支持多种分辨率和帧数配置,适合在不同显卡条件下进行实验与创作。

文章目录

- 工作流介绍

- 工作流程

- 大模型应用

-

- [CLIPTextEncode(Positive Prompt) 控制视频主体语义与风格](#CLIPTextEncode(Positive Prompt) 控制视频主体语义与风格)

- [CLIPTextEncode(Negative Prompt) 排除不需要的错误视觉](#CLIPTextEncode(Negative Prompt) 排除不需要的错误视觉)

- 使用方法

- 应用场景

- 开发与应用

工作流介绍

该工作流围绕视频生成与编辑展开,涵盖模型加载、文本编码、采样解码、掩码扩展、尺寸调整以及最终视频导出等环节。整体结构清晰,将文本与视频元素有机结合,用户能够在不同分辨率与时长设定下快速得到期望的视频结果。

核心模型

工作流依托 Wan2.1 系列扩散模型与 VAE、文本编码器配合实现视频生成,其中 14B 版本模型提供更高的画质与分辨率支持,而 1.3B 模型则在速度与硬件占用方面更具优势。搭配 CausVid LoRA,可在保证画面质量的同时大幅度缩短生成时间,从而提升效率与可操作性。

| 模型名称 | 说明 |

|---|---|

| wan2.1_vace_14B_fp16.safetensors | 高精度大模型,支持 480P 与 720P 视频生成,画质更佳,但推理耗时较长 |

| wan2.1_vace_1.3B_fp16.safetensors | 中等规模模型,仅支持 480P,速度快,适合硬件资源有限场景 |

| wan_2.1_vae.safetensors | 负责视频潜空间与图像间的解码与映射,保证输出细节的真实感 |

| umt5_xxl_fp16 / fp8.safetensors | 文本编码器,将输入的提示词转化为可供模型理解的条件信息 |

| Wan21_CausVid LoRA (1.3B/14B) | 针对视频生成加速优化的 LoRA 模型,显著缩短推理时间 |

Node节点

节点的组合设计是工作流的核心,涵盖从输入、处理到输出的完整链路。文本提示经由 CLIP 编码后进入采样器,与扩散模型和 LoRA 协同作用生成视频潜空间数据,随后通过解码器与尺寸控制节点转化为图像序列,最终合成为视频文件。在此过程中,节点不仅完成数据流转,更通过参数设定实现画质、时长、分辨率等可控化调节。

| 节点名称 | 说明 |

|---|---|

| UNETLoader | 加载扩散模型(1.3B 或 14B),为视频生成提供核心推理能力 |

| LoraLoader | 加载对应 LoRA 模型,优化视频生成速度与稳定性 |

| CLIPLoader | 文本编码器加载节点,将提示词转为语义条件 |

| CLIPTextEncode | 文本提示与负面提示的语义编码 |

| KSampler | 控制采样过程,决定生成视频的风格与细节 |

| WanVaceToVideo | 将语义条件与潜空间结合,输出视频潜空间结果 |

| VAEDecode | 将潜空间数据解码为可视图像 |

| ImagePadForOutpaint / ImageToMask / MaskToImage | 用于视频帧扩展和掩码处理,支持视频范围的外延生成 |

| GetVideoComponents / LoadVideo | 对输入视频进行帧与音频的解析与加载 |

| CreateVideo / SaveVideo / SaveAnimatedWEBP | 将图像序列合成为视频,并导出为 MP4 或 WebP 动态图 |

工作流程

在这个工作流中,所有节点依次衔接,形成了一个从文本条件到视频输出的完整链路。首先通过模型与 LoRA 的加载建立生成基础,随后将正向与负向提示词编码为条件输入进入采样器,并与视频潜空间数据进行融合。潜空间经过裁剪与解码后转化为帧图像序列,结合外扩与掩码机制实现画幅控制,最终通过视频合成节点输出为 MP4 或 WebP 动态文件。整体流程的逻辑既保证了画面细节的生成,又在不同阶段提供了分辨率、长度和效果上的调节空间,使得视频生成既高效又具备灵活性。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型与条件加载 | 加载 UNet 模型、VAE、文本编码器与 LoRA,为视频生成提供基础算力与语义条件 | UNETLoader、VAELoader、CLIPLoader、LoraLoader |

| 2 | 文本提示编码 | 将输入的正向与负向提示词转化为模型可理解的语义向量 | CLIPTextEncode(Positive/Negative) |

| 3 | 视频潜空间生成 | 基于提示条件与采样策略,生成视频的潜空间数据并控制帧长与尺寸 | WanVaceToVideo、KSampler、PrimitiveInt(Width/Height/Length) |

| 4 | 潜空间裁剪与解码 | 对生成的潜空间序列进行裁剪和解码,转化为可视帧图像 | TrimVideoLatent、VAEDecode |

| 5 | 外扩与掩码处理 | 对图像进行外扩、掩码生成与批量复制,实现视频画面范围延伸 | ImagePadForOutpaint、ImageToMask、MaskToImage、RepeatImageBatch |

| 6 | 视频帧与音频解析 | 对输入视频素材进行加载与拆解,提取出帧序列与音频内容 | LoadVideo、GetVideoComponents |

| 7 | 视频合成与导出 | 将生成的图像帧序列重组为视频,导出为 MP4 或 WebP 格式 | CreateVideo、SaveVideo、SaveAnimatedWEBP |

大模型应用

CLIPTextEncode(Positive Prompt) 控制视频主体语义与风格

该节点将文字描述转成语义嵌入,用来指导 Wan VACE 视频生成模型理解场景、角色、动作变化和画面氛围。Prompt 的写法直接影响镜头语言、人物神态、环境光线以及视频整体的叙事感,是整个视频生成过程最核心的语义控制源。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode(Positive Prompt) | A portrait of a woman with her eyes closed, her head surrounded by white transparent glass flowers, with only her face exposed. The camera slowly moves in, and the girl smiles. There are other transparent glass flowers in the style of Nicoletta Ceccoli around her. The detailed painting features natural light and soft lighting, creating a beautiful, surreal, and emotionally expressive movie scene. | 将正向 Prompt 转化为语义向量,用来控制视频的主题、镜头推进方式、人物神情、场景氛围与风格表达。 |

CLIPTextEncode(Negative Prompt) 排除不需要的错误视觉

该节点负责提供负向语义控制,抑制视频生成中出现的模糊、杂乱、错位等质量问题。负向 Prompt 让模型减少错误细节,使画面更干净、稳定与自然。

| 节点名称 | Prompt 信息 | 说明 |

|---|---|---|

| CLIPTextEncode(Negative Prompt) | bad quality, blurry, messy, chaotic | 将负向 Prompt 转化为语义向量,用于压制低质量细节,减少画面瑕疵、结构混乱或风格漂移。 |

使用方法

该工作流通过"载入视频 → 转换为图片帧 → 扩展画幅 → 构建控制掩码 → 融入文本 Prompt → Wan VACE 模型生成 → 重建视频"的完整链路自动化运行。用户只需替换输入视频与 Prompt,工作流会自动提取视频帧,生成 Outpainting 后的画面,输入 WanVaceToVideo 进行视频级生成,再通过 KSampler 推理和 VAE 解码回图像帧,最终合成为 MP4 或 WebP 动画。

整个流程无需多余手动处理,只需更换素材与 Prompt 即可完成视频级生成或视频重绘任务。

| 注意点 | 说明 |

|---|---|

| Prompt 决定视频语义 | 写得越具体,镜头、角色和氛围越稳定 |

| 负向 Prompt 需保持简洁 | 避免过强的负向导致画面失真 |

| 视频尺寸需能被 16 整除 | WanVaceToVideo 的尺寸步长限制 |

| 长度参数需正确 | Length-1 必须可被 4 整除,保证视频帧同步 |

| Outpaint 区域不能过大 | 避免模型生成过度自由导致结构崩坏 |

| LoRA 强度需要测试 | CausVid LoRA 可加速,但过强会产生抖动 |

| 1.3B 仅支持 480P、14B 支持 720P | 根据显存与生成质量选择合适模型 |

| KSampler 步数依用途调整 | LoRA 加速时 2-4 步即可,非加速需回到默认步数 |

应用场景

该工作流的应用覆盖了多个实际创作与研究方向。对于影视后期工作者而言,可以快速将提示词描述的创意画面转化为高质量视频镜头,用于概念设计或镜头预览。在学术研究场景中,该流程展示了文本到视频的生成机制,便于探索扩散模型在视频方向上的能力。对于个人创作者或自媒体用户,该工作流提供了一种低门槛的工具,将短文本和简单素材转化为具备艺术表现力的视频内容,丰富了创作手段。不同分辨率和模型版本的选择也让用户能够在高性能显卡与中低配置硬件之间灵活切换,实现从快速预览到精细输出的完整链路。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 影视前期可视化 | 将文字设想转化为视频画面,用于分镜头脚本演示 | 影视导演、设计师 | 短视频镜头与场景演示 | 高度契合剧本需求的动态画面 |

| 学术研究实验 | 探索文本驱动视频生成的算法路径与模型表现 | AI研究人员、学生 | 实验性视频样本与对比 | 展示不同模型与参数下的效果差异 |

| 自媒体内容创作 | 基于简短提示快速生成视频素材 | 自媒体创作者 | 带特效的短片、宣传片 | 提升内容创意与视觉冲击力 |

| 视频艺术创作 | 在艺术风格与超现实效果上进行实验 | 数字艺术家 | 具备独特风格的视频片段 | 呈现视觉艺术化的表达方式 |

| 教程与教学 | 演示扩散模型在视频方向的应用流程 | 教师、教育机构 | 教学用演示视频 | 提供可操作的学习案例 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用