近日,百度百舸基于 SGLang 与 vLLM 主流推理框架,成功完成智谱 GLM-4.x 系列语言模型(GLM-4.5 / GLM-4.5-Air / GLM-4.6 / GLM-4.7)在昆仑芯 XPU 平台上的适配与验证。

作为国产大模型标杆,智谱 GLM-4.x 系列语言模型覆盖从中等规模到超大规模的全参数区间,完成了从 GLM-4.0 Dense 架构向 MoE 架构的演进,在模型性能与推理效率上实现双重突破。目前,该系列模型已在通用对话、行业智能体以及企业级推理服务等场景中得到广泛应用。

针对企业级用户在昆仑芯 XPU 平台快速部署 GLM 4.x 系列语言模型的需求,百度混合云研发团队通过「敏捷适配 - 精度对齐 - 性能调优」,构建了基于主流推理框架的模型适配路径。

敏捷适配

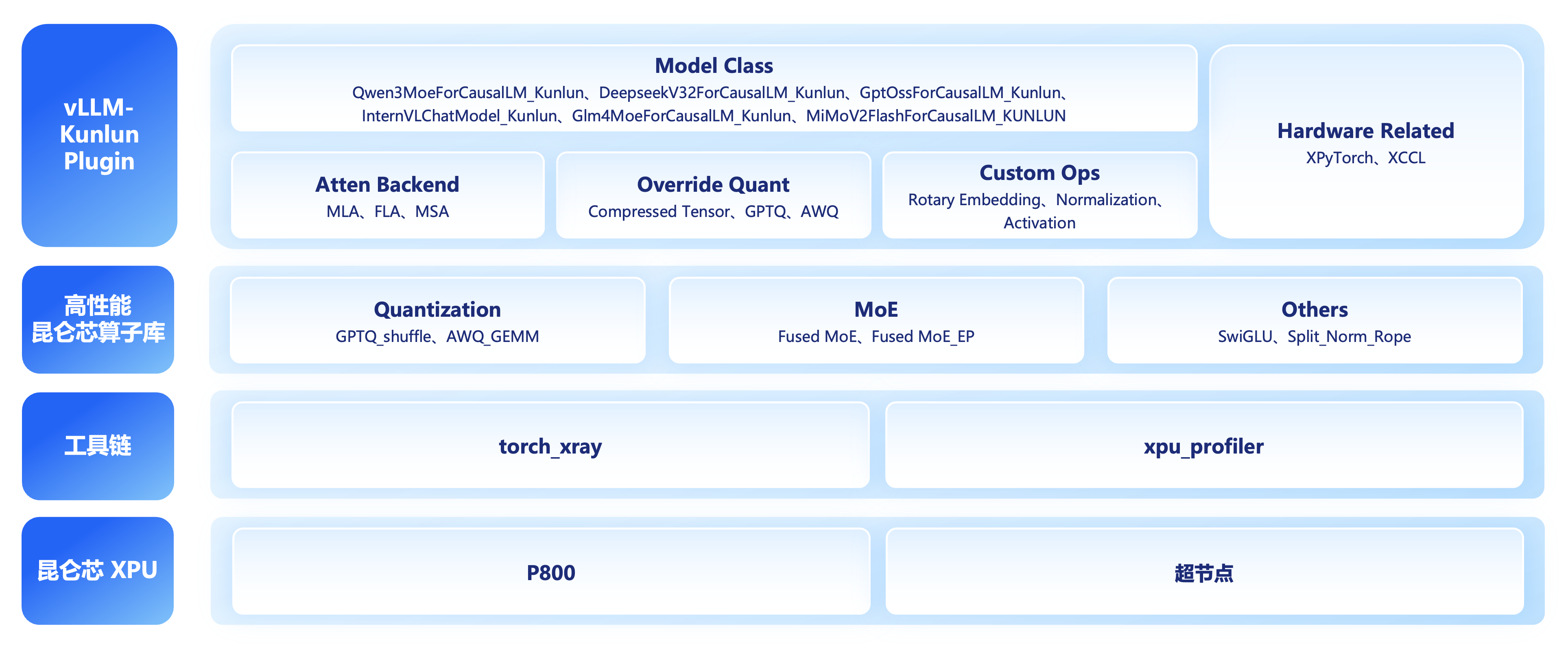

依托昆仑芯既有的高性能算子库(Flash Attention、Page Attention、Fused MoE 等),研发团队分别基于 SGLang 主代码库及 vLLM-Kunlun Plugin,完成模型适配与功能验证。

其中,vLLM-Kunlun Plugin 通过将 XPU 后端与 vLLM 主干代码解耦,支持用户从 GPU 平台高效迁移至 XPU 平台,并能无缝同步 vLLM 社区最新版本。

精度对齐

研发团队通过 torch_xray 精度对齐工具,对 GLM-4.x 系列语言模型在昆仑芯平台上的推理过程进行逐层、逐算子的数值对齐,一旦发现精度异常,迅速结合代码判断,可以快速定位和解决精度异常的原因,从而确保 XPU 平台的模型输出与 GPU 平台保持一致;此外,在性能调优过程中,如果优化手段引入了新的精度问题,同样可以借助 torch_xray 定位精度问题。

性能调优

借助 XPU-profiler 性能分析工具,研发团队对 GLM 模型的推理执行过程生成时序图,再结合「GPU 时间比照」,「模型代码分析」,对性能瓶颈进行系统性调优:

- 在算子层面,基于 Profiling 结果,识别推理过程中被频繁调用、耗时较长的关键算子,通过引入及开发融合算子,将原本串联执行的多个算子进行合并(如 moe_ffn_block、moe_gate_ops 等),显著减少 Kernel Launch 次数,有效压缩首字延迟(TTFT);并通过优化 Fused MoE 算子降低 MoE 场景中专家切换过程中对显存带宽的占用,提升稀疏计算场景下的推理;同时,针对 Prefill 与 Decode 阶段的计算特征差异,分别适配昆仑芯的 Prefill_attention 与 Decode_attention 专用算子,实现长序列并行计算与单 token 低时延场景的针对性优化;

- 在计算执行层面,XPU 的计算中,往往会穿插 CPU 的调度与处理时间,这会形成较多的计算气泡。为此,百舸团队通过 XPU Graph 技术,录制并复用静态计算图,将计算执行逻辑固化,从而减少 CPU 对模型推理的中断次数,提升单位时间内 XPU 的有效计算时长,优化模型的推理效率;

- 在通信层面,引入通信阈值自适应机制,实现 All-Reduce 算法的动态切换。例如,我们设定 2M 阈值,通信量低于阈值时采用 butterfly 算法,依托其低延迟、少交互的特性提升小流量传输效率;高于阈值则切换为 ring 算法,充分发挥其高带宽利用率优势适配大流量场景,从而面向不同流量场景下均可实现最优的通信效率。

结语

通过双推理框架的适配实践、插件化的高效迭代机制,以及覆盖推理流程全链路的系统级优化能力,GLM-4.x 系列语言模型在昆仑芯 XPU 平台上,在保持推理精度与 GPU 平台一致的前提下,实现了稳定且高效的推理性能表现,充分发挥了硬件性能。

目前,百度混合云研发团队在昆仑芯 XPU 平台上已沉淀一套面向大模型推理场景的适配经验,不仅支持模型在多推理框架上的快速部署与适配,也能够在模型持续演进和快速迭代的过程中,实现性能与成本目标,为企业用户加速全国产化 AI 场景落地提供坚实支撑。