前言

在Oracle 11g生产环境运维中,两大高频技术痛点极易踩坑:

一是表空间使用率监控 ,默认MB单位在大容量库中可读性极差,需精准转换为GB统计;

二是遗留LONG类型字段 的模糊查询,直接使用INSTR/LIKE全部报错,且4000字符长度限制导致超长文本匹配失效。

本文聚焦Oracle 11g环境 ,从原理层面剖析问题根源,提供可直接落地的生产级方案,彻底解决LONG字段超长模糊查询难题,同时优化表空间监控脚本,兼顾实用性与专业性。

一、前置优化:Oracle表空间使用率GB级精准查询

1.1 技术原理

表空间使用率统计核心依赖Oracle三类数据字典视图:

DBA_DATA_FILES:存储永久表空间数据文件总大小;DBA_FREE_SPACE:存储表空间空闲空间大小;DBA_TEMP_FILES/V$TEMP_SPACE_HEADER:存储临时表空间 大小与使用量。

通过字节(Byte)换算为GB(1GB=1024*1024*1024 Byte),实现大容量库的可视化监控。

1.2 永久表空间(业务数据)GB统计脚本

sql

SELECT

df.tablespace_name AS tablespace_name,

-- 总大小(GB),保留2位小数

ROUND(SUM(df.bytes) / 1024 / 1024 / 1024, 2) AS total_gb,

-- 已使用大小(GB)

ROUND((SUM(df.bytes) - SUM(fs.bytes)) / 1024 / 1024 / 1024, 2) AS used_gb,

-- 剩余大小(GB)

ROUND(SUM(fs.bytes) / 1024 / 1024 / 1024, 2) AS free_gb,

-- 使用率(百分比)

ROUND((SUM(df.bytes) - SUM(fs.bytes)) / SUM(df.bytes) * 100, 2) AS used_pct,

dt.contents AS tablespace_type

FROM dba_data_files df

JOIN dba_free_space fs ON df.tablespace_name = fs.tablespace_name

JOIN dba_tablespaces dt ON df.tablespace_name = dt.tablespace_name

GROUP BY df.tablespace_name, dt.contents

-- 按使用率降序,优先预警高占用表空间

ORDER BY used_pct DESC;1.3 临时表空间(排序/临时运算)GB统计脚本

sql

SELECT

tf.tablespace_name AS temp_tablespace_name,

ROUND(SUM(tf.bytes) / 1024 / 1024 / 1024, 2) AS total_gb,

ROUND(SUM(ths.used_blocks * ts.block_size) / 1024 / 1024 / 1024, 2) AS used_gb,

ROUND((SUM(tf.bytes) - SUM(ths.used_blocks * ts.block_size)) / 1024 / 1024 / 1024, 2) AS free_gb,

ROUND(SUM(ths.used_blocks * ts.block_size) / SUM(tf.bytes) * 100, 2) AS used_pct

FROM dba_temp_files tf

JOIN v$temp_space_header ths ON tf.tablespace_name = ths.tablespace_name

JOIN dba_tablespaces ts ON tf.tablespace_name = ts.tablespace_name

WHERE ts.contents = 'TEMPORARY'

GROUP BY tf.tablespace_name

ORDER BY used_pct DESC;权限要求:需授予

SELECT_CATALOG_ROLE或DBA权限;适用场景:日常运维空间监控、容量预警。

二、核心痛点:Oracle 11g LONG字段模糊查询失效原理剖析

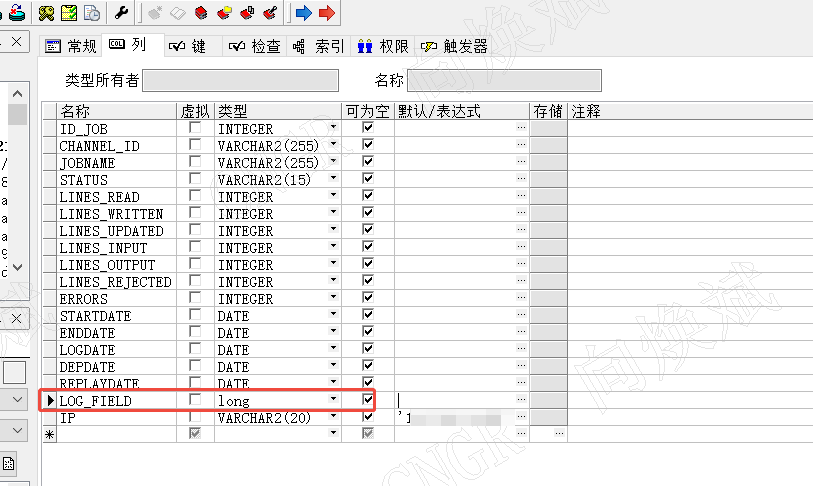

2.1 业务场景

业务表fr_report_sql中sql字段为LONG类型 ,存储超长SQL脚本(长度>4000字符),需检索包含指定日期(如2026-02-11)的记录。

2.2 官方限制与踩坑总结

LONG是Oracle已废弃的遗留数据类型 ,在11g中存在不可逆的底层限制:

- 不支持字符函数 :无法直接使用

INSTR/LIKE/SUBSTR等字符串操作函数; - 不支持嵌套转换 :XMLTYPE、子查询转VARCHAR2、

TO_LOB嵌套等写法全部失效; - 4000字符硬限制:PL/SQL中VARCHAR2变量最大仅支持4000字符,超长文本直接截断;

- 无函数索引:无法通过索引优化查询,全表扫描效率极低。

这也是常规写法、XML转换、子查询等方案均报错的根本原因。

三、方案1:临时应急方案 - 超长LONG字段分批检索(无表结构变更)

3.1 实现原理

利用PL/SQL的LONG变量可存储完整LONG数据 的特性,规避VARCHAR2长度限制,按4000字符为单位分批读取 LONG内容,逐批匹配目标字符串,通过ROWID关联原表返回结果。

优势 :无需修改表结构、无数据风险、适配所有11g环境;劣势:仅适合临时查询,大数据量表性能一般。

3.2 生产级脚本

sql

-- 步骤1:创建会话级全局临时表(GTT),存储匹配成功的ROWID

CREATE GLOBAL TEMPORARY TABLE tmp_long_match (

row_id ROWID NOT NULL

) ON COMMIT PRESERVE ROWS;

-- 步骤2:PL/SQL分批读取LONG,全量匹配目标日期

DECLARE

-- 目标匹配日期(可替换为TO_CHAR(SYSDATE, 'YYYY-MM-DD')自动匹配当日)

v_target_str VARCHAR2(10) := '2026-02-11';

v_long_content LONG;

v_batch_content VARCHAR2(4000);

v_pos NUMBER := 1;

v_batch_size NUMBER := 4000;

BEGIN

-- 清空临时表

DELETE FROM tmp_long_match;

COMMIT;

-- 遍历全表,逐行处理LONG字段

FOR rec IN (SELECT ROWID, sql FROM fr_report_sql) LOOP

v_long_content := rec.sql;

v_pos := 1;

-- 分批读取,直到匹配成功或读取完毕

WHILE v_pos <= LENGTH(v_long_content) LOOP

v_batch_content := SUBSTR(v_long_content, v_pos, v_batch_size);

-- 匹配目标字符串

IF INSTR(v_batch_content, v_target_str) > 0 THEN

INSERT INTO tmp_long_match (row_id) VALUES (rec.ROWID);

EXIT; -- 匹配成功,跳出当前行循环

END IF;

v_pos := v_pos + v_batch_size;

END LOOP;

END LOOP;

COMMIT;

END;

/

-- 步骤3:查询最终结果

SELECT t.* FROM fr_report_sql t

WHERE EXISTS (SELECT 1 FROM tmp_long_match tmp WHERE tmp.row_id = t.ROWID);四、方案2:生产级永久方案 - LONG转CLOB(官方推荐)

4.1 技术优势

CLOB是Oracle官方替代LONG的标准大文本类型,彻底解决所有限制:

- 支持

INSTR/LIKE/SUBSTR等所有字符串函数; - 无长度限制(最大4GB),完美适配超长文本;

- 支持函数索引、全表扫描优化,查询效率远超LONG;

- 11g原生支持,与业务代码无兼容性问题。

4.2 零风险全量迁移步骤(含数据备份,生产环境必用)

sql

-- 【安全前置】备份原表,防止数据丢失

CREATE TABLE fr_report_sql_bak_20260213 AS SELECT * FROM fr_report_sql;

-- 步骤1:新增CLOB类型临时字段

ALTER TABLE fr_report_sql ADD (sql_clob CLOB);

-- 步骤2:PL/SQL全量迁移LONG数据到CLOB(无截断、无丢失)

DECLARE

v_long_sql LONG;

CURSOR cur_data IS SELECT ROWID, sql FROM fr_report_sql;

BEGIN

FOR rec IN cur_data LOOP

v_long_sql := rec.sql;

-- LONG可直接赋值给CLOB,原生支持完整迁移

UPDATE fr_report_sql SET sql_clob = v_long_sql WHERE ROWID = rec.ROWID;

END LOOP;

COMMIT;

END;

/

-- 步骤3:验证数据完整性(对比长度,确保无丢失)

SELECT

COUNT(*) AS total_count,

SUM(CASE WHEN LENGTH(sql_clob) = LENGTH(sql) THEN 1 ELSE 0 END) AS valid_count

FROM fr_report_sql;

-- 步骤4:替换原字段(删除废弃LONG字段,CLOB字段重命名为原字段名)

ALTER TABLE fr_report_sql DROP COLUMN sql;

ALTER TABLE fr_report_sql RENAME COLUMN sql_clob TO sql;4.3 转换后极简查询(直接使用,无任何转换)

sql

-- 1. 固定日期匹配(支持任意长度文本、任意位置匹配)

SELECT * FROM fr_report_sql WHERE INSTR(sql, '2026-02-11') > 0;

-- 2. 自动匹配当日日期(动态适配)

SELECT * FROM fr_report_sql WHERE sql LIKE '%' || TO_CHAR(SYSDATE, 'YYYY-MM-DD') || '%';五、方案对比与生产最佳实践

| 方案 | 适用场景 | 复杂度 | 性能 | 长期维护性 |

|---|---|---|---|---|

| 分批检索临时方案 | 临时查询、禁止改表结构 | 中 | 一般 | 低 |

| LONG转CLOB永久方案 | 生产环境、长期使用 | 低 | 优 | 高 |

最佳实践建议

- 生产环境优先选LONG转CLOB:一次性改造,永久解决所有LONG类型痛点,是Oracle官方标准方案;

- 临时查询用分批检索:无需改表,快速满足临时检索需求;

- 表空间监控:固定使用GB级脚本,纳入日常运维监控体系。

结语

Oracle 11g中LONG类型的模糊查询问题,本质是遗留数据类型的底层限制 ,而非语法错误。通过LONG转CLOB的生产级改造,不仅能解决超长文本匹配问题,更能规避Oracle废弃类型的后续风险;配合GB级表空间监控脚本,可全面提升运维效率与问题排查精准度。

在Oracle运维中,拥抱官方推荐的新标准(CLOB),远比纠结遗留类型的兼容方案更高效、更稳定。