前言

欢迎加入开源鸿蒙跨平台社区:https://openharmonycrossplatform.csdn.net

在正式动手适配之前,我觉得有必要花一篇文章把Flutter Plugin的工作机制讲透。很多人做插件适配的时候,上来就抄Android端的代码改改,结果各种问题。根本原因就是没搞清楚底层的通信机制。

我刚开始写Flutter插件的时候也是这样,对Platform Channel的理解停留在"能调原生代码"的层面。直到有一次遇到一个诡异的bug------Dart端调用原生方法偶尔会收不到回调,排查了两天才发现是线程问题。从那以后我就下定决心把这块原理吃透。

今天这篇文章,我会从架构设计、通信机制、消息编码、插件注册四个维度来分析Flutter Plugin,最后再结合flutter_speech的实际代码做一个串讲。内容偏理论,但对后续的适配工作非常重要。

💡 建议:如果你已经有Flutter插件开发经验,可以跳过前三节,直接看第四节的flutter_speech源码分析。

一、Flutter Plugin 的架构设计

1.1 Plugin vs Package

先厘清一个概念:Flutter中的Plugin 和Package是不一样的。

| 类型 | 是否包含原生代码 | 典型场景 | 例子 |

|---|---|---|---|

| Package | ❌ 纯Dart | 工具类、UI组件 | provider, dio |

| Plugin | ✅ 包含原生代码 | 调用平台能力 | camera, flutter_speech |

yaml

# Package的pubspec.yaml - 没有plugin配置

name: my_package

dependencies:

flutter:

sdk: flutter

# Plugin的pubspec.yaml - 有plugin平台配置

name: flutter_speech

flutter:

plugin:

platforms:

android:

pluginClass: FlutterSpeechRecognitionPlugin

ohos:

pluginClass: FlutterSpeechPluginflutter_speech显然是一个Plugin,因为语音识别必须调用操作系统的原生API,纯Dart是做不了的。

1.2 三层架构模型

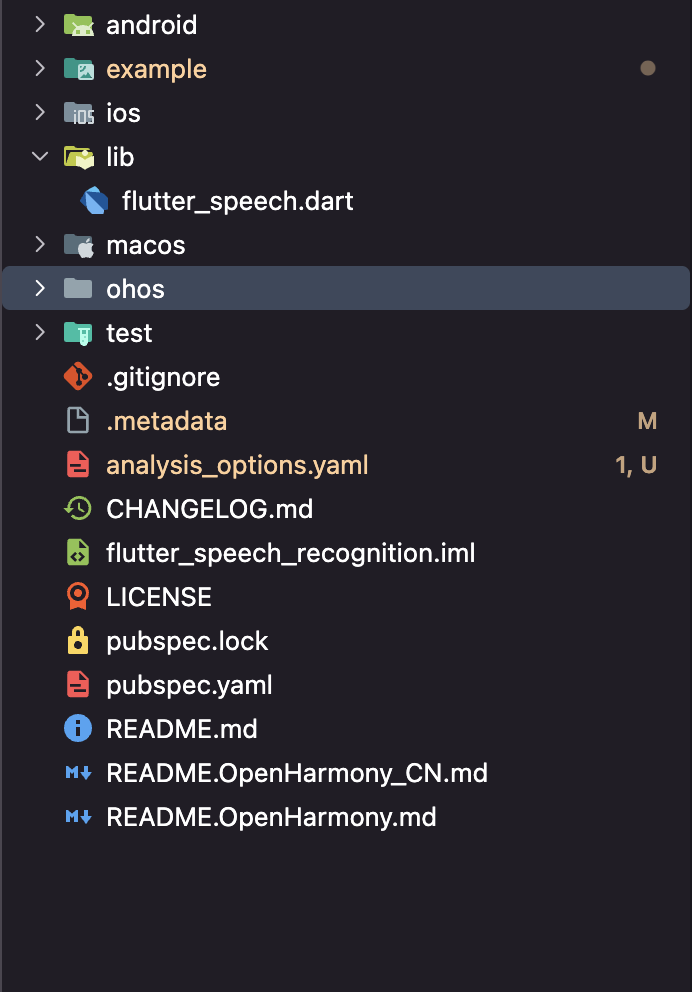

Flutter Plugin的架构可以用一张图概括:

图:Flutter Plugin三层架构示意图

┌──────────────────────────────────────┐

│ Application Layer │

│ (你的Flutter App代码) │

├──────────────────────────────────────┤

│ Plugin Dart Layer │

│ (flutter_speech.dart) │

│ SpeechRecognition类 + MethodChannel │

├──────────────────────────────────────┤

│ Platform Channel Layer │

│ (Flutter Engine内部) │

│ 消息编码 → 线程调度 → 消息路由 │

├──────────┬──────────┬────────────────┤

│ Android │ iOS/Mac │ OpenHarmony │

│ Java/ │ ObjC/ │ ArkTS │

│ Kotlin │ Swift │ (.ets) │

└──────────┴──────────┴────────────────┘每一层的职责很明确:

- Dart层:定义API接口,处理业务逻辑,对上层应用屏蔽平台差异

- Channel层:负责Dart和原生之间的消息传递,包括序列化、线程切换

- 原生层:调用具体平台的SDK,实现实际功能

1.3 为什么需要Platform Channel

有人问过我:"Flutter不是自己画UI的吗,为什么还需要和原生通信?"

答案很简单:Flutter的渲染引擎只负责UI,操作系统的能力(摄像头、麦克风、传感器、文件系统等)必须通过原生API访问。

dart

// 这些操作都需要Platform Channel

await camera.takePicture(); // 需要调用原生摄像头API

await speechRecognition.listen(); // 需要调用原生语音识别API

await geolocator.getCurrentPosition(); // 需要调用原生定位APIPlatform Channel就是Flutter提供的标准化通信桥梁,让Dart代码能够安全、高效地调用原生能力。

二、MethodChannel 通信机制详解

2.1 三种Channel类型

Flutter提供了三种Platform Channel,适用于不同场景:

| Channel类型 | 通信模式 | 适用场景 | flutter_speech用的 |

|---|---|---|---|

| MethodChannel | 请求-响应 | 方法调用 | ✅ 是 |

| EventChannel | 流式推送 | 持续数据流 | ❌ 否 |

| BasicMessageChannel | 自由格式 | 自定义协议 | ❌ 否 |

flutter_speech选择了MethodChannel,这是最常用的一种。它的通信模式类似HTTP请求:Dart端发起调用,原生端处理后返回结果。

2.2 MethodChannel 工作流程

以flutter_speech的activate方法为例,完整的调用流程是这样的:

dart

// 第1步:Dart端发起调用

Future activate(String locale) =>

_channel.invokeMethod("speech.activate", locale);Dart端 Flutter Engine 原生端

│ │ │

│ invokeMethod │ │

│ ("speech.activate", │ │

│ "zh_CN") │ │

│──────────────────────────>│ │

│ │ 序列化消息 │

│ │ 切换到平台线程 │

│ │────────────────────────>│

│ │ │ onMethodCall

│ │ │ 处理逻辑...

│ │ │ result.success(true)

│ │<────────────────────────│

│ │ 反序列化结果 │

│ │ 切换到UI线程 │

│<──────────────────────────│ │

│ Future完成 │ │

│ 返回true │ │🎯 关键点 :整个过程涉及两次线程切换 (UI线程→平台线程→UI线程)和两次序列化(编码→解码→编码→解码)。这就是为什么Platform Channel有一定的性能开销。

2.3 双向通信

MethodChannel不仅支持Dart调原生,还支持原生调Dart。flutter_speech大量使用了这个特性来传递识别结果:

dart

// Dart端:注册回调处理器

SpeechRecognition._internal() {

_channel.setMethodCallHandler(_platformCallHandler);

}

Future _platformCallHandler(MethodCall call) async {

switch (call.method) {

case "speech.onSpeechAvailability":

availabilityHandler(call.arguments);

break;

case "speech.onSpeech":

recognitionResultHandler(call.arguments); // 实时识别结果

break;

case "speech.onRecognitionComplete":

recognitionCompleteHandler(call.arguments); // 识别完成

break;

}

}

typescript

// OpenHarmony原生端:主动调用Dart

this.channel?.invokeMethod('speech.onSpeech', result.result);

this.channel?.invokeMethod('speech.onRecognitionComplete', result.result);这种双向通信模式非常适合语音识别这种场景------Dart端发起"开始监听"的请求,原生端持续推送识别结果。

2.4 Channel命名规范

MethodChannel通过名称字符串来标识,必须保证Dart端和原生端使用完全相同的名称:

dart

// Dart端

static const MethodChannel _channel =

const MethodChannel('com.flutter.speech_recognition');

typescript

// OpenHarmony原生端

this.channel = new MethodChannel(binding.getBinaryMessenger(),

"com.flutter.speech_recognition");⚠️ 常见错误 :Channel名称不一致。我见过有人Dart端写的是

speech_recognition,原生端写的是speechRecognition,结果怎么调都没反应。这种bug特别隐蔽,日志里也不会报错,只是默默地不工作。

三、消息编码与序列化

3.1 StandardMethodCodec

MethodChannel默认使用StandardMethodCodec进行消息编码,它基于二进制格式,效率比JSON高不少:

| Dart类型 | 编码标识 | 原生对应类型 | 大小 |

|---|---|---|---|

| null | 0x00 | null | 1字节 |

| true | 0x01 | boolean | 1字节 |

| false | 0x02 | boolean | 1字节 |

| int (32bit) | 0x03 | int | 5字节 |

| int (64bit) | 0x04 | long | 9字节 |

| double | 0x06 | double | 9字节 |

| String | 0x07 | String | 变长 |

| List | 0x0C | Array | 变长 |

| Map | 0x0D | Map | 变长 |

3.2 flutter_speech中的数据传递

看看flutter_speech实际传递了哪些类型的数据:

dart

// Dart → 原生:传递String类型的locale

_channel.invokeMethod("speech.activate", locale); // locale是String

// 原生 → Dart:传递不同类型

channel?.invokeMethod('speech.onSpeechAvailability', true); // bool

channel?.invokeMethod('speech.onSpeech', result.result); // String

channel?.invokeMethod('speech.onRecognitionStarted', null); // null

channel?.invokeMethod('speech.onError', errorCode); // number数据类型都很简单,没有复杂的嵌套结构。这是好事,因为序列化开销和数据复杂度成正比。

3.3 性能考量

对于flutter_speech这种插件,Platform Channel的性能开销基本可以忽略。但如果你做的是视频流处理或者高频传感器数据,就需要认真考虑了:

dart

// 低频调用(flutter_speech的场景)- 完全没问题

// 语音识别结果大概每秒回调1-3次

channel.invokeMethod('speech.onSpeech', text); // ✅ OK

// 高频调用(假设的场景)- 可能有性能问题

// 每秒60帧的视频数据

channel.invokeMethod('video.onFrame', frameData); // ⚠️ 需要优化💡 优化建议 :如果遇到高频数据传输场景,可以考虑使用

BasicMessageChannel配合BinaryCodec,或者直接用FFI(Foreign Function Interface)绕过Platform Channel。

四、插件注册与平台分发流程

4.1 pubspec.yaml 中的插件声明

Flutter通过pubspec.yaml来声明插件支持的平台和对应的实现类:

yaml

flutter:

plugin:

platforms:

ios:

pluginClass: FlutterSpeechRecognitionPlugin

macos:

pluginClass: FlutterSpeechRecognitionPlugin

android:

package: com.flutter.speech_recognition.flutter_speech

pluginClass: FlutterSpeechRecognitionPlugin

ohos:

package: com.flutter.speech_recognition.flutter_speech

pluginClass: FlutterSpeechPlugin几个关键字段:

| 字段 | 含义 | Android | OpenHarmony |

|---|---|---|---|

| package | 包名/命名空间 | Java包名 | ArkTS模块标识 |

| pluginClass | 插件主类名 | Java类名 | ArkTS类名 |

| dartPluginClass | Dart端插件类 | 可选 | 可选 |

📌 注意 :Android和OpenHarmony的

pluginClass名称不同------Android是FlutterSpeechRecognitionPlugin,OpenHarmony是FlutterSpeechPlugin。这是因为两个平台的实现是独立的。

4.2 自动注册机制

Flutter在编译时会自动扫描所有依赖的插件,生成注册代码:

java

// Android端自动生成的注册代码(GeneratedPluginRegistrant.java)

public final class GeneratedPluginRegistrant {

public static void registerWith(@NonNull FlutterEngine flutterEngine) {

flutterEngine.getPlugins().add(new FlutterSpeechRecognitionPlugin());

}

}

typescript

// OpenHarmony端自动生成的注册代码(GeneratedPluginRegistrant.ets)

export default class GeneratedPluginRegistrant {

static registerWith(registry: FlutterEngine): void {

registry.getPlugins().add(new FlutterSpeechPlugin());

}

}开发者不需要手动注册插件,Flutter的构建系统会自动处理。但理解这个机制有助于排查"插件找不到"的问题。

4.3 插件生命周期

每个Flutter Plugin都有明确的生命周期:

App启动

│

├── FlutterEngine创建

│ │

│ ├── onAttachedToEngine() ← 插件初始化,创建MethodChannel

│ │

│ ├── onAttachedToAbility() ← (仅OpenHarmony) 获取UIAbilityContext

│ │

│ ├── [正常运行,处理方法调用]

│ │

│ ├── onDetachedFromAbility() ← (仅OpenHarmony) 释放Context

│ │

│ └── onDetachedFromEngine() ← 插件销毁,清理资源

│

└── App退出对应到flutter_speech的OpenHarmony实现:

typescript

export default class FlutterSpeechPlugin implements FlutterPlugin, MethodCallHandler, AbilityAware {

onAttachedToEngine(binding: FlutterPluginBinding): void {

// 创建MethodChannel并注册Handler

this.channel = new MethodChannel(binding.getBinaryMessenger(),

"com.flutter.speech_recognition");

this.channel.setMethodCallHandler(this);

}

onDetachedFromEngine(binding: FlutterPluginBinding): void {

// 清理Channel和引擎资源

if (this.channel != null) {

this.channel.setMethodCallHandler(null);

}

this.destroyEngine();

}

onAttachedToAbility(binding: AbilityPluginBinding): void {

// 获取UIAbilityContext(权限申请需要)

this.abilityContext = binding.getAbility().context;

}

onDetachedFromAbility(): void {

this.abilityContext = null;

}

}🤦 我踩过的坑 :有一次忘记在

onDetachedFromEngine里调用destroyEngine(),结果App切后台再回来时语音识别引擎状态混乱,各种诡异bug。资源释放一定不能忘!

五、flutter_speech 的 Dart 层 API 设计分析

5.1 单例模式

flutter_speech使用了工厂构造函数实现单例:

dart

class SpeechRecognition {

static final SpeechRecognition _speech = new SpeechRecognition._internal();

factory SpeechRecognition() => _speech;

SpeechRecognition._internal() {

_channel.setMethodCallHandler(_platformCallHandler);

}

}为什么用单例?因为语音识别引擎在原生端通常也是单例的(一个设备同一时间只能有一个语音识别会话),Dart端保持一致可以避免很多状态管理问题。

5.2 方法调用映射

Dart层的四个核心方法和原生端的映射关系:

dart

// Dart方法 → MethodChannel方法名 → 原生处理

Future activate(String locale) =>

_channel.invokeMethod("speech.activate", locale);

// → onMethodCall中case "speech.activate"

Future listen() =>

_channel.invokeMethod("speech.listen");

// → onMethodCall中case "speech.listen"

Future cancel() =>

_channel.invokeMethod("speech.cancel");

// → onMethodCall中case "speech.cancel"

Future stop() =>

_channel.invokeMethod("speech.stop");

// → onMethodCall中case "speech.stop"| Dart方法 | Channel方法名 | 参数 | 返回值 | 说明 |

|---|---|---|---|---|

| activate | speech.activate | String locale | bool | 激活引擎 |

| listen | speech.listen | 无 | bool | 开始监听 |

| cancel | speech.cancel | 无 | bool | 取消识别 |

| stop | speech.stop | 无 | bool | 停止识别 |

5.3 回调处理机制

flutter_speech定义了五种回调,覆盖了语音识别的完整生命周期:

dart

typedef void AvailabilityHandler(bool result);

typedef void StringResultHandler(String text);

// 五种回调

late AvailabilityHandler availabilityHandler; // 引擎可用性变化

late StringResultHandler recognitionResultHandler; // 实时识别结果

late VoidCallback recognitionStartedHandler; // 识别开始

late StringResultHandler recognitionCompleteHandler;// 识别完成

late VoidCallback errorHandler; // 错误发生回调的触发时序:

activate() → onSpeechAvailability(true)

│

listen() → onRecognitionStarted()

│

├── onSpeech("你") → onSpeech("你好") → onSpeech("你好世界")

│ (实时部分结果,不断更新)

│

stop() → onRecognitionComplete("你好世界")

│

└── 流程结束🎯 设计亮点 :

onSpeech回调会在识别过程中持续触发,每次传递当前的完整识别文本(而不是增量)。这样Dart端直接替换显示就行,不需要自己做文本拼接。

5.4 _platformCallHandler 实现

这是Dart端处理原生回调的核心方法:

dart

Future _platformCallHandler(MethodCall call) async {

print("_platformCallHandler call ${call.method} ${call.arguments}");

switch (call.method) {

case "speech.onSpeechAvailability":

availabilityHandler(call.arguments);

break;

case "speech.onSpeech":

recognitionResultHandler(call.arguments);

break;

case "speech.onRecognitionStarted":

recognitionStartedHandler();

break;

case "speech.onRecognitionComplete":

recognitionCompleteHandler(call.arguments);

break;

case "speech.onError":

errorHandler();

break;

default:

print('Unknowm method ${call.method} ');

}

}注意这里有个拼写错误:Unknowm应该是Unknown。这种小问题在开源项目里很常见,不影响功能但看着不舒服。

六、从Android到OpenHarmony的映射思路

6.1 接口映射对照表

理解了Flutter Plugin机制后,Android到OpenHarmony的映射就很清晰了:

| Android概念 | OpenHarmony对应 | flutter_speech中的体现 |

|---|---|---|

| FlutterPlugin | FlutterPlugin | 插件主接口 |

| MethodCallHandler | MethodCallHandler | 方法调用处理 |

| ActivityAware | AbilityAware | 上下文获取 |

| FlutterPluginBinding | FlutterPluginBinding | 引擎绑定 |

| ActivityPluginBinding | AbilityPluginBinding | Ability绑定 |

| BinaryMessenger | BinaryMessenger | 消息传递器 |

6.2 生命周期映射

Android OpenHarmony

─────── ───────────

onAttachedToEngine() → onAttachedToEngine()

onDetachedFromEngine() → onDetachedFromEngine()

onAttachedToActivity() → onAttachedToAbility()

onDetachedFromActivity() → onDetachedFromAbility()💡 好消息:Flutter-OHOS团队在设计接口时,刻意保持了和Android端的一致性。所以如果你熟悉Android的Flutter插件开发,转到OpenHarmony会非常顺畅。

6.3 关键差异点

虽然接口设计很相似,但有几个关键差异需要注意:

- 开发语言:Android用Java/Kotlin,OpenHarmony用ArkTS(.ets文件)

- 上下文类型 :Android是

Activity/Context,OpenHarmony是UIAbilityContext - 权限API :Android用

ActivityCompat,OpenHarmony用abilityAccessCtrl - 构建系统:Android用Gradle,OpenHarmony用hvigor

typescript

// OpenHarmony的导入方式

import {

FlutterPlugin,

FlutterPluginBinding,

MethodCall,

MethodCallHandler,

MethodChannel,

MethodResult,

AbilityAware,

} from '@ohos/flutter_ohos';七、调试Platform Channel的实用技巧

7.1 日志调试法

最简单也最有效的调试方法------加日志:

dart

// Dart端加日志

Future _platformCallHandler(MethodCall call) async {

print("📱 [Dart] Received: ${call.method} args=${call.arguments}");

// ...

}

typescript

// OpenHarmony原生端加日志

onMethodCall(call: MethodCall, result: MethodResult): void {

console.info(TAG, `📱 [Native] Received: ${call.method} args=${call.args}`);

// ...

}7.2 常见问题排查清单

| 症状 | 可能原因 | 排查方法 |

|---|---|---|

| 方法调用无响应 | Channel名称不一致 | 对比Dart和原生端的Channel名 |

| 回调不触发 | setMethodCallHandler未调用 | 检查构造函数 |

| 参数为null | 序列化类型不匹配 | 检查参数类型 |

| 偶尔崩溃 | 线程安全问题 | 确保UI操作在主线程 |

| 内存泄漏 | 未在detach时清理 | 检查onDetachedFromEngine |

7.3 使用DevTools调试

bash

# 启动Flutter DevTools

flutter pub global activate devtools

flutter pub global run devtools

# 在DevTools中可以:

# 1. 查看Widget树

# 2. 监控性能

# 3. 查看日志输出

# 4. 分析内存使用八、小结:为什么理解机制很重要

8.1 适配工作的本质

理解了Flutter Plugin机制后,你会发现OpenHarmony适配的本质就是:

- 实现

FlutterPlugin接口 → 管理插件生命周期 - 实现

MethodCallHandler接口 → 处理Dart端的方法调用 - 实现

AbilityAware接口 → 获取OpenHarmony上下文 - 在方法处理中调用Core Speech Kit → 实现实际功能

- 通过

channel.invokeMethod回调Dart端 → 传递结果

就这五步,不多不少。

8.2 知识图谱

Flutter Plugin机制

├── Platform Channel

│ ├── MethodChannel(flutter_speech使用)

│ ├── EventChannel

│ └── BasicMessageChannel

├── 消息编码

│ ├── StandardMethodCodec

│ └── 二进制序列化

├── 插件注册

│ ├── pubspec.yaml声明

│ └── 自动代码生成

└── 生命周期

├── onAttachedToEngine

├── onAttachedToAbility(OHOS特有)

├── onDetachedFromAbility(OHOS特有)

└── onDetachedFromEngine总结

本文从四个维度深入分析了Flutter Plugin的工作机制:

- 架构设计:三层架构(Dart层 → Channel层 → 原生层),职责分明

- 通信机制:MethodChannel的请求-响应模式和双向通信能力

- 消息编码:StandardMethodCodec的二进制编码,高效且跨平台

- 插件注册:pubspec.yaml声明 + 自动代码生成,开发者无需手动注册

理解了这些原理,后面的适配工作就有了清晰的方向。下一篇我们将深入flutter_speech的源码,逐行分析Dart层的实现细节。

如果这篇文章对你有帮助,欢迎点赞👍、收藏⭐、关注🔔,你的支持是我持续创作的动力!

相关资源: