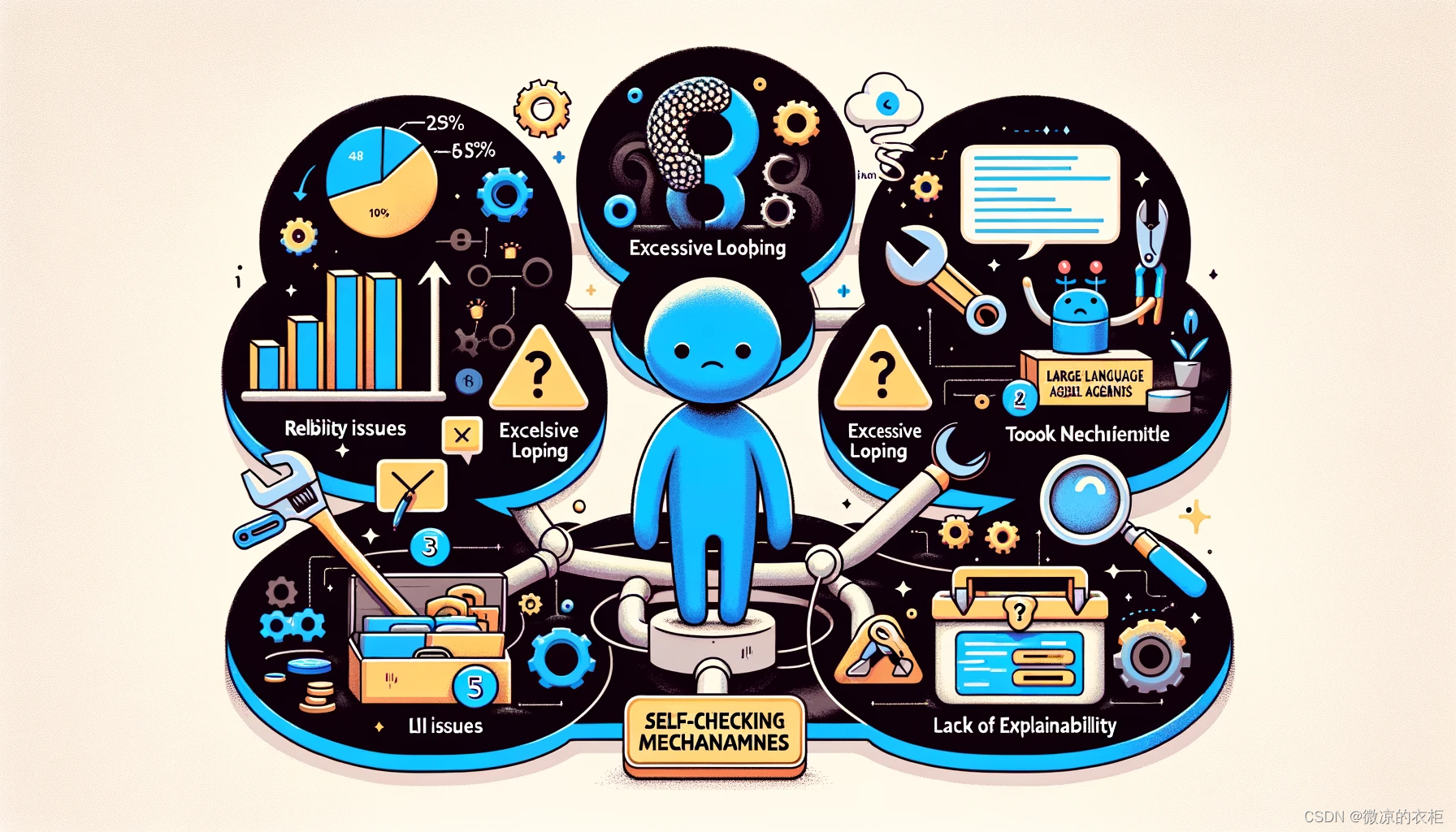

在这篇文章中,我将讨论人们在将代理系统投入生产过程中经常遇到的五个主要问题。我将尽量保持框架中立,尽管某些问题在特定框架中更加常见。

1. 可靠性问题

可靠性是所有代理系统面临的最大问题。很多公司对代理系统的复杂任务持谨慎态度,因为大多数代理系统的可靠性非常低。虽然典型的公司希望实现 99.999% 的可靠性,但大多数代理系统的可靠性仅能达到 60% 到 70% 左右。这对大多数应用来说是不够的,尤其是当代理系统需要完全自主运行时。

解决方法:

- 确保代理系统能够一致地产生用户期望的输出。

- 逐步提高系统的可靠性,确保其能够在大多数情况下正常工作。

- 设计健全的错误处理机制,避免因个别错误导致系统失效。

2. 过度循环问题

代理系统进入过度循环是一个常见问题。这可能是由于工具的失败或代理系统无法接受子代理的输出而引起的。在某些框架中,这个问题尤为突出,例如 CrewAI 和其他类似框架。

解决方法:

- 限制代理系统的循环次数或重试次数。

- 设计有效的监控和检测机制,以便快速识别和停止无限循环。

- 确保代理系统能够识别并处理失败的工具输出。

3. 工具问题

很多现有的工具并不适合代理系统的需求,尤其是那些用于信息检索(RAG)而非代理任务的工具。因此,定制工具对于代理系统的成功至关重要。

解决方法:

- 为特定用例创建自定义工具。

- 确保工具能够有效地获取、处理数据,并将有用的输出提供给 LLM。

- 设计工具以适应代理系统的特定需求,避免简单工具在复杂场景中的失败。

4. 自检机制

代理系统需要具备自检能力,能够检查其输出的有效性和准确性。例如,对于生成代码的代理系统,可以通过运行单元测试来验证代码的正确性。

解决方法:

- 为代理系统生成的输出设置检查点,确保输出的质量。

- 针对不同的用例,设计相应的验证机制,确保代理系统的输出符合预期。

- 检查代理系统生成的 URL 是否存在,避免虚假 URL 的出现。

5. 可解释性问题

代理系统的输出需要具备可解释性,用户能够理解代理系统为何产生某个结果。例如,引用来源是提高输出可信度的一种有效方式。

解决方法:

- 提供引用和解释,展示代理系统使用的信息来源。

- 记录代理系统的操作日志,便于用户追踪和调试。

- 确保代理系统的决策过程透明,便于用户理解和信任。

额外建议:调试机制

调试是代理系统开发中不可或缺的一部分。需要设计智能的输出和日志记录机制,便于开发者快速识别和解决问题。

解决方法:

- 独立记录代理系统的推理过程,便于快速识别问题。

- 确保日志记录详细且易于分析,帮助开发者定位问题根源。

- 设计合理的决策点,减少不必要的复杂性,提高系统的稳定性。

总之,在将大型语言模型代理系统投入生产时,需要关注以上五个主要问题,并采取相应的措施进行优化。通过不断迭代和改进,逐步提高代理系统的可靠性、自主性和可解释性,最终实现高效稳定的生产部署。

希望这篇文章能够帮助你理解并解决在将 LLM 代理系统投入生产过程中遇到的一些关键问题。如果你有任何问题或建议,请在评论区留言。如果你觉得这篇文章有帮助,请点赞并关注,谢谢!