一、探索性数据分析

探索性数据分析(Exploratory Data Analysis,简称EDA)是数据分析过程中的一个重要阶段,旨在通过可视化和统计方法探索数据的结构、特征和关系,以获得对数据的直观理解和洞察。

以下是进行探索性数据分析时可能采取的一些步骤和技术:

-

数据概览 :查看数据的基本信息,包括数据类型、缺失值情况、特征数量等。使用

info()函数、head()函数等快速查看数据的前几行。 -

描述性统计 :计算数据的统计指标,如均值、中位数、标准差等,以了解数据的分布情况。使用

describe()函数可以一次性获得多个统计量。 -

数据可视化:绘制各种图表来展现数据的分布、关系和趋势。常用的可视化工具包括散点图、直方图、箱线图、热力图等。使用Python中的matplotlib、seaborn等库进行可视化操作。

-

特征分布:观察各个特征的分布情况,包括连续型特征和离散型特征。对于连续型特征,可以绘制直方图或密度图;对于离散型特征,可以绘制柱状图。

-

特征相关性:分析各个特征之间的相关性,可以通过绘制相关系数矩阵、热力图等方式来展现特征之间的相关关系。

-

异常值检测:识别并处理数据中的异常值,使用箱线图、散点图等方法来识别异常值,并根据业务逻辑或统计方法进行处理。

-

缺失值处理:分析数据中的缺失值情况,选择合适的方法来处理缺失值,如删除缺失值、填充缺失值等。

-

特征工程:根据数据的特点和业务需求,进行特征的构建、转换和选择,以提高模型的性能。

通过以上步骤,可以更好地理解数据集的特征、结构和规律,为后续的建模和分析工作提供基础。

二、ANOVA

ANOVA(Analysis of Variance,方差分析)是一种统计方法,用于比较两个或多个组之间的平均值是否存在显著差异。ANOVA的基本思想是将总体方差分解为组间(Treatment)方差和组内(Error)方差,然后通过比较这两个方差来判断组之间是否存在显著差异。

ANOVA适用于以下场景:

-

多组比较:当你有两个以上的组需要比较时,ANOVA可以帮助你确定这些组之间是否存在显著差异。

-

连续型因变量:ANOVA通常用于连续型因变量,即需要比较的变量是定量数据。

-

独立观察值:ANOVA假设不同组的观察值是独立的。

-

方差齐性:ANOVA的可靠性要求各组的方差相等或接近相等。

ANOVA有几种不同的类型,包括单因素(One-Way ANOVA)、双因素(Two-Way ANOVA)等。其中,单因素ANOVA用于比较一个因素(自变量)对一个因变量的影响,双因素ANOVA用于比较两个因素对因变量的影响。

ANOVA的步骤包括:

-

建立假设:提出原假设和备择假设,通常假设各组之间的均值相等。

-

选择显著水平(α):通常选择α=0.05作为显著水平。

-

计算统计量:计算ANOVA的统计量,例如F统计量。

-

判断显著性:比较计算得到的F值与临界值,如果F值大于临界值,则拒绝原假设,表明组间存在显著差异。

如果ANOVA的结果显示组间存在显著差异,接下来通常会进行进一步的事后比较(Post-hoc Comparisons),以确定具体哪些组之间存在差异。常用的事后比较方法包括Tukey's HSD(Honestly Significant Difference)、Bonferroni校正等。

三、XGBoost

XGBoost,全称为eXtreme Gradient Boosting,是一种梯度提升树(Gradient Boosting Tree)算法的改进版本。它由陈天奇在2014年提出,是一种高效、灵活、可扩展的机器学习算法,被广泛应用于数据挖掘和预测建模任务中。

XGBoost的主要特点包括:

-

优化的梯度提升算法:XGBoost通过改进目标函数和正则化项,提高了梯度提升树算法的性能。它在每一轮迭代中都会计算模型的梯度,并利用树模型的特殊结构来近似最优解,从而加速模型训练过程。

-

支持并行化处理:XGBoost支持并行化处理,可以利用多核CPU进行计算,提高了模型训练的效率。此外,XGBoost还支持在分布式计算环境下运行,如Hadoop、Spark等。

-

灵活的正则化策略:XGBoost引入了L1和L2正则化项,以控制模型的复杂度,防止过拟合。通过控制正则化参数,用户可以灵活地调整模型的复杂度和泛化能力。

-

特征重要性评估:XGBoost可以计算每个特征对模型的重要性,帮助用户识别关键特征。这些特征重要性分数可以用于特征选择和解释模型的预测结果。

-

内置的交叉验证功能:XGBoost内置了交叉验证功能,可以帮助用户选择最佳的模型参数,提高模型的泛化能力。

XGBoost已成为数据科学竞赛和实际应用中的常用工具,其性能优异、易于使用和可扩展性等优点使其受到了广泛关注和应用。

四、Random Forest

随机森林(Random Forest)是一种集成学习方法,它通过构建多个决策树(Decision Tree)并将它们结合起来进行预测。随机森林在每个决策树的训练过程中,都会随机选择一部分样本和特征进行训练,从而降低了模型的方差,提高了泛化能力。

随机森林的主要特点包括:

-

Bagging策略:随机森林采用自助采样法(Bootstrap Aggregating,Bagging)来构建多个决策树。在每个决策树的训练过程中,随机抽取一部分样本进行训练,从而使得每个决策树的训练数据都不完全相同。

-

随机特征选择:除了对样本进行随机抽样外,随机森林还对特征进行随机选择。在每个节点划分时,随机森林从所有特征中选择一部分特征进行划分,这样可以增加决策树之间的差异性,提高模型的多样性。

-

决策树的平均:随机森林中的每个决策树都是一个弱学习器,它们的预测结果通过投票或平均的方式进行集成,从而得到最终的预测结果。

-

高效的并行化处理:由于每个决策树都是独立训练的,随机森林可以很容易地并行化处理,利用多核CPU或分布式计算资源进行训练。

-

抗过拟合能力:随机森林通过集成多个决策树,降低了模型的方差,从而提高了模型的泛化能力和抗过拟合能力。

随机森林适用于各种类型的数据和问题,特别是在处理高维数据、大规模数据和复杂数据结构时表现优异。它被广泛应用于分类、回归、特征选择等任务中,并在实践中取得了很好的效果。

五、Decision Tree

决策树是一种广泛使用的机器学习算法,可用于分类和回归任务。它通过树状结构模型化决策及其可能的结果。以下是决策树的工作原理、组成部分和一些关键概念的概述:

决策树的组成部分

-

根节点:树的顶部节点,代表整个数据集,然后将其分成两个或多个同质集合。

-

内部节点:基于属性做出决策的节点。每个内部节点基于一个特征和一个阈值将数据集分割成子集。

-

叶节点(终端节点):代表最终输出或类别标签的节点。对于回归任务,这可能是一个数值;对于分类任务,则是一个类别标签。

决策树的工作原理

-

特征选择:算法选择最能根据某个标准(如基尼不纯度、信息增益或均方误差)分割数据的特征。

-

分割:选择的特征将数据集分割成子集。这个过程对每个子集递归进行,创建分支。

-

停止条件:递归在满足某个停止条件时终止,例如最大树深度、每个叶节点的最小样本数或没有进一步的信息增益。

-

预测:一旦树建立完毕,可以通过从根节点根据输入数据的特征到叶节点的路径进行预测。

关键概念

- 基尼不纯度:衡量数据集的不纯度或不确定性;由CART(分类和回归树)算法使用。

- 熵和信息增益:由ID3(迭代二分器3)和C4.5算法使用,以衡量不确定性的数量及其在分割后的减少量。

- 剪枝:通过移除对分类实例贡献较小的节点来减小树的规模,有助于防止过拟合。

优点

- 易于解释:决策树直观且易于可视化。

- 非参数模型:不假设任何底层分布。

- 处理数值和分类数据:可用于这两种类型的数据,而无需显著的预处理。

缺点

- 过拟合:如果不加以控制(通过剪枝、设置深度),决策树很容易对训练数据过拟合。

- 偏差方差权衡:对训练数据高度敏感;小的变化可能导致完全不同的树。

- 复杂树:当数据集很大或噪声很多时,树可能变得非常复杂且难以解释。

六、Z检验

Z检验是一种假设检验方法,用于确定样本均值与总体均值之间的差异是否显著。这种检验通常适用于大样本或已知总体方差的情况。Z检验包括单样本Z检验、双样本Z检验和比例Z检验等。以下是Z检验的详细说明:

单样本Z检验

单样本Z检验用于比较样本均值和已知总体均值,以确定它们之间的差异是否显著。

公式

双样本Z检验

双样本Z检验用于比较两个独立样本的均值,以确定它们之间的差异是否显著。

公式

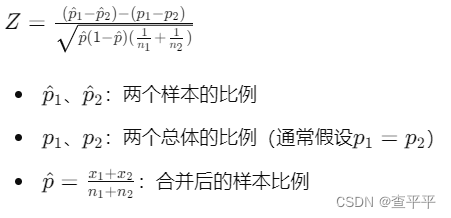

比例Z检验

比例Z检验用于比较样本比例和总体比例,或者比较两个样本比例之间的差异。

单样本比例Z检验公式

双样本比例Z检验公式

七、 Logistic回归模型

Logistic回归模型是一种用于分类任务的广泛使用的机器学习算法,特别是二元分类问题。它通过估计特征与目标变量之间的关系,预测目标变量的概率。Logistic回归模型的核心是逻辑函数(也称为sigmoid函数),它将任意实数值映射到0和1之间。

逻辑函数

逻辑函数的形式如下:

逻辑回归的工作原理

优点

- 简单易理解:逻辑回归是一个简单而易于理解的模型。

- 计算效率高:训练和预测速度快,适用于大规模数据集。

- 可解释性强:模型参数可以解释为特征对预测结果的影响。

缺点

- 线性假设:逻辑回归假设特征与目标变量之间存在线性关系,对于非线性关系的建模能力有限。

- 易受异常值影响:异常值可能对模型产生显著影响。

- 不能自动处理特征交互:需要手动创建交互特征。