【LSTM结合Transformer】 的研究方向探索了如何利用Transformer 模型处理序列数据的能力以及LSTM在捕捉时间序列依赖性方面的优势。这一方向的意义在于通过融合两种模型的特点,提高了对复杂时空数据的预测准确性,尤其是在智能电网攻击检测、多变量时间序列预测和时空预测等领域。研究结果表明,这种混合模型能够有效地捕捉数据中的时空特征,增强了模型对长期依赖关系的学习能力,并在多个数据集上实现了性能上的提升。近年来,无数的研究者们对LSTM结合Transformer这个领域的进行了大量研究,并产出了大量的学术成果。

这种策略结合了两者的优势,在各种序列分析任务中实现了更精确的预测、更好的性能表现、更高的训练效率 。比如登上Nature子刊的最新混合架构,以及**精度高达95.65%**的BiLSTM-Transformer。

为了帮助大家全面掌握**【LSTM结合Transformer】** 的方法并寻找创新点,本文总结了最近两年 【LSTM结合Transformer】 相关的16篇前沿研究成果,这些论文、来源、论文的代码都整理好了,希望能给各位的学术研究提供新的思路。

需要的同学 扫码添加我

回复"LSTM16 "即可全部领取

1、XTM: A Novel Transformer and LSTM-Based Model for Detection and Localization of Formally Verified FDI Attack in Smart Grid

方法:

-

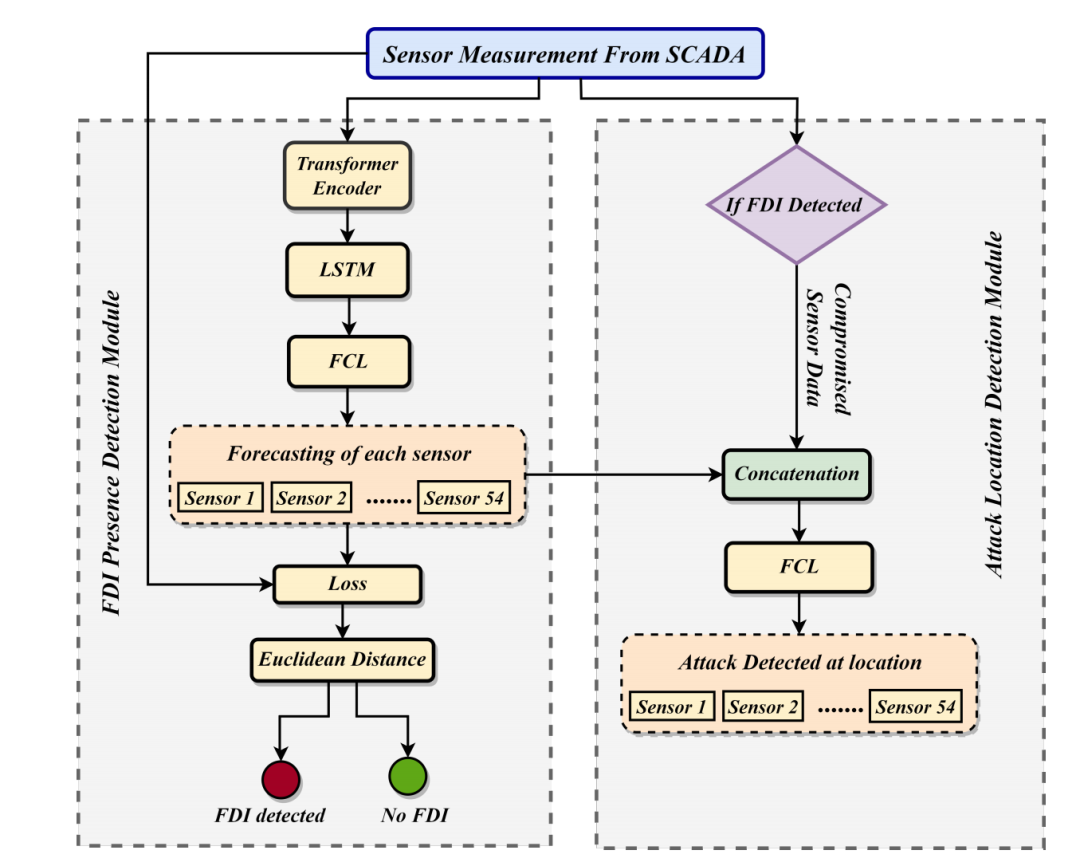

该论文提出了一种名为XTM的新型混合深度学习模型,用于实时检测和定位智能电网中的虚假数据注入(FDI)攻击。

-

XTM模型结合了变换器(Transformer)和长短期记忆网络(LSTM),是首个在该研究领域探索变换器性能的混合深度学习模型。

-

论文首先引入了一种新的阈值选择方案,以检测FDI的存在,取代了传统的坏数据检测(BDD)算法。

-

接着,使用多标签分类方法定位攻击的确切入侵点。

-

为了操纵数据集,使用了基于正式验证的约束满足攻击向量模型。

-

在IEEE-14总线系统中,考虑了电力系统的时序特性,使用小时和分钟级的传感器数据来训练和评估所提出的模型,实现了接近100%的检测准确率。

-

还评估了位置检测模块的行准确率(RACC),对于小时和分钟级数据集,值分别为92.99%和99.99%。

创新点

-

混合模型架构:XTM是首个将变换器和LSTM结合用于FDI攻击检测的模型,利用了变换器在处理序列数据方面的优势。

-

实时监测与预测:XTM能够实时预测传感器测量值,独立于系统参数,使其能够有效地作为电网入侵时的FDI攻击缓解工具。

-

阈值选择方案:提出了一种新的阈值选择方案,提高了对FDI攻击存在性的检测准确性,取代了传统的BDD方法。

-

多标签分类定位:使用多标签分类方法来确定攻击的确切位置,这种方法在检测攻击位置方面提供了更高的灵活性和准确性。

-

数据集和攻击向量的公开:论文提供了详细的数据集和攻击向量描述,并将它们公开在GitHub上,促进了研究社区的进一步研究和模型验证。

-

高准确率:在IEEE-14总线系统上进行的测试显示,XTM模型在检测FDI攻击及其位置方面,相比文献中提到的其他深度学习方法,展现出了更高的性能。

-

考虑时序特性:模型训练和评估考虑了电力系统的小时级和分钟级数据,增强了模型对实时数据的适应性和准确性。

2、SwinLSTM: Improving Spatiotemporal Prediction Accuracy using Swin Transformer and LSTM

方法:

-

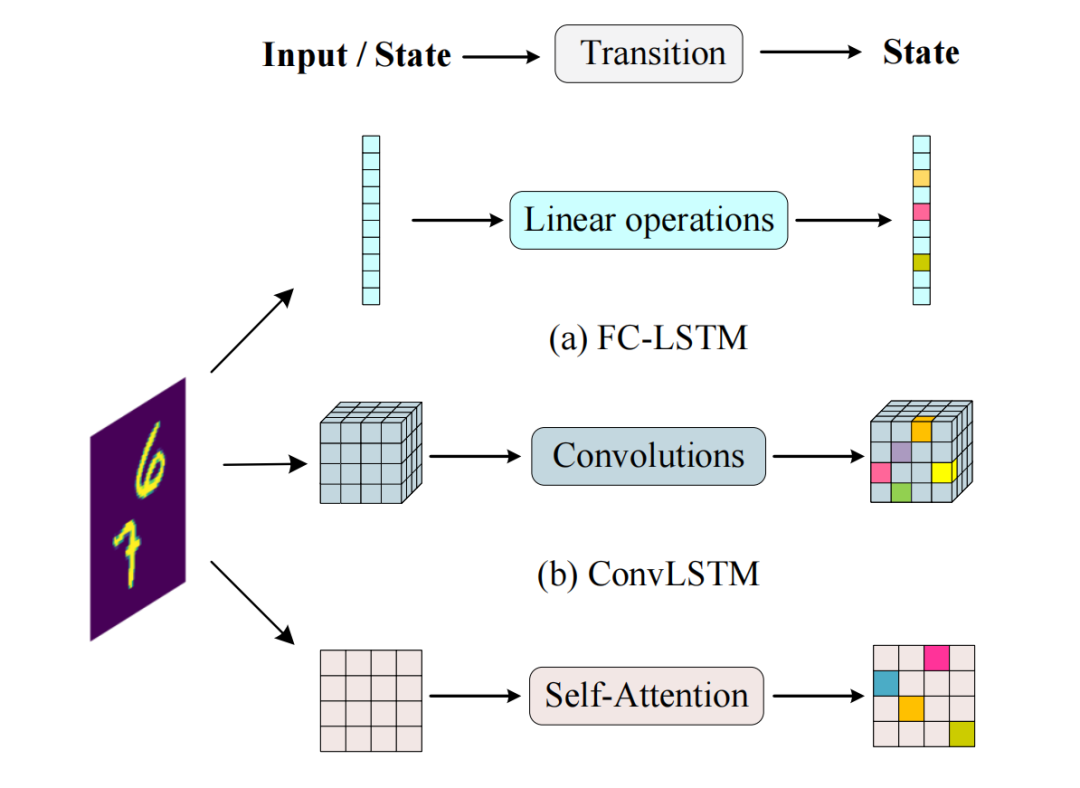

该论文提出了一种新的循环单元SwinLSTM,用于提高时空预测的准确性。

-

SwinLSTM结合了Swin Transformer模块和简化版的LSTM,替代了ConvLSTM中的卷积结构,引入自注意力机制。

-

论文构建了一个以SwinLSTM单元为核心的网络架构,用于时空预测任务。

-

该架构首先将输入图像分割成一系列图像块,然后将这些图像块展平并输入到嵌入层。

-

SwinLSTM层接收嵌入后的图像块或前一层(Patch Merging或Patch Expanding)转换后的隐藏状态,并结合前一时间步的细胞和隐藏状态来提取时空表示。

-

最后,重建层将时空表示解码生成下一帧。

创新点

-

SwinLSTM单元:提出了一种新的循环单元,有效结合了Swin Transformer的全局空间建模能力和LSTM的时间序列建模能力。

-

自注意力机制:使用自注意力机制代替传统的卷积操作,以捕获全局空间依赖性,这在传统的CNN中是难以实现的。

-

架构设计:构建了一个以SwinLSTM单元为核心的预测网络,该网络能够同时有效地模拟空间和时间依赖性。

-

无特定技巧:SwinLSTM在没有使用特定技巧的情况下,超越了现有的最先进方法,这表明了其方法的通用性和有效性。

-

跨数据集验证:在多个数据集(Moving MNIST、Human3.6m、TaxiBJ和KTH)上进行了实验验证,证明了SwinLSTM的优越性能和泛化能力。

-

性能提升:与ConvLSTM相比,SwinLSTM在预测精度上表现出显著提升,这强调了学习全局空间依赖性对于捕获时空依赖性的重要性。

需要的同学 扫码添加我

回复"LSTM16 "即可全部领取

3、TCLN: A Transformer-based Conv-LSTM network for multivariate time series forecasting

方法:

-

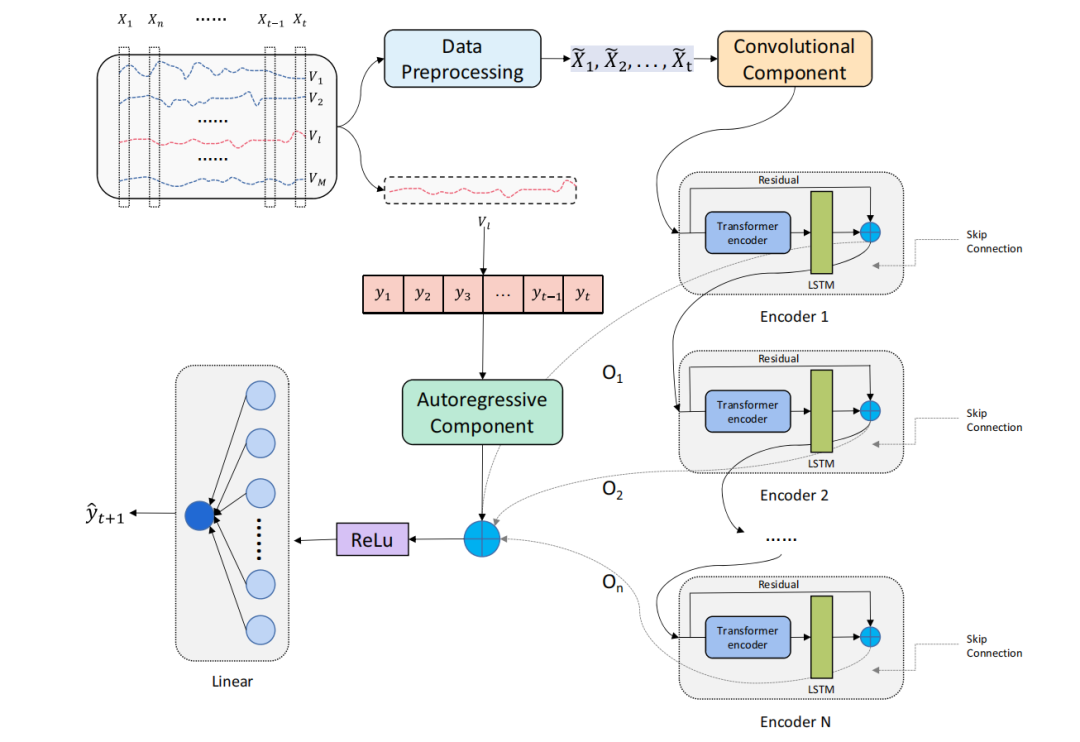

该论文提出了一种基于Transformer、卷积神经网络(CNN)和长短期记忆网络(LSTM)的新型模型,用于解决多变量时间序列预测(MTSF)问题

-

模型首先通过提出的多核CNN模块提取空间特征向量

-

然后,通过包含Transformer编码器层和LSTM网络的编码器层来充分提取时间信息,同时获得潜在的时空相关性

-

为了提取更多的特征信息,模型堆叠了多个编码器层。

-

最后,输出通过由ReLU激活函数和线性层组成的解码器层进行解码。

-

为了提高模型的鲁棒性,还集成了一个自回归模型。

创 新点:

-

多核CNN模块:与传统卷积层相比,多核CNN模块具有更深的感受野,能够提取变量间的更多空间信息。

-

编码器层的结合:Transformer编码器层与LSTM网络的结合,不仅能够处理长序列输入,还能从输入顺序的角度有效获取时间信息。

-

堆叠编码器层:通过堆叠多个编码器层,模型能够更充分地提取特征信息。

-

自回归模型集成:自回归模型的加入,增强了模型对目标变量过去序列线性相关的提取能力,提升了预测精度。

-

多变量时间序列预测:模型针对多变量时间序列预测任务进行了特别设计,能够处理复杂的非线性关系和长期依赖问题。

-

多数据集验证:在包括经济、气候、能源和工业产品产量的四个数据集上验证了模型性能,证明了模型的泛化能力。

-

长时域预测能力:模型在长时域预测任务上表现出色,能够满足实际应用中对长期预测的需求。

需要的同学 扫码添加我

回复"LSTM16 "即可全部领取