随着大型语言模型 (LLM)(例如Llama 2和Llama 3)不断突破人工智能的界限,它们正在改变我们与周围技术的互动方式。这些模型早已集成到我们的手机中,但到目前为止,它们理解和处理请求的能力还非常有限。然而,这些新型LLM人工智能模型可以理解和生成类似人类的文本,使它们成为增强语音助手、聊天机器人和其他自然语言处理任务等应用程序的理想选择。

然而,这些 AI 模型的一个主要限制是它们需要大量资源才能运行计算。虽然桌面应用程序可以利用强大的CPUs 和GPUs,但手机的硬件却有限得多。更困难的是,由于我们的移动设备几乎一直伴随着我们,隐私也是一个更大的问题。网络连接也是一个问题,因为快速可靠的信号并不能保证。因此,为了最大限度地利用Llama 3Android 设备上的东西,我们必须在设备上离线运行它。

我们在 Android 手机上没有太多这样的选择。话虽如此,也有些工具可让您在 Android 设备上本地下载和运行 LLM 模型。您可以下载小型 AI 模型(2B 到 8B),如Llama 3、Gemma、Phi-2、Mistral 等。就此而言,让我们开始吧。

在本文中,我们将探讨如何在 Android 设备上运行小型轻量级模型,例如 Gemma-2B、Phi-2 和 StableLM-3B 。

具体操作

克隆此repo以访问并使用作为示例提供的演示 Android 应用程序git clone https://github.com/googlesamples/mediapipe

cd mediapipe

git sparse-checkout init --cone

git sparse-checkout set examples/llm_inference/android

接下来,下载您选择的量化 LLM 模型。目前,文档仅支持四种模型:Gemma 2B、Phi-2、Falcon-RW-1B 和 StableLM-3B。

为了避免兼容性问题,请在下载过程中使用此 Colab 笔记本:LLM 转换笔记本。

现在您已经下载了 model.bin 文件,您需要将其传输到您的 Android 设备。您可以使用命令adb shell推送文件,如文档中所述

有关使用 Android 调试桥 (ADB) 的更多详细信息,请参阅本文:了解 Android 调试桥 (ADB)。

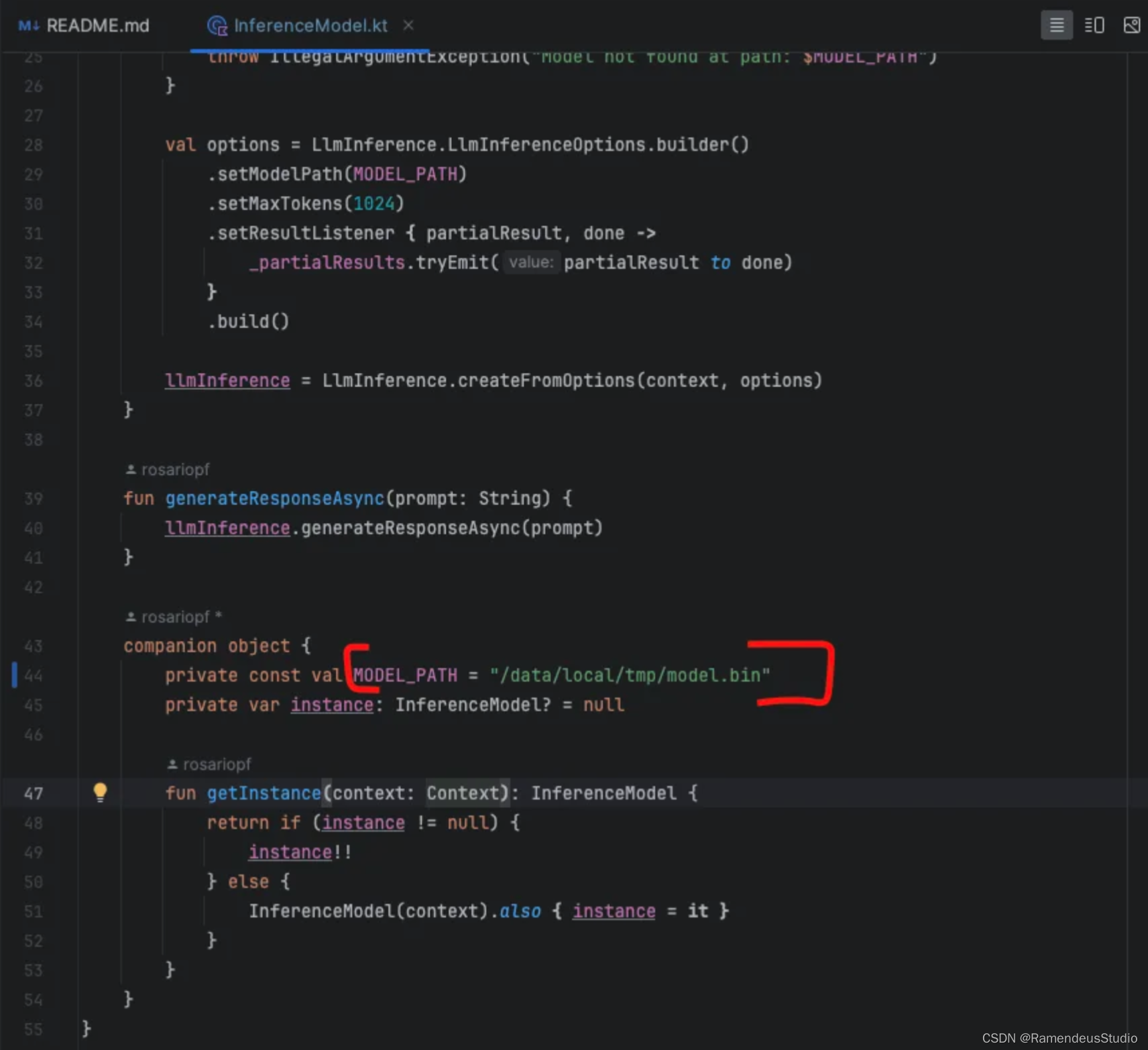

传输模型后,导航到InferenceModel.kt位于以下位置的文件:mediapipe/examples/llm_inference/android/app/ src / main /java/com/google/mediapipe/examples/llminference

在此文件中,修改generateResponseAsync函数以更新模型路径,以反映您在手机上存储模型的位置

接下来,将 Android 应用程序构建为 APK 文件,并将其安装在 Android 手机上

演示

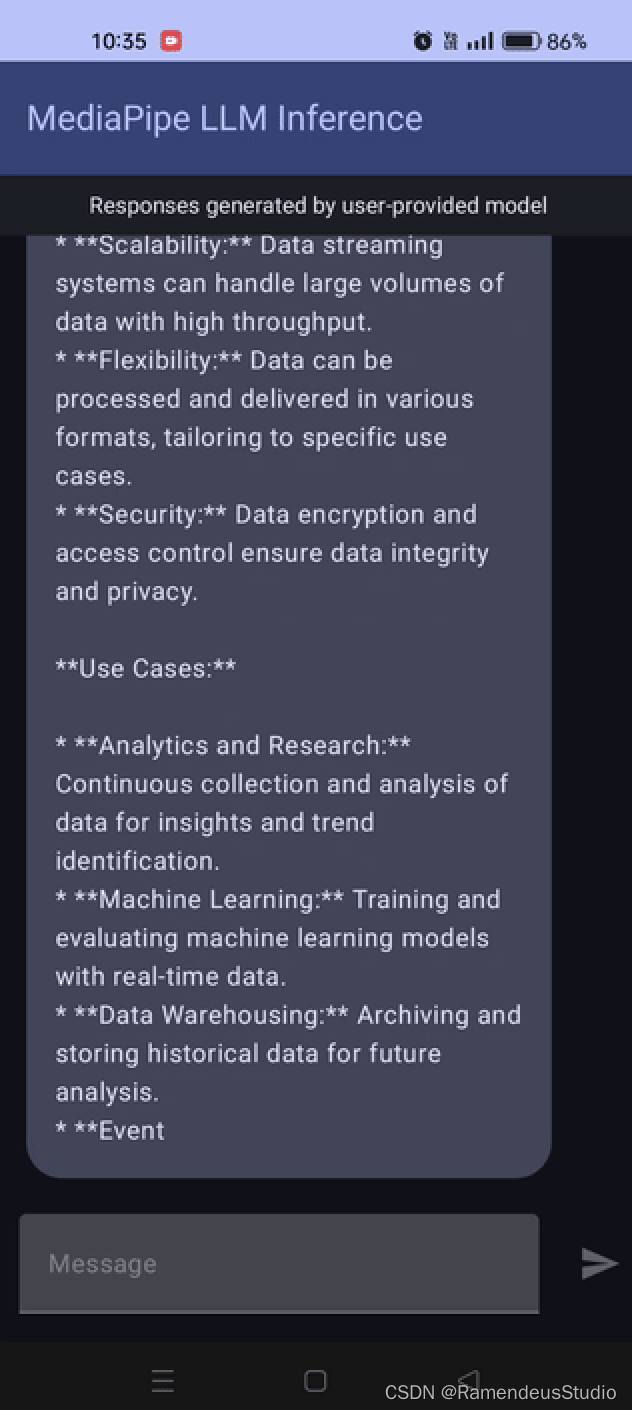

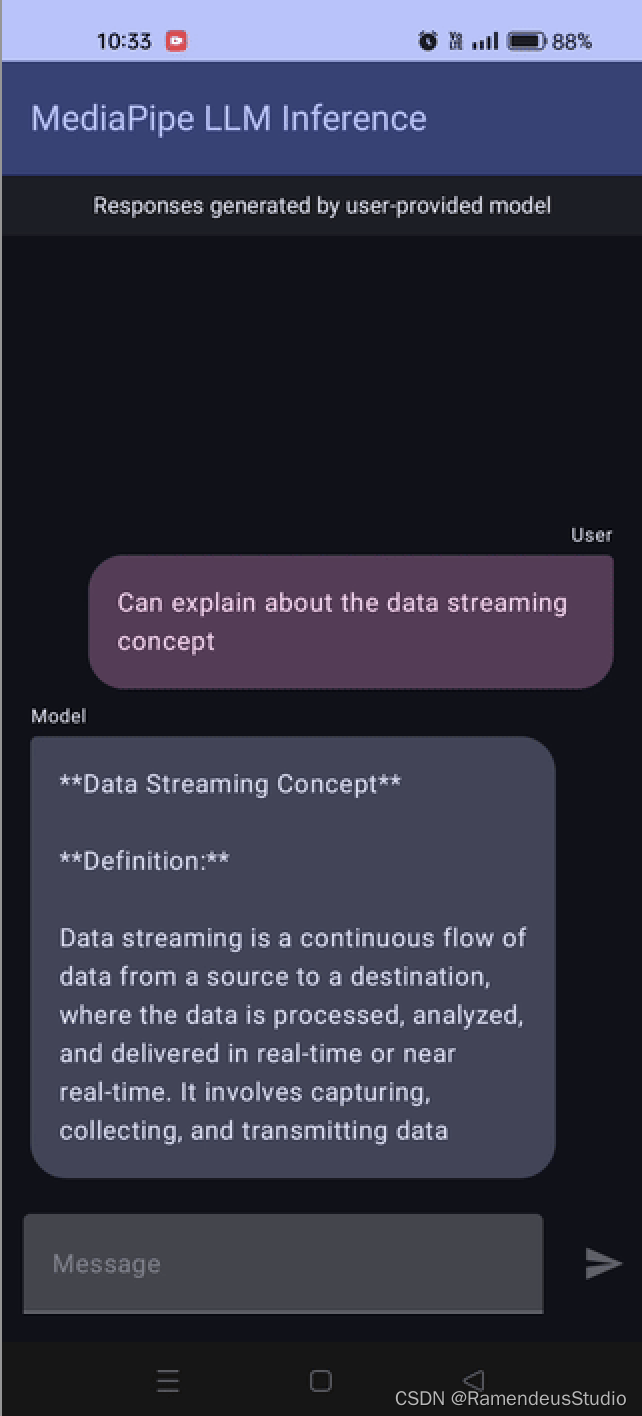

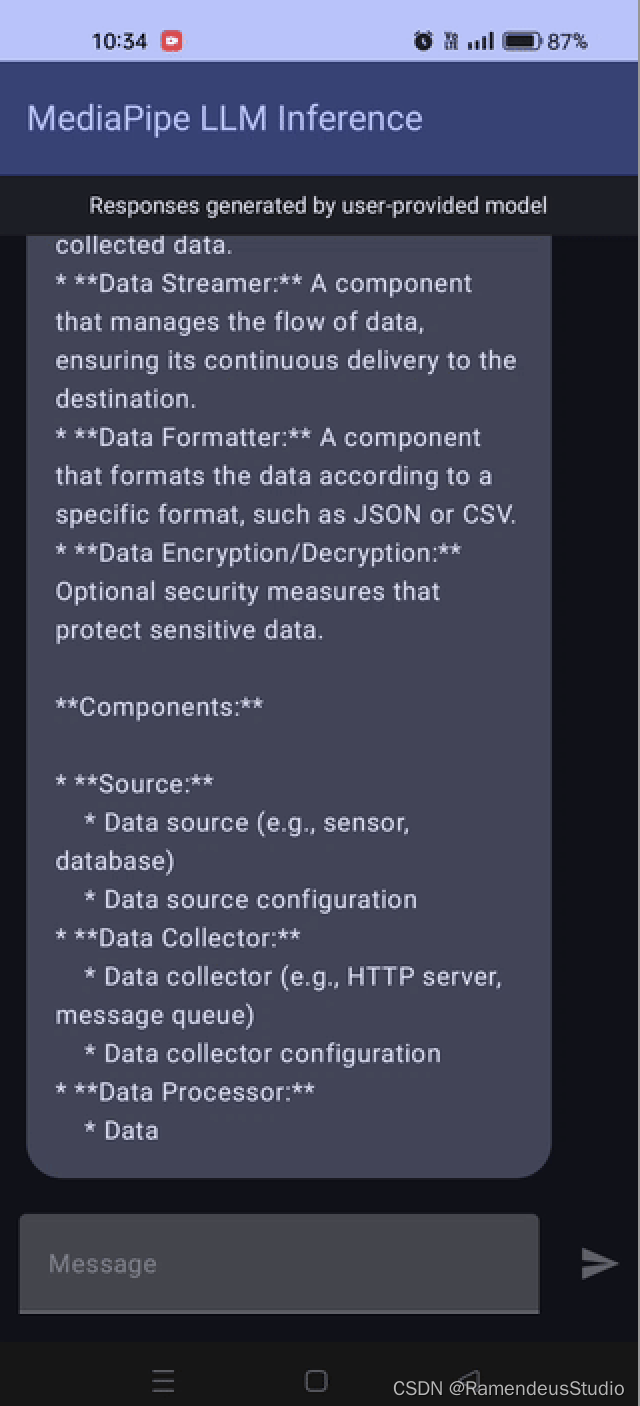

为了演示,我在搭载骁龙 778 芯片的 Android 手机上测试了 Gemma-2B 4 位模型并检查了结果。

结论

在 Android 手机上运行小型轻量级模型效果很好 。在演示中,我们使用了搭载骁龙 芯片的手机。响应需要几秒钟,结果并不完美,可能是因为使用了量化模型

然而,关键的一点是在设备上运行轻量级 LLM 相当令人印象深刻,表明这些模型变得更加高效👍。

欢迎你分享你的作品到我们的平台上. http://www.shxcj.com 或者 www.2img.ai 让更多的人看到你的才华。

创作不易,觉得不错的话,点个赞吧!!!