Llama 3.1在代码生成方面的卓越表现

在代码生成领域,Llama 3.1的表现尤为出色,几乎成为了开源模型中的佼佼者。它不仅在代码自动化和生成方面表现突出,还可以作为AI编程助手,帮助调试代码和开发完整的应用程序。在多个基准测试中,Llama 3.1的表现几乎与GBT-4 Omni和Claude 3.5 Sonic持平,甚至在某些情况下超越了这些模型。

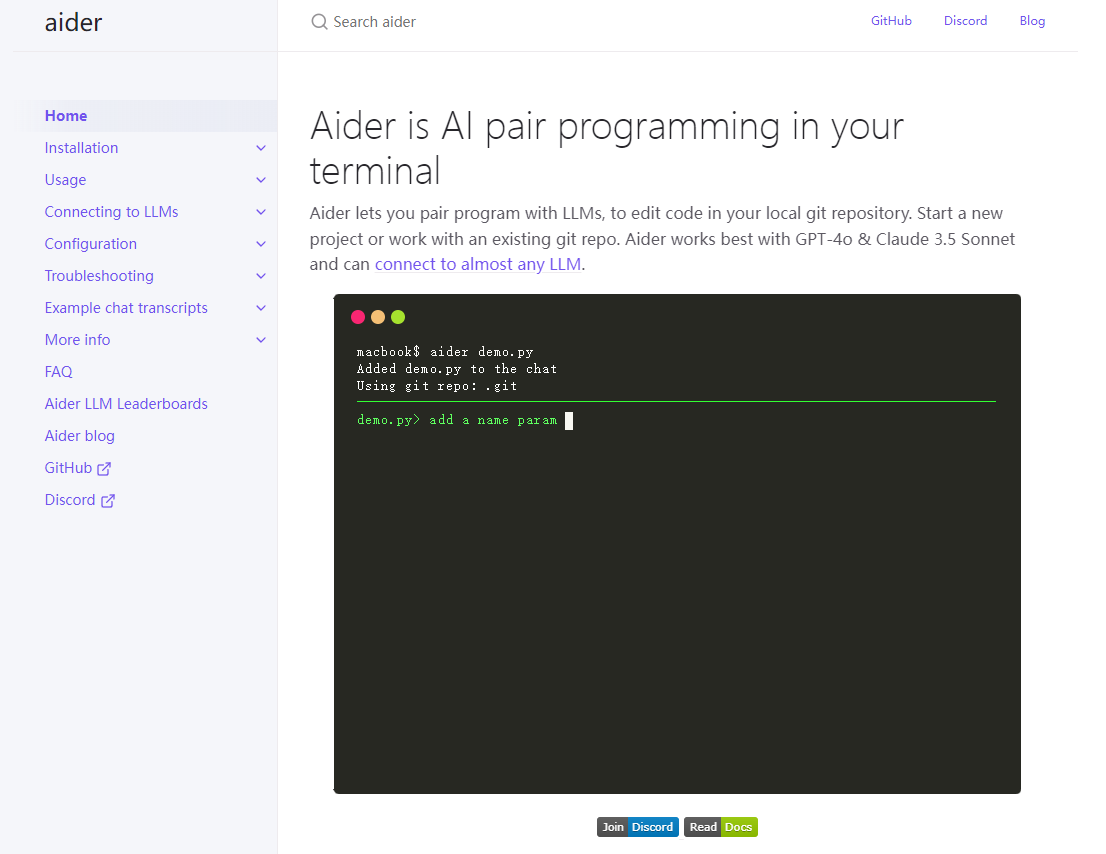

今天我们将展示如何将新的Llama 3.1与Aider搭配使用。Aider是一款可以在终端中访问的AI编程助手,能够显著提升代码生成能力,支持调试等多种功能。今天我们将展示如何将Llama 3.1连接到Aider,以创建无需任何代码的全栈应用程序。

开始之前的准备工作

在开始之前,你需要确保你的计算机上已经安装了ollama,这是运行大型模型的基础。你还需要安装Python和pip,并确保安装了git以便克隆仓库。完成这些必要的准备工作后,我们就可以开始了。

安装和配置Llama 3.1

首先,你需要在ollama网站上搜索并下载Llama 3.1模型。根据需要选择要安装的模型,例如8亿参数的轻量级模型,然后在命令提示符中运行相应的命令进行下载和安装。安装完成后,你可以通过输入简单的命令来测试模型是否正常工作。

安装和配置Aider

接下来,你需要在命令提示符中运行pip install aider-chat来安装Aider。安装完成后,你需要将你的ollama或ollama API基础设置为本地主机。根据你的操作系统选择适当的命令,然后在命令提示符中运行。设置成功后,你可以开始使用Aider与Llama 3.1进行互动。

实例演示:生成UI组件和完整的网站

现在我们来实际操作,首先生成一个简单的按钮。只需在Aider中输入生成按钮的命令,几秒钟后你就会看到生成的HTML代码。将代码复制到HTML在线查看器中,你可以看到一个简单的"点击我"按钮已经生成。

接下来,我们尝试生成一个更复杂的SaaS网站。输入相关命令后,Aider会生成一段HTML代码,包含定价计划和其他必要信息。虽然某些组件可能需要进一步调整,但基本的现代网站结构已经生成。

总结与推荐

通过这些实例,我们可以看到Llama 3.1在代码生成和应用程序开发方面的强大能力。尤其是当与Aider结合使用时,它可以显著提升开发效率。建议你尝试将ollama服务器与Aider结合使用,并部署在AWS或其他云提供商上,以充分发挥405亿参数模型的能力。

希望这篇文章对你有所帮助,也希望你能尝试使用Llama 3.1和Aider来提升你的开发效率。如果你有任何问题或需要更多信息,可以查看本文中提到的链接和资源。