0. 引言

图像分割就是把图像空间按照一定的要求分成一些"有意义"的区域的技术叫图像分割。

一幅图像通常是由代表物体的图案与背景组成,简称物体与背景。若想从一幅图像中"提取"物体,可以设法用专门的方法标出属于该物体的点,如把物体上的点标为"1",而把背景点标为"0",通过分割以后,可得一幅二值图像。

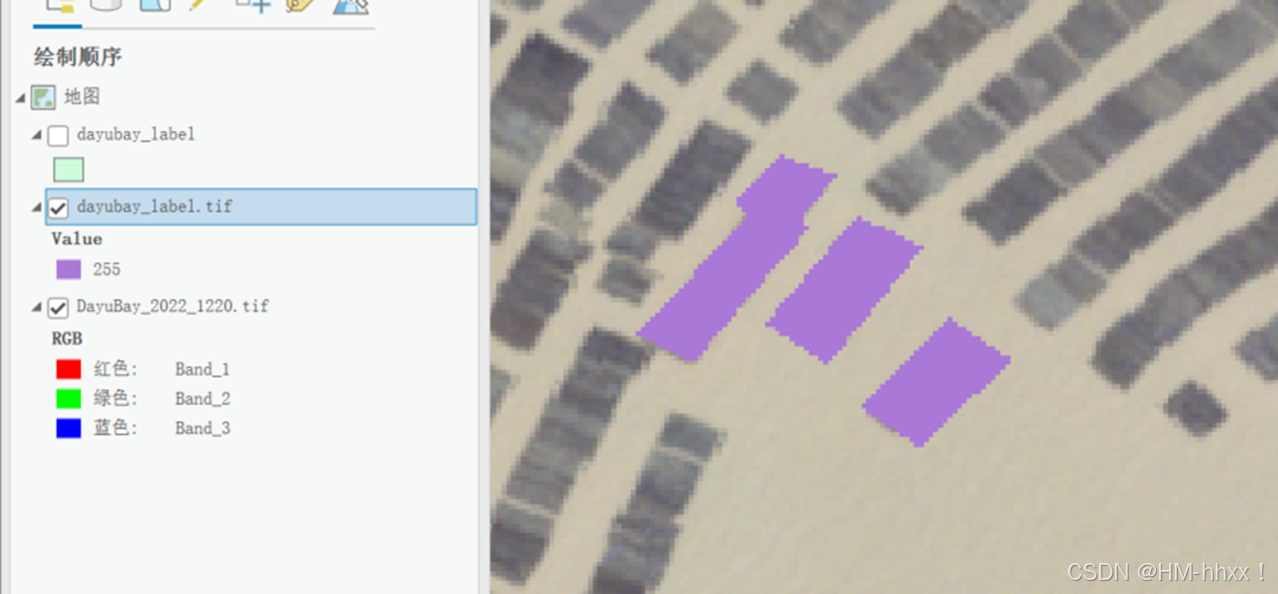

如图所示,我们将遥感图像中目标地物作为前景,通过语义分割网络实现前景与背景之间的分割:

1. 数据获取

遥感数据获取的方式有很多,主要包括自身项目获取的商业卫星影像(如高分系列卫星数据等)和通过网站下载获取的开源免费的遥感卫星数据(如Landsat、Sentinel、MODIS等)。下面列举了一些用于获取常用的免费的遥感卫星数据的网站:

1.1 欧空局ESA 哨兵数据

Copernicus Data Space 是ESA提供的在线数据服务平台,主要提供Sentinel卫星数据。用户需要注册账号后,可以通过该平台检索和下载Sentinel数据。Copernicus Data Space 生态系统 |欧洲的地球之眼![]() https://dataspace.copernicus.eu/

https://dataspace.copernicus.eu/

1.2 Earth Data地球科学数据系统(NASA)

地球科学数据系统 (ESDS) 计划提供对 NASA 地球科学数据收集的全面和开放访问,提供了多种遥感数据,包括MODIS、ASTER等。用户可以在该网站上注册账号,并通过不同的工具获取数据,如NASA Worldview、NASA GIBS等。

Earthdata | Earthdata (nasa.gov)![]() https://www.earthdata.nasa.gov/

https://www.earthdata.nasa.gov/

1.3 Google Earth Engine(GEE)

GEE是一个在线的遥感数据处理平台,提供了全球范围内多种遥感数据。用户可以通过编写JavaScript代码在平台上进行数据处理和下载,包括Landsat、Sentinel、MODIS等系列卫星的遥感影像数据。

https://developers.google.com/earth-engine/![]() https://developers.google.com/earth-engine/

https://developers.google.com/earth-engine/

1.4 地理空间数据云

地理空间数据云是中国科学院计算机网络信息中心下属数据平台,具有包括Landsat、MODIS、Sentinel等常见遥感数据,也包括高分1/2/3/4/5/6号、资源三号等国产数据。

地理空间数据云![]() https://www.gscloud.cn/home

https://www.gscloud.cn/home

1.5 NOAA系列卫星数据

NOAA(美国国家海洋和大气管理局)的卫星系列广泛应用于科研、气象预报、环境监测和灾害管理等领域。如GOES(地球静止环境卫星)系列,提供实时天气监测和预报,能够跟踪风暴、温度、湿度等气象参数。POES(极地轨道环境卫星)系列和JPSS(联合极地卫星系统),获取全球气候数据,监测温度、降水、海冰覆盖等。SST(海表温度)和海洋色素数据,有助于研究海洋生态系统和气候变化。此外,NOAA系列卫星还可以提供关于温室气体、气溶胶和臭氧层等大气成分的数据,支持环境和气候变化研究。

国家环境卫星、数据和信息服务 (noaa.gov)![]() https://www.nesdis.noaa.gov/

https://www.nesdis.noaa.gov/

1.6 吉林一号高分辨率影像

"吉林一号"卫星遥感影像已广泛应用于国土资源监测、土地测绘、矿产资源开发、智慧城市建设、交通设施监测、农业估产、林业资源普查、生态环境监测、防灾减灾及应急响应等领域。

该系列卫星数据可通过教育认证形式申请免费数据使用,分辨率可达亚米级!!

吉林一号网 (jl1mall.com)![]() https://www.jl1mall.com/

https://www.jl1mall.com/

2. 数据标注

在计算机视觉任务中,尤其是在图像分割领域,数据标注通常使用Labelme工具进行目标标记。然而,与常规RGB图像(如.jpg和.png格式)不同,遥感图像通常包含更多的数据通道(如.tif格式),并且包含丰富的空间坐标信息。因此,使用传统的数据标注方法往往会导致重要属性信息的丢失。

在接下来的部分,我们将以ArcGIS Pro工具为例,进行遥感图像的数据人工标注,以便为深度学习模型的训练提供高质量的输入数据。通过这种方式,我们可以更好地保留遥感图像的多维信息,从而提高模型的性能和准确性。

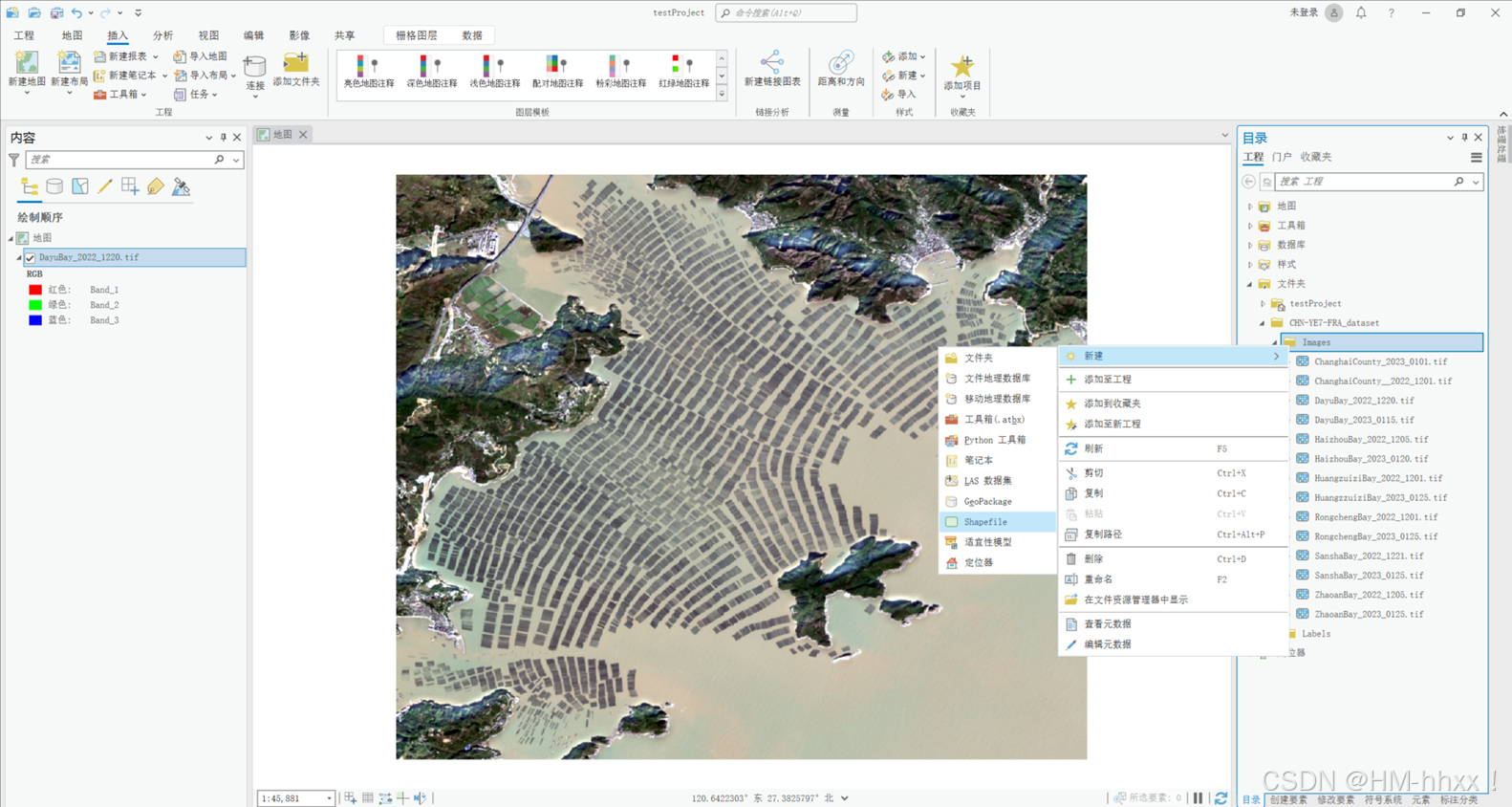

2.1 加载遥感影像

2.2 新建shapefile(矢量)文件

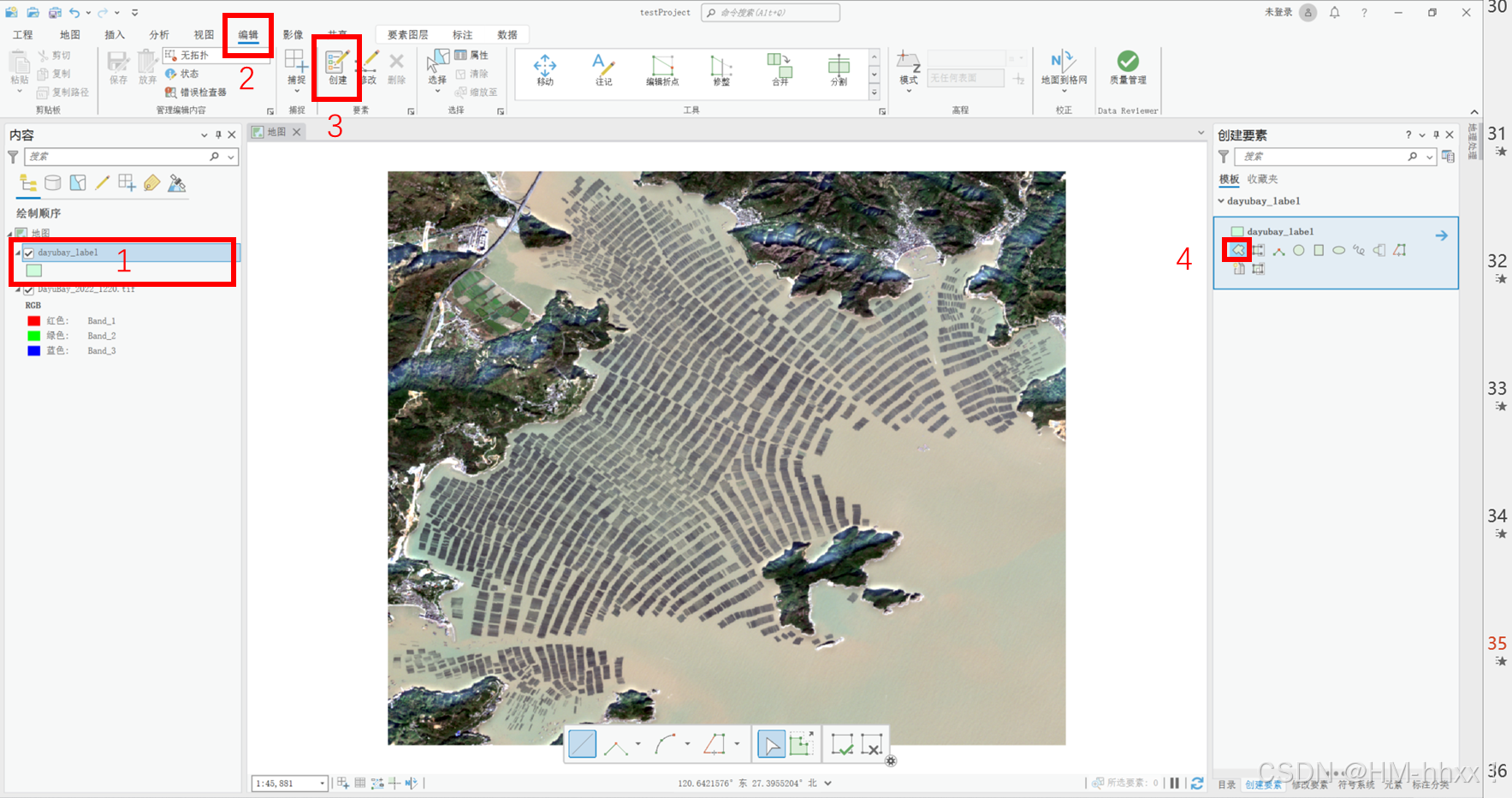

2.3 标注目标地物

1. 选中新建的shapefile图层

2. 选择编辑

3. 点击创建

4. 选择面

5. 开始勾画索要提取的区域

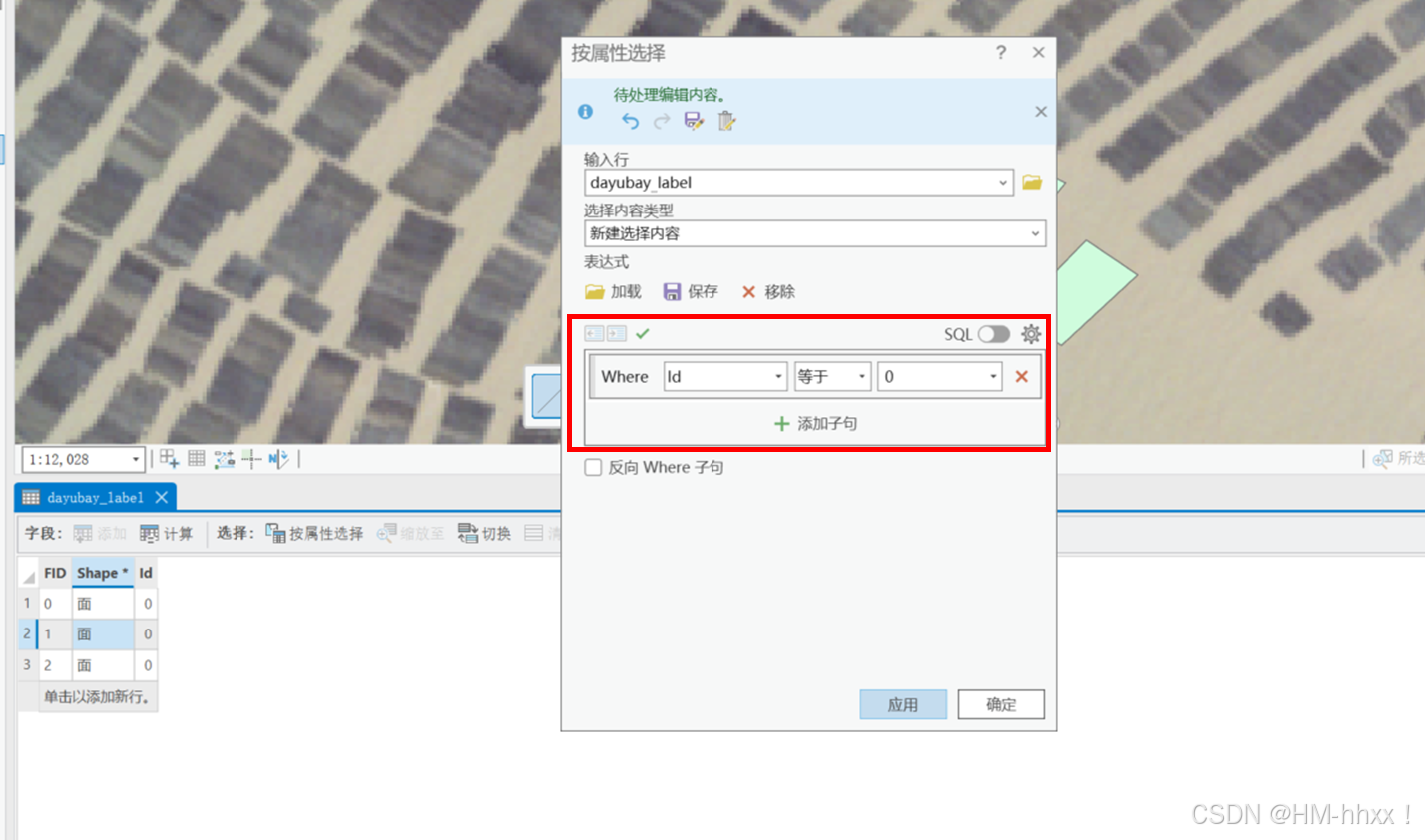

2.4 设置属性值

1.选中新建的shapefile图层

2.右键该图层打开属性表

3.点击按属性选择

4.选择所有id=0的数据

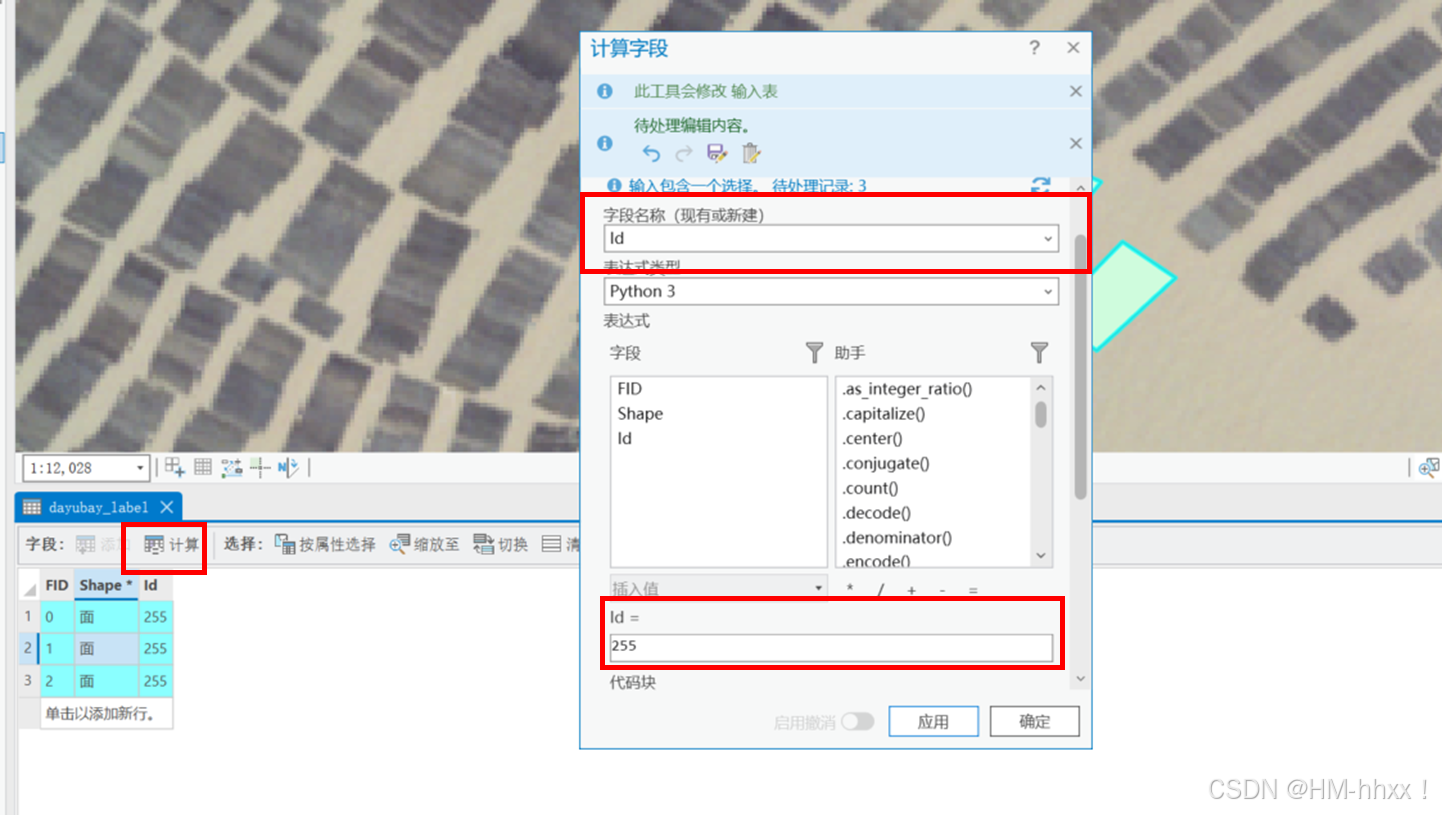

5.点击计算

6.在计算字段的选项框中字段名称选择id,选择插入值选项,并将插入值=255

注:值255后续可用于创建Label文件时作为目标地物的像元值,该部分也可以在开始时新建一个属性字段value用于保存目标地物的像元值。

当目标地物为多个类别时,可采用不同的像元灰度值作为每一类地物的标识,如128,255等,背景为0

7.点击确定

2.5 将矢量标注文件转换为栅格数据

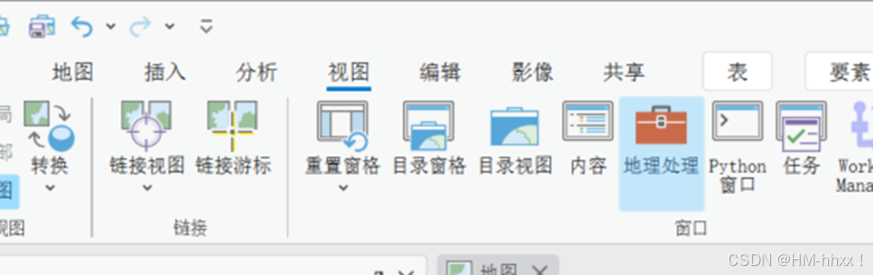

1.在顶部的视图选项中选择地理处理选项

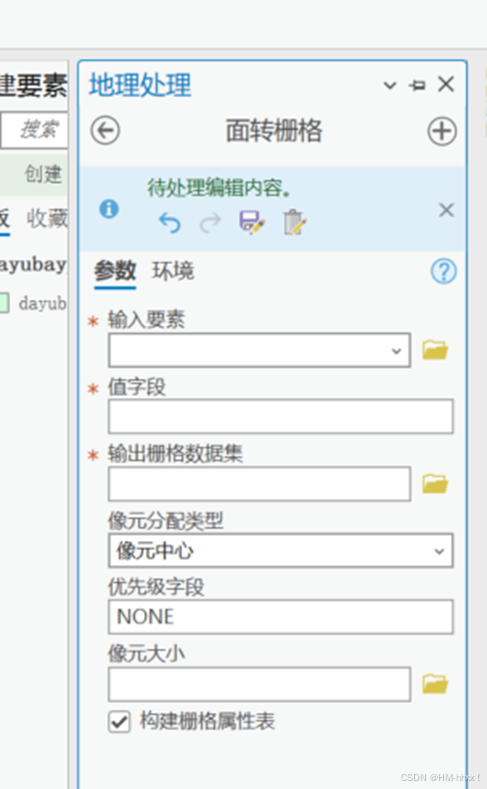

2. 查找面转栅格工具

3. 在面转栅格的工具栏内进行设置

!!在该部分中,输入要素选择最开始创建的shapefile图层, 值字段选择所设置像元灰度值的字段名称,输出的栅格数据集选择自己的路径,像元分配类型以像元中心,像元大小选择进行标注的影像。

!!随后点击环境配置,在该部分中,像元大小,捕获栅格输出的坐标均要以最开始参考的影像一致,不然会出现导出的栅格图层与原始的影像像元数不对应的情况。

最后点击运行,便可将所标注的矢量转为栅格数据(.tif格式),并在ArcGIS Pro中检查该标注栅格是否与原始影像的栅格像元数大小一致**。**

3. 数据集制作

在初步标注数据后,我们将获得一对影像:原始的遥感影像和相应的标注影像。然而,由于遥感影像的像元数量(即宽度和高度)往往较大且不规则,而深度学习模型的训练则需要规则的像元大小(如256×256或512×512),因此需要对数据进行进一步处理,以符合网络训练的要求。

接下来,我们将采用Python和GDAL库进行数据的滑动裁剪,以生成符合训练需求的标准化影像。这一过程不仅能保证影像的连续性和完整性,还能有效提高模型的训练效率和准确性。

3.1 滑动裁剪

下面这段代码用于对遥感影像进行滑动裁剪,以生成适合深度学习模型训练的数据集。

代码的主要功能分为三个部分:读取影像、滑动裁剪和保存裁剪结果。

-

读取数据 :

read_image函数使用GDAL库读取指定路径的影像文件。可以选择读取特定波段或所有波段,并将影像数据以NumPy数组的形式返回。如果影像无法打开,将返回None。 -

滑动裁剪 :

sliding_crop函数对读取的影像进行裁剪。首先,计算是否需要在图像的边缘进行填充,以确保裁剪窗口的完整性。然后,利用指定的窗口大小和步长,在影像上进行滑动裁剪,生成多个裁剪的小图像,这些小图像被存储在列表中并返回。 -

保存数据 :

save_crops函数负责将裁剪后的影像保存到指定目录中。首先检查输出目录是否存在,不存在则创建之。接着,通过检查现有文件,确保新文件的命名不与已有文件冲突。每个裁剪图像使用连续的索引命名。save_image函数使用GDAL库将影像数据保存为GeoTIFF格式。

在主程序部分,代码读取原始影像和标注影像,确保它们的尺寸相同后,执行裁剪并保存结果。如果尺寸不一致,程序会输出相应的错误信息。整体流程高效且易于扩展,适合处理大规模遥感影像数据集。

python

import os

from osgeo import gdal

import numpy as np

from tqdm import tqdm

# 读取数据

def read_image(image_path, num_bands=None, selected_bands=None):

dataset = gdal.Open(image_path)

if dataset is None:

print(f"Could not open image: {image_path}")

return None

else:

if num_bands is None:

num_bands = dataset.RasterCount

image_data = []

for i in range(1, num_bands + 1):

if selected_bands is not None and i not in selected_bands:

continue

band = dataset.GetRasterBand(i)

band_data = band.ReadAsArray()

image_data.append(band_data)

return np.array(image_data)

# 滑动裁剪

def sliding_crop(image, window_size=(512, 512), stride=256):

height, width = image.shape[1], image.shape[2]

# 计算需要填充的高度和宽度

pad_height = 0

pad_width = 0

if height % window_size[0] != 0:

pad_height = window_size[0] - (height % window_size[0])

if width % window_size[1] != 0:

pad_width = window_size[1] - (width % window_size[1])

# 在图像右侧和下侧填充0值

padded_image = np.pad(image, ((0, 0), (0, pad_height),

(0, pad_width)), mode='constant', constant_values=0)

crops = []

for y in range(0, height + pad_height - window_size[0] + 1, stride):

for x in range(0, width + pad_width - window_size[1] + 1, stride):

crop = padded_image[:, y:y+window_size[0], x:x+window_size[1]]

crops.append(crop)

return crops

# 保存数据

def save_crops(crops, output_dir):

if not os.path.exists(output_dir):

os.makedirs(output_dir)

existing_files = os.listdir(output_dir)

existing_indices = set()

for filename in existing_files:

if filename.startswith("crop_") and filename.endswith(".tif"):

index_str = filename.split("_")[1].split(".")[0]

existing_indices.add(int(index_str))

start_index = max(existing_indices) + 1 if existing_indices else 0

for i, crop in enumerate(crops):

output_path = os.path.join(output_dir, f"crop_{start_index + i}.tif")

save_image(crop, output_path)

def save_image(image_data, output_path):

num_bands, height, width = image_data.shape

driver = gdal.GetDriverByName("GTiff")

dataset = driver.Create(output_path, width, height,

num_bands, gdal.GDT_Byte)

for i in range(num_bands):

dataset.GetRasterBand(i + 1).WriteArray(image_data[i])

dataset.FlushCache()

if __name__ == "__main__":

# 影像的路径

image_path = r"xxxx.tif"

# 标签的路径

label_path = r"xxxx.tif"

images = read_image(image_path)

labels = read_image(label_path, 1)

if images.shape[1:] == labels.shape[1:]:

print("Images have same dimensions. Starting cropping...")

# 设置滑动窗口的大小及步长,用于生成重叠的滑动裁剪块

images_crops = sliding_crop(images, window_size=(512, 512), stride=256)

labels_crops = sliding_crop(labels, window_size=(512, 512), stride=256)

# 保存裁剪后的图像

save_crops(images_crops,

r"H:\Images")# 影像块的文件夹

save_crops(labels_crops,

r"H:\Labels")# 标签块的文件夹

print("Cropping done and crops saved!")

else:

print("Images have different dimensions. Cannot proceed with cropping.")最终,通过上述代码,我们可以生成两个对应的文件夹:Images和Labels,分别用于保存原始的遥感影像和相应的标签影像。接下来,用户可以根据自己的语义分割网络的数据读取方式,顺利进行网络训练。

代码已上传至GitHub仓库,未来还将定期更新更多用于遥感图像处理的Python代码,欢迎关注和使用!