美国当地时间12月2日晚,作为拥有超过6万名现场参会者和40万名线上参会者的全球云计算顶级盛宴,亚马逊云科技2024 re:Invent全球大会在拉斯维加斯盛大揭幕。

作为本届re:Invent全球大会的首场重头戏,亚马逊云科技高级副总裁Peter DeSantis的主题演讲,也由此被赋予了特殊的意义。

持续不断创新的源动力

众所周知,作为全球云计算技术的开创者,亚马逊云科技不仅在2006年3月正式推出了Amazon EC2弹性计算云服务,并且在之后超过18年的时间里,一直持续引领着全球云计算领域的技术革新。

那么问题就来了:作为一家将创新写入DNA的科技企业,亚马逊云科技持续不断创新的源动力究竟从何而来?

为了形象地阐述这个问题,Peter DeSantis用亚马逊雨林的"树根"来对亚马逊云科技的企业文化进行了比喻。不是所有的树都有树根,然而一棵枝繁叶茂的参天大树,必然有着扎进土壤深处的根系,才能保证树木即使在恶劣的环境下也能茁壮成长。

"亚马逊雨林的扶壁根系,支撑着世界上最大的树木生长在并不稳定的土壤系统中。扶根可以从一棵树的底部延伸数百英尺,并与附近的树木互锁构成一个坚实的基础,来支撑这些巨大的雨林。"Peter DeSantis说道,"而亚马逊云科技最独特的事情之一,是我们的领导者能够在细节上花费大量时间精力,去了解客户和服务真正发生了什么事情,从而能够快速做出决定,甚至有可能在问题发生之前就解决或预防它们。"

Peter DeSantis指出,亚马逊云科技的文化是独一无二的,它帮助企业在扩大规模的同时,还能够保持对安全性能、运营效率、成本和创新的坚定关注,为客户带来不断提升的云计算服务与用户体验。

不断升级的云计算基础设施

通过在自研芯片和系统等领域持续不断的创新,亚马逊云科技在云计算运营性能、安全、成本等方面也积累了独特能力和核心优势。

亚马逊云科技计算与网络副总裁David Brown指出,作为亚马逊云科技旗下的自研芯片系列之一,2018年推出的第一代Amazon Graviton系列芯片就提供了足以媲美x86的优异性能;随后的Amazon Graviton2更是在广泛的工作负载类型中实现了对x86的反超;Amazon Graviton3可以为Nginx等工作负载提供高达60%的性能提升;作为迄今为止性能最强大的Graviton芯片,Graviton4的vCPU数量是Graviton3的3倍,计算性能也较上一代芯片提升了30%。

"在过去的两年中,亚马逊云科技数据中心有超过50%的新增CPU算力都运行在Graviton之上,比其他所有类型的CPU加起来还要多。"David Brown表示。

谈到Amazon Nitro系统时,David Brown表示,Nitro系统通过将大部分虚拟化功能卸载到专用硬件芯片上,极大简化了虚拟机监控程序,消除了传统虚拟化的性能开销。为了确保整个硬件供应链的安全性,Nitro引入了硬件完整性的验证管控机制,从芯片制造阶段开始就对每个硬件组件进行加密认证,从根本上防止了硬件层面的攻击和篡改。

David Brown指出,如果将Nitro系统与Graviton4芯片配合,即可创建一个相互锁定的信任网络,使CPU到CPU、CPU到Nitro芯片的所有连接,都可以由硬件提供安全保护。此外在存储驱动器中嵌入Nitro卡,还可以实现存储和计算分离的架构,使得计算和存储资源能够独立扩展,从而在满足扩容需求的同时,还可以减少故障范围,加快恢复速度,提高存储服务的敏捷性、可靠性和效率。

AI基础设施的创新

在生成式AI大潮席卷全球的今天,亚马逊云科技在AI基础设施领域的创新,也理所当然地成为了业界人士关注的焦点。

Peter DeSantis在主题演讲中指出,伴随着工作负荷的不断增加,人工智能中巨量的计算负载并不能完全通过横向扩展(Scale out)资源来解决,而是也需要纵向扩展单个计算单元的能力(Scale up)。如果只是单纯添加服务器的话,用户不会发现计算变得更快,而只是增加了成本。

强调了数据并行性的限制之后,Peter DeSantis提出了构建AI基础设施的两个基本支柱:"第一,因为我们有从全球批量规模扩展的限制,我们可以通过购买更强大的服务器,来构建更大的AI模型,这是AI基础设施挑战的扩展部分;第二,尽管在构建AI模型时存在扩展的限制,但是我们仍然从构建这些非常大的集群中获得了很多价值,为了做好这一点,我们需要利用多年来一直在构建的扩展工具,譬如高效的数据中心、快速的扩展、强大的网络等等。"

Amazon Trainium2实例正式可用

作为亚马逊云科技旗下的自研芯片系列之一,专门为AI工作负载而设计的Amazon Trainium系列芯片,也因为近年来生成式AI的炙手可热而备受关注。在本届re:Invent大会上,Peter DeSantis也宣布基于Amazon Trainium2的Amazon Elastic Compute Cloud(Amazon EC2)Trn2实例正式可用,同时还推出了全新的Amazon EC2 Trn2 UltraServers,让用户能够以优越的性价比训练和部署最新的AI模型,以及未来的大语言模型(LLM)和基础模型(FM)。

Trainium2采用了先进的封装技术,将计算芯片和高带宽内存(HBM)模块集成在一个紧凑的封装内,实现了CPU和内存的无缝集成,不仅提高了性能,降低了延迟,而且数据交换也更加高效,同时还减少了电压,提高了能效。

与当前基于GPU的EC2 P5e和P5en实例相比,Amazon EC2 Trn2实例的性价比提升30-40%,配备了16个Trainium2芯片,可提供高达20.8万亿次每秒浮点算力的性能,非常适合训练和部署具有数十亿参数的大型语言模型(LLMs)。而Amazon EC2 Trn2 UltraServers更是配备了64个Trainium2芯片,采用亚马逊云科技专有的NeuronLink超速互连技术,可提供高达83.2万亿次每秒浮点算力,其计算、内存和网络能力是单一实例的四倍,能够支持训练和部署超大规模的模型。

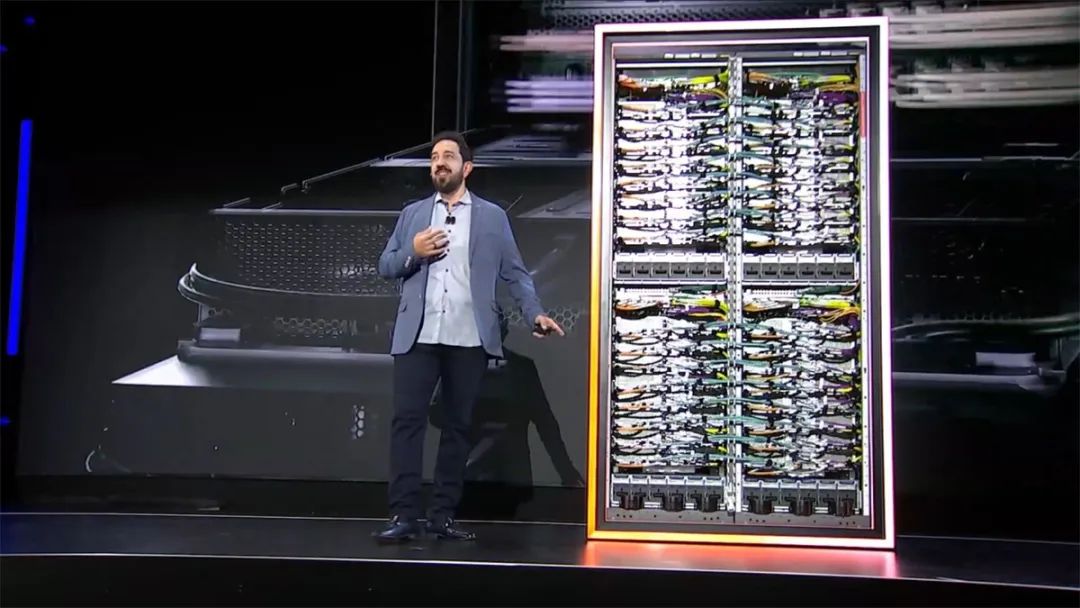

"过去我一直想把硬件带到舞台上,但是每年都被说服放弃这一想法。但是今年为了向你们展示什么是超级服务器,我把它带到了舞台上。它能够提供比任何当前的EC2 AI服务器还要多5倍的计算容量和10倍的内存。这就是你要建立一个万亿参数AI模型所需要的服务器。"Peter DeSantis说道。

Amazon Bedrock低延迟优化推理

对于许多企业和开发者来说,Amazon Bedrock无疑是他们拥抱生成式AI时的最佳助手。通过这项完全托管的服务,用户可以非常方便地调用来自AI21 Labs、Anthropic、Cohere、Meta、Stability AI、Mistral AI以及亚马逊云科技的高性能基础模型(FM),以及通过安全性、隐私性和负责任的AI构建生成式AI应用程序所需的一系列功能,使用自己的数据来构建私人订制的生成式AI应用。

在本届re:Invent大会上,Peter DeSantis宣布Amazon Bedrock推出了一项新的低延迟优化推理功能。它让用户能够访问亚马逊云科技最新的AI基础设施和软件优化技术,从而在各种领先的模型上获得最佳的推理性能。

与此同时,亚马逊云科技还与Anthropic合作推出了AI模型Claude 3.5的低延迟优化版本,通过低延迟模式运行Claude Haiku可提速60%。Anthropic联合创始人兼首席计算官Tom Brown还宣布,下一代Claude模型将在Project Rainier上训练。这个集成了数十万个Trn2芯片的集群运算能力是以往集群的5倍多,客户可以用更低价格、更快速度使用更高智能的模型。

构建更大更强的AI集群网络

谈到如何构建大规模AI集群,Peter DeSantis认为网络是一大关键因素。飞速发展的生成式AI和大模型,需要更大的网络带宽,更快的获取网络资源,以及更高的可靠性。这也对网络提出了更高的要求。

为了解决这一问题,亚马逊云科技开发出了面向大规模AI集群的网络架构"10p10u网络"。该网络架构支持对超级服务器进行集群,因而被用于驱动基于UltraSever或NVIDIA节点构建的大规模计算集群,为数以千计的计算节点之间提供数十PB/s的网络带宽,延迟低于10微秒。大规模并行和高密度互连的特点,使得"10p10u网络"可以非常方便地从少量机架快速扩展到跨越多个数据中心的大规模集群,具备极佳的弹性。

"'10p10u网络'是有史以来规模最快的网络,其斜坡对我们来说也是前所未有。在过去的12个月里我们安装了超过300万个链接,这甚至是在许多人开始关注我们的培训之前。"Peter DeSantis说道。同时他还表示,通过在Graviton、Nitro、存储、网络等核心领域的持续投资和创新,亚马逊云科技正在构建更大、更强的AI服务器集群,以更好地满足客户的需求。