在深度学习中,长短期记忆网络(LSTM, Long Short-Term Memory)是一种强大的循环神经网络(RNN)变体,专门为解决序列数据中的长距离依赖问题而设计。LSTM因其强大的记忆能力,广泛应用于自然语言处理、时间序列分析和语音识别等任务中。本文将详细介绍LSTM的原理、结构以及其在多分类预测中的实现。

一、LSTM

LSTM由Hochreiter和Schmidhuber在1997年提出,是一种能够有效避免传统RNN梯度消失或梯度爆炸问题的网络架构。与传统RNN不同,LSTM通过引入记忆单元(Cell State)和门控机制(Gate Mechanism),实现了对长时间序列依赖信息的捕获和控制。

二、LSTM的核心结构与工作原理

LSTM的核心在于其结构中包含的三个门:

输入门(Input Gate) :控制新信息对记忆单元的更新程度。

遗忘门(Forget Gate) :决定需要忘记的历史信息。

输出门(Output Gate):决定当前时间步需要输出的信息。

1. 记忆单元(Cell State)

记忆单元是LSTM中存储信息的核心组件,其状态可以通过门控机制进行动态更新。

2. 遗忘门

遗忘门控制需要从记忆单元中移除的信息

3. 输入门

输入门决定新信息加入记忆单元的程度

4. 输出门

输出门决定隐藏状态的更新

三、LSTM的优势

解决梯度问题:通过门控机制有效缓解梯度消失或爆炸问题。

强大的记忆能力:能够记住序列中的长距离依赖信息。

广泛适用性:在时间序列预测、文本分类、语音处理等任务中表现卓越。

四、LSTM部分代码与参数设置

c

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

rng('default');

%% 导入数据

res = xlsread('data.xlsx');

%% 划分训练集和测试集

num_size = 0.7; % 训练集占数据集比例

outdim = 1; % 最后一列为输出

num_samples = size(res, 1); % 样本个数

% res = res(randperm(num_samples), :); % 打乱数据集(不希望打乱时,注释该行)

num_train_s = round(num_size * num_samples); % 训练集样本个数

L = size(res, 2) - outdim; % 输入特征维度

P_train = res(1: num_train_s, 1: L)';

T_train = res(1: num_train_s, L + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: L)';

T_test = res(num_train_s + 1: end, L + 1: end)';

N = size(P_test, 2);

%% 参数设置

options = trainingOptions('adam', ... % Adam 梯度下降算法

'MiniBatchSize', 128, ... % 批大小

'MaxEpochs', 1000, ... % 最大迭代次数

'InitialLearnRate', 1e-2, ... % 初始学习率

'LearnRateSchedule', 'piecewise', ... % 学习率下降

'LearnRateDropFactor', 0.1, ... % 学习率下降因子

'LearnRateDropPeriod', 700, ... % 经过700次训练后 学习率为 0.01 * 0.1

'Shuffle', 'every-epoch', ... % 每次训练打乱数据集

'ValidationPatience', Inf, ... % 关闭验证

'Plots', 'training-progress', ... % 画出曲线

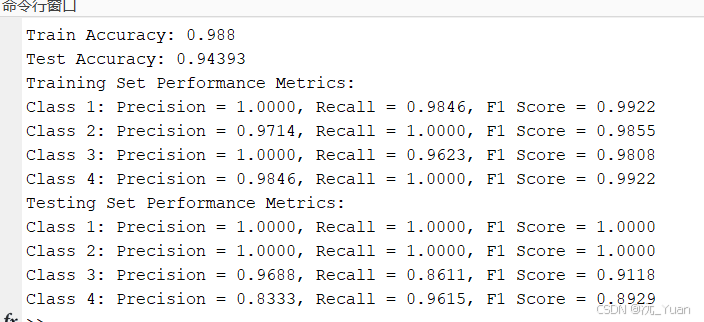

'Verbose', false);五、运行结果