开启持久化卷后可以实现服务开启在不同节点也能读取到和拿到服务节点的文件。

基本流程为将集群中一个节点作为服务节点安装共享储存应用的服务端选择目录和开启端口,其他节点根据端口挂载目录。然后使用kubesphere选择相应的镜像并将端口信息和挂载目录信息作为参数来开启容器。容器开启后即可使用集群文件服务。

一、环境

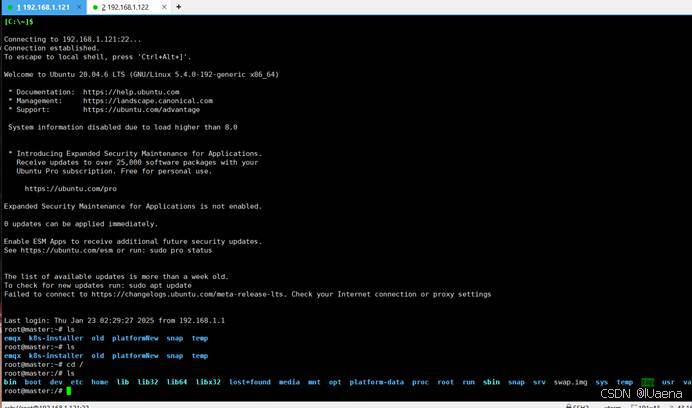

举例机器为两个ubuntu2020系统的节点,其中192.168.1.121作为服务端开启共享目录,192.168.1.122作为客户端挂载121上的共享目录

|---------------|-----|

| IP | 分类 |

| 192.168.1.121 | 服务端 |

| 192.168.1.122 | 客户端 |

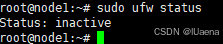

二、关闭防火墙

两台机器都关闭一下防火墙

sudo systemctl stop ufw

sudo systemctl disable ufw检查一下是否关闭成功

sudo ufw status

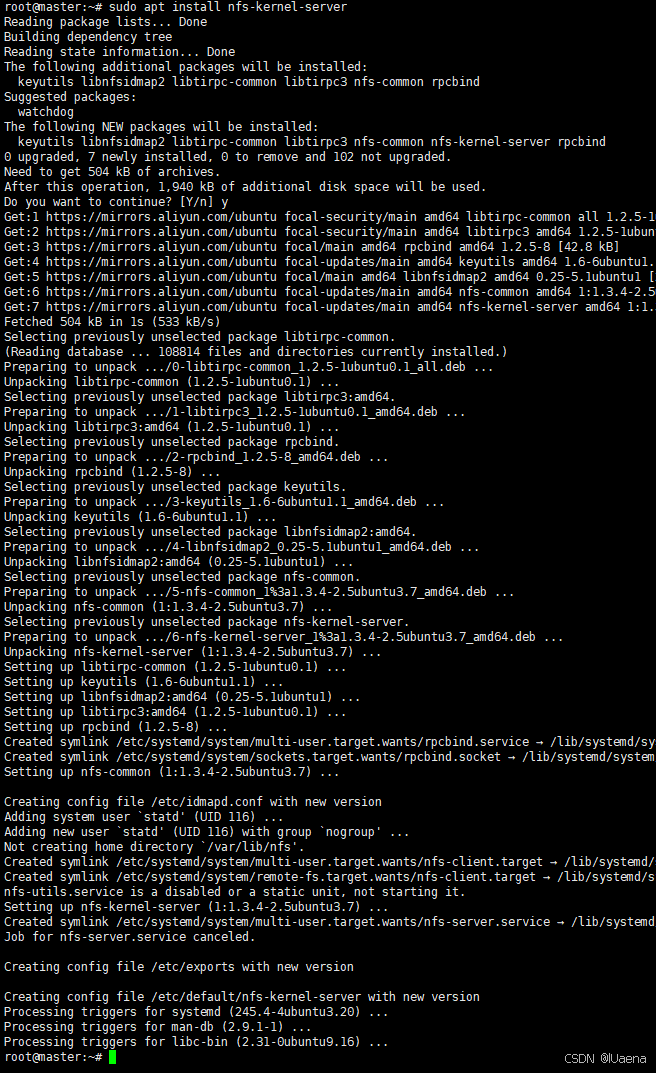

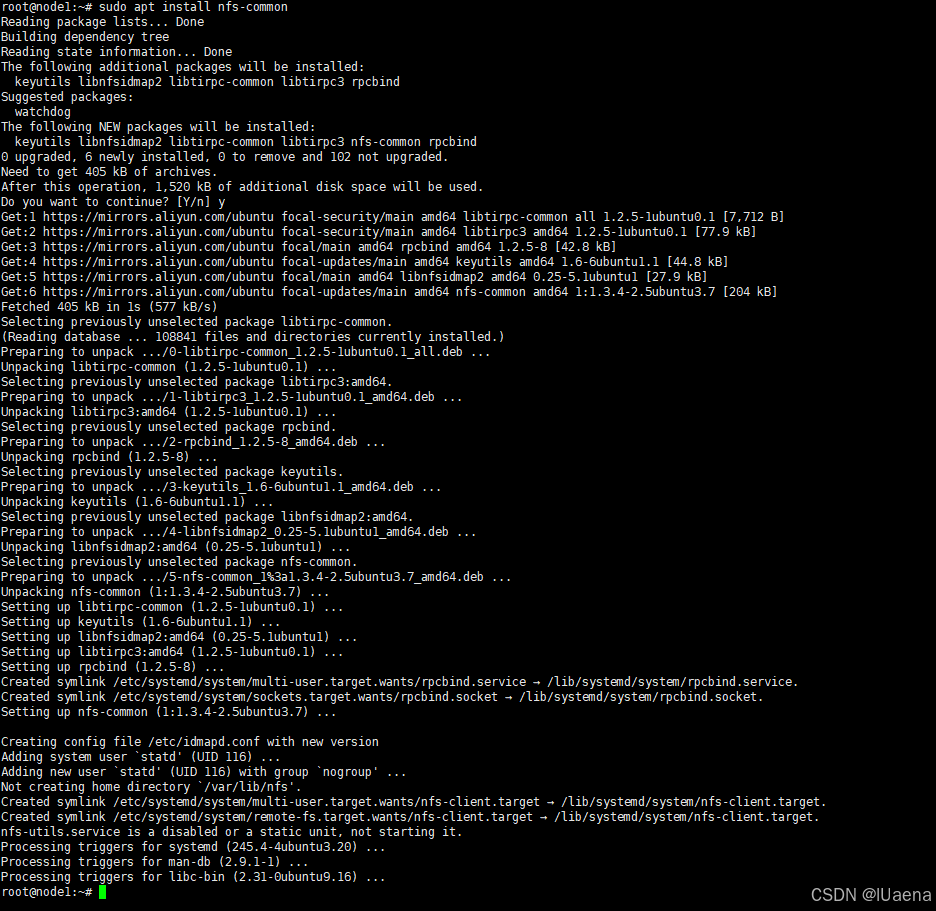

三、nfs

1、安装

这边使用nfs作为共享存储应用安装在两个机器上。

首先在服务节点也就是121上下载nfs服务端,执行以下命令:

sudo apt install nfs-kernel-server

然后在客户节点也就是122上下载nfs客户端,执行以下命令:

sudo apt install nfs-common

注:离线环境可以自己根据系统版本准备nfs-utils的离线包,下载失败的可以换个源或者apt update一下

2、启动

服务端也就是我这边环境的121执行下列操作:

首先创建共享文件夹:(可以自己起名,后面同步更改就好了)

mkdir /nfs赋权:

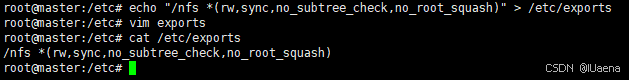

chmod 775 /nfs写入配置文件:

echo "/nfs *(rw,sync,no_subtree_check,no_root_squash)" > /etc/exports不放心可以cat /etc/exports看一下

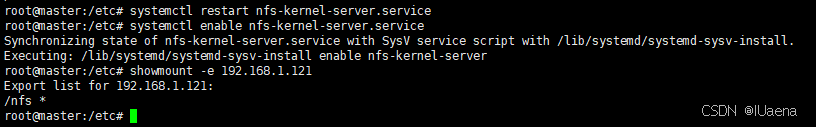

启动服务,设置自启动:

systemctl start nfs

systemctl enable nfs验证一下共享文件是否已经开启:

showmount -e 192.168.1.121

可以看到出现/nfs *即为开启成功

四、镜像

大体步骤为将nfs镜像上传到harbor,然后使用kubesphere设置参数开启服务,让kubesphere绑定192.168.1.121上的nfs服务。

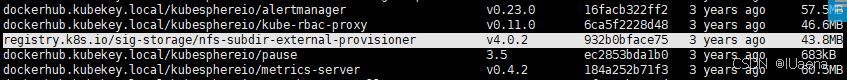

1、上传镜像到本地

镜像文件可以直接点击下载:【免费】nfsDocker镜像资源-CSDN文库

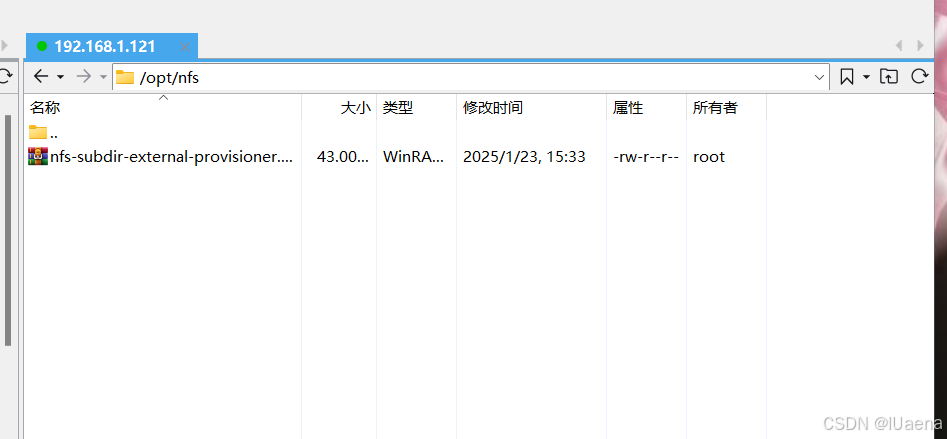

下载完解压一下

直接把文件拷贝到121上,我随便在/opt里建了个nfs的文件夹然后把镜像文件放了进去

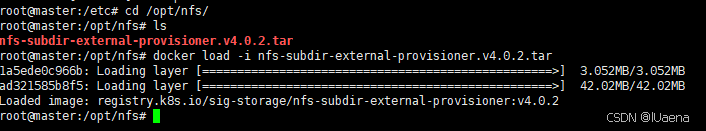

执行load命令:

cd /opt/nfs

docker load -i nfs-subdir-external-provisioner.v4.0.2.tar

2、上传镜像到harbor

我这边就使用harbor里安装kubesphere时候创建的kubesphereio项目来存这个镜像

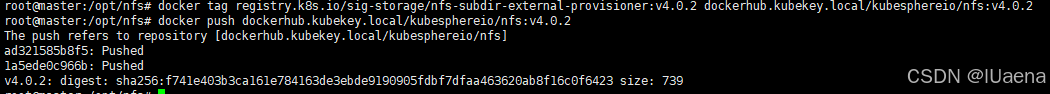

把刚才的镜像改一下标签然后push一下

docker tag registry.k8s.io/sig-storage/nfs-subdir-external-provisioner:v4.0.2 dockerhub.kubekey.local/kubesphereio/nfs:v4.0.2

docker push dockerhub.kubekey.local/kubesphereio/nfs:v4.0.2

3、开启服务

用到了helm,kk安装完kubesphere应该就有helm了所以不用额外安装了

下载一下文件:【免费】helm创建nfs负载服务包资源-CSDN文库

将nfs-subdir-external-provisioner.zip解压后放到121机器上,并在nfs-subdir-external-provisioner目录中执行命令:

helm install nfs-subdir-external -f values.yaml . -n nfs --create-namespace --set nfs.server=192.168.1.121 --set nfs.path=/nfs --set image.repository=dockerhub.kubekey.local/kubesphereio/nfs --set image.tag=v4.0.2 --set storageClass.name=master-nfs-storage --set storageClass.reclaimPolicy=Retain

#--set nfs.server换成你的地址

#--set nfs.path换成你开启的共享文件夹

#--set image.repository换成你的harbor上的镜像然后看一下kubsphere上,看到应用已经被安装

五、使用验证

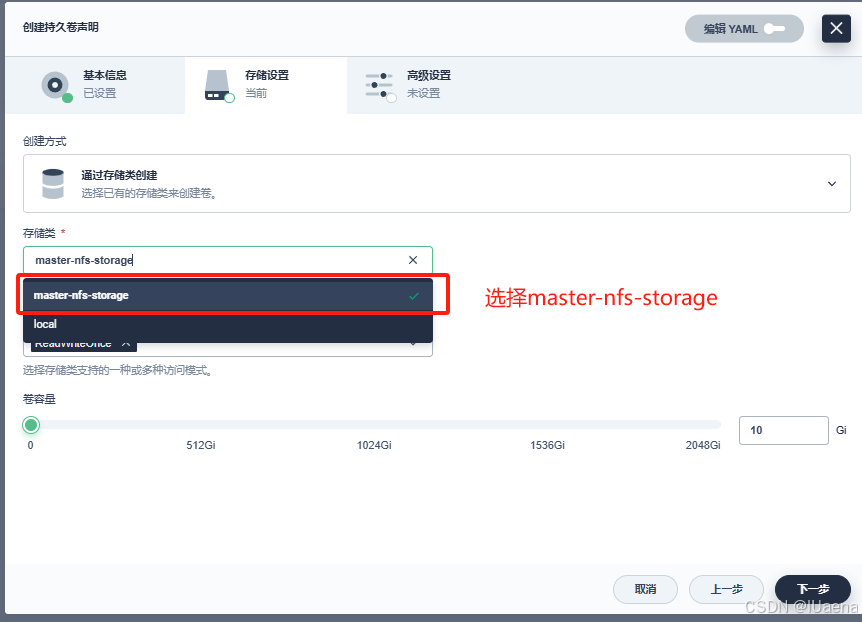

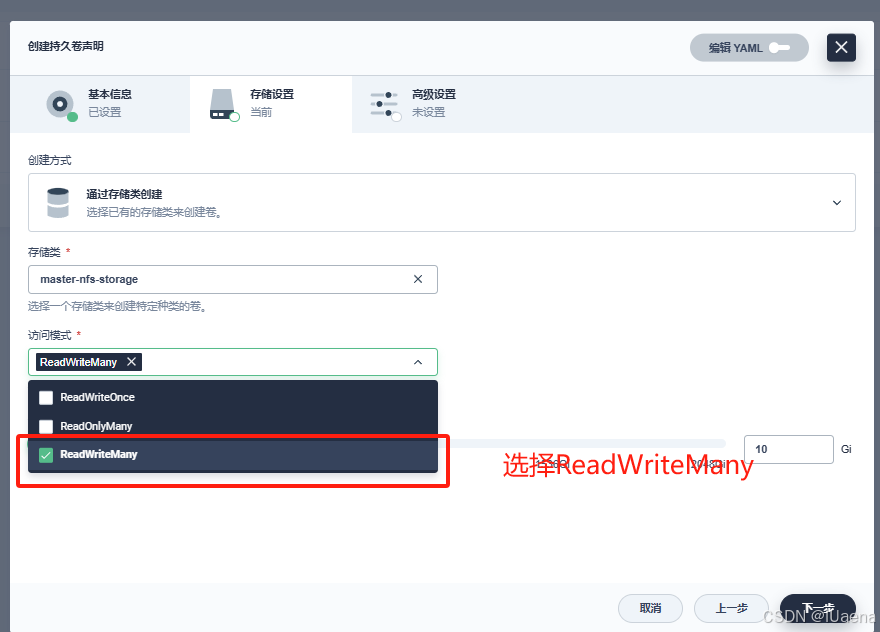

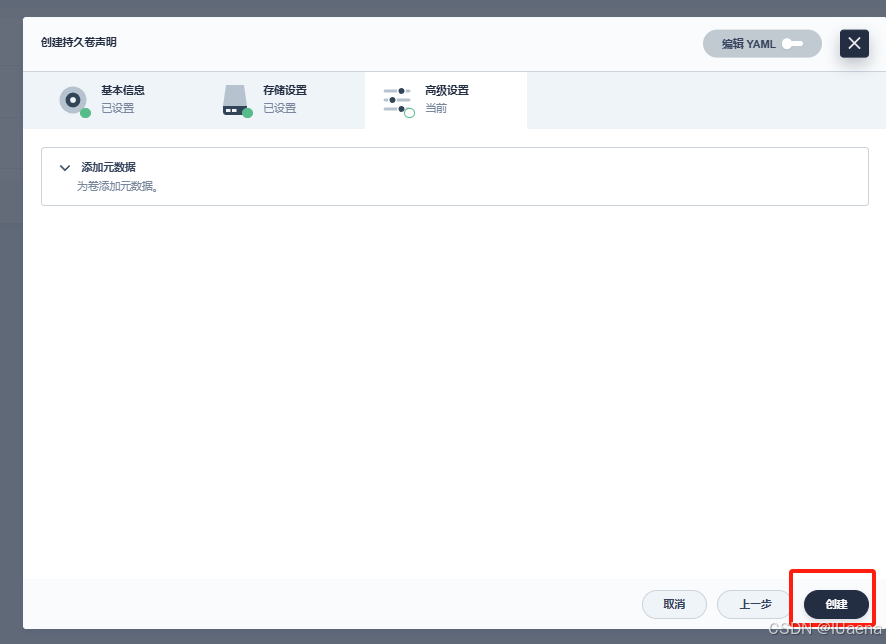

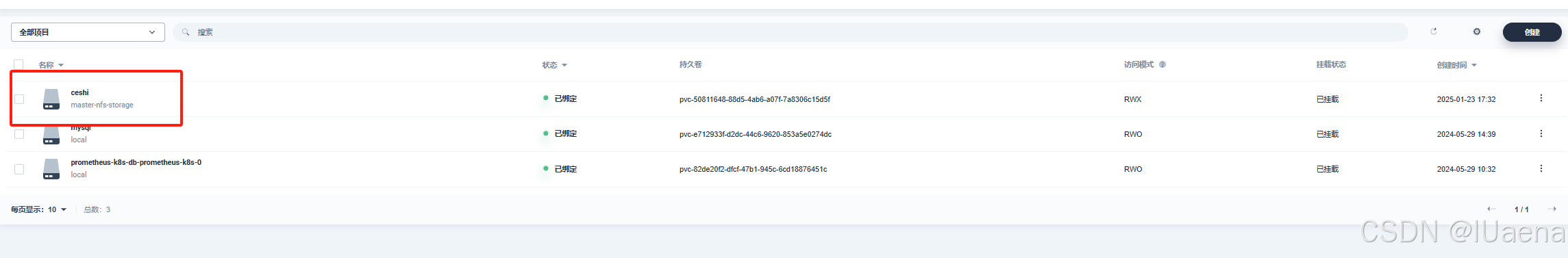

1、创建持久化卷

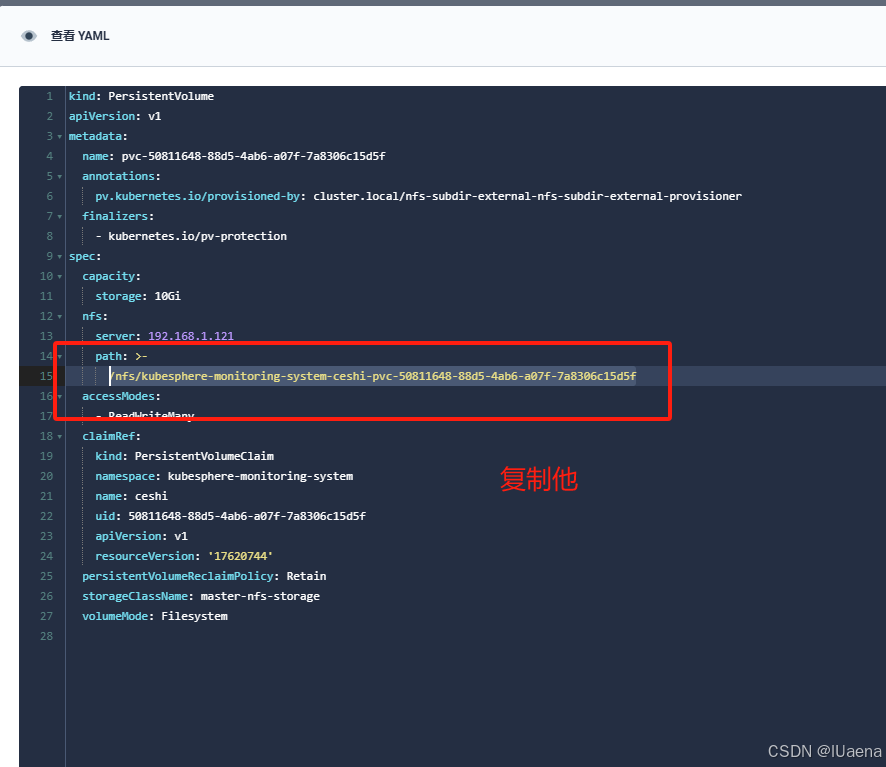

往里边随便存点东西,点击查看yaml,然后复制里面的地址

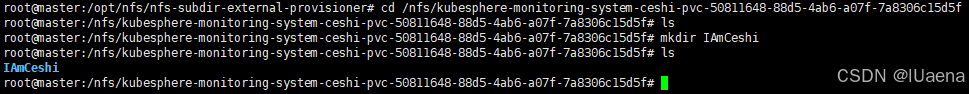

打开121,进入这个文件夹,在里面随便创建个文件夹,后面测试用

cd /nfs/kubesphere-monitoring-system-ceshi-pvc-50811648-88d5-4ab6-a07f-7a8306c15d5f

mkdir IAmCeshi

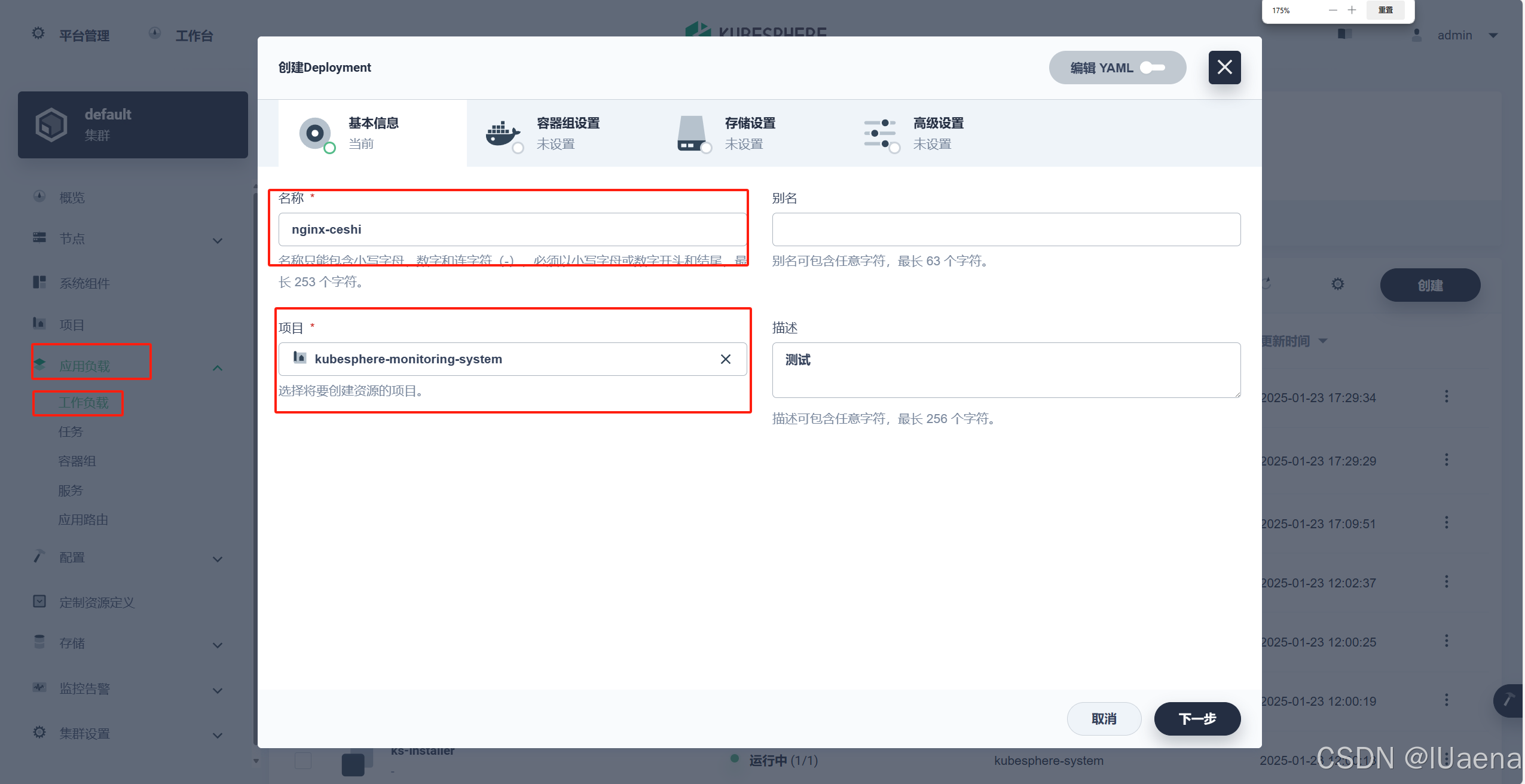

2、创建负载

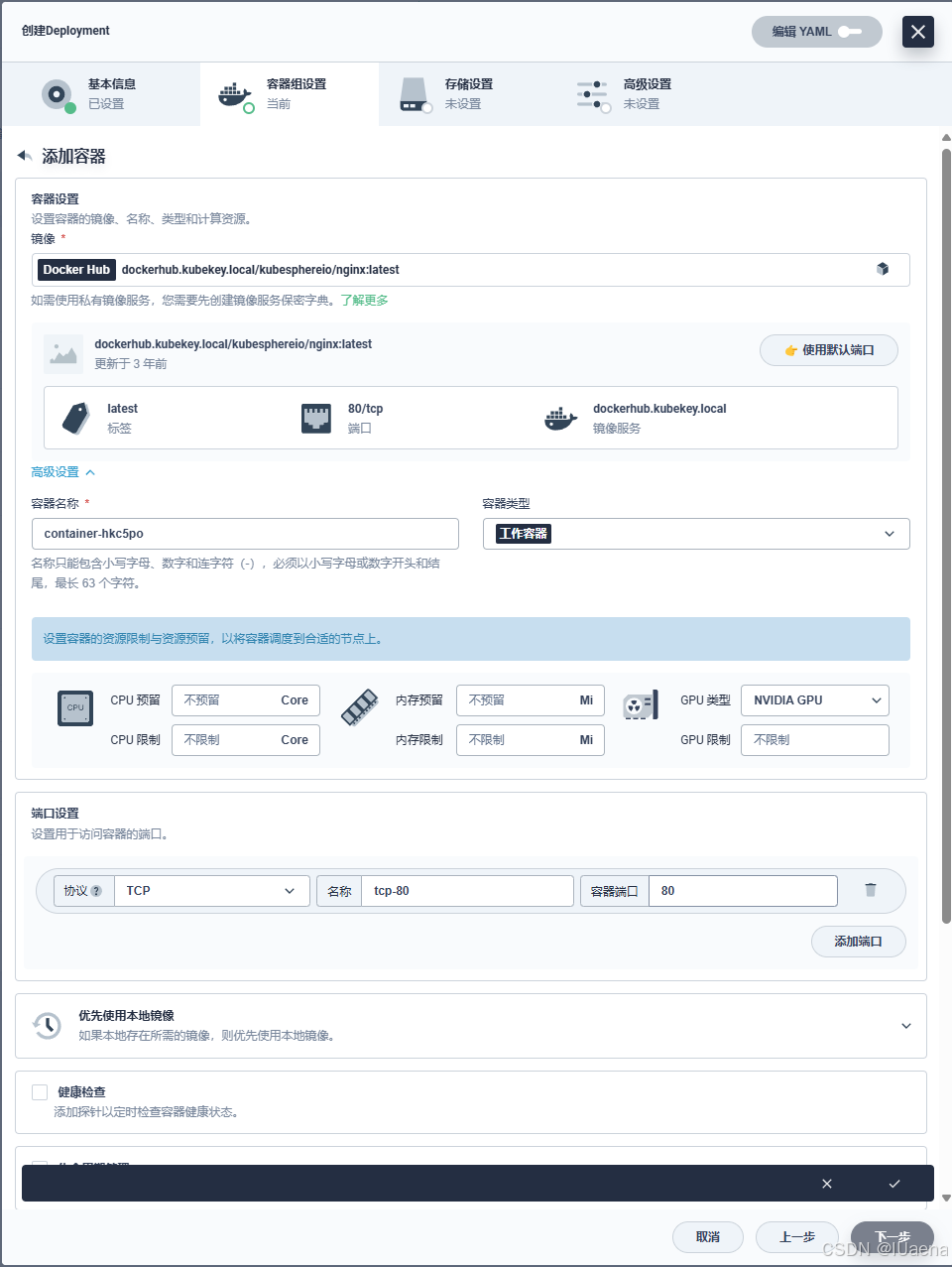

使用nginx镜像测试,正常创建负载

为了测试,这边选一下node1节点,也就是我这边的122,看一下存在121中/nfs的文件能否被开在122节点上的服务读取到

点击创建

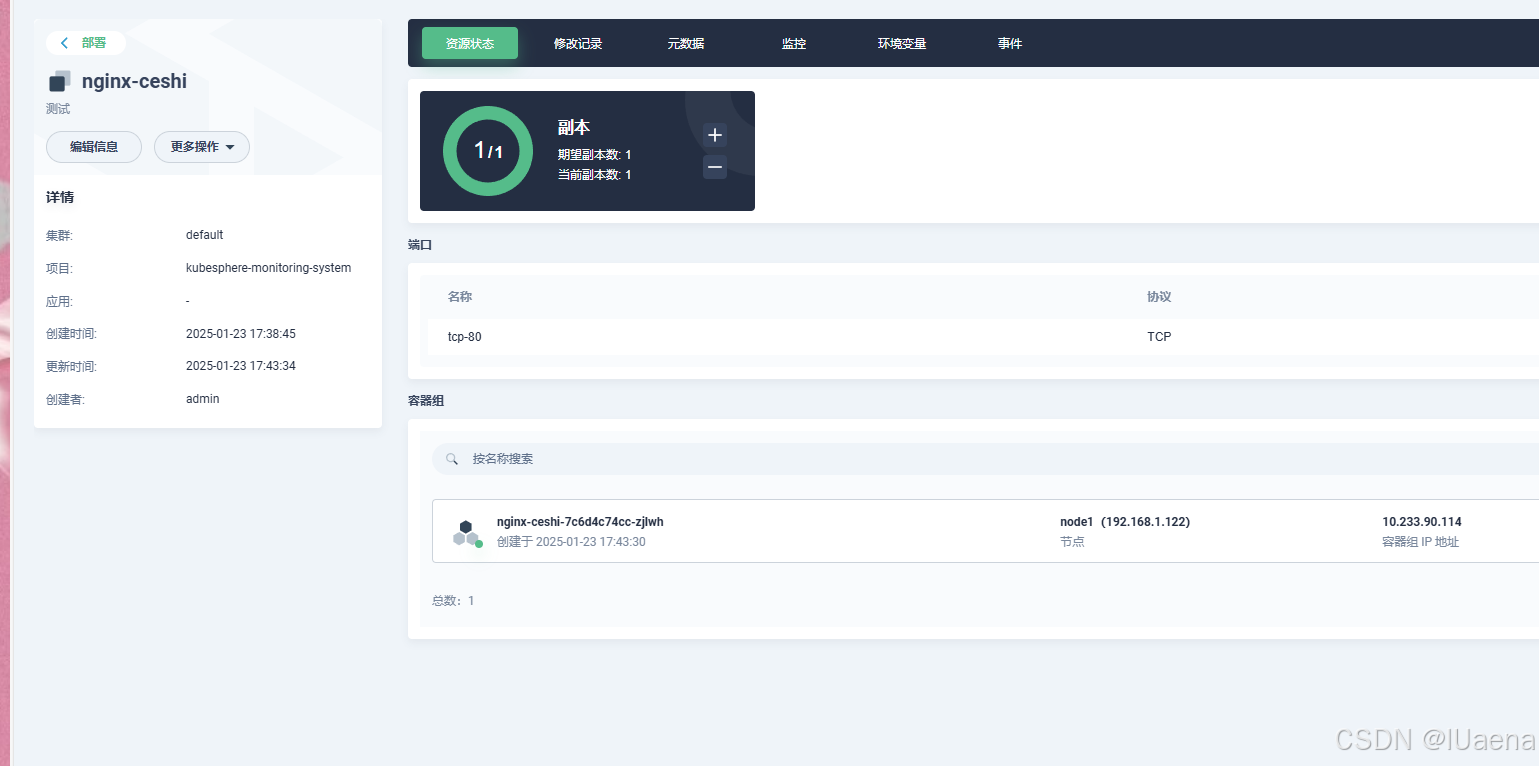

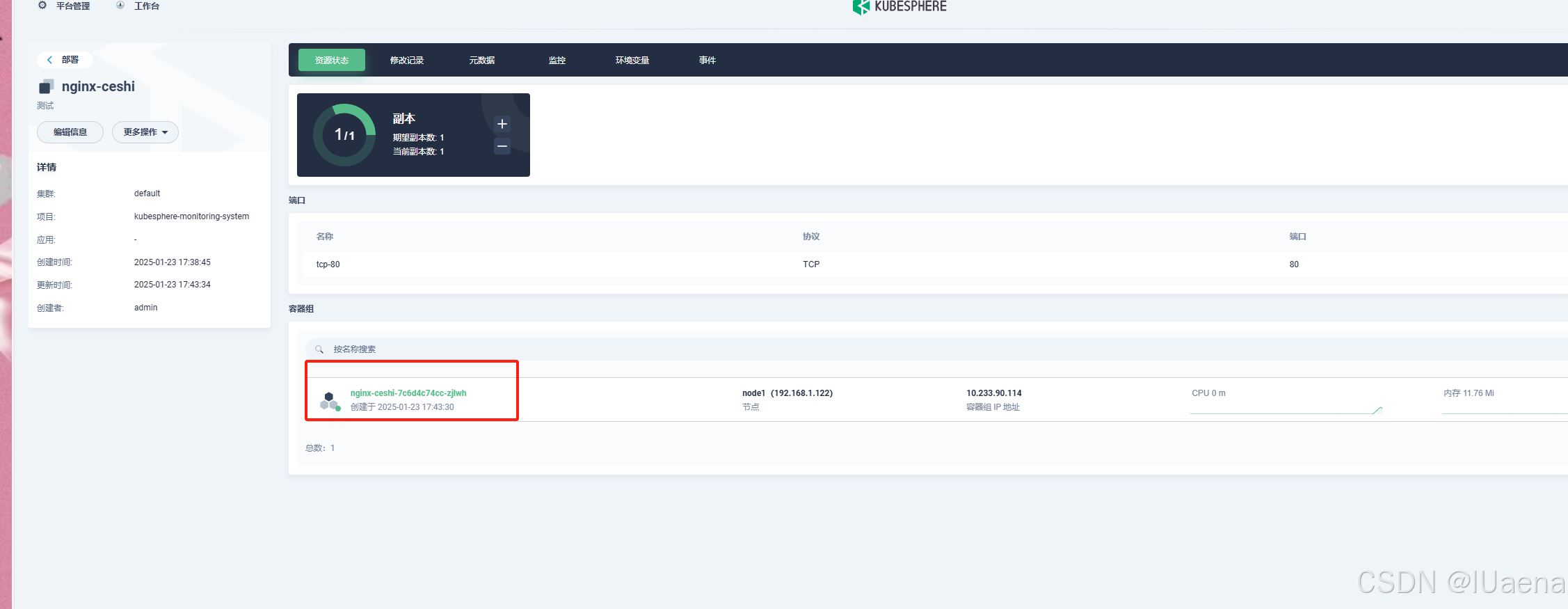

创建成功

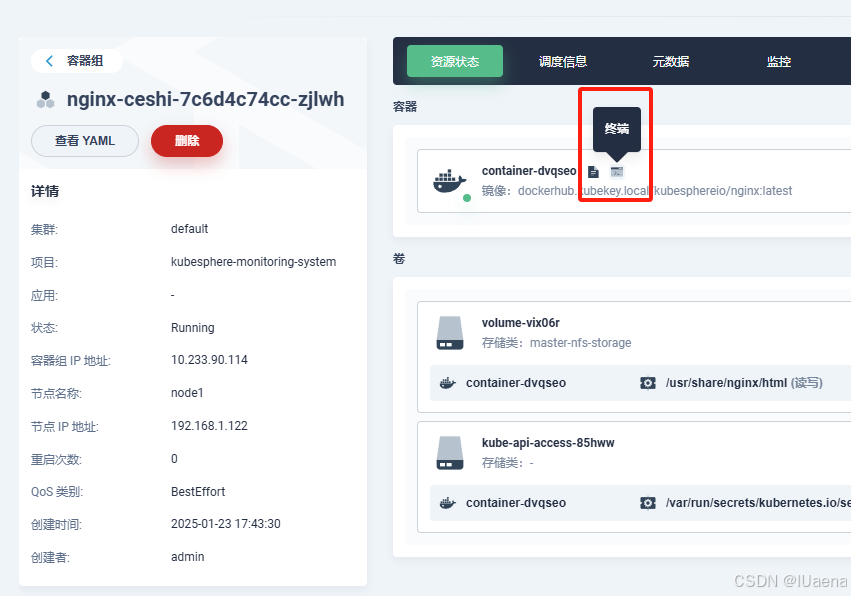

点进入容器终端看一下

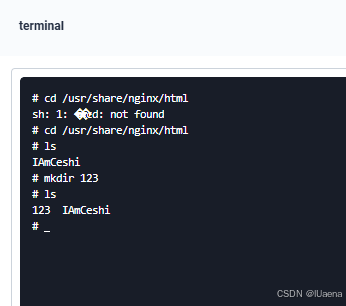

打开终端后进入到刚才创建负载挂的文件夹,也就是刚才的/usr/share/nginx/html/usr/share/nginx/html,可以看到刚才创建的文件夹

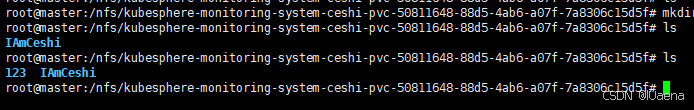

从里面再创建一个文件夹,然后在121上看一下

验证完成可以使用