步骤 1:安装 Ollama

Ollama 是一个本地 AI 运行工具,支持在终端中直接运行 AI 模型。

-

下载 Ollama

访问 Ollama 的下载页面:https://ollama.com/download,选择适合你操作系统的版本(Windows、macOS 或 Linux)。

-

安装 Ollama

下载完成后,按照安装向导完成安装。

-

验证安装

安装完成后,打开终端(或命令提示符),运行以下命令验证 Ollama 是否安装成功:

bashollama --version如果显示版本号,说明安装成功。

步骤 2:下载 DeepSeek R1 模型

Ollama 支持直接从终端下载和运行 DeepSeek R1 模型。

- 下载模型

在终端中运行以下命令:

bash

ollama run deepseek-r1:1.5b适合本地的小参数模型

-

等待模型下载完成

-

验证模型运行

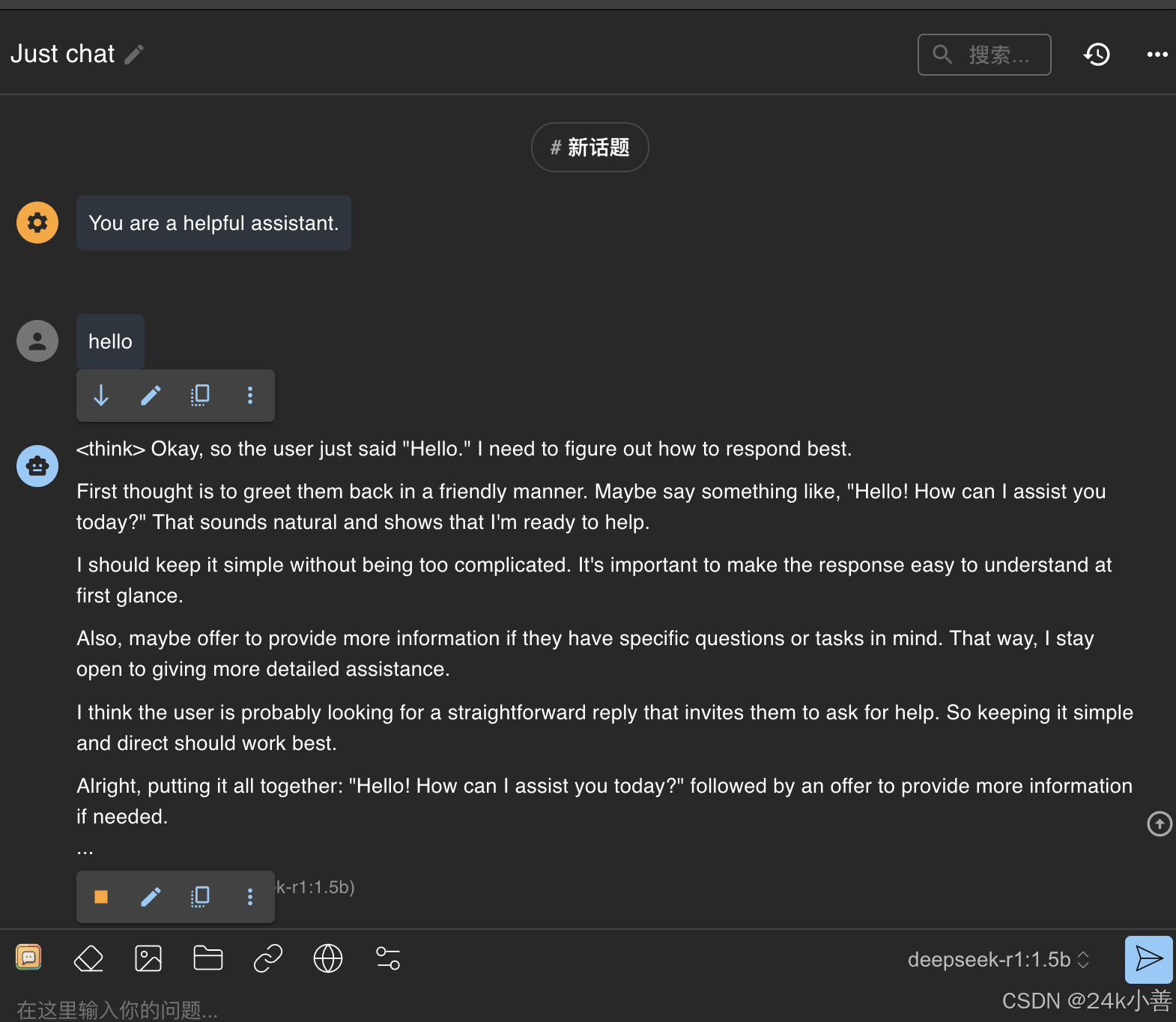

下载完成后,Ollama 会自动启动模型。你可以在终端中直接与 DeepSeek R1 进行对话。例如:

bash>>> hello如果模型返回响应,说明模型已成功运行。

步骤 3:安装 Chatbox

Chatbox 是一个 GUI 工具,可以提供更好的交互体验。

-

下载 Chatbox

访问 Chatbox 的下载页面:https://chatboxai.app/en#,选择适合你操作系统的版本。

-

安装 Chatbox

下载完成后,按照安装向导完成安装。

-

配置 Chatbox

4.

打开 Chatbox,进行以下配置:

- 在"配置 API 模型"选项中选择 Ollama API。

- 设置 API 主机为:

http://127.0.0.1:11434(这是 Ollama 的默认 API 地址)。 - 选择 DeepSeek R1 作为默认模型。

- 保存设置。

-

启动 Chatbox

配置完成后,点击"启动"按钮,Chatbox 会连接到本地的 Ollama 服务。你可以通过 Chatbox 的界面与 DeepSeek R1 进行对话。

到此已经可以和deepseek对话了😄🎉🎉🎉