一、Open WebUI简介与安装前准备

Open WebUI是一个开源的大语言模型(LLM)交互界面,支持本地部署与离线运行。通过它,用户可以在类似ChatGPT的网页界面中,直接操作本地运行的Ollama等大语言模型工具。

安装前的核心要求:

-

Python 3.11(必须严格使用此版本,更高版本可能不兼容)

-

Node.js 20.x及以上(用于前端依赖管理)

-

Ollama已安装并运行(若未安装,参考《Windows系统安装Ollama超简教程》)

二、详细安装步骤

步骤1:安装Python 3.11

- 访问 Python官网,下载

Python 3.11.9安装包。

2.安装时务必勾选**"** Add Python 3.11 to PATH ",避免后续命令无法识别。

- 验证安装,输入python --version看到版本信息即表示安装成功:

python --version步骤2:安装Node.js与npm

- 从Node.js中文网(https://nodejs.org/zh-cn)下载最新LTS版本(如20.12.2)。

2.安装完成后验证:

node -v && npm -v步骤3:安装Open WebUI

打开cmd窗口,输入:

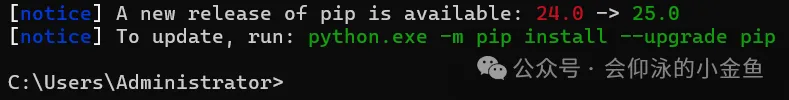

pip install open-webui等待一段时间就会自动安装完成,切记不要用python3.11以上的版本,否则可能出现不兼容的问题:

见到下图所示界面,就表示安装成功:

三、运行Open WebUI并连接Ollama

启动Open WebUI

open-webui serve打开另一个cmd窗口输入open-webui serve 启动open-webui之后,在浏览器输入默认访问地址:http://localhost:8080。

若需自定义数据存储路径:

打开http://localhost:8080后,可以看到如下界面:

点击开始使用进入注册账号页面,输入账号密码注册即可:

进入网站后,在右上角选择本地的大模型,我们本地安装的是deepseek-r1.5,选择之后就可以进行对话了:

四、常见问题与优化

- 中文界面设置:登录后,在右上角设置中选择"简体中文"提升用户体验。

- 模型文件存储路径优化 :

通过环境变量OLLAMA_MODELS将模型文件迁移至非系统盘(如D:\ollama_models),避免C盘爆满。 - 端口冲突处理 :

若8080端口被占用,可通过--port参数指定其他端口:open-webui serve --port 8090

除了Open-webUI,还有一些其他的工具可以访问DeepSeek,有兴趣的朋友可以再去了解一下。

到目前为止,我们已经可以跟本地搭建DeepSeek进行对话了。不过一般的主机配置只能运行一些残血大模型,想要获取更智能的模型,DeepSeek官网api才是最佳选择。