本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

DeepSeek-R1-0528 是一款表现优异的大规模开源推理模型,参数量达到 671B。虽然模型规模庞大,但通过极致的量化技术,它现在可以在配置合理的本地设备上运行。这一进展使得开发者和研究者无需依赖云服务,即可在本地部署强大的语言模型,实现私有化、安全性和效率的平衡。

本文将详细介绍如何在本地部署并运行 DeepSeek-R1-0528,包括系统要求、依赖安装、模型加载、前端 UI 使用和 CPU/GPU 配置等关键环节。

硬件和环境要求

由于模型体积较大,推荐使用高性能设备以确保运行顺畅:

| 类型 | 推荐配置 |

|---|---|

| GPU | 至少 24GB 显存(如 RTX 4090、A6000) |

| 内存 | 推荐 128GB(最低 64GB 并配合 Swap) |

| 存储空间 | 200GB 以上 |

| 操作系统 | Ubuntu 20.04+、Windows WSL 或 macOS(支持 Docker) |

在无 GPU 场景下也可采用 CPU 模式运行,适合测试用途。

安装 Ollama

Ollama 是一款轻量级模型推理服务器,适用于运行 GGUF 格式模型。首先安装 Ollama:

arduino

sudo apt-get update

sudo apt-get install pciutils -y

curl -fsSL https://ollama.com/install.sh | sh访问 Ollama 官网:ollama.com

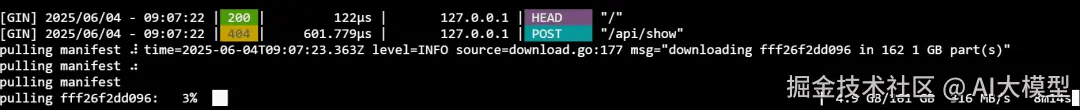

下载并运行模型

DeepSeek-R1-0528 已被转换为 GGUF 格式并托管于 Hugging Face,可直接拉取运行:

arduino

ollama serve &

ollama run hf.co/unsloth/DeepSeek-R1-0528-GGUF:TQ1_0 该版本为 TQ1_0,采用 1.66-bit 动态量化压缩,模型文件约 162GB。

该版本为 TQ1_0,采用 1.66-bit 动态量化压缩,模型文件约 162GB。

模型地址:huggingface.co/unsloth/Dee...

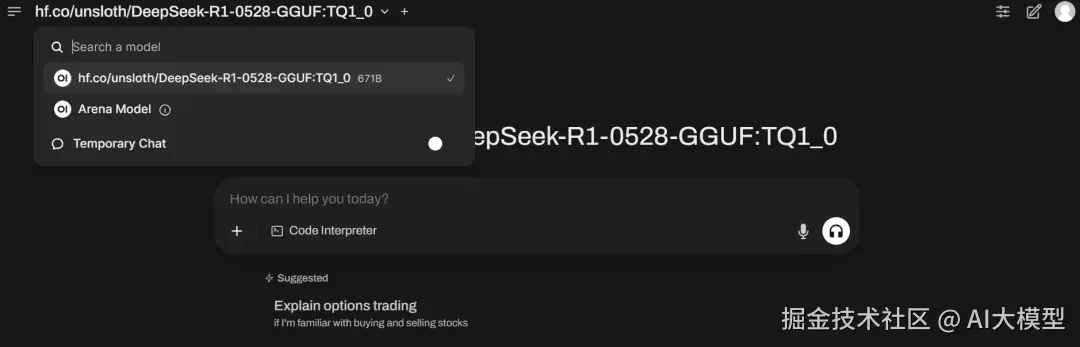

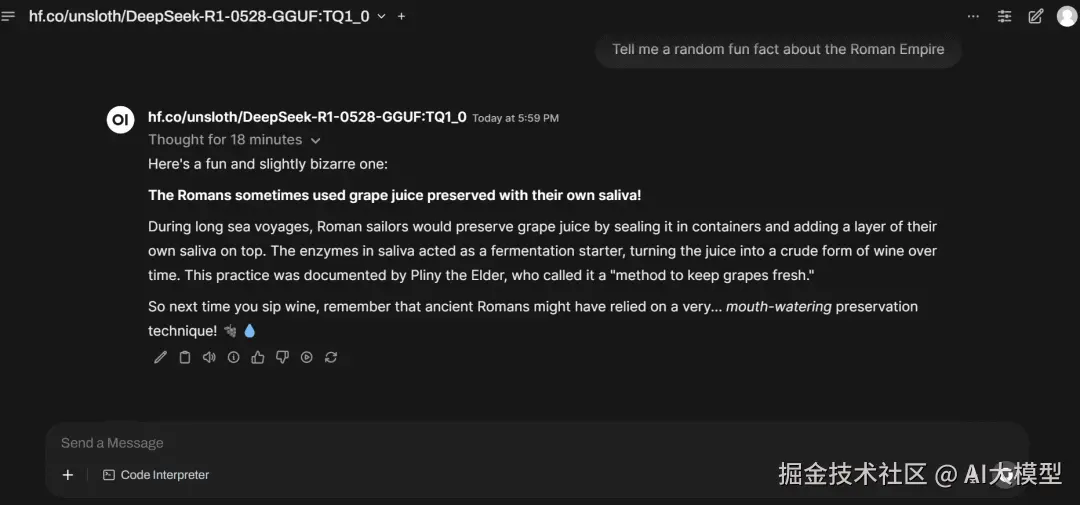

部署 Open WebUI 以实现图形界面交互

如果希望通过浏览器操作模型,可使用 Open WebUI。其容器版本支持直接与 Ollama 集成:

lua

docker pull ghcr.io/open-webui/open-webui:cuda

docker run -d -p 9783:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

ghcr.io/open-webui/open-webui:cuda部署成功后,在浏览器中访问:http://localhost:9783/

即可在 Web 页面中选择 DeepSeek 模型进行对话。

Open WebUI 地址:github.com/open-webui/...

纯 CPU 模式运行(可选)

在没有可用 GPU 的环境中,也可以通过以下方式启用纯 CPU 模式:

bash

pkill ollama

sudo fuser -v /dev/nvidia*

CUDA_VISIBLE_DEVICES="" ollama serve

ollama run hf.co/unsloth/DeepSeek-R1-0528-GGUF:TQ1_0在 CPU 模式下,推理速度约为每秒 1 个 token,适用于模型验证与功能测试。

常见问题与优化建议

| 问题 | 解决方案 |

|---|---|

| 模型下载中断 | 使用 Hugging Face CLI 工具,支持断点续传 |

| 显存不足 | 使用内存+Swap 配置,或尝试更高压缩版本(如 TQ2_0) |

| 模型响应缓慢 | 建议至少使用 24GB 显存 GPU,或优化推理线程 |

| WebUI 无法识别模型 | 重启 Ollama 并刷新 WebUI 页面 |

如需更轻量化运行,还可选择替代后端工具如 llama.cpp,或桌面可视化工具 LM Studio。

关键资源链接汇总

| 工具 / 模型 | 链接 |

|---|---|

| Ollama 官网 | ollama.com |

| DeepSeek-R1-0528 模型页面 | huggingface.co/unsloth/Dee... |

| Open WebUI 项目 | github.com/open-webui/... |

| llama.cpp 推理引擎 | github.com/ggerganov/l... |

| LM Studio 桌面客户端 | lmstudio.ai |

总结

DeepSeek-R1-0528 的本地部署证明,大规模语言模型并非只能依赖云端。通过先进的量化压缩技术和灵活的部署工具,现在任何拥有高性能设备的个人或小团队都可以构建私有的智能语言系统。

本指南涵盖了从环境准备到模型部署的全过程,帮助你最大程度发挥 DeepSeek-R1-0528 的能力。在安全性、定制性和控制力日益重要的 AI 应用场景中,本地部署将成为越来越多开发者的首选路径。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。