本文分享在自己的本地电脑部署 llama3.1,而且轻松简易,快速上手。

这里借助Ollama工具,在Linux系统中进行大模型部署~

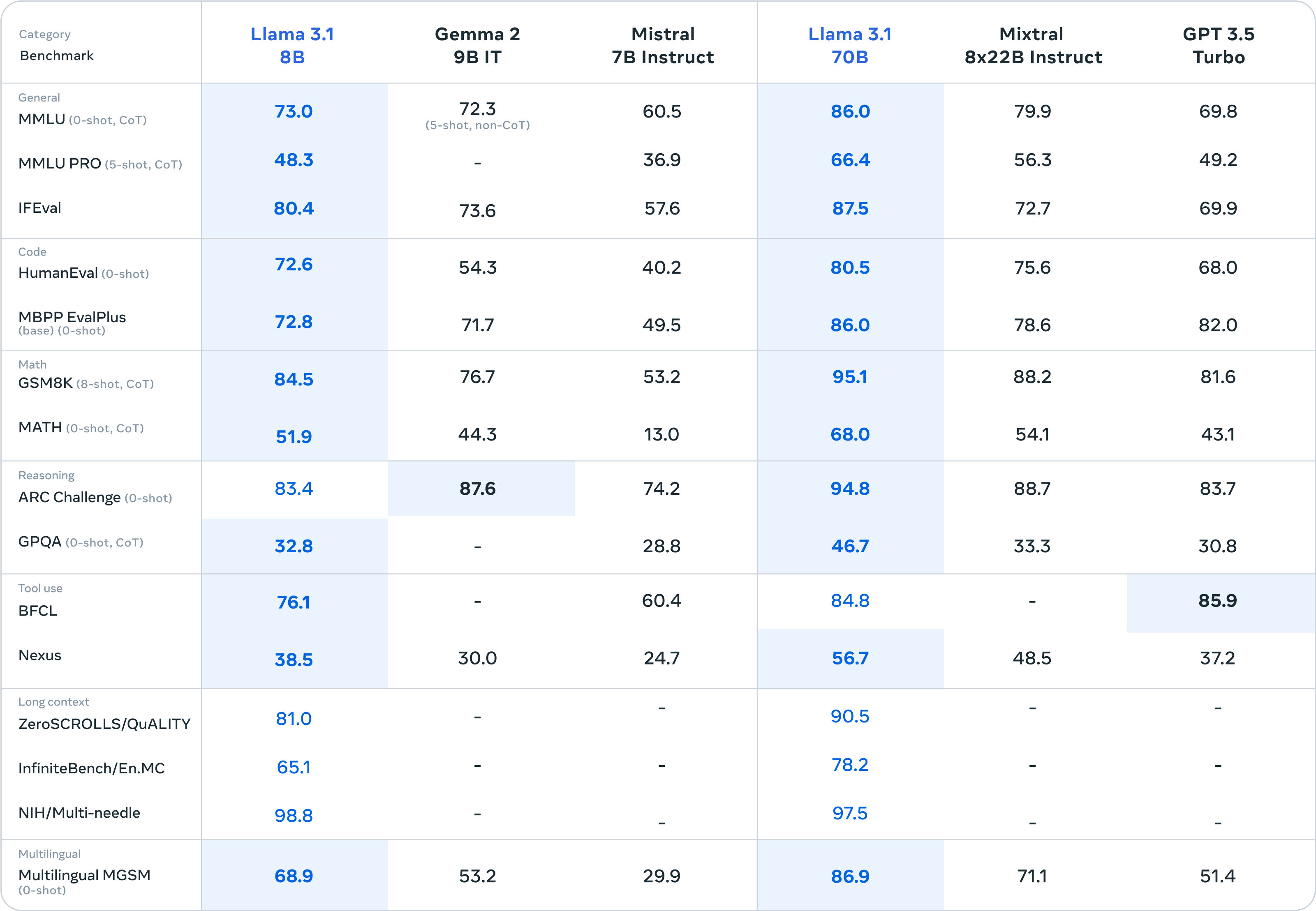

Llama3.1,有三个版本:8B、70B、405B

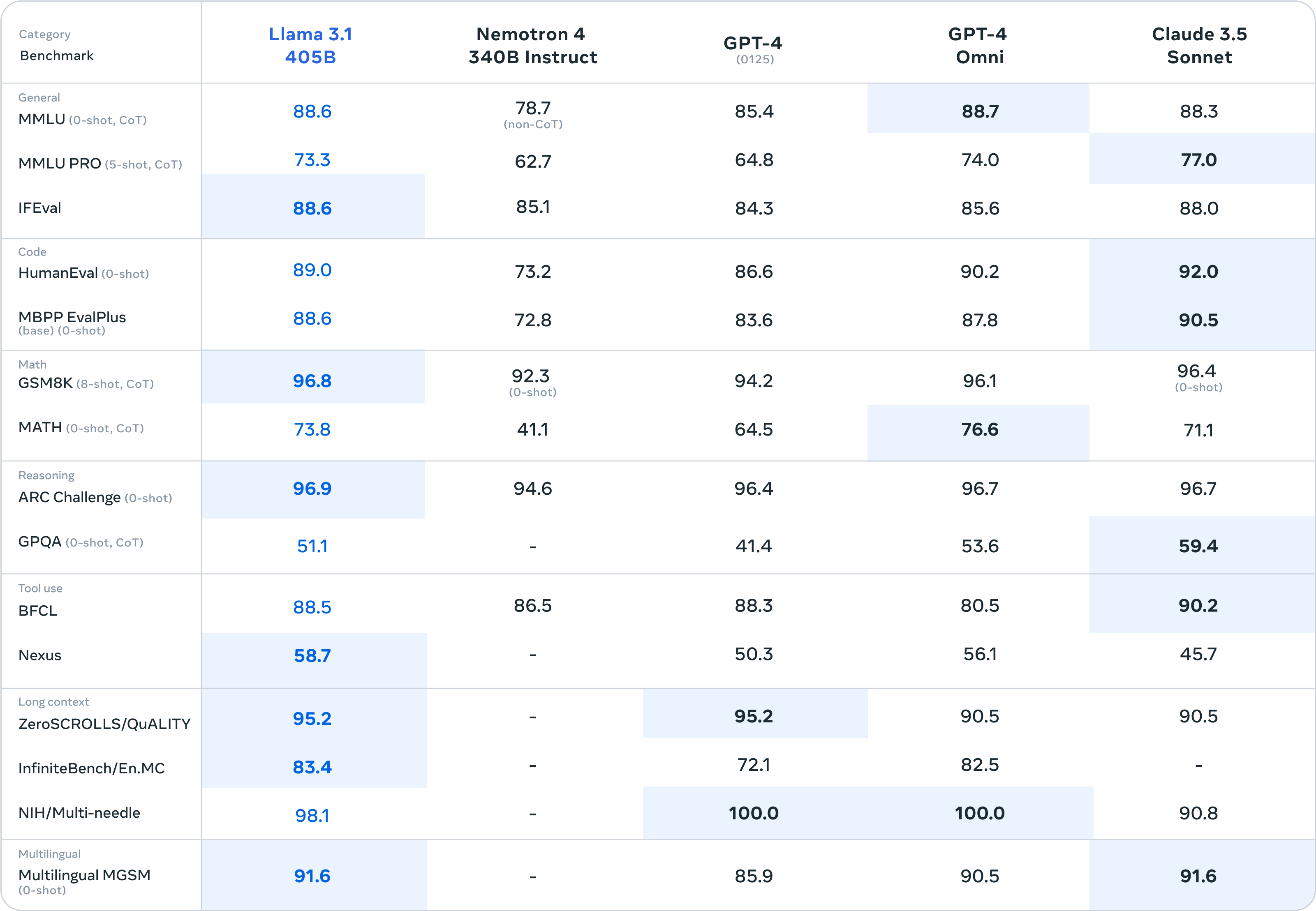

Llama 3.1 405B 是第一个公开可用的模型,在常识、可操纵性、数学、工具使用和多语言翻译等最先进的能力方面可与顶级 AI 模型相媲美。

8B 和 70B 模型的升级版本支持多种语言,上下文长度显著增加至 128K,工具使用先进,推理能力也更强。

这使得 Meta 的最新模型能够支持高级用例,例如长篇文本摘要、多语言对话代理和编码助手。

Meta 还对其许可证进行了修改,允许开发人员使用 Llama 模型(包括 405B 模型)的输出来改进其他模型。

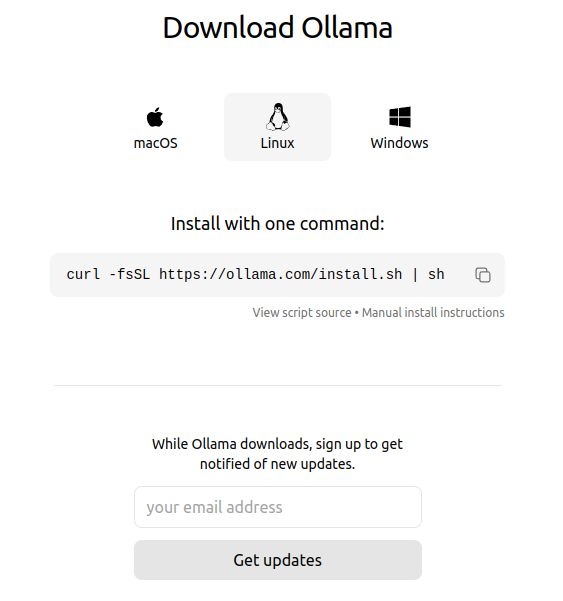

1、安装Ollama

来到官网地址:Download Ollama on macOS

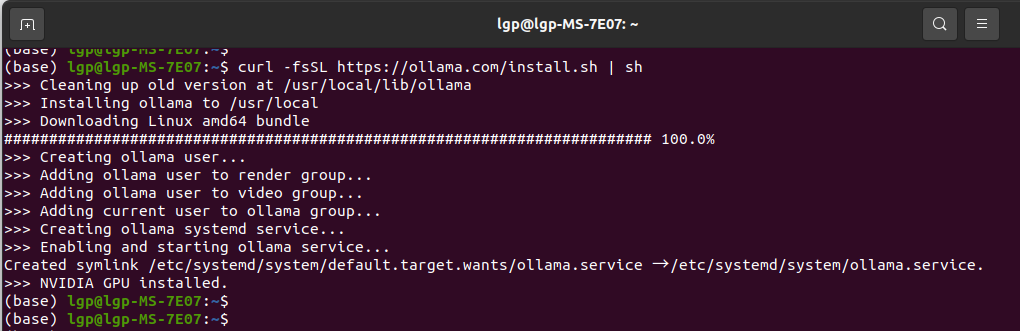

执行命令来安装ollama:curl -fsSL https://ollama.com/install.sh | sh

安装位置默认是在 /usr/local/lib/ollama

恭喜Ollama安装成功啦~

启动Ollama():ollama serve

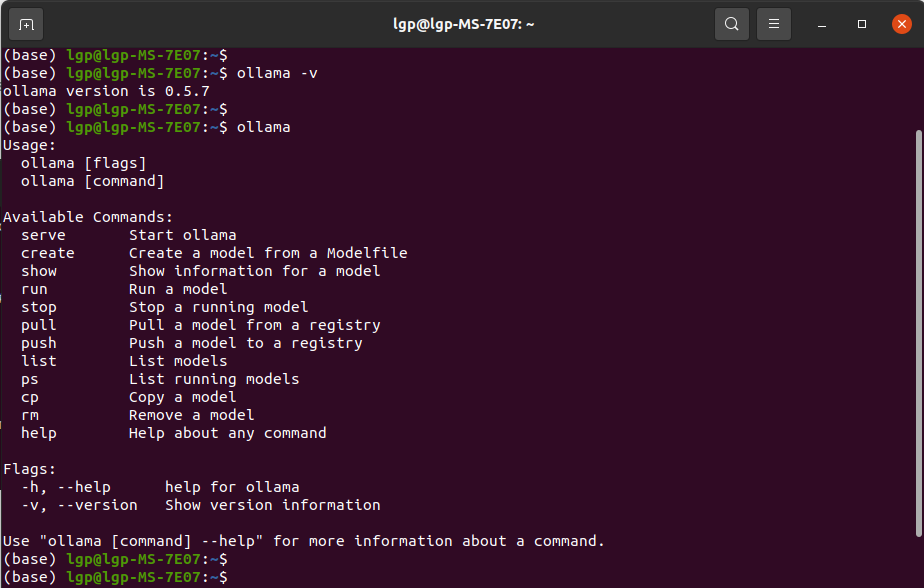

然后可以查询一下版本(可选):ollama -v

或者看一下ollama命令有那些参数(可选):ollama

2、加载和使用Llama3.1

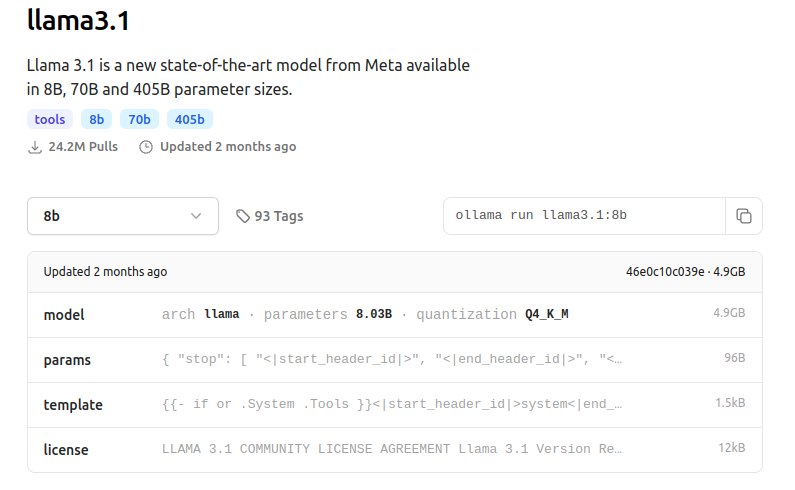

来到Ollama的模型库 https://ollama.com/library/llama3.1

Llama3.1,有三个版本:8B、70B、405B

这里可以先选择小的试一试,比如8b,

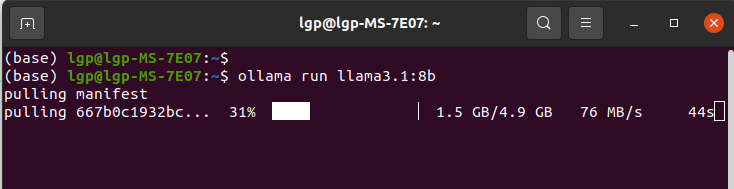

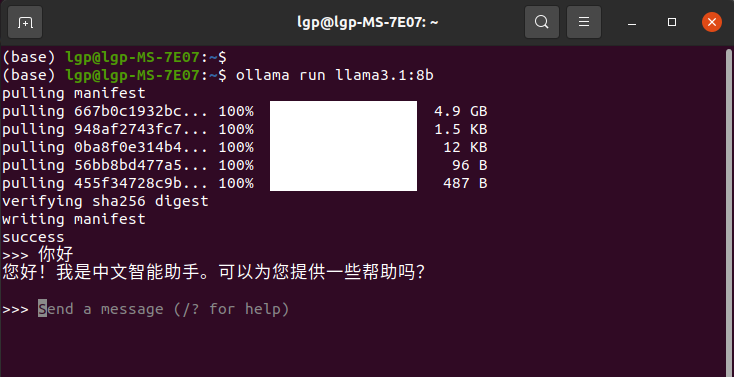

输入命令:ollama run llama3.1:8b

这里建议能科学上网,不然可能需要等待很久很久~

成功加载llama3.1:8b啦,能和它聊天交流~

如果想退出聊天,按下Ctrl + d

3、安装chatbox,改善聊天界面

如果使用命令进行聊天,感觉不太舒服,而且代码也不方便表示

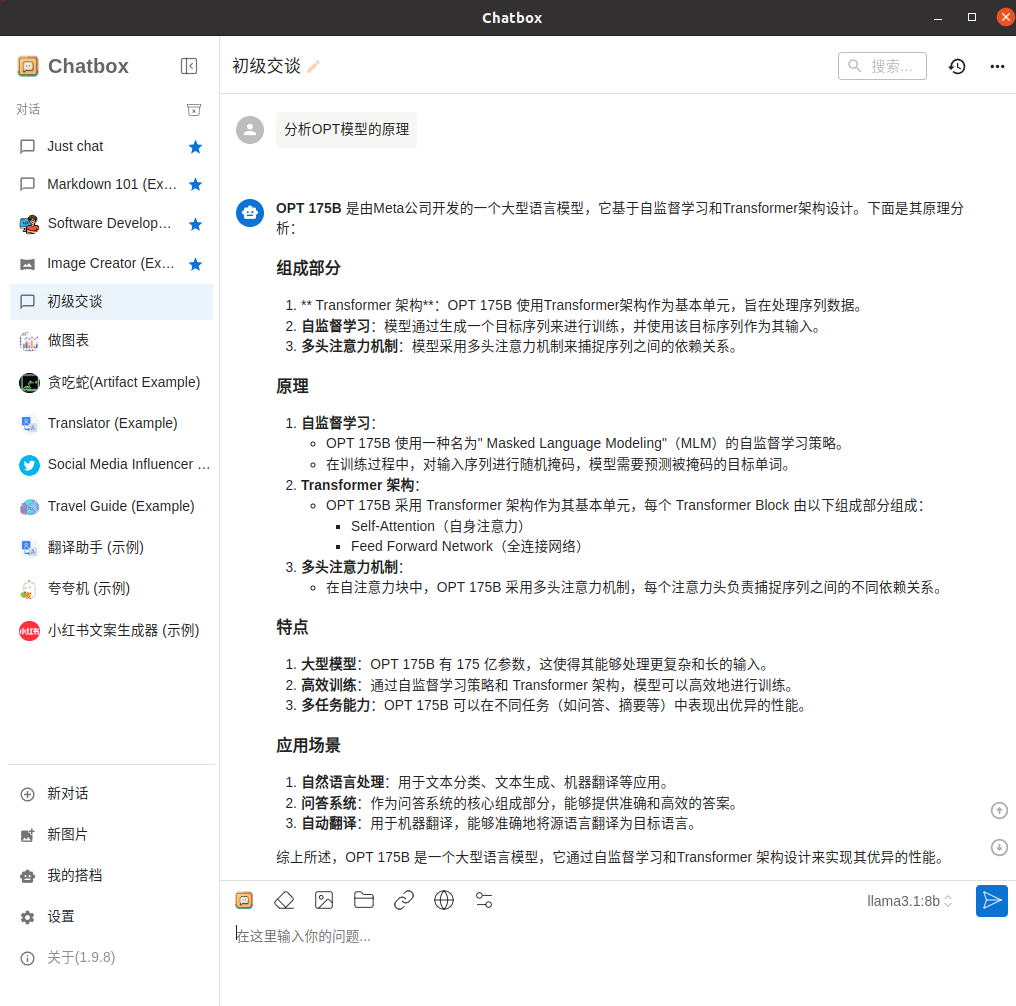

这时我们使用chatbox工具,然后加载DeepSeek-R1模型,这样可以用一个漂亮的可视化界面聊天啦

chatbox官网地址:Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

点击下载完成后,能看到Chatbox-1.9.8-x86_64.AppImage

我们需要给它添加可运行权限:

sudo chmod a+x Chatbox-1.9.8-x86_64.AppImage

然后双击运行,就能打开它啦~

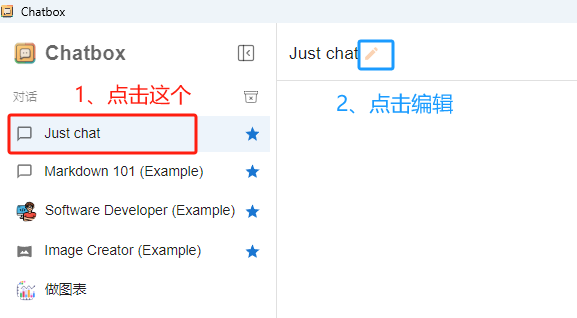

然后打开Chatbox,进行编辑配置

选择"OLLAMA API",然后选择模型"llama3.1:8b",其他配置默认就好啦

开启聊天啦

4、尝试不同版本的Llama

上面是llama3.1:8b的版本,用起来很流畅,于是尝试更大参数量的版本(70b、405b等)

对应的命令:

ollama run llama3.1:70b

ollama run llama3.1:405b

相关文章分享:

DeepSeek-R1 本地电脑部署 Windows系统 【轻松简易】_windows部署 deepseek r1-CSDN博客

DeepSeek-R1 本地电脑部署 Linux系统 【轻松简易】_14900kflinux-CSDN博客

分享完成~