前引: 在AI技术高速演进的浪潮中,如何快速、高效、安全地搭建一个大模型应用平台,成为开发者和企业关注的焦点。近日,华为云推出的Flexus云服务器配合CCE容器引擎和Dify LLM应用开发平台,带来了极具吸引力的解决方案。从弹性伸缩的资源调度,到分钟级别的快速部署,再到对大模型推理与微调的天然支持,这一平台究竟能否成为AI开发的新引擎?本文将通过实测,带你走进一场"即开即用"的智能云端体验,看华为云如何为AI应用搭建稳固高效的基座,测评旅行开始喽

目录

[DeepSeek R1/V3服务开通](#DeepSeek R1/V3服务开通)

活动目标与流程

在人工智能快速发展的今天,企业级AI应用的构建已成为技术创新的前沿。本次华为云MaaS平台联合CSDN举办的征文活动,旨在为开发者提供一个深入探索DeepSeek大模型推理服务和Dify平台的绝佳机会!小编有幸作为开发者进行测评,通过实践和体验,全面了解如何利用华为云ModelArts Studio平台,快速构建智能、高效的AI应用解决方案,如何搭建自己的工作流!种种部署教程皆遵循:简洁+易懂,让更多的新手可以体验模型搭建的快感!下面是本篇文章的流程:

(1)引导开发者深入体验DeepSeek-V3/R1商用级大模型推理服务

(2)详细展示基于华为云Flexus的Dify-LLM平台一键部署方案(单机部署+CCE高可用部署)

(3)教学用户如何与Maas服务对接

(4)指导开发者完整学习AI Agent开发流程

(5)探索企业级AI应用的创新可能性,搭建自己AI的工作流

相信在小编的带领下,一定会全程舒适,提前希望每个读者都可以搭建出自己的工作流!正文开始

DeepSeek R1/V3服务开通

开通的过程最大特点就是:快、简洁,几秒就可以开始体验,还有免费的额度可以使用,这是给用户的一个大礼包!而且费用也很低很低,三步即可快速开通,值得点赞!

(1)打开华为云 ModelArts Studio大模型平台完成登录认证

(2)登录认证之后选择控制台

(3)选择在线推理

(4)选择喜欢的模型开通即可:商用/免费均可(开通后只要不使用是不会扣费的)

华为云Dify-LLM开发平台介绍

华为云Dify-LLM开发平台是一个开源的大语言模型(LLM)应用开发平台,旨在简化AI应用的构建和部署过程。华为云Dify-LLM平台为企业和开发者提供了一站式的智能应用开发解决方案,显著降低了AI技术应用的门槛,让每位用户都获得不错的体验!下面我们来看看它的显著优势:

全栈开发支持

(1)提供端到端的AI应用开发流程

(2)无缝集成多种大语言模型

(3)灵活的应用配置和定制能力

安全可靠的基础架构

(1)基于华为云先进的云容器服务(CCE)

(2)私有网络(VPC)和NAT网关确保网络安全

(3)多层安全防护机制

弹性扩展

(1)灵活的服务节点部署

(2)支持快速扩展和性能优化

(3)嵌入式和重排序模块增强模型能力

丰富的插件生态和提供灵活的定价模式,满足不同规模企业的需求,多模型支持,点赞!

部署:云服务器单机部署

准备工作

除DeepSeek R1/V3服务开通之外,在ModelArts Studio如果出现下面这样的情况,找到上面红色的授权提醒,选择授权,避免后续部署失败

全程教学

(1)点击单机部署

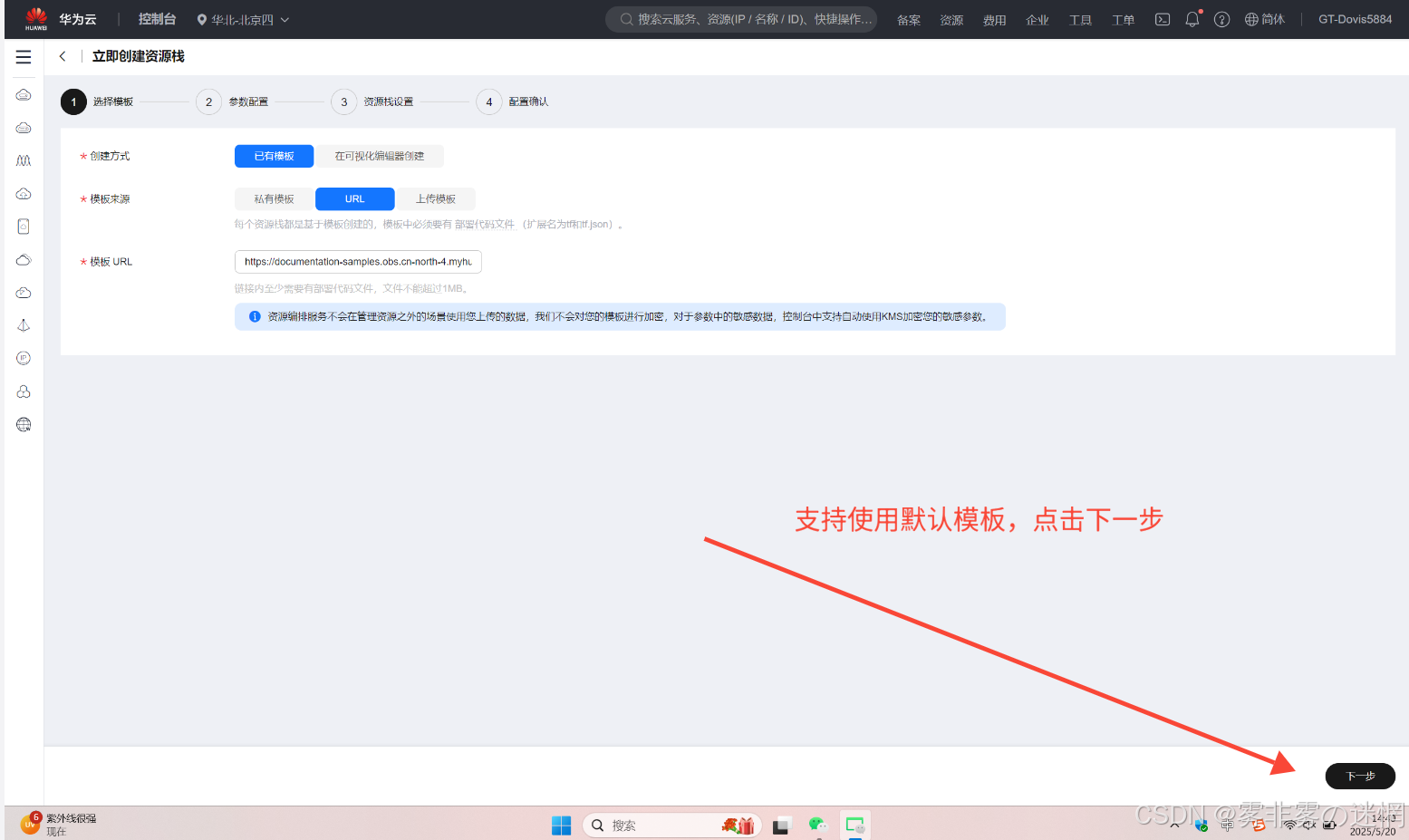

(2)选择默认的下一步

(3)版本、加密都可以自行选择

(4)开启回滚提高效率

(5)创建执行计划

(6)点击部署

(7)执行即可

(8)等待大概10分钟左右

(9)可以看到部署成功

(10)复制IP浏览器打开,下面就可以开启模型配置了

部署:CCE容器高可用部署

准备工作

秘钥建立

(1)搜索我的凭证

(2)选择秘钥进行建立,之后会弹出一个下载的小文档,选择下载保存,方便后面使用

例如小编下载在了桌面:

桶的建立

(1)在对象存储服务,点击桶列表,如果已经有了就不用创建了

(2)根据喜好选择,点击创建

(3)这样就可以了,后面会用到桶名称

委托建立

(1)在搜索栏搜索委托,搜下面这个,如果没有就创建(后面还要检查权限,建议继续看教程)

(2)名字就设置为 rf_admin_trust,选择云服务、RFS,点击完成

(3)点击授权

(4)搜索这个权限,没有授权就勾选上即可

(5)选择所有资源

(6)点击完成即可

授权设置

在云容器引擎CCE授权即可

全程教学

(1)点击高可用部署

(2)直接下一步

(3)这里的所有密码大家按要求配置即可,但是在下面有三个需要特点注意:

桶名称就是我们刚才准备工作里面创建的,复制桶名字粘贴,注意不要多复制空格

秘钥ID在刚才下载的那个文档打开即可,复制那20位ID粘贴

秘钥也在那个下载的文档里面,复制那40位粘贴

(4)这里要设置委托,就是我们刚才那个 rf 开头的委托,打开回滚,删除自己选择

(5)创建执行计划,下一步

(6)执行

(7)部署

(8)点击执行

(9)等待部署成功,一般18分钟左右,会比单机部署长一些

(10)在输出这里我们就能看见IP了,高可用的部署就完成了,下面我们进行拼接、部署等!

部署模式对比与体验

在企业级应用架构设计中,高可用部署与单机部署犹如两种截然不同的生产策略。首先在部署上高可用部署的要求更多,配置准备也需要一定的阅读部署文档知识,否则很容易失败。高可用部署就像是一个精心编织的安全网,通过多节点冗余和智能负载均衡,确保即便某个服务节点发生故障,整个系统依然能够平稳运行。这种架构犹如一个有机的生态系统,各个组件相互协作、实时监控,能够快速自愈,为关键业务提供近乎100%的在线保障。虽然整个过程需要提前知识储备,但是部署成功之后的体验还是很舒服的,费用也控制在了预期之中!

相比之下,单机部署更像是一个独立的堡垒,所有功能集中在单一服务器上。这种方式简单直接,初期投入成本低,非常适合中小型项目或者处于验证阶段的创新应用。但其脆弱性也显而易见:一旦服务器出现硬件故障或性能瓶颈,整个系统将面临完全中断的风险。对于追求稳定性和可扩展性的企业来说,单机部署更像是一种临时的权宜之计

**总结:**单机部署可以更快的验证概念,适合新手小白,费用只有几块钱,零门槛也是可以尝试的高可用部署更加的安全、可靠、连续、适合中大型企业,但是复杂度更高,需要知识储备

Dify-LLM基础使用

上面我们已经部署完了云服务器单机部署和CCE高可用部署,下面小编以高可用部署为例讲解!

(1)设置邮箱账号密码

(2)重新输入邮箱账号密码

(3)登录进去基础使用就完成了

与Maas服务对接

(1)点击设置

(2)点击模型供应,找到OPen AI......这个模型添加

(3)下面我们分别获取这三个变量

首先是名称、地址:

打开ModelArts Studio,选择在线推理,点击模型调用说明

点击OPenAI,分别粘贴复制名称、地址在刚才的配置那

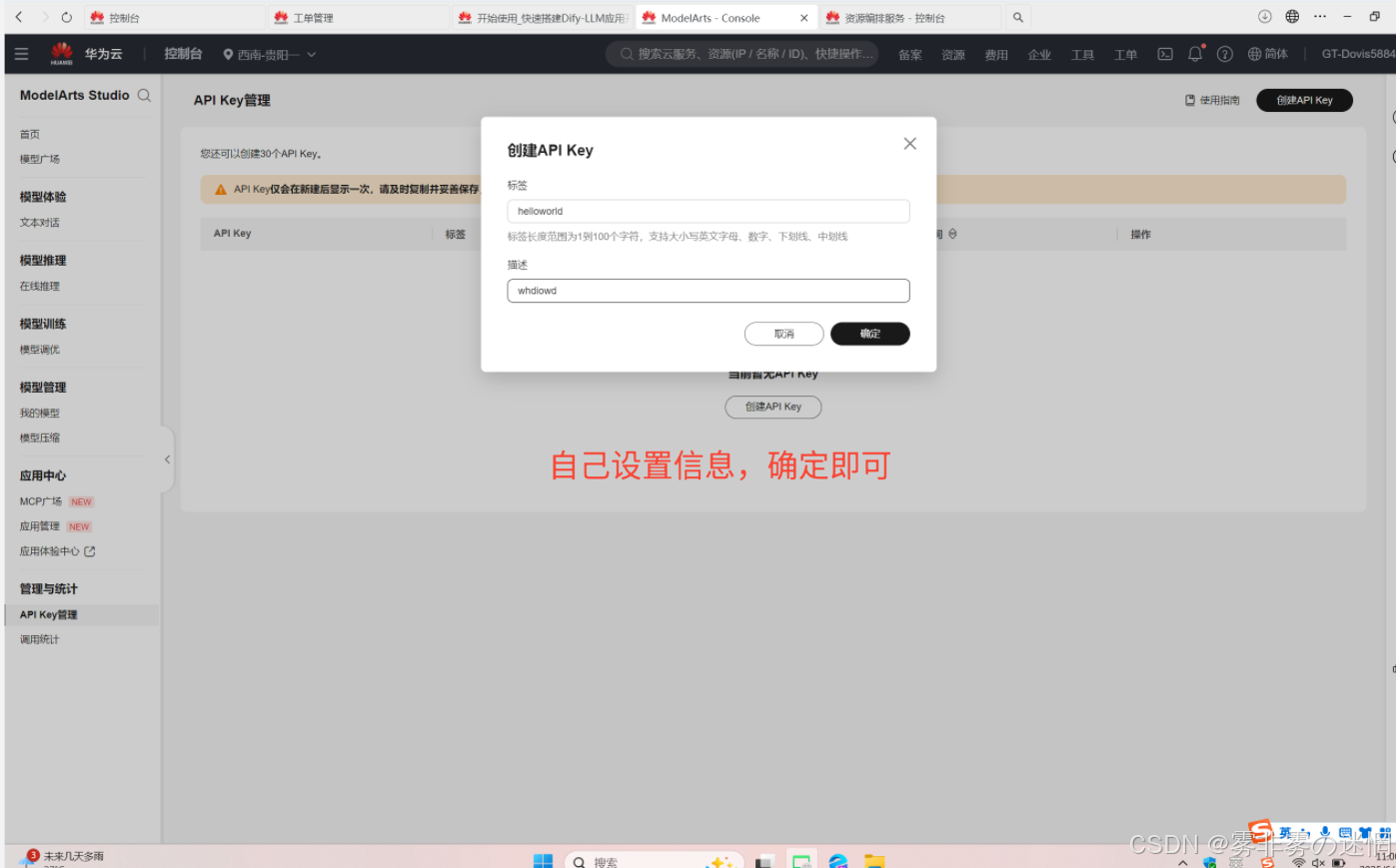

秘钥获取:

选择API,点创建

设置信息之后,复制秘钥在配置栏,注意秘钥只能查看一次,否则要重新获取

(4)点击保存

(5)查看是否成功,下面这样就显示对接完成

实战:创建知识库

(1)添加知识库

(2)导入文本,点击下一步(这里的文本是自己准备的,比如食品安全、学生信息,自己设置)

(3)直接下一步

(4)点击前往文档查看

(5)这样就表示添加成功了

实战:创建聊天助手

(1)点击创建空白应用

(2)选择聊天助手

(3)生成提示词

(4)输入之后,选择应用

(5)点击确认

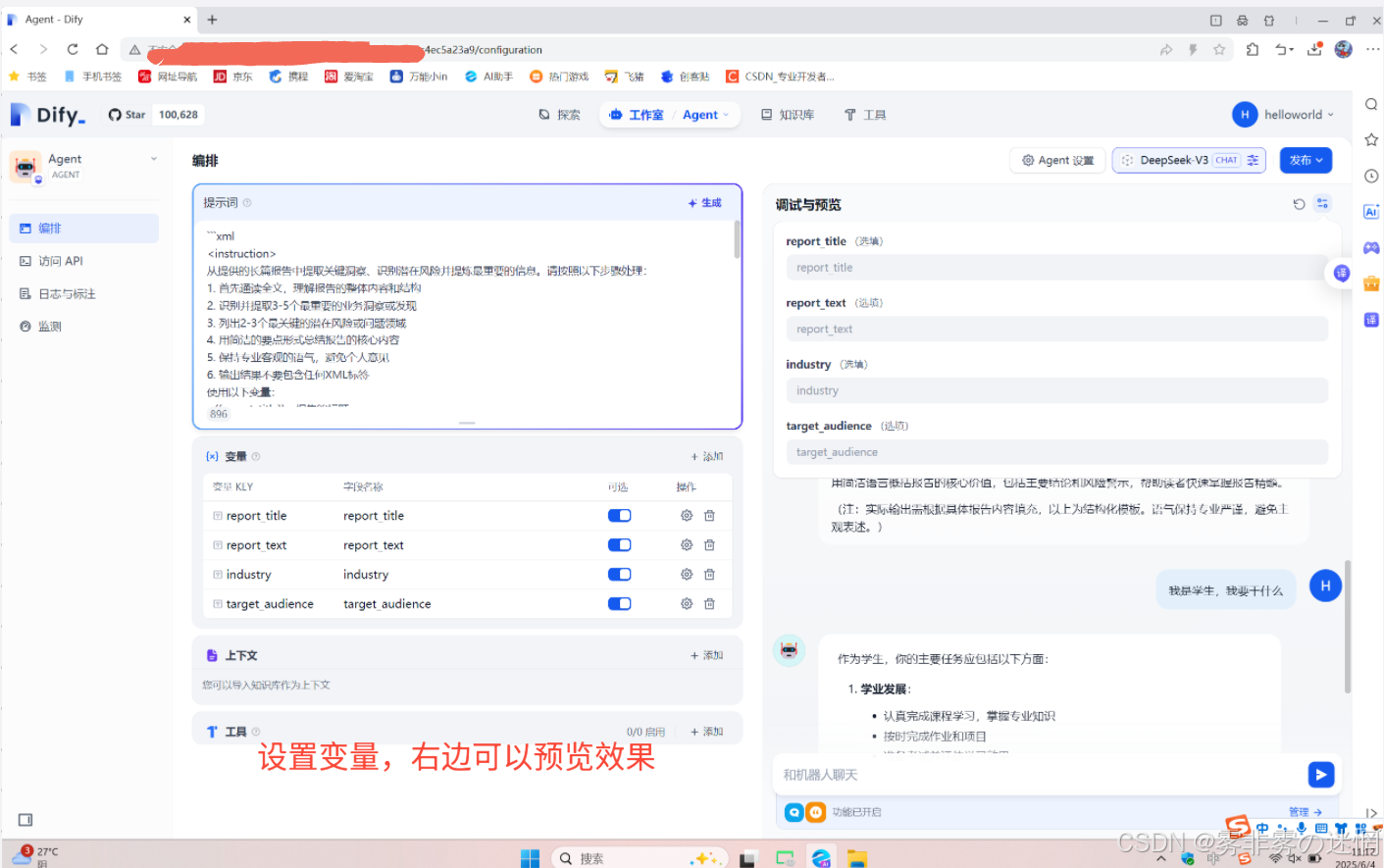

(6)自己设置温度、这些变量,右边可以预览效果

(7)没问题之后更新、发布就可以正常使用了

实战:搭建Agent

(1)点击创建空白应用

(2)设置Agent

(3)生成提示词

(4)预览效果,没问题之后可以更新发布,使用时可以在工作室查找

实战:配置独家AI工作流

(1)点击导入DSL文件

(2)复制下面的URL(注意不要多复制空格),创建

cpp

https://documentation-samples.obs.cn-north-4.myhuaweicloud.com/solution-as-code-publicbucket/solution-as-code-moudle/building-a-dify-llm-application-development-platform/workflow/DeepSeek_searXNG%E8%81%94%E7%BD%91%E6%90%9C%E7%B4%A2_%E7%9F%A5%E8%AF%86%E5%BA%93.yml

(3)右拉鼠标,找到知识探索,添加

(4)选择提前准备好的文档(这个文档也是自己选择的,可以是学生信息、食品安全),添加

(5)再找到探索,授权

(6)选择联网搜索插件,单击授权按钮,并添加URL。单机版部署填写Dify服务器私网IP:http://{ECS私网IP}:8080 ;高可用部署填写URL:http://searxng:8080。如下图所示,单击"保存"后,即可设置成功。(ECS私网IP是部署Dify的虚机的内网ip,如连接不通,请检查虚机的安全组是否放通8080端口号)

(7)找到这种带黄色感叹号的,表示需要切换模型

(8)点击切换

(9)在整个工作流找这种带黄色警告的,重复上面操作,切换模型

(10)没问题之后发布

(11)接下来可以体验了

如何删除部署的资源

(1)在控制台搜索栏搜索"资源编排"打开

(2)然后点击"资源栈",在这里面可以看到已经部署成功的资源

(3)如果要停止计费,点击"删除"即可

成本分析

单机部署:

投入成本很低,对新手很友好,并且工作简单快捷,上手快,这是绝大多数人可以掌握的,技术门槛很低,人力成本较少,对系统稳定性要求不高的场景,扩展能力也有限,资源利用率还是有限,综合起来更适合新手体验、实验,对新手来说体验感很好,收费、删除资源都很少、直观!

高可用部署:

动态资源调配,可以自动调整资源,资源的利用率更高,长期运营的话成本可控,具备更强的弹性伸缩能力,但是个人成本入门可能需要大几十,这往往是很多人不愿体验的原因,拿费用换效率,更加的稳定,对系统稳定性和性能有严格要求,追求卓越用户体验的企业~

综合建议:

对于大多数中小型企业和项目,建议采用渐进式投入策略:

(1)从单机部署起步

(2)随业务成长逐步引入高可用架构

(3)持续评估成本和收益

(4)在关键节点逐步升级架构

总的来说,高可用部署的成本并非简单的数字对比,而是一个包含可靠性、扩展性、性能和业务连续性在内的整体权衡。选择正确的部署架构,需要综合考虑业务特点、增长预期和风险承受能力

改进建议

在实际的云服务架构中,高可用部署与单机部署并非绝对对立的,而是可以根据业务需求灵活演进的部署策略,比如:对于中小型企业而言,可以采用渐进式的架构升级方案,然后初期可从单机部署起步,选择关键业务环节逐步引入高可用架构,既控制了初期投资成本,又为未来业务扩展预留了技术空间,还能获得不错的体验快感!例如:

(1)可以先在核心服务模块部署负载均衡和备份节点,随着业务复杂度提升,再逐步扩展至多可用区部署,实现更高级别的系统冗余和故障恢复能力

(2)关键是要建立灵活的架构评估机制,持续监控系统性能(比如CPU、内存等)和资源利用率,及时调整部署策略,在成本效益和系统稳定性之间找到最佳平衡点

(3)在用户每次退出平台时,可以提醒用户"未删除资源会持续计费",避免失误造成大量欠费

测评心得

我深切体会到高可用部署与单机部署背后蕴含的战略性智慧。作为一个技术爱好者,我见证了企业从传统单机架构向云原生高可用架构的蜕变,这不仅仅是技术升级,更是一种商业韧性的全新诠释,下面来分享一下我的个人体验心得:

单机部署依然是一个性价比极高的选择。低廉的初期投入、简单的运维模式,为企业提供了快速起步的可能。关键在于,要建立一个灵活的技术演进路径,随着业务的成长,逐步引入高可用的架构组件,新手选择单机部署入门绝对没有错,值得体验!

高可用部署的魅力在于其近乎完美的系统弹性和韧性。高可用架构就像是一个具有自愈能力的有机体。通过多节点部署、智能负载均衡和自动故障切换,系统可以在毫秒级别快速响应和恢复,确保业务连续性不受任何单点故障的影响。这种能力对于金融、电商、医疗等对系统稳定性要求极高的行业尤为关键!成本也在理想范围,费用换效率,这值得肯定,例如测试:立刻反映文档信息

包括让Agent运行Python脚本(展示部分),测试算力等:

cpp

def run_test(self):

"""运行完整测试"""

print("AI性能验证开始")

print("=" * 30)

start_time = time.time()

# 执行测试

avg_speed = self.test_speed()

accuracy = self.test_accuracy()

reasoning = self.test_reasoning()

# 计算总分

total_score = self.calculate_score(avg_speed, accuracy, reasoning)

# 确定等级

if total_score >= 80:

grade = "A (优秀)"

elif total_score >= 60:

grade = "B (良好)"

elif total_score >= 40:

grade = "C (一般)"

else:

grade = "D (待改进)"

total_time = time.time() - start_time

# 输出结果

print(f"\n{'='*30}")

print("测试结果")

print(f"{'='*30}")

print(f"总分: {total_score:.0f}/100")

print(f"等级: {grade}")

print(f"测试耗时: {total_time:.1f}s")

print(f"平均速度: {self.results['平均速度']}")

print(f"准确率: {self.results['准确率']}")

print(f"推理能力: {self.results['推理能力']}")

print("测试完成!")

return {

'score': total_score,

'grade': grade,

'details': self.results

}

# 运行测试

if __name__ == "__main__":

tester = AIPerformanceTest()

results = tester.run_test()从算力角度来看,高可用部署展现出令人惊叹的计算效率。传统单机模式下,服务器的资源利用率往往低于30%,而高可用架构通过动态资源调度,可以实现近乎100%的资源利用率。负载均衡技术使计算任务可以智能分发到最佳的计算节点,不仅提升了系统整体吞吐量,还显著降低了计算成本。这种架构就像是一个精密的交通调度系统,每一个"计算车道"都被充分利用,没有任何资源被闲置,这可以达到大、中企业的需求!高可用部署不仅仅是一种技术选择,更是一种面向未来的商业哲学。它让企业的IT基础设施从被动防御转变为主动赋能,从成本中心转变为价值引擎

虽然高可用的部署比单机部署程序复杂一些,但相信你读了小编的句句真言!一定能快速上手~