目录

[二、Dify 介绍](#二、Dify 介绍)

[2.1 Dify 是什么](#2.1 Dify 是什么)

[2.2 Dify 核心特性](#2.2 Dify 核心特性)

[2.2.1 多模型支持](#2.2.1 多模型支持)

[2.2.2 可视化编排工作流](#2.2.2 可视化编排工作流)

[2.2.3 低代码/无代码开发](#2.2.3 低代码/无代码开发)

[2.3 Dify 适用场景](#2.3 Dify 适用场景)

[2.4 Dify 与Coze的对比](#2.4 Dify 与Coze的对比)

[2.4.1 定位与目标用户](#2.4.1 定位与目标用户)

[2.4.2 核心功能对比](#2.4.2 核心功能对比)

[2.4.3 开发体验与成本](#2.4.3 开发体验与成本)

[2.4.4 适用场景对比](#2.4.4 适用场景对比)

[2.4.5 其他差异对比](#2.4.5 其他差异对比)

[三、Dify 部署过程详解](#三、Dify 部署过程详解)

[3.1 环境准备](#3.1 环境准备)

[3.1.1 服务器环境](#3.1.1 服务器环境)

[3.1.2 Docker环境](#3.1.2 Docker环境)

[3.1.3 Docker Compose 环境](#3.1.3 Docker Compose 环境)

[3.2 服务器安装git](#3.2 服务器安装git)

[3.3 Dify 部署操作步骤](#3.3 Dify 部署操作步骤)

[3.3.1 下载git包](#3.3.1 下载git包)

[3.3.2 配置环境变量](#3.3.2 配置环境变量)

[3.3.3 启动dify容器](#3.3.3 启动dify容器)

[3.3.4 访问dify控制台](#3.3.4 访问dify控制台)

[3.3.5 设置管理员并登录](#3.3.5 设置管理员并登录)

[四、Dify 基本配置与使用](#四、Dify 基本配置与使用)

[4.1 配置大模型](#4.1 配置大模型)

[4.1.1 安装大模型插件](#4.1.1 安装大模型插件)

[4.1.2 大模型配置](#4.1.2 大模型配置)

[4.2 创建应用](#4.2 创建应用)

[4.2.1 从模板创建应用](#4.2.1 从模板创建应用)

[4.2.2 创建空白应用](#4.2.2 创建空白应用)

一、前言

在当下人工智能飞速发展的今天,大语言模型(LLM)应用日益广泛。Dify 作为一款开源的 LLM 应用开发平台,融合了后端即服务(Backend as a Service, BaaS)和 LLMOps 的理念,为开发者提供了一种高效、便捷的方式来构建生产级的生成式 AI 应用。

Dify支持多种主流大语言模型,如GPT、Mistral、Llama3等,并通过低代码/无代码开发方式,降低了开发门槛。其核心特性包括多模型支持、丰富的功能组件和灵活的应用编排,适用于智能客服、内容生成、数据分析等多个应用场景。Dify通过可视化的界面和强大的RAG引擎,帮助开发者快速构建和优化AI应用,显著提高了开发效率和应用质量。与同类产品相比,Dify在API优先、灵活应用编排和插件生态方面具有显著优势,适合不同技术背景的开发者使用。未来,Dify有望在AI应用开发领域发挥更大的作用,推动AI技术的普及和创新。

二、Dify 介绍

2.1 Dify 是什么

Dify 是一个开源的大模型应用开发平台,旨在帮助开发者快速构建、部署和管理基于大型语言模型(LLM)的 AI 应用。它提供了一套完整的工具链,支持从提示词工程(Prompt Engineering)到应用发布的全流程,适用于企业级 AI 解决方案和个人开发者项目。

官网入口:Dify: Production-Ready AI Agent Builder

中文站入口:Dify:企业级 AI Agent 开发平台

Dify 一词源自 Define + Modify,寓意着定义并且持续改进 AI 应用,强调了其为用户提供的灵活定制和持续优化的能力。

2.2 Dify 核心特性

Dify 具备如下核心特点:

-

可视化编排工作流

-

通过低代码界面设计 AI 应用流程,无需深入编程即可构建复杂的 LLM 应用。

-

支持 对话型(Chat App) 和 文本生成型(Completion App) 应用。

-

-

多模型支持

-

兼容主流大模型 API,如 OpenAI GPT、Anthropic Claude、Cohere、Hugging Face 等。

-

支持私有化部署的 Llama 2、ChatGLM、通义千问 等开源模型。

-

-

灵活的提示词工程

-

提供 Prompt 模板、变量插值、上下文管理等功能,优化 AI 输出效果。

-

支持 RAG(检索增强生成),可结合外部知识库提升回答准确性。

-

-

数据管理与持续优化

-

记录用户与 AI 的交互日志,用于分析和迭代改进模型效果。

-

支持 A/B 测试,对比不同提示词或模型版本的表现。

-

-

企业级功能

-

支持 多租户、权限管理,适合团队协作开发。

-

可私有化部署,保障数据安全。

-

2.2.1 多模型支持

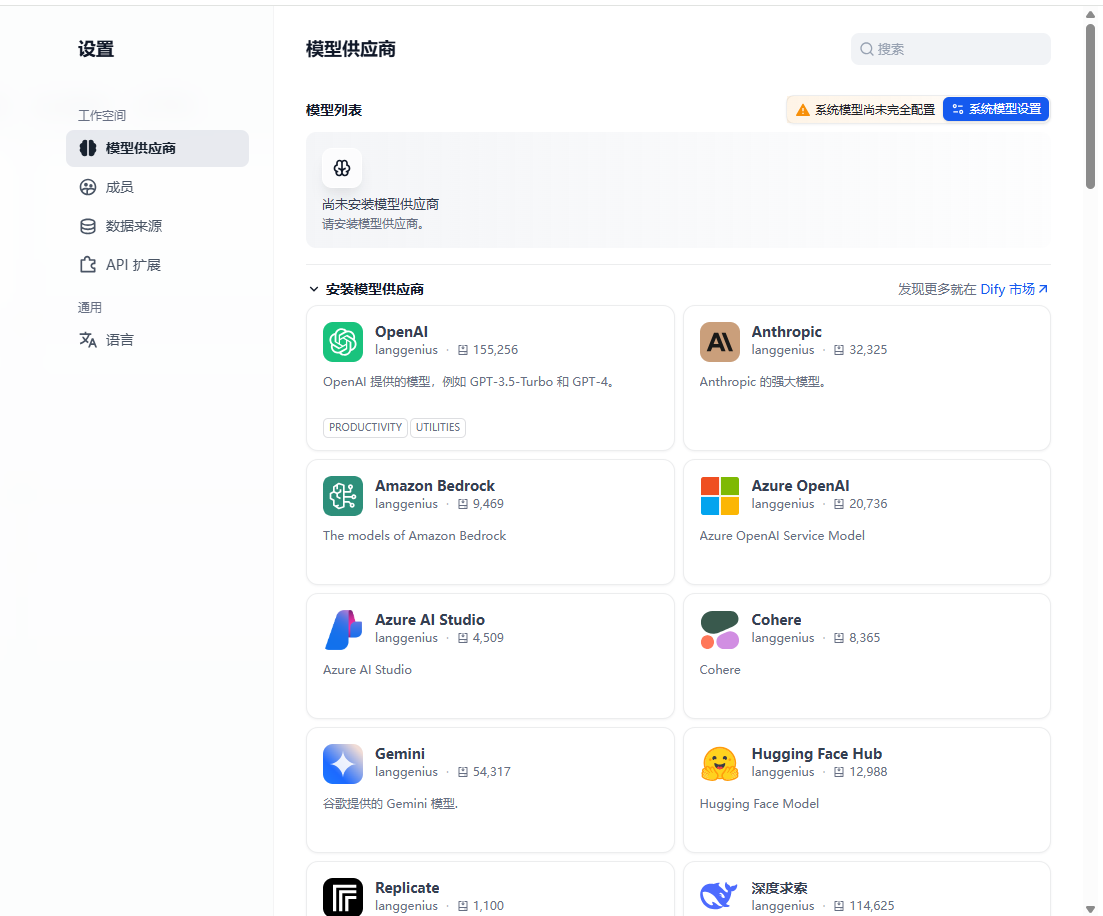

在dify控制台,内置了非常多的大模型可供用户选择使用,比如GPT系列,DeepSeel大模型等

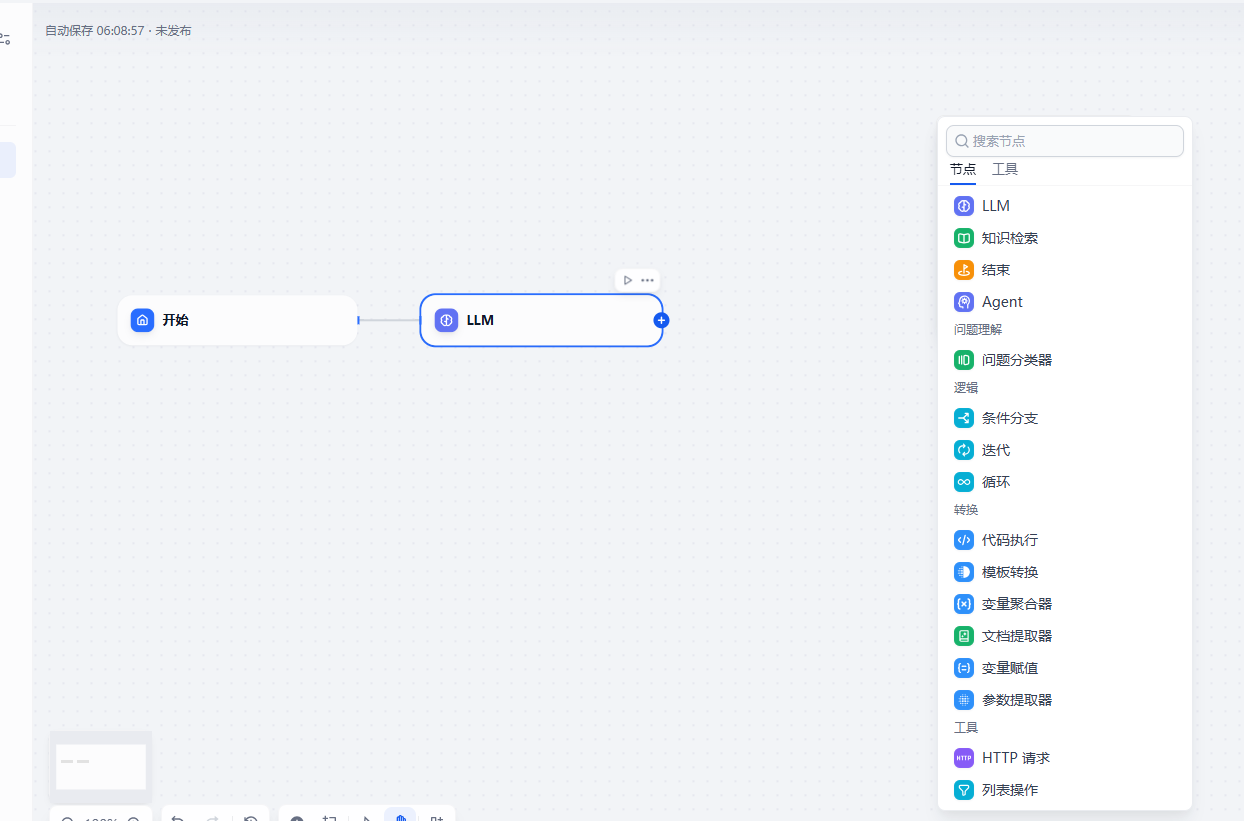

2.2.2 可视化编排工作流

dify提供了可视化的编排工作流,工作流的配置非常灵活,可以帮助用户根据自身的需要在一个流程中增加各类节点,从而完成一些非常复杂的场景下的流程编排业务。

2.2.3 低代码/无代码开发

Dify 提供了直观的可视化界面,和在使用Coze的时候一样,用户只需要通过拖拉拽,并结合界面参数配置的方式,即可快速搭建出一个AI智能体的应用,而无需编写大量代码 。

这一特性大大降低了AI应用开发门槛,即使没有编码功底的人也能参与到AI应用开发中。这样不仅提高了开发效率,还能让更多的人参与到 AI 创新中来,推动 AI 技术在各个领域的广泛应用。

2.3 Dify 适用场景

Dify 适用于多种生成式 AI 应用开发场景:

-

内容创作与生成

-

自动化生成文章、报告、营销文案等

-

结合知识库实现专业领域内容生成(如法律、医疗文档)

-

-

智能对话系统

-

构建多轮对话客服机器人、虚拟助手

-

通过 Agent 框架实现任务分解与工具调用(如搜索、图像生成)

-

-

数据分析与自动化

-

解读复杂数据并生成可视化报告

-

自动化业务流程(如工单处理、邮件回复)

-

-

个性化推荐与营销

-

基于用户画像生成个性化推荐内容。

-

结合RAG实现精准信息检索与推送。

-

2.4 Dify 与Coze的对比

说到Dify的时候,很难不联想到与其功能类似的另一款AI智能体产品Coze,下面从几个方面对它们做一些对比分析,便于后续进行选择参考。以下是 Dify 和 Coze 的详细对比,涵盖定位、功能、适用场景等多个维度。

2.4.1 定位与目标用户

从两者产品的定位与用户群体来说,两者异同点如下:

-

核心定位

-

Dify

- 企业级 AI 应用开发平台,强调灵活性与私有化部署

-

Coze

- 轻量级 AI Bot 开发平台,主打快速部署与社交生态集成

-

-

目标用户

-

Dify

- 专业开发者、企业(金融、医疗等需数据合规的场景)

-

Coze

- 个人开发者、中小团队、非技术人员(C端应用)

-

-

开发模式

-

Dify

- 低代码/API 优先,支持复杂业务逻辑编排

-

Coze

- 零代码/拖拽式操作,模板驱动快速搭建

-

总结来说:

Dify 适合需要深度定制、多模型混合调用或数据敏感的企业级应用;

Coze 适合快速构建社交机器人、轻量级客服等场景,尤其依赖字节生态(如抖音、飞书);

2.4.2 核心功能对比

两者在核心功能上也有一些差异,如下:

|-------|-------------------------------------|-------------------------------|

| 功能 | Dify | Coze |

| 模型支持 | 多模型接入(GPT-4、Llama、Claude 等),支持私有化部署 | 主要依赖字节自研模型(如豆包AI),海外版支持有限 |

| 知识库 | 支持长文本分段(如法律合同、科研论文),RAG 优化 | 单文件限制 6000 token,需手动分割,检索精度较低 |

| 工作流编排 | DSL 引擎,支持可视化与代码双模式,节点类型丰富 | 节点操作灵活但功能较浅,支持嵌套工作流 |

| 数据隐私 | 支持私有化部署,数据完全自主控制 | 仅云端服务,数据需上传第三方平台 |

| 插件生态 | 50+ 内置工具(如 Google 搜索、DALL·E) | 60+ 官方插件(如新闻、旅游),扩展便捷 |

总结来说:

-

Dify 在模型灵活性、知识库处理和企业级功能上更强

-

Coze 在插件丰富性和社交平台集成上更优

2.4.3 开发体验与成本

从开发体验与成本来说,具有如下差异:

|------|------------------------------|----------------------|

| 维度 | Dify | Coze |

| 学习曲线 | 需熟悉 Prompt 工程和 LLMOps,技术门槛较高 | 拖拽式界面,5 分钟即可上手 |

| 成本 | 开源免费,但需自行承担模型调用与运维成本 | 免费版功能受限,高级功能依赖字节生态资源 |

| 部署方式 | 支持本地/云端私有化部署 | 仅限云端服务,一键发布至社交平台 |

总结来说:

-

Dify 适合长期投入的企业级项目,成本可控但需技术储备

-

Coze 试错成本低,适合快速验证创意

2.4.4 适用场景对比

两者在实际适用的场景上也稍有差别,如下:

-

选 Dify:

-

复杂业务逻辑(如智能投顾、医疗诊断系统)

-

需多模型混合调用或数据敏感的场景(如金融合规)

-

-

选 Coze:

-

快速搭建社交机器人(如抖音客服、微信公众号助手)

-

团队技术能力较弱或需快速原型验证

-

2.4.5 其他差异对比

最后再补充下面几点差异对比:

-

用户体验

- Coze 的工作流设计更直观(如节点自由拖拽、撤销功能),而 Dify 的日志分析和调试功能更专业

-

生态绑定

- Coze 深度集成字节系应用(如抖音、飞书),Dify 提供标准化 API 便于跨平台集成

三、Dify 部署过程详解

接下来通过实际操作演示下如何基于云服务器(linux环境)部署Dify的详细流程。

3.1 环境准备

部署Dify,有多种方式,本文采用比较通用也是官方推荐的一种部署方式,即采用Docker部署Dify。

3.1.1 服务器环境

基于linux操作系统,云服务器或虚拟机,服务器配置至少2C4G。

3.1.2 Docker环境

提前在服务器安装并配置Docker环境。

- 版本需在 24.0+

为了后面在构建镜像过程中顺利进行,建议在docker中提前配置相关的镜像源,参考下面的配置:

java

{

"registry-mirrors":[

"https://docker.m.daocloud.io",

"https://docker.rainbond.cc",

"https://docker.lmirror.top"

],

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false

}3.1.3 Docker Compose 环境

本文将基于Docker Compose命令构建Dify镜像,因此需要提前安装docker compose环境

- 版本号可以结合自身的情况选择,一般建议不要于docker的版本相差太大

bash

sudo curl -L "https://github.com/docker/compose/releases/download/1.29.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose安装完成后,可用使用下面的命令检查一下

3.2 服务器安装git

服务器如果没有安装过git的话,使用下面的命令安装一下

bash

yum install git

3.3 Dify 部署操作步骤

3.3.1 下载git包

使用下面的命令下载dify的安装包

bash

git clone https://github.com/langgenius/dify.git

3.3.2 配置环境变量

进入到docker目录之后,配置环境变量信息,将下面的文件拷贝一份,命名为:.env,该文件可用于设置数据库、API 密钥等配置信息,后续需要使用的时候参考相关的资料进行配置即可,先保持默认的即可。

3.3.3 启动dify容器

在/dify/docker目录下,默认提供了可用于构建dify镜像的 docker-compose.yaml 文件,在当前目录下,只需要执行命令即可

bash

docker-compose up -d耐心等待一会,等待镜像构建完成,以及容器启动完成

看到上面的输出之后,使用docker ps命令查看相关的容器

3.3.4 访问dify控制台

如果是在linux环境部署的,请提前开放 3000端口,客户端浏览器访问的端口,然后访问: IP:3000

3.3.5 设置管理员并登录

初次访问时,dify要求设置一个管理员账户

设置完成后,跳转到下面的登录界面

登录成功后,就跳转到下面的主页了

四、Dify 基本配置与使用

上述完成了Dify的部署过程,接下来简单介绍下Dify的配置和使用。

4.1 配置大模型

Dify 是基于大语言模型的 AI 应用开发平台,后续使用Dify时需要接入大模型,Dify 目前已支持市面上主流的模型供应商,可以通过如下步骤设置Dify使用的大模型(以接入deepseek为例),参考下面的配置过程。

4.1.1 安装大模型插件

点击右上角个人账户下面的设置按钮

然后来到下面的大模型列表页面,在这个页面,Dify内置并展示了当前市面主流的大模型列表,可供使用者选择

如果第一页没有找到,继续往下找,找到deepseek大模型

然后点击安装

等待安装完成即可

安装完成后,回到模型供应商列表,就能看到刚刚安装的这个deepseek插件了

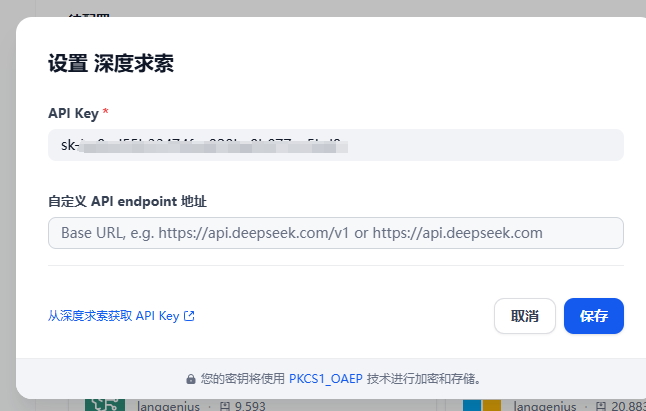

4.1.2 大模型配置

安装模型完成后,需要对模型进行配置,设置模型的API-KEY,如下(以deepseek为例),API-KEY需要自己在对应大模型官网进行设置,部分模型API-KEY需要付费。

4.2 创建应用

应用是使用dify的功能的基本承载主体,因此需要掌握如何创建一个dify应用,在dify界面,创建应用有下面几种方式:

-

基于应用模板创建(新手推荐);

-

创建一个空白应用;

-

通过DSL文件(本地/在线)创建应用;

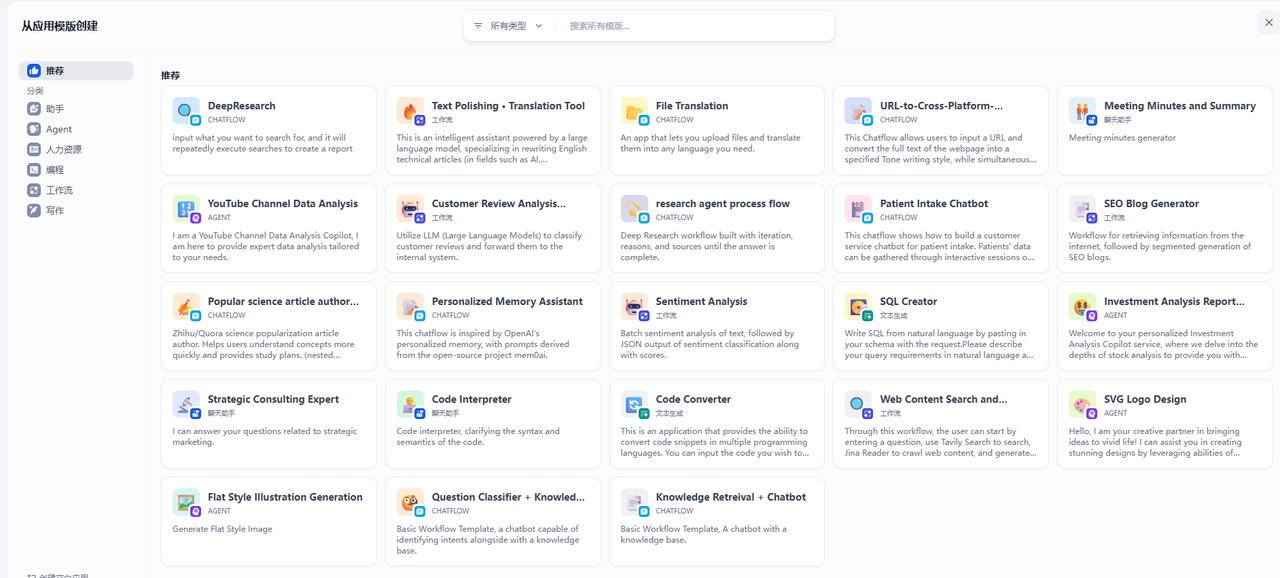

4.2.1 从模板创建应用

对新手来说,初次使用 Dify 时,对于应用创建比较陌生,为了帮助新手快速了解在 Dify 上能够构建哪些类型的应用,Dify 团队内的提示词工程师已经创建好了多场景、高质量的应用模板。

点击左侧的从应用创建模板

弹出的页面中,默认是推荐,可以在左上角的菜单中进行筛选:

可以从中选择任意一个你喜欢的模板,将鼠标放在模板上会浮现出【使用改模板】按钮,点击按钮,选择应用图标,填写应用名称和描述(当然也可以不用直接点创建),将当前模板添加至工作区,比如我这里选择其中一个

选择之后,在下面的弹框中填写应用名称和描述,也可以使用默认的

点击创建后,这个模板需要安装插件才能使用,点击安装一下

最后在你的应用列表中就能看到这个应用了

4.2.2 创建空白应用

这种方式是日常使用最多,也是最灵活的一种创建应用的方式,控制权完全掌握在使用者自己手里,点击创建空白应用,在下面弹出的框中,默认提供了多种应用类型,比如聊天助手,Agent,工作流等,可以根据自身的需求选择即可,然后填写应用名称,图标也可以自己更换

最后点击创建,来到下面的页面,即应用的各项参数配置页面,在这个页面你就可以根据自身的需要进行各种参数配置,大模型设置,工作流等设置

同样,创建完成后,在应用列表也可以看到这个创建的应用

五、写在文末

本文详细介绍了Dify这款开源的大模型应用开发平台的部署,并详细介绍了安装部署、配置和应用的创建过程,基于Dify,企业开发人员可以私有化定制自己的专属AI智能体,从而快速验证业务价值,更多详细的关于Dify的技术使用会在后续的篇章中继续分享,本篇到此结束,感谢观看。