基于MCP的一体化人工智能部署架构-从训练、调度到性能反馈的闭环系统设计(附代码)

随着企业对自动化、智能化运维需求的不断提升,MCP(Model Control Pipeline) 正成为行业自动化流程中的关键技术组件。本文将以实际应用为基础,从部署、集成到监控的全过程,探讨 MCP 在工业制造、能源与物联网等领域的落地案例,并提供代码示例,展示如何构建一体化的 AI 控制与监控流程。

一、什么是 MCP?

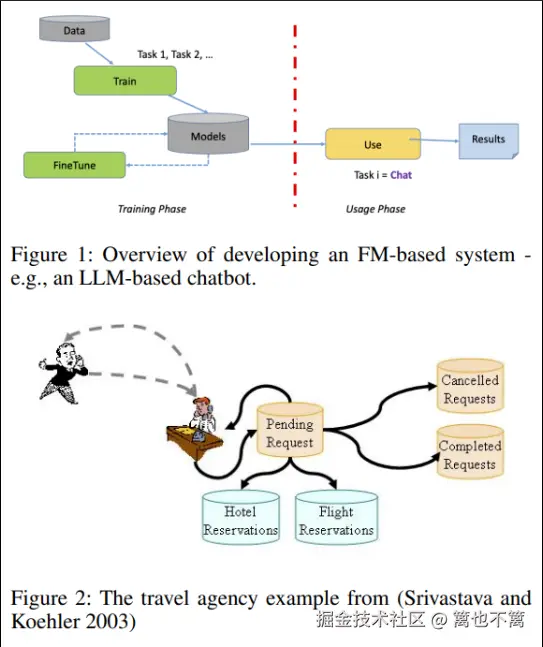

MCP(Model Control Pipeline) 是一种自动化的人工智能控制架构,它将模型训练、部署、推理和监控串联起来,形成一条可持续更新与反馈的闭环流程。相比传统的 AI 部署流程,MCP 具备以下优势:

- 支持 CI/CD,提升模型迭代效率

- 内置模型健康检查与报警机制

- 支持在线/离线混合推理

- 可与工业边缘设备/云端无缝集成

二、行业背景:自动化升级的需求

在多个行业中,自动化不仅仅是机器替代人力,更是提升精度、降低风险的战略工具。

- 工业制造:机器人路径规划与质量检测需要实时 AI 推理

- 能源行业:风电/光伏状态检测需要模型长时间稳定运行

- IoT 场景:需要边缘侧设备实时推理与远程部署更新

而 MCP 能将模型从训练到上线全过程规范化,解决部署难、版本混乱、监控缺失等关键痛点。

三、案例分析:智能工厂中的 MCP 应用

我们以某智能工厂的"缺陷检测系统"为例,完整复盘 MCP 在其生产线的集成过程。

1. 模型开发阶段

采用 PyTorch 构建缺陷分类模型,并使用 MCP 提供的 model_registry 进行统一版本管理。

python

import torch.nn as nn

import torch

class DefectClassifier(nn.Module):

def __init__(self):

super().__init__()

self.net = nn.Sequential(

nn.Conv2d(3, 16, kernel_size=3),

nn.ReLU(),

nn.Flatten(),

nn.Linear(16*62*62, 2)

)

def forward(self, x):

return self.net(x)训练完成后将模型注册入 MCP:

python

from mcp_sdk import ModelRegistry

model = DefectClassifier()

ModelRegistry.register(model, version="v1.0", name="defect_cls")2. 自动化部署流程

使用 MCP 的 DeploymentManager 进行容器化部署,可选择 Kubernetes/Edge 推理设备。

python

from mcp_sdk import DeploymentManager

DeploymentManager.deploy(

model_name="defect_cls",

version="v1.0",

target="edge_node_01",

strategy="canary" # 金丝雀发布,减少停机风险

)支持在不同设备组中灰度发布,兼容多种部署模式(如 REST API, MQTT, WebSocket 推理)。

3. 推理服务接入

将推理服务接入工厂生产线,通过摄像头采集数据并发送至 MCP 推理引擎。

python

import cv2

import requests

import base64

frame = cv2.imread("test_image.jpg")

_, img_encoded = cv2.imencode('.jpg', frame)

payload = base64.b64encode(img_encoded.tobytes()).decode()

response = requests.post(

url="http://mcp-server/api/infer",

json={"image": payload, "model_name": "defect_cls", "version": "v1.0"}

)

result = response.json()

print(result)4. 实时监控与报警

使用 MCP 的 MonitorEngine 自动记录模型性能指标,如准确率、推理延迟、异常率。

python

from mcp_sdk import MonitorEngine

MonitorEngine.watch(model_name="defect_cls", version="v1.0", metrics=["accuracy", "latency"])

alerts = MonitorEngine.get_alerts()

if alerts:

print("⚠️ 警告:模型性能下降!", alerts)结合 Grafana 或 Prometheus 可构建可视化监控面板。

四、优势总结:为什么选择 MCP?

| 功能 | MCP 提供支持 | 传统流程 |

|---|---|---|

| 模型注册与版本控制 | ✅ | ❌ |

| 自动部署与灰度发布 | ✅ | ❌ |

| 监控与异常报警 | ✅ | 部分 |

| 多端推理兼容 | ✅ | 部分 |

MCP 不仅是 AI 工程能力的提升工具,更是 AI 产业化落地的加速引擎。

五、延伸场景:面向未来的行业升级

MCP 正在逐步扩展至以下领域:

- 自动驾驶系统:模型动态更新与风险响应

- 电网调度系统:实时模型切换与负载均衡

- 医疗影像 AI 系统:多模型协同监测与自动告警

这标志着一个"模型即服务 + 自动运维"的新范式已经成型。

六、从"无"到"有":构建完整的 MCP 自动化流程

1. 环境初始化与架构搭建

部署 MCP 流水线的第一步是搭建系统运行环境。整个架构主要由以下几部分组成:

- 模型注册中心(Model Registry):统一管理模型版本

- 推理服务管理器(Inference Server):提供 REST/MQTT 接口

- 部署调度器(Deployment Orchestrator):支持设备调度与策略发布

- 性能监控器(Monitor Engine):接入 Prometheus+Grafana

- 事件总线(Event Bus) :MQ 支撑,收集告警与状态变更

环境部署脚本(Docker Compose 示例)

yaml

version: '3.7'

services:

registry:

image: mcp/model-registry

ports:

- "8001:8001"

inference:

image: mcp/inference-server

ports:

- "8002:8002"

monitor:

image: mcp/monitor-engine

ports:

- "9090:9090" # Prometheus端口

grafana:

image: grafana/grafana

ports:

- "3000:3000"使用以下命令启动完整平台:

bash

docker-compose up -d部署完成后,我们即可使用 MCP-SDK 向系统注册模型、发布任务,并进行可视化监控。

2. 多模型协同机制设计

在复杂生产环境中,往往一个模型无法覆盖所有情形。MCP 支持"多模型并行部署",通过策略控制模型选择。

示例:按工位分布多模型部署

python

from mcp_sdk import DeploymentManager

# 工位1部署模型A

DeploymentManager.deploy(model_name="defect_cls_A", version="v1.0", target="station_1")

# 工位2部署模型B

DeploymentManager.deploy(model_name="defect_cls_B", version="v2.1", target="station_2")通过部署策略配置规则引擎,MCP 可以根据图像元数据自动路由至最优模型。

json

{

"route_by": "station_id",

"rules": {

"station_1": "defect_cls_A:v1.0",

"station_2": "defect_cls_B:v2.1"

}

}此种设计大大提高模型适应性,也为后续个性化推理(例如微调模型)提供支撑。

3. 模型热更新与在线评估机制

MCP 提供"热更新 + 在线评估"能力,无需重启服务即可部署新版本,并支持 A/B 测试。

热更新部署

python

DeploymentManager.deploy(

model_name="defect_cls_A",

version="v1.1",

target="station_1",

strategy="rolling_update"

)实时精度评估与回滚策略

在监控模块中注册指标阈值,一旦新模型效果下降,自动回滚旧版本:

python

MonitorEngine.set_threshold(

model_name="defect_cls_A",

version="v1.1",

metric="accuracy",

min_value=0.85,

action="rollback_to:v1.0"

)通过在线反馈数据(如人工审核标签),系统还能自动进行微调或提醒重新训练。

4. 跨端部署:边缘与云端协同

很多工业现场具有边缘计算需求,例如摄像头旁部署 ARM 边缘设备。MCP 支持 ARMv8 与 Jetson 平台部署。

云边一体推理模式示意

- 边缘设备:低延迟推理,现场图像处理

- 云端服务器:执行复杂模型,提供高精度补偿判断

边缘推理代码简化版如下:

python

from mcp_sdk import EdgeClient

client = EdgeClient(endpoint="tcp://192.168.0.88:1883")

result = client.infer(image_path="frame.jpg", model_name="defect_cls_A", version="v1.1")

print(result)边缘设备无需 GPU,CPU 下也可运行 TensorRT / ONNX 模型,结合模型量化技术可进一步压缩模型大小。

5. 融合工业协议与事件响应

工业现场常使用 Modbus/TCP , OPC-UA , CAN 总线等通信协议。MCP 提供协议适配层可将推理结果转换为工业协议信号输出。

OPC-UA 推理响应集成

python

from mcp_sdk.protocols import OPCUAExporter

opc = OPCUAExporter(server_url="opc.tcp://192.168.0.22:4840")

opc.publish_result("station_1/defect", value=1) # 1代表有缺陷还可结合报警系统输出灯光、声音或 PLC 动作:

python

if result["label"] == "defect":

trigger_alarm(zone="B2", type="sound")实现闭环控制 ------ 从模型推理结果直接驱动物理动作。

结语

MCP 架构代表了 AI 项目从"模型可用"走向"系统稳定"的关键跃迁。在复杂的生产环境中,只有实现从训练 → 部署 → 监控的一体化闭环,才能真正实现 AI 自动化的高效、安全和持续演进。

未来的工业自动化,不再只是部署模型,而是部署一个"活的系统"。MCP 正是这个系统的中枢。