负载均衡

负载均衡:Load Balance,简称LB,是一种服务或基于硬件设备等实现的高可用反向代理技术,负载均衡将特定的业务(web服务、网络流量等)分担给指定的一个或多个后端特定的服务器或设备,从而提高了公司业务的并发处理能力、保证了业务的高可用性、方便了业务后期的水平动态扩展。

负载均衡作用

Web服务器的动态水平扩展-->对用户无感知

增加业务并发访问及处理能力-->解决单服务器瓶颈问题

节约公网IP地址-->降低IT支出成本

隐藏内部服务器IP-->提高内部服务器安全性

配置简单-->固定格式的配置文件

功能丰富-->支持四层和七层,支持动态下线主机

性能较强-->并发数万甚至数十万

负载均衡类型

硬件:

F5 美国F5网络公司

Netscaler 美国思杰公司

Array 华耀

AD-1000 深信服

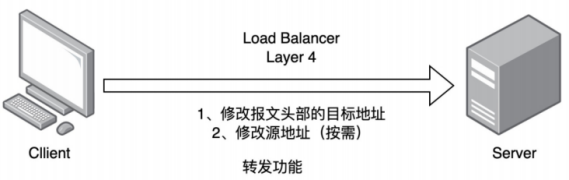

四层负载

1.通过ip+port决定负载均衡的去向。

2.对流量请求进行NAT处理,转发至后台服务器。

3.记录tcp、udp流量分别是哪台服务器处理,后续该请求连接的流量都通过该服务器处理。

4.支持四层的软件

lvs:重量级四层负载均衡器。

Nginx:轻量级四层负载均衡器,可缓存。(nginx四层是通过upstream模块)

Haproxy:模拟四层转发。

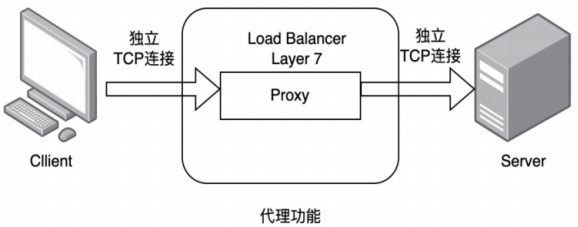

七层负载

1.通过虚拟ur|或主机ip进行流量识别,根据应用层信息进行解析,决定是否进行负载均衡。

2.代理后台服务器与客户端建立连接,如nginx可代理前后端,与前端客户端tcp连接,与后端服务器建立tcp连接,

3.支持7层代理的软件:

Nginx:基于http协议(nginx七层是通过proxy_pass)

Haproxy:七层代理,会话保持、标记、路径转移等。

四层与七层负载区别

所谓的四到七层负载均衡,就是在对后台的服务器进行负载均衡时,依据四层的信息或七层的信息来决定怎么样转发流量

四层的负载均衡,就是通过发布三层的IP地址(VIP),然后加四层的端口号,来决定哪些流量需要做负载均衡,对需要处理的流量进行NAT处理,转发至后台服务器,并记录下这个TCP或者UDP的流量是由哪台服务器处理的,后续这个连接的所有流量都同样转发到同一台服务器处理。

七层的负载均衡,就是在四层的基础上(没有四层是绝对不可能有七层的),再考虑应用层的特征,比如同一个Web服务器的负载均衡,除了根据VIP加80端口辨别是否需要处理的流量,还可根据七层的URL、浏览器类别、语言来决定是否要进行负载均衡。

1.分层位置:四层负载均衡在传输层及以下,七层负载均衡在应用层及以下

2.性能 :四层负载均衡架构无需解析报文消息内容,在网络吞吐量与处理能力上较高:七层可支持解析应用层报文消息内容,识别URL、Cookie、HTTP header等信息。、

3.原理 :四层负载均衡是基于ip+port;七层是基于虚拟的URL或主机IP等。

4.功能类比:四层负载均衡类似于路由器;七层类似于代理服务器。

5.安全性:四层负载均衡无法识别DDoS攻击;七层可防御SYN Cookie/Flood攻击

haproxy简介

HAProxy是法国开发者 威利塔罗(Willy Tarreau) 在2000年使用C语言开发的一个开源软件 ,是一款具备高并发(万级以上)、高性能的TCP和HTTP负载均衡器 ,支持基于cookie的持久性,自动故障切换,支持正则表达式及web状态统计

haproxy的安装和服务信息

haproxy]# dnf install haproxy -y

# haproxy -v 【查看版本】

环境配置

RS1,RS2,haproxy]# systemctl disable --now firewalld

haproxy]# systemctl start haproxy

RS1,RS2]# dnf install nginx -y

haproxy软件基本信息

软件安装包: haproxy-2.4.22-3.el9_3.x86_64.rpm

启动文件: /lib/systemd/system/haproxy.service

主配置目录: /etc/haproxy/

主配置文件: /etc/haproxy/haproxy.cfg

子配置目录: /etc/haproxy/conf.d

haproxy的基本配置信息

HAProxy 的配置文件haproxy.cfg由两大部分组成,分别是:

global:全局配置段

进程及安全配置相关的参数

性能调整相关参数

Debug参数

proxies:代理配置段

defaults:为frontend, backend, listen提供默认配置

frontend:前端,相当于nginx中的server {}

backend:后端,相当于nginx中的upstream {}

listen:同时拥有前端和后端配置,配置简单,生产推荐使用

proxies配置

proxies参数

defaults /etc/haproxy/haproxy.cfg 【代理参数,级别比集群参数低】

mode http # HAProxy实例使用的连接协议【tcp四层,http7层】

log global # 指定日志地址和记录日志条目的syslog/rsyslog日志设备

此处的global表示使用global配置段中设定的log值。

option httplog # 日志记录选项,httplog表示记录与 HTTP会话相关的各种属性值

包括 HTTP请求、会话状态、连接数、源地址以及连接时间等

option dontlognull # dontlognull表示不记录空会话连接日志

option http-server-close # 等待客户端完整HTTP请求的时间,此处为等待10s,也是默认情况的时间。

option forwardfor except 127.0.0.0/8 # 透传客户端真实IP至后端web服务器

在apache配置文件中加入:<br>%{XForwarded-For}i

option redispatch # 当server Id对应的服务器挂掉后,强制定向到其他健康的服务器,重新派发

option http-keep-alive # 开启与客户端的会话保持

retries 3 # 连接后端服务器失败次数

timeout http-request 10s # 等待客户端请求完全被接收和处理的最长时

timeout queue 1m # 设置删除连接和客户端收到503或服务不可用等提示信息前的等待时间

timeout connect 10s # 设置等待服务器连接成功的时间

timeout client 1m # 设置允许客户端处于非活动状态,即既不发送数据也不接收数据的时间

timeout server 1m # 设置服务器超时时间,即允许服务器处于既不接收也不发送数据的非活动时间

timeout http-keep-alive 10s # session 会话保持超时时间,此时间段内会转发到相同的后端服务器

timeout check 10s # 指定后端服务器健康检查的超时时间,是否活着

maxconn 3000 # 最大连接数

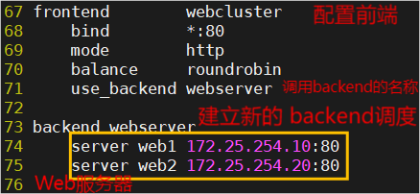

Proxies配置-frontend

frontend 配置参数:

bind:指定HAProxy的监听地址,可以是IPV4或IPV6,可以同时监听多个IP或端口,可同时用于listen字段中

#格式: bind [<address>]:<port_range> [, ...] [param*]

注意:如果需要绑定在非本机的IP,需要开启内核参数:net.ipv4.ip_nonlocal_bind=1

backlog <backlog> #针对所有server配置,当前端服务器的连接数达到上限后的后援队列长度,backlog 不支持backen

示例:

frontend webcluster

bind *:80

mode http

balance roundrobin

use_backend webserver

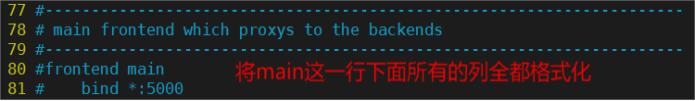

Proxies配置-listen 简化配置

haproxy]# vim /etc/haproxy/haproxy.cfg 【更改主配置文件】

# systemctl restart haproxy.service 【重启检测无报错】

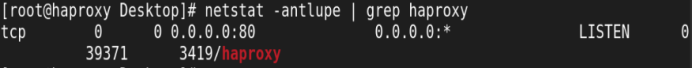

# netstat -antlupe | grep haproxy 查看结果:

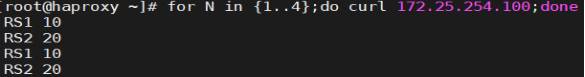

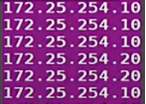

haproxy]# for N in {1..4};do curl 172.25.254.100;done 检测查看:

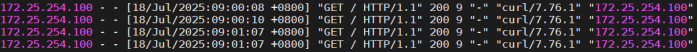

RS]# cat /var/log/nginx/access.log

haproxy]# vim /etc/haproxy/haproxy.cfg 【格式化,透传客户端真实IP至后端web服务器】

# systemctl restart haproxy.service

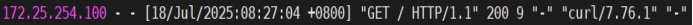

# curl 172.25.254.100

RS]# cat /var/log/nginx/access.log查看结果:

后面的信息是172.25.254.100告诉的,七层负载的TCP在haproxy出入都是独立链接的

global配置多线程

配置参数说明 /etc/haproxy/haproxy.cfg

global 【集群参数,级别最高】

log 127.0.0.1 local2 #定义全局的syslog服务器;日志服务器需要开启UDP协议,最多可以定义两个

chroot /var/lib/haproxy #锁定运行目录

pidfile /var/run/haproxy.pid #指定pid文件

maxconn 10000 #指定最大连接数

user haproxy #指定haproxy的运行用户

group haproxy #指定haproxy的运行组

daemon #指定haproxy以守护进程方式运行

turn on stats unix socket

#stats socket /var/lib/haproxy/stats #指定haproxy的套接子文件

#nbproc 2 #指定haproxy的work进程数量,默认是1个

#cpu-map 1 0 #指定第一个work绑定第一个cpu核心,加快访问

#cpu-map 2 1 #指定第二个work绑定第二个cpu核心

#nbthread 2 #指定haproxy的线程数量,默认每个进程一个线程,此参数与nbproc互斥【cpu-map 2 1 #2表示第二个进程,1表示第二个cpu核心】

#maxsslconn 100000 #每个haproxy进程ssl最大连接数,用于haproxy配置了证书的场景下

#maxconnrate 100 #指定每个客户端每秒建立连接的最大数量

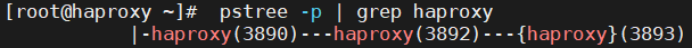

多进程和线程配置

haproxy]# vim /etc/haproxy/haproxy.cfg 【更改主配置文件】

# systemctl restart haproxy.service 【重启】

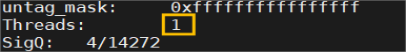

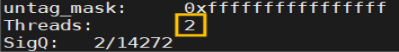

# pstree -p | grep haproxy 【查看线程】

# cat /proc / 3890 /status 【3890 是haproxy子进程id】

# cat /proc / 3892 /status

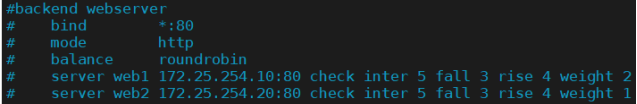

Proxies配置-backend

定义一组后端服务器,backend服务器将被frontend进行调用。

注意: backend 的名称必须唯一,并且必须在listen或frontend中事先定义才可以使用,否则服务无法启动

mode http|tcp #指定负载协议类型,和对应的frontend必须一致

option #配置选项

server #定义后端real server,必须指定IP和端口

注意:option后面加 httpchk,smtpchk,mysql-check,pgsql-check,ssl-hello-chk方法,可用于实现更多应用层检测功能。

haproxy]# vim /etc/haproxy/haproxy.cfg 【更改主配置文件,设置新的server服务】

#针对一个server配置

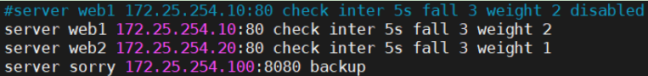

check #对指定real进行健康状态检查,如果不加此设置,默认不开启检查,只有check后面没 有其它配置也可以启用检查功能

#默认对相应的后端服务器IP和端口,利用TCP连接进行周期性健康性检查,注意必须指定 端口才能实现健康性检查

addr <IP> #可指定的健康状态监测IP,可以是专门的数据网段,减少业务网络流量

port <num> #指定的健康状态监测端口

inter <num> #健康状态检查间隔时间,默认2000 ms

fall <num> #后端服务器从线上转为线下的检查的连续失效次数,默认为3

rise <num> #后端服务器从下线恢复上线的检查的连续有效次数,默认为2

weight <weight> #默认为1,最大值为256,0(状态为蓝色)表示不参与负载均衡,但仍接受持久连接

backup #将后端服务器标记为备份状态,只在所有非备份主机down机时提供服务,类似Sorry Server

disabled #将后端服务器标记为不可用状态,即维护状态,除了持久模式

#配置后将不再接受连接,状态为深黄色,优雅下线,不再接受新用户的请求

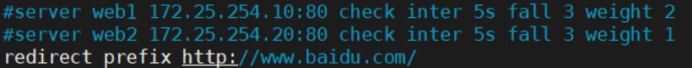

redirect prefix http://www.baidu.com/ #将请求临时(302)重定向至其它URL,只适用于http模式

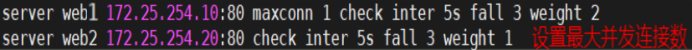

maxconn <maxconn> #当前后端server的最大并发连接数

# systemctl restart haproxy.service 【重启】

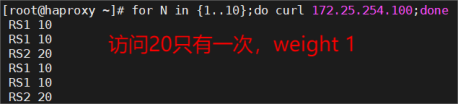

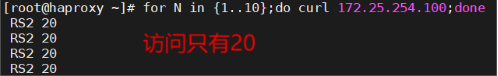

# for N in {1..10};do curl 172.25.254.100;done 检测查看:

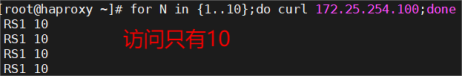

RS2 ~]# systemctl stop nginx.service

# for N in {1..10};do curl 172.25.254.100;done 检测查看:

RS2 ~]# systemctl st art nginx.service

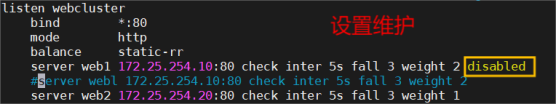

设置RS1维护

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service 【重启】

# for N in {1..10};do curl 172.25.254.100;done 检测查看:

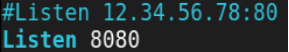

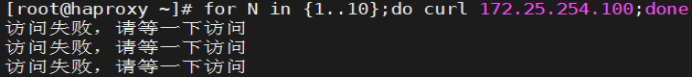

设置两个RS无法访问后访问别的服务器

【RS # systemctl stop nginx.service】

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service 【重启】

# dnf install httpd -y 【下载包】

# vim /etc/httpd/conf/httpd.conf 【配置端口】

# systemctl enable --now httpd 【开启服务】

# echo "访问失败,请等一下访问" > /var/www/html/index.html

请求临时(302)重定向

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service

设置最大并发连接数

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service

这时有大量访问时候,访问少的出现20的会比较少,大量访问的20会频繁出现。

socat 工具

对服务器动态权重和其它状态可以利用 socat工具进行调整,Socat 是 Linux 下的一个多功能的网络工具,名字来由是Socket CAT,相当于netCAT的增强版.Socat 的主要特点就是在两个数据流之间建立双向通道,且支持众多协议和链接方式。如 IP、TCP、 UDP、IPv6、Socket文件等

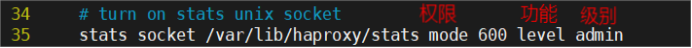

范例:利用工具socat 对服务器动态权重调整

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service

# dnf install socat -y

# socat -h 【查看帮助】

# echo "help" | socat stdio /var/lib/haproxy/stats 【查看对此文件做的动作】

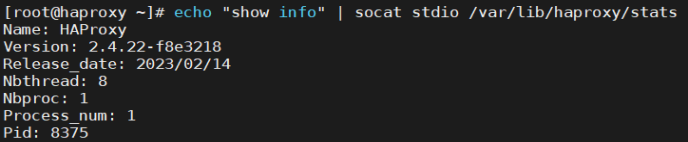

# echo "show info" | socat stdio /var/lib/haproxy/stats 【查看haproxy状态】

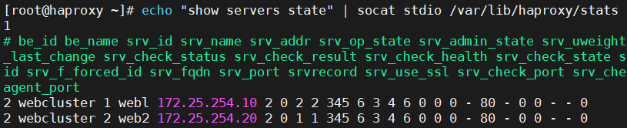

# echo "show servers state" | socat stdio /var/lib/haproxy/stats 【查看集群状态】

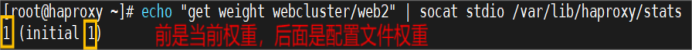

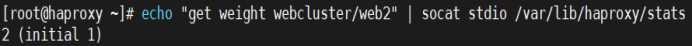

# echo get weight webcluster/web 2 | socat stdio /var/lib/haproxy/stats 【查看集群权重】

# echo " set weight webcluster/web2 2 " | socat stdio /var/lib/haproxy/stats 【更改权重】

# echo "disable server webcluster/ web 2 " | socat stdio /var/lib/haproxy/stats 【下线web 2】

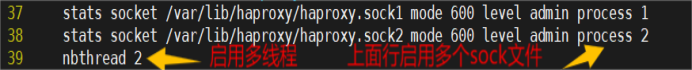

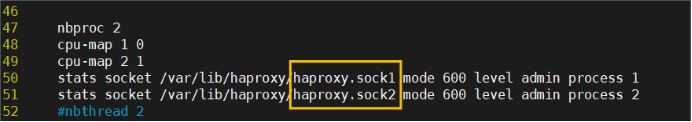

针对多进程处理方法

如果开启多进程那么我们在对进程的sock文件进行操作时其对进程的操作时随机的

如果需要指定操作进程那么需要用多soct文件方式来完成

# vim /etc/haproxy/haproxy.cfg

# systemctl restart haproxy.service

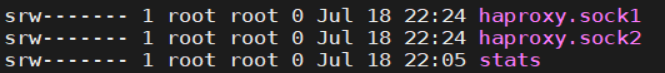

这样每个进程就会有单独的sock文件来进行单独管理

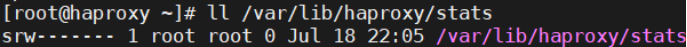

# ll /var/lib/haproxy/