在构建高并发、多任务的 Python 应用时,线程安全(Thread Safety) 是保证程序稳定性与正确性的重要基础。本篇文章将从原理、机制、常用工具、典型场景和最佳实践五个方面系统讲解 Python 中的线程安全,帮助你在实际开发中正确地识别并解决多线程冲突问题。

一、什么是线程安全?

线程安全 是指在多线程环境下 ,对共享数据的访问不导致数据竞争(race condition)或状态不一致的程序行为。

当多个线程同时读写同一变量、对象或资源时,如果没有适当的同步机制,可能会出现:

- 读到部分更新的数据

- 丢失写入

- 应用崩溃或死锁

例如以下一些非线程安全的代码

- 共享变量的自增操作(经典)

python

import threading

counter = 0

def increment():

global counter

for _ in range(100000):

counter += 1

threads = [threading.Thread(target=increment) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]

print("期望值:", 5 * 100000)

print("实际值:", counter)counter += 1实际是读取、加一、写入的组合操作(非原子)- 多线程中会产生丢失写入的现象

- 对象属性的非安全访问

python

import threading

class User:

def __init__(self):

self.name = "guest"

user = User()

def change_name():

for i in range(100000):

user.name = f"admin" # 非线程安全

threads = [threading.Thread(target=change_name) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]

print(user.name) # 最终值可能是任意线程写入的user.name在并发写入中状态不可预测- 会造成业务逻辑混乱,比如权限错误等

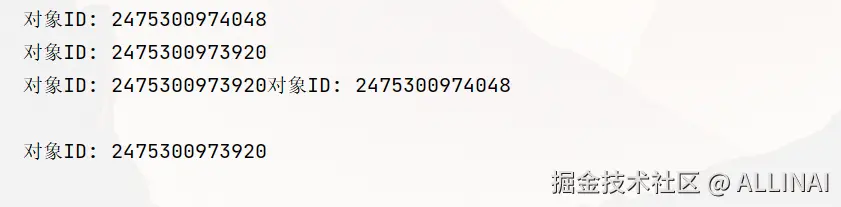

- 懒加载资源时的重复初始化

python

import threading

import time

class LazyInit:

def __init__(self):

self._obj = None

def get(self):

if self._obj is None:

time.sleep(0.1) # 模拟初始化耗时

self._obj = object()

return self._obj

resource = LazyInit()

def init_resource():

obj = resource.get()

print(f"对象ID: {id(obj)}")

threads = [threading.Thread(target=init_resource) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]if self._obj is None判断后,在多线程间竞态,可能创建多个对象- 应该加锁来确保只初始化一次(双重检查锁)

- 缓存读写并发导致数据不一致

python

cache = {}

def writer():

for i in range(1000):

cache["data"] = i # 写入缓存

def reader():

for _ in range(1000):

val = cache.get("data")

if val is None:

print("读取到空值")

elif val < 0:

print("读取到非法值")

t1 = threading.Thread(target=writer)

t2 = threading.Thread(target=reader)

t1.start()

t2.start()

t1.join()

t2.join()dict本身在读写之间不是线程安全的- 会出现

KeyError或读取到未完整写入的值

- 文件写操作非线程安全

python

import threading

def write_file():

with open("output.txt", "a") as f:

for _ in range(100):

f.write("hello\n")

threads = [threading.Thread(target=write_file) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]- 文件追加操作并不是原子性的

- 多线程下会导致写入冲突、文件内容交错、乱码等

- 日志或终端打印输出错乱

python

import threading

def log():

for i in range(10):

print(f"[{threading.current_thread().name}] log {i}")

threads = [threading.Thread(target=log, name=f"T{i}") for i in range(3)]

[t.start() for t in threads]

[t.join() for t in threads]print()本身是线程安全的,但输出顺序是非确定性的- 日志文件中可能交错、难以追踪

- 类变量竞争

python

import threading

import time

class Singleton:

instance = None

@classmethod

def get_instance(cls):

if cls.instance is None:

time.sleep(0.1) # 模拟实例化耗时

cls.instance = object()

return cls.instance

def create():

print(id(Singleton.get_instance()))

threads = [threading.Thread(target=create) for _ in range(10)]

[t.start() for t in threads]

[t.join() for t in threads]- 多线程中可能返回多个

object()实例 - 违反单例设计意图

二、Python 的线程模型与 GIL

Python(特别是 CPython 实现)中使用了 全局解释器锁(GIL) 来控制同一时间只有一个线程执行字节码。这意味着:

- GIL 简化了 C 扩展的线程安全实现

- 但 不能保证共享数据层面的线程安全

- GIL 并不阻止你自己"作死"地读写共享数据

特别是在涉及 I/O、数据库、文件、socket 或外部资源 时,线程之间的竞争是真实存在的。

三、实现线程安全的常用工具

🔐 1. threading.Lock:最基础的互斥锁

✅ 适用场景

- 多线程访问或修改 共享变量 或 对象状态

🔧 示例:加锁保护共享计数器

python

import threading

counter = 0

lock = threading.Lock()

def worker():

global counter

for _ in range(100000):

with lock:

counter += 1 # 临界区

threads = [threading.Thread(target=worker) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]

print("最终计数值:", counter)✅ 说明

with lock:是最佳实践,确保异常时也会自动释放锁counter += 1是非原子操作,必须加锁保护

🔁 2. threading.RLock:可重入锁(Reentrant Lock)

🧠 类比说明:可重入锁 vs 普通锁(Lock)

- 普通锁(Lock):你上锁之后就不能再进去,即使你自己还在里面,你打不开第二道门,被"自己锁死"了。

- 可重入锁(RLock):你上锁之后,如果还是你自己想再进去,你能继续进去并正常出来,每进一次就记一次,出来也要解锁同样的次数。

✅ 适用场景

- 同一线程递归或重复获取锁时不会死锁

- 多层函数都加了锁

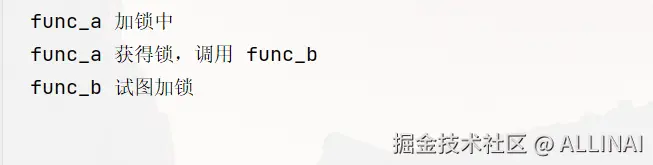

🔧 示例1:同一线程重复操作数据结构时加锁

- 你在函数 A 中获取了锁,但 A 调用了 B,B 又尝试获取锁,会死锁

python

import threading

lock = threading.Lock()

def func_b():

print("func_b 试图加锁")

with lock: # ❌ 死锁发生在这里

print("func_b 获得锁")

def func_a():

print("func_a 加锁中")

with lock:

print("func_a 获得锁,调用 func_b")

func_b()

t = threading.Thread(target=func_a)

t.start()

t.join()Lock死锁原因分析:func_a获得了锁- 调用

func_b,它也试图获得锁 - 但锁已经被当前线程占有

Lock不允许同一线程再次获取,所以死锁

- 使用

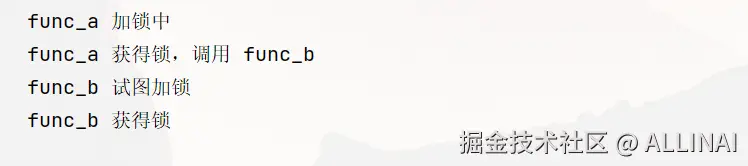

RLock解决同线程死锁

python

import threading

lock = threading.RLock()

def func_b():

print("func_b 试图加锁")

with lock:

print("func_b 获得锁")

def func_a():

print("func_a 加锁中")

with lock:

print("func_a 获得锁,调用 func_b")

func_b()

t = threading.Thread(target=func_a)

t.start()

t.join()RLock如何防止死锁?RLock在内部维护了:当前拥有锁的线程ID 和 一个计数器- 第一次加锁:如果锁是空闲的,线程获得它,计数器设为 1

- 如果同一个线程再次加锁:允许加锁,计数器加 1

- 每次

release()都会减 1,直到计数器变为 0,真正释放锁

🔧 示例2:递归锁场景

python

import threading

class Counter:

def __init__(self):

self._value = 0

self._lock = threading.RLock()

def increment(self):

with self._lock:

self._value += 1

self.log() # 这里再次用到锁

def log(self):

with self._lock:

print(f"当前值: {self._value}")

counter = Counter()

counter.increment()如果你用 Lock 而不是 RLock,调用 increment() 会死锁,因为它又调用了 log(),而 log() 也试图获取相同的锁。

⏳ 3. threading.Event:线程间信号机制

✅ 适用场景

- 主线程等待子线程完成任务

- 多个线程协调某个阶段

🔧 示例:等待"准备完毕"后再启动多个线程

python

import threading

import time

event = threading.Event()

def worker():

print(f"{threading.current_thread().name} 等待信号中...")

event.wait()

print(f"{threading.current_thread().name} 开始工作")

threads = [threading.Thread(target=worker) for _ in range(3)]

[t.start() for t in threads]

time.sleep(2)

print("主线程发出开始信号")

event.set() # 所有等待线程开始执行✅ 输出

scss

Thread-1 (worker) 等待信号中...

Thread-2 (worker) 等待信号中...

Thread-3 (worker) 等待信号中...

主线程发出开始信号

Thread-1 (worker) 开始工作

Thread-3 (worker) 开始工作

Thread-2 (worker) 开始工作🧺 4. queue.Queue:线程安全的队列(生产者-消费者模型)

✅ 适用场景

- 多线程任务分发

- 数据缓冲、任务池、日志队列等

🔧 示例:生产者-消费者模型

python

import threading

import queue

import time

import random

# 创建线程安全的队列

q = queue.Queue()

# 消费者函数

def consumer():

while True:

item = q.get() # 阻塞式获取任务

if item is None: # 特殊标志,表示退出

q.task_done()

break

print(f"消费:{item}")

time.sleep(random.uniform(0.2, 0.5)) # 模拟处理时间

q.task_done() # 告诉队列任务处理完了

# 生产者函数

def producer():

for i in range(10):

print(f"生产:{i}")

q.put(i) # 放入任务

time.sleep(random.uniform(0.1, 0.3)) # 模拟生成时间

# 发送退出信号给所有消费者(一个 None 表示一个消费者应退出)

for _ in range(2):

q.put(None)

# 启动多个消费者线程

consumers = [threading.Thread(target=consumer) for _ in range(2)]

for t in consumers:

t.start()

# 启动生产者线程

producer_thread = threading.Thread(target=producer)

producer_thread.start()

# 等待所有生产者任务放入队列

producer_thread.join()

# 阻塞主线程直到所有任务被处理完成

q.join()

print("所有任务处理完毕。")✅ 输出

生产:0

消费:0

生产:1

消费:1

生产:2

消费:2

生产:3

消费:3

生产:4

消费:4

生产:5

消费:5

生产:6

消费:6

生产:7

消费:7

生产:8

消费:8

生产:9

消费:9

所有任务处理完毕。✅ 说明

queue.Queue内部加锁,天然线程安全task_done()+q.join()可实现阻塞等待所有任务完成- 忘记

task_done()将导致join()永远阻塞

🧮 5. threading.Semaphore:限制同时运行线程数量

Semaphore: 信号,

/ˈsem.ə.fɔː/,发音近似为:"塞-么-阔"

✅ 适用场景

- 限制并发线程数量

- 控制对数据库连接、API 调用、I/O 的并发访问

🔧 示例:最多允许 3 个线程同时访问资源

python

import threading

import time

sema = threading.Semaphore(3)

def worker(i):

with sema:

print(f"线程 {i} 获取到资源")

time.sleep(2)

print(f"线程 {i} 释放资源")

threads = [threading.Thread(target=worker, args=(i,)) for i in range(6)]

[t.start() for t in threads]

[t.join() for t in threads]✅ 输出(可观察到并发控制)

bash

线程 0 获取到资源

线程 1 获取到资源

线程 2 获取到资源

# 等待2秒前3个释放后,才会进入下3个

线程 0 释放资源

线程 3 获取到资源

线程 2 释放资源

线程 4 获取到资源

线程 1 释放资源

线程 5 获取到资源

线程 3 释放资源

线程 5 释放资源

线程 4 释放资源🧩 6. threading.Condition:更复杂的等待-通知模型

✅ 适用场景

-

有条件触发的资源等待,如:

- 缓冲区为空等待写入

- 数据可用时通知读取

🔧 示例:等待缓冲区非空后消费

python

import threading

import time

buffer = []

condition = threading.Condition()

def producer():

with condition:

print("生产者准备生产数据...")

buffer.append(1)

condition.notify() # 通知消费者

print("生产者完成")

def consumer():

with condition:

while not buffer:

print("消费者等待数据...")

condition.wait()

buffer.pop()

print("消费者取走数据")

threading.Thread(target=consumer).start()

time.sleep(1)

threading.Thread(target=producer).start()✅ 输出

erlang

消费者等待数据...

生产者准备生产数据...

生产者完成

消费者取走数据✅ 说明

Condition是线程同步的一种高级工具- 一般用于线程等待"某个条件成立"时再继续执行

- 常配合

Lock使用,提供wait-notify机制

python

condition = threading.Condition()

# 线程等待条件满足

with condition:

condition.wait() # 阻塞,直到 condition.notify() 被调用

# 另一个线程发出通知

with condition:

condition.notify()🔗 7. threading.Barrier:所有线程准备就绪后统一继续

✅ 适用场景

- 所有线程需要在某个阶段同步后再继续运行

🔧 示例:模拟赛跑起跑线

python

import threading

import time

import random

barrier = threading.Barrier(3)

def runner(i):

print(f"选手 {i} 准备中...")

time.sleep(random.uniform(0.5, 2))

print(f"选手 {i} 准备就绪")

barrier.wait()

print(f"选手 {i} 起跑!")

threads = [threading.Thread(target=runner, args=(i,)) for i in range(3)]

[t.start() for t in threads]

[t.join() for t in threads]✅ 输出

- 所有线程都会"卡在"

barrier.wait(),直到所有人准备好后才一起继续执行。

erlang

选手 0 准备中...

选手 1 准备中...

选手 2 准备中...

# 等待所有选手准备完毕后起跑

选手 2 准备就绪

选手 1 准备就绪

选手 0 准备就绪

选手 0 起跑!选手 2 起跑!

选手 1 起跑!✅ 总结对比表

| 工具 | 功能/用途 | 适合场景 |

|---|---|---|

Lock |

互斥访问资源 | 修改全局变量、对象属性 |

RLock |

支持重入锁 | 多层调用、递归结构 |

Event |

信号通知 | 同步加载、启动控制 |

Queue |

线程安全队列 | 任务池、生产者消费者模型 |

Semaphore |

限制并发量 | 限制数据库/API/I/O并发 |

Condition |

等待特定条件 | 数据准备通知、复杂通信 |

Barrier |

所有线程达到同步点再继续 | 多线程阶段统一推进 |

四、线程安全设计的几种策略

✅ 避免共享:无状态设计

尽可能让每个线程操作独立的数据(如局部变量、不可变对象),不共享即安全。

✅ 使用锁控制访问范围

对共享资源加锁,只在必要的临界区中访问共享数据。

python

def update_data():

with lock:

# 修改共享变量✅ 使用线程安全的数据结构

如 queue.Queue, collections.deque(thread-safe append/pop)等。

✅ 使用线程安全包装类

创建类似 ThreadSafeObject 的包装器,隐藏锁逻辑,提升可维护性。

- 例如

chatchat\server\knowledge_base\kb_cache\base.py中的ThreadSafeObject类

python

class ThreadSafeObject:

def __init__(

self, key: Union[str, Tuple], obj: Any = None, pool: "CachePool" = None

):

self._obj = obj

self._key = key

self._pool = pool

self._lock = threading.RLock()

self._loaded = threading.Event()

def __repr__(self) -> str:

cls = type(self).__name__

return f"<{cls}: key: {self.key}, obj: {self._obj}>"

@property

def key(self):

return self._key

@contextmanager

def acquire(self, owner: str = "", msg: str = "") -> Generator[None, None, FAISS]:

owner = owner or f"thread {threading.get_native_id()}"

try:

self._lock.acquire()

if self._pool is not None:

self._pool._cache.move_to_end(self.key)

logger.debug(f"{owner} 开始操作:{self.key}。{msg}")

yield self._obj

finally:

logger.debug(f"{owner} 结束操作:{self.key}。{msg}")

self._lock.release()

def start_loading(self):

self._loaded.clear()

def finish_loading(self):

self._loaded.set()

def wait_for_loading(self):

self._loaded.wait()

@property

def obj(self):

return self._obj

@obj.setter

def obj(self, val: Any):

self._obj = val✅ 原子操作场景使用 atomic 工具(第三方)

如使用 atomicwrites 写文件,或 concurrent.futures 提供的线程池管理。

- atomic 是一个第三方 Python 库,用于实现原子变量操作(atomic operations),从而在多线程中实现线程安全的共享变量修改,不需要显式使用锁(如 threading.Lock)。

python

from atomic import AtomicLong

import threading

counter = AtomicLong(0)

def worker():

for _ in range(100000):

counter += 1 # 实际是原子加法

threads = [threading.Thread(target=worker) for _ in range(5)]

[t.start() for t in threads]

[t.join() for t in threads]

print("最终计数值:", counter.value)concurrent.futures是 Python 标准库中一个非常实用的并发模块,它提供了高级接口来执行异步任务,封装了线程池(ThreadPoolExecutor)和进程池(ProcessPoolExecutor),使并发编程更简单、易读且强大。

python

from concurrent.futures import ThreadPoolExecutor

import time

def task(name):

print(f"开始任务 {name}")

time.sleep(1)

return f"任务 {name} 完成"

with ThreadPoolExecutor(max_workers=3) as executor:

futures = [executor.submit(task, i) for i in range(5)]

for future in futures:

result = future.result() # 阻塞直到任务完成

print(result)五、常见线程安全问题及解决示例

1. 自增计数器丢失写入

python

counter = 0

lock = threading.Lock()

def increase():

global counter

with lock:

counter += 12. 资源初始化竞态

多个线程并发访问对象初始化可能重复或失败。

python

class LazyResource:

def __init__(self):

self._lock = threading.Lock()

self._resource = None

def get(self):

if self._resource is None:

with self._lock:

if self._resource is None:

self._resource = self._expensive_load()

return self._resource3. 阻塞等待加载完成

适合模型加载、缓存预热等:

python

import threading

class ResourceLoader:

def __init__(self):

# 创建一个 Event 对象,用于线程同步

# 表示资源是否已经加载完成

self._loaded = threading.Event()

# 用于保存实际加载的数据

self._data = None

def load(self):

# 实际加载资源(假设是耗时操作)

self._data = self._expensive_init()

# 加载完成后,通知所有等待的线程继续执行

self._loaded.set()

def get(self):

# 如果资源还没加载,当前线程会在此阻塞等待

self._loaded.wait()

# 加载完成后,返回数据

return self._data✅ 说明

- Event 是一种线程同步原语,相当于一个"信号灯":

wait():如果灯没亮(未 set),就阻塞等待set():亮灯,唤醒所有在等待的线程

- 多线程协作中,常用于:

- 加载完成通知

- 阻止早于准备好的访问

六、线程安全与异步的区别

- 线程安全处理的是多线程共享资源问题

- 异步 (如

asyncio)处理的是并发控制和协程调度 - 两者可以结合使用,如线程池中异步调度加载任务,但共享数据仍需加锁

七、最佳实践总结

| 建议 | 描述 |

|---|---|

| 优先避免共享 | 无共享则无线程安全问题 |

| 用上下文封装锁 | 减少锁忘记释放的问题 |

| 日志记录关键操作 | 便于排查死锁与并发 bug |

| 封装为线程安全类 | 如 ThreadSafeObject, SafeCache |

| 不滥用锁 | 锁太多会死锁或性能低下 |

熟练使用 Queue |

解耦任务生产与消费逻辑 |

八、结语

虽然 Python 的 GIL 在一定程度上缓解了多线程中的部分问题,但线程安全始终是并发编程中的核心挑战。理解其底层机制、合理使用 同步原语(并发编程专业术语,用来协调多个线程/进程对共享资源访问的最基本的工具或机制),并形成良好的编码规范,才能在实际项目中编写出高性能且可靠的多线程程序。