DNF:用于暗光视觉的解耦与反馈网络

摘要

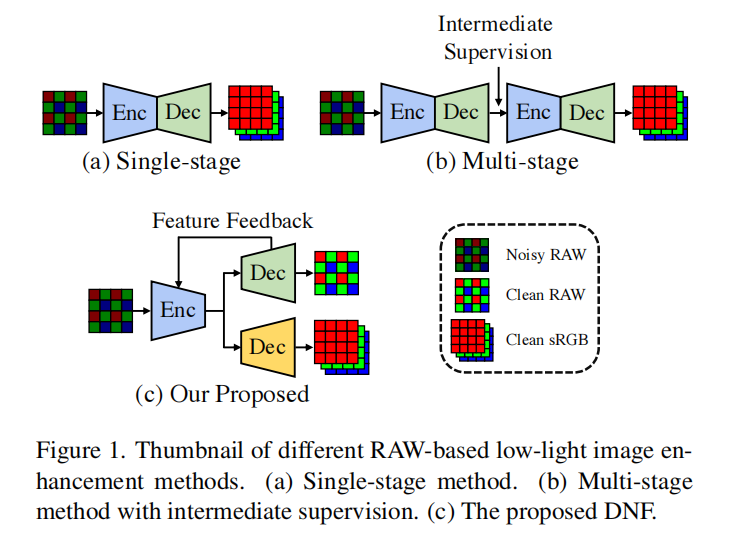

RAW 数据的独特属性在低光照图像增强方面展现出巨大潜力。然而,现有架构在单阶段和多阶段方法中的固有局限性限制了其性能。跨两个不同域(噪声到干净和 RAW 到 sRGB)的混合映射,由于域模糊性 (domain ambiguity) 误导了单阶段方法 。多阶段方法仅通过每个阶段的结果图像传播信息,忽略了有损图像级数据流中的丰富特征 。在本文中,我们探究了解决这些瓶颈的通用方案,并提出了一种解耦与反馈 (Decouple aNd Feedback) 框架 ,缩写为 DNF。为了缓解域模糊性,我们解耦 了特定领域的子任务,并充分利用了 RAW 和 sRGB 域中的独特属性 。通过反馈机制实现跨阶段的特征传播,避免了由图像级数据流引起的信息损失。我们方法的两个关键见解令人满意地解决了基于 RAW 数据的低光照图像增强的固有局限性,使我们的方法以仅 19% 的参数大幅超越之前的最先进方法,在 SID 的 Sony 和 Fuji 子集上分别实现了 0.97dB 和 1.30dB 的 PSNR 提升。

1 引言

低光照场景下的成像越来越受到关注,尤其是随着智能手机和监控系统上夜景模式的普及。然而,由于极低的信噪比,低光照图像增强 (Low-Light Image Enhancement, LLIE) 是一项具有挑战性的任务。最近,深度学习解决方案被广泛研究以解决不同数据域中的这一任务,范围从基于 sRGB 的方法 [14, 15, 21, 40] 到基于 RAW 的方法 [2, 7, 35, 47]。与 sRGB 数据相比,包含未处理信号的 RAW 数据在三个方面 对 LLIE 有益:1) 在 RAW 域中,信号与光子计数线性相关 ,2) 在图像信号处理 (Image Signal Processing, ISP) 流水线 [33] 之前,RAW 图像上的噪声分布是可处理的 (tractable),3) RAW 格式更高的位深记录了更多可区分的低强度信号。

开创性工作 SID [2] 提出了一个用于基于 RAW 的 LLIE 的大规模配对数据集,重新点燃了对数据驱动方法的兴趣。如图 1 所示,一类工作 [2, 5, 12, 13, 22, 42] 专注于设计单阶段网络架构,另一类 [4, 7, 35, 47] 则利用多阶段网络进行渐进式增强。尽管性能有很大提升,但两种架构仍然受到固有局限性的制约。首先,当前的单阶段方法 强制神经网络学习从噪声 RAW 域到干净 sRGB 域的直接映射,跨越两个不同域(噪声到干净和 RAW 到 sRGB)的混合映射会误导整体增强过程,导致域模糊性问题 。例如,RAW 图像中可处理的噪声在色彩空间转换过程中会被映射到不可预测的分布。因此,色彩偏移和未处理的噪声 不可避免地出现在最终结果中。其次,现有的多阶段方法 通过级联子网络组成流程,每个子网络负责基于上一阶段的输出图像进行渐进式增强。在它们采用图像级数据流的设计下,只有图像在多个阶段间前向传播 ,后一阶段只能从前一阶段的结果中获取信息。同时,每个阶段中的每个子网络都可能由于下采样操作或单独的目标函数 [41] 而导致信息损失 。因此,次优的性能与有损图像级数据流密切相关。误差随着阶段传播、累积和放大,最终无法重建纹理细节。

为了利用 RAW 图像在 LLIE 中的潜力,需要一个超越上述两个限制的通用流程。具体来说,神经网络应该利用不同域中的上述优点 [7],而不是被域模糊性所混淆。根据 RAW 和 sRGB 域的独特属性,有必要将增强解耦为特定领域的子任务 。在探索了 RAW 域中的线性和可处理噪声之后,可以有意识地执行从 RAW 域到 sRGB 域的色彩空间转换,而不受噪声干扰。此外,流程不能阻碍阶段间的通信 ,而不是仅允许一小部分有损信息通过的图像级数据流。由于不同的子任务,每个层级的中间特征往往是互补的 [20, 46]。同时,多尺度特征保留了纹理和上下文信息 ,为后续阶段提供了额外的指导 [41]。因此,需要不同阶段的特征在数据流中传播,聚合丰富的特征并保持信息的完整性。特定领域的解耦,加上特征级数据流,有助于提高可学习性以获得更好的增强性能,并保持方法的可解释性。

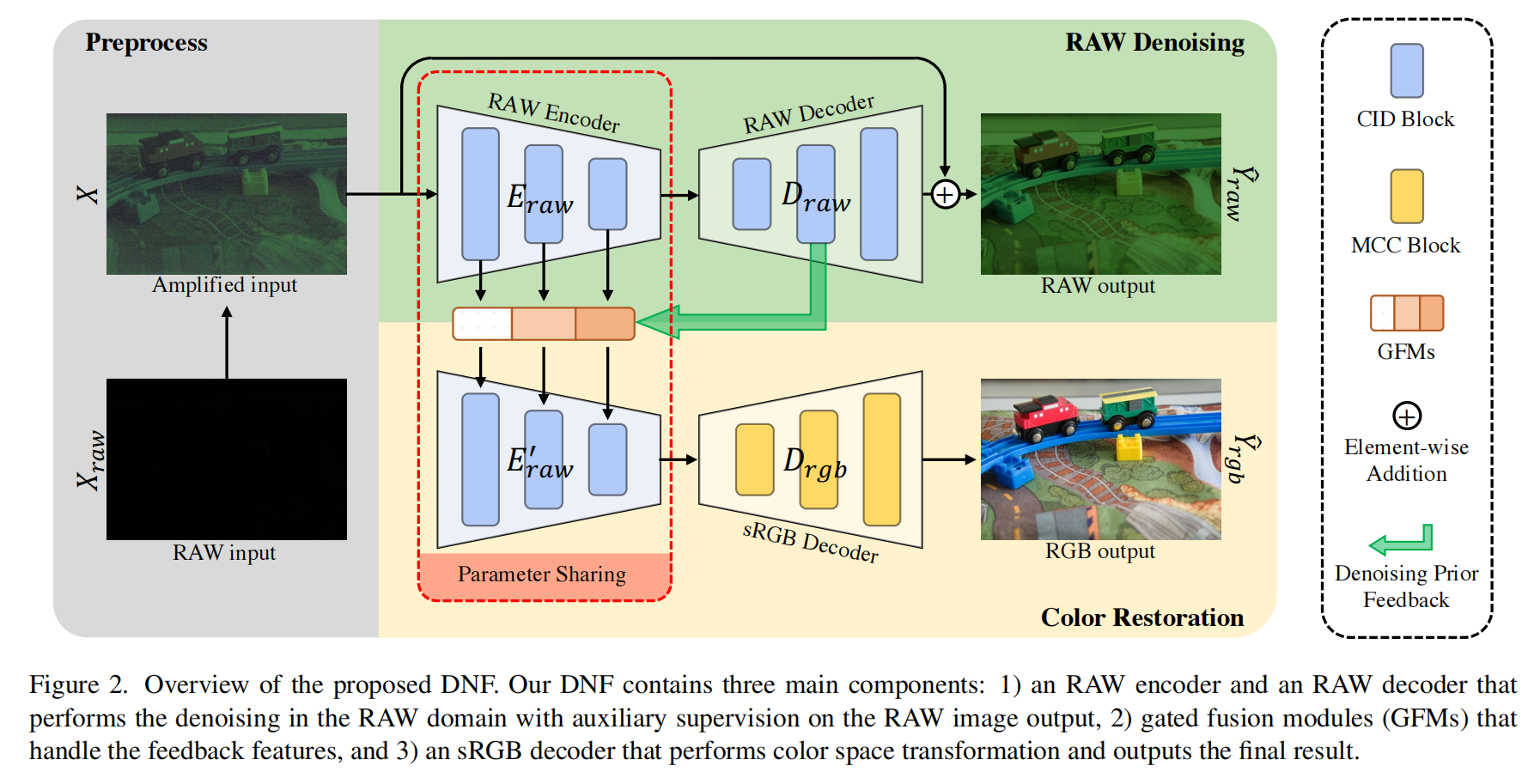

基于这些原则,我们提出了一个解耦与反馈 (Decouple and Feedback, DNF) 框架,包含以下为基于 RAW 的 LLIE 量身定制的设计。增强过程被解耦为两个特定领域的子任务:RAW 域中的去噪 [30, 33, 45, 48] 和到 sRGB 域的色彩恢复 [8, 28, 39],如图 1(c)1(c)1(c) 所示。在先前工作 [27] 中常用的编码器-解码器架构下,子网络中的每个模块都源自每个域的专有属性:用于 RAW 去噪的通道独立去噪 (Channel Independent Denoising, CID) 块,以及用于色彩渲染的矩阵化色彩校正 (Matrixed Color Correction, MCC) 块。此外,我们不使用不准确的去噪 RAW 图像,而是将来自 RAW 解码器的多尺度特征作为去噪先验。然后,这些特征通过提出的门控融合模块 (Gated Fusion Modules, GFM) 流入共享的 RAW 编码器,自适应地区分纹理细节和残留噪声。经过去噪先验反馈 (Denoising Prior Feedback) 后,信号进一步与噪声区分开来,在 RAW 域中产生完整且丰富的特征。得益于特征级数据流,MCC 块的解码器可以有效地处理剩余的增强和到 sRGB 域的色彩转换。

主要贡献总结如下:

- 特定领域任务解耦扩展了对 RAW 和 sRGB 域中独特属性的利用,避免了域模糊性。

- 由去噪先验反馈赋能的特征级数据流减少了误差累积,并聚合了跨阶段的互补特征。

- 与之前的最先进方法相比,所提出的方法仅使用 19% 的参数和 63% 的 FLOPs 就获得了显著的提升,例如在 SID 的 Sony 数据集上 PSNR 提高了 0.97dB,在 SID 的 Fuji 数据集上 PSNR 提高了 1.30dB。

2 相关工作

基于 RAW 的低光照图像增强

正如我们在第 1 节提到的,由于其独特的属性,RAW 图像在极低光照条件下的图像增强中得到了广泛探索。如图 1 所示,基于 RAW 的方法通常根据是否存在中间监督分为两类:单阶段和多阶段。单阶段 方法 [2, 5, 12, 13, 22, 42] 旨在迫使深度神经网络学习从噪声 RAW 域到干净 sRGB 域的直接映射。为了获得更好的性能,采用了多种尝试,包括相似性和感知损失 [42]、残差学习 [22]、多尺度特征 [5] 和轻量化 [12, 13]。然而,由于域模糊性,上述单阶段方法通常无法恢复纹理细节。多阶段 方法 [4, 7, 35, 47] 被提出来解决单阶段方法的局限性。通过在 sRGB 域上进行中间监督,EEMEFN [47] 和 LDC [35] 在第二阶段重建了细节。不同域上的中间监督用于不同的目的,例如 RAW 域用于解耦 [7],单色域用于低光照信息补充 [4]。然而,所有现有的多阶段方法共享相同的架构,即级联编码器-解码器 [27]。它们的图像级数据流导致了跨阶段的误差累积。我们提出的方法与现有方法在两个方面不同:1) 采用特定领域解耦架构以充分利用 RAW 和 sRGB 格式的特性。2) 采用特征级反馈架构来处理图像级数据流的误差累积。

解耦机制

解耦机制旨在将原始任务划分为几个更简单的子任务,然后显式地攻克它们。通过适当的解耦,神经网络可以更容易收敛,从而获得更好的性能。Li 等人 [18] 将外推任务解耦为边界框布局生成、分割布局生成和图像生成。合理的解耦通过边界框和分割布局这两个立足点减少了文本和图像之间的领域差距。最近的修复 (inpainting) 工作 [16, 25, 26] 旨在将修复任务解耦为结构和纹理重建以获得更好的结果。在高级任务 [11] 中,将领域自适应任务解耦为特征分布对齐和分割获得了性能提升。我们通过特定领域任务解耦来实现这一机制,将 LLIE 任务解耦为 RAW 去噪和色彩恢复。

反馈机制

反馈机制使网络能够访问先前状态的掌握情况。这一思想已应用于许多任务:分类 [37]、超分辨率 [17, 19] 和点云补全 [36]。引入反馈机制后,Li 等人 [19] 采用课程学习策略进行渐进式恢复。Yan 等人 [36] 旨在利用高分辨率特征通过反馈机制丰富低分辨率特征。所有现有方法都应用反馈机制来逐步完成单一任务,这与我们的方法不同。我们的反馈机制使我们的网络能够在两个不同的子任务之间进行通信,并且是在不同的领域中。

3 方法

如图 2 所示,提出的解耦与反馈框架包含两个阶段:RAW 去噪和色彩渲染 ,以渐进式增强低光照 RAW 图像。给定输入图像 XrawX_{raw}Xraw,乘以预定义的放大倍数 [2] 后,放大的图像 XXX 首先在 RAW 域中被编码器 ErawE_{raw}Eraw 和解码器 DrawD_{raw}Draw 去噪。然后,我们不使用不准确的 Y^raw\hat{Y}{raw}Y^raw 进行色彩渲染,而是将来自 DrawD{raw}Draw 的去噪特征 Fdn\mathbf{F}{dn}Fdn 反馈给 Eraw′E^{\prime}{raw}Eraw′,利用去噪先验进一步区分信号,并在 RAW 域中组合出丰富的特征。最后,sRGB 解码器 DrgbD_{rgb}Drgb 接收 RAW 域中的多尺度特征,渲染出 sRGB 域中的最终输出 Y^rgb\hat{Y}_{rgb}Y^rgb。

具体来说,一个共享编码器 ErawE_{raw}Eraw 和两个解码器 (DrawD_{raw}Draw 和 DrgbD_{rgb}Drgb) 是专门为通过特定领域任务解耦 (包含任务特定块,见第 3.1 节)解耦的子任务设计的。引入了通道独立去噪 (Channel Independent Denoising, CID) 块来学习 RAW 域中不同颜色通道中可处理且独立的噪声分布。根据色彩空间的定义,矩阵化色彩校正 (Matrixed Color Correction, MCC) 块使用全局矩阵变换完成到 sRGB 域的剩余增强。此外,我们结合了一个去噪先验反馈 机制以避免跨阶段的误差累积。利用从 RAW 解码器提取的去噪特征 Fdn\mathbf{F}_{dn}Fdn,RAW 编码器用高频信息丰富了浅层特征。此外,提出了一个带门控机制 [17] 的门控融合模块 (Gated Fusion Module, GFM),用于自适应地探索埋在噪声中的细节(见第 3.2 节)。

特定领域任务解耦

我们提出特定领域任务解耦 (Domain-Specific Task Decoupling) 来处理由噪声到干净和 RAW 到 sRGB 的混合映射引起的域模糊性。噪声 RAW 和干净 sRGB 域之间的鸿沟使得网络难以学习跨越这两个域的直接映射。因此,我们建议在鸿沟之间引入对干净 RAW 域的中间监督,以缓解直接学习混合映射的困难。通过对干净 RAW 域的中间监督,我们可以:1) 将增强解耦为 RAW 去噪和色彩恢复,2) 充分利用 RAW 图像上噪声分布可处理的特性进行去噪,3) 减少色彩恢复过程中的噪声干扰,从而减少色彩偏移。

在 RAW 域中去噪。 如图 2 所示,我们堆叠多个通道独立去噪 (CID) 块来实现 RAW 编码器 ErawE_{raw}Eraw 和 RAW 解码器 DrawD_{raw}Draw。CID 块的设计基于以下两个先验知识:1) RAW 格式的低光照图像受到与信号无关的噪声影响,该噪声服从零均值分布 [9, 33],2) 由于不同通道的信号在 RAW 域中本质上相关性较低 [34, 24],噪声分布往往在通道间是独立的。因此,我们需要对几乎相同的信号(相邻像素)进行突发观测 (burst observations) 以去除零均值噪声的干扰。此外,在去噪过程中防止通道间信息交换对于处理通道独立噪声分布是必不可少的。根据以上讨论,我们在 CID 块中引入具有大核的深度卷积 (depth-wise convolution) 进行去噪。CID 块的详细结构如图 3(a) 所示。具体来说,对于输入特征 FinF_{in}Fin,经过通道独立去噪块后的输出特征 FoutF_{out}Fout 可以表示为:

Fout=MLP(DConv7(Fin))+Fin,F_{out}=\texttt{MLP}(\texttt{DConv7}(F_{in}))+F_{in},Fout=MLP(DConv7(Fin))+Fin,

其中 DConv7\texttt{DConv7}DConv7 是使用 7×77\times 77×7 核的深度卷积。MLP 由两个逐点卷积层 (point-wise convolutional layers) 和一个 GELU [6] 非线性函数实现。同时,设置了一个残差开关 (residual switch) 来执行两种不同的功能(通过权重共享的 CID 块),详见第 3.2 节。

从 RAW 到 sRGB 的色彩校正。 矩阵变换通常用于规范的 ISP 流水线 [23]。由于全局共享的设置,如环境光照和色彩空间规范,图像的色彩主要通过通道级矩阵变换来增强或转换到另一个色彩空间。遵循这一原则,我们引入矩阵化色彩校正 (Matrixed Color Correction, MCC) 块来执行全局色彩增强以及局部细化,如图 3(b) 所示。对于 sRGB 解码器 DrgbD_{rgb}Drgb,我们堆叠多个 MCC 块进行色彩校正。该块的设计受益于转置自注意力 (transposed self-attention) 的最新进展 [38]。它的全局感受野和通道级操作非常适合规范 ISP 中的色彩校正。给定输入源特征 Fsource∈RC×H×WF_{source}\in\mathbb{R}^{C\times H\times W}Fsource∈RC×H×W,首先通过一个 1×11\times 11×1 卷积层、一个 3×33\times 33×3 深度卷积和一个展平 (flatten) 操作生成查询 Q∈RC×HWQ\in\mathbb{R}^{C\times HW}Q∈RC×HW、键 K∈RC×HWK\in\mathbb{R}^{C\times HW}K∈RC×HW 和值 V∈RC×HWV\in\mathbb{R}^{C\times HW}V∈RC×HW 的向量。然后,通过矩阵乘法获得变换矩阵 M∈RC×CM\in\mathbb{R}^{C\times C}M∈RC×C。该过程可以表示为:

Q,K,V=Flatten(DConv3(PConv(Fsource))),Q,K,V=\texttt{Flatten}(\texttt{DConv3}(\texttt{PConv}(F_{source} ))),Q,K,V=Flatten(DConv3(PConv(Fsource))),

M=Softmax(Q⋅KT/λ),M=\texttt{Softmax}(Q\cdot K^{T}/\lambda),M=Softmax(Q⋅KT/λ),

其中应用缩放系数 λ\lambdaλ 以保证数值稳定性。然后,色彩向量 VVV 被矩阵 MMM 变换,在特征级执行色彩空间转换。色彩变换后的目标特征可以通过 Ftarget=M⋅VF_{target}=M\cdot VFtarget=M⋅V 获得。作为全局矩阵变换的补充,我们使用一个深度卷积和一个逐点卷积来进一步细化局部细节。

去噪先验反馈

在以前的基于 RAW 的方法 [4, 7, 35, 47] 中,一部分高频内容在增强过程中被错误地识别为噪声,严重恶化了最终结果,导致细节丢失并产生有损数据流。为了避免现有多阶段方法的有损图像级数据流,我们提出了一种具有特征级信息传播的去噪先验反馈 (Denoising Prior Feedback) 机制。我们将 Fdn={Fdn1,Fdn2,...,FdnL}\mathbf{F}{dn}=\{F{dn}^{1},F_{dn}^{2},...,F_{dn}^{L}\}Fdn={Fdn1,Fdn2,...,FdnL} 表示为从 RAW 解码器 DrawD_{raw}Draw 提取的一组去噪特征,其中 LLL 表示阶段数。Fdn\mathbf{F}{dn}Fdn 的每个元素主要包含 RAW 域中不同尺度的最终噪声估计信息。具体来说,这些特征使噪声更易区分,并作为进一步去噪的指导。通过将去噪特征集 Fdn\mathbf{F}{dn}Fdn 通过多个反馈连接 [19, 1, 29] 重路由到 RAW 编码器的相应阶段,编码器利用上一次估计逐渐生成更好的去噪特征以进行进一步增强。因此,sRGB 解码器 DrgbD_{rgb}Drgb 可以更专注于色彩校正。反馈流程如图 2 所示,可表示为:

Fdn=Draw(Eraw(X)),Frdn=Eraw′(X,Fdn),\mathbf{F}{dn}=D{raw}(E_{raw}(X)),\quad F_{rdn}=E^{\prime}{raw}(X,\mathbf{F}{dn}),Fdn=Draw(Eraw(X)),Frdn=Eraw′(X,Fdn),

其中 FrdnF_{rdn}Frdn 表示将转发到 sRGB 解码器的精炼去噪特征。Eraw′E^{\prime}{raw}Eraw′ 表示 RAW 编码器,它不仅包含 ErawE{raw}Eraw 的权重,还配备了 LLL 个门控融合模块 (GFMs)。每个 GFM 负责处理来自 Fdn\mathbf{F}_{dn}Fdn 的一个反馈特征。

门控融合模块 (Gated Fusion Modules, GFM)。 GFM 旨在通过门控机制 [17] 自适应地融合反馈噪声估计与初始去噪特征。在特征门控期间,我们希望有用的信息能沿空间和通道维度自适应地被选择和合并。为了效率,我们使用一个逐点卷积和一个深度卷积 [3] 分别聚合通道和局部内容信息。然后,我们将混合特征沿通道维度分成两部分,即 ,FgatelF^{l}{gate}Fgatel 和 FconlF^{l}{con}Fconl。经过 GELU 非线性函数激活后,FgatelF^{l}{gate}Fgatel 通过逐点乘法对 FconlF^{l}{con}Fconl 进行门控。我们通过这种门控机制实现了空间和通道的自适应性。GFM 的详细结构如图 3© 所示。在第 lll 个 (l∈{1,2,...,L}l\in\{1,2,...,L\}l∈{1,2,...,L}) 阶段的操作可以表示为:

Fgatel,Fconl=DConv3(PConv([Frawl,Fdnl])),F^{l}{gate},F^{l}{con} =\text{DConv3}(\text{PConv}([F^{l}{raw},F^{l}{dn}])),Fgatel,Fconl=DConv3(PConv([Frawl,Fdnl])),

Ffusel=PConv(Fconl⊙GELU(Fgatel))+Frawl,F^{l}{fuse} =\text{PConv}(F^{l}{con}\odot\text{GELU}(F^{l}{gate}))+F^{l}{raw},Ffusel=PConv(Fconl⊙GELU(Fgatel))+Frawl,

其中 DConv3 和 PConv 分别表示核为 3×33\times 33×3 的深度卷积和逐点卷积。⊙\odot⊙ 表示哈达玛积 (hadamard product)。FrawlF^{l}{raw}Frawl 是在原始 RAW 编码器中第 lll 个上采样层之后获得的特征。FflF^{l}{f}Ffl 是对应的融合特征。

一个逐点卷积在这个融合特征上执行通道混合。混合后的特征被送入 RAW 编码器中的下一个 CID 块以进行进一步精炼。

残差开关机制 (Residual Switch Mechanism)。 如图 2 所示,我们仅在 RAW 域的去噪阶段保留全局捷径 (global shortcut) 以获得更好的去噪效果 [22, 43],而在色彩恢复阶段移除它以避免噪声 RAW 域和干净 sRGB 域之间的模糊连接。因此,编码器在去噪时需要执行噪声估计,而在色彩恢复时需要重建信号。为了在单个编码器中实现这两种矛盾的功能,我们提出了一种简单而有效的残差开关机制 (Residual Switch Mechanism, RSM),如图 3(a) 所示,使共享 RAW 编码器中的 CID 块能够产生两种矛盾的特征:噪声和信号。在具有全局残差连接的去噪阶段,局部残差捷径 (local residual shortcuts) 被关闭以估计噪声。相反,在渲染阶段触发局部残差,通过捷径上的原始特征抵消噪声,最终重建信号。如图 4 所示,共享 RAW 编码器的 CID 块能够通过 RSM 在不同阶段产生两种不同的特征。然而,没有 RSM,权重共享的 CID 块在色彩恢复阶段无法区分噪声和信号,导致特征模糊。残留的噪声阻碍了色彩校正过程,并再次引入了域模糊性。

训练目标

为了顺序完成由特定领域任务解耦解耦出的 RAW 去噪和色彩恢复子任务,我们在不同域上引入了两种不同的监督,即 干净 RAW 和干净 sRGB。真实标签 (ground truth) 是清晰的 RAW 图像 YrawY_{raw}Yraw。我们将去噪解码器的输出 RAW 图像表示为 Y^raw\hat{Y}_{raw}Y^raw。我们网络的损失函数是:

L=∥Yraw−Y^raw∥1+∥Yrgb−Y^rgb∥1,L=\left\|Y_{raw}-\hat{Y}{raw}\right\|{1}+\left\|Y_{rgb}-\hat{Y}{ rgb}\right\|{1},L= Yraw−Y^raw 1+ Yrgb−Y^rgb 1,

其中 YrgbY_{rgb}Yrgb 是真实标签 sRGB 图像。值得注意的是,在我们的方法中,RAW 监督和 sRGB 监督都只采用了 L1L_{1}L1 损失,而不是像之前的方法 [7, 30, 32, 42, 47] 那样混合复杂的损失函数。训练细节和详细的网络架构可在补充材料中找到。

4 实验与分析

数据集与评估指标

我们在两个不同的基于 RAW 的 LLIE 数据集上对我们的 DNF 进行了基准测试,即暗光视觉 (See-In-the-Dark, SID) [2] 数据集和单色 RAW 配对 (Mono-Colored Raw Paired, MCR) [4] 数据集。SID [2] 数据集包含 5094 张极低光照 RAW 图像及相应的正常光照参考图像,由两台相机拍摄:采用 Bayer 传感器、分辨率为 4240 × 2832 的 Sony A752,以及采用 X-Trans 传感器、分辨率为 6000 × 4000 的 Fuji X-T2。低光照图像的曝光时间从 0.1s 到 0.033s 不等,参考图像的曝光时间是低光照图像的 100 到 300 倍。请注意,在 Sony 子集的测试集中,三个场景的长短对没有对齐,因此我们在测试阶段遵循之前的方法 [22, 47] 丢弃这些图像。为了公平比较,所有对比方法都在相同的设置下进行评估。MCR [4] 数据集包含 4980 张分辨率为 1280 × 1024 的训练和测试图像,包括 3984 张低光照 RAW 图像、498 张单色图像和 498 张 sRGB 图像。包含室内和室外两种不同的场景,设置了不同的曝光时间,室内场景为 1/256s 到 3/8s,室外场景为 1/4096s 到 1/32s。然而,没有提供 RAW 格式的真实标签,而这对于训练我们的方法是必不可少的。因此,我们选择每个场景曝光时间最长的图像作为 RAW 真实标签。同时,单色图像在我们的 DNF 中不予考虑。我们将 PSNR、SSIM [31] 和 LPIPS [44] 分别作为像素级、结构性和感知评估的定量评估指标。

与最先进方法的比较

我们在 SID [2] 和 MCR [4] 数据集的 Sony 和 Fuji 两个子集上评估我们的 DNF,并将其与最先进的基于 RAW 的 LLIE 方法进行比较,包括单阶段方法 SID [2], DID [22], SGN [5], LLPack-Net [12] 和 RRT [13],以及多阶段方法 EEMEFN [47], LDC [35], RRENet [7] 和 MCR [4]。

定量评估。 如表 1 和表 2 所示,我们的方法大幅超越了之前的最先进方法。在 SID 数据集上,我们的 DNF 取得了最佳的 PSNR 和 LPIPS 分数,在 Sony 和 Fuji 子集上分别比第二名方法提高了 0.97 dB 和 1.30 dB 的 PSNR,以及 0.005 和 0.023 的 LPIPS。请注意,LDC [35] 和 MCR [4] 是在不同的方案¹下训练和测试的,这可能导致更好的性能。关于复杂度,我们的 DNF 的参数量和 FLOPs 明显少于当前最佳方法(即 MCR 和 EEMEFN)。我们的网络分别比 MCR 和 EEMEFN 少用了 1/5 和 1/15 的参数,以及 3/5 和 1/13 的 FLOPs。在 MCR 数据集上,如表 2 所示,我们的方法实现了最佳的 PSNR 和 SSIM 分数,以更少的参数和 FLOPs 超过了之前的最先进方法 0.31dB(PSNR)和 0.07(SSIM)。

定性评估。 图 5 和图 6 展示了在 SID [2] 数据集上的定性结果。可以看出,由于去噪能力有限,对比方法增强的结果存在严重的内容失真和伪影。此外,得益于解耦和反馈架构,色彩转换和增强更准确,不受噪声干扰,因此表现出更好的色彩一致性以及更真实、生动的色彩渲染。我们的方法成功地抑制了密集的噪声,同时保留了丰富的纹理细节。在 MCR 数据集上的定性比较可在补充材料中找到。

消融研究

我们对提出的 DNF 进行了广泛的消融研究。所有实验均在 SID [2] 的 Sony 子集上进行。

特定领域任务解耦。 为了更好地评估我们特定领域任务解耦的影响,我们在去噪解码器上引入了不同类型的中间监督,如表 3 所示。1) 没有监督 (w/o Sup.) 无法将去噪先验反馈回共享 RAW 编码器,导致 PSNR 下降 0.14dB。2) sRGB 监督 (sRGB Sup.) 将主任务解耦为第一阶段增强和细节重建,类似于 [47, 35]。第一阶段增强由于直接从噪声 RAW 学习到干净 sRGB 域而遭受域模糊性,导致 PSNR 下降 0.42dB。sRGB Sup. 和 w/o Sup. 之间的比较(下降 0.28dB)表明域模糊性严重制约了网络的性能。

去噪先验反馈。 为了验证我们基于反馈机制的框架的有效性,我们首先在表 3 中检查了我们框架的单阶段和多阶段(两阶段,类似于大多数现有方法 [7, 4, 47, 35])变体。1) 单阶段变体(通过直接级联 RAW 编码器和 sRGB 解码器)导致 PSNR 下降 0.46dB。2) 多阶段变体简单地级联了两个分别配备 CID 块和 MCC 块的 UNet [27]。有损图像级数据流严重恶化了性能,导致 PSNR 下降 0.30dB。

门控融合模块 (Gated Fusion Module)

采用了其他三种融合模块:传统的卷积层(下降 0.22dB)、没有门控机制的深度卷积(下降 0.27dB)和专用于特征融合的 SKFF [10, 40] 模块(下降 0.25dB)。由于门控机制提供的逐像素选择,我们的方法享有最佳性能。

残差开关机制 (Residual Switch Mechanism)。 如表 4 所示,与完全不使用任何残差捷径相比,利用全局残差捷径提高了性能(上升 0.06dB)。然而,色彩恢复阶段的全局捷径会通过引入域模糊性而限制性能(下降 0.03dB)。使用或禁用所有局部捷径的实验引入了功能矛盾,从而导致不同程度的性能下降(与 DNF 相比分别下降 0.33dB 和 0.30dB)。与实现残差开关机制的另一种方法(在去噪时开启或在色彩恢复时关闭)相比,在色彩恢复阶段开启 CID 块的局部捷径提供了更多关于图像内容的信息,从而实现了更高的性能。

与其他特征级数据流的比较。 如表 5 所示,与一个特征级数据流的多阶段框架相比,我们的模型产生了最佳性能,这验证了残差开关机制 (RSM) 的有效性。该特征级多阶段框架保留了门控融合模块,但涉及两个不同的 RAW 编码器。结果表明,权重共享的编码器可以通过我们提出的 RSM 执行两种不同的功能。此外,噪声估计和信号重建这两种互补功能相互补充,以实现更好的性能。

5 结论

鉴于 RAW 格式的独特属性,我们提出了一种用于基于 RAW 的低光照图像增强的解耦与反馈框架。作为一个通用流程,提出的 DNF 克服了先前方法的固有局限性。特定领域任务解耦消除了单阶段方法引起的域模糊性,而去噪先验反馈取代了采用有损图像级数据流的多阶段方法。显著的性能和广泛的实验表明了所提出框架的优越性,以及 RAW 图像在低光照增强方面的巨大潜力。

局限性。 所提出框架的一个剩余局限性(也与大多数现有方法共享)是输入图像的放大倍数是根据曝光时间预先定义的。在极低光照条件下,估计正常光照在现实场景中至关重要且困难。