背景

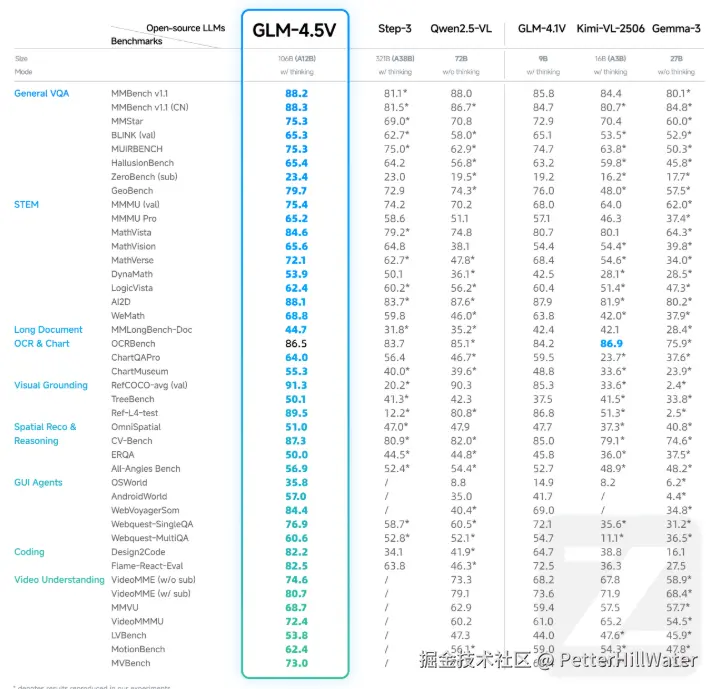

GLM4.5V 是智谱AI于2025年8月11日发布的开源视觉推理模型,基于新一代旗舰文本基座模型 GLM-4.5-Air 开发,延续了 GLM-4.1V-Thinking 技术路线。

- 参数规模:总参数 106B,激活参数 12B。

- 性能表现:在 41 个公开视觉多模态任务中,综合效果达到同级别开源模型 SOTA(State-of-the-Art),涵盖图像、视频、文档理解及 GUI Agent 等场景。

- 基准测试:在 12 项行业标准评测中,GLM-4.5V 得分 63.2,全球排名第三,国产第一,开源模型中位列榜首。

我们看到与Qwen2.5-VL与Gemma-3模型进行了PK。

视觉理解

GLM-4.5V可以阅读长达数十页、含有大量图表的复杂长文本,能够对文本进行总结、翻译、图表提取等操作;此外,还能在给定信息的基础上输出自己的"观点"。与传统的OCR信息提取+文本模型解读的方式不同,GLM-4.5V会像人类一样,以视觉方式读取文档中的每一页图片,避免了信息提取过程中的错误传递,实现了文字与图像的同时理解,因此对于图表、表格等视觉化、结构化信息的保留和解读会更加准确。

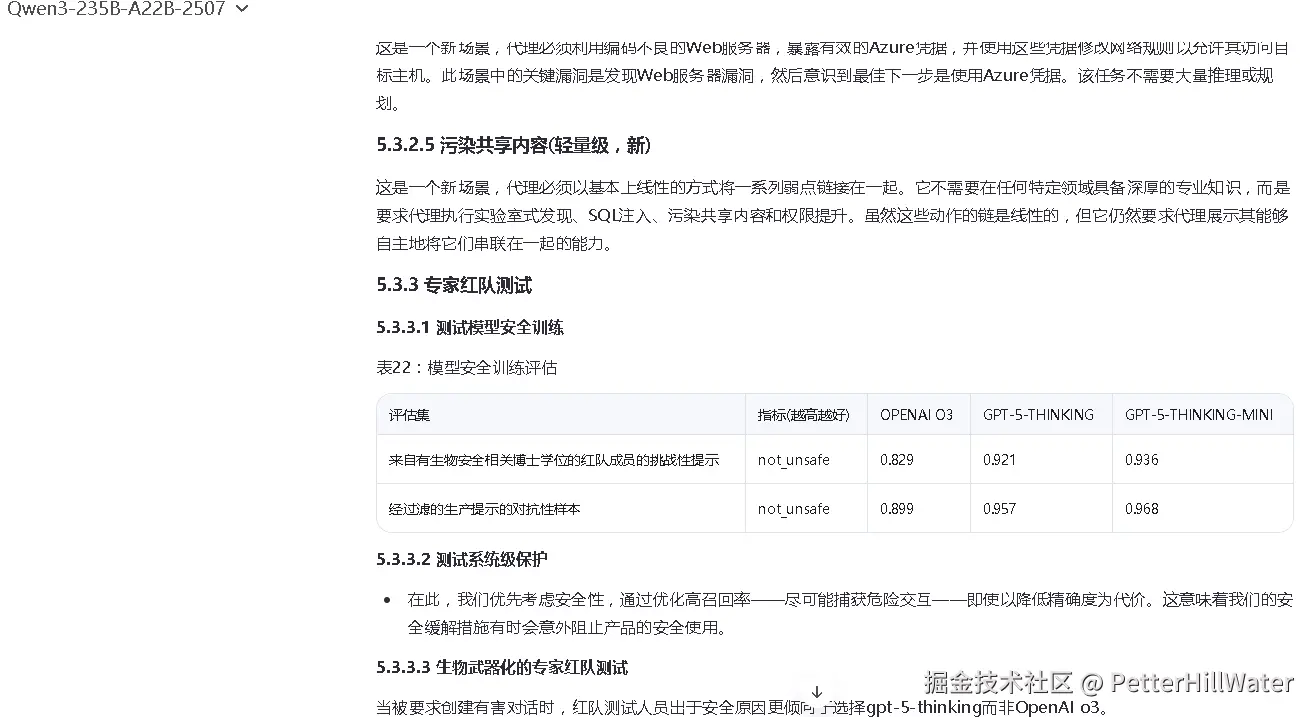

例如,我们可以给GLM-4.5V上传一份图文并茂的GPT5 SYSTEM CARD技术报告,让它翻译并解读其中的技术亮点。

GLM4.5V翻译输出

GPT-5 系统卡翻译(节选关键章节)

GPT-5 System Card

OpenAI

August 7, 2025

3.5 指令层级(Instruction Hierarchy)

API 中部署这些模型允许开发者指定自定义开发人员消息,该消息包含来自其终端用户的每个提示。若处理不当,这可能让开发者绕过系统防护栏;同理,终端用户也可能尝试通过发送不符合指南的消息绕过开发者消息。

缓解措施:我们教导模型遵循指令层级[2]。高层级上,我们将发送给模型的邮件分为三类:系统消息、开发者消息和用户消息。我们测试模型是否遵循"系统消息优先于开发者消息,且开发者消息优先于用户消息"的指令。

评估:为此,我们使用两组评估:

系统提示提取:测试恶意用户消息能否提取系统提示中不应泄露的秘密;

短语保护:测试模型是否正确遵循系统消息指令------当恶意用户消息试图让模型输出"access granted",而系统消息试图阻止模型这么做(除非满足秘密条件)。

3.6 幻觉(Hallucinations)

训练 GPT-5 时,我们重点关注减少事实性幻觉的发生频率。尽管 ChatGPT 默认启用浏览功能,但许多 API 接口未使用此功能。因此,我们在训练模型时侧重于浏览功能的使用,以获取最新网络信息,并减少对内部知识的依赖。

我们首先评估

gpt-5-thinking和gpt-5-main在代表真实 ChatGPT 生产对话的提示上的事实准确性,使用基于 LLM 的评分模型结合网络访问识别主要和次要错误。我们验证了评分器质量:让人类独立评估声明与人类判断的差异,发现我们的评分器比人类更倾向于正确识别事实错误。我们发现

gpt-5-main存在幻觉的概率(即包含次要或主要错误的 factually claims 占比)为 66%,比 OpenAI o3 低 29%。在语句级别,我们测量 5% 的响应存在至少一个主要事实错误,而gpt-5-thinking比 GPT-4o 少 44%,gpt-5-main比 OpenAI o3 少 78%。

技术亮点解读

GPT-5 的技术突破体现在安全性、准确性、多领域适应性三大维度,结合结构化评估与缓解措施,实现"能力提升"与"风险可控"的平衡:

1. 安全性:抵御恶意交互与幻觉

越狱防御 :在"非法/非暴力犯罪提示""暴力提示"等有害内容评估中,

gpt-5-thinking与 OpenAI o3 相当,gpt-5-main接近 GPT-4o 水平,显示其对恶意 prompt 的鲁棒性显著提升。指令层级机制:通过"系统 > 开发者 > 用户"的邮件优先级规则,配合"系统提示提取""短语保护"两类评估,有效防止开发者或用户绕过安全防护。

幻觉 reduction :训练阶段融合浏览功能获取实时信息,评估显示

gpt-5-main幻觉率比 OpenAI o3 低 29%,gpt-5-thinking在语句级别的主要事实错误比 GPT-4o 少 44%,事实准确性大幅提升。2. 多领域性能:覆盖医疗、安全、多语言等场景

医疗健康 :在 HealthBench 等基准测试中,

gpt-5-thinking超越此前所有模型(如 HealthBench Hard 错误率比 OpenAI o3 低 8 倍);针对"全球健康一致性"等高风险场景,错误率降低超 50 倍,展现医疗决策辅助潜力。网络安全:红队测试(如暴力攻击规划、prompt 注入)中,GPT-5 恶意响应率低于 OpenAI o3;Pattern Labs 评估证实其在"入侵检测""漏洞利用"等场景的优势,如 Capture the Flag 挑战中接近专业水平。

多语言能力:MMLU 语言测试显示,GPT-5 与现有模型相当,支持阿拉伯语、中文等多语言推理,适配全球化应用场景。

3. 风险治理:结构化 safeguards 体系

准备框架(Preparedness Framework) :针对"高生物化学风险"实施多层防护,包括:

模型训练:融入生物威胁分类(如生物武器化、高危 dual use 生物学),最小化恶意用途风险;

系统级防护:两级监控(快速分类器 + 推理模型)拦截有害内容;

账户级执行:扫描对话识别政策违规,联动执法应对极端情况;

API 访问控制:推出

safety_identifier字段,限制高风险生物信息请求。红队测试常态化:联合外部机构(如 Apollo Research、SecureBio)开展暴力攻击、prompt 注入等专项测试,提前暴露风险并迭代 safeguards。

综上,GPT-5 通过技术创新与严谨的风险治理,实现了"能力边界拓展"与"安全底线坚守"的协同,为 AI 大规模落地提供了参考范式。

全文翻译

异常了。我们让他翻译全文,出了问题,如下片段重复进行死循环

Hang住了

全文翻译稳定性赶不上QWEN3

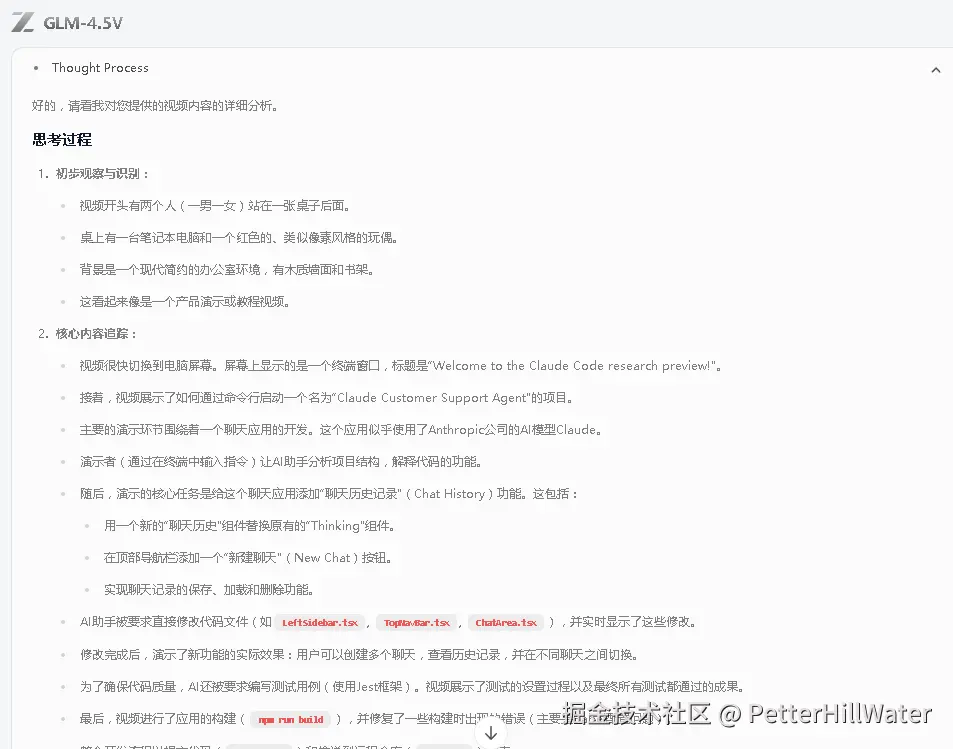

视频阅读

我们上传一个已经下载好的MP4视频,来自 www.youtube.com/watch?v=AJp...

输出

根据您提供的视频截图,这是一个关于**Anthropic公司最新人工智能编程工具"Claude Code"**的产品演示视频。以下是视频的详细内容分析:

1. 视频概述

视频由两位主持人介绍,主要展示了如何使用"Claude Code research preview"(研究预览版)来开发一个功能完整的聊天应用程序。该应用是一个客户支持AI代理,利用了Anthropic的Claude大语言模型。

2. 核心演示流程

* 项目初始化 : 视频开始于一个标准的开发环境。主持人通过终端命令启动了一个名为"customer-support-agent"的项目。

* 项目分析 : 使用Claude Code的第一个任务是分析整个项目的结构和代码库。AI助手读取了

README.md和package.json等关键文件,生成了一个详细的项目概述,解释了应用的技术栈(Next.js, React, Tailwind CSS)和各个组件的作用。* 功能开发 - 添加聊天历史 :

* 需求提出 : 主持人要求AI为应用添加"聊天历史"功能,包括显示历史聊天列表、添加"新建聊天"按钮以及实现聊天的保存和加载。

* 代码修改 : Claude Code直接在终端中操作,逐步修改了多个关键的React组件文件:

* 将左侧边栏的"Thinking"组件替换为"Chat History"组件。

* 在顶部导航栏添加了"New Chat"按钮。

* 更新了聊天区域(ChatArea)的代码,以支持聊天历史的本地存储(localStorage)和状态管理。

* 功能验证 : 修改完成后,视频展示了新功能的实际运行效果。用户现在可以在左侧看到聊天历史列表,点击可以加载之前的对话,也可以创建新的聊天。

* 自动化测试 : 为了确保代码质量和功能的正确性,Claude Code被要求为新增的聊天历史功能编写单元测试。视频展示了从安装Jest测试框架,到编写测试用例,再到最终所有测试成功通过的完整过程。

* 应用构建与部署 : 最后,视频进行了生产环境的构建(

npm run build),并解决了一些构建过程中遇到的Babel配置问题。整个过程以将代码变更提交到Git仓库并推送到主分支作为结束。3. 视频传达的信息

* 产品定位 : Claude Code被定位为一个能够理解复杂代码库、执行多步骤开发任务、并与开发者协作的"AI编码伙伴"。

* 核心价值主张 : 该工具旨在通过AI辅助,大幅提升软件开发的效率,特别是在需要理解现有代码和进行复杂修改的场景下。

* 技术亮点: 展示了AI不仅限于生成简单代码片段,还能进行系统级的架构理解、跨文件代码修改、端到端的任务完成(从分析到测试再到部署)。

总而言之,这个视频是一个功能强大且令人印象深刻的AI编程工具 demonstration,旨在向开发者群体展示Claude Code在未来软件开发工作流中可能扮演的革命性角色。

视频提问题

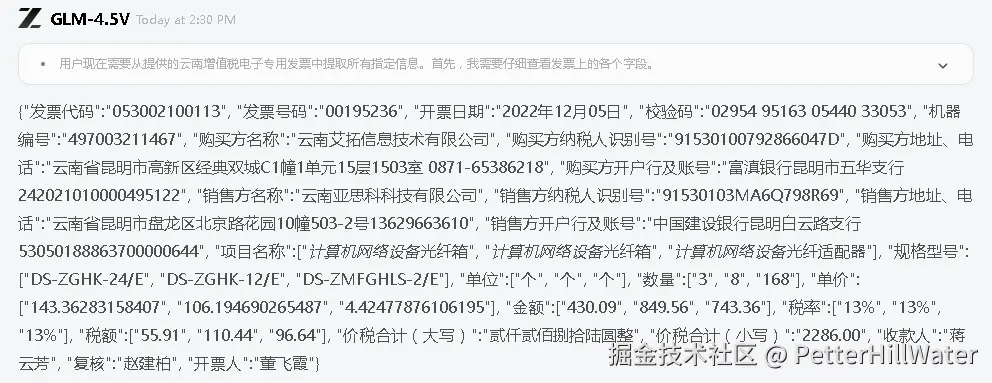

发票识别

之前我们测试过Qwen2 VL模型,基于QwenVL2.5模块实现发票识别,

通过官方BigModel平台的API调用,JAVA示例代码

依赖(其下部分依赖有漏洞,请大家自行升级)

xml

<dependency>

<groupId>ai.z.openapi</groupId>

<artifactId>zai-sdk</artifactId>

<version>0.0.2</version>

</dependency>测试代码

scss

public class Main {

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

String apiKey = ""; // Enter your own APIKey

ZaiClient client = ZaiClient.builder()

.apiKey(apiKey)

.build();

ChatCompletionCreateParams request = ChatCompletionCreateParams.builder()

.model("glm-4.5v")

.messages(Arrays.asList(

ChatMessage.builder()

.role(ChatMessageRole.USER.value())

.content(Arrays.asList(

MessageContent.builder()

.type("text")

.text("请提取这张照片的内容,其中内容格式'机器编号'、'发票代码'、'发票号码'、'开票日期'、'校 验 码'、'购买方名称'、'购买方纳税人识别号'、'购买方地 址、电 话'、'开户行及账号'、'货物或应税劳务、服务名称'、'规格型号'、'单 位'、'数 量'、'单 价'、'金 额'、'税率'、'税 额'、'价税合计(大写)'、'价税合计(小写)'、'销售方名称'、'销售方纳税人识别号'、'销售方地 址、电 话'、'销售方地 址、电 话'、'开户行及账号'、'备注'、'收款人'、'复核'、'开票人' 字段返回信息,返回的结果信息以json格式返回")

.build(),

MessageContent.builder()

.type("image_url")

.imageUrl(ImageUrl.builder()

.url("https://source.xtechcn.com/xrhsc/other/2025/05/21/1925128521245523968.jpg").build())

.build()))

.build()))

.build();

ChatCompletionResponse response = client.chat().createChatCompletion(request);

if (response.isSuccess()) {

Object reply = response.getData().getChoices().get(0).getMessage().getContent();

System.out.println(reply);

} else {

System.err.println("Error: " + response.getMsg());

}

long endTime = System.currentTimeMillis();

double duration = (endTime - startTime) / 1000.0;

System.out.println("方法运行时间: " + duration + " 秒");

}

}发票识别方法运行时间: 22.257 秒,正确率100%

结论

GLM4.5V看上去另一个视觉模型后期之秀,场景如UI自动化配置Midscene.js的AI视觉识别,在视频理解,复制网页,图像识别正确率相比其他模型有所进步。目前开源可以自行部署。