I. 引言

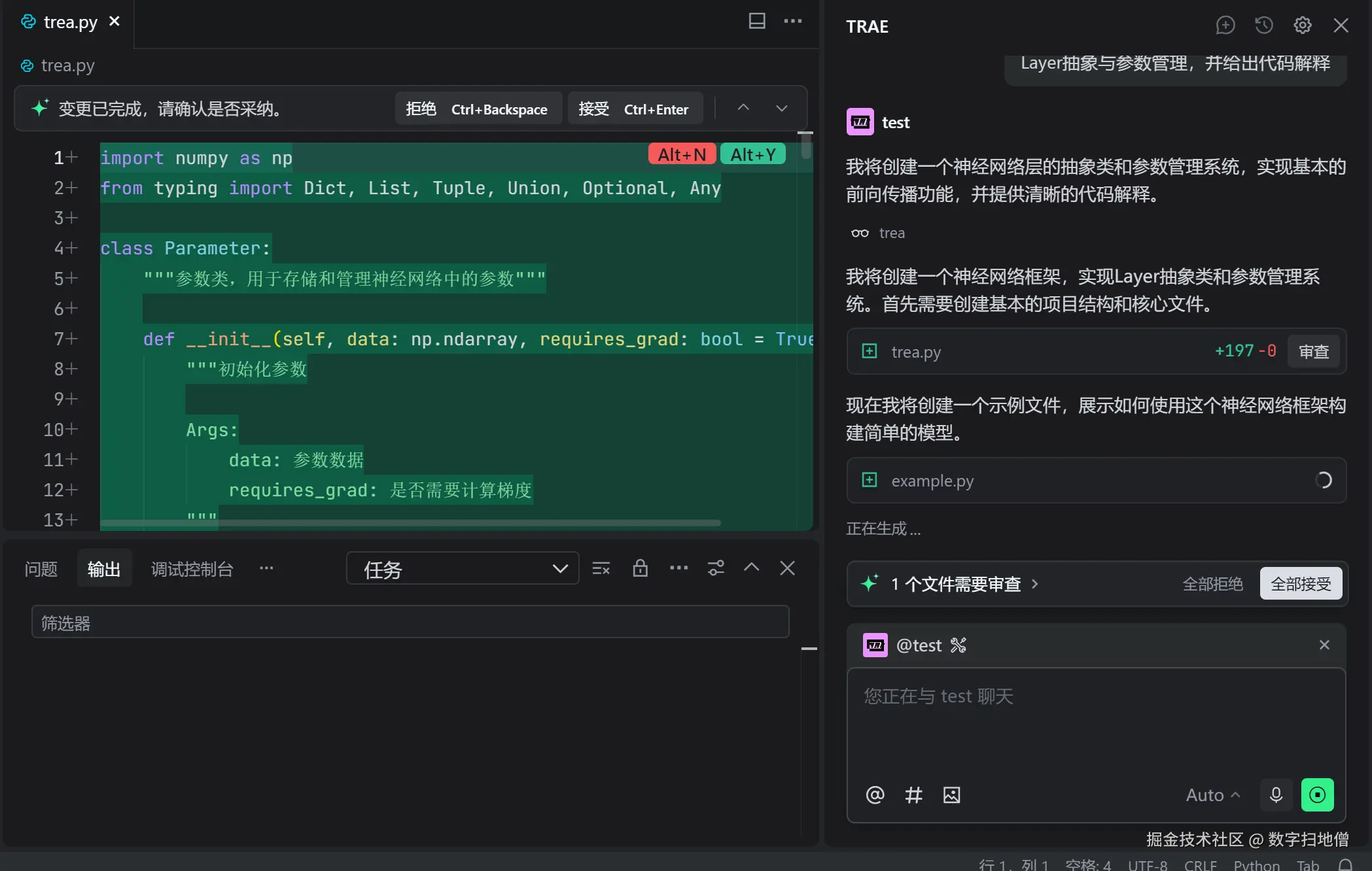

在深度学习模型的构建中,Layer(层)作为核心组件,承担着对数据进行逐步抽象和特征提取的关键任务。Trae 框架以其强大的 Layer 抽象和便捷的参数管理功能,为开发者提供了高效构建复杂神经网络的能力。本文将深入浅出地介绍 Trae 中的 Layer 抽象机制、自定义层开发、预训练层应用以及参数管理技巧,结合丰富的代码示例和实例分析,助力读者掌握模型构建的核心技能。

II. Layer 抽象基础

理解 Trae 中的 Layer 抽象是构建高效神经网络的第一步。Layer 在框架中不仅是数据流动的节点,更是参数组织和计算逻辑封装的基本单元。

2.1 标准层类型

Trae 提供了多种内置的标准层类型,满足不同场景下的建模需求。

| 层类型 | 功能描述 | 常见应用场景 |

|---|---|---|

| Dense(全连接层) | 对输入进行线性变换后应用激活函数 | 分类问题中的输出层、多层感知机 |

| Conv2D(二维卷积层) | 在图像数据上提取空间特征 | 图像分类、目标检测 |

| LSTM(长短期记忆层) | 处理序列数据,捕捉长期依赖关系 | 文本生成、时间序列预测 |

| Dropout(丢弃层) | 随机丢弃部分神经元输出,防止过拟合 | 各种模型的正则化 |

| BatchNormalization(批量归一化层) | 对每一批数据进行归一化处理,加速训练 | 几乎所有类型的神经网络 |

示例:使用标准层构建简单模型

python

import trae

# 构建一个包含多种标准层的模型

model = trae.keras.Sequential([

trae.keras.layers.Dense(64, activation='relu', input_shape=(20,)), # 全连接层

trae.keras.layers.Dropout(0.5), # 防止过拟合

trae.keras.layers.BatchNormalization(), # 批量归一化

trae.keras.layers.Dense(32, activation='relu'),

trae.keras.layers.Dense(10, activation='softmax') # 输出层

])

# 打印模型结构

model.summary()代码解析:

- Sequential 模型按顺序堆叠各层。

- Dense 层实现输入数据的线性变换和非线性激活。

- Dropout 层在训练时随机丢弃神经元输出,测试时自动禁用。

- BatchNormalization 层确保每层输入数据分布稳定,加快训练收敛。

2.2 Layer 的核心属性

每个 Layer 对象包含若干关键属性,开发者可通过这些属性深入了解和操作层的行为。

| 属性名 | 说明 |

|---|---|

weights |

层中所有权重参数的列表,包括可训练和不可训练的 |

trainable_weights |

仅包含可训练的权重参数 |

non_trainable_weights |

仅包含不可训练的权重参数 |

input_shape |

层的输入形状 |

output_shape |

层的输出形状 |

input |

获取层的输入张量 |

output |

获取层的输出张量 |

示例:访问层的属性

python

# 获取第一层的权重信息

first_layer = model.layers[0]

print("Weights shape:", [w.shape for w in first_layer.weights])

print("Trainable weights count:", len(first_layer.trainable_weights))输出示例:

yaml

Weights shape: [(20, 64), (64,)] # 权重矩阵和偏置向量

Trainable weights count: 22.3 Layer 抽象基础总结(mermaid)

III. 自定义层开发

尽管 Trae 提供了丰富的标准层,但在实际项目中,我们常常需要开发自定义层以实现特定的计算逻辑。

3.1 自定义层开发流程

开发自定义层通常遵循以下步骤:

- 继承基类 :从

trae.keras.layers.Layer继承,创建新的层类。 - 定义构造函数 :在

__init__方法中定义层的参数和子层。 - 构建层 :在

build方法中创建权重变量。 - 实现前向传播 :在

call方法中定义层的计算逻辑。

示例:开发一个简单的自定义层

python

class CustomDense(trae.keras.layers.Layer):

def __init__(self, units, activation=None):

super().__init__()

self.units = units

self.activation = trae.keras.activations.get(activation)

def build(self, input_shape):

# 创建权重变量

self.kernel = self.add_weight(

shape=(input_shape[-1], self.units),

initializer='glorot_uniform',

trainable=True,

name='kernel'

)

self.bias = self.add_weight(

shape=(self.units,),

initializer='zeros',

trainable=True,

name='bias'

)

def call(self, inputs):

# 定义前向传播逻辑

return self.activation(trae.matmul(inputs, self.kernel) + self.bias)代码解析:

__init__方法中定义了层的超参数(units 和 activation)。build方法根据输入形状创建权重矩阵和偏置向量。call方法实现了矩阵乘法和激活函数应用的前向传播过程。

3.2 自定义层的高级特性

3.2.1 支持多种输入类型

自定义层可以设计为接受多种类型和形状的输入。

示例:支持多个输入的自定义层

python

class MultiInputLayer(trae.keras.layers.Layer):

def __init__(self):

super().__init__()

def build(self, input_shape):

# 假设输入为两个张量

shape1, shape2 = input_shape

self.kernel1 = self.add_weight(

shape=(shape1[-1], 64),

initializer='glorot_uniform',

trainable=True

)

self.kernel2 = self.add_weight(

shape=(shape2[-1], 64),

initializer='glorot_uniform',

trainable=True

)

def call(self, inputs):

# inputs 是一个包含两个张量的列表

input1, input2 = inputs

return trae.concat([

trae.matmul(input1, self.kernel1),

trae.matmul(input2, self.kernel2)

], axis=-1)使用示例:

python

# 构建模型使用多输入层

input1 = trae.keras.Input(shape=(10,))

input2 = trae.keras.Input(shape=(20,))

multi_input_layer = MultiInputLayer()([input1, input2])

output = trae.keras.layers.Dense(1)(multi_input_layer)

model = trae.keras.Model(inputs=[input1, input2], outputs=output)3.2.2 实现自定义梯度

对于需要自定义梯度的计算操作,可以通过 trae.custom_gradient 装饰器实现。

示例:带有自定义梯度的操作

python

@trae.custom_gradient

def custom_activation(x):

# 前向传播

y = trae.tanh(x)

# 自定义反向传播

def grad(dy):

return dy * (1 - y**2)

return y, grad

# 在自定义层中使用

class CustomActivationLayer(trae.keras.layers.Layer):

def call(self, inputs):

return custom_activation(inputs)代码解析:

custom_activation函数定义了前向传播的计算逻辑(tanh 激活)。grad函数定义了反向传播时梯度的计算方式。- 自定义梯度操作可确保数值稳定性和计算效率。

3.3 自定义层开发总结(mermaid)

IV. 预训练层的应用

在实际项目中,使用预训练层可以显著提升模型性能,减少训练成本。

4.1 加载预训练层

Trae 支持从本地文件或在线模型库加载预训练层。

4.1.1 从本地加载预训练权重

示例:加载本地预训练的 Dense 层权重

python

# 构建模型结构

model = trae.keras.Sequential([

trae.keras.layers.Dense(64, activation='relu', input_shape=(20,)),

trae.keras.layers.Dense(32, activation='relu'),

trae.keras.layers.Dense(10, activation='softmax')

])

# 加载本地预训练权重

model.load_weights('pretrained_weights.h5')4.1.2 使用在线预训练模型

通过 TensorFlow Hub 加载预训练模型并作为层使用。

python

import tensorflow_hub as hub

# 加载预训练的 ResNet50 模型作为特征提取器

pretrained_layer = hub.KerasLayer(

"https://tfhub.dev/google/tf2-preview/resnet_50/feature_vector/4",

output_shape=[2048],

trainable=False,

input_shape=[224, 224, 3]

)

# 构建模型

model = trae.keras.Sequential([

pretrained_layer,

trae.keras.layers.Dense(1024, activation='relu'),

trae.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])4.2 预训练层的微调

微调(Fine-tuning)是指在新数据集上进一步训练预训练模型,以适应特定任务。

示例:微调预训练层

python

# 解冻预训练层的部分层进行微调

pretrained_layer.trainable = True

# 通常只微调最后几层

for layer in pretrained_layer.layers[:-4]:

layer.trainable = False

# 重新编译模型

model.compile(

optimizer=trae.keras.optimizers.Adam(1e-5), # 使用较低的学习率

loss='categorical_crossentropy',

metrics=['accuracy']

)

# 继续训练

model.fit(X_train, y_train, epochs=5, validation_split=0.2)代码解析:

- 将预训练层设置为可训练(

trainable=True)。 - 通过索引限制只微调最后几层,保留早期层的通用特征提取能力。

- 使用较低的学习率避免破坏预训练层已学习到的特征。

4.3 预训练层的应用总结(mermaid)

V. 参数管理技巧

高效的参数管理是构建和优化模型的关键环节,影响模型的性能、内存占用和训练效率。

5.1 参数共享

在某些场景下,我们希望多个层共享相同的参数,这在自然语言处理中的嵌入层中较为常见。

示例:实现参数共享

python

# 创建一个共享的 Dense 层

shared_layer = trae.keras.layers.Dense(64, activation='relu')

# 构建模型,多个位置使用共享层

model = trae.keras.Sequential([

trae.keras.layers.Input(shape=(20,)),

shared_layer,

trae.keras.layers.Dense(32, activation='relu'),

shared_layer, # 再次使用共享层

trae.keras.layers.Dense(10, activation='softmax')

])

# 打印模型参数,观察共享层的权重是否重复计算

model.summary()注意:参数共享要求共享层的输入形状一致,否则会导致维度不匹配错误。

5.2 参数冻结与解冻

在迁移学习中,经常需要冻结部分层的参数,防止其在训练过程中更新。

示例:冻结和解冻层参数

python

# 冻结模型中所有层的参数

for layer in model.layers:

layer.trainable = False

# 解冻最后两层,允许参数更新

for layer in model.layers[-2:]:

layer.trainable = True

# 查看各层的可训练状态

for layer in model.layers:

print(f"Layer {layer.name} trainable: {layer.trainable}")5.3 参数管理的高级技巧

5.3.1 使用约束和正则化

通过在层中添加约束和正则化项,控制参数的取值范围和复杂度。

示例:应用权重约束和正则化

python

# 添加 L2 正则化和最大范数约束

regularizer = trae.keras.regularizers.l2(0.01)

constraint = trae.keras.constraints.MaxNorm(max_value=2, axis=0)

model = trae.keras.Sequential([

trae.keras.layers.Dense(

64,

activation='relu',

kernel_regularizer=regularizer,

kernel_constraint=constraint,

input_shape=(20,)

),

trae.keras.layers.Dense(10, activation='softmax')

])

# 编译模型时,正则化损失会自动加入总损失函数

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])代码解析:

kernel_regularizer添加了 L2 正则化项,惩罚权重的较大取值。kernel_constraint施加了最大范数约束,限制权重的更新范围。- 正则化损失会在编译模型时自动与主损失函数结合。

5.3.2 动态参数管理

在某些动态模型中,参数可能依赖于输入数据或训练状态,需要动态管理。

示例:动态参数管理

python

class DynamicParameterLayer(trae.keras.layers.Layer):

def __init__(self):

super().__init__()

def build(self, input_shape):

# 创建一个动态参数,形状依赖于输入

self.dynamic_weight = self.add_weight(

shape=(input_shape[-1], input_shape[-1]),

initializer='glorot_uniform',

trainable=True

)

def call(self, inputs):

# 动态计算,使用输入相关的参数

return trae.matmul(inputs, self.dynamic_weight)代码解析:

build方法中的参数创建依赖于输入形状,使其能够适应不同输入维度。- 动态参数管理在构建自适应模型时非常有用,例如在元学习或条件计算场景中。

5.4 参数管理技巧总结(mermaid)

VI. 实战案例:构建图像分类模型

将前面讲解的 Layer 抽象和参数管理技巧应用于实际项目,构建一个图像分类模型。

6.1 数据准备

使用 CIFAR-10 数据集进行图像分类任务。

python

# 加载 CIFAR-10 数据集

from tensorflow.keras.datasets import cifar10

(X_train, y_train), (X_test, y_test) = cifar10.load_data()

# 数据预处理

X_train, X_test = X_train / 255.0, X_test / 255.0

y_train = trae.keras.utils.to_categorical(y_train, 10)

y_test = trae.keras.utils.to_categorical(y_test, 10)6.2 模型构建

结合标准层、自定义层和预训练层构建模型。

python

# 定义一个自定义卷积块

class ConvBlock(trae.keras.layers.Layer):

def __init__(self, filters, kernel_size):

super().__init__()

self.conv = trae.keras.layers.Conv2D(filters, kernel_size, padding='same')

self.bn = trae.keras.layers.BatchNormalization()

self.activation = trae.keras.layers.ReLU()

def call(self, inputs):

x = self.conv(inputs)

x = self.bn(x)

return self.activation(x)

# 构建模型

model = trae.keras.Sequential([

trae.keras.layers.Input(shape=(32, 32, 3)),

ConvBlock(32, (3, 3)), # 自定义卷积块

trae.keras.layers.MaxPooling2D((2, 2)),

ConvBlock(64, (3, 3)),

trae.keras.layers.MaxPooling2D((2, 2)),

trae.keras.layers.Flatten(),

trae.keras.layers.Dense(128, activation='relu'),

trae.keras.layers.Dropout(0.5),

trae.keras.layers.Dense(10, activation='softmax')

])

# 加载预训练权重(如果有)

# model.load_weights('pretrained_weights.h5')

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])6.3 模型训练与评估

训练模型并评估其性能。

python

# 训练模型

history = model.fit(

X_train, y_train,

epochs=50,

batch_size=64,

validation_split=0.2

)

# 评估模型

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f"Test accuracy: {test_acc:.4f}")6.4 模型优化

通过调整参数管理策略优化模型。

python

# 冻结部分层进行微调

for layer in model.layers[:4]:

layer.trainable = False

# 使用学习率衰减优化训练

initial_lr = 0.001

lr_schedule = trae.keras.optimizers.schedules.ExponentialDecay(

initial_lr,

decay_steps=10000,

decay_rate=0.96,

staircase=True

)

optimizer = trae.keras.optimizers.Adam(learning_rate=lr_schedule)

# 重新编译并继续训练

model.compile(optimizer=optimizer, loss='categorical_crossentropy', metrics=['accuracy'])

model.fit(

X_train, y_train,

epochs=20,

batch_size=64,

validation_split=0.2

)