前段时间我在服务器上的虚拟环境全部都没了,只能重新创建环境然后装包,正好也做一个记录,以防以后我又要装环境。以下过程是在Linux服务器上进行的,如果是Windows环境,可能会有些许差异。

一、创建并激活虚拟环境

首先,使用 conda 创建一个独立的虚拟环境,我使用的是3.10的Python版本,但不一定非要这个版本。

conda create --name stable_diffusion_env python=3.10创建完成后,激活该环境:

conda activate stable_diffusion_env二、安装核心依赖包

执行以下命令安装 Stable Diffusion 所需的核心依赖库:

pip install diffusers transformers accelerate safetensors ftfy经过漫长的下载后,会得到这么一大段信息:

python

Successfully installed

MarkupSafe-3.0.2

Pillow-11.3.0

accelerate-1.10.0

certifi-2025.8.3

charset_normalizer-3.4.3

diffusers-0.34.0

filelock-3.18.0

fsspec-2025.7.0

ftfy-6.3.1

hf-xet-1.1.7

huggingface-hub-0.34.4

idna-3.10

importlib_metadata-8.7.0

jinja2-3.1.6

mpmath-1.3.0

networkx-3.4.2

numpy-2.2.6

nvidia-cublas-cu12-12.4.5.8

nvidia-cuda-cupti-cu12-12.4.127

nvidia-cuda-nvrtc-cu12-12.4.127

nvidia-cuda-runtime-cu12-12.4.127

nvidia-cudnn-cu12-9.1.0.70

nvidia-cufft-cu12-11.2.1.3

nvidia-curand-cu12-10.3.5.147

nvidia-cusolver-cu12-11.6.1.9

nvidia-cusparse-cu12-12.3.1.170

nvidia-cusparselt-cu12-0.6.2

nvidia-nccl-cu12-2.21.5

nvidia-nvjitlink-cu12-12.4.127

nvidia-nvtx-cu12-12.4.127

packaging-25.0

psutil-7.0.0

pyyaml-6.0.2

regex-2025.7.34

requests-2.32.4

safetensors-0.6.2

sympy-1.13.1

tokenizers-0.21.4

torch-2.6.0

tqdm-4.67.1

transformers-4.55.0

triton-3.2.0

typing-extensions-4.14.1

urllib3-2.5.0

wcwidth-0.2.13

zipp-3.23.0这也是为什么我二话不说,啥环境都没有的情况下,直接就pip install diffusers transformers accelerate safetensors ftfy,因为他会自动安装其他的依赖包,包括Pytorch- GPU,省去很多时间。但似乎Windows环境不会自动下载Pytorch- GPU,需要自己下载对应的Pytorch- GPU版本,我的是2.6.0+cu124。

三、安装额外依赖库

随后还有一些其他的漏网之鱼需要安装

1、安装 PEFT(参数高效微调库):

python

pip install peft安装成功提示:

python

Successfully installed peft-0.17.02、遇到的报错1:

python

ImportError: requires the protobuf library but it was not found这是表示加载 T5 等模型的 tokenizer 时需要 protobuf 库(用于处理协议缓冲区数据),但当前环境中未安装。

解决方法:

pip install protobuf成功提示:

python

Successfully installed protobuf-6.31.13、遇到的报错2:

python

ValueError: Cannot instantiate this tokenizer from a slow version...这是表示部分 tokenizer 依赖 sentencepiece 库(用于分词处理),缺少该库会导致初始化失败。

解决方法:

pip install sentencepiece成功提示:

python

Successfully installed sentencepiece-0.2.14、安装其他必要库:

python

pip install torchvision # 用于处理图像数据

pip install datasets # 用于加载和处理HuggingFace的数据集四、Hugging Face 认证配置

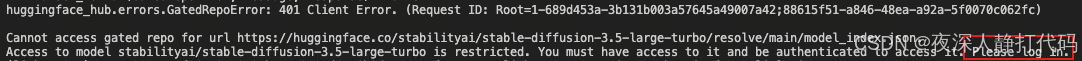

为了访问 Hugging Face 上的模型和数据集,需要进行认证(先在hugingface上申请访问令牌,然后复制到终端),否则被拒绝访问:

在终端输入:

python

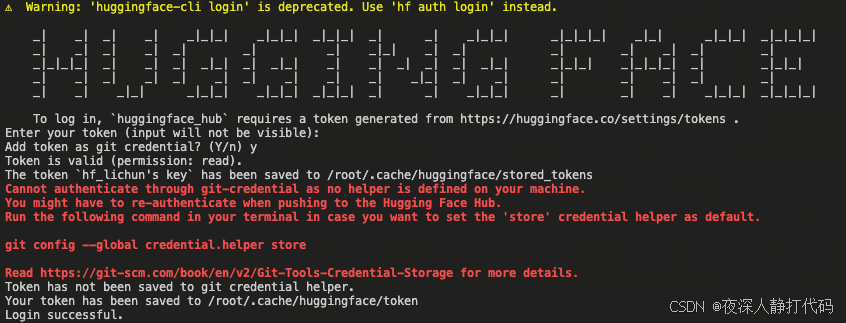

huggingface-cli login

会提示你输入访问令牌(输入令牌的时候,终端是看不见的,输入后回车就行):

python

hf_rv********************Oq他还提示 Warning: 'huggingface-cli login' is deprecated. Use 'hf auth login' instead.,意思是说huggingface-cli login已经被弃用了,使用hf auth login进行登陆。

登录成功后,就可以访问huggingface进行模型权重的下载了。

五、加速下载配置(可选)

如果遇到下载速度缓慢的问题,可以配置代理加速:

python

export http_proxy=http://

export https_proxy=http://

export HTTP_PROXY=http://

export HTTPS_PROXY=http://完成以上所有步骤后,Stable Diffusion 模型的运行环境就配置完毕,可以开始进行模型推理和训练工作了。整个过程还是比较简单的,没有遇到啥问题,我又可以进行推理和微调训练了。后续如果有机会,会出一个LoRA微调的实战分享吧。