1.前言

中药信息的发展是一个跨越数千年的演进过程,它不仅反映了中医药学自身的理论体系构建,也体现了人类记录、传播和利用知识方式的变革。从原始社会的口耳相传,到甲骨金石的刻画,再到纸张印刷的普及,直至现代的数字化技术,每一种信息载体的革新都推动了中医药知识的积累与传播。

我这里也有一个中药信息发展时间

然而据广州调查显示,近90%小学生对中医药"一问三不知",仅知"针灸""凉茶"等概念,无法辨识决明子等常用药材。

北京中医药大学调查指出,青少年普遍缺乏中药基础知识。之前也给大家介绍过一个关于中药的文本+图片的工作流,dify案例分享-手把手教你用 Dify 搭建中药科普工作流,小白也能轻松上手!

当时制作的时候时间仓促没有做短视频版本,后面我们基于这个题材也做过一个基于dify版本,在实际使用过程中发现很多限制条件。

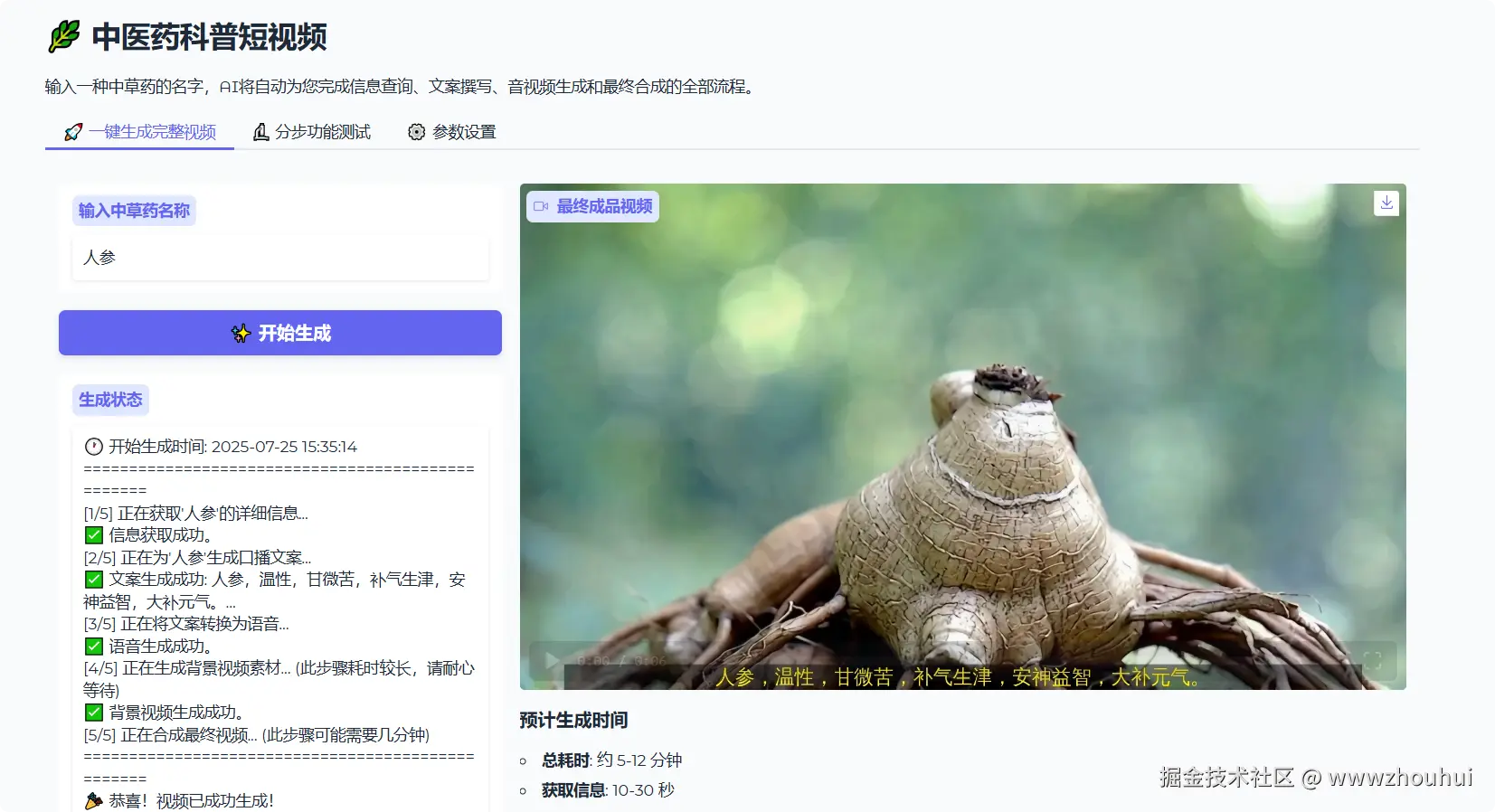

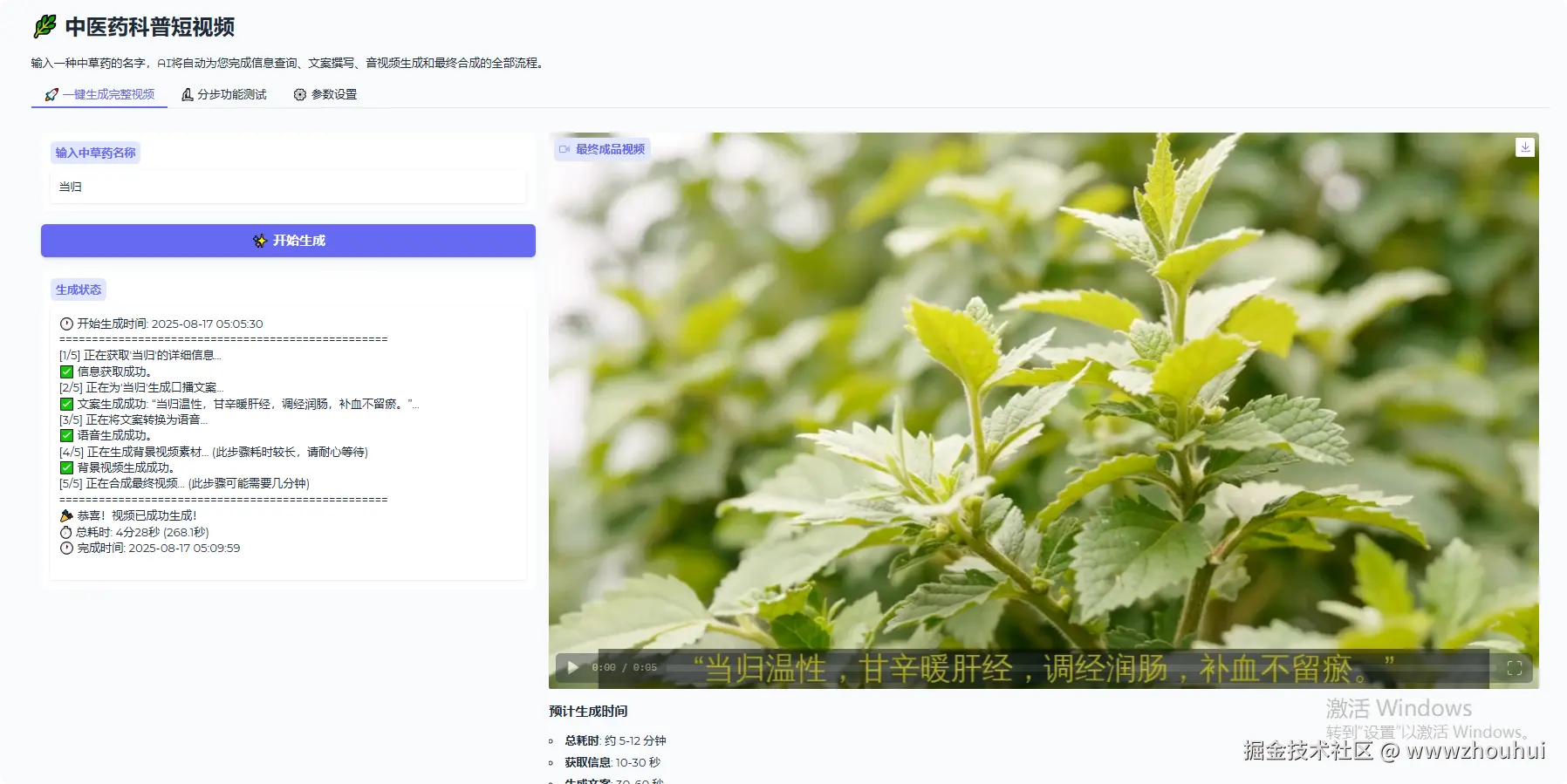

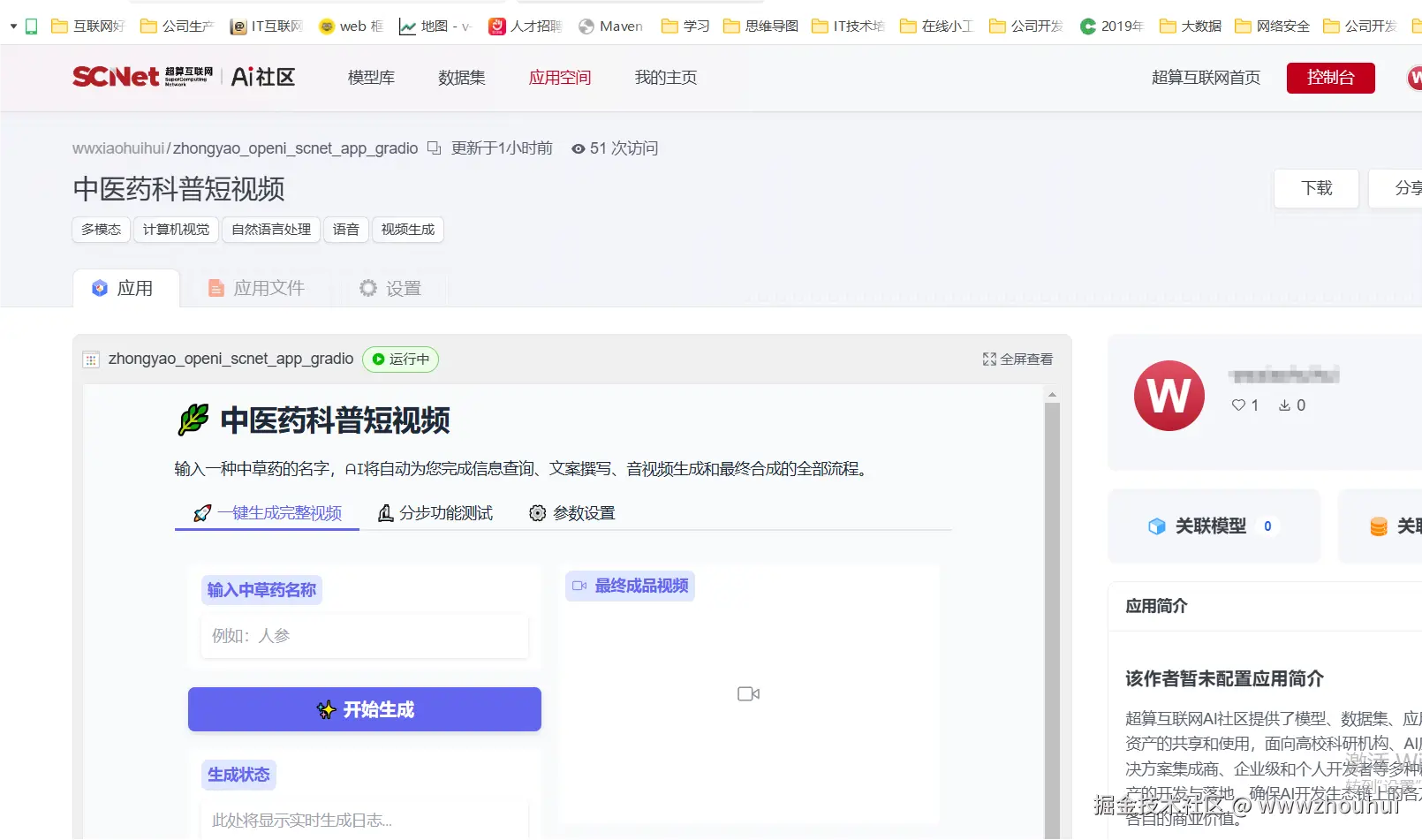

很有兴看到了OpenI x SCNet "智能超算"创新应用挑战赛,觉的这个比赛不错刚好可以借助这个比赛来打磨我这个项目,让更多人了解中医药这些我们平时能用到但是又不太了解的小知识。那么这个项目的应用的效果是什么样子的呢?我们看下面的图。

我们也可以生成的视频下载下来观看。

视频号

那么这样的中药科普短视频是如何制作的呢?下面带大家来做制作一下。

2.项目和模型介绍

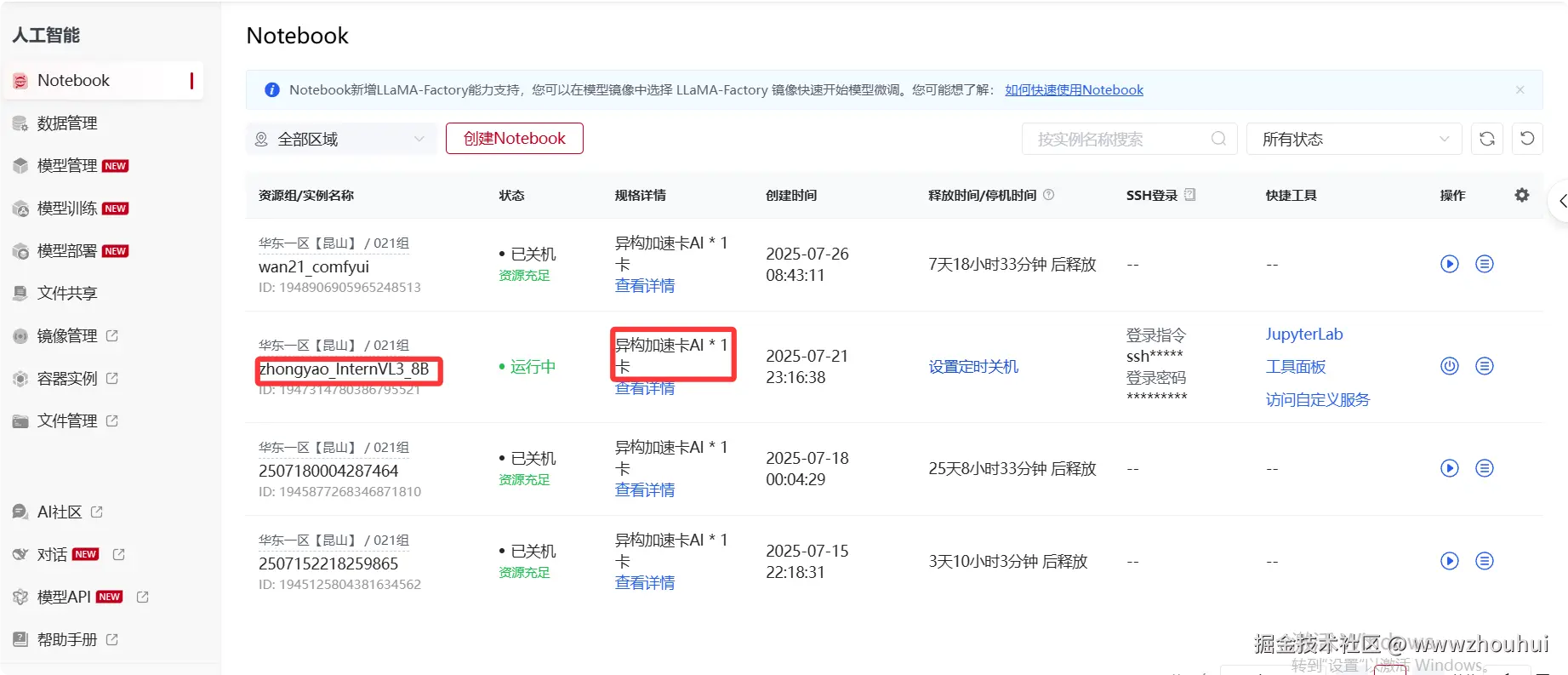

首选我们需要给大家减少一下项目的背景,本项目主要是基于启智社区联合联合超算互联网举办的"超算智能"创新应用挑战赛。

详细内容大家可以看这里滚烫热辣,燃情一夏!OpenI x SCNet "智能超算"创新应用挑战赛陪你放暑假!

我这个项目也是基于比赛提供的新一代国产异构加速卡AI,显存64GB。兼容CUDA 所以在文本模型推理和部署这块几乎没有遇到困难。直接在比赛提供国产显卡推理环境中实现模型的推理。

文本模型介绍

文本模型这块我们使用了上海人工智能实验室2025年1月15日推出的书生浦语internlm3-8b-instruct 模型。这个模型我平时用的比较多,主要是模型比较简单,另外速度非常快。模型这里我们可以在超算互联网模型管理提前下载好。

上面图显示模型来源AI社区,可以在社区找到同步过来就可以了,速度也是非常快。

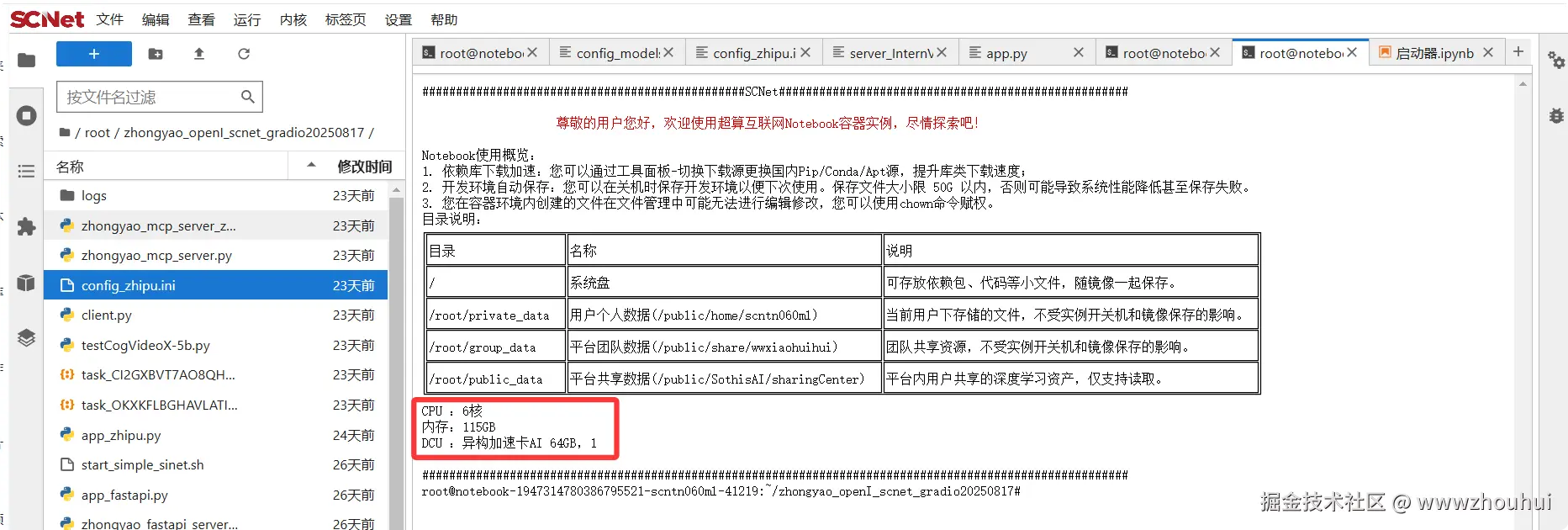

在平台提供notebook 管理界面里面我们可以把模型同步到下面目录

shell

/private_data/SothisAI/model/Aihub/InternVL3-8B/main/InternVL3-8B

文生图模型

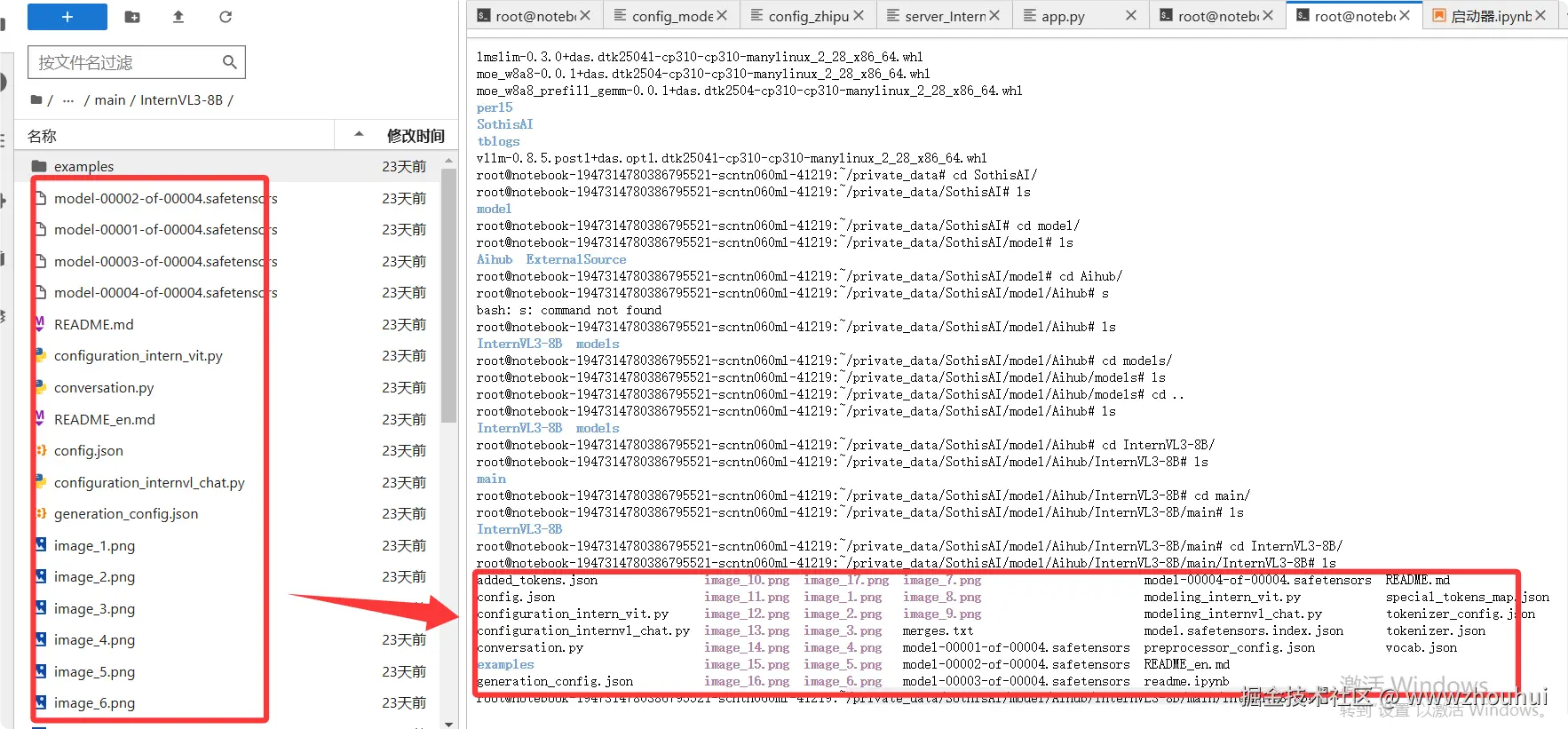

文生图模型我们使用是阿里通义千问2025 年 8 月 5 日推出的Qwen-Image模型。这个模型生图效果非常好,它是开源模型。我们可以在魔搭社区上面找到并体验这个模型。目前魔搭社区刚好提供了免费API接口,那么我们就刚好可以借用这个免费的API 接口来实现这个文生图功能。

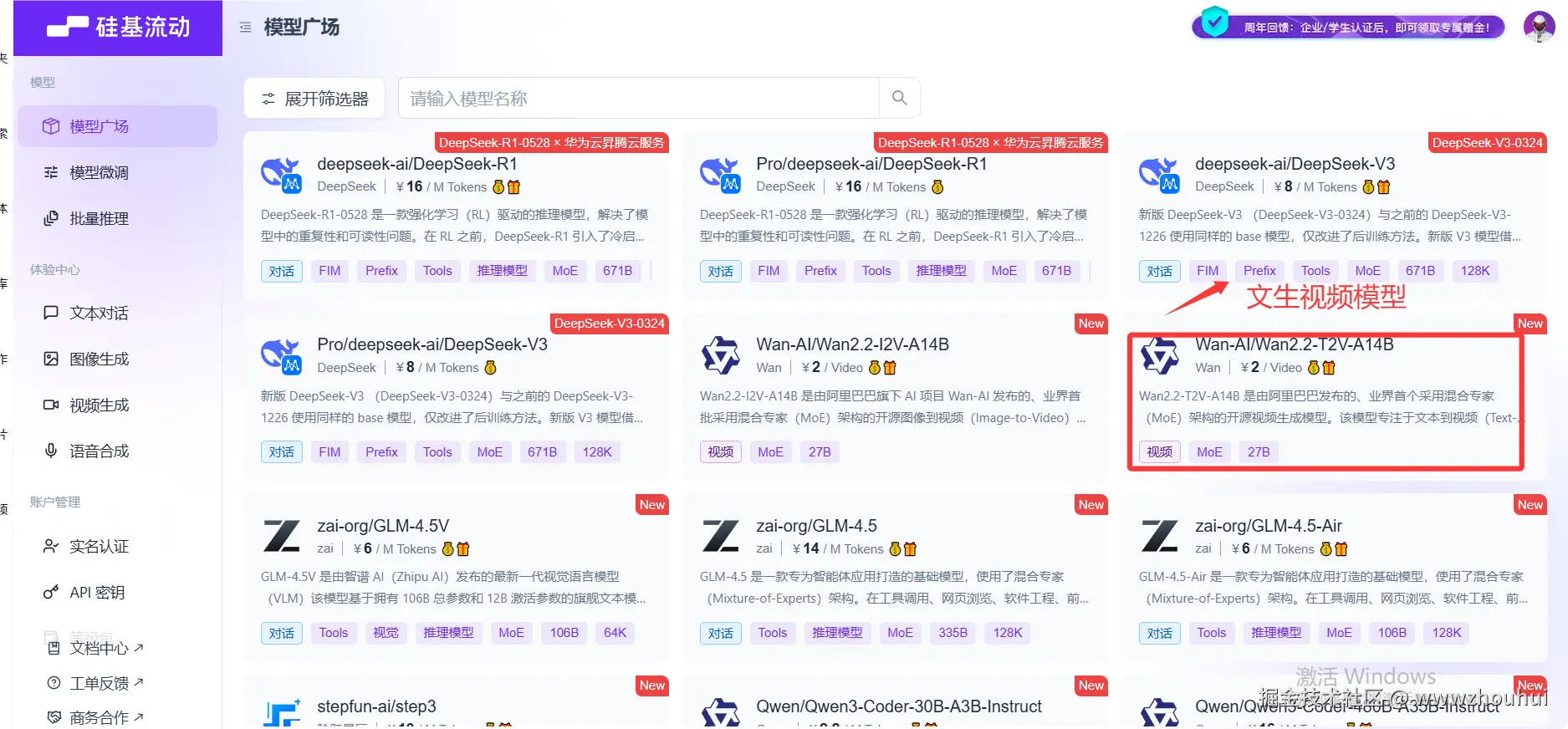

文生视频模型

文生视频模型这里我们也用阿里通义万象提供开源的Wan2.2-T2V-A14B模型。这个模型的发布时间是2025 年 7 月 28 日。文生视频效果也非常好。我在魔搭平台上只找到了模型体验地址没有对外提供免费API 接口。前几天硅基流动刚好上线了这个新的文生视频模型。

TTS模型

文本生成语音模型目前市面上也非常多。硅基流动、火山引擎、阿里白炼、gitee等平台上都有相关文本生成语音模型。我这里考虑速度和免费这里用到了edgetts ,这个项目我之前做成一个标准的API 接口,我其他项目也可以使用,所以我这里就用这个API接口来实现文本生成语音的功能。开源项目地址github.com/rany2/edge-...

以上我们就简单梳理了一下该项目中用到的模型。下面我们用一个表格来展示这个模型的特点。

| 模型名称 | 核心特点 | 开源时间 | 费用价格 | 优点 | 缺点 |

|---|---|---|---|---|---|

| 书生浦语 internlm3-8b-instruct | 轻量级多模态模型,支持多轮对话与深度思考模式,80 亿参数实现实时交互,综合性能超越同量级开源模型 | 2025 年 1 月 15 日 | 开源免费(Apache 2.0 协议,允许商业使用),支持本地部署 | 轻量快速(消费级显卡即可运行)、支持多语言、可通过 system prompt 切换对话 / 思考模式 | 参数规模较小,复杂推理任务能力弱于大模型,数学运算准确率约 80% |

| Qwen-Image | 200 亿参数文生图模型,支持复杂文本渲染与精准编辑,采用 MMDiT 架构,中文长文本渲染准确率达 96.7 | 2025 年 8 月 5 日 | 开源免费(Apache 2.0 协议),魔搭社区提供免费 API(公测期间每日 2000 次调用) | 开源可商用、生图效果媲美专业工具,支持多语言混合提示词 | 需较高显存(建议 12GB 以上),生成速度较慢(单图约 30 秒),API 调用有频率限制 |

| Wan2.2-T2V-A14B | 270 亿参数文生视频模型,首创 MoE 架构与电影美学控制系统,支持 60 + 专业影视参数控制,5 秒 720P 视频生成显存需求 22GB | 2025 年 7 月 28 日 | 开源免费(Apache 2.0 协议),需自行部署或使用付费 API(如硅基流动) | 电影级光影 / 色彩控制、支持复杂运动与多人物交互,5B 版本可在 RTX 4090 运行 | 生成视频长度限制 5 秒,硬件要求高(旗舰版需 A100 显卡),无免费 API 接口 |

| EdgeTTS | 轻量级 TTS 解决方案,基于微软 Edge 浏览器语音引擎,支持多语言合成,提供标准化 API 接口 | 2023 年 3 月(GitHub 创建) | 开源免费(MIT 协议),依赖微软 TTS 服务(无直接费用但可能存在调用限制) | 免费轻量、支持实时合成、可自定义语音风格,适配多平台开发 | 语音自然度一般(尤其中文),依赖外部 API 稳定性,生成音频时长有限制 |

3 项目开发介绍

本项目一个基于 AI 技术的自动化工具,旨在快速生成关于中医药知识的科普短视频。用户只需输入一种中草药的名称,系统便能自动完成信息检索、文案撰写、语音合成、视频素材生成以及最终的视频合成,整个过程一键完成。

✨ 核心功能

- 一键式视频生成: 输入药材名,全自动输出包含解说、字幕和背景视频的成品。

- 分步功能测试 : 为开发者和高级用户提供独立的素材生成工具,包括:

- 获取药材详细信息 (JSON格式)

- AI 生成药材高清图片

- AI 生成相关背景视频 (无声)

- 将文本转换为语音 (TTS)

- 动态参数配置: 提供 Web UI 界面,允许用户在运行时动态修改和应用各项服务(如API密钥、模型名称、文件路径等),无需重启程序。

- 多 AI 服务集成: 支持多种 AI 服务提供商,包括自定义文本模型(internlm3-8b)、魔搭社区、硅基流动等。

- 跨平台支持: 提供针对 Windows 和 Linux 系统的详细配置和安装指导。

🛠️ 技术栈

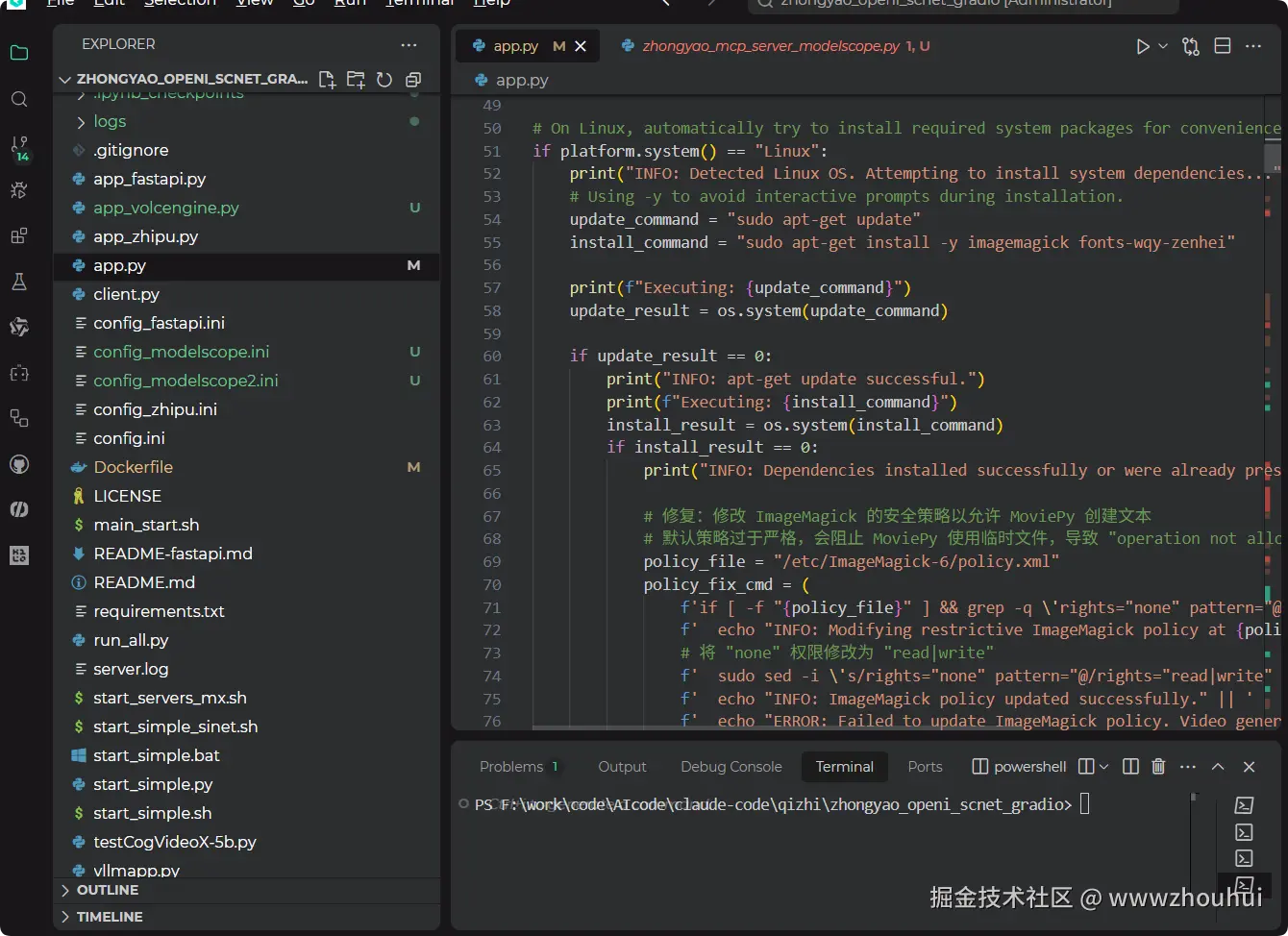

- 应用框架 : Gradio Web界面 (

app.py) - 集成后端逻辑 : 所有后端功能(MCP工具、API调用、视频处理)均集成在

zhongyao_mcp_server.py中,并由Gradio应用直接调用。 - AI 模型接口 :

- 语言模型 : 外部本地 VLLM 服务(通过

chat_api配置连接) - 文生图 : 魔搭社区 (modelscope) API (

Qwen-Image模型) - 文生视频 :硅基流动 (SiliconFlow) API (`Wan2.2-T2V-A14B 模型)

- 语音合成 (TTS): Edge-TTS API

- 语言模型 : 外部本地 VLLM 服务(通过

- 视频处理: MoviePy, FFmpeg

- 外部依赖: ImageMagick (用于字幕生成)

- 对象存储: 腾讯云 COS (用于存储生成的音视频文件)

🏗️ 系统架构

本应用采用一体化架构,Gradio 应用直接集成了所有后端逻辑。

scss

┌───────────────────────────────────────────┐

│ app.py (Gradio 应用) │

│ ┌───────────────────────────────────────┐ │

│ │ UI界面 & 交互逻辑 (Gradio) │ │

│ └───────────────────────────────────────┘ │

│ ┌───────────────────────────────────────┐ │

│ │ 集成后端 (zhongyao_mcp_server.py) │ │

│ │ - AI工具函数 (文案、图片、视频、音频) │ │

│ │ - 视频合成 (MoviePy) │ │

│ │ - 配置管理 │ │

│ └───────────────────────────────────────┘ │

└────────────────────┬────────────────────┘

│

┌────────────┴───────────┐

│ 外部API / 服务调用 │

▼ ▼

┌───────────────┐ ┌───────────────┐

│ 本地VLLM 服务 │ │ 硅基流动 API │

│ (文本生成) │ │ (文生视频) │

└───────────────┘ └───────────────┘

▼ ▼

┌───────────────┐ ┌───────────────┐

│ 魔搭社区 API │ │ Edge-TTS API │

│ (文生图) │ │ (语音合成) │

└───────────────┘ └───────────────┘核心组件说明:

-

Gradio 应用 (

app.py):- 作为项目唯一入口,提供完整的用户交互界面。

- 直接导入并调用

zhongyao_mcp_server.py中的函数来执行所有后端任务。 - 内置"一键生成"、"分步测试"和"参数设置"三大功能模块。

- 在Linux环境下会尝试自动安装

imagemagick等系统依赖。

-

集成后端 (

zhongyao_mcp_server.py):- 定义了所有核心AI能力函数,如

get_chinese_herb_info,get_chinese_herb_image,get_chinese_herb_video等。 - 管理对外部AI服务(魔搭、硅基流动、VLLM、TTS)的API请求。

- 使用

moviepy库执行视频和音频的下载、处理与合成。 - 负责加载

config.ini配置文件,并支持通过UI进行运行时热更新。

- 定义了所有核心AI能力函数,如

-

外部AI服务:

- 智普AI: 主要用于文生视频。

- 硅基流动: 主要用于文生图。

- 本地VLLM服务: (需单独运行) 用于生成中药信息和口播文案。

- Edge-TTS: 用于文本转语音。

项目结构和代码

4 部署和发布

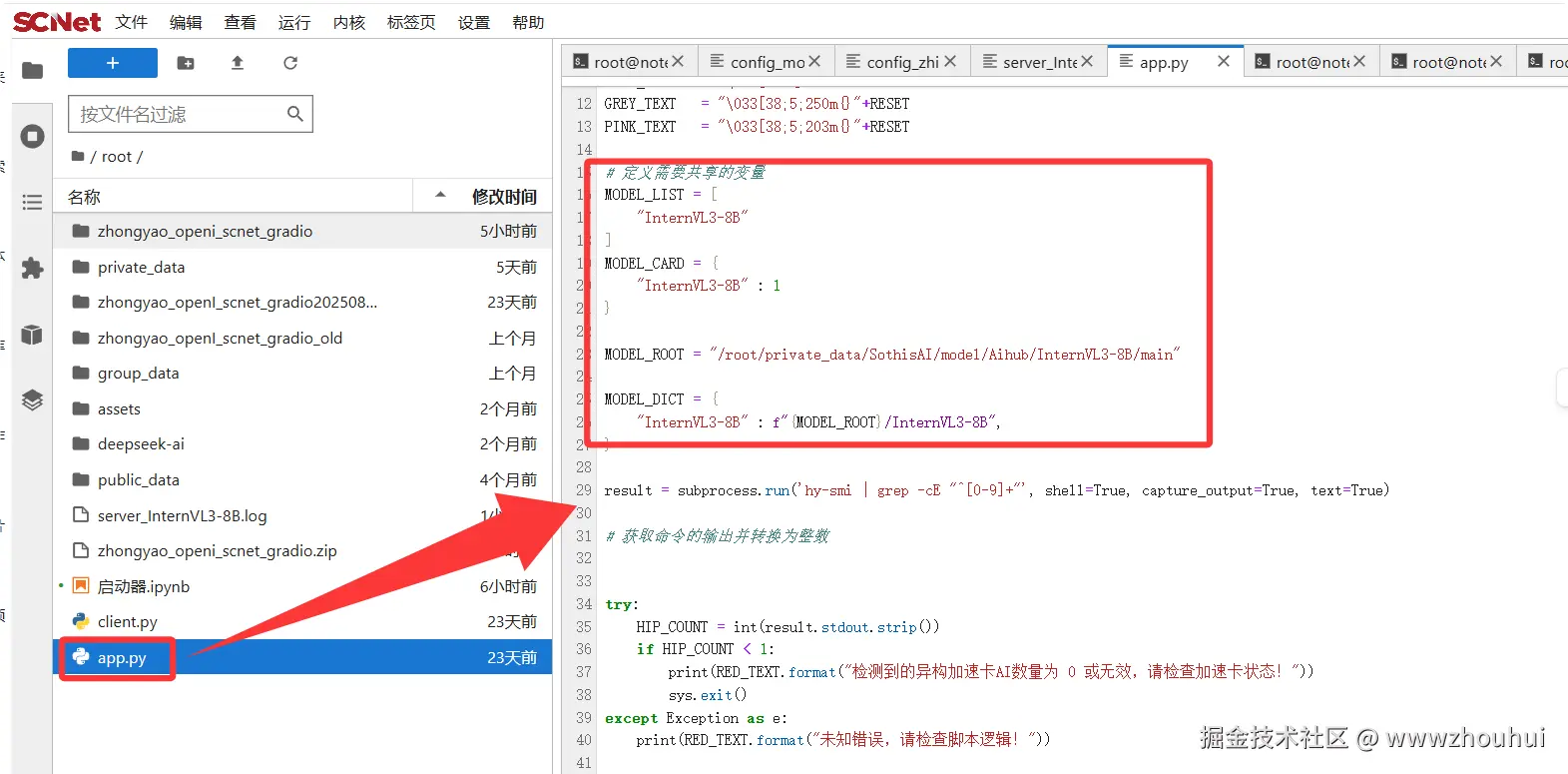

文本模型部署

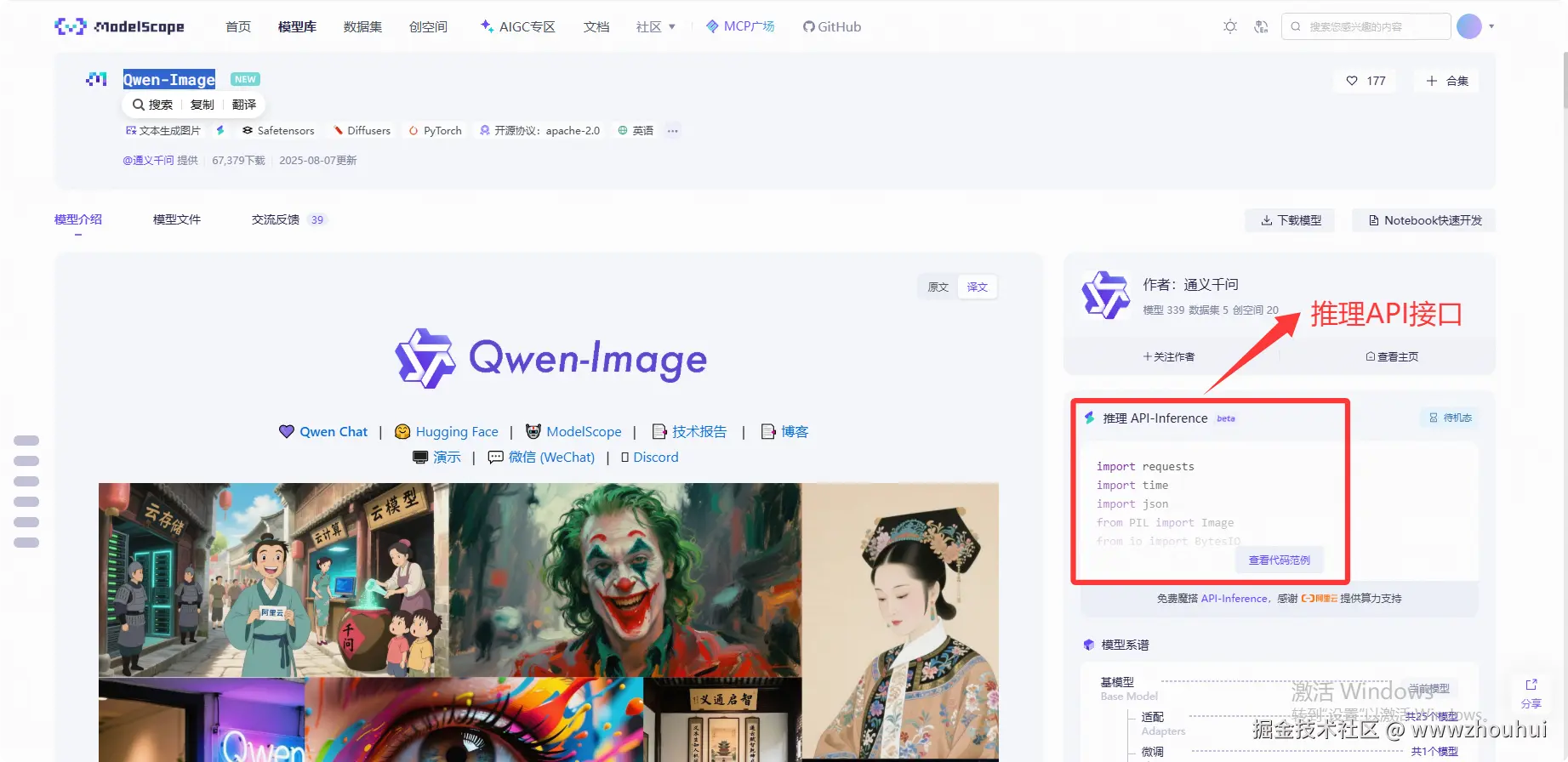

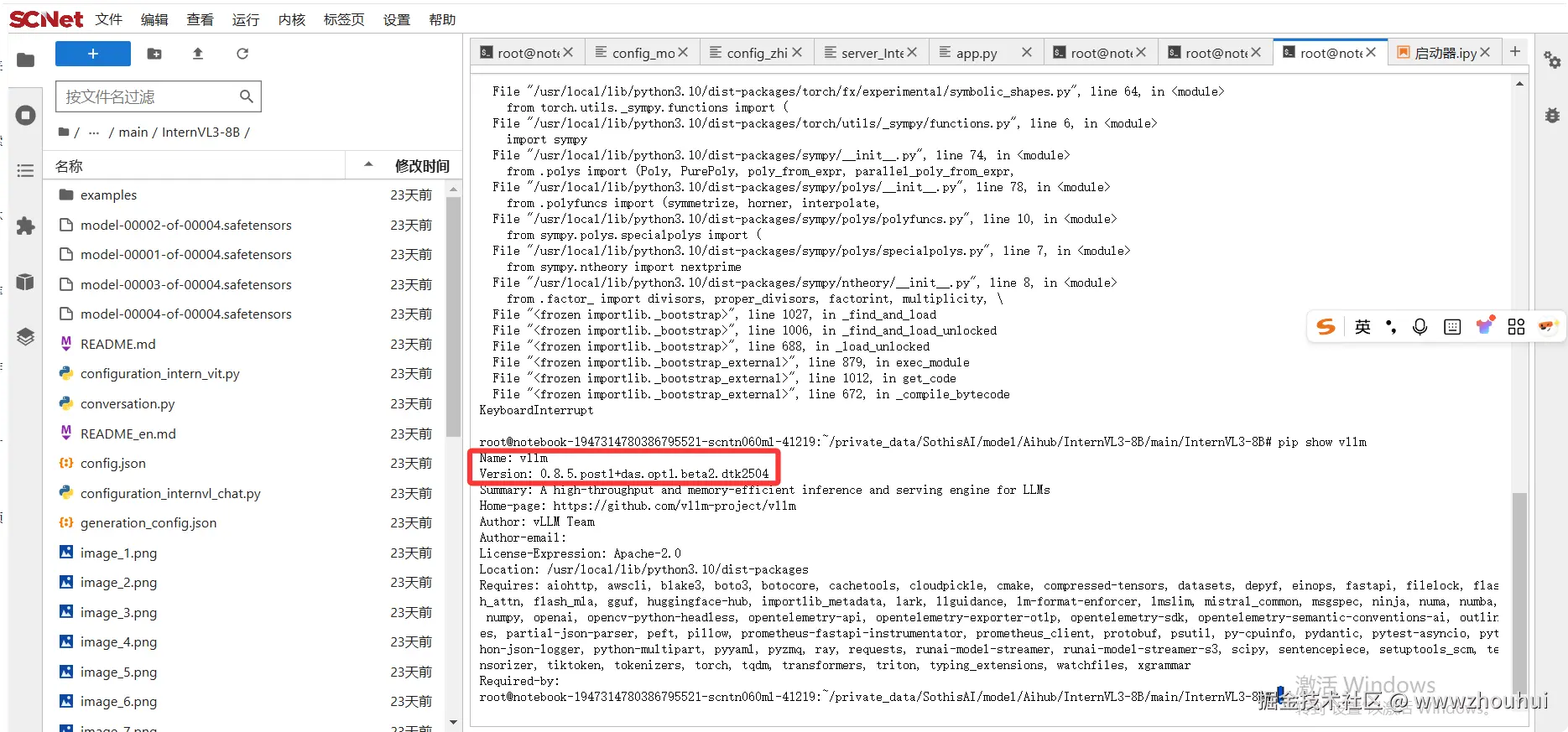

这里我们需要用到国产异构加速卡AI 来部署InternVL3-8B 模型对外提供标准api 接口,推理框架我们使用vllm框架。

这里我们用到平台提供的 jupyterlab-deepseek-r1-0528-qwen3-8b-api 镜像,这个镜像本身就自带比较新vllm框架,不需要我们自己安装了。(非常省心)

我们进入nodebook里面查看一下 VLLM 版本

shell

pip show vllm

模型推理这里我们修改了一下app.py(原来的是deepseek-r1-0528-qwen3-8b)我们把它换成InternVL3-8B模型,如果你不想改模型直接用deepseek-r1-0528-qwen3-8b 也是可以的。

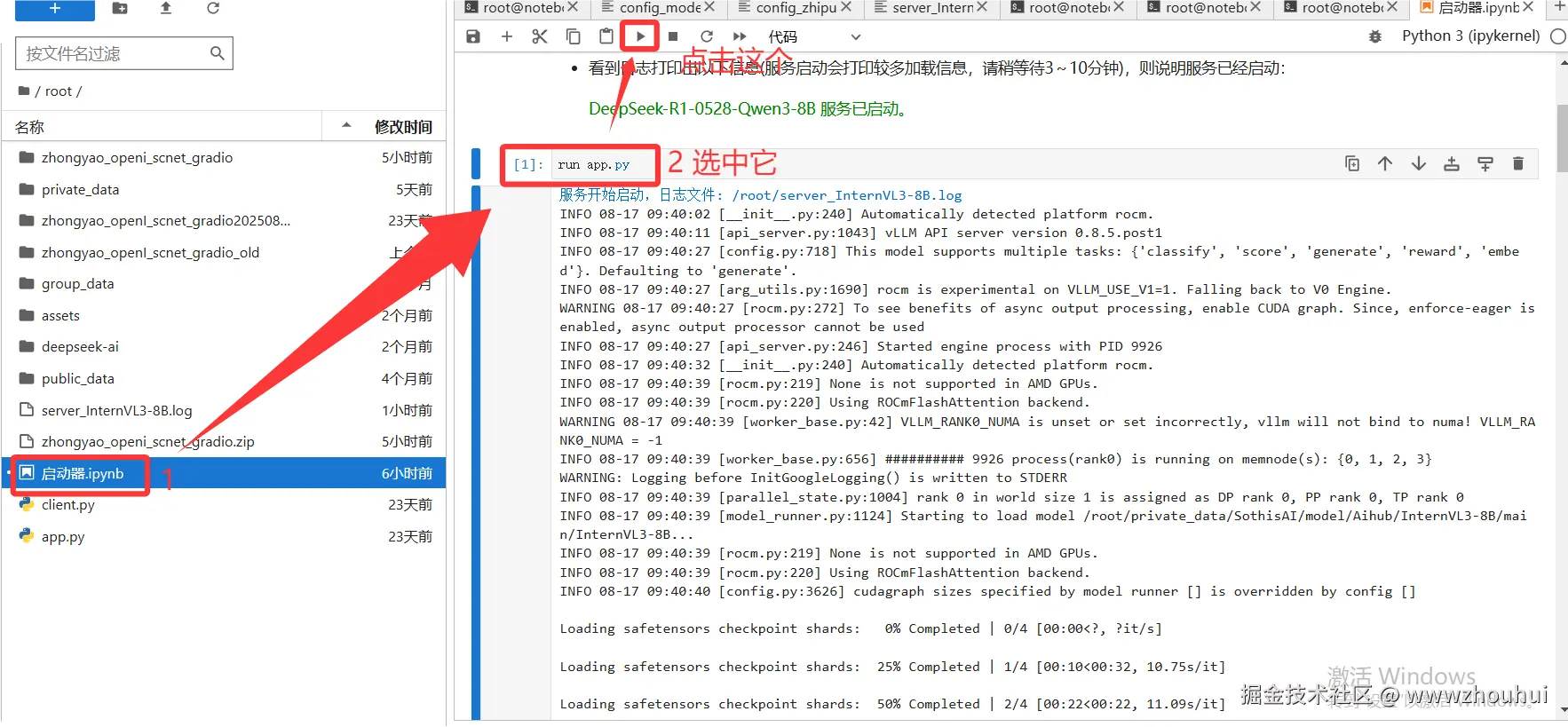

启动代码,我们直接点击启动器.ipynb就可以实现模型接口服务启动了。

启动完成后,我们就可以看到模型推理接口启动了。

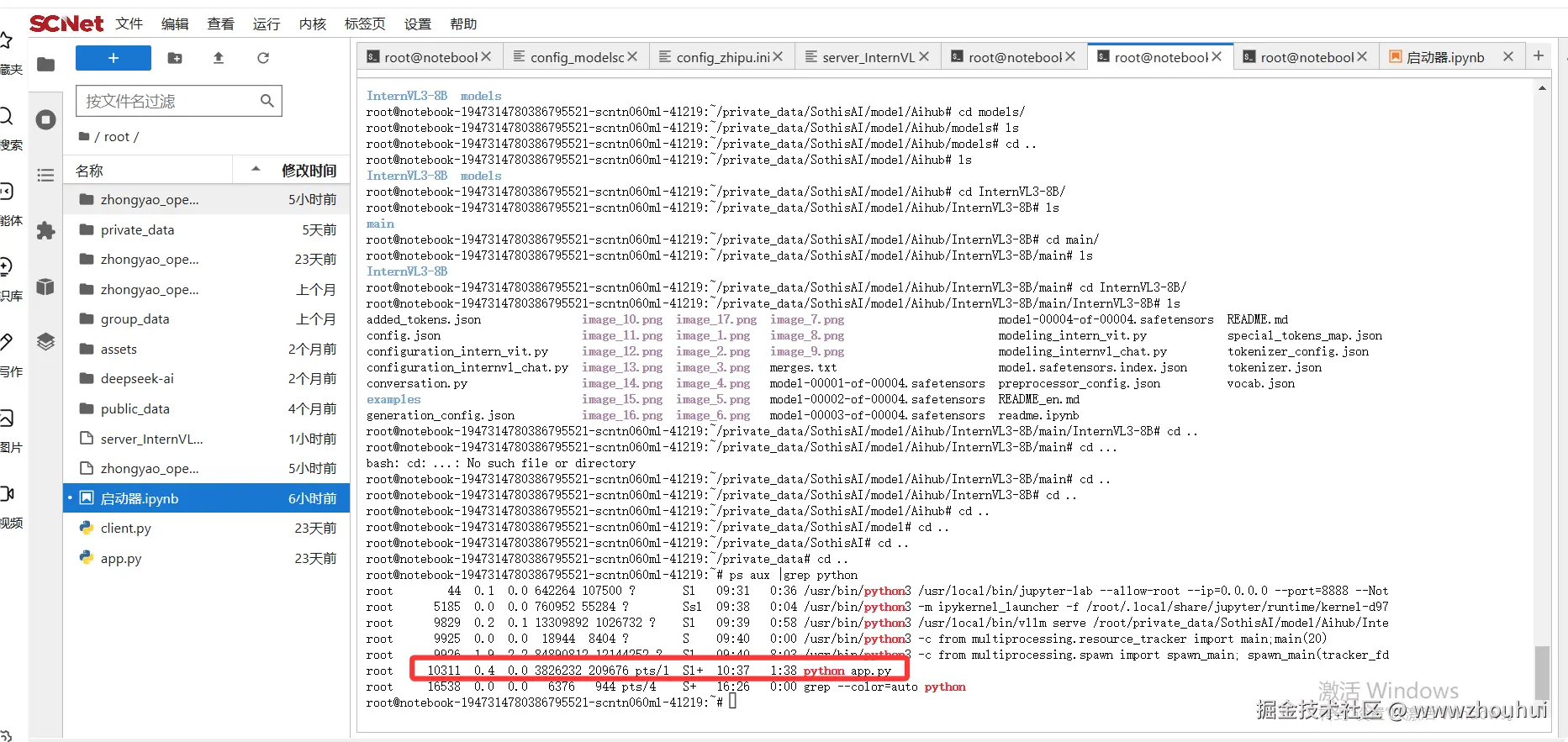

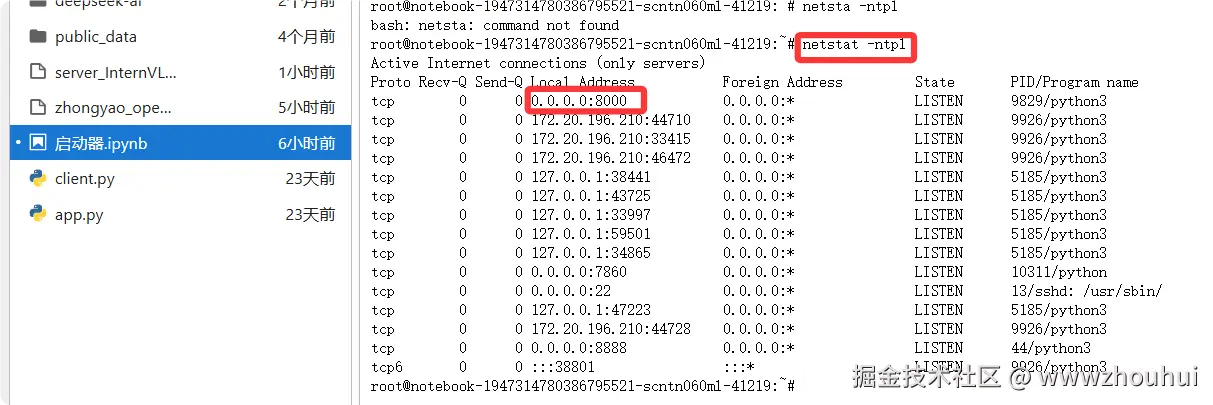

如果不放心也可以在控制台查看启动进程和端口号

perl

ps aux |grep python

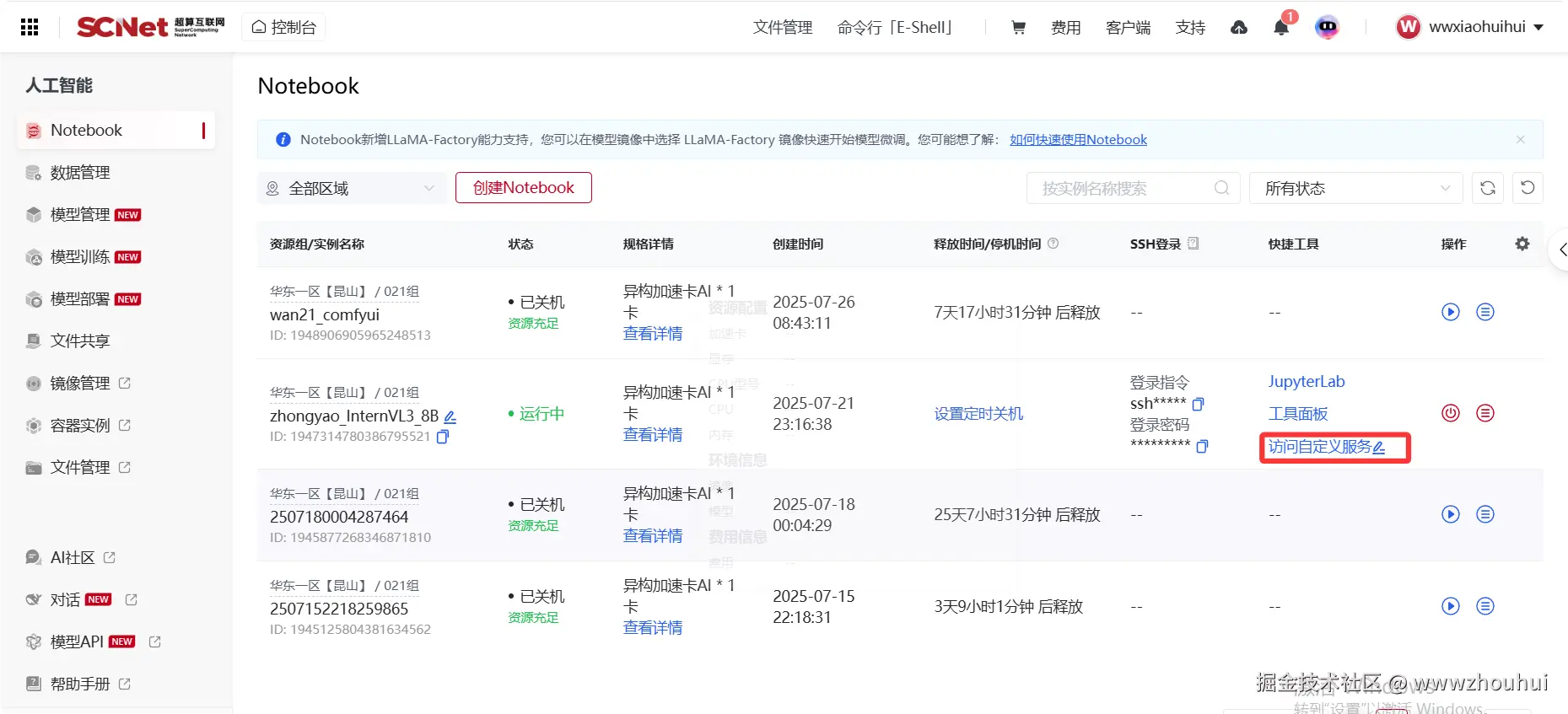

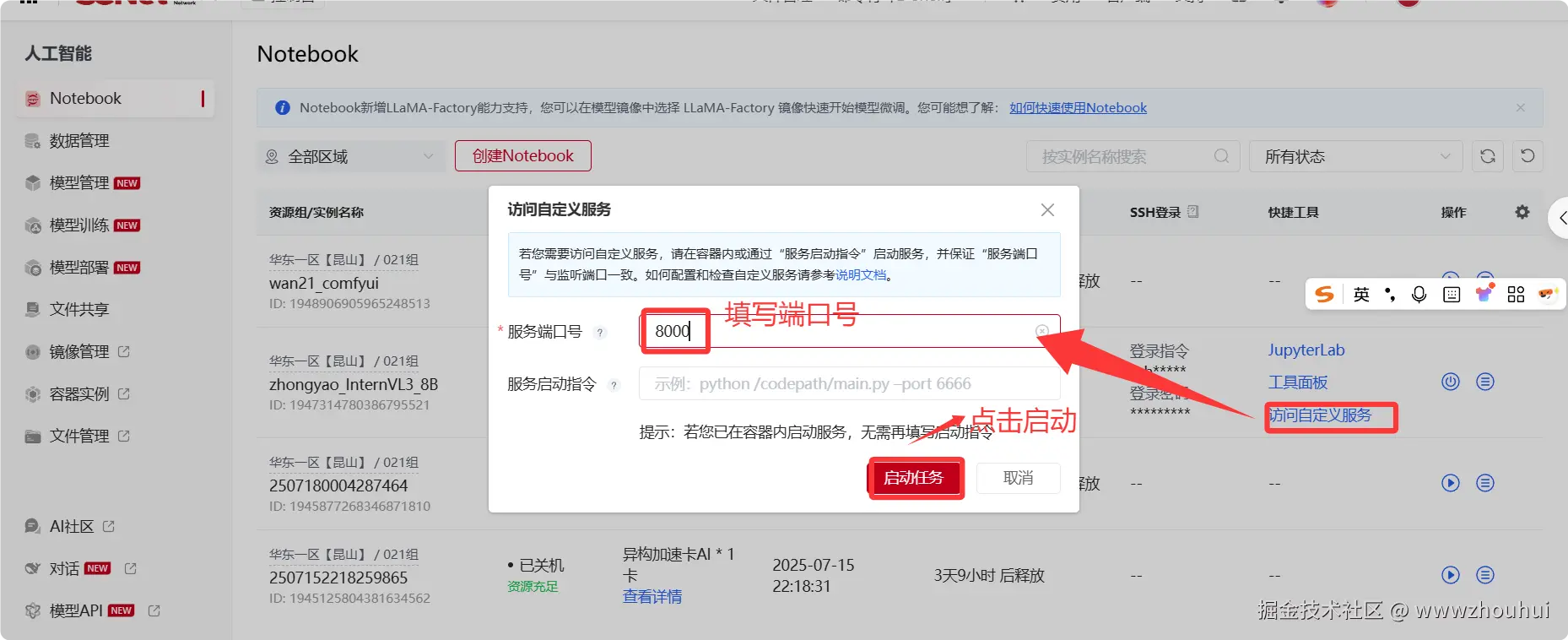

上面程序启动完后,我们可以把模型接口对外提供映射服务。回到scnet控制台管理页面,点击访问自定义服务

启动完成后,系统会生成一个对外提供访问的域名接口

我的对外提供的接口服务是c-1956886791489179649.ksai.scnet.cn:58043

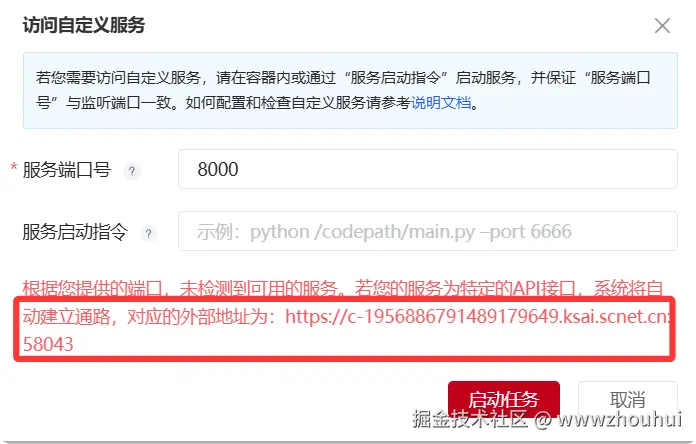

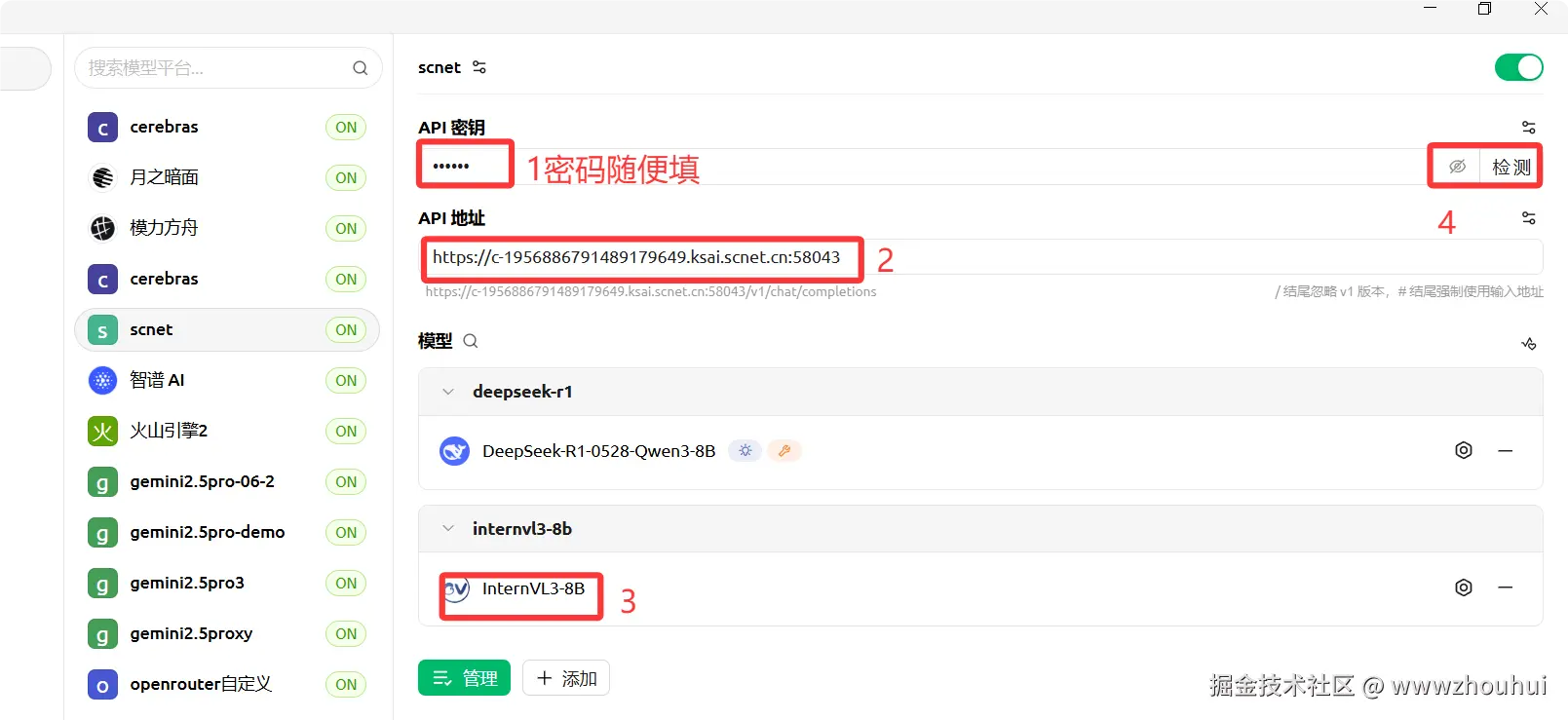

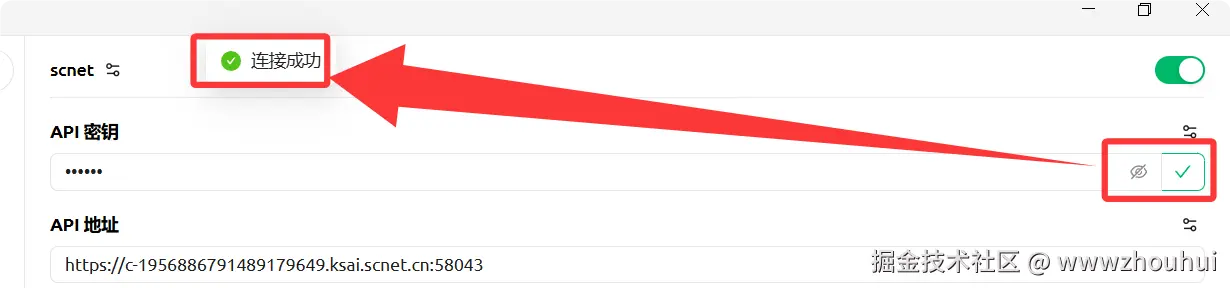

接下来我们可以使用一个第三方工具验证测试一下,我这里就那cherry-studio来测试

点击检测,显示连接成功。说明我们接口对外提供服务是OK的。

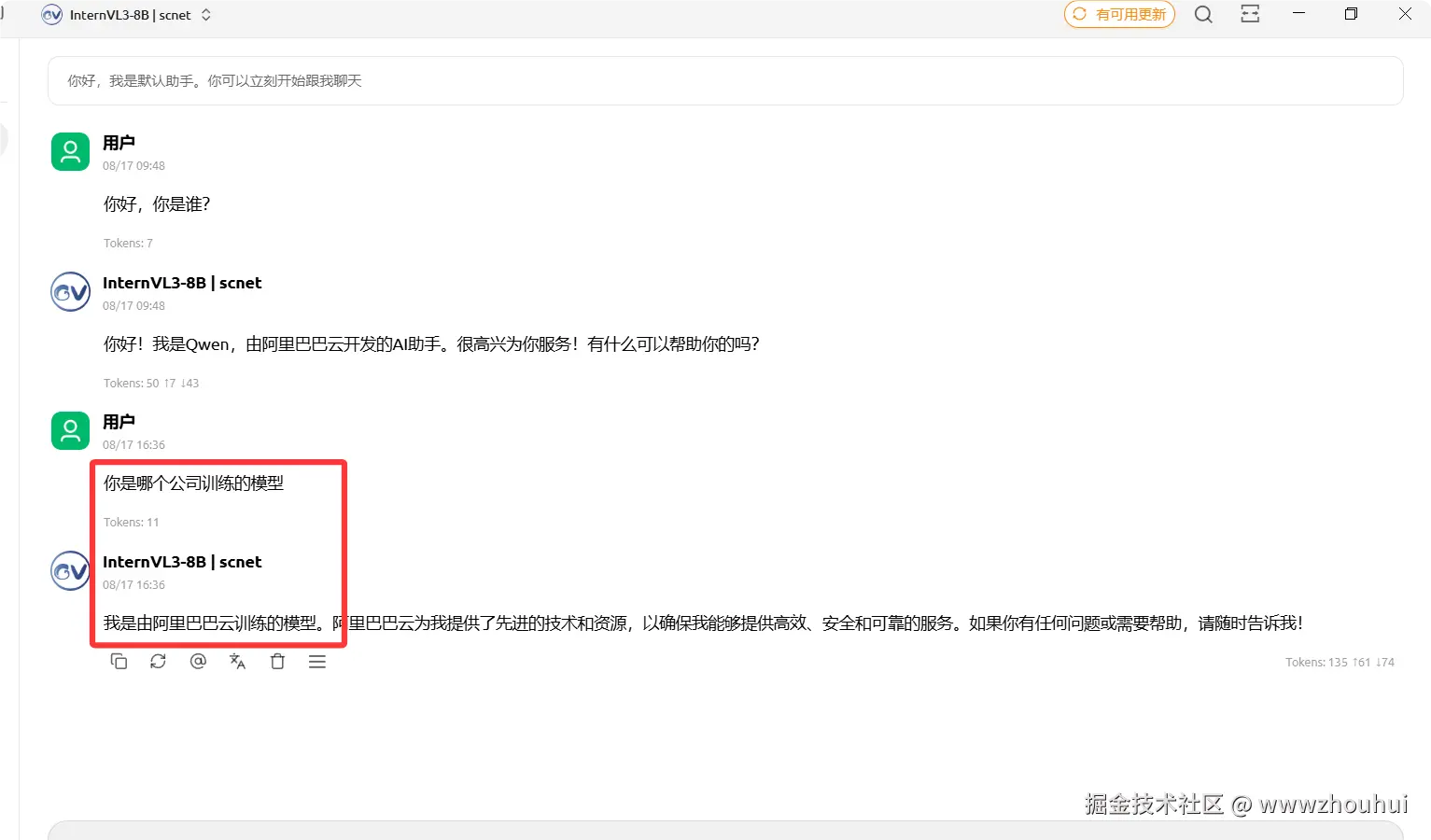

我们也可以找一个聊天窗口对话测试一下。

有返回消息说明VLLM推理的InternVL3-8B模型是OK的。

应用程序部署

关于程序部署的问题,有小伙伴问我:"明明 scnet 平台有现成的服务器,为啥不直接部署在上面,非要用第三方服务器呢?" 其实我一开始确实是部署在 scnet 平台的 ------ 毕竟有现成的服务器可用,谁也不想多折腾呀~

不过后来发现了个问题:scnet 平台的服务器在网络连接上做了限制。咱们的程序需要调用一些第三方平台的接口才能正常工作,但把程序部署到他们的容器里后,就没法连到外部的第三方平台了。简单说就是:这个平台允许别人调用它自己的接口,但它里面的程序想往外调用别人的接口时,网络就不通了。

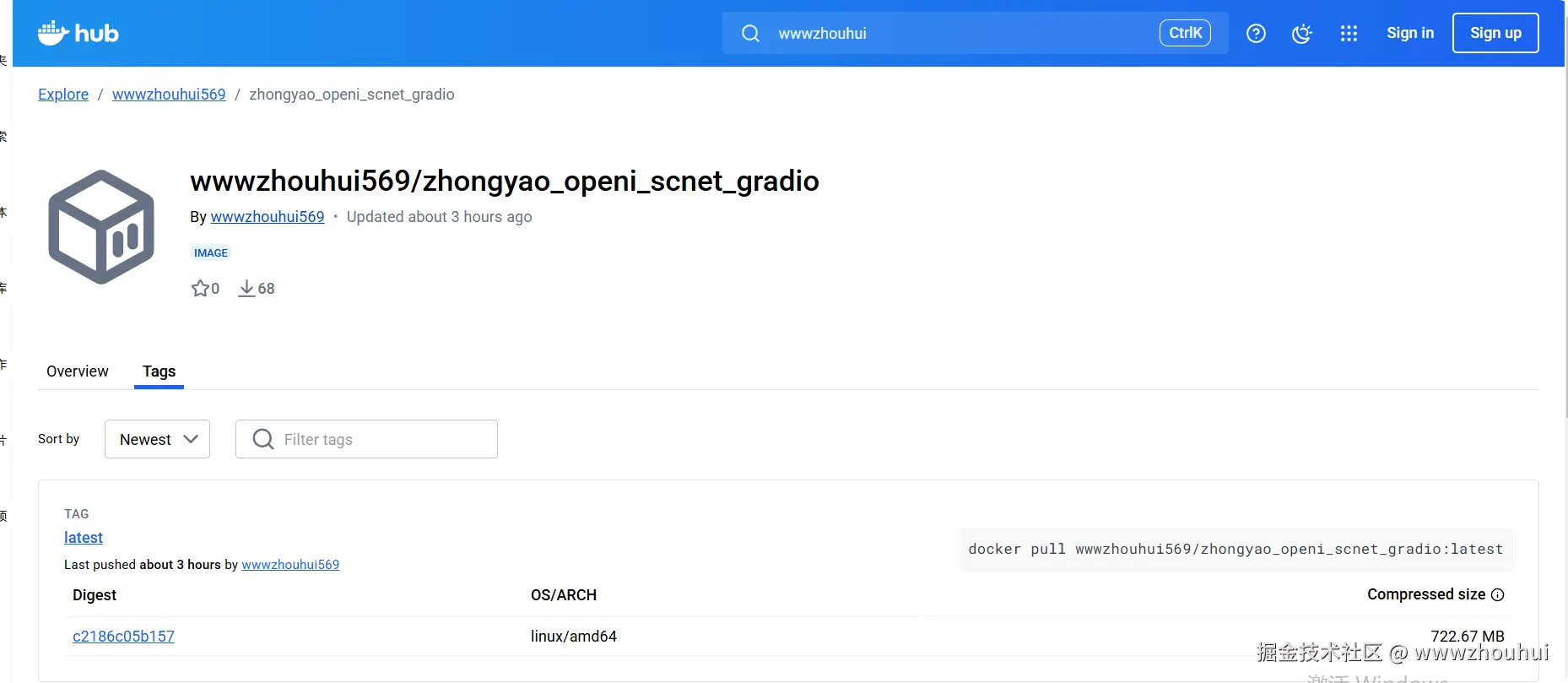

项目中提供了dockerfile 可以通过docker build -t 来实现编译打包。镜像包我已经打包上传hub.docker仓库了

感兴趣的小伙伴可以一键获取镜像

启动镜像

shell

docker run -d \

--name zhongyao_openi_scnet_gradio \

-p 7890:7860 \

wwwzhouhui569/zhongyao_openi_scnet_gradio:latest启动完成我们就可以在我部署的地址上访问了

IP访问:http://125.208.20.215:7890

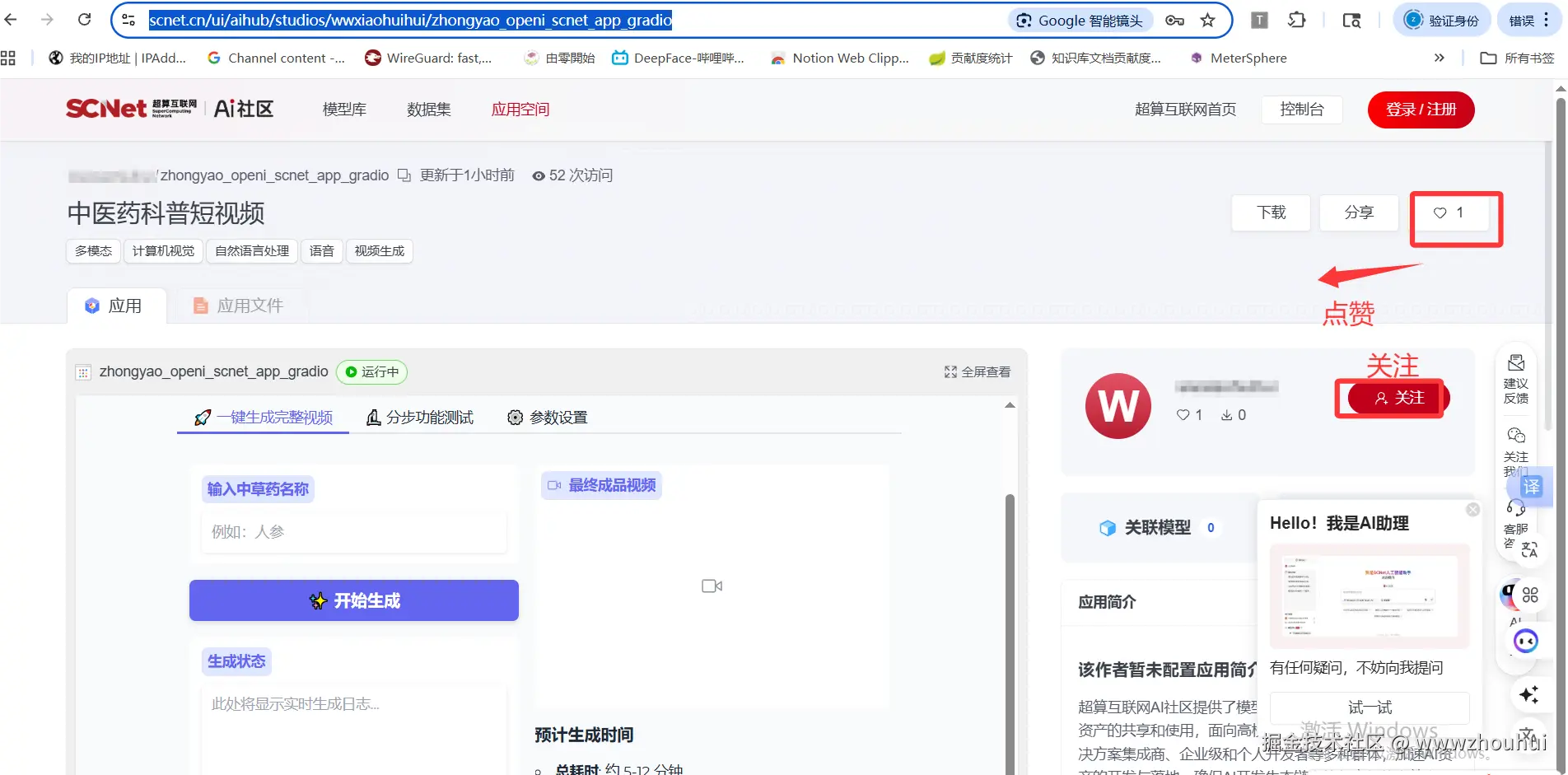

scnet应用开发构建

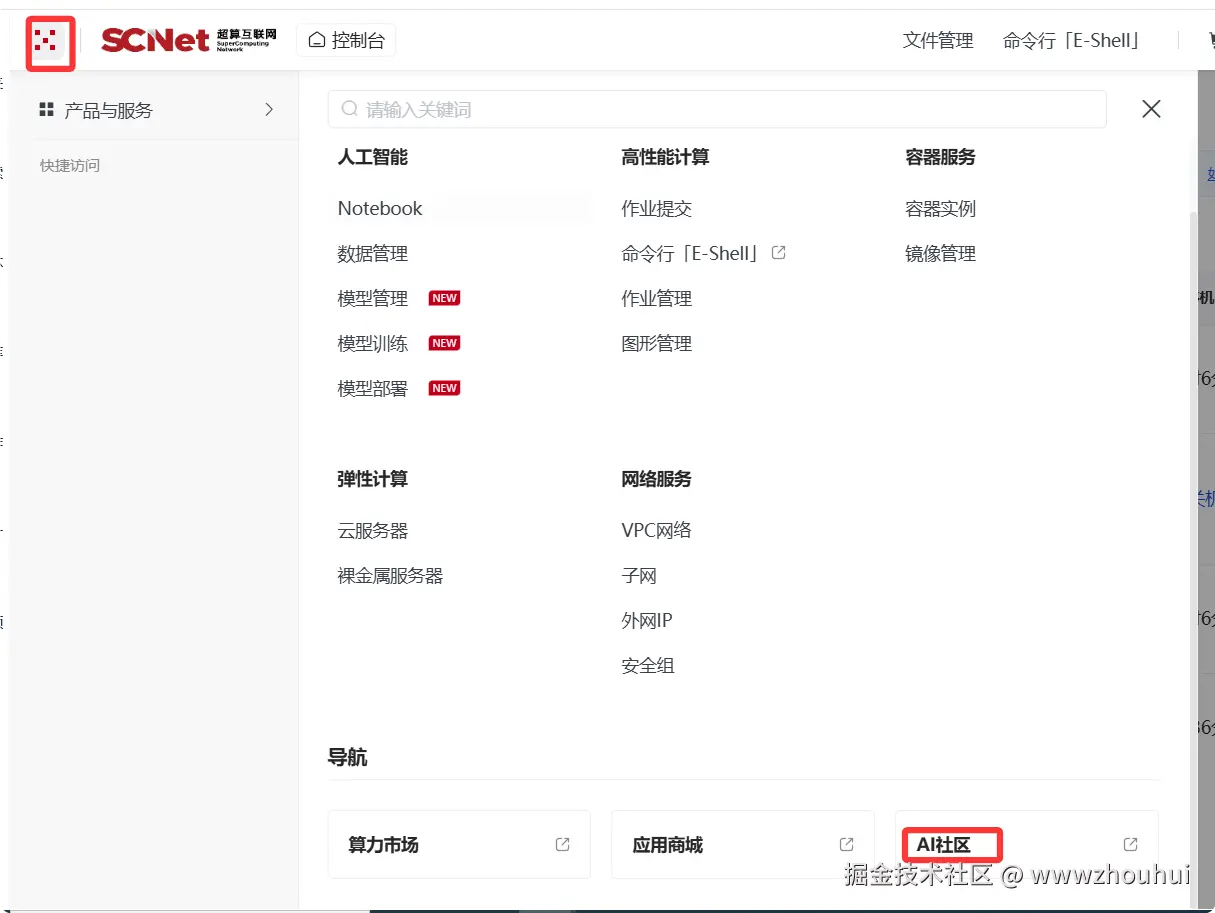

我们在scnet超算互联网左上角点击弹出框中选择右下角AI社区,进入AI 社区界面

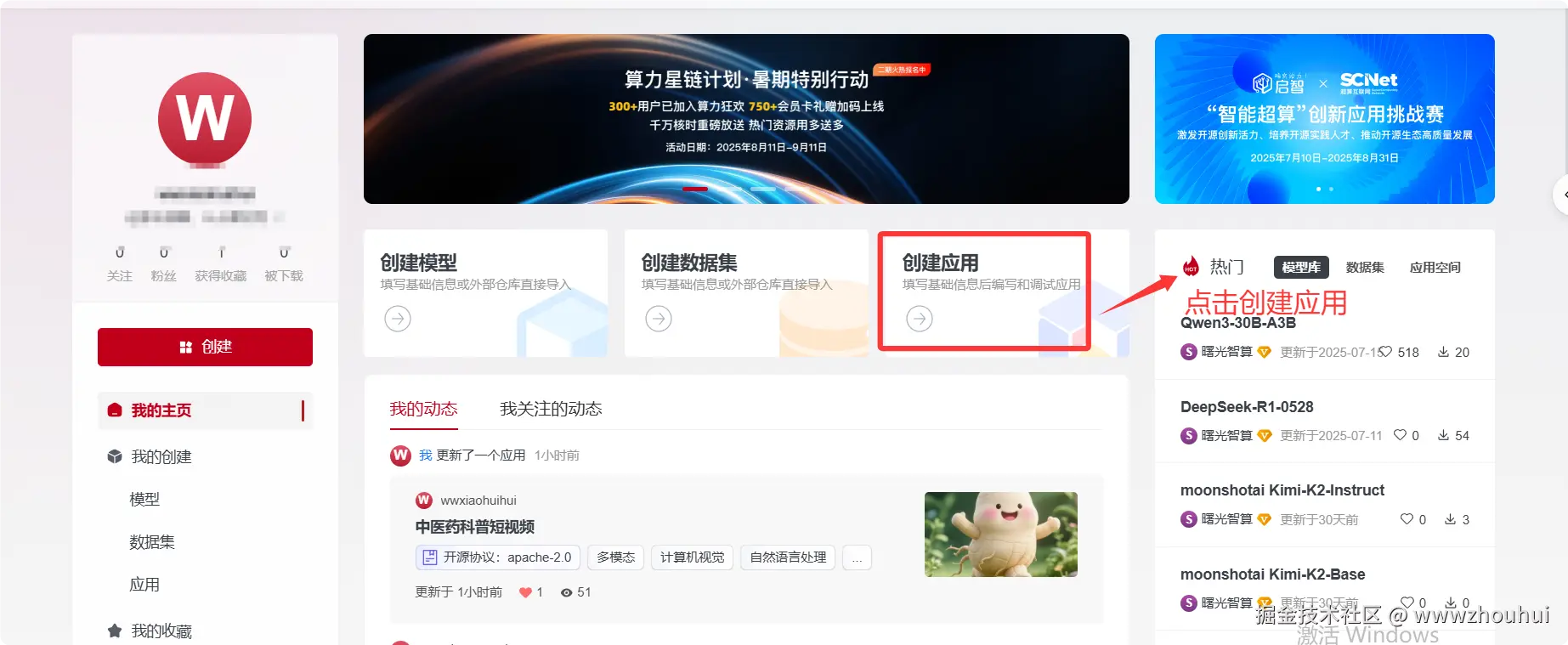

点击我的主页

点击创建应用

详细步骤大家可以看官方开发指引,n16teki97n.feishu.cn/docx/HlWud6...

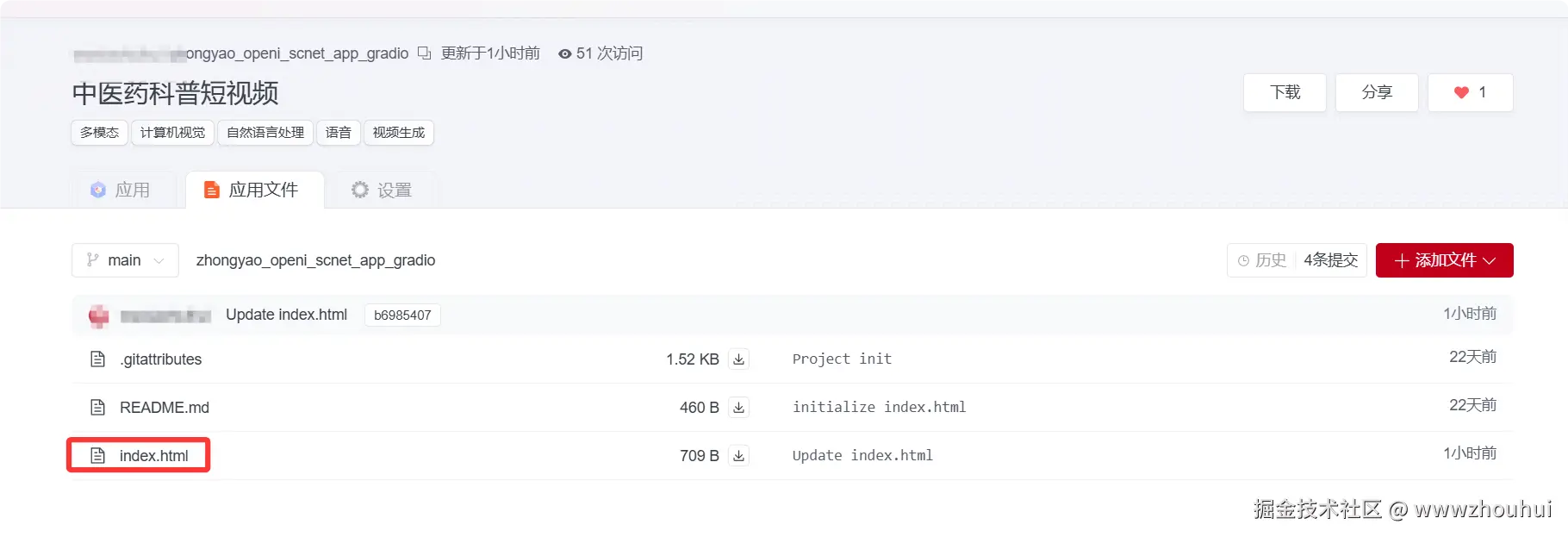

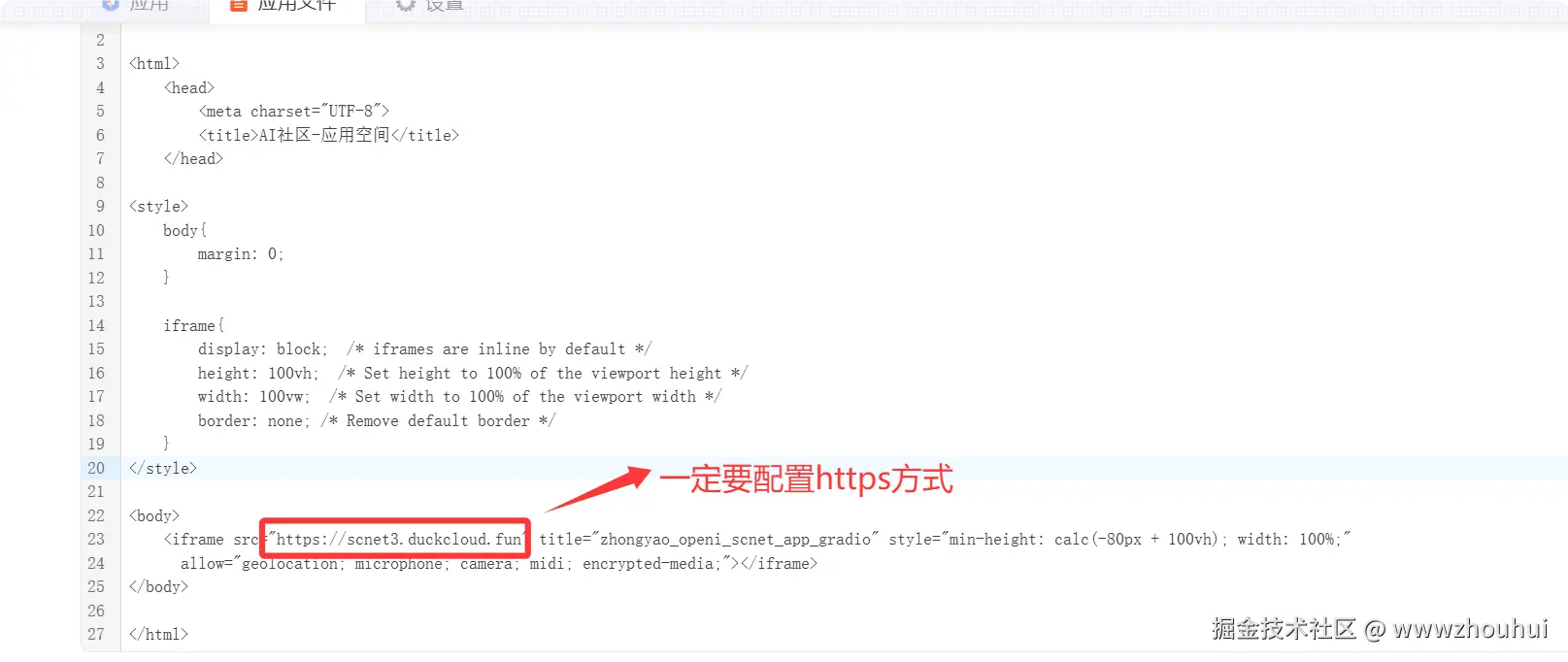

这里就不做详细展开。应用程序这里我们选择超链接,生成简单HTML代码,结构如下

需要注意的是iframe 代码里面超链接地址是需要https 方式如果是使用http页面发布后是不能显示的。

发布完成我们在就可以对外访问了

体验地址

觉的项目不错麻烦点个小红星

5.总结

今天主要带大家深入了解并实践了借助多种 AI 模型与超算互联网平台,实现中医药科普短视频自动化生成的方法。这个项目作为 OpenI x SCNet "智能超算" 创新应用挑战赛的实践成果,通过整合书生浦语 internlm3-8b-instruct 文本模型、Qwen-Image 文生图模型、Wan2.2-T2V-A14B 文生视频模型及 EdgeTTS 语音合成工具,构建了一套从药材信息检索到成品视频输出的全流程自动化方案。

该项目以 "一键生成" 为核心亮点,用户只需输入药材名称,即可自动完成文案撰写、图片生成、视频制作、语音合成及最终合成,同时支持分步测试与动态参数配置,兼顾了普通用户的便捷性与开发者的灵活性。依托开源模型的免费特性(如 Apache 2.0 协议的文本与图像模型)和超算平台的高效算力,既降低了中医药科普内容的创作门槛,又保障了生成内容的专业性与质量。

这种集成化方案为中医药知识普及工作者、教育者及相关爱好者提供了理想工具,尤其适合快速产出面向青少年的科普内容,有效缓解了当前青少年中医药知识匮乏的问题。它的出现为传统文化科普领域注入了新活力,让古老的中医药知识能通过短视频这种更易被接受的形式走进大众视野。

感兴趣的小伙伴可以按照本文步骤部署体验,感受 AI 技术与传统文化结合的独特魅力,也欢迎大家为项目点赞支持。今天的分享就到这里结束了,我们下一篇文章见。