在 AI 开发领域,有一个痛点几乎所有开发者都遇到过:当你用 OpenAI 的 API 开发聊天机器人时,它能侃侃而谈,但让它帮你查天气、订机票、调用公司内部接口时,它要么答非所问,要么直接 "瞎编" 一个结果。

这不是大模型不够聪明,而是传统的 LLM(大语言模型)本质上是 "文本生成器"------ 它擅长根据上下文生成连贯的文字,但缺乏与外部系统交互的能力。直到Function Calling(函数调用)出现,这个局面才被彻底打破。

本文将从基础到深入,从 OpenAI API 的基础接入,到传统 LLM 的致命局限,再到 Function Call 的工作原理、实战案例、高级技巧和未来趋势。无论你是 AI 开发新手还是进阶开发者,都能在这里找到可落地的技术指南。

OpenAI API 基础接入

在聊 Function Call 之前,我们需要先掌握 OpenAI API 的基础用法。这部分是所有进阶功能的基石,即使是新手也能快速上手。

1. 环境准备:3 分钟搭建开发环境

要调用 OpenAI API,你需要完成 3 件事:

- 注册 OpenAI 账号并获取 API 密钥

- 安装官方 SDK

- 配置开发环境

步骤 1:获取 API 密钥

-

进入 "API Keys" 页面(platform.openai.com/account/api...),点击 "Create new secret key",生成并保存你的密钥(形如

sk-xxxx)。注意:密钥仅显示一次,务必妥善保存,不要泄露给他人。

步骤 2:安装 OpenAI SDK

OpenAI 提供了官方 JavaScript SDK,支持 Node.js 和浏览器环境(浏览器环境需注意密钥安全,建议通过后端转发)。

bash

# 初始化

npm init vite

# 用npm安装(或用pnpm)

npm install openai步骤 3:初始化客户端

在代码中导入 SDK 并初始化客户端,传入 API 密钥和基础地址(国内用户可使用代理地址):

javascript

// 导入OpenAI SDK

import OpenAI from 'openai';

// 初始化客户端

const client = new OpenAI({

apiKey: 'sk-xxxxxx', // 你的API密钥

baseURL: 'https://api.openai.com/v1', // 官方地址(国内用户可替换为代理地址,如'https://api.302.ai/v1')

});2. 第一个对话:让 AI 回答你的问题

用chat.completions.create方法可以发送对话请求,这是最基础的 AI 交互方式。

javascript

async function simpleChat() {

// 发送对话请求

const response = await client.chat.completions.create({

model: "gpt-3.5-turbo", // 模型名称(可选gpt-4o、gpt-3.5-turbo等)

messages: [

{

role: "user", // 角色:user(用户)、assistant(AI)、system(系统提示)

content: "什么是Function Call?用一句话解释" // 用户提问

}

],

temperature: 0.7, // 随机性(0-2,值越低回答越确定)

});

// 提取AI回答

const answer = response.choices[0].message.content;

console.log("AI回答:", answer);

}

// 执行函数

simpleChat();

3. 基础参数解析:让 AI 更懂你的需求

chat.completions.create方法有多个关键参数,决定了 AI 的回答风格和效果:

| 参数名 | 作用 | 常用值 |

|---|---|---|

model |

选择模型 | gpt-3.5-turbo(性价比高)、gpt-4o(能力强,支持多模态) |

messages |

对话历史 | 数组,每个元素包含role(角色)和content(内容) |

temperature |

随机性 | 0(确定、严谨)~2( creative、发散),默认 0.7 |

max_tokens |

最大 tokens | 控制回答长度(1token≈0.75 个英文单词),默认无穷大 |

stream |

流式响应 | true(逐字返回,类似 ChatGPT 实时打字效果)、false(一次性返回) |

传统 LLM 的 "致命局限"

传统 LLM虽然能生成流畅的文本,但在实际应用中存在难以克服的缺陷。这些缺陷,正是 Function Call 诞生的核心原因。

1. 知识滞后:无法获取 "昨天之后" 的信息

OpenAI 的 GPT 模型(比如 GPT-4、GPT-3.5)的训练数据截止到某个时间点(比如 GPT-4o 截止到 2023 年 10 月)。这意味着:

- 你问 "2024 年奥运会冠军是谁",它无法回答(超出知识范围);

- 你问 "今天北京的天气",它只能根据历史数据 "猜" 一个结果,而不是实时查询;

- 你问 "公司内部系统的用户数据",它更是一无所知(训练数据不可能包含私有信息)。

没有外部工具的 LLM,就像一个 "与世隔绝的学者"------ 知识渊博但无法获取新信息。

2. 无法与外部系统交互:"想帮忙但没权限"

LLM 本身是一个 "文本生成器",没有能力调用 API、查询数据库或操作外部工具。

- 你问:"我的银行卡余额还有多少?"

- 传统 LLM 只能说:"请登录银行 APP 查询"(无法调用银行接口)。

这种 "只能建议,不能行动" 的特性,让 AI 的实用性大打折扣。

3. 上下文依赖:复杂任务 "记不住细节"

当任务需要多步骤处理或依赖外部数据时,LLM 的 "短期记忆" 会失效。

- 你问:"先查下明天北京的天气,再推荐适合的穿搭。"

- 传统 LLM 可能先胡编一个天气,再基于错误信息推荐穿搭(因为它无法 "暂停思考" 去查天气,只能凭记忆瞎编)。

4. 安全性隐患:直接生成敏感操作指令

如果用户要求执行高风险操作(如转账、修改密码),传统 LLM 可能直接生成操作步骤,存在安全风险。

- 你问:"如何用 API 修改我的支付宝密码?"

- 传统 LLM 可能会详细说明接口地址、参数格式(如果它 "学过" 相关文档),但无法验证用户身份,导致安全漏洞。

小结:传统 LLM 的本质是 "文本生成器",而非 "问题解决器"

这些局限的核心原因是:LLM 被设计为 "被动生成文本",而不是 "主动执行操作" 。要让 AI 从 "聊天工具" 变成 "实用助手",必须给它添加 "调用外部工具的能力"------ 这就是 Function Call 的核心价值。

Function Call: 给 LLM 插上 "外接设备" 的 USB 接口

Function Call(函数调用)是 OpenAI 在 2023 年 6 月推出的功能,它允许 LLM 在对话中 "主动决定是否调用外部函数",并根据函数返回结果生成最终回答。简单说:让 AI 从 "只会说" 变成 "会做 + 会说" 。

1. 什么是 Function Call?

用一句话解释:

Function Call 是一种机制,它允许 LLM 在处理用户请求时,像程序员调用函数一样,调用外部工具(API、数据库、本地函数等),并将工具返回的结果整合到回答中。

它的核心突破是:解决了 "自然语言到结构化操作" 的转换问题。

- 用户用自然语言提问("查天气");

- LLM 将其转换为结构化的函数调用(

getWeather(city="北京")); - 执行函数获取真实数据;

- LLM 用数据生成自然语言回答。

举个例子:当用户问 "今天抚州天气怎么样?" 时,带 Function Calling 的流程是这样的:

- LLM 分析问题:"用户需要天气信息,我需要调用 getWeather 函数,参数是 city=' 北京 '";

- LLM 生成一个 "函数调用指令"(而不是直接回答);

- 你的代码接收指令,调用实际的天气 API,获取结果(比如 "晴,28℃");

- 把天气结果返回给 LLM;

- LLM 用自然语言整理结果,回复用户:"今天北京天气晴朗,气温 28℃"。

整个过程中,LLM 负责 "判断需要调用什么工具" 和 "整理结果",而实际的 "干活"(调用接口)由你的代码完成 ------ 分工明确,既发挥了 LLM 的语义理解能力,又保证了结果的准确性。

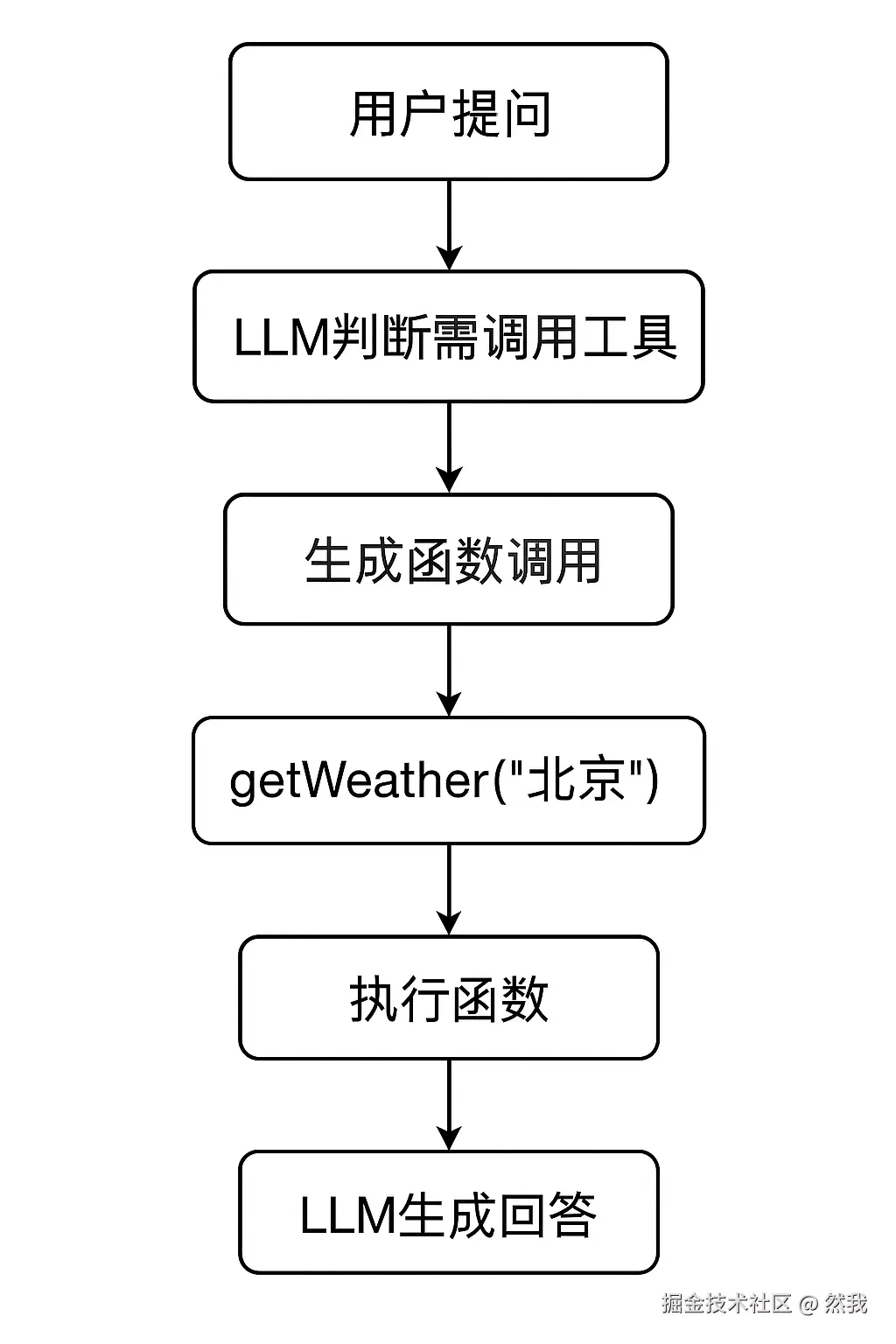

Function Call 工作流程:5 步看懂 AI 如何 "调用工具"

Function Call 的工作流程可以概括为 "提问→判断→调用→处理→回答"5 个步骤。我们结合 "查询北京天气" 的案例,一步步拆解其中的逻辑。

案例背景:

用户提问:"今天北京的天气怎么样?"

我们需要让 AI 调用getWeather函数(模拟获取天气的 API),并返回结果。

步骤 1:定义工具(函数)

首先,我们需要告诉 LLM:"你可以调用这些工具,每个工具的作用和参数是什么"。

工具定义需要包含:

name:函数名称(必须唯一,用于调用);description:函数作用(帮助 LLM 判断是否需要调用);parameters:参数格式(用 JSON Schema 定义,包含参数名、类型、是否必填)。

javascript

// 定义工具列表(告诉LLM可以调用哪些函数)

const tools = [

{

type: "function", // 固定值,标识这是一个函数工具

function: {

name: "getWeather", // 函数名

description: "获取指定城市的实时天气信息(温度、天气状况)", // 函数作用

parameters: {

type: "object", // 参数类型为对象

properties: {

city: {

type: "string", // 参数类型为字符串

description: "城市名称(如:北京、上海)" // 参数描述

}

},

required: ["city"] // 必传参数(必须包含city)

}

}

}

];步骤 2:用户提问,LLM 判断是否需要调用工具

当用户发送提问后,LLM 会结合问题和工具定义,判断 "是否需要调用工具":

- 如果不需要(如 "1+1 等于几"),直接生成回答;

- 如果需要(如 "查天气"),生成函数调用指令。

javascript

// 第1次调用OpenAI API:让LLM判断是否调用工具

const firstResponse = await client.chat.completions.create({

model: "gpt-4o", // 注意:只有gpt-3.5-turbo-1106、gpt-4-1106-preview及以上模型支持Function Call

messages: [

{

role: "user",

content: "今天北京的天气怎么样?"

}

],

tools: tools, // 传入工具定义

tool_choice: "auto" // 让LLM自动判断是否调用工具(可选"none"强制不调用,"function"强制调用)

});此时,LLM 会返回一个 "函数调用指令",格式如下:

json

{

"choices": [

{

"message": {

"role": "assistant",

"content": null, // 此时不直接回答,而是生成工具调用

"tool_calls": [

{

"id": "call_abc123", // 调用唯一标识(用于后续关联结果)

"type": "function",

"function": {

"name": "getWeather", // 要调用的函数名

"arguments": "{"city":"北京"}" // 函数参数(JSON字符串)

}

}

]

}

}

]

}关键逻辑 :LLM 通过分析问题("查北京天气")和工具描述("getWeather 用于获取城市天气"),匹配到需要调用getWeather,并自动提取参数city="北京"。

步骤 3:解析函数调用,执行本地函数

拿到 LLM 返回的 "函数调用指令" 后,我们需要:

- 解析出要调用的函数名和参数;

- 执行对应的本地函数(或调用外部 API);

- 获取函数返回结果。

javascript

// 解析LLM返回的工具调用指令

const toolCall = firstResponse.choices[0].message.tool_calls?.[0];

if (!toolCall) {

// 未生成工具调用,直接返回回答

console.log("AI回答:", firstResponse.choices[0].message.content);

return;

}

// 提取函数名和参数

const functionName = toolCall.function.name; // "getWeather"

const functionArgs = JSON.parse(toolCall.function.arguments); // { city: "抚州" }

// 执行本地函数(模拟调用天气API)

const getWeather = async (city) => {

// 实际场景中,这里可以调用第三方天气API(如高德、百度地图API)

return {

city: city,

temp: "28℃",

condition: "晴",

updateTime: "2024-08-18 10:00"

};

};

// 执行函数并获取结果

const functionResult = await getWeather(functionArgs.city); // { city: "北京", temp: "28℃", ... }步骤 4:将函数结果回传给 LLM

函数执行完成后,需要将结果 "喂回" 给 LLM,让它基于真实数据生成自然语言回答。

此时,对话历史需要包含:

- 原始用户提问;

- LLM 生成的工具调用指令;

- 工具返回的结果(标记为

role: "tool")。

javascript

// 第2次调用OpenAI API:传入工具结果,让LLM生成最终回答

const secondResponse = await client.chat.completions.create({

model: "gpt-4o",

messages: [

{ role: "user", content: "今天北京的天气怎么样?" }, // 原始提问

firstResponse.choices[0].message, // LLM生成的工具调用指令

{

role: "tool", // 标记这是工具返回的结果

tool_call_id: toolCall.id, // 关联对应的工具调用(与步骤2中的id一致)

content: JSON.stringify(functionResult) // 工具返回的结果(JSON字符串)

}

],

tools: tools // 仍需传入工具定义(LLM可能需要多轮调用)

});messages中新增了一条role: "tool"的消息,包含工具返回的结果;tool_call_id必须和之前的toolCall.id一致,否则 LLM 无法关联 "哪个调用对应哪个结果";content是工具返回的结果,通常转为 JSON 字符串(方便 LLM 解析结构化数据)。

步骤 5:LLM 生成最终回答

LLM 收到工具返回的结果后,会将结构化数据转换为自然语言回答:

javascript

// 提取最终回答

const finalAnswer = secondResponse.choices[0].message.content;

console.log("AI最终回答:", finalAnswer);

// 输出:今天北京的天气为晴,气温28℃,数据更新于2024-08-18 10:00。实战案例:3 个场景吃透 Function Call 的落地技巧

理论懂了还不够,我们通过 3 个递进式案例,掌握 Function Call 在不同场景下的具体用法。

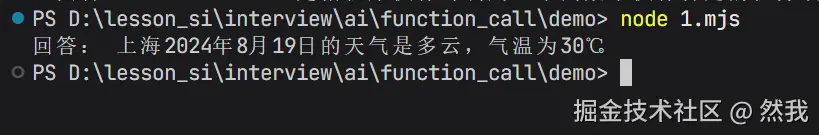

案例 1:基础版 ------ 天气查询(单工具调用)

需求:用户提问 "上海明天的天气如何?",AI 调用天气函数返回结果。

完整代码(可直接运行):

javascript

import OpenAI from 'openai';

// 1. 初始化OpenAI客户端

const client = new OpenAI({

apiKey: 'sk-xxxx', // 替换为你的API密钥

baseURL: 'https://api.302.ai/v1' // 国内代理地址(可选)

});

// 2. 定义工具(天气查询函数)

const tools = [

{

type: 'function',

function: {

name: "getWeather",

description: "获取指定城市、指定日期的天气(日期格式:YYYY-MM-DD,默认今天)",

parameters: {

type: "object",

properties: {

city: { type: "string", description: "城市名称" },

date: { type: "string", description: "日期(YYYY-MM-DD)" }

},

required: ["city"]

}

}

}

];

// 3. 本地天气函数(模拟API调用)

const getWeather = async (city, date) => {

// 实际场景中可替换为真实API请求(如高德天气API)

const mockData = {

"上海": {

"2024-08-19": { temp: "30℃", condition: "多云" },

"2024-08-20": { temp: "27℃", condition: "小雨" }

}

};

const targetDate = date || new Date().toISOString().split('T')[0]; // 默认今天

return {

city,

date: targetDate,

...mockData[city]?.[targetDate] || { temp: "未知", condition: "数据未找到" }

};

};

// 4. 主函数:处理对话流程

async function handleWeatherQuery(userQuestion) {

// 第一步:让LLM判断是否调用工具

const firstResp = await client.chat.completions.create({

model: "gpt-4o",

messages: [{ role: "user", content: userQuestion }],

tools: tools,

tool_choice: "auto"

});

const toolCall = firstResp.choices[0].message.tool_calls?.[0];

if (!toolCall) {

// 无需调用工具,直接返回回答

return firstResp.choices[0].message.content;

}

// 第二步:解析并执行函数

const { name, arguments: argsStr } = toolCall.function;

const args = JSON.parse(argsStr);

let functionResult;

if (name === "getWeather") {

functionResult = await getWeather(args.city, args.date);

} else {

throw new Error(`未知函数:${name}`);

}

// 第三步:回传结果,生成最终回答

const secondResp = await client.chat.completions.create({

model: "gpt-4o",

messages: [

{ role: "user", content: userQuestion },

firstResp.choices[0].message,

{

role: "tool",

tool_call_id: toolCall.id,

content: JSON.stringify(functionResult)

}

],

tools: tools

});

return secondResp.choices[0].message.content;

}

handleWeatherQuery("上海2024-08-19的天气如何?").then(answer => {

console.log("回答:", answer);

});

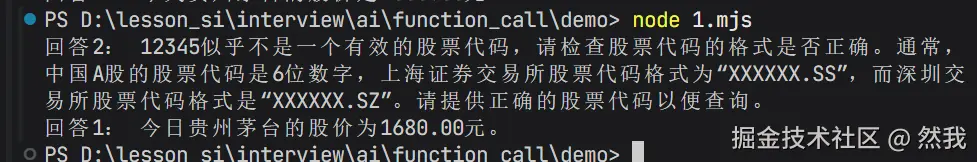

案例 2:进阶版 ------ 股票查询(带参数校验)

需求:用户查询 "茅台今天的股价",AI 调用股票函数,若参数缺失(如未指定日期),自动补充默认值;若参数错误(如股票代码不存在),返回友好提示。

核心升级点:

- 增加参数校验(检查股票代码是否合法);

- 处理函数执行错误(如 API 调用失败);

- 让 LLM 根据错误信息调整调用逻辑。

javascript

// 1. 工具定义(股票查询函数)

const tools = [

{

type: 'function',

function: {

name: "getStockPrice",

description: "查询股票代码对应的实时股价(需股票代码,如贵州茅台是600519.SS)",

parameters: {

type: "object",

properties: {

code: { type: "string", description: "股票代码(如600519.SS)" }

},

required: ["code"]

}

}

}

];

// 2. 股票查询函数(带参数校验和错误处理)

const getStockPrice = async (code) => {

// 步骤1:参数校验(检查股票代码格式)

if (!/^[0-9]{6}.[A-Za-z]{2}$/.test(code)) {

throw new Error(`股票代码格式错误(正确格式:600519.SS),你传入的是${code}`);

}

// 步骤2:模拟API调用(正常返回或报错)

const mockData = {

"600519.SS": { name: "贵州茅台", price: "1680.00元", time: "2024-08-18 15:00" }

};

if (mockData[code]) {

return mockData[code];

} else {

throw new Error(`未找到股票代码${code}的数据`);

}

};

// 3. 主函数(处理错误场景)

async function handleStockQuery(userQuestion) {

// 第一步:LLM判断是否调用工具

const firstResp = await client.chat.completions.create({

model: "gpt-4o",

messages: [{ role: "user", content: userQuestion }],

tools: tools,

tool_choice: "auto"

});

const toolCall = firstResp.choices[0].message.tool_calls?.[0];

if (!toolCall) {

return firstResp.choices[0].message.content;

}

// 第二步:执行函数(捕获错误)

const { name, arguments: argsStr } = toolCall.function;

const args = JSON.parse(argsStr);

let functionResult, errorMessage;

try {

if (name === "getStockPrice") {

functionResult = await getStockPrice(args.code);

}

} catch (err) {

errorMessage = err.message; // 捕获错误信息

}

// 第三步:回传结果(包括错误信息)

const secondResp = await client.chat.completions.create({

model: "gpt-4o",

messages: [

{ role: "user", content: userQuestion },

firstResp.choices[0].message,

{

role: "tool",

tool_call_id: toolCall.id,

content: errorMessage ? `Error: ${errorMessage}` : JSON.stringify(functionResult)

}

],

tools: tools

});

return secondResp.choices[0].message.content;

}

// 测试1:正确查询(茅台代码600519.SS)

handleStockQuery("贵州茅台今天的股价是多少?").then(answer => {

console.log("回答1:", answer);

});

// 测试2:错误代码(参数错误)

handleStockQuery("查询股票代码12345的价格").then(answer => {

console.log("回答2:", answer);

});

Function Call 高级技巧:从 "能用" 到 "好用"

掌握基础流程后,这些技巧能帮你优化 Function Call 的可靠性和用户体验。

1. 工具定义的 "黄金原则":让 LLM "秒懂" 你的工具

LLM 能否正确调用工具,取决于工具定义的清晰度。遵循以下原则:

- description 要具体:避免模糊表述,比如 "查询天气" 不如 "获取指定城市未来 7 天的温度、降水概率和风力";

- parameters 要详细 :给每个参数加

description,说明格式(如date: "YYYY-MM-DD,例如2024-08-18"); - required 要明确 :必传参数一定要在

required中声明,避免 LLM 漏传。

2. 多工具调用:让 AI "自主决策" 调用顺序

当有多个工具时(如查天气、查航班、订酒店),LLM 会根据用户需求自动决定调用顺序。

例如,用户说 "明天去上海开会,帮我安排行程",LLM 会:

- 调用

getWeather查上海明天的天气; - 调用

getFlights查合适的航班; - 调用

bookHotel预订酒店; - 整合结果生成行程建议。

实现时只需在tools数组中定义多个工具,LLM 会自动处理调用逻辑。

3. 错误处理:让 AI "自我纠错"

当工具调用失败(如参数错误、API 超时),不要直接返回错误,而是将错误信息回传给 LLM,让它调整策略:

- 若参数错误,LLM 会重新解析问题,生成正确参数;

- 若 API 超时,LLM 会提示用户 "暂时无法获取数据,请稍后再试"。

4. 流式响应:让回答 "实时生成"

对于耗时较长的工具调用(如查询大型数据库),可开启流式响应(stream: true),让用户看到 "AI 正在调用工具→正在处理结果→正在生成回答" 的实时过程,减少等待焦虑。

目前的局限性

- 依赖工具定义质量:工具描述模糊会导致 LLM 调用错误;

- 多轮调用效率低:复杂任务可能需要多次 API 调用,耗时较长;

- 无法处理极端复杂逻辑:涉及多步骤、多工具的精密协作时,LLM 可能 "混乱";

- 模型能力差异:gpt-3.5 对复杂工具调用的支持较弱,需用 gpt-4 及以上模型。

未来趋势

- 多模态 Function Call:不仅调用函数,还能处理图片、音频(如 "分析这张图片中的物体,调用识别 API");

- 与 RAG 深度结合:将 Function Call 与知识库(RAG)结合,让 AI 先查询私有数据,再调用工具,解决 "知识滞后 + 无法交互" 的双重问题;

- 自动化工作流:LLM 可自动创建 "工具调用链"(如 "查天气→订机票→订酒店"),实现端到端自动化;

- 更低门槛:未来可能无需手动定义工具,LLM 会自动 "理解" API 文档,生成调用逻辑。

结语:Function Call 不是 "锦上添花",而是 "必备能力"

从技术演进的角度看,Function Call 不是简单的功能升级,而是 AI 交互逻辑的根本性变革 ------ 它标志着 AI 从 "被动响应" 进入 "主动执行" 的新阶段。

对于开发者来说,掌握 Function Call 已不再是 "加分项",而是开发实用 AI 应用的 "必备技能"。无论是构建企业级智能助手,还是优化日常工作流,Function Call 都能帮你突破传统 LLM 的局限,让 AI 真正解决实际问题。