新用户可获得高达 200 美元的服务抵扣金

亚马逊云科技新用户可以免费使用亚马逊云科技免费套餐(Amazon Free Tier)。注册即可获得 100 美元的服务抵扣金,在探索关键亚马逊云科技服务时可以再额外获得最多 100 美元的服务抵扣金。使用免费计划试用亚马逊云科技服务,最长可达 6 个月,无需支付任何费用,除非您选择付费计划。付费计划允许您扩展运营并获得超过 150 项亚马逊云科技服务的访问权限。

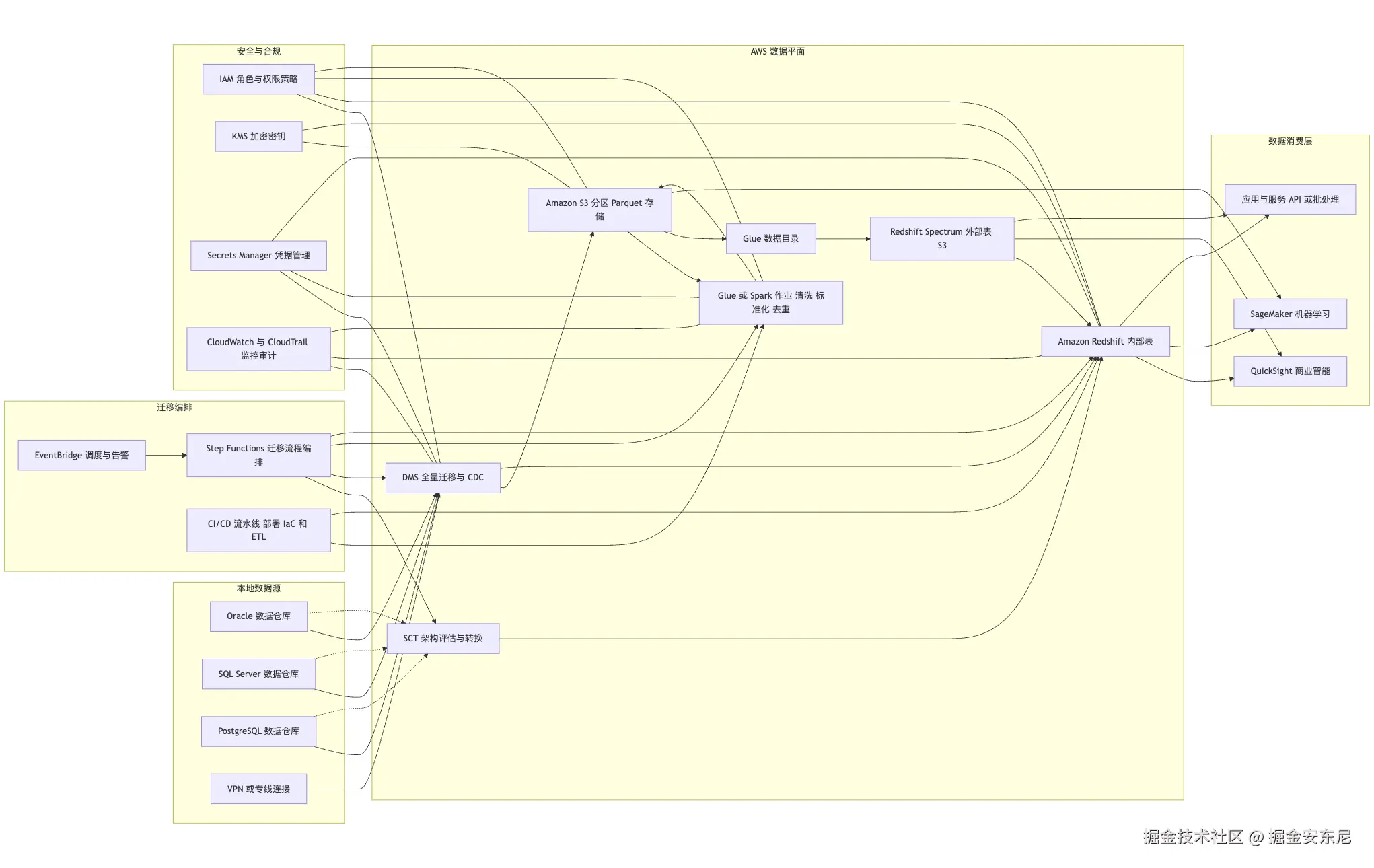

在当今数据驱动的时代,数据仓库已成为企业智能决策和业务创新的关键基础设施。无论是零售、电信、金融,还是制造业,各类组织都在加速推进数据仓库现代化 ,以追求更高的性能、更灵活的扩展能力以及更优的成本效益。然而,从传统数据仓库向现代云原生架构迁移,并不仅仅是一次简单的"搬家"------它往往伴随着架构差异、数据量庞大、实时性要求提升以及安全合规等多重挑战。这些问题如果处理不当,不仅会拖延项目进度,还可能影响业务连续性。

本文将聚焦于数据仓库迁移至 亚马逊 Redshift 的规划与准备阶段 ,结合实践经验深入剖析每一个关键步骤,并分享可直接落地的最佳实践与工具策略 ------从数据评估、架构设计,到性能优化、成本规划。通过系统掌握这些准备工作,不仅能够顺利完成迁移,还能在新环境中充分释放 Redshift 的潜力,获得更高的查询性能、更低的总体拥有成本(TCO)以及面向未来的可扩展能力 。【权益传送门】

🎯 主要挑战与解决方案

在数据仓库现代化过程中,迁移不仅仅是"把数据搬过去"这么简单,而是一次涉及架构重构、性能优化与业务连续性保障的系统工程。企业在推进迁移到 亚马逊 Redshift 的过程中,通常会遇到以下核心挑战及对应的应对策略:

- 架构不兼容与复杂转换

挑战:源数据仓库与目标 亚马逊 Redshift 在架构层面存在差异,例如数据类型、索引策略、存储模型等可能无法直接映射。这会导致:

- 某些架构元素缺乏直接支持,需要人工重构

- 手动调整耗时长,增加迁移风险和周期

解决方案 : 借助 亚马逊云 Schema Conversion Tool (SCT) ,可自动化完成大部分架构转换工作:

- 自动生成符合 亚马逊 Redshift 规范的架构脚本

- 在迁移前执行兼容性分析与测试,提前发现并修正潜在问题

- 支持部分对象的手动优化,减少重复劳动并提升转换准确性

- 大规模数据集迁移的时间与性能压力

挑战:在严格的停机窗口或有限时间内迁移 TB 级甚至 PB 级数据,如果传输速度不足,会造成:

- 数据导入超时,延误上线计划

- 迁移过程中业务中断,影响正常运营

解决方案 : 结合 亚马逊云 Database Migration Service (DMS) 的高效数据传输能力与优化策略:

- 启用 并行处理 提高数据加载速度

- 应用数据压缩技术,在保证数据完整性的前提下减少传输体积

- 采用 持续数据复制(CDC 模式),在迁移过程中保持源系统与目标系统实时同步,实现"零停机"切换

- 数据仓库选型与弹性扩展能力不足

挑战:传统数据仓库存在硬件扩容周期长、维护成本高、灵活性不足等问题,很难满足业务快速增长或多变的分析需求。

解决方案 : 迁移到 亚马逊 Redshift 可以在架构层面解决这些瓶颈:

- 提供 无服务器(Serverless)模式 与 按需扩展 能力,按业务负载自动调整资源

- 原生支持 实时分析 、半结构化数据处理 以及与 亚马逊 SageMaker 集成的机器学习推理

- 免维护硬件与自动化运维,大幅降低 总体拥有成本(TCO)

📋 数据仓库现代化的五个阶段

一次完整的数据仓库现代化迁移,通常会经历五个环环相扣的阶段:从规划与准备、架构转换与数据准备,到数据迁移执行、性能与成本优化,再到监控与持续改进。每个阶段都决定着后续工作的成败,其中前两个阶段尤为关键,它们直接影响迁移的可行性、风险控制和最终效果。

🔍 第一阶段:规划与评估

在项目启动的第一步,团队需要对现有系统进行一次"全面体检"。这不仅是简单的数据盘点,更是从业务、技术、资源等多个维度去理解当前数据仓库的全貌------它的体量、架构、数据访问模式以及运行负载。你需要知道总数据量有多大,哪些是每天都在频繁读取的热数据,哪些是归档后偶尔才会查询的冷数据;要清楚数据库中有哪些复杂的表间关系、视图和存储过程,是否存在外键、触发器等在 亚马逊 Redshift 中并不直接支持的元素;还要掌握日常查询的类型和频率,是批量生成固定报表的长跑型聚合查询,还是用户临时发起的即席探索,以及这些查询在一天中的哪个时段最为密集。

在这个阶段的分析结果,会直接决定你后续采用何种迁移策略------是一次性全量迁移,还是分批次、分主题域地切换;是将所有数据都迁入 Redshift 内部存储,还是将低频访问的数据放到 亚马逊 S3 结合 Spectrum 做分层访问。同时,工作负载分析还能帮助你预测目标环境的计算与存储需求,提前规划 Redshift 的节点规格、并发队列以及弹性伸缩策略,从而在上线后既能应对高峰,又不会因资源闲置而浪费成本。

🔧 第二阶段:架构转换与数据准备

当规划与评估结束,迁移项目就进入到"落地准备"的阶段。此时的重点,不再是盘点现状,而是让现有系统的架构和数据,逐步适配 亚马逊 Redshift 的运行环境。这往往是一次"翻译"和"清洗"并行的过程------你需要把源数据库的结构语言,转化成 Redshift 能够理解并高效执行的版本,同时确保即将迁移的数据是干净、完整且一致的。

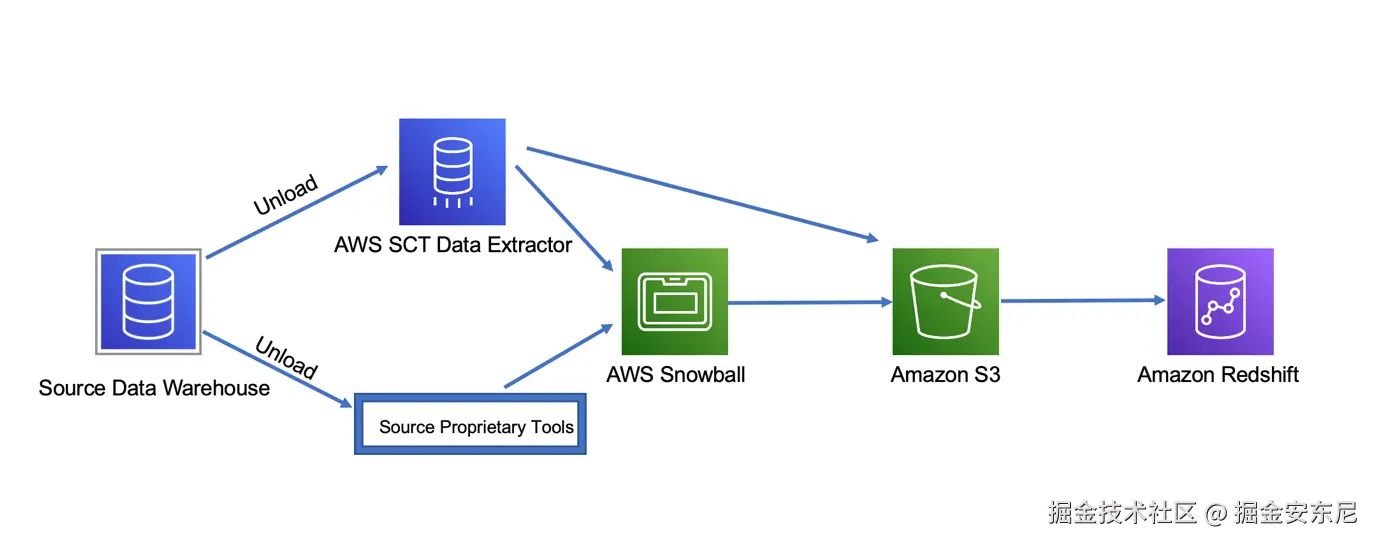

架构转换通常从 亚马逊云Schema Conversion Tool(SCT)开始,它能够自动分析源系统的架构,将表结构、索引策略、视图定义等元素转换为 Redshift 支持的格式,并在发现不兼容的地方时给出详细的修改建议。虽然自动化能解决大部分问题,但对于复杂的存储过程、触发器或自定义数据类型,依然需要人工参与优化------这既是技术上的必要性,也是为后续性能调优预先埋下的伏笔。

与此同时,数据准备工作也应同步展开。对于海量数据,最好先明确哪些是必须立即迁移的核心数据集,哪些可以延后或按需迁移。此时可以利用 亚马逊云Database Migration Service(DMS)提前建立数据管道,并通过并行加载、数据压缩等方式提升传输效率。在数据正式迁移前,还需要进行一轮全面的质量检查,确保不存在重复、缺失或格式异常的记录,避免在新环境中引入潜在问题。如果业务需要"零停机"切换,DMS 的持续数据复制(CDC)功能可以让源端和目标端在整个迁移窗口内保持实时同步,这样切换时就像按下一个开关,业务就平滑切换到 Redshift 上运行。

这一阶段完成后,你将得到一个已经结构兼容、数据准备就绪的目标环境,为第三阶段的数据迁移执行创造了条件。可以说,前两个阶段的细致打磨,直接决定了后续迁移的速度与稳定性。

🚀 第三阶段:数据迁移执行

当架构和数据都准备妥当,迁移终于进入最具"动作感"的阶段------把数据真正搬到 亚马逊 Redshift 上。这一阶段的核心目标,是在保证数据完整性和业务连续性的前提下,尽快、稳妥地完成数据导入。执行时往往需要在速度与风险之间找到平衡点:全量一次性迁移适合数据量相对可控、停机窗口充足的场景;而对于 TB 级甚至 PB 级的企业级仓库,则更常采用分批迁移与持续数据复制(CDC)结合的方式,让新旧系统并行一段时间,再完成平滑切换。

在 亚马逊 生态中,亚马逊云Database Migration Service(DMS)依旧是执行阶段的核心工具。它不仅支持批量数据导入,还能在迁移过程中进行数据校验,确保源端与目标端的一致性。为了提升速度,可以启用并行加载模式,结合数据压缩减少传输体积。如果网络带宽成为瓶颈,可以考虑使用 亚马逊 S3 作为中转,将数据批量导出到 S3,再通过 Redshift 的 COPY 命令一次性加载,这种方式往往能显著提升导入效率。在切换的最后关口,务必进行一次全量校验,确保新系统的数据准确无误,然后再逐步下线旧系统的查询与写入功能,完成迁移闭环。

⚙️ 第四阶段:性能与成本优化

迁移完成后,系统虽然已经能在 Redshift 上运行,但"能跑"并不代表"跑得好"。这一阶段的重点,是让新环境在性能和成本之间找到最佳平衡点。性能优化的第一步,是对查询和工作负载进行分析,识别慢查询并针对性优化 SQL、索引和分布键设计;同时合理调整排序键,减少扫描的数据量,让常用的聚合和连接操作尽可能走分区和并行计算路径。

Redshift 的 Workload Management(WLM)是这一阶段的关键调节器。通过为不同类型的查询分配独立队列,可以避免长跑型分析任务阻塞短响应查询,实现多类型工作负载的高效并行。对于偶发的分析高峰,可以启用 Concurrency Scaling 或自动伸缩功能,在需求下降后自动释放额外资源,避免长期闲置造成浪费。

在成本方面,除了按需付费的 Serverless 模式,Redshift 还支持预留实例购买(Reserved Instances),适合长期稳定运行的生产环境;对于冷数据,可以将其卸载到 亚马逊 S3,通过 Redshift Spectrum 按查询量付费访问,实现存储成本的显著下降。经过这一轮性能与成本优化,新环境不仅能稳定支撑业务,还能为未来的增长留出充足的弹性空间。

💡 实施建议和最佳实践

要让数据仓库迁移顺利推进,首先需要组建一支专业且分工明确的迁移团队。项目经理负责统筹全局、把控节奏;数据架构师则要为目标环境设计合理的架构方案;DBA 处理具体的数据库迁移与性能调优;业务分析师确保迁移后的系统依旧满足各类业务需求;而测试工程师则在整个过程中扮演守门人的角色,验证迁移结果的准确性和稳定性。这样一支团队,既覆盖了技术层面,也兼顾了业务和质量保障。

团队就位后,必须制定一份详细的时间表,将关键里程碑明确到具体日期------从评估工作的收尾,到架构设计的确认,再到测试环境的搭建、正式的数据迁移窗口以及生产环境的切换。时间表不仅是进度管理的工具,更是跨部门协同的契约,确保每一步都有清晰的起止时间和责任人。

与此同时,风险评估和缓解策略也应同步落实。迁移过程中,数据丢失或损坏、迁移时间超出预期、性能不达标、业务中断时间过长,都是常见的风险点。应对这些挑战的办法包括:建立完善的备份与恢复策略、在正式迁移前进行多轮测试验证、为关键环节准备可行的回滚方案,以及制定详细的应急预案,以便在突发状况下迅速响应。

在工具和服务的选择上,亚马逊云原生工具往往能满足绝大多数需求。亚马逊云Schema Conversion Tool(SCT)可以自动化架构转换,提供兼容性评估与迁移前验证;亚马逊云Database Migration Service(DMS)则在执行迁移、实时数据同步、减少停机时间方面表现出色;而 亚马逊 Redshift 作为目标平台,凭借高性能的分析能力与弹性扩展特性,成为现代化数据仓库的核心。对于更复杂的场景,还可以引入第三方工具,如数据质量验证平台、性能监控解决方案和数据血缘追踪系统,以构建更完整的迁移生态。

总结

无论是架构转换、数据准备,还是迁移执行与性能优化,每一步都有成熟的工具与方法可以借鉴------亚马逊云SCT 自动化转换架构,DMS 实现高效数据传输与实时同步,Redshift 则为后续分析提供高性能、可扩展的运行环境。

以上就是本文的全部内容啦。最后提醒一下各位工友,如果后续不再使用相关服务,别忘了在控制台关闭,避免超出免费额度产生费用~