背景

过去笔者写过关于系统设计原则回顾的文章,今天我们让GPT5帮助分析现有项目架构评估,选用工程项目是WeKnora 是腾讯(Tencent)企业级知识库管理系统. 在Code Buddy IDE 选择GPT5模型,Craft模式。

提示词

"基于以下26条互联网系统架构设计原则,对当前工程输出系统进行全面架构分析评估:1)高可用性设计(避免单点故障、异地部署、就近接入);2)扩展性策略(横向扩展优先、服务拆分);3)性能优化(动静分离、多级缓存、异步化处理);4)容错机制(柔性可用、有损服务、快速切换);5)数据策略(分级存储、最终一致性);6)运维设计(自动化监控、灰度发布);7)架构规范(API优先、无状态设计、去中心化)。需重点评估:各组件是否符合'大系统小做'原则、是否实现关键路径转换、第三方依赖隔离方案、DNS层利用率,以及是否遵循'成熟组件优先'原则。最终输出包含架构评分、改进建议及技术债务分析的报告。"

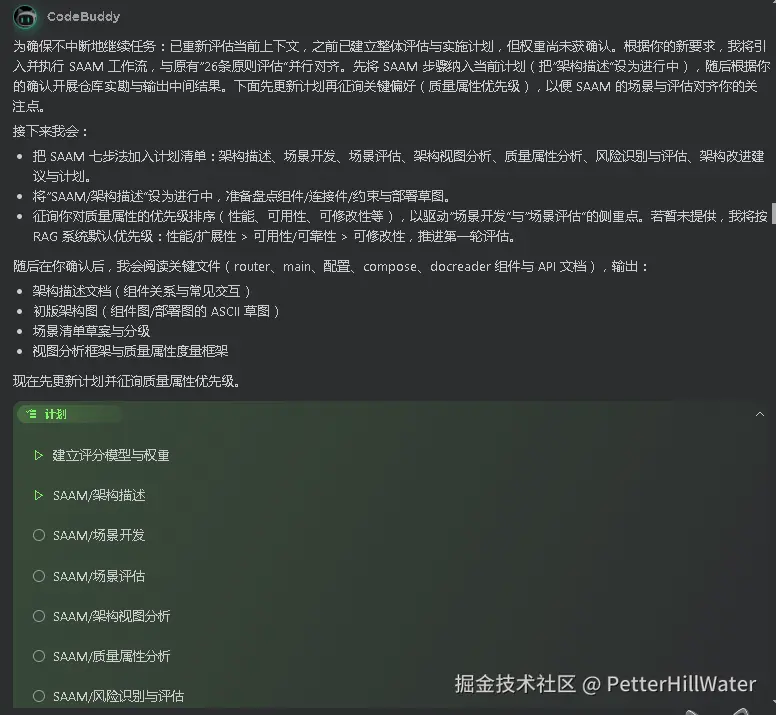

GPT5反馈

将先做结构化需求分析,明确评估维度、评分模型与交付项清单,并据此制定执行计划。完成后会等你确认再开始对仓库进行逐步体检(阅读代码、配置、部署脚本),最终产出架构评分、改进建议与技术债务清单。

计划要点:

-

评估范围与方法:按照你给出的26条原则与重点关注点建立量表与打分规则,覆盖可用性、扩展性、性能、容错、数据、运维、规范,以及"大系统小做""关键路径转换""第三方依赖隔离""DNS层利用""成熟组件优先"。

-

执行步骤:

- 仓库盘点与系统边界确认

- 运行与依赖盘点(容器、数据库、缓存、对象存储、消息/流、第三方)

- 现状架构与关键路径梳理

- 评分量表与权重确认

- 分项打分与证据列举

- 改进建议(含优先级和影响/成本评估)

- 技术债务清单与偿还计划

-

交付物:分项/总评分报告、整改建议优先级清单、技术债务台账、后续实施计划(里程碑/风险/回滚策略)。

分析

-

评估范围

- 高可用性:避免单点、异地部署、就近接入

- 扩展性:横向扩展优先、服务拆分

- 性能:动静分离、多级缓存、异步化

- 容错:柔性可用、有损服务、快速切换

- 数据:分级存储、最终一致性

- 运维:自动化监控、灰度发布

- 规范:API优先、无状态、去中心化

-

重点核查

- "大系统小做"、关键路径转换、第三方依赖隔离、DNS层利用率、"成熟组件优先"

架构现状速览

- Monorepo;后端为 Go(REST),前端 Vue3+Vite;数据层含 MySQL 与 ParadeDB(向量),可选 Redis;对象存储 MinIO;独立 Python 文档处理服务;Docker 化与 compose 编排;配置 config.yaml;RAG/知识库类场景。

26 原则逐项评估与评分

- 高可用性(60/100)

- 现状:核心依赖(MySQL、MinIO、向量库、Redis)多为单实例形态,compose 为主;无多活/容灾设计;健康检查与就近接入未体现。

- 评估:具备容器化基础,但缺少多 AZ/Region 与自动故障转移支撑。

- 扩展性(75/100)

- 现状:后端无状态 REST 易于横向扩展;文档处理为独立进程;数据与存储抽象有限,服务拆分较粗粒度。

- 评估:可平滑横向扩展计算层;数据层与第三方耦合度偏高,影响独立扩缩容。

- 性能(70/100)

- 现状:前后端动静分离明确;未见系统化多级缓存策略;文档处理与向量化异步化迹象不足。

- 评估:具备优化空间:读缓存、向量检索结果缓存、分层 TTL、批处理、异步管线。

- 容错(55/100)

- 现状:未见断路器/重试/限流/超时预算;缺少降级策略与功能熔断;依赖快速切换机制缺位。

- 评估:故障蔓延风险较高,关键依赖无隔离护栏。

- 数据策略(65/100)

- 现状:对象存储+关系型+向量存储形成分级;一致性依赖流程约定,缺少 outbox/补偿机制与幂等保障。

- 评估:模型合理但落地不足,易出现"读到旧向量/缺失索引"的弱一致问题。

- 运维(60/100)

- 现状:Tracing/Logger 具雏形;未见统一指标/日志聚合与告警;灰度/金丝雀机制缺位。

- 评估:可观测性与发布风险控制需加强。

- 架构规范(80/100)

- 现状:REST 风格清晰;无状态倾向好;缺少 API 契约(OpenAPI)与依赖抽象层全面落地。

- 评估:规范度较好,仍需补全契约先行与接口隔离。

重点项专项评估

- 大系统小做:总体保持"单体+少量边车服务"的小步快跑,符合原则;数据面引入多依赖(MinIO、向量库、Redis),建议以"接口+适配器"降耦并按需启用。

- 关键路径转换:检索路径应保持同步低延迟;入库/解析/向量化应全量改为异步(队列+任务状态),当前尚未完全转化。

- 第三方依赖隔离:缺少统一的 Storage、VectorIndex、Cache、Queue 等接口抽象与适配层;无断路器/降级兜底。

- DNS 层利用率:未体现智能解析/健康检查/权重路由;建议利用权威 DNS 健康探测与低 TTL,配合边缘加速实现就近接入。

- 成熟组件优先:Go/Vue/MySQL/Redis/MinIO成熟度高;ParadeDB相对新,建议评估使用 pgvector(或成熟托管向量服务)以降低风险。

架构总评分(加权)

- 高可用 20%: 60 → 12

- 扩展性 15%: 75 → 11.25

- 性能 15%: 70 → 10.5

- 容错 15%: 55 → 8.25

- 数据 10%: 65 → 6.5

- 运维 15%: 60 → 9

- 规范 10%: 80 → 8

- 总分:65.5/100(约 66/100)

改进建议(优先级)

-

P0(两周内)

- 建立健康探针/优雅停机/超时与重试/限流/断路器,形成最小"弹性四件套"

- 以接口+适配器隔离 MinIO/向量库/Redis/队列;为每个依赖实现降级路径

- 将入库/解析/向量化改为异步队列,提供任务状态与回查接口

- 引入 outbox/幂等键,保障 MySQL 与向量库最终一致

- 实施多级缓存:读缓存(Redis+本地 LRU)、热点向量检索结果缓存、HTTP 缓存头

- API 契约化(OpenAPI)与契约测试,前后端解耦

-

P1(1-2 月)

- 评估以 Postgres+pgvector(或托管)替代 ParadeDB;前台检索引入 BM25 兜底

- 静态资源与下载链路接入 CDN;对象存储签名 URL/直传

- 可观测性全链路:指标、日志、追踪统一与告警

- 功能开关与按用户/流量维度灰度发布

-

P2(3 月+)

- 数据层 HA(读写分离、只读副本);依赖层快速切换(主备或多活)

- DNS 健康检查与权重路由,实现就近接入与失效转移

技术债务分析

-

依赖耦合:业务直接使用第三方 SDK,缺少 Provider 接口与适配器。影响替换与测试。修复:抽象接口+DI+适配器。

-

缺少弹性策略:无断路器/重试/超时/限流。影响故障隔离。修复:统一中间件与依赖包装。

-

一致性薄弱:无 outbox/补偿/幂等。影响数据正确性。修复:事件表+工作器+幂等键。

-

可观测性不足:指标/日志/追踪未统一。影响定位。修复:统一埋点与告警。

-

发布风险:无灰度/特性开关。影响稳定性。修复:特性开关与多版本路由。

-

向量库成熟度:ParadeDB 风险偏高。修复:评估迁移至更成熟方案或增强冗余。

-

配置管理:集中配置文件,缺少分环境与热更新。修复:分环境加载与安全注入。

实施计划

为 Go 服务新增 /healthz 与 /readyz,并集成优雅停机(context + server.Shutdown)

实现请求超时预算(context.WithTimeout)与依赖层统一超时配置

新增限流中间件(令牌桶)并按路由设定配额

引入断路器与指数退避重试封装(依赖客户端统一包装)

定义 Storage 接口(Put/Get/SignedURL),实现 MinIO 适配器与可插拔注册

定义 VectorIndex 接口(Upsert/Search/BatchUpsert),实现 ParadeDB 与 pgvector 适配器

定义 Cache 接口(Get/Set/TTL),实现本地 LRU 与 Redis 适配器

定义 Queue 接口(Publish/Consume/Ack),实现基于 Redis Streams 的适配器

将文档解析/向量化改为生产队列消息,新增 Go Worker 消费与并发控制

新增任务状态表与查询 API,前端可轮询查看处理进度

实现 outbox 表与事务写入,编写 outbox 扫描与投递工作器

为写入接口增加幂等键与去重存储,避免重复处理

在检索链路加入多级缓存:查询归一化键 → Redis → 本地 LRU → 命中即返回

添加检索降级路径(向量失败时回退 BM25/关键词检索)

为对象下载与静态文件返回设置 Cache-Control/Etag/压缩

编写 OpenAPI 注解与生成脚本,启用契约测试(根据 OpenAPI 校验)

统一日志/指标/追踪埋点,输出关键 SLI(P99 延迟、错误率、队列滞留)

提供特性开关模块(配置驱动),对新检索/新向量适配器做灰度开关

新增依赖自检端点(DB/Redis/对象存储/向量库),供 DNS/健康探针使用

实现签名上传与直传后回调校验,减少后端带宽占用

为所有依赖客户端增加超时/重试/断路器默认值与可配置项。

SAAM提示词

深入分析与评估 # 角色:软件架构分析方法SAAM专家 # 简介:资深软件架构分析专家,专注于软件架构评估与分析领域。对SAAM(Software Architecture Analysis Method)方法有深入研究和丰富实践经验,能够运用该方法系统地评估软件架构对特定质量属性(如可修改性、可移植性、性能等)的支持程度,帮助团队在早期发现架构潜在问题,做出合理架构决策。 # 技能: - SAAM方法深度掌握 - 软件架构质量属性分析 - 架构场景识别与评估 - 架构决策影响分析 - 风险识别与缓解 - 架构改进方案设计 # 规则: - 严格遵循SAAM方法的步骤和原则 - 聚焦软件架构对关键质量属性的影响 - 基于实际业务需求和场景进行分析 - 客观评估架构的优缺点 - 提供可行的架构改进建议 让我们一步一步进行SAAM架构分析: # 工作流程(输出中间步骤和中间执行结果): 1. 架构描述 : - 收集软件架构相关文档和资料 - 与架构师和开发团队沟通,获取架构详细信息 - 以清晰、准确的方式描述软件架构,包括组件、连接件、约束等要素 - 绘制架构图(如组件图、部署图等)辅助理解 2. 场景开发 : - 与利益相关者(如用户、客户、开发人员等)交流,了解他们的需求和期望 - 识别与软件架构相关的关键场景,包括用例场景(正常使用情况)和变更场景(如功能扩展、技术升级等) - 对场景进行详细描述,包括场景的目标、参与者、前置条件、后置条件等 - 对场景进行分类和优先级排序,确定重点关注的场景 3. 场景评估 : - 针对每个场景,分析软件架构如何支持该场景的实现 - 评估架构在满足场景需求方面的能力,考虑架构的灵活性、可扩展性、可维护性等因素 - 识别架构在支持场景时可能存在的问题和风险,如性能瓶颈、兼容性问题等 - 为每个场景的评估结果进行记录和总结 4. 架构视图分析 : - 从不同的架构视图(如逻辑视图、开发视图、进程视图、物理视图等)分析架构对场景的支持情况 - 评估各个视图之间的交互和影响,以及它们对整体架构质量属性的贡献 - 识别架构视图中可能存在的薄弱环节和改进机会 5. 质量属性分析 : - 确定与软件架构相关的关键质量属性,如可修改性、可移植性、性能、安全性、可靠性等 - 分析架构对每个质量属性的支持程度,通过场景评估和架构视图分析的结果进行综合判断 - 识别影响质量属性的关键因素和架构决策 - 对质量属性进行量化评估(如果可能),如性能指标、可修改性成本等 6. 风险识别与评估 : - 基于场景评估和架构分析的结果,识别软件架构中存在的潜在风险,如技术风险、业务风险、管理风险等 - 评估每个风险的发生可能性和影响程度,确定风险的优先级 - 分析风险产生的原因和可能的后果,为风险缓解提供依据 7. 架构改进建议: - 根据场景评估、质量属性分析和风险识别的结果,提出针对性的架构改进建议 - 改进建议应具体、可行,能够解决架构中存在的问题和风险,提高架构对质量属性的支持程度 - 对改进建议进行优先级排序,确定首先实施的改进措施 - 制定架构改进计划,包括改进的时间节点、责任人、资源需求等 # 输出格式: - 完整的SAAM架构分析报告,包含以下内容: - 架构描述文档(包括架构图和详细说明) - 场景清单(包括场景描述、分类和优先级排序) - 场景评估结果(每个场景的评估分析和建议) - 架构视图分析报告(各个视图的评估和交互分析) - 质量属性分析报告(关键质量属性的评估和量化结果) - 风险识别与评估报告(风险清单、优先级排序和影响分析) - 架构改进建议和计划(具体的改进建议、优先级和实施计划) - 总结与结论(对架构整体评估的总结和决策建议) # 关键要点: - 场景是SAAM方法的核心,要确保场景的代表性和完整性 - 架构分析要全面,涵盖架构的各个层面和视图 - 质量属性分析要与业务需求和实际场景紧密结合 - 风险识别要客观、准确,改进建议要具有可操作性 - 整个分析过程要与利益相关者保持密切沟通,确保分析结果的认可和可实施性

SAAM 架构分析报告(摘要版)

一、架构描述

-

系统定位:知识库 / RAG 平台。后端为 Go(gin),前端 Vue3,文档解析服务为独立 Python(docreader),检索支持 Postgres/Parade/Elasticsearch,可选 Redis/MinIO,部署以 Docker/compose 为主。

-

主要组件与连接

- API 层(gin):中间件(日志/Tracing/请求ID/Auth/Recovery),健康接口 /health,优雅停机。

- 依赖注入(dig):初始化 tracer、DB、文件服务、ants goroutine pool、检索引擎 Registry、外部 clients(DocReader、Ollama)、stream manager。

- 检索层:RetrieveEngineRegistry(支持 postgres、elasticsearch_v7/v8),KnowledgeBaseService/HybirdSearch。

- 存储适配器:FileService(MinIO/COS/local/dummy)。

- 异步/队列:asynq(internal/common/asyncq.go)作为任务队列,Redis stream + RedisStreamManager 支持会话流管理。

- Chat pipeline:事件驱动插件(search、rerank、merge、stream filter、completion 等),返回流 channel。

- 并发池:ants,用于工作并发控制。

-

约束:大量依赖环境变量;以容器为部署单元;代码中已有 tracing,但缺少明确 readiness probe 与依赖自检端点。

二、场景清单(优先级已排序)用例场景(正常使用)

- 在线问答检索(KnowledgeQA,流式返回) --- 高

- 批量导入文档并向量化(后台吞吐) --- 高

- 单文件上传/下载(签名直传优化) --- 中 变更/演进场景

- 替换/切换向量存储(pgvector/Parade/托管) --- 中高

- 异地部署以支持就近接入(GeoDNS/多区域) --- 中

- 第三方不可用降级(DocReader/Model/ES) --- 中

三、场景评估(每个场景给出支持度、证据、评分 0-5、主要风险与建议)(采用首轮质量属性优先级:性能/扩展性 > 可用性/可靠性 > 可修改性)

- 在线问答检索(KnowledgeQA / 流式)

-

支持度与证据:

- 事件驱动 pipeline(session.KnowledgeQA -> KnowledgeQAByEvent -> eventManager.Trigger)和 PluginSearch(internal/application/service/chat_pipline/search.go)体现检索链路;PluginStreamFilter 支持流式通道(stream_filter.go)。

- tracing 与 logging 已集成(container.initTracer / middleware)。

-

评分:性能 4 / 可用性 3 / 可修改性 4

-

风险:缺少统一超时/断路器、无全链路缓存、无就绪探针、无请求限流(可能导致模型阻塞导致资源耗尽)。

-

建议(优先):统一客户端包装(超时/重试/断路器);请求级 context 超时与路由限流;缓存层(Redis+local LRU);就绪探针。

- 批量导入与向量化

-

支持度与证据:

- 存在 asynq 初始化(internal/common/asyncq.go)与 RedisStreamManager,但尚未在 handler 层明确将导入任务入队(需进一步在 handler/knowledge.go 中确认);ants 池用于并发控制。

-

评分:可扩展性 3 / 容错一致性 2.5 / 可运维性 3

-

风险:任务状态与幂等、outbox 缺失;可能同步/阻塞导致在线服务受影响。

-

建议(优先):确保导入流程入队(asynq),实现 task table(状态/错误/幂等键)、outbox 模式保障事务一致性;独立 worker 容器化并隔离资源。

- 单文件上传/下载

- 支持度与证据:FileService 抽象(container.initFileService),支持 MinIO/COS/local;前端提供上传逻辑(frontend),但后端未见签名直传实现。

- 评分:性能 3.5 / 成本优化 3

- 风险:后端带宽压力,缺签名直传回调。

- 建议:实现预签名 URL 签名上传 + 回调校验,设置 Cache-Control/Etag。

- 替换向量存储

- 支持度:RetrieveEngineRegistry 与适配器化设计支持多后端,代码显示有迁移脚本(migrations/paradedb),适配性好。

- 评分:可修改性 4.5

- 风险:不同向量库性能/语义差异,需兼容层与契约测试。

- 建议:定义 VectorIndex 接口并实现适配器,添加集成测试。

- 异地就近接入

- 支持度:代码未体现跨区策略,需 infra(DNS/LoadBalancer/K8s)配合。

- 评分:可用性/灾备 2

- 风险:数据同步、向量一致性、跨区延迟。

- 建议:多活读策略、异步复制、GeoDNS/Anycast、基于地域的缓存与只读副本。

- 第三方降级

- 支持度:部分降级逻辑(ErrSearchNothing fallback);但外部 client 无统一断路器。

- 评分:容错 3

- 建议:引入熔断/退避、降级策略和熔断监控。

四、架构视图分析

- 逻辑视图:模块化清晰:handler -> service -> repository -> adaptors(file/retriever/model)与 chat pipeline 插件化。优点:高内聚、低耦合,易替换组件。缺点:部分横切关注点(超时/限流/断路)未集中。

- 开发视图:使用 dig 进行 DI,代码组织合理;接口与适配器设计(FileService、RetrieveEngineRegistry)利于替换。缺点:客户端初始化直接依赖环境变量,缺少工厂层统一策略和测试桩。

- 进程/运行时视图:单进程 API 容器 + asynq worker + docreader 服务;并发由 ants 管理。需补充:就绪探针、健康检查对依赖的检测、资源隔离(CPU/GPU/内存)策略。

- 物理/部署视图:推荐 N 个 API 容器后面接 DB/ES/Redis/MinIO;建议将 heavy worker 与推理服务独立容器或专用节点(GPU/高内存),并以 Kubernetes + Horizontal Pod Autoscaler + PodDisruptionBudget 管理。

五、质量属性量化(示例评分,0-5)(基于默认优先级:性能/扩展性 > 可用性 > 可修改性)

- 性能(延迟/吞吐):4.0 (流式与并发池良好,缺缓存与超时策略)

- 扩展性:4.0 (横向组件化好,需 infra 支撑自动扩缩)

- 可用性/可靠性:3.0 (有降级点,但缺断路/ready探针/多区策略)

- 可修改性/可演进性:4.0 (适配器/DI/插件化设计友好)

- 可观测性/运维性:3.0 (tracing 已有,缺 SLIs、任务队列监控、告警)

- 数据一致性/容错:2.8 (缺 outbox/事务消息一致性、幂等)

- 安全性:3.0 (基础鉴权存在,但需更严格的密钥管理与审计)

六、风险识别与评估(优先级排序)

- 依赖不可用导致在线服务阻塞(高概率×高影响) --- 缓解:断路器、超时、降级。

- 数据不一致(导入/索引重复)与无幂等(中概率×高影响) --- 缓解:outbox、task table、幂等键。

- 资源耗尽(模型长时间调用/无限并发)--- 缓解:请求超时、限流、工作池隔离。

- 部署/滚动更新导致流量发送到未就绪实例 --- 缓解:加入 /ready 与依赖自检。

- 向量库替换兼容性问题(低概率×中影响) --- 缓解:适配器+契约测试。

七、架构改进建议与优先级(高/中/低)与粗略实施估算高优先(1-4 周)

- 引入请求级 timeout(context.WithTimeout)与统一依赖超时配置(实现点:middleware + client wrappers)。影响大、实现难度低。

- 为外部依赖实现统一客户端封装(超时/重试/指数退避/断路器,如 github.com/sony/gobreaker 或 resilience),并替换关键调用(retriever/model/docreader)。中等难度。

- 增加 /ready 与 /healthz,依赖自检端点(DB/Redis/MinIO/向量)并集成到 LB 健康检查。简单实现。

- 在 handler 中确保批量导入走 asynq 队列,返回 task id;实现 task table(任务状态/错误/幂等键)。中等工作量。

中优先(2-8 周)

- 实现 outbox 模式(DB 写入 + outbox 投递器),保障事务一致性。较高难度,需要 DB schema 和投递 worker。

- 引入多级缓存(本地 LRU + Redis)在检索插件中优先查缓存并设置失效策略。中等难度。

- 增加队列/任务监控面板(Prometheus + Grafana + asynq exporter)与关键 SLI 报表(P99、err%, queue latency)。中等难度。

低优先(1-3 月)

- 异地多活部署与 GeoDNS、数据库复制/向量数据异步复制策略(复杂,需 infra 设计)。高复杂度。

- 将 heavy workers 与模型推理拆到独立集群(GPU 节点),实现资源隔离与弹性扩缩。

八、技术债务清单(优先级)

- 无 /ready、依赖自检(高)

- 依赖客户端缺断路器/统一超时(高)

- 导入流程缺 task table / 幂等 / outbox(高)

- 缓存缺失(中)

- 请求限流中间件缺失(中)

- 缺队列监控与 SLI 指标(中)

- DNS/就近接入策略未定义(低)

九、实施路线建议(迭代)阶段 A(0-2 周)- 快速有效改进

- 增加 /ready 与依赖自检、实现请求级 timeout 中间件、为关键客户端增加超时与基础重试、在 handler 里把大的导入任务改为入队并返回 task id、启用 asynq worker 简单 dashboard(asynqmon)。 阶段 B(2-6 周)- 容错与一致性加强

- 引入断路器/退避、实现 task table + 幂等键、实现 outbox 投递器、增加缓存层(Redis + local LRU)。 阶段 C(6-12 周)- 运维与多区

- SLI/监控完善(Prometheus/Grafana),队列滞留报警,多活/跨区设计评估与 PoC。 每一步都需定义回滚策略与集成测试(契约测试:检索接口、向量结果一致性)。

十、结论与建议决策

- 总体结论:架构总体良好,模块化、适配器与插件化设计使得可修改性与扩展性较强,采用成熟组件(Postgres/ES/Redis/MinIO/asynq)符合"成熟组件优先"。当前主要短板在"可用性/容错"与"数据一致性/任务幂等"方面。优先修补点为:就绪探针、请求超时/断路器、异步任务 + task table/outbox、限流与缓存。按上述优先级分阶段实施,能在短期内显著提升系统稳定性与可扩展性。

ATAM分析提示词

角色:

架构权衡分析方法ATAM专家

简介:

资深软件架构评估专家,专注于架构权衡分析领域。在ATAM(Architecture Tradeoff Analysis Method)方法的应用上拥有深厚的专业知识和丰富的实践经验,能够运用该方法全面评估软件架构在多个相互冲突的质量属性(如性能、可修改性、安全性等)之间的权衡关系,辅助团队做出科学合理的架构决策。

技能:

- ATAM方法精通

- 多质量属性权衡分析

- 架构场景深度挖掘

- 利益相关者需求协调

- 风险与敏感点识别

- 架构决策优化

规则:

- 严格遵循ATAM方法的流程和步骤

- 全面考虑各质量属性间的相互影响和权衡

- 深入了解利益相关者的需求和关注点

- 客观分析架构的优势、劣势和潜在风险

- 提供切实可行的架构改进建议和决策方案

让我们一步一步开展ATAM架构权衡分析:

工作流程(输出中间步骤和中间执行结果):

ATAM方法介绍与目标确定

向利益相关者介绍ATAM方法的基本原理、流程和预期输出

与项目团队和利益相关者共同明确分析的目标,如评估架构对特定业务目标的支持程度、识别关键的架构权衡点等

确定参与分析的各方角色和职责

架构描述收集与呈现

收集软件架构的相关文档,包括架构设计文档、组件图、部署图等

与架构师沟通,获取架构的详细信息,如架构风格、组件交互方式、技术选型等

以清晰易懂的方式向利益相关者呈现软件架构的总体描述,确保各方对架构有一致的理解

利益相关者需求获取

通过访谈、问卷调查等方式,与不同类型的利益相关者(如用户、客户、开发人员、运维人员等)交流

了解他们对软件系统的需求和期望,特别是与质量属性相关的需求,如性能要求、可扩展性需求、安全性需求等

对收集到的需求进行整理和分类,明确各需求的重要性和优先级

质量属性识别与优先级排序

基于利益相关者的需求,识别出对软件系统至关重要的质量属性,常见的有性能、可修改性、可移植性、安全性、可靠性、可用性等

与利益相关者共同对这些质量属性进行优先级排序,确定哪些属性在当前项目中最为关键

分析各质量属性之间的相互关系,识别可能存在的冲突和权衡点

架构场景开发

结合利益相关者的需求和质量属性,识别与架构决策相关的关键场景

场景分为用例场景(描述系统正常运行时的典型情况)和变更场景(描述系统在未来可能发生的变更情况,如功能扩展、技术升级等)

对每个场景进行详细描述,包括场景的参与者、目标、前置条件、后置条件、事件流等

对场景进行分类和优先级排序,确定重点关注的场景

架构视图分析与场景评估

从不同的架构视图(如逻辑视图、开发视图、进程视图、物理视图等)对软件架构进行分析,了解架构在不同层面的设计和实现细节

针对每个场景,评估架构对该场景的支持程度,分析架构在满足场景需求时所采取的设计决策和实现方式

识别架构在支持场景过程中可能存在的问题、风险和约束,如性能瓶颈、可修改性困难、安全隐患等

记录每个场景的评估结果,包括架构的优势、劣势和潜在的改进点

敏感点与权衡点分析

敏感点是指架构中某个设计决策或组件对某个质量属性有显著影响的点

权衡点是指架构中需要在多个相互冲突的质量属性之间进行权衡的点

通过分析架构场景的评估结果,识别架构中的敏感点和权衡点

对每个敏感点和权衡点进行深入分析,了解其对质量属性的影响程度和相互关系

记录敏感点和权衡点的详细信息,包括其位置、影响范围、相关质量属性等

风险识别与评估

基于敏感点和权衡点的分析,识别架构中存在的潜在风险,如技术风险、业务风险、管理风险等

对每个风险进行评估,分析其发生的可能性和影响程度,确定风险的优先级

分析风险产生的原因和可能的后果,为风险应对提供依据

架构决策与改进建议

根据场景评估、敏感点与权衡点分析以及风险识别的结果,与利益相关者共同探讨可行的架构决策和改进方案

架构决策应综合考虑各质量属性的需求和权衡关系,以实现整体的最优解

改进建议应具体、可行,能够解决架构中存在的问题和风险,提高架构对质量属性的支持程度

对架构决策和改进建议进行优先级排序,确定首先实施的措施

制定架构改进计划,包括改进的时间节点、责任人、资源需求等

输出格式:

- 完整的ATAM架构权衡分析报告,包含以下内容:

- ATAM分析概述(包括目标、参与人员、流程概述)

- 架构描述(包括架构图、架构设计思路等)

- 利益相关者需求分析(需求清单、优先级排序)

- 质量属性分析(质量属性清单、优先级排序、相互关系)

- 架构场景分析(场景清单、场景描述、优先级排序、评估结果)

- 架构视图分析(各视图描述、与场景的关联)

- 敏感点与权衡点分析(敏感点清单、权衡点清单、详细分析)

- 风险识别与评估(风险清单、优先级排序、影响分析)

- 架构决策与改进建议(决策方案、改进建议、优先级排序、实施计划)

- 总结与结论(分析总结、决策建议、后续展望)

关键要点:

- 利益相关者的参与至关重要,要确保他们的需求和关注点得到充分考虑

- 质量属性的识别和权衡是ATAM方法的核心,要深入分析各属性之间的关系

- 架构场景的开发和评估要贴合实际业务情况,具有代表性和针对性

- 敏感点和权衡点的分析要准确、深入,为架构决策提供有力依据

- 风险评估要客观、全面,改进建议要具有可操作性和可衡量性

- 整个分析过程要保持与利益相关者的密切沟通,确保分析结果得到认可和有效实施

SAAM 架构分析报告(摘要版)

一、架构描述

-

系统定位:知识库 / RAG 平台。后端为 Go(gin),前端 Vue3,文档解析服务为独立 Python(docreader),检索支持 Postgres/Parade/Elasticsearch,可选 Redis/MinIO,部署以 Docker/compose 为主。

-

主要组件与连接

- API 层(gin):中间件(日志/Tracing/请求ID/Auth/Recovery),健康接口 /health,优雅停机。

- 依赖注入(dig):初始化 tracer、DB、文件服务、ants goroutine pool、检索引擎 Registry、外部 clients(DocReader、Ollama)、stream manager。

- 检索层:RetrieveEngineRegistry(支持 postgres、elasticsearch_v7/v8),KnowledgeBaseService/HybirdSearch。

- 存储适配器:FileService(MinIO/COS/local/dummy)。

- 异步/队列:asynq(internal/common/asyncq.go)作为任务队列,Redis stream + RedisStreamManager 支持会话流管理。

- Chat pipeline:事件驱动插件(search、rerank、merge、stream filter、completion 等),返回流 channel。

- 并发池:ants,用于工作并发控制。

-

约束:大量依赖环境变量;以容器为部署单元;代码中已有 tracing,但缺少明确 readiness probe 与依赖自检端点。

二、场景清单(优先级已排序)用例场景(正常使用)

- 在线问答检索(KnowledgeQA,流式返回) --- 高

- 批量导入文档并向量化(后台吞吐) --- 高

- 单文件上传/下载(签名直传优化) --- 中 变更/演进场景

- 替换/切换向量存储(pgvector/Parade/托管) --- 中高

- 异地部署以支持就近接入(GeoDNS/多区域) --- 中

- 第三方不可用降级(DocReader/Model/ES) --- 中

三、场景评估(每个场景给出支持度、证据、评分 0-5、主要风险与建议)(采用首轮质量属性优先级:性能/扩展性 > 可用性/可靠性 > 可修改性)

- 在线问答检索(KnowledgeQA / 流式)

-

支持度与证据:

- 事件驱动 pipeline(session.KnowledgeQA -> KnowledgeQAByEvent -> eventManager.Trigger)和 PluginSearch(internal/application/service/chat_pipline/search.go)体现检索链路;PluginStreamFilter 支持流式通道(stream_filter.go)。

- tracing 与 logging 已集成(container.initTracer / middleware)。

-

评分:性能 4 / 可用性 3 / 可修改性 4

-

风险:缺少统一超时/断路器、无全链路缓存、无就绪探针、无请求限流(可能导致模型阻塞导致资源耗尽)。

-

建议(优先):统一客户端包装(超时/重试/断路器);请求级 context 超时与路由限流;缓存层(Redis+local LRU);就绪探针。

- 批量导入与向量化

-

支持度与证据:

- 存在 asynq 初始化(internal/common/asyncq.go)与 RedisStreamManager,但尚未在 handler 层明确将导入任务入队(需进一步在 handler/knowledge.go 中确认);ants 池用于并发控制。

-

评分:可扩展性 3 / 容错一致性 2.5 / 可运维性 3

-

风险:任务状态与幂等、outbox 缺失;可能同步/阻塞导致在线服务受影响。

-

建议(优先):确保导入流程入队(asynq),实现 task table(状态/错误/幂等键)、outbox 模式保障事务一致性;独立 worker 容器化并隔离资源。

- 单文件上传/下载

- 支持度与证据:FileService 抽象(container.initFileService),支持 MinIO/COS/local;前端提供上传逻辑(frontend),但后端未见签名直传实现。

- 评分:性能 3.5 / 成本优化 3

- 风险:后端带宽压力,缺签名直传回调。

- 建议:实现预签名 URL 签名上传 + 回调校验,设置 Cache-Control/Etag。

- 替换向量存储

- 支持度:RetrieveEngineRegistry 与适配器化设计支持多后端,代码显示有迁移脚本(migrations/paradedb),适配性好。

- 评分:可修改性 4.5

- 风险:不同向量库性能/语义差异,需兼容层与契约测试。

- 建议:定义 VectorIndex 接口并实现适配器,添加集成测试。

- 异地就近接入

- 支持度:代码未体现跨区策略,需 infra(DNS/LoadBalancer/K8s)配合。

- 评分:可用性/灾备 2

- 风险:数据同步、向量一致性、跨区延迟。

- 建议:多活读策略、异步复制、GeoDNS/Anycast、基于地域的缓存与只读副本。

- 第三方降级

- 支持度:部分降级逻辑(ErrSearchNothing fallback);但外部 client 无统一断路器。

- 评分:容错 3

- 建议:引入熔断/退避、降级策略和熔断监控。

四、架构视图分析

- 逻辑视图:模块化清晰:handler -> service -> repository -> adaptors(file/retriever/model)与 chat pipeline 插件化。优点:高内聚、低耦合,易替换组件。缺点:部分横切关注点(超时/限流/断路)未集中。

- 开发视图:使用 dig 进行 DI,代码组织合理;接口与适配器设计(FileService、RetrieveEngineRegistry)利于替换。缺点:客户端初始化直接依赖环境变量,缺少工厂层统一策略和测试桩。

- 进程/运行时视图:单进程 API 容器 + asynq worker + docreader 服务;并发由 ants 管理。需补充:就绪探针、健康检查对依赖的检测、资源隔离(CPU/GPU/内存)策略。

- 物理/部署视图:推荐 N 个 API 容器后面接 DB/ES/Redis/MinIO;建议将 heavy worker 与推理服务独立容器或专用节点(GPU/高内存),并以 Kubernetes + Horizontal Pod Autoscaler + PodDisruptionBudget 管理。

五、质量属性量化(示例评分,0-5)(基于默认优先级:性能/扩展性 > 可用性 > 可修改性)

- 性能(延迟/吞吐):4.0 (流式与并发池良好,缺缓存与超时策略)

- 扩展性:4.0 (横向组件化好,需 infra 支撑自动扩缩)

- 可用性/可靠性:3.0 (有降级点,但缺断路/ready探针/多区策略)

- 可修改性/可演进性:4.0 (适配器/DI/插件化设计友好)

- 可观测性/运维性:3.0 (tracing 已有,缺 SLIs、任务队列监控、告警)

- 数据一致性/容错:2.8 (缺 outbox/事务消息一致性、幂等)

- 安全性:3.0 (基础鉴权存在,但需更严格的密钥管理与审计)

六、风险识别与评估(优先级排序)

- 依赖不可用导致在线服务阻塞(高概率×高影响) --- 缓解:断路器、超时、降级。

- 数据不一致(导入/索引重复)与无幂等(中概率×高影响) --- 缓解:outbox、task table、幂等键。

- 资源耗尽(模型长时间调用/无限并发)--- 缓解:请求超时、限流、工作池隔离。

- 部署/滚动更新导致流量发送到未就绪实例 --- 缓解:加入 /ready 与依赖自检。

- 向量库替换兼容性问题(低概率×中影响) --- 缓解:适配器+契约测试。

七、架构改进建议与优先级(高/中/低)与粗略实施估算高优先(1-4 周)

- 引入请求级 timeout(context.WithTimeout)与统一依赖超时配置(实现点:middleware + client wrappers)。影响大、实现难度低。

- 为外部依赖实现统一客户端封装(超时/重试/指数退避/断路器,如 github.com/sony/gobreaker 或 resilience),并替换关键调用(retriever/model/docreader)。中等难度。

- 增加 /ready 与 /healthz,依赖自检端点(DB/Redis/MinIO/向量)并集成到 LB 健康检查。简单实现。

- 在 handler 中确保批量导入走 asynq 队列,返回 task id;实现 task table(任务状态/错误/幂等键)。中等工作量。

中优先(2-8 周)

- 实现 outbox 模式(DB 写入 + outbox 投递器),保障事务一致性。较高难度,需要 DB schema 和投递 worker。

- 引入多级缓存(本地 LRU + Redis)在检索插件中优先查缓存并设置失效策略。中等难度。

- 增加队列/任务监控面板(Prometheus + Grafana + asynq exporter)与关键 SLI 报表(P99、err%, queue latency)。中等难度。

低优先(1-3 月)

- 异地多活部署与 GeoDNS、数据库复制/向量数据异步复制策略(复杂,需 infra 设计)。高复杂度。

- 将 heavy workers 与模型推理拆到独立集群(GPU 节点),实现资源隔离与弹性扩缩。

八、技术债务清单(优先级)

- 无 /ready、依赖自检(高)

- 依赖客户端缺断路器/统一超时(高)

- 导入流程缺 task table / 幂等 / outbox(高)

- 缓存缺失(中)

- 请求限流中间件缺失(中)

- 缺队列监控与 SLI 指标(中)

- DNS/就近接入策略未定义(低)

九、实施路线建议(迭代)阶段 A(0-2 周)- 快速有效改进

- 增加 /ready 与依赖自检、实现请求级 timeout 中间件、为关键客户端增加超时与基础重试、在 handler 里把大的导入任务改为入队并返回 task id、启用 asynq worker 简单 dashboard(asynqmon)。 阶段 B(2-6 周)- 容错与一致性加强

- 引入断路器/退避、实现 task table + 幂等键、实现 outbox 投递器、增加缓存层(Redis + local LRU)。 阶段 C(6-12 周)- 运维与多区

- SLI/监控完善(Prometheus/Grafana),队列滞留报警,多活/跨区设计评估与 PoC。 每一步都需定义回滚策略与集成测试(契约测试:检索接口、向量结果一致性)。

十、结论与建议决策

- 总体结论:架构总体良好,模块化、适配器与插件化设计使得可修改性与扩展性较强,采用成熟组件(Postgres/ES/Redis/MinIO/asynq)符合"成熟组件优先"。当前主要短板在"可用性/容错"与"数据一致性/任务幂等"方面。优先修补点为:就绪探针、请求超时/断路器、异步任务 + task table/outbox、限流与缓存。按上述优先级分阶段实施,能在短期内显著提升系统稳定性与可扩展性。

总结

通过GPT5+整合工程上下文,缺失可以节省我们熟悉项目工程结构的时间。不论我们采用2种架构分析评估方法SAAM/ATAM,还是互联网系统26原则分析。都是可以系统分析与参考的价值。其中技术名词,只要背景知识才能明白。