了解更多详情,关注公众号:金众诚科技

在企业数字化架构中,主数据管理(Master Data Management, MDM)平台的核心价值在于构建一个单一可信 数据源 (Single Source of Truth),确保关键业务实体(如客户、物料、供应商、产品等)在整个组织内的一致性与权威性。然而,随着企业信息化建设的深入,一个普遍且棘手的问题浮出水面:当 主数据平台 需要服务数十甚至上百个下游系统时,如何高效、可靠、实时地完成数据下发?

这一问题在大型制造、零售、金融、医疗等行业尤为突出。IT架构师和系统集成团队常常面临"一对多"数据分发的复杂性挑战:下游系统技术栈各异、数据格式不一、更新频率不同、网络环境复杂。若处理不当,轻则导致数据延迟、接口超时,重则引发业务中断或数据不一致。

本文将从企业IT实践角度,深入探讨主数据平台在面对多下游系统时的数据下发策略,并结合典型场景,分析如何通过高效的集成架构实现可扩展、高可用的数据分发体系。

多下游系统带来的典型挑战

系统异构性高

下游系统可能包括:

- 传统ERP(如SAP、Oracle)

- 云原生SaaS应用(如Salesforce、钉钉)

- 自研业务系统(Java、.NET)

- 工业控制系统(MES、SCADA)

- 数据分析平台(BI、数据仓库)

这些系统使用的通信协议(HTTP、JDBC、MQ)、数据格式(JSON、XML、EDI)、认证机制各不相同,统一接入难度大。

数据需求差异大

不同系统对主数据的需求存在显著差异:

- CRM系统需要完整的客户画像,包括联系方式、行业分类、历史订单;

- MES系统仅需客户编号和产品型号,用于生产排程;

- 财务系统关注客户信用额度和付款条件。

若统一推送全量数据,会造成网络带宽浪费和下游系统处理压力。

更新频率与实时性要求不同

- 销售系统要求客户信息变更后秒级同步,以支持实时报价;

- 报表系统可接受每日批量同步,用于生成经营分析;

- 档案系统仅需事件触发式归档,记录历史变更。

如何平衡实时性与系统负载,是架构设计的关键。

失败处理与重试机制缺失

当某个下游系统临时宕机或网络中断,主数据平台若无完善的错误处理机制,可能导致数据丢失或需人工干预恢复,影响整体数据一致性。

运维监控困难

缺乏统一的监控视图,难以追踪"某条客户数据是否已成功下发至所有目标系统",故障排查效率低。

主流数据下发模式对比

面对多下游系统,企业通常采用以下几种数据分发策略:

| 模式 | 说明 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| 点对点直连 | 主数据平台直接调用每个下游系统的API | 实现简单 | 耦合度高,新增系统需修改主数据平台代码 | 系统少于5个 |

| 批量文件导出 | 定时生成CSV/Excel文件,由下游系统定时拉取 | 降低实时性压力 | 延迟高,文件解析易出错 | 报表、归档类系统 |

| 消息队列(MQ) | 主数据变更发布为消息,下游系统订阅消费 | 解耦、异步、可扩展 | 需统一消息格式,增加运维复杂度 | 实时性要求高、系统多 |

| API网关+订阅机制 | 下游系统通过API订阅主数据变更,平台主动推送 | 灵活、可控 | 需维护订阅关系,推送失败需重试 | 中大型企业 |

构建可扩展的数据分发架构

为应对多下游系统的挑战,建议采用分层架构设计:

1. 统一数据出口层

主数据平台通过一个统一数据分发中心进行中转。该中心负责:

- 接收主数据变更事件(如"客户A已更新");

- 根据预设规则进行数据清洗、格式转换;

- 路由至不同的分发通道。

2. 多通道分发策略

- 实时通道:通过Kafka、RabbitMQ等消息中间件,将变更事件发布为消息,供实时系统(如CRM、MES)订阅。

- 批量通道:定时生成标准化数据包(JSON/CSV),通过FTP或API提供下载,供BI、数据仓库使用。

- API 查询通道:提供RESTful接口,供临时查询或补数使用。

3. 订阅与路由管理

建立"订阅注册表",记录每个下游系统的:

- 所需主数据类型(如仅客户、含客户+产品);

- 数据格式偏好(JSON Schema);

- 接收方式(MQ主题、API端点);

- 更新频率(实时、每日、每周)。

主数据平台根据订阅信息,按需分发,避免"全量广播"带来的资源浪费。

4. 失败处理与重试机制

- 消息发送失败时,自动进入重试队列,支持指数退避;

- 连续失败达到阈值,触发告警并记录至异常日志;

- 支持人工干预与手动重推。

5. 监控与审计

- 提供可视化监控面板,展示各系统数据同步状态、延迟时间、失败次数;

- 记录完整的数据流转日志,支持按主数据ID追溯分发路径;

- 定期生成数据一致性报告,供审计使用。

记录数据操作的日志信息,提供了完整的数据操作审计轨迹

技术实践:如何实现高效、稳定的分发?

事件驱动架构

采用"变更即事件"的设计理念。当主数据在MDM平台中被创建、更新或删除时,自动发布一个标准化事件(如CustomerUpdated),包含变更内容和元数据(操作人、时间)。下游系统作为"消费者",根据自身需求订阅相关事件。

优势:解耦、异步、可扩展,适合高并发场景。

数据格式 标准化

定义企业级主数据交换格式(如基于JSON Schema的通用模型),确保所有下游系统接收的数据结构一致。对于特殊需求,可在分发层进行"适配转换"。

接口认证支持Web API在线测试,可直接模拟请求、调试鉴权逻辑、实时验证Token有效性等。

异步非阻塞处理

数据分发过程应异步执行,避免阻塞主数据平台的核心业务流程。可采用线程池、消息队列等方式实现高吞吐量。

灰度发布与版本管理

当主数据模型变更(如客户新增"数据合规等级"字段),可先向部分系统灰度推送,验证无误后再全量发布,降低风险。

落地建议:如何选择主数据管理解决方案?

面对复杂的多系统环境,自研数据分发系统往往成本高、维护难。越来越多企业选择采用成熟的集成平台来承载主数据分发任务。

理想的平台应具备:

- 灵活的 主数据 建模能力:支持自定义客户、物料、供应商等模型;

- 丰富的连接器:预置与ERP、CRM、MES、数据库等系统的集成能力;

- 可视化规则配置:无需编码即可定义数据清洗、映射、转换逻辑;

- 多模式分发支持:同时支持定时任务、事件触发、API调用等多种同步方式;

- 高可用与监控:提供失败重试、告警、日志追踪等运维能力。

在此背景下,一些具有扩展性能的主数据管理解决方案,采用微服务架构,基于Spring Boot和Spring Cloud技术栈构建,集成了Swagger(API文档)、NGINX(反向代理)、Sentinel(流量控制)等多个核心组件 ,确保了系统的高可用性、可扩展性和灵活性,充分满足分布式应用场景下的严苛要求。

在部署层面,所有应用均采用容器化(Docker)部署模式,显著提升了部署效率与资源利用率,支持快速弹性伸缩,适应业务高峰期的数据分发压力。

更重要的是,支持轻松管理主数据模型、数据标准和清洗规则,实现跨系统主数据的统一管理。其核心能力在于支持基于定时任务 或事件触发,自动执行数据同步与分发,确保关键数据在复杂异构环境下的实时性与一致性。对于IT团队而言,这种"技术门槛低、可扩展"的设计,能够显著降低集成复杂度,快速响应业务变化,真正实现从"系统集成"到"数据驱动"的转型跃迁。

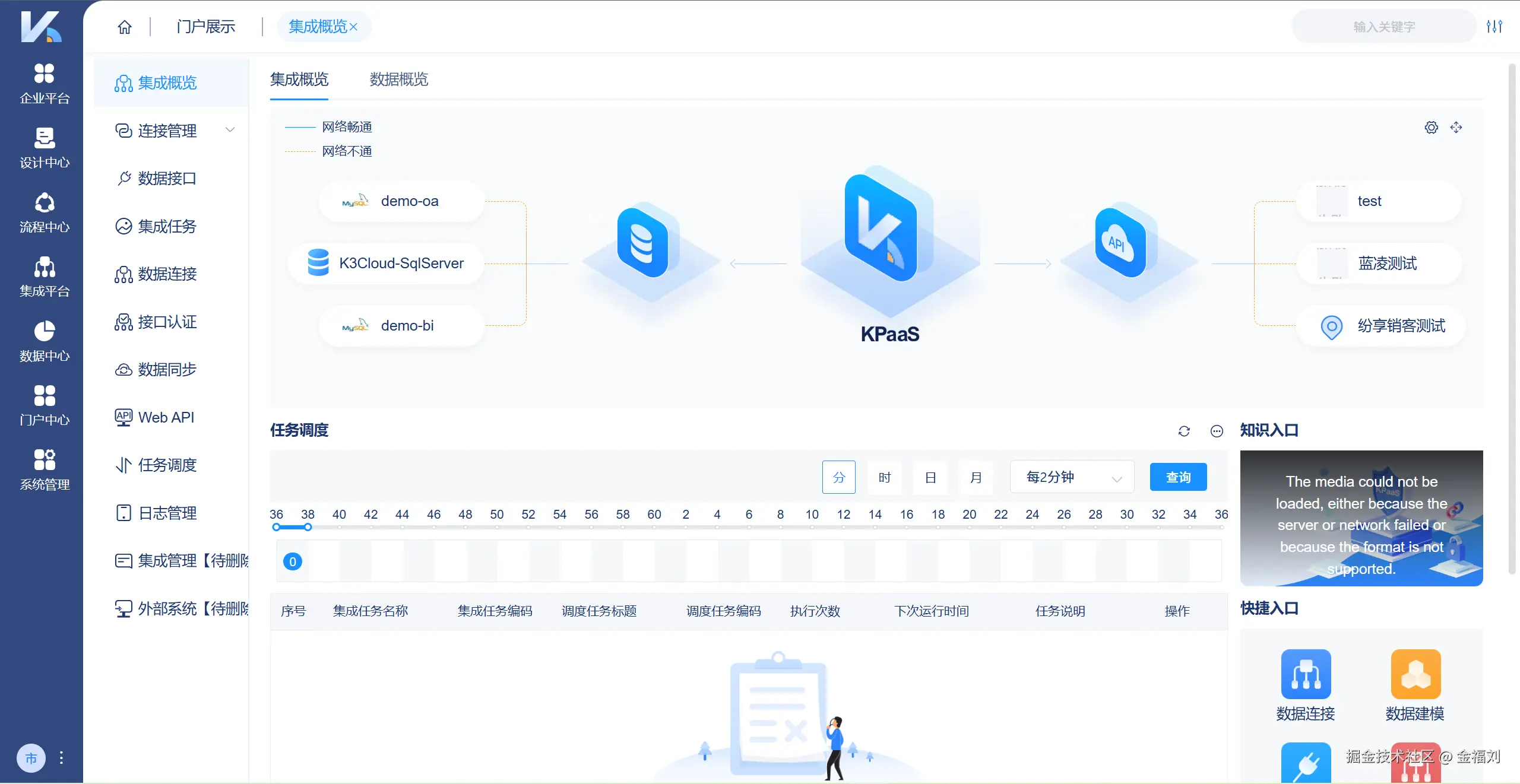

强大的数据集成能力,支持数据接口、连接、认证及同步,通过集成任务、Web API和智能调度实现高效数据流转,并配备完善日志管理,助力企业降本增效。

结语

主数据平台的价值不仅在于"集中管理",更在于"高效分发"。当下游系统数量增多,传统的点对点同步模式已难以为继。企业需要构建一个解耦 、灵活、可监控的数据分发体系,通过事件驱动、多通道分发、订阅管理等机制,实现主数据的精准、实时、可靠传递。

选择具备强大集成能力和高效技术架构的一站式解决方案,不仅是技术选型问题,更是提升企业数据治理能力、支撑业务敏捷性的战略决策。让主数据真正"流动起来",才能释放其作为企业核心资产的最大价值,助力企业在数字化竞争中赢得先机。

了解更多详情,关注公众号:金众诚科技