文心大模型的持续快速进化,得益于百度在芯片、框架、模型和应用上的全栈布局,尤其是飞桨深度学习框架和文心大模型的联合优化。

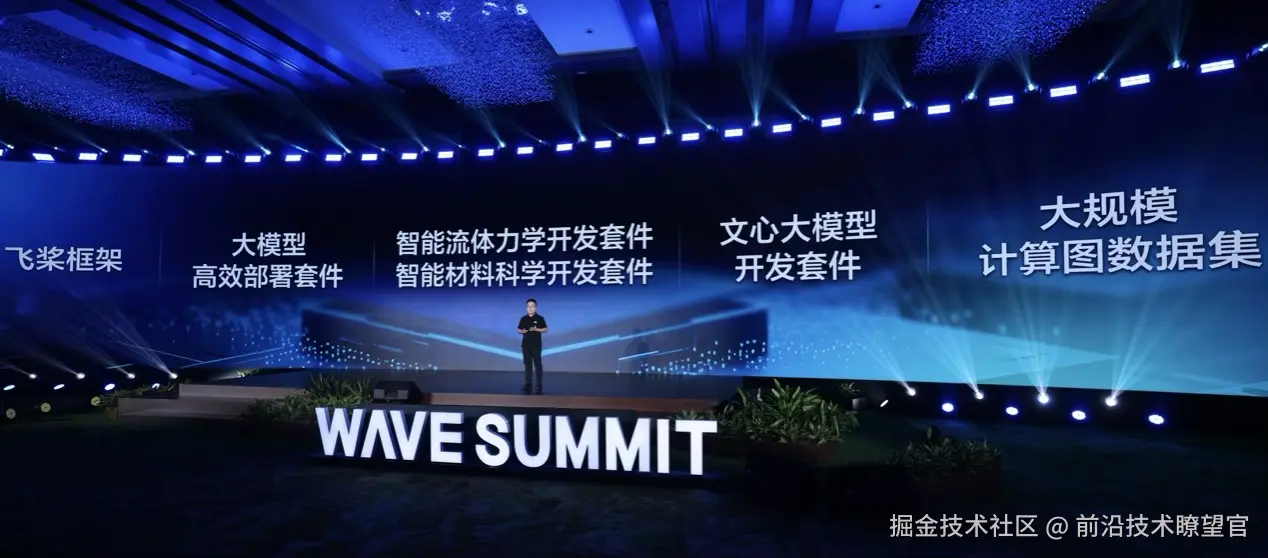

百度AI技术生态总经理马艳军正式对外发布飞桨(PaddlePaddle)框架v3.2,以及文心大模型开发套件ERNIEKit、大模型高效部署套件FastDeploy和两大AI科学计算套件PaddleCFD、PaddleMaterials,全面降低大模型从训练到部署的应用门槛。依托计算优化、并行策略和原生容错能力三大核心升级,飞桨框架v3.2突破大模型训练技术难题,显著提升了训练效率,在ERNIE-4.5-300B-A47B模型上实现预训练MFU达47%。同时,该版本强化了类CUDA芯片适配能力,实现了最高92%的算子内核复用率,并全面兼容Safetensors权重及生态加速库一键接入,显著降低部署成本。

百度AI技术生态总经理 马艳军

在推理部署侧,大模型高效部署套件FastDeploy通过模型压缩、推理和服务协同优化,显著提升端到端推理性能。基于该套件,ERNIE-4.5-300B-A47B模型在TPOT 50ms时延条件下,实现了输入57K tokens/秒、输出29K tokens/秒的高吞吐性能。

面向科研领域,PaddleCFD和 PaddleMaterials两大AI科学计算开发套件能够有效提升流体力学和材料科学领域的研发效率,缩短科研周期,并提升任务精度。

大会现场,百度开源了最新思考模型ERNIE-4.5-21B-A3B-Thinking,该模型是在ERNIE-4.5-21B-A3B基础上训练的深度思考模型,在内容创作、逻辑推理、数学计算、代码生成与工具调用等多个任务中表现卓越。此外,ERNIEKit文心大模型开发套件提供了更加便捷的模型后训练方案,仅需4张GPU即可对ERNIE-4.5-300B-A47B模型进行高效调优,进一步降低开发者将模型落地到实际应用的门槛;开源了大规模计算图数据集GraphNet,提供了超2700个模型计算图及标准化评测体系,填补了AI编译器测试基准的空白,助力优化设计与性能提升。