目录

-

- 环境准备

- 安装Ollama

- [使用 Pip 安装 Open-WebUI](#使用 Pip 安装 Open-WebUI)

- 配置服务以便开机启动

本次实验环境使用的openEuler 24.03 LTS SP2长期支持版本

Planned EOL: 2026/03

openEuler 24.03 LTS SP2 是基于6.6内核的LTS版本,面向服务器、云、边缘计算和嵌入式场景,提供更多新特性和功能,给开发者和用户带来全新的体验,服务更多的领域和更多的用户。

检查系统架构

bash

uname -m

cat /etc/os-release环境准备

为了确保顺利安装,需确认操作系统已更新至最新状态并安装必要的依赖包:

ssh

sudo su

yum update -y

sudo yum install vim tar -y安装Ollama

下载安装(下载太慢的可以考虑去TB店铺也就1元左右的代下载费用)

如果是x86_64

https://github.com/ollama/ollama/releases/download/v0.11.6/ollama-linux-amd64.tgz

如果是ARM64

https://github.com/ollama/ollama/releases/download/v0.11.6/ollama-linux-arm64.tgz

本地下载完成后进行上传

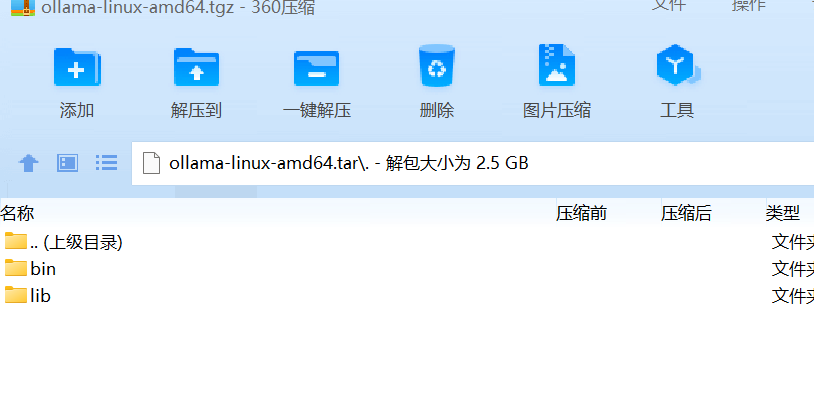

解压Ollama

找到文件名称为ollama-linux-amd64.tgz 的文件

文件结构如下图

压缩包直接解压到/usr目录下,可以省去配置环境变量的步骤

具体的解压命令如下:

bash

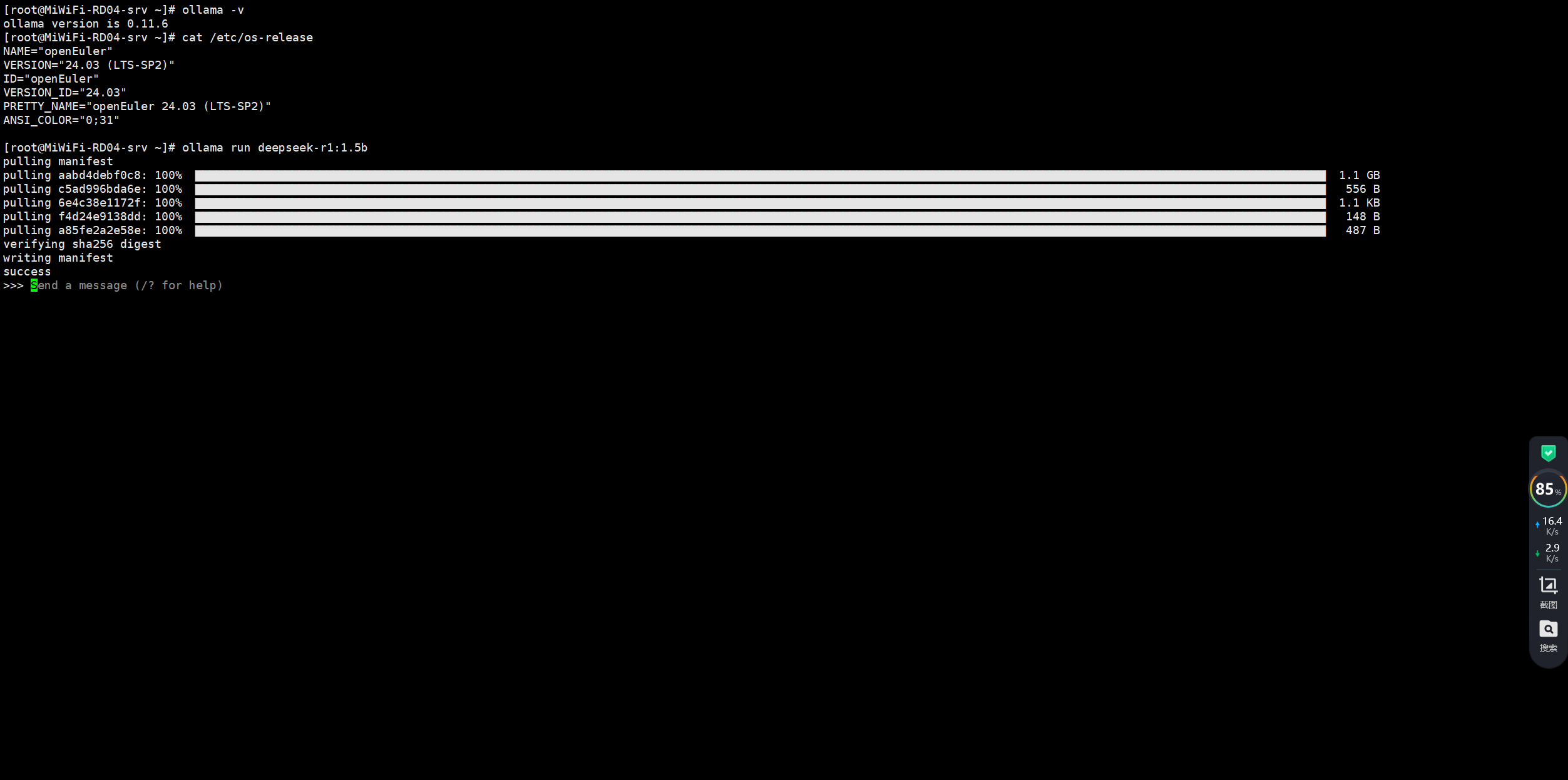

tar -xvf ollama-linux-amd64.tgz -C /usr校验ollama 是否安装成功

bash

ollama serve

ollama -v拉取deepseekR1:1.5b

bash

ollama run deepseek-r1:1.5b

使用 Pip 安装 Open-WebUI

按照官方文档指引,可以通过 Python 的包管理工具 pip 来安装 Open-WebUI 库。

先设置pypi源,不然下载速度慢得怀疑人生

bash

# 设置华为云镜像源

pip3 config set global.index-url https://repo.huaweicloud.com/repository/pypi/simple

pip3 config set global.trusted-host repo.huaweicloud.com

# 查看当前配置

pip3 config get global.index-url开始安装open-webui

bash

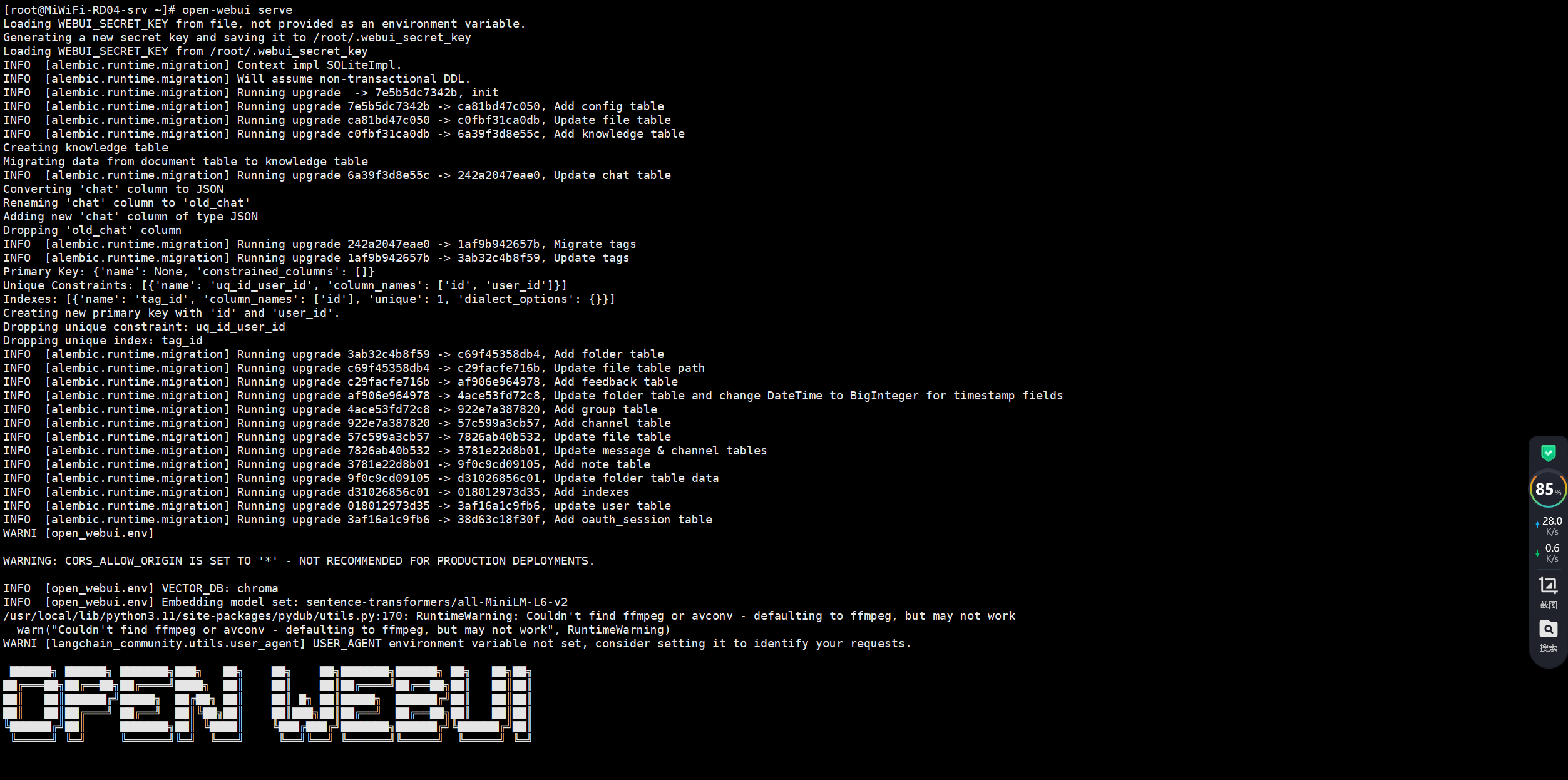

pip3 install open-webui启动 Open-WebUI

完成上述准备工作之后,在命令行输入

bash

open-webui serve

即可启动服务。此时应该可以在浏览器访问对应的端口查看到 Web UI 页面默认为 http://localhost:8080

配置服务以便开机启动

ollama服务

配置 ollama 服务

bash

vim /etc/systemd/system/ollama.service内容添加如下:

bash

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="PATH=$PATH"

#指定模型存储位置,可以直接在外网下载好模型,打包解压到内网的ollama的模型目录下,就能实现离线安装了

Environment="OLLAMA_MODELS=/home/ollama/models"

#解决ollama无法访问的问题

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=default.targetopen-webui服务

配置 DeepSeek

针对 DeepSeek 的具体配置文件路径通常位于 /etc/deepseek/config.yaml 或者项目根目录下的同名文件内。根据实际需求调整参数设置以适应生产环境的要求。

将两者集成在一起

为了让两个应用能够协同工作,可以考虑利用反向代理的方式让它们共享同一个域名的不同子路径;也可以直接修改其中一个项目的路由规则使其指向另一个的服务地址。具体的实现取决于所使用的框架和技术栈的选择。

常见问题及解决方案

Docker无法正常启动:可能是 SELinux 设置阻止了某些权限。尝试临时关闭它来排查问题

ssh

setenforce 0Pip 安装失败:检查网络连接状况,有时国内镜像源可能会更稳定一些。可通过指定 -i https://pypi.tuna.tsinghua.edu.cn/simple --trusted-host pypi.tuna.tsinghua.edu.cn参数切换为清华大学提供的 PyPI 源。

找不到特定版本的软件包:当遇到这种情况时,请查阅相关产品的发行说明或社区论坛获取更多信息和支持

Docker 安装

考虑到后续操作会涉及到容器技术,建议提前准备好 Docker 运行环境

- 卸载旧版本的Docker

bash

sudo yum remove docker \

docker-client \

docker-client-latest \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-engine- 安装必要的工具(yum-utils提供了yum-config-manager等工具)

bash

sudo yum install -y yum-utils device-mapper-persistent-data lvm2- 添加清华源(替换官方源)

bash

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo- 安装Docker

bash

sudo yum install -y docker-ce docker-ce-cli containerd.io- 启动Docker服务

bash

sudo systemctl start docker- 设置Docker开机启动

bash

sudo systemctl enable docker- 配置国内镜像加速器

bash

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://registry.docker-cn.com", "https://hub-mirror.c.163.com"]

}

EOF配置 ollama 服务

bash

vim /etc/systemd/system/ollama.service内容添加如下:

bash

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/opt/app/middles/ollama/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="PATH=$PATH"

#指定模型存储位置,可以直接在外网下载好模型,打包解压到内网的ollama的模型目录下,就能实现离线安装了

Environment="OLLAMA_MODELS=/opt/app/middles/ollama/models"

#解决ollama无法访问的问题

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=default.target启动服务:

bash

sudo systemctl daemon-reload

sudo systemctl enable ollama配置Ollama 全局环境变量

vi /etc/profile.d/ollama.sh

#ollama.sh内容如下

bash

PATH=$PATH:/opt/app/middles/ollama/bin

export PATH#刷新

source /etc/profile