引言

当你看到进度条像佛系养生时,是否怀疑过:

- 为何我写的 for 循环像在走红毯?

- pandas 一 groupby,内存像买房一样首付没了?

- 电脑 8 核在摸鱼,我的 Python 却独自搬砖?

- CSV、Parquet、Zarr 究竟该选谁?

- GPU 安装倒是成功了,就是没帮我跑快?

如果你点头超过两次,这本由清华大学出版社出版的新书《极速Python:高性能编码、计算与数据分析》很大概率就是你的"性能军火库"。

这本书要解决什么(用工程语言说人话)

- 写法提速:从算法与数据结构、内存访问模式入手,告诉你"为什么慢、该怎么改"

- 工具提速:系统串起 NumPy、pandas、Cython、Numba、Dask、Apache Arrow、Parquet、Zarr

- 硬件提速:教你用对多进程/多线程/向量化/GPU,量化收益而不是"玄学加速"

- 数据提速:I/O、序列化、零拷贝、列存格式,减少"在路上耗时"

- 成本提速:不仅跑得快,还要省内存、可维护、可复用、可迁移

一句话:从"代码---数据---硬件---工程化"四个维度立体提速。

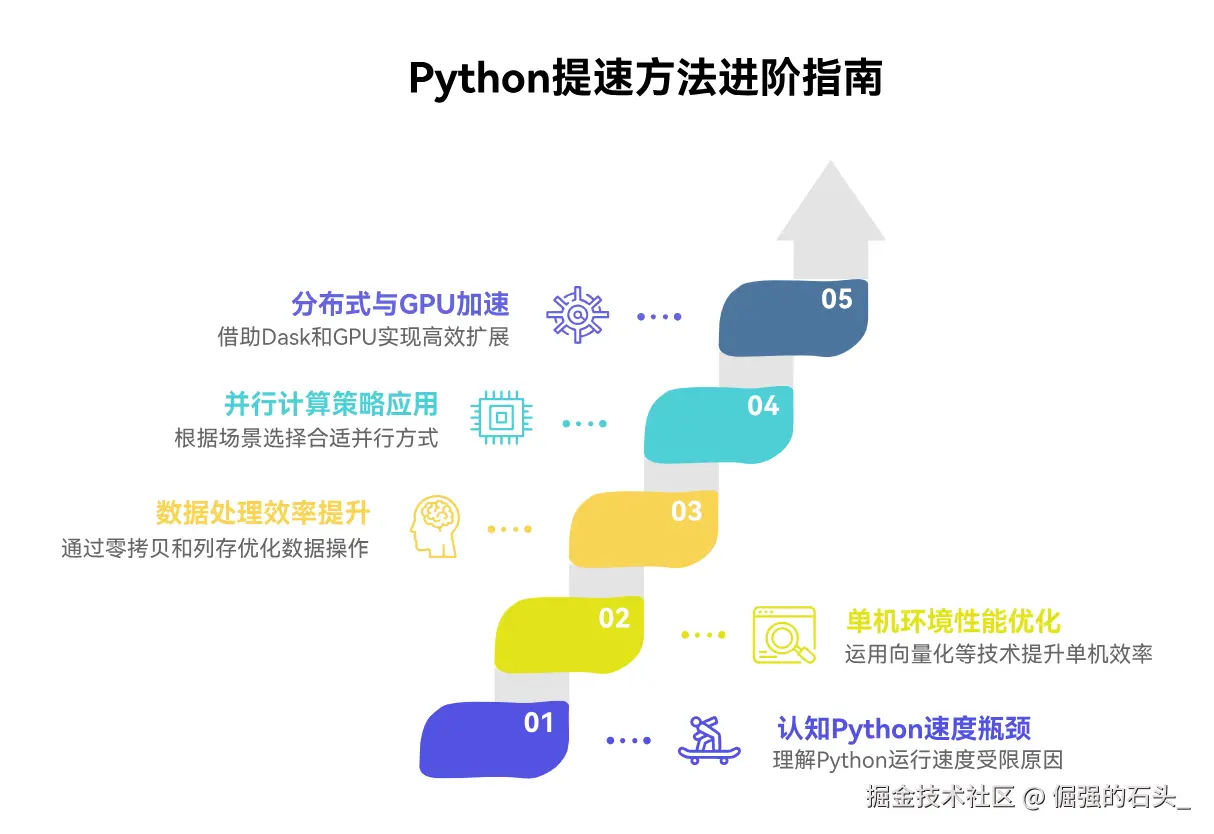

读法建议:从易到难的提速路线

- 认知阶段:为什么 Python(有时)慢?

- 单机提速:向量化、Numba/Cython、内存布局与对象模型

- 数据提速:Arrow 零拷贝、Parquet/Zarr 列存

- 并行提速:多进程/多线程/异步,何时各就各位

- 分布式/GPU:Dask 水平扩展,GPU 适配"密集型核"

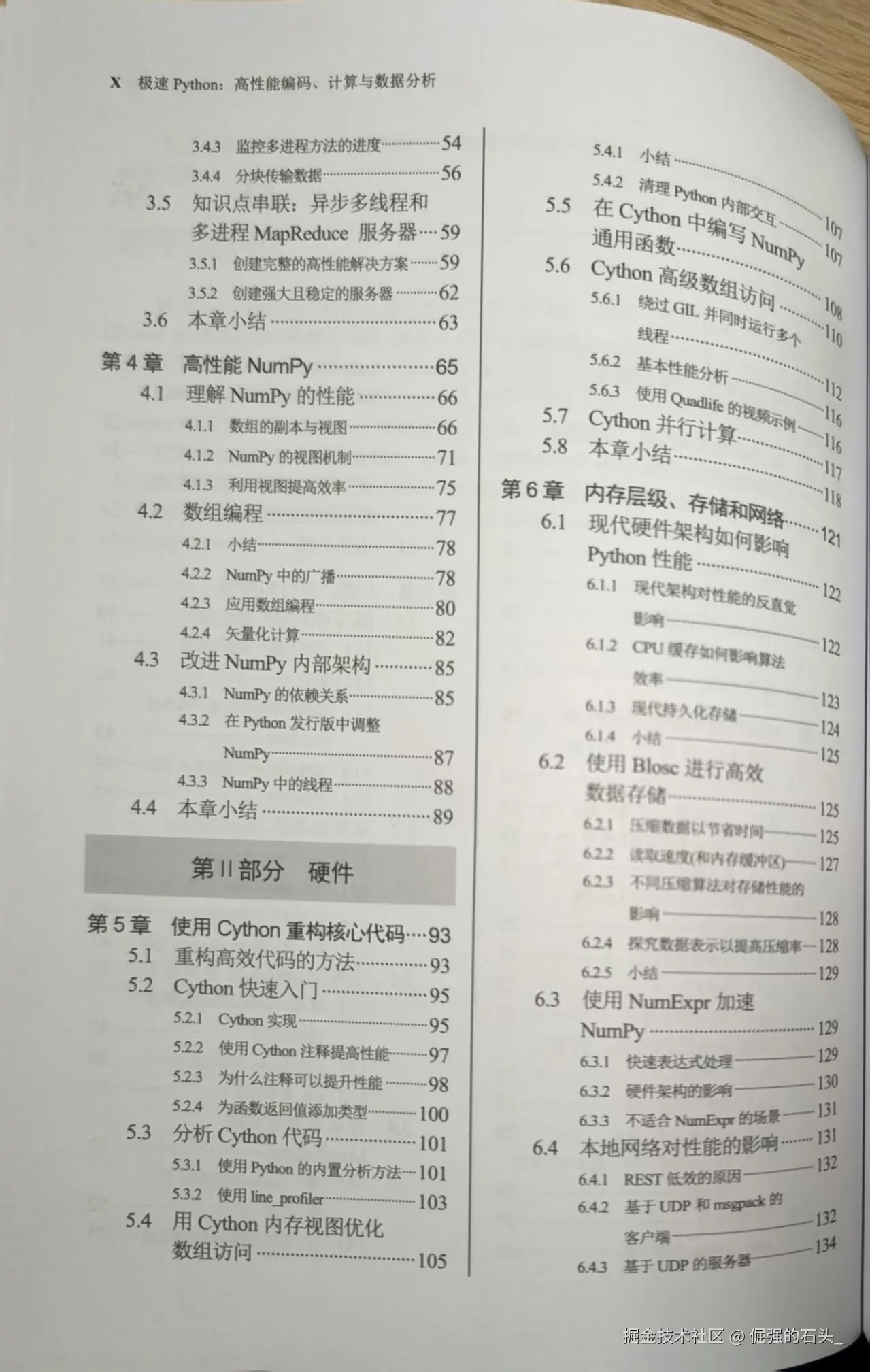

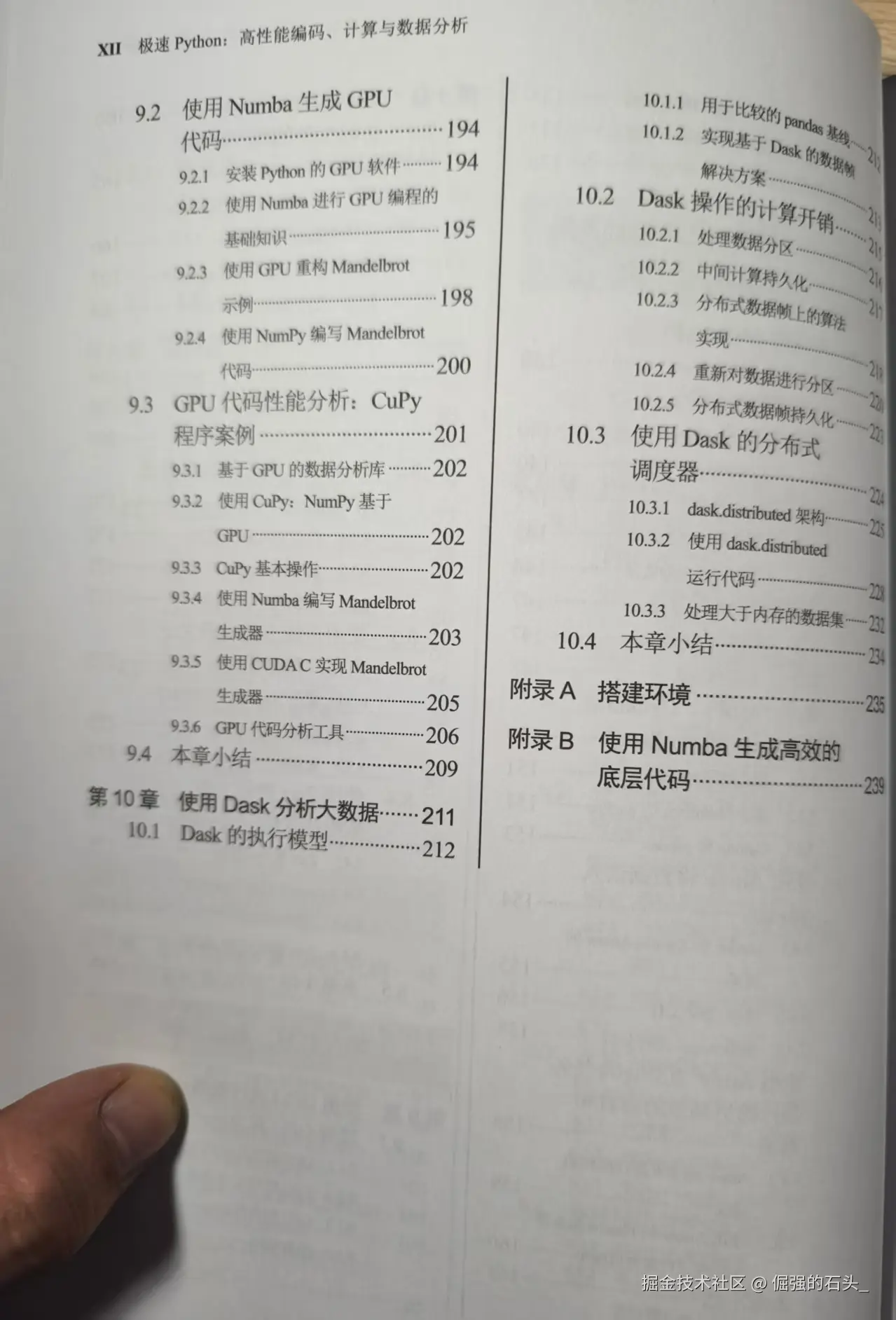

书里覆盖了什么(10 章导读·每章一句话)

- 第 1--2 章:大数据时代的性能陷阱;从源码层面拆解 Python 代码与内存模型

- 第 3 章:并发的"适度与取舍"------多进程、多线程、异步正确使用场景

- 第 4 章:NumPy 速成与阵地战:向量化让循环"退休"

- 第 5 章:Cython 入门:用接近 C 的速度写 Python 风格代码

- 第 6 章:对象与数据结构优化:把解释器负担降到最低

- 第 7 章:Apache Arrow 与 pandas:零拷贝和跨语言内存格式

- 第 8 章:数据持久化:Parquet、Zarr 等列存格式的工程实践

- 第 9 章:GPU 计算起步:何时值得上卡、怎样评估收益

- 第 10 章:Dask 分布式:把"能并就并"变成"会并且稳"

- 附录:环境安装、Numba 速成与替代方案

四个"抓手"帮你马上变快

- NumPy/向量化:把 Python 循环交给底层 C 实现

- Cython/Numba:在保留写法的同时获得本地代码性能

- GPU 并行:把密集型计算丢给合适的加速库

- Dask 分布式:从单机扩展到集群,吞下更大数据

场景选型速查(不做表,用要点说清)

- 数值数组计算为主:优先 NumPy 向量化;仍不够快→尝试 Numba(njit)

- 纯 Python 循环/对象开销大:先改数据结构,再考虑 Numba/Cython

- I/O 或列式分析:优先 Arrow(内存)+ Parquet(磁盘);超大数组看 Zarr

- 单机 CPU 吃满且能切分任务:多进程/多线程(I/O 型)

- 单机顶不住且任务可并:Dask → 本地多进程 → 集群

- 计算密集、数据能放 GPU:先评估 CuPy/Numba CUDA,算子适配再上

可复现的 4 段小实验(复制即可改造)

- 向量化 vs 循环(常见 10x 级别提速,视数据与环境而定)

python

import numpy as np, time

n = 10_000_000

x = np.random.rand(n)

t0 = time.time()

s1 = 0.0

for v in x:

s1 += v * v

t1 = time.time()

t2 = time.time()

s2 = np.sum(x * x)

t3 = time.time()

print("loop:", t1 - t0, "vec:", t3 - t2, "equal:", abs(s1 - s2) < 1e-6)- 一行 JIT 起飞(Numba)

python

import numpy as np

from numba import njit

@njit

def sum_squares(a):

s = 0.0

for v in a:

s += v * v

return s

x = np.random.rand(10_000_000)

_ = sum_squares(x) # 首次会编译

print(sum_squares(x)) # 二次调用飞快- Arrow + Parquet:I/O 与零拷贝

python

import pandas as pd

import pyarrow as pa

import pyarrow.parquet as pq

df = pd.DataFrame({"a": range(5_000_00), "b": range(5_000_00, 10_000_00)})

table = pa.Table.from_pandas(df, preserve_index=False)

pq.write_table(table, "demo.parquet", compression="zstd")

tbl = pq.read_table("demo.parquet", memory_map=True)

# 零拷贝到 pandas(需要版本支持)

df2 = tbl.to_pandas(types_mapper=pd.ArrowDtype)

print(len(df2), df2.memory_usage(deep=True).sum())- Dask:本地并行一个 groupby

python

import dask.dataframe as dd

ddf = dd.read_parquet("demo.parquet") # 或 dd.read_csv("*.csv")

res = ddf.groupby("a").b.sum().compute()

print(res.head())提示:实验在你本机的具体加速比会因 CPU/GPU、磁盘、库版本而不同。书里会教你如何"量化收益",而不是只看别人截图。

为什么这本书"像工程手册"而不是"工具说明书"

- 不只教 API,而是教你做"性能诊断":剖析器、基准、指标定义

- 不只给技巧,还教"取舍与顺序":向量化 → JIT → 改数据布局 → 并行/分布式

- 不只说"有多快",还说"代价在哪":可维护性、可移植性、资源成本

- 不只关心一台机器,而是考虑到"算力生态":多核、GPU、存储与网络

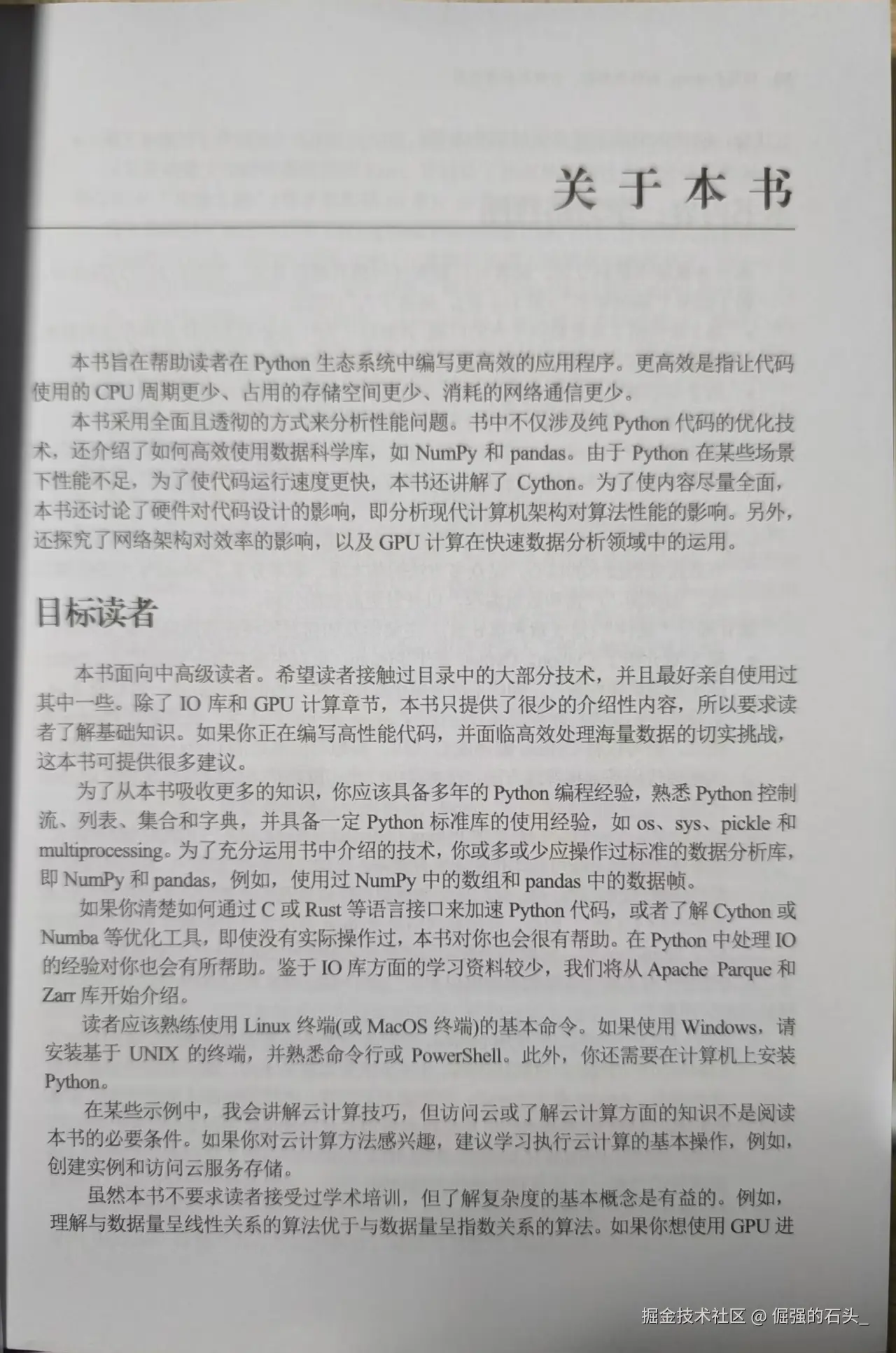

适合哪些读者

- 想把"能跑"变成"跑得好"的 Python 开发者、数据分析师、科研与工程人员

- 处理 ETL、特征工程、科学计算、仿真、时序/图像/基因等大数据任务的同学

- 需要给团队搭建"性能工程规范"和最佳实践模板的 Tech Lead/讲师

你能收获什么

- 一套从定位问题→选型→验证→部署→监控的闭环流程

- 可复用的代码片段与项目脚手架思路

- 对 Arrow/Parquet/Zarr 等数据格式的"工程直觉"

- 对多核/GPU/分布式的收益评估方法,避免"性能汗牛充栋但没测过"

作者简述

- 作者 Tiago Rodrigues Antão,长期深耕科学计算与数据工程,是 Biopython 重要贡献者,亦著有《Bioinformatics with Python Cookbook》。

- 原版口碑良好,业内专家给出积极评价;本书中文版由清华大学出版社出版,术语打磨与技术审校到位,阅读流畅。

结语

Python 并不慢,慢的是"没有策略的写法"。《极速Python:高性能编码、计算与数据分析》并非广告词堆砌,而是一套能落地的提速方法论:让你写得优雅、跑得更快、资源更省、可维护更强。

点击下方链接直达👇 书籍官方购买渠道

如果你也在优化的路上,欢迎留言分享:你最近一次"性能起飞"的案例,或者最想加速的模块。让"快"成为 Python 工程的新常态。