在企业数据架构不断演进的今天,数据的实时性已成为支撑业务敏捷响应、提升决策效率的关键因素。无论是金融交易系统的风控告警,还是电商平台的用户行为分析,亦或是工业物联网中的设备监控,都对底层数据同步提出了近乎"即时"的要求。传统以定时批处理为主的ETL(Extract-Transform-Load)模式,在面对高频变更场景时逐渐暴露出延迟高、资源消耗大等瓶颈。而一种名为 CDC(Change Data Capture,变更数据捕获) 的技术,正悄然成为实现实时数据集成的核心手段。

一、什么是数据库同步?为何实时性如此重要?

数据库同步,本质上是将一个或多个源数据库中的数据变化,准确、可靠地复制到目标系统的过程。其目的包括数据备份、灾备恢复、跨系统数据共享、构建数据仓库或实时分析平台等。

随着企业数字化转型深入,"准实时"甚至"近实时" 的数据流转需求日益普遍。例如:

-

风控系统需要在用户交易发生后的几秒内完成欺诈识别;

-

用户画像系统需基于最新点击行为动态调整推荐策略;

-

运维监控平台必须及时感知数据库异常操作。

一旦数据同步滞后,可能带来严重后果:错失营销时机、风险事件未能及时拦截、报表数据失真导致误判......这些不仅影响运营效率,更可能造成直接经济损失。

二、CDC 技术:从"拉取全量"到"捕捉增量"

传统的ETL通常采用周期性全量抽取 + 增量比对的方式进行同步,如每天凌晨执行一次全表扫描。这种方式实现简单,但存在明显短板------高延迟、高IO压力、网络带宽浪费。

相比之下,CDC 的核心思想在于"只关注变化"。它通过监听数据库自身的事务日志(如 MySQL 的 binlog、Oracle 的 Redo Log、PostgreSQL 的 WAL),精准捕获每一条 INSERT、UPDATE 和 DELETE 操作,并将其作为"变更事件"传递至下游系统。

这意味着:

-

不再需要频繁扫描整张表;

-

数据延迟可控制在秒级甚至毫秒级;

-

网络和计算资源消耗显著降低。

这种"轻量级、持续流式"的同步机制,正是 CDC 能够"快人一步"的根本原因。

三、CDC 的工作原理与关键技术要素

1.变更监测机制:如何发现"变"了?

主流 CDC 实现依赖于数据库的日志机制:

MySQL:解析 binlog 中的 ROW 格式日志;

Oracle:使用 LogMiner 或 GoldenGate 捕获 Redo/Archive Logs;

SQL Server:启用 CDC 或 Change Tracking 功能;

PostgreSQL:基于逻辑复制槽(Logical Replication Slot)读取 WAL 日志。

相较之下,基于时间戳轮询、触发器或快照对比的方法虽兼容性强,但性能开销大、易漏数据,已逐步被日志解析方式取代。

2.增量识别与类型区分

CDC 工具需能明确识别三类变更:

Insert:新增记录;

Update:字段值修改(部分工具支持新旧值对比);

Delete:行删除。

为确保准确性,通常依赖主键或唯一约束来定位变更对象。同时,版本号、时间戳或标志位也可用于辅助判断变更顺序与幂等性。

3.可靠传输与一致性保障

完整的 CDC 流程包含三个阶段:提取 → 传输 → 应用。

在这个过程中,必须解决几个关键问题:

顺序一致性:同一主键的多次更新必须按原始顺序应用,否则可能导致状态错乱;

幂等性处理:在网络重试或任务重启时,避免重复写入造成数据膨胀;

事务边界保持:跨多表的事务变更应作为一个整体同步,防止中间状态暴露;

隔离级别影响:如"读已提交"下可能看到中间状态,"串行化"则更严格但性能更低,需结合实际配置权衡。

此外,在分布式环境中,还需考虑节点故障、网络分区等情况下的容错能力。

4.DDL 变更的挑战:结构变了怎么办?

除了 DML(数据操作),DDL(数据定义语言)变更如新增列、修改字段类型、重命名表等,也是现实场景中常见需求。

然而,DDL 处理远比 DML 复杂:

日志中 DDL 记录格式不统一;

目标端表结构需同步变更,且不能中断正在进行的数据流;

若未妥善处理,极易引发数据写入失败或字段映射错误。

因此,成熟的 CDC 平台往往提供自动 DDL 解析与同步机制,或支持人工干预+映射配置,以应对结构演化带来的挑战。

四、CDC vs 传统 ETL:一场关于"时效性"与"复杂度"的博弈

可以看出,CDC 并非万能替代方案,而是针对特定场景的优化选择。企业在选型时,应根据自身业务节奏、数据规模和系统架构做出平衡。

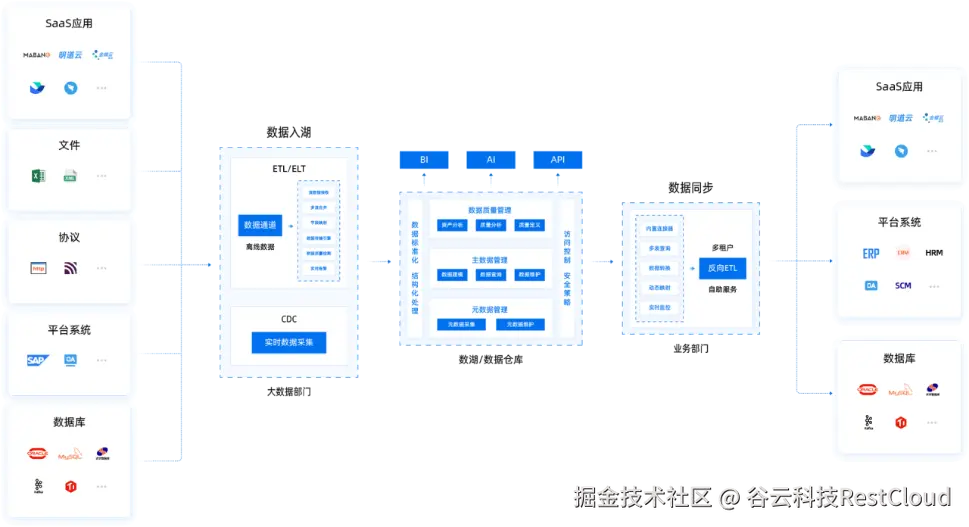

五、ETLCloud:一个融合 CDC 与 ETL 的集成实践案例

在众多数据集成平台中,ETLCloud提供了一个兼具批处理与流式同步能力的全域解决方案。作为一款集成了 ETL、ELT、CDC、API 服务与任务调度的一体化平台,ETLCloud 在实时数据同步方面展现出较强的技术整合能力。

1.支持广泛的数据库生态

ETLCloud 支持包括 MySQL、Oracle、PostgreSQL、SQL Server、达梦、人大金仓等在内的多种主流关系型数据库,覆盖多数企业现有环境,尤其适合异构系统间的数据打通。

2.精准捕获 DML 变更

平台可通过解析数据库日志,实现对 Insert、Update、Delete 操作的细粒度捕获,并保留变更前后的字段值,便于审计与回溯。

3.实时同步 + 结构变更支持

值得一提的是,ETLCloud提供了 DDL 同步功能。当源端表结构调整时,系统可自动检测并生成对应的变更脚本,或提示用户手动确认后同步至目标库,有效缓解结构演进带来的维护难题。

4.容错与运维能力完善

在实际运行中,网络中断、数据库连接超时等问题难以避免。ETLCloud 支持断点续传机制,可在任务恢复后从中断位置继续同步,避免重新初始化带来的性能冲击。同时,平台内置实时监控面板,展示延迟、吞吐量、错误率等指标,并支持邮件、Webhook 等告警方式,便于快速响应异常。

5.安全与治理兼顾

面向企业级应用场景,ETLCloud 提供了完善的权限管理体系,支持数据源访问控制、角色分级授权以及操作日志追踪,满足 GDPR、等保等合规要求。

平台中可视化拖拽界面降低了使用门槛,使得非技术人员也能参与流程设计;而丰富的转换组件(如去重、脱敏、聚合、字段映射)则实现了 CDC 与 ETL 的无缝衔接------变更数据可在加载前完成清洗与标准化,真正实现"边同步边治理"。

六、如何评估与选型 CDC 方案?

企业在引入 CDC 技术时,建议从以下几个维度综合评估:

七、总结与展望

CDC 技术之所以能让数据库同步"快人一步",在于它跳出了传统批量思维,转而利用数据库自身日志机制,实现了低延迟、低开销、高精度的增量同步。尽管面临一致性保障、DDL 处理、系统兼容性等挑战,但随着技术成熟,其价值已在金融、电商、制造等领域得到广泛验证。

像 ETLCloud 这样的集成平台,通过将 CDC 与 ETL、调度、API 发布等功能融合,为企业提供了"一站式"数据流动解决方案。它既可用于构建实时数仓,也可服务于微服务间的事件驱动架构。

未来,CDC 将进一步与 Flink、Kafka、Data Lakehouse 等技术深度融合,向更低延迟、更强语义一致性的方向发展。同时,借助 AI 能力实现异常检测、自动补偿、智能调优,也将成为下一代数据同步平台的重要趋势。

对于企业而言,不妨从小范围试点开始,选择典型业务场景验证 CDC 效果,逐步建立团队能力与运维体系。唯有如此,才能真正驾驭这项"快人一步"的技术,释放数据的实时价值。