作者:云栖现场

AI 原生不再是一个新的概念,而是企业在业务落地实践过程中已经形成的共识。不论是技术团队还是业务部门,都认同 AI 原生已经成为了应用架构的新范式。但是,围绕 AI 原生究竟涵盖哪些核心要素,因岗位视角不同、落地阶段不同、应用场景不同,仍有不同的理解:有强调模型和数据的,有更关注上下文工程与工具调用的,也有聚焦可观测、安全与治理的。

今天,阿里云智能资深技术专家简志在"云栖大会- AI 基础设施进化论坛"分享了团队的实践感悟,包括从云原生到 AI 原生的演进路线,AI 原生所包含的关键要素,以及未来的发展方向,希望对参与 AI 建设的所有同行者们有所启发。

预告:9 月 25 日(周四),D3-2,AI 原生应用架构论坛,将发布《AI 原生应用架构白皮书》,帮助大家系统、全面了解 AI 原生应用的开发、测试、上线和运维的完整应用生命周期,并辅以实操展示关键功能的实现。

云原生到 AI 原生的演进路线

AI 原生能带来效率和提升和智能的释放。

应用架构大致经历了四个阶段:

- 第一阶段, 应用以单体软件形态运行在个人 PC 上,典型代表是 Windows 95 生态,操作系统的普及直接催生了大规模的本地应用;

- 第二阶段, 随着企业数字化系统逐步成型,应用形态从单机转向服务端,用户通过客户端或浏览器访问,实现了资源与功能的集中化和用户使用的平权化;

- 第三阶段, 云计算与云原生基础设施兴起,开发者不再需要关注底层部署和运维,应用交付模式演变为按需弹性、持续集成,开发人员可以专注在业务逻辑本身;

- 第四阶段, 2025 年开始,低门槛的泛开发群体正在崛起,他们将依托低代码、智能体和 AI 原生能力,通过快速原型与迭代验证,实现应用的快速上线与规模化创新。

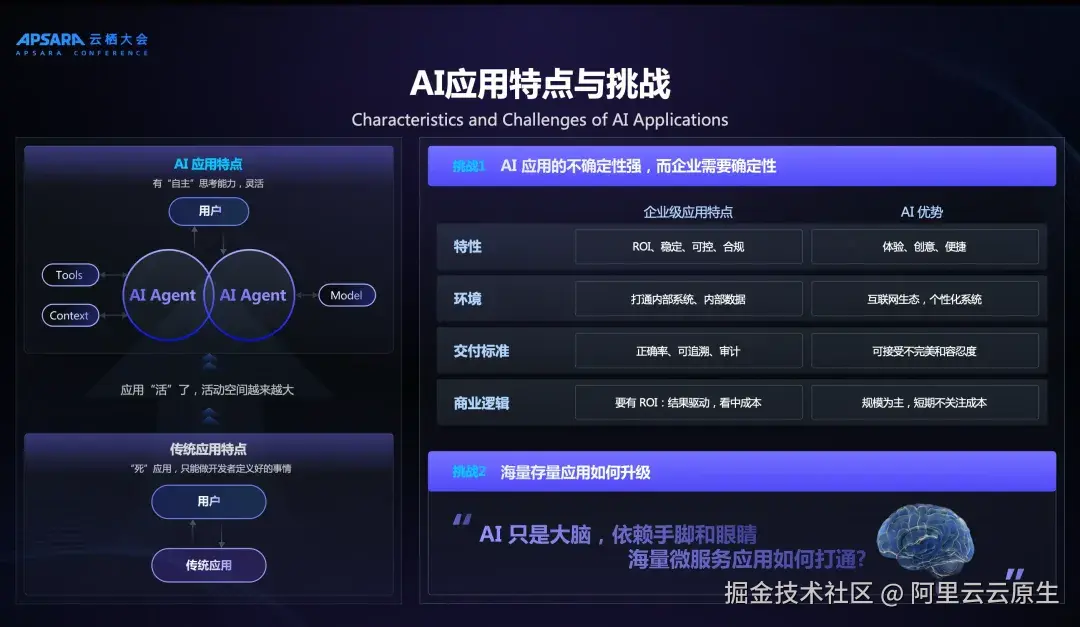

AI 驱动的应用与传统应用存在着本质的区别。传统应用在构建完成后,其业务逻辑以代码形式固化,行为可预测、确定。而 AI 应用则不同,它能够调用外部工具、理解上下文,并与大模型进行交互,因而具备动态决策与自适应能力,呈现出"活的应用"的特征。正是这种"活性",对基础设施提出了新的要求:应用活动范围显著扩大,调用链条更复杂,企业必须重新思考算力、存储、接口、网络、安全与治理的边界。同时,AI 的概率性本质与企业对稳定性、合规性和可审计性的要求之间,形成了天然矛盾。

在落地层面,企业在部署 AI 应用时面临两大挑战:

- 第一, 如何在满足 AI 应用灵活性与探索性的同时,确保系统运行的稳定性、合规性和可追溯性,避免因黑箱和不确定性引发生产风险;

- 第二, 如何在已有数字化基础设施之上快速叠加 AI 能力,利用存量接口和系统资产实现平滑升级,而不是推倒重来。这意味着,企业迈向 AI 化的正确路径,应是基于现有系统架构的渐进式升级,通过网关、运行时、消息中间件和可观测体系的增强,加速进入 AI 时代,而非进行高风险的全盘重构。

AI 原生的关键要素

我们提炼了 AI 框架、AI 运行时、AI 网关、AI MQ、AI 可观测、Auto Memory、AI DevOps+Coding+Operation 这 8 大关键要素。这些要素对大模型输出结果的可靠性、原型验证(PoC)到生产部署的调优效率,以及上线后的推理速度、问题排查困难、安全风险和资源成本,都会有所助益。

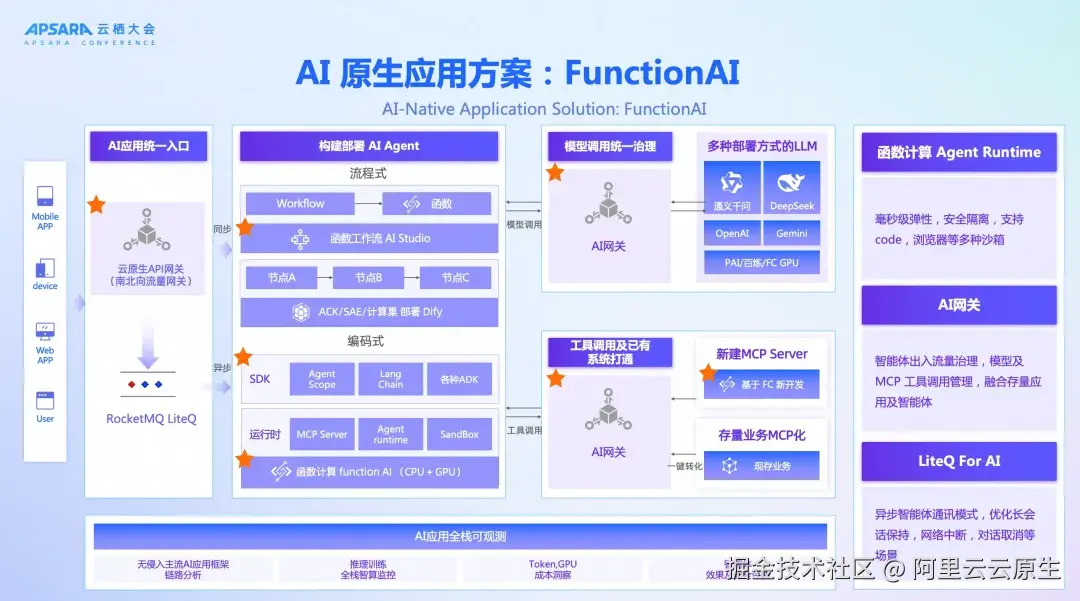

AI 原生应用方案:Function AI

应用架构是指导如何系统性地构建应用。因此我们提炼的这个 AI 原生的应用架构图,把 8 大关键要素串联了起来,提供一套包含运行时、网关、消息队列与可观测能力的完整技术栈,非单一产品而是组件化方案:Function AI。企业不必从零组装,而是可以基于方案缩短从 PoC 到生产的周期。该方案包括:

- 运行时: 基于函数计算(Function Compute),支持按需调用、秒级计费,具备百万级函数注册与十万并发处理能力。

- AI 网关: 专为AI场景设计,屏蔽大小模型调用的不确定性,统一接口格式,集成安全防护并兼容HTTP存量业务。

- 消息队列(MQ): 支持异步处理、优先级调度与 IP 级消费控制,提升系统稳定性与吞吐率。

接下去我们将对该方案的核心能力,即 AI 原生的 8 大关键要素进行展开。

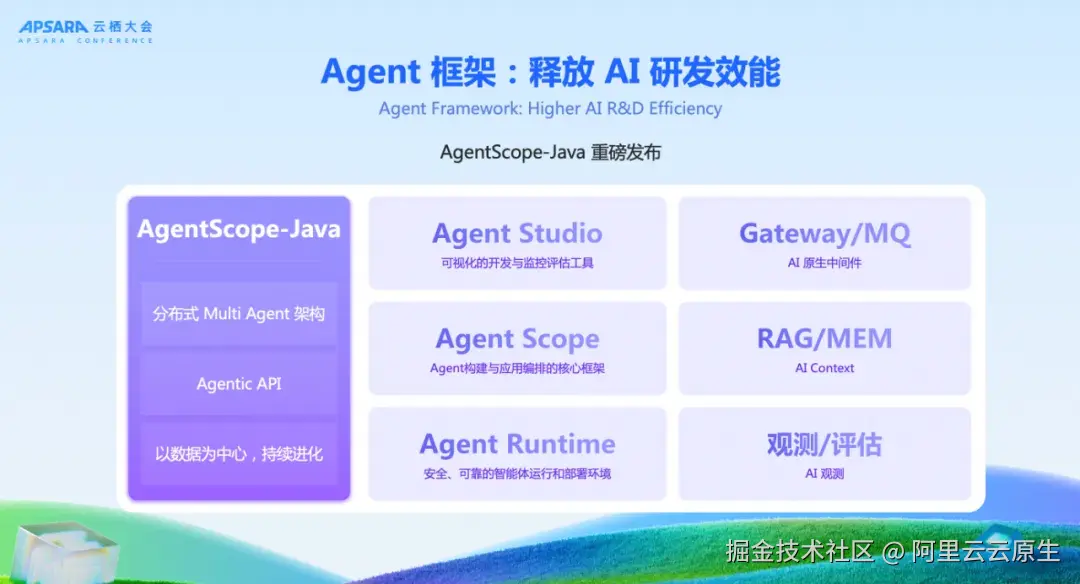

Agent 框架:释放 AI 研发效能

针对中国主流的 Java 开发者群体,我们重磅发布 AgentScope Java 版开发框架。该框架深度兼容 Spring 生态,支持零代码、低代码与全代码三种开发模式,满足从入门开发者到资深工程师的不同需求。框架内置了丰富的示例与模板,开发者可以基于现有 Spring 工程快速集成智能体能力,并实现与上下文、工具调用及模型交互的无缝结合。

在工程实践上,该框架支持从本地 IDE 环境一键部署至云端,简化了开发---测试---上线的全链路过程,实现了从原型构建到生产交付的顺畅迁移。这为 Java 开发者提供了一套完整的 AI 应用工程化解决方案,降低了智能体应用的落地门槛,同时确保与现有企业系统的兼容与可扩展性。

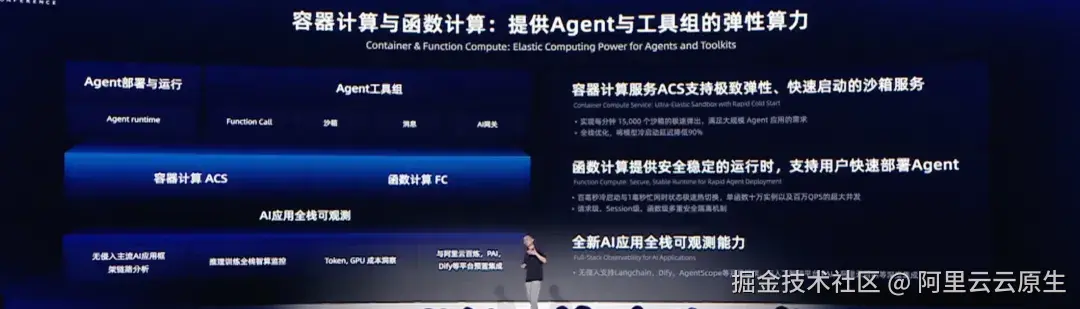

AI 运行时

函数计算 FC 为 AI Agent 与强化学习提供轻量灵活、安全隔离、极速弹性的沙箱(Sandbox)运行环境,基于函数计算打磨 Agent Runtime 以及 Sandbox(Code Interpretor、Browser Tools .....),已经服务于百炼、魔搭、通义千问、阿里国际、加和等阿里内外多个核心客户。

- 第一,在安全隔离方面,函数计算通过安全容器技术,为每一个任务提供了虚拟机级别的隔离强度;请求级别、Session 级别以及函数级别多重隔离机制覆盖全场景 Sandbox 的业务诉求。

- 第二,函数计算的架构生而为云,具备最小粒度的资源开销、极为轻量的元数据与资源的生命周期管理,超高并发的可扩展能力,轻松支撑单集群百万函数、单函数数十万实例以及百万QPS的超大并发能力。

- 第三,具备极速弹性能力,支持缩容到零,能够在百毫秒内冷启动一个全新的沙箱实例。同时,基于内存快照技术实现忙闲时自动转化,从闲置到活跃可以做到 1 毫秒内极速恢复,业界最快,满足最极致的 Sandbox 延时诉求;真正按执行时长毫秒级计费,完美匹配 AI 应用稀疏调用以及瞬间 burst 的业务负载特征。

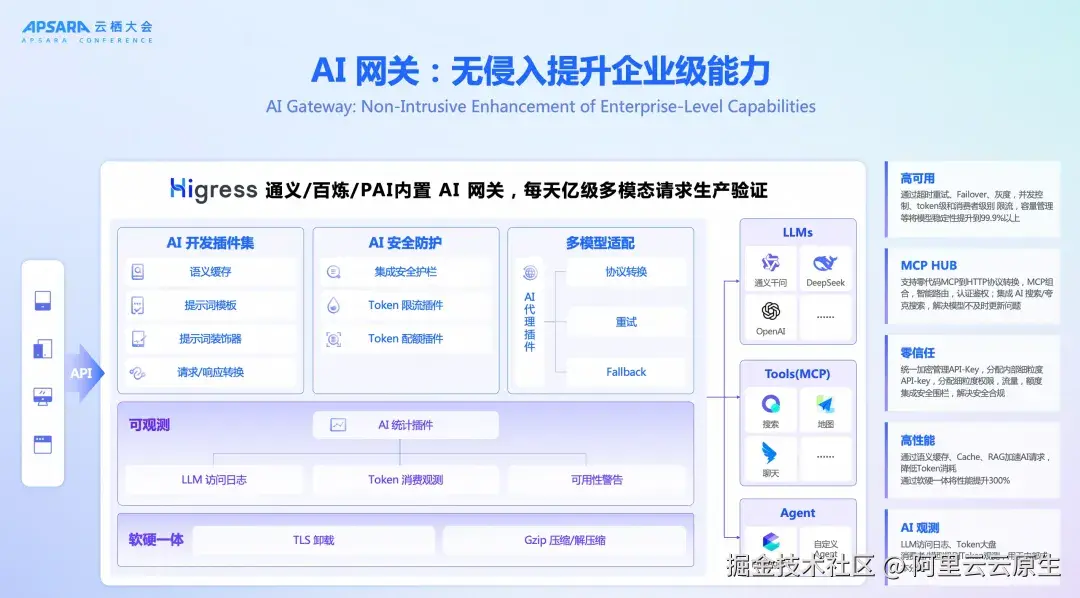

AI 网关:无侵入提升企业级能力

与传统网关相比,AI 网关针对大模型调用场景进行了架构级增强。阿里云 AI 网关提供了开源(Higress)、商业(API 网关)两种交付模式。

- 支持模型代理,超时重试,Failover,Token 和消费者级别流控和额度管理;将大模型稳定性提升一个数量级。 支持安全护栏,敏感信息脱敏,敏感信息拦截,WAF 防护,API-Key KMS 加密存储,TLS 加密传输,消费者认证鉴权等 AI 零信任能力。

- 支持 MCP HUB 能力,零代码将 HTTP 协议转换 MCP 协议,快速复用存量系统工具;支持 MCP 组合和智能路由,零代码帮助客户从几个服务中筛选合适工具,支持 MCP 认证鉴权。

- 支持软硬一体 Gzip 压缩和解压缩,性能提升 300%+,通过压缩帮助客户节省40%+流量;支持 Token 压缩能力,英文压缩 50% 基本不影响语义。 通过软硬一体将 TLS 卸载性能提升 116%,大幅提升 1 倍业务峰值吞吐。

- 提供 AI 开放平台,支持 MCP 市场 / Agent市场(帮助客户快速复用基础 AI 服务,提升写作效率),支持 AI 服务的计量计费、成本分摊等,为 AI FinOps 提供基础,支持 AI API 的生命周期管理。

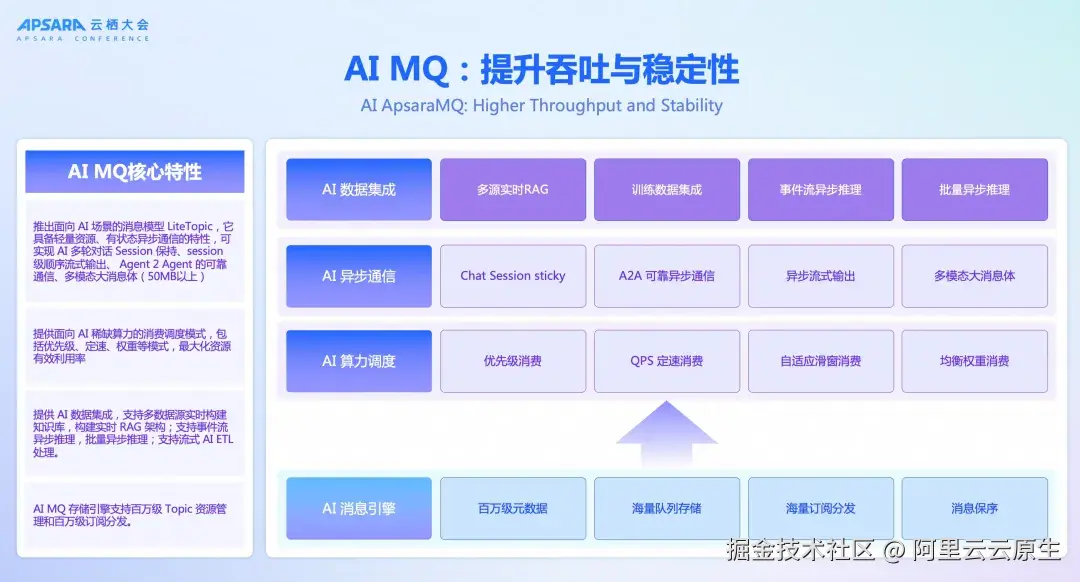

AI MQ:提升吞吐与稳定性全栈

AI MQ 是我们推出面向 AI 场景的消息模型 LiteTopic,它具备轻量资源、有状态异步通信的特性,可实现 AI 多轮对话 Session 保持、Session 级顺序流式输出、 Agent 2 Agent 的可靠通信、多模态大消息体(50MB 以上)。具备一下特性:

- 提供面向 AI 稀缺算力的消费调度模式,包括优先级、定速、权重等模式,最大化资源有效利用率。

- 提供 AI 数据集成,支持多数据源实时构建知识库,构建实时 RAG 架构;支持事件流异步推理,批量异步推理;支持流式 AI ETL 处理。

- AI MQ 存储引擎支持百万级 Topic 资源管理、百万级队列存储、百万级订阅分发。

AI 可观测:覆盖 IaaS 到应用

AI 应用可观测,是一次针对 AI 应用的可观测能力的全面进化。通过构建一个贯穿 AI 基础设施(IaaS)到大模型服务(MaaS)的全栈式、一体化的可观测解决方案。目标是为企业提供一个智算应用的"上帝视角",清晰洞察从底层 GPU 算力、网络、存储,到中间层容器调度、模型推理与训练,再到上层 AI 应用与智能体交互的每一个环节。

构建统一可观测体系,采集从请求发起到结果返回全过程的数据,涵盖调用链路、token 消耗、失败原因等维度,为用户提供模型调用的实时状态、延迟波动情况以及 token 消耗的精确统计,帮助企业在性能与成本之间实现动态平衡。

阿里云统一可观测能力对主流开发框架保持透明兼容,开发者无需改造即可接入,从而在多样化的 AI 应用场景中提供一致的观测与治理体验。

数据工程:监控、评估到记忆

数据工程依赖统一可观测体系,我们提供了:

- AI 全栈统一监控: 基于 Prometheus 构建 AI 全栈监控大盘,包括模型性能分析、Token 成本分析、GPU 资源异动分析等。

- 模型调用端到端链路追踪: 基于 OpenTelemetry Trace 实现用户终端、网关、模型应用、模型服务、外部依赖工具等全链路追踪。

- 模型日志存储与评估分析: 构建统一日志分析平台,对模型调用日志进行二次评估分析,实现质量、安全、意图提取等语义检测。

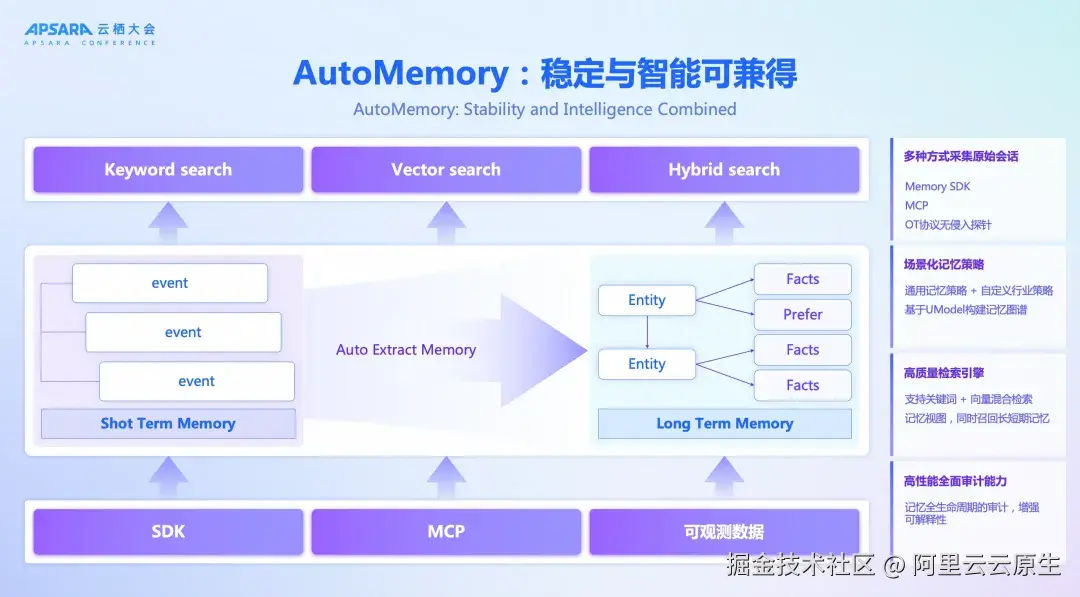

AutoMemory:稳定与智能可兼得

在智能体应用中,后台 ETL 能力可对交互产生的大量数据进行抽取、清洗与结构化处理,并沉淀至 Memory 模块。通过将用户偏好、历史问题与上下文信息长期保存并动态更新,智能体能够在后续对话与任务中进行精准调用,从而具备持续学习与优化的能力,实现"越用越聪明"的效果。

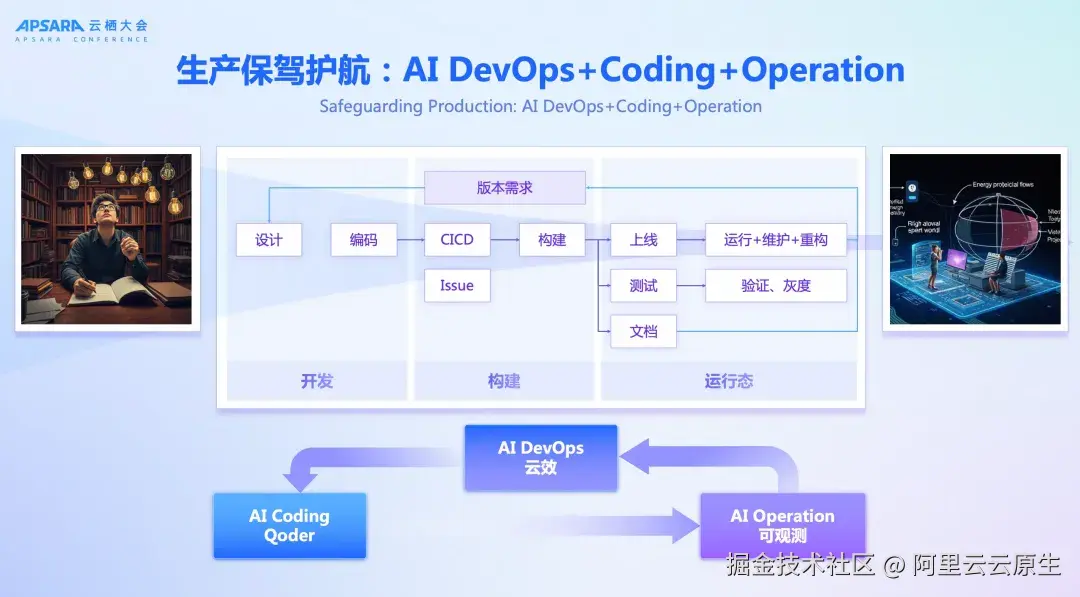

AI DevOps+Coding+Operation

与此同时,体系还打通了 AI DevOps 流程:当代码提交与应用发布后,系统会自动捕获并关联线上问题,由 AI Agent 生成包含错误堆栈、对应代码位置及责任人信息的报告。这一过程显著缩短了故障定位与调试时间,并通过自动反馈机制推动问题快速修复,从而形成研发---运维---优化的智能化闭环,提升整体系统的可维护性与交付效率。

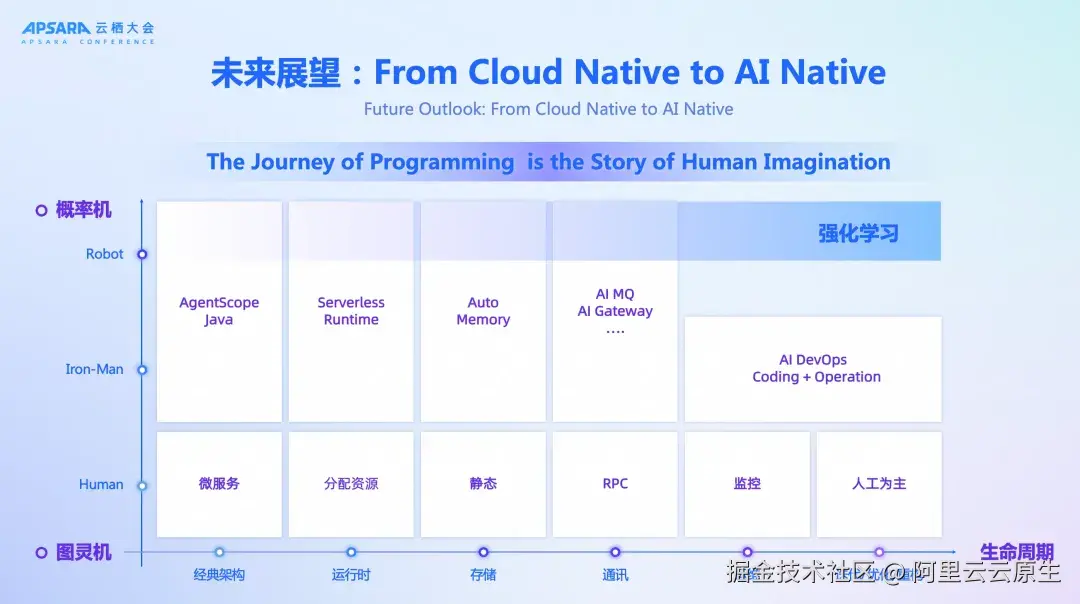

展望未来

传统计算体系建立在图灵机模型与确定性指令集之上,应用逻辑一旦编码完成便保持固定,系统运行结果可预测、可验证。而在 AI 时代,应用逐渐运行在以概率推理为基础的概率机之上,输出具有不确定性和动态适应性。

当前阶段,可以视为 "Iron Man"式的人机协同:人类依旧主导核心决策,但大量繁琐操作被智能体所分担,整体效率显著提升。展望未来,随着强化学习与反馈闭环的持续优化,智能体将具备更高水平的自适应能力,使人类能够将精力集中于创造性工作,应用本身则更贴近真实业务与生活场景。

从工程视角看,行业正经历从确定性系统向概率性智能体的范式迁移。这一转变要求底层基础设施不再仅仅是资源池,而要成为支持智能体的动态运行平台。通过云原生技术栈与 AI 工程化框架的深度融合,企业能够构建具备可信赖性(可观测、安全合规)、可扩展性(异构算力与弹性伸缩)、可进化性(模型迭代与上下文记忆增强)的下一代应用体系,从而推动智能化升级进入全新阶段。

展区和论坛一览 👇