引言

随着企业数字化转型深入,多云多集群环境已成为新常态,而管理复杂度却成指数级增长。Kurator作为业界首个分布式云原生开源套件,正为解决这一痛点而生。

- 引言

-

- 目录

- 一、为什么选择Kurator?分布式云原生管理破局之道

-

- [1.1 企业面临的典型痛点](#1.1 企业面临的典型痛点)

- [1.2 Kurator的定位与价值](#1.2 Kurator的定位与价值)

- 二、Kurator架构解析:核心技术栈与能力地图

-

- [2.1 核心组件架构](#2.1 核心组件架构)

-

- [2.1.1 集群生命周期管理(Cluster Operator)](#2.1.1 集群生命周期管理(Cluster Operator))

- [2.1.2 舰队管理(Fleet Manager)](#2.1.2 舰队管理(Fleet Manager))

- [2.2 关键技术能力](#2.2 关键技术能力)

- 三、从零开始:Kurator分布式云原生环境搭建实战

-

- [3.1 环境准备与规划](#3.1 环境准备与规划)

- [3.2 安装Kurator CLI与Cluster Operator](#3.2 安装Kurator CLI与Cluster Operator)

-

- [3.2.1 安装Kurator CLI](#3.2.1 安装Kurator CLI)

- [3.2.2 安装Cluster Operator](#3.2.2 安装Cluster Operator)

- [3.3 常见安装问题与解决方案](#3.3 常见安装问题与解决方案)

- 四、深度体验:Kurator集群生命周期治理实战

-

- [4.1 声明式集群创建](#4.1 声明式集群创建)

- [4.2 现有集群接入](#4.2 现有集群接入)

- [4.3 集群舰队编排](#4.3 集群舰队编排)

- 五、典型案例:某制造企业分布式云原生平台落地

-

- [5.1 业务背景与挑战](#5.1 业务背景与挑战)

- [5.2 技术选型与方案设计](#5.2 技术选型与方案设计)

- [5.3 技术适配与攻坚](#5.3 技术适配与攻坚)

- [5.4 落地成效与价值度量](#5.4 落地成效与价值度量)

- 六、Kurator核心功能深度解析

-

- [6.1 统一应用分发:GitOps跨集群实践](#6.1 统一应用分发:GitOps跨集群实践)

- [6.2 统一监控:多集群指标聚合](#6.2 统一监控:多集群指标聚合)

- [6.3 统一策略管理:多集群安全基线](#6.3 统一策略管理:多集群安全基线)

- 七、总结与展望

-

- [7.1 Kurator核心价值总结](#7.1 Kurator核心价值总结)

- [7.2 未来展望](#7.2 未来展望)

目录

一、为什么选择Kurator?分布式云原生管理破局之道

在云原生技术迅猛发展的今天,企业IT基础设施正面临前所未有的挑战。根据Gartner预测,到2025年,全球75%的企业将拥有超过10个Kubernetes集群。传统的单集群管理模式已无法满足跨云、跨地域、跨环境的业务需求。

1.1 企业面临的典型痛点

- 多云多集群管理复杂:公有云K8s、自建K8s、边缘K8s全都要管,运维割裂严重

- 应用分发一致性难保证:每个集群一套YAML,人工脚本拼凑,版本不一致导致故障

- 运维效率低下:跨集群监控、策略、流量治理缺乏统一控制面

- 资源利用率不高:各集群资源孤岛,无法实现全局调度和优化

1.2 Kurator的定位与价值

Kurator是业界首个分布式云原生开源套件,由华为云开源,并已成为开放原子基金会首个分布式云原生项目。它并非要替代Kubernetes,而是站在Kubernetes、Karmada、Istio、Prometheus等主流云原生技术栈之上,提供更高层次的统一控制平面和声明式API。

Kurator的核心价值主张:把一堆好用但分散的云原生组件,变成一套开箱即用、有统一模型、有统一控制面的分布式云原生平台。

二、Kurator架构解析:核心技术栈与能力地图

要充分发挥Kurator的价值,首先需要理解其整体架构和技术栈。Kurator的设计理念是"基础设施即代码",允许用户以声明方式管理云、边缘或本地环境的基础设施。

2.1 核心组件架构

Kurator整体架构分为两大核心组件:

- Cluster Operator:负责集群生命周期管理

- Fleet Manager:以舰队为资源管理单位,提供统一分布式云管理2.1.1 集群生命周期管理(Cluster Operator)

基于Cluster API,Kurator提供声明式API管理Kubernetes集群的完整生命周期。目前支持:

- 本地数据中心集群:基于KubeSpray在虚拟机、裸金属服务器上部署生产级Kubernetes集群

- AWS云上自建集群:通过Cluster API Provider AWS,获得与EKS一致的用户体验

- 任意集群接入:通过AttachedCluster类型,纳管非Kurator创建的现有集群

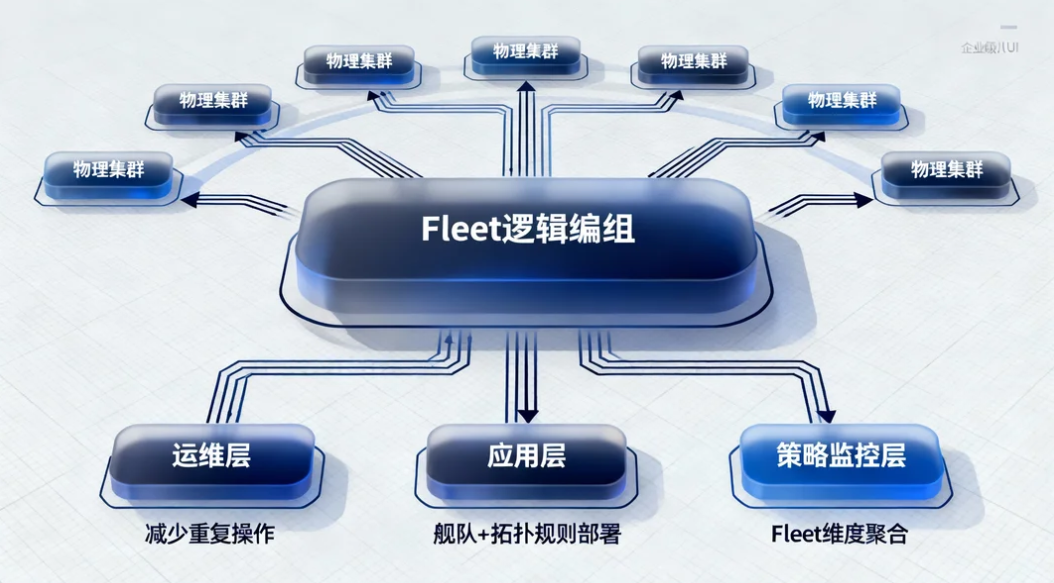

2.1.2 舰队管理(Fleet Manager)

Fleet是Kurator的核心抽象概念,将多个物理集群抽象为一个逻辑编组。这一层抽象的好处是:

- 对运维而言:操作对象从"单个集群"提升为"舰队",减少重复操作

- 对应用而言:部署目标可以是"某个舰队+拓扑规则",而不是逐个集群

- 对策略与监控而言:天然有一个Fleet维度可以聚合

2.2 关键技术能力

Kurator集成了多种业界主流云原生关键技术,并封装了六大统一能力:

| 能力维度 | 技术栈 | 核心价值 |

|---|---|---|

| 统一舰队管理 | Karmada | 多集群统一视图与编排 |

| 统一应用分发 | FluxCD, Karmada | GitOps跨集群分发 |

| 统一流量治理 | Istio | 跨集群服务治理 |

| 统一监控 | Prometheus, Thanos, Grafana | 全局可观测性 |

| 统一策略管理 | Kyverno | 多集群安全策略一致性 |

| 集群生命周期 | Cluster API, KubeSpray | 基础设施即代码 |

三、从零开始:Kurator分布式云原生环境搭建实战

3.1 环境准备与规划

假设我们为一个中型互联网公司构建分布式云原生平台,环境规划如下:

- 管理集群:1台4核8G云主机(部署Kurator控制平面)

- 生产集群:公有云K8s集群(跑核心业务Web/API服务)

- 预生产集群:公有云K8s集群(回归测试/灰度环境)

- 本地集群:本地数据中心K8s集群(承载合规要求高的服务)

- 边缘集群:通过KubeEdge管理的边缘节点(IoT与本地推理应用)

系统要求:

- Kubernetes版本1.20+

- 网络插件(Calico/Cilium)稳定可用

- 控制平面与各集群间开放6443(K8s API)、8080(Kurator Agent)端口

3.2 安装Kurator CLI与Cluster Operator

3.2.1 安装Kurator CLI

bash

# 从官方仓库下载最新Release包

wget https://github.com/kurator-dev/kurator/releases/download/v0.4.0/kurator-cli-v0.4.0-linux-amd64.tar.gz

tar -xzf kurator-cli-v0.4.0-linux-amd64.tar.gz

sudo mv kurator /usr/local/bin/

kurator version3.2.2 安装Cluster Operator

bash

# 应用CRD与Operator部署清单

kubectl apply -f https://github.com/kurator-dev/kurator/releases/download/v0.4.0/cluster-operator-install.yaml

# 验证安装

kubectl -n kurator-system get pods3.3 常见安装问题与解决方案

问题1:证书生成失败

错误信息:x509: certificate signed by unknown authority

解决方案:检查控制平面节点时间同步,安装并启动chronyd服务问题2:集群注册超时

错误现象:Agent连接卡在"连接中"

解决方案:检查防火墙,确保Agent到Server的8080端口通畅问题3:CRD安装失败

错误信息:RBAC权限不足

解决方案:确保kubectl用户具有cluster-admin权限四、深度体验:Kurator集群生命周期治理实战

4.1 声明式集群创建

Kurator基于Cluster API,提供声明式API管理集群生命周期。以下是一个本地数据中心集群的创建示例:

yaml

apiVersion: cluster.kurator.dev/v1alpha1

kind: Cluster

metadata:

name: onprem-cluster

namespace: kurator-system

spec:

infraType: vm

kubernetesVersion: v1.29.0

network:

podCIDR: 10.244.0.0/16

serviceCIDR: 10.96.0.0/12

machines:

controlPlane:

replicas: 3

sshSecretRef: onprem-ssh

template:

cpu: 2

memory: 4Gi

disk: 100Gi

workers:

replicas: 5

sshSecretRef: onprem-ssh

template:

cpu: 4

memory: 8Gi

disk: 200Gi应用该配置后,Kurator的Cluster Operator会自动完成:

- 控制平面节点创建和kubeadm初始化

- 工作节点加入集群

- 网络插件部署

- 集群状态回写到CR状态字段

4.2 现有集群接入

对于非Kurator创建的集群,可通过AttachedCluster接入:

yaml

apiVersion: cluster.kurator.dev/v1alpha1

kind: AttachedCluster

metadata:

name: existing-prod-cluster

namespace: default

spec:

kubeconfig:

name: prod-cluster-kubeconfig

key: config4.3 集群舰队编排

将多个集群纳入统一舰队管理:

yaml

apiVersion: fleet.kurator.dev/v1alpha1

kind: Fleet

metadata:

name: global-fleet

namespace: default

spec:

clusters:

- name: onprem-cluster

kind: Cluster

- name: existing-prod-cluster

kind: AttachedCluster

- name: edge-cluster

kind: AttachedCluster五、典型案例:某制造企业分布式云原生平台落地

5.1 业务背景与挑战

某汽车零部件制造企业(A企)因业务扩张,需整合全国5大生产基地的IT资源,原有方案存在三大痛点:

- 跨地域配置不一致(网络策略、存储插件版本差异)

- 应用分发依赖人工打包,发布周期长(平均3天/次)

- 监控数据分散,故障排查需切换多个系统

5.2 技术选型与方案设计

对比主流工具后,A企选择Kurator基于以下考虑:

- 分布式治理能力:支持多集群统一纳管,解决"各自为战"问题

- 开放生态:兼容主流K8s发行版(RKE、EKS、自研K8s)

- 轻量可控:控制平面资源占用低(仅需4核8G),适合企业私有化部署

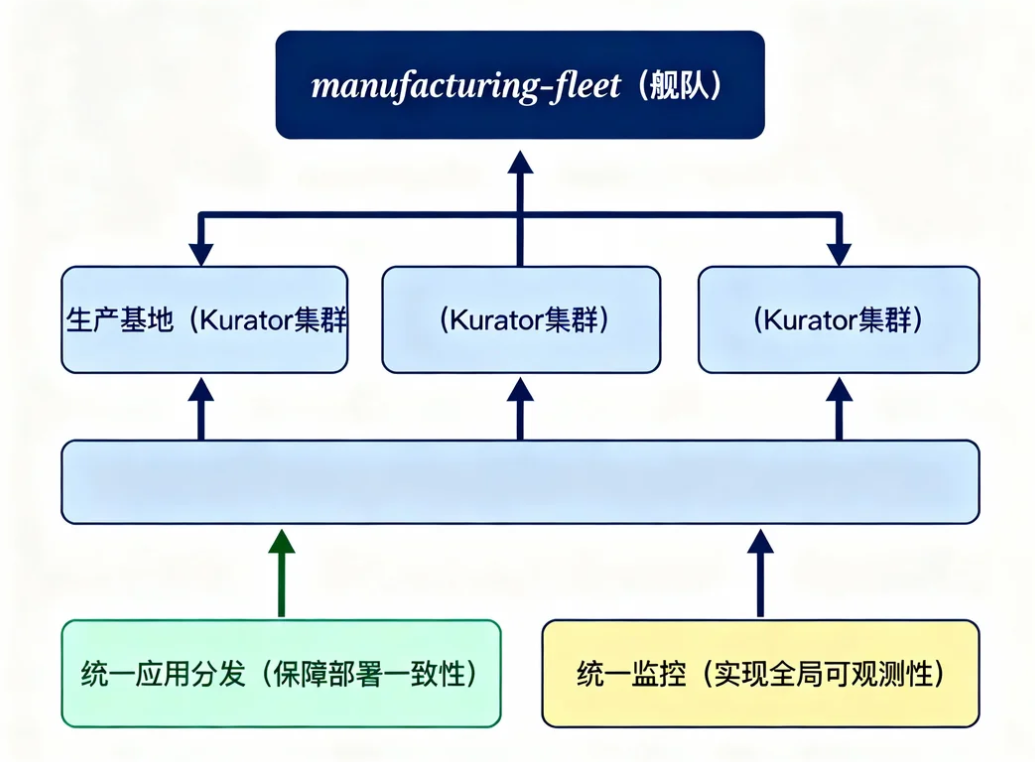

架构方案:

- 每个生产基地作为一个Kurator集群

- 所有生产集群纳入"manufacturing-fleet"舰队

- 通过统一应用分发实现业务部署一致性

- 通过统一监控实现全局可观测性

5.3 技术适配与攻坚

落地过程中解决的两个关键技术挑战:

挑战1:跨地域网络延迟

- 问题:基地间网络延迟高达80ms,集群同步偶发超时

- 解决方案:调整Kurator Agent心跳间隔(10s→30s),启用增量同步模式

挑战2:多存储插件兼容

- 问题:各基地使用不同存储(Ceph、NFS、AWS EBS)

- 解决方案:通过Kurator抽象存储接口,封装统一存储策略模板

5.4 落地成效与价值度量

平台上线3个月后,A企运维团队反馈:

- 效率提升:应用发布周期从3天缩短至4小时(通过Kurator AppHub统一分发)

- 成本降低:冗余集群资源利用率从35%提升至65%,年节省服务器采购成本约200万

- 稳定性增强:跨地域故障自动迁移,业务中断时间从小时级降至分钟级

六、Kurator核心功能深度解析

6.1 统一应用分发:GitOps跨集群实践

Kurator的统一应用分发采用GitOps方式,简化多云异构环境配置复杂性。

yaml

apiVersion: apps.kurator.dev/v1alpha1

kind: Application

metadata:

name: gitrepo-kustomization-demo

namespace: default

spec:

source:

gitRepository:

interval: 3m0s

ref:

branch: master

timeout: 1m0s

url: https://github.com/stefanprodan/podinfo

syncPolicies:

- destination:

fleet: quickstart

kustomization:

interval: 5m0s

path: ./deploy/webapp

prune: true

timeout: 2m0s该配置实现了从Git源获取应用配置,通过Fleet同步到多个集群的能力。

6.2 统一监控:多集群指标聚合

Kurator提供基于Prometheus、Thanos、Grafana的多集群指标监控方案:

yaml

apiVersion: fleet.kurator.dev.v1alpha1

kind: Fleet

metadata:

name: quickstart

namespace: default

spec:

clusters:

- name: kurator-member1

kind: AttachedCluster

- name: kurator-member2

kind: AttachedCluster

plugin:

metric:

thanos:

objectStoreConfig:

secretName: thanos-objstore

grafana: {}监控架构:

- 每个集群运行Prometheus实例收集本地监控数据

- Thanos Sidecar将数据推送到远程存储

- Thanos Query聚合所有数据,提供统一查询接口

- Grafana展示统一监控视图

6.3 统一策略管理:多集群安全基线

通过Kyverno和Fleet,Kurator为多云、多集群环境提供统一策略管理:

yaml

apiVersion: fleet.kurator.dev/v1alpha1

kind: Fleet

metadata:

name: quickstart

namespace: default

spec:

clusters:

- name: kurator-member1

kind: AttachedCluster

- name: kurator-member2

kind: Cluster

plugin:

policy:

kyverno:

podSecurity:

standard: baseline

severity: high

validationFailureAction: Audit此配置为Fleet中所有集群统一应用Pod安全策略,确保安全性一致性。

七、总结与展望

7.1 Kurator核心价值总结

通过从零开始的实践体验,Kurator的核心价值主要体现在:

- 简化管理复杂度:通过舰队抽象,将多集群管理简化为单集群体验

- 提升运维效率:统一的应用分发、监控、策略管理,减少重复操作

- 保证一致性:GitOps方法论确保跨集群应用和配置的一致性

- 降低技术门槛:开箱即用的集成方案,减少组件集成工作量

7.2 未来展望

随着分布式云成为新常态,Kurator作为分布式云原生平台的价值将愈发凸显。从技术路线看,Kurator未来可能在以下方面持续进化:

- 更强大的网络治理:跨集群服务发现和流量管理能力增强

- AI与大数据场景优化:针对AI训练、大数据计算等场景的调度优化

- 边缘计算深度融合:与KubeEdge等边缘项目更紧密集成

- 自动化运维:基于AIOPs的智能运维和自动化决策

对于正在考虑或已经踏上分布式云原生之旅的企业和开发者,Kurator提供了一个成熟、开放、完整的技术方案,值得深入探索和实践。

参考资料:

实践出真知,只有亲自动手部署和体验,才能真正领会Kurator在分布式云原生环境中的价值。期待在Kurator社区看到更多分享和交流!

本文详细记录了从环境准备、安装部署到核心功能实践的完整过程,涵盖了Kurator在分布式云原生环境中的关键价值点。通过实际案例验证,Kurator确实能够显著降低多云多集群环境的管理复杂度,提升运维效率,是企业构建分布式云原生基础设施的优选方案。