1线性回归,最小二乘(高数角度),正规方程组(线性代数角度),贝叶斯(概率角度)

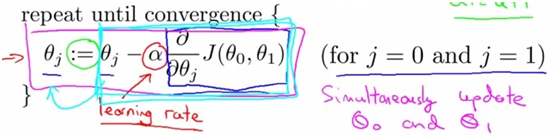

初始化假设h(theta)=theta0+theta1*x,(这里以单变量为例),利用梯度下降法进行权值的更新。

中J(theta0,theta1)就是损失函数,即(1/2m)*(h(theta)-y)^2。A代表机器学其习率,梯度下降算法中另一关键点就是机器学习率的设计:设计准则是保证每一步迭代后都保证能使cost function下降,a过小会导致J(theta)收敛过慢,a过大,则会导致J(theta)跨步较大,可能会得到相反的结果,随着迭代次数的增加,J(theta)越跳越大,造成无法收敛。

与gradient descent平行的一种方法为Normal Equation,它采用线性代数中非迭代的方法

对于有m个样本,每个拥有n个feature的一个训练集,有X是m×(n+1)的矩阵,XTX是(n+1)×(n+1)的方阵,那么对于参数θ的计算就出现了一个问题,如果|XTX|=0,即XTX不可求逆矩阵怎么办?这时可以进行冗余feature的删除(m<=n的情况,feature过多)。其实这里是利用行列式中任意两行相同,该行列式为0,所以feature中可能有冗余,进而来删除冗余,以达效果。

2逻辑回归与过拟合的解决。

所谓one-vs-all method就是将binary分类的方法应用到多类分类中。比如我想分成K类,那么就将其中一类作为positive,另(k-1)合起来作为negative,这样进行K个h(θ)的参数优化,每次得到的一个hθ(x)是指给定θ和x,它属于positive的类的概率。

线性回归和logistic回归都有过拟合的问题,解决方案一般有两种:1减少feature的数量,2添加normal regularization.

问题,最小二乘,logistic,梯度下降之间的关系,以及所处的位置(即功能)

最小二乘法和Logistic回归的目标函数,可使用不同的概率分布,在极大似然估计的框架下导出------分别是高斯分布和二项分布;因此,它们同属于(广义)线性模型。梯度下降是具体的数值计算手段;并且,这两个目标函数的二阶导Hessian矩阵正(负)定,全局最优一定是局部最优解

3神经网络

引入神经网络的目的,其实就是为了解决多个特征,多个样本的问题,多个样本,比如下图中这个例子:从100*100个pixels中选出所有XiXj作为logistic regression的一个参数,那么总共就有5*10^7个feature,即x有这么多维。

向前传递

Backpropagationalgorithm其实是误差反向传播,定义神经网络的总误差为:

希望通过调整权重参数(theta)来最小化E,每层按照如下方式进行更新

根据backpropagation算法进行梯度的计算,这里引入了error变量δ,该残差表明了该节点对最终输出值的残差产生了多少影响。对于最后一层,我们可以直接算出网络产生的输出与实际值之间的差距,我们将这个差距定义为。对于隐藏单元我们如何处理呢?我们将通过计算各层节点残差的加权平均值计算hidden layer的残差。在最后一层中,

对于前面的每一层,都有

4深度学习

1、有监督学习和无监督学习

有监督学习:最常见的是分类和回归

regression:Y是实数vector。回归问题,就是拟合(X,Y)的一条曲线,使得cost function L最小。

2、无监督学习:无监督学习的目的是学习一个function f使它可以描述给定数据的位置分布P(Z)。包括两种:density estimation & clustering.densityestimation就是密度估计,估计该数据在任意位置的分布密度。clustering就是聚类,将Z聚集几类,或者给出一个样本属于每一类的概率。由于不需要事先根据训练数据去train聚类器,故属于无监督学习。

深度学习核心思想:

把learning hierarchy 看做一个network,则

①无监督学习用于每一层网络的pre-train;

②每次用无监督学习只训练一层,将其训练结果作为其higher一层的输入;

③用监督学习去调整所有层

深度神经网络的一大特点就是含有多隐含层

CNN(深度卷积网络)和DBN(深度置信网络)

卷积神经网络是一种特殊的深层的神经网络模型,它的特殊性体现在两个方面,一方面它的神经元间的连接是非全连接 的,另一方面同一层中某些神经元之间的连接的权重是共享的(即相同的)。它的非全连接和权值共享的网络结构使之更类似于生物神经网络,降低了网络模型的复杂度(对于很难学习的深层结构来说,这是非常重要的),减少了权值的数量。

卷积网络是为识别二维形状而特殊设计的一个多层感知器

ELM(极限学习机)

极限学习机(ExtremeLearning Machine) ELM,是由黄广斌提出来的求解神经网络算法。ELM最大的特点是对于传统的神经网络,尤其是单隐层前馈神经网络(SLFNs),ELM比传统的学习算法速度更快。