检索增强生成(RAG)

通过检索器检索专有知识(向量数据库)并入输入给大模型,生成的答案更可靠,还有助于缓解"幻觉"问题。

LangChain 文档中可以找到一个使用检索器和 LLM 回答问题并给出知识来源的简单例子 python.langchain.com/docs/tutori...

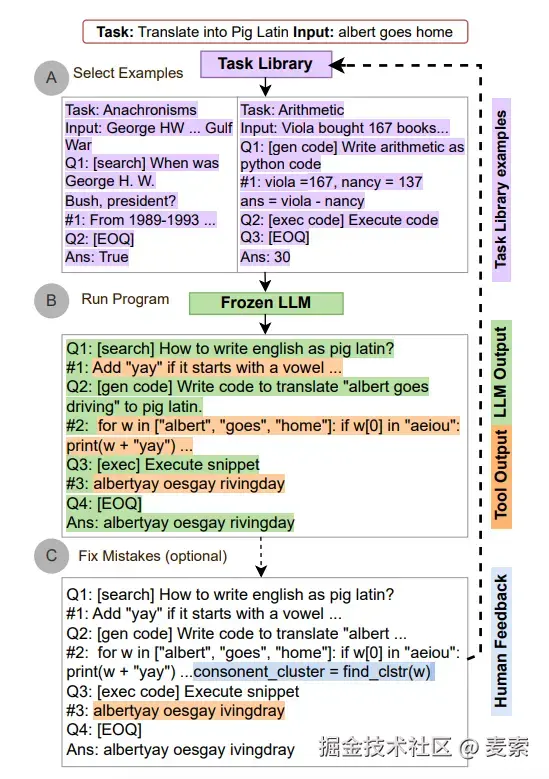

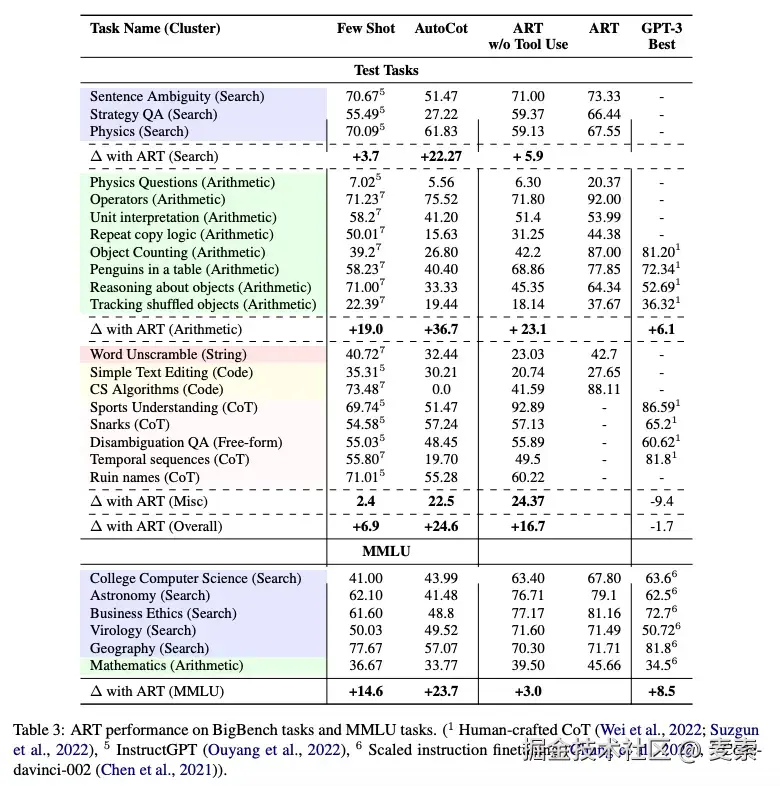

自动推理并使用工具(ART)

交替运用 CoT 提示和工具已经被证明是一种强大而稳健的方法。使用冻结的 LLM 来自动生成包含中间推理步骤的程序,其工作原理如下:

- 接到一个新任务的时候,从任务库中选择多步推理和使用工具的示范。

- 在测试中、调用工具时先暂停生成,将工具输出整合后继续接着生成。

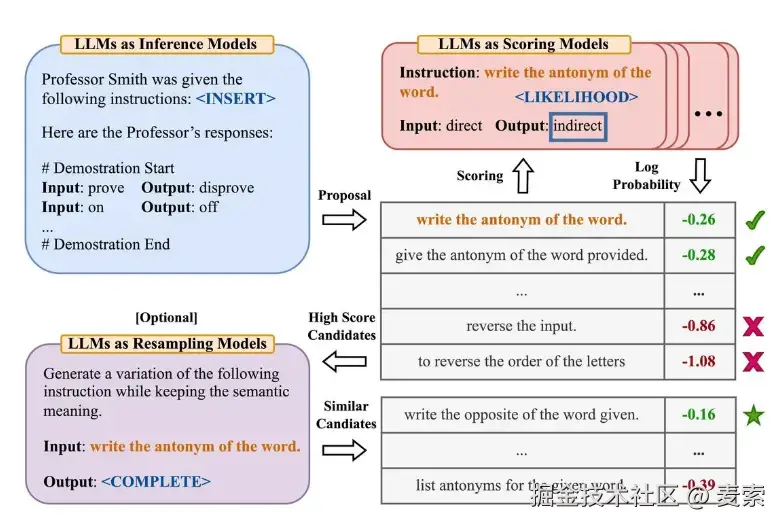

自动提示工程师(APE)

自动指令生成和选择:

🤖 APE 是怎么工作的?

- 目标明确:告诉 AI 你想完成什么任务,比如"总结一段话"或"翻译成英文"。

- AI 自己生成提示语:系统会让 AI 自动生成很多种不同的提问方式(比如:"请总结这段话","给我一个简短的摘要","这段内容讲了啥?"等等)。

- 测试哪种最好:然后系统再让 AI 测试这些提示语,看哪个效果最好(也就是 AI 回答得最准确、最有用)。

- 选出最优提示:最后系统挑出那个"最棒的提示语",以后就可以直接用了!

🎯 举个例子:

假设你希望 AI 把中文翻译成英文。

- APE 会自动生成一些提示语:

- "请把下面这句话翻译成英文。"

- "翻译这个句子为英语。"

- "将以下内容转换为英文。"

- 然后测试哪一句翻译得最准,就把那一句保留下来。

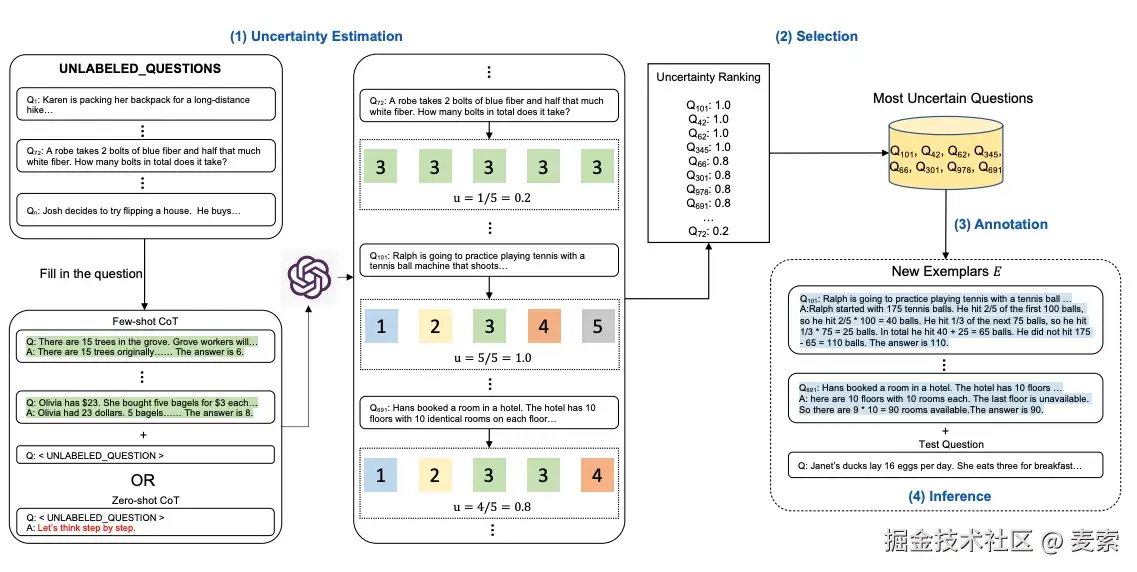

活动提示(Active-Prompt)

CoT 方法依赖人工样本范例,但这些范例可能不是不同任务的最有效的。Active-Prompt 方法为 LLM 应用到不同的任务提供了新的思路。

过程:

- 使用或不使用少量 CoT 示例查询 LLM,让 LLM 生成 K 个可能的答案

- 选择最不确定的问题由人类进行注释

- 使用新的注释范例来推断每个问题

方向性刺激提示

程序辅助语言模型(PAL)

读取自然语言问题并生成程序作为中间推理步骤。

自我反思(Reflexion)

写一个关于雨天的故事,100字即可 反思一下这个故事还有哪些提升的点 按照上面的反思来优化这个故事