我的创作纪念日:在CSDN的技术写作之旅

机缘

最初成为技术创作者的初心,源于在实战项目中遇到的种种挑战和解决方案的积累。还记得第一次在CSDN发表文章,是因为高中时很喜欢编程以开发一个完整的小程序来证明自己并发布了有关微信小程序的文章最详细的微信小程序制作方法。当时就想,如果能把这样的经验记录下来,既能帮助遇到同样问题的同行,也能为自己的技术成长留下印记。

从那时起,技术写作就成了我技术生活中不可或缺的一部分。无论是日常学习中的新知识梳理,还是文章中的一步一步地操作,我都习惯用文字来沉淀和分享。

收获

在创作的道路上,收获远超预期:

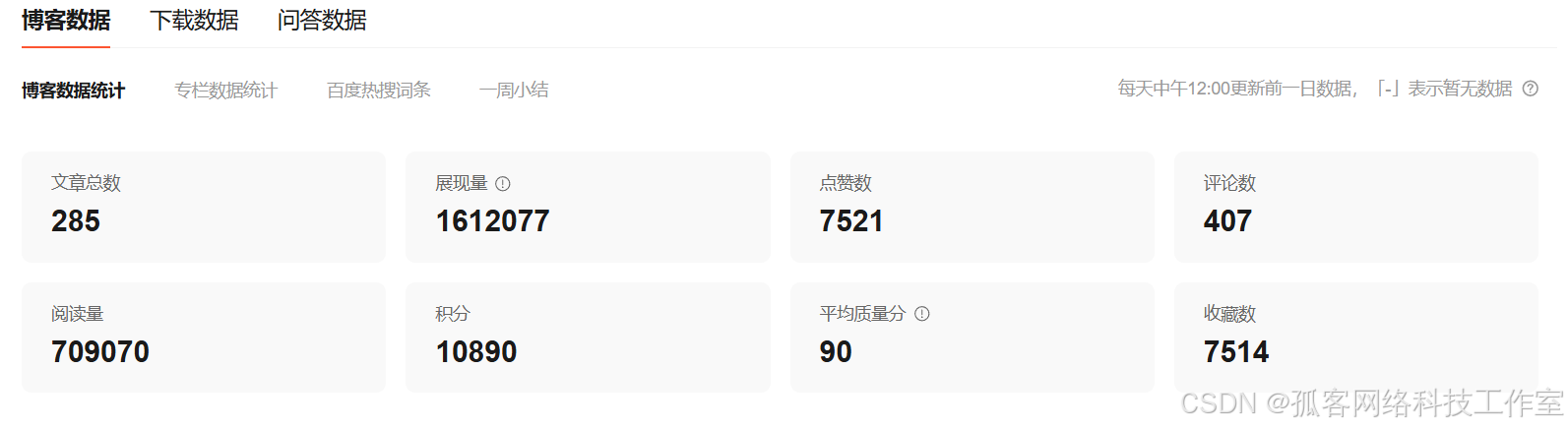

- 粉丝与影响力 :收获了4334粉丝的关注,每一份关注都是对我内容质量的认可

- 互动与反馈 :累计获得7524 点赞,407+ 条有价值的评论互动

- 数据表现 :单篇文章最高阅读量达6.8万+,多篇文章被CSDN首页推荐

- 行业连接 :通过文章认识了多位志同道合的技术专家,甚至促成了几次宝贵的合作机会

最让我感动的是,有读者专门留言说我的某篇文章帮助他解决了工作中的关键技术难题,这种能够实际帮助到他人的成就感,是任何数据都无法衡量的。

日常

技术创作已经深度融入我的工作和学习生态中:

平衡之道:

- 每周固定安排两个晚上进行深度写作

- 利用碎片时间记录技术灵感和素材

- 将工作中的技术方案系统化整理成文

- 把写作当作技术学习的总结和升华

创作不仅没有影响工作,反而促使我更深入地理解技术本质,形成了"学习-实践-总结-分享"的良性循环。

成就

分享一段让我颇为自豪的代码------一个高效处理海量数据的分布式任务调度框架核心模块:

java

/**

* 智能任务分片调度器 - 支持动态分片和负载均衡

*/

@Component

@Slf4j

public class SmartTaskShardingScheduler {

private final RedisTemplate<String, Object> redisTemplate;

private final ZSetOperations<String, String> zSetOperations;

// 基于一致性哈希的动态分片算法

public List<TaskShard> dynamicSharding(List<String> allTasks,

int shardCount,

String jobInstanceId) {

// 获取活跃的工作节点

Set<String> activeNodes = getActiveWorkerNodes();

if (activeNodes.isEmpty()) {

throw new RuntimeException("No available worker nodes");

}

// 构建一致性哈希环

ConsistentHash<String> consistentHash = new ConsistentHash<>(32, activeNodes);

List<TaskShard> shards = new ArrayList<>();

// 动态分片:根据节点性能和负载情况分配任务

Map<String, NodeLoadInfo> nodeLoadMap = getNodeLoadInfo(activeNodes);

for (int i = 0; i < allTasks.size(); i++) {

String task = allTasks.get(i);

// 考虑节点负载的智能路由

String assignedNode = weightedAssignNode(consistentHash, task, nodeLoadMap);

TaskShard shard = new TaskShard();

shard.setTaskId(task);

shard.setAssignedNode(assignedNode);

shard.setShardIndex(i % shardCount);

shards.add(shard);

// 更新节点负载信息

updateNodeLoad(assignedNode, 1);

}

log.info("Job {} sharded into {} shards across {} nodes",

jobInstanceId, shards.size(), activeNodes.size());

return shards;

}

// 基于权重的节点分配算法

private String weightedAssignNode(ConsistentHash<String> consistentHash,

String task,

Map<String, NodeLoadInfo> nodeLoadMap) {

List<String> candidateNodes = consistentHash.getNodes();

double totalWeight = 0.0;

// 计算基于CPU、内存、网络负载的综合权重

Map<String, Double> weightMap = new HashMap<>();

for (String node : candidateNodes) {

NodeLoadInfo loadInfo = nodeLoadMap.get(node);

double weight = calculateNodeWeight(loadInfo);

weightMap.put(node, weight);

totalWeight += weight;

}

// 加权随机选择

double random = Math.random() * totalWeight;

double currentWeight = 0.0;

for (String node : candidateNodes) {

currentWeight += weightMap.get(node);

if (random <= currentWeight) {

return node;

}

}

return candidateNodes.get(0);

}

// 综合权重计算

private double calculateNodeWeight(NodeLoadInfo loadInfo) {

double cpuWeight = (100 - loadInfo.getCpuUsage()) / 100.0 * 0.4;

double memoryWeight = (100 - loadInfo.getMemoryUsage()) / 100.0 * 0.3;

double networkWeight = (100 - loadInfo.getNetworkLoad()) / 100.0 * 0.3;

return cpuWeight + memoryWeight + networkWeight;

}

// 故障转移和重分片机制

public void handleNodeFailure(String failedNode) {

log.warn("Detected node failure: {}, initiating resharding", failedNode);

// 获取该节点负责的所有任务

Set<String> affectedTasks = getTasksByNode(failedNode);

if (!affectedTasks.isEmpty()) {

// 重新分片到健康节点

List<TaskShard> newShards = dynamicSharding(

new ArrayList<>(affectedTasks),

getOptimalShardCount(),

"failover-" + System.currentTimeMillis()

);

// 更新任务分配信息

updateTaskAssignment(newShards);

log.info("Failover completed: {} tasks reassigned", affectedTasks.size());

}

}

}这段代码在我们的生产环境中稳定运行,每天处理数百万级别的任务调度,实现了:

- 动态负载均衡:基于实时节点性能智能分配

- 故障自愈:节点故障时自动重新分片

- 高性能:支持万级QPS的任务调度

- 可观测性:完整的监控和日志体系

憧憬

职业规划:

- 深入钻研云原生和AI基础设施领域

- 向技术专家和架构师方向发展

- 培养更多年轻工程师,传承技术经验

创作规划:

- 计划推出Python零入门到大师系列专栏

- 探索视频+图文的多媒体技术分享形式

- 目标在一年内产出50+ 高质量技术文章

- 希望能出版自己的技术专著

技术愿景 :

希望通过持续的技术分享,推动国内技术社区的发展,让更多开发者能够站在前人的肩膀上,避免重复踩坑,共同构建更加繁荣的技术生态。

感谢CSDN这个平台,让我能够与这么多优秀的技术人同行。创作之路虽然不易,但每次看到读者的肯定和感谢,都觉得一切付出都是值得的。期待在下一个创作纪念日,能够分享更多的成长和突破!

感谢阅读,让我们在技术的道路上继续同行,共同进步!