大家好,这里是程序员晚枫。

2025年4月,Python官方发布了PEP 784最终提案,宣布将Zstandard(简称Zstd)压缩库正式纳入标准库,配套推出compression统一命名空间。这是自2012年Python 3.3添加lzma模块后,标准库在压缩领域的首次重大更新。十年磨一剑,Zstd凭什么能打破僵局?统一命名空间又将如何改写Python压缩生态?

Zstd凭什么成为Python标准库新宠?

在Python现有压缩模块中,zlib(DEFLATE算法)、gzip、bzip2和lzma已服役多年,但性能瓶颈日益凸显。Zstd的出现,彻底改变了这一格局。

作为Meta开发的开源压缩算法,Zstd的核心优势堪称"全能型选手":压缩率远超zlib和bzip2,接近lzma但解压速度快3-5倍。Anaconda的实测数据显示,采用Zstd后包下载大小减少30-40%,安装速度直接提升2.5倍------这意味着原本10分钟的依赖安装,现在只需4分钟就能完成。

更关键的是,Zstd早已不是实验室产品。它已被IETF标准化为RFC 8478,成为ZFS/Btrfs文件系统、Linux内核、conda包管理器的标配。"Zstd的解压速度让我们的CI/CD流水线效率提升了40%,"一位字节跳动工程师在社区评论中感叹,"Python终于跟上了行业节奏。"

统一命名空间:解决十年老问题

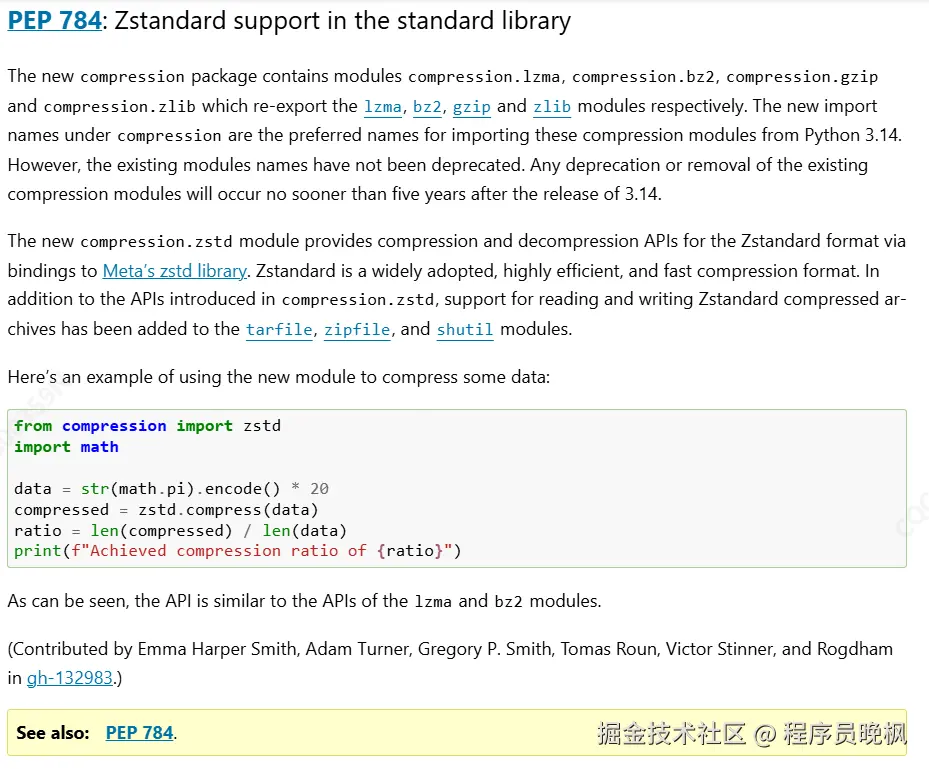

但Zstd的加入并非简单"模块新增"。PEP 784最颠覆性的设计,是推出compression顶级命名空间。

长期以来,Python压缩模块分散在zlib、gzip等独立模块中,而PyPI上早已存在zstd和zstandard第三方包,直接使用原名必然引发冲突。新方案将所有压缩模块统一收纳:

- 新Zstd模块命名为

compression.zstd - 现有模块通过

compression.gzip、compression.lzma等方式重新导出 - 原模块入口(如

import gzip)至少保留5年过渡期

"这就像给杂乱的工具箱装了抽屉,"Python核心开发者Gregory P. Smith解释,"未来开发者无需记忆'该用zlib还是gzip',直接从compression命名空间选择算法即可。"

为保证兼容性,官方提供了平滑过渡方案:

python

# 兼容新旧版本的导入方式

try:

from compression.lzma import LZMAFile

except ImportError:

from lzma import LZMAFile # 旧版本回退技术规范与安全底线

Zstd模块基于成熟的pyzstd项目实现,API设计与现有模块保持一致:

- 基础接口 :

compress()/decompress()支持一次性压缩 - 流接口 :

ZstdFile/open()处理大文件流 - Zstd特有功能 :字典训练(

train_dict())优化小数据压缩

技术团队对依赖管理做了严格限制:Unix系统通过包管理器动态检测libzstd,Windows则内置源码依赖,若系统缺失库文件,模块会"优雅失效"而非崩溃。安全方面,代码通过libfuzzer模糊测试和AddressSanitizer内存检测,Meta的每日安全测试也为zstd库本身提供保障。

值得注意的是,官方明确否决了多个争议方案:曾考虑用zstdlib作为模块名,但因易拼写错误被弃;计划将zipfile纳入命名空间,最终因"压缩与归档是不同概念"作罢。这些细节透露出一个信号:Python正在用更系统化的思维重构基础设施。

对开发者意味着什么?

对普通开发者而言,最直接的变化是** wheel包体积更小、安装更快**。目前PyPI上超过70%的wheel包仍使用zlib压缩,若全面转向Zstd,按Anaconda的数据推算,平均下载时间可缩短35%。

框架维护者则迎来新机遇:tarfile、zipfile模块已在参考实现中集成Zstd支持,未来处理大型日志、备份文件时,开发者可直接调用compression.zstd接口,无需额外安装第三方库。"想象一下,用Python处理10GB日志文件,解压速度提升5倍是什么体验?"一位数据工程师在Reddit评论区留言。

结语:Python生态的"压缩革命"

从zlib到Zstd,从分散模块到统一命名空间,PEP 784的意义远不止添加一个新功能。它标志着Python正在用现代化思维重构基础设施------既要保持"内置电池"的便利性,又要解决历史遗留的生态碎片化问题。

随着Python 3.14的临近,这场"压缩革命"即将落地。对开发者而言,是时候更新依赖管理策略;对行业而言,这或许是Python在大数据、云原生场景竞争力提升的关键一步。毕竟,在存储成本与传输效率日益重要的今天,每一个字节的优化,都可能成为下一个技术突破的起点。