介绍

ollama 是一个开源的本地大语言模型(LLM)运行平台,允许用户在本地计算机上轻松部署、运行和管理各种大型语言模型(deepseek,qwen,gemma3,...)。

主要特点:

- 🚀 本地运行:模型完全在本地运行,无需联网,保护隐私

- 📦 简单易用:一键安装,命令行操作简单

- 🔧 多平台支持:支持 Windows、macOS、Linux

安装

windows 系统

- 官网下载链接:ollama.com/download

- 双击下载的 .exe 文件进行安装

Ubuntu/Debian 系统

curl -fsSL https://ollama.com/install.sh | sh

拉取模型

- 搜索地址: ollama.com/search

- 以下是一些常用模型,不需要显卡用cpu就可以带起来;

- 如有好一点的显卡(如 GeForce RTX 4060),可使用 32B 的模型,效果更好。

bash

ollama pull codellama:7b # 代码模型

ollama pull gemma3:4b # Google Gemma 模型

ollama pull qwen3:8b # 通义千问模型

ollama pull qwen2.5-coder:7b # 通义千问代码模型

ollama pull deepseek-r1:7b # deepseek 模型

ollama pull deepseek-coder:6.7b # deepseek 代码模型- 查看已有模型:

ollama list

bash

ollama list

NAME ID SIZE MODIFIED

deepseek-r1:7b 0a8c26691023 4.7 GB 7 months ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 7 months ago- 注意:要是无法拉取,可以挂一下代理

- 拉取的模型文件在

C:\Users\[账户名]\.ollama路径下(windows),如过想把模型移动到另一台内网电脑,可以打包复制该文件夹

运行模型

- 默认 Ollama服务绑定到

127.0.0.1:11434

bash

ollama run deepseek-r1:7b - 可修改

OLLAMA_HOST替换服务端口

bash

# Linux/macOS

export OLLAMA_HOST=0.0.0.0:11435

ollama serve

# Windows (Command Prompt)

set OLLAMA_HOST=0.0.0.0:11435

ollama serve

# Windows (PowerShell)

$env:OLLAMA_HOST="0.0.0.0:11435"

ollama serve使用

open-webui

-

python 安装运行:

bash

pip install open-webui

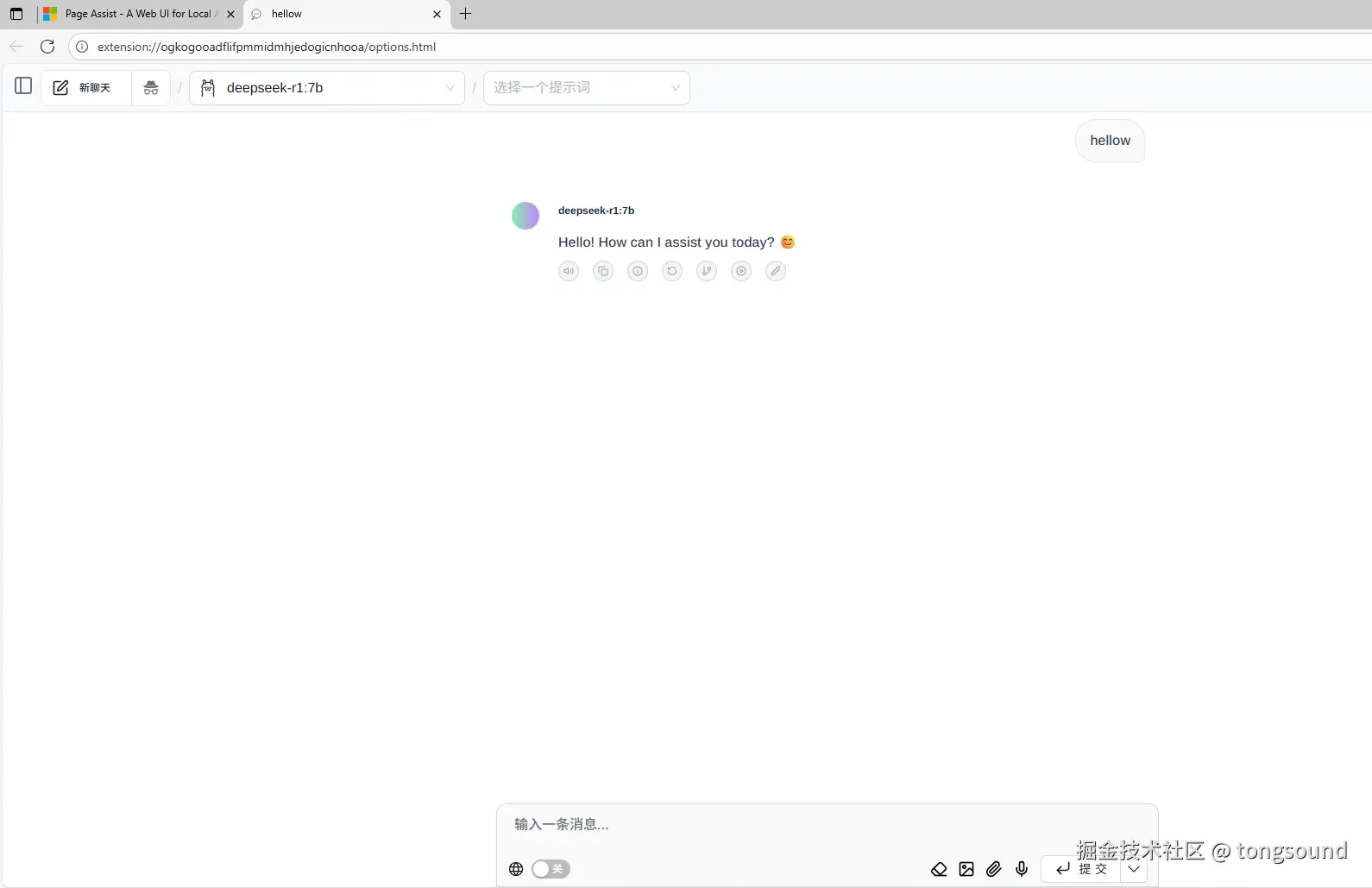

open-webui serveedge浏览器插件:Page Assist

-

edge浏览器插件:Page Assist - A Web UI for Local AI Models

-

示例如下:

-

一般情况浏览器插件就可以了,方便些

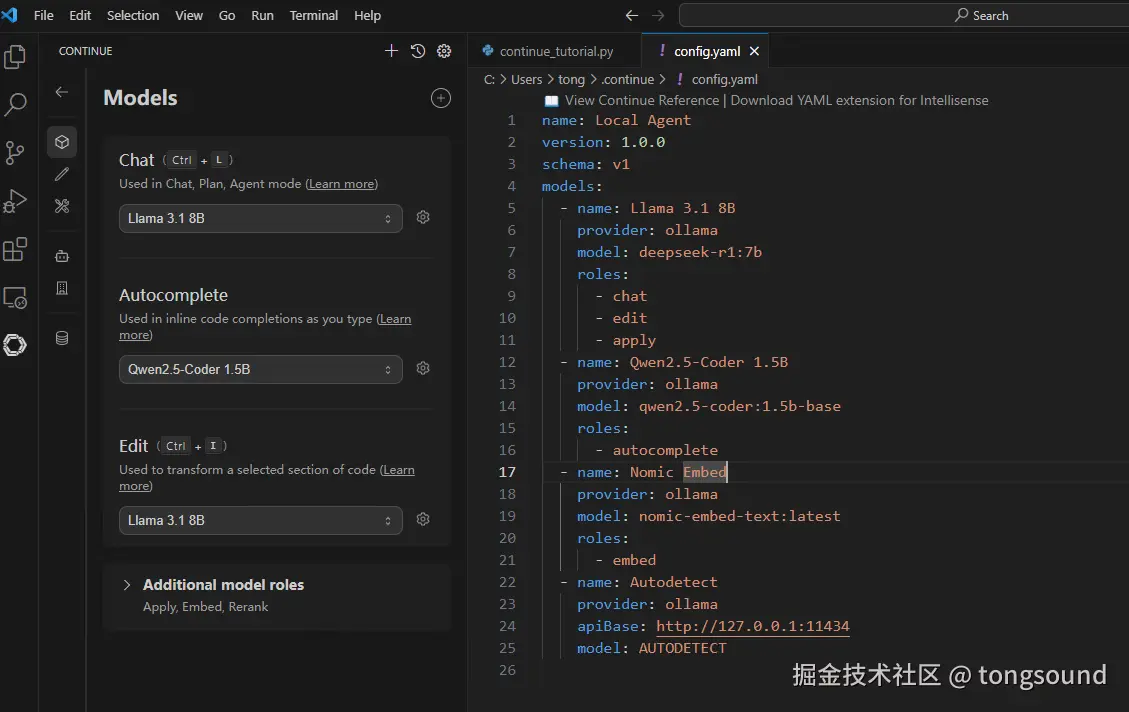

vscode 插件 : Continue.continue

- marketplace.visualstudio.com/items?itemN...

- 可以用来 代码编辑 及 代码自动补全

- v1.2.8 版本配置示例如下:

- 部署到服务器时,IP端口改成对应的服务器IP端口

bash

name: Local Agent

version: 1.0.0

schema: v1

models:

- name: Llama 3.1 8B

provider: ollama

model: deepseek-r1:7b

roles:

- chat

- edit

- apply

- name: Qwen2.5-Coder 1.5B

provider: ollama

model: qwen2.5-coder:1.5b-base

roles:

- autocomplete

- name: Nomic Embed

provider: ollama

model: nomic-embed-text:latest

roles:

- embed

- name: Autodetect

provider: ollama

apiBase: http://127.0.0.1:11434

model: AUTODETECT