引言(Introduction)

人工智能(AI)与机器学习(ML)的迅猛发展为企业利用数据驱动洞察创造了新机遇。但把 AI 融入既有企业工作流常常面临重大挑战:基础设施复杂度高、数据安全顾虑多、且需要大量专业人才。Snowflake Cortex AI 通过将 AI/ML 能力直接嵌入 Snowflake Data Cloud ,为企业提供一条无缝且高效的 AI 采用路径,从而正面应对这些挑战。

Snowflake Cortex 向组织提供强大的能力与基于 SQL 的 ML 与 LLM 函数 ,使用户无需深入的机器学习专长也能开展高级分析。也就是说,数据从业者、业务分析师与开发者都能轻松在工作流中引入 AI 洞察,而不必进行繁重的建模或基础设施管理。

Cortex 的关键优势在于其与 Snowflake 安全且受治理的环境 实现原生集成 。由于 AI 负载在 Snowflake 平台内执行,组织在利用 AI 能力的同时,仍可保持数据完整性、合规与安全 。这减少了数据搬移需求,确保敏感信息持续受 Snowflake 治理体系保护。

通过提供低代码/无代码 的 AI 分析界面,Snowflake Cortex 让企业更高效地释放数据价值。无论是文本摘要、情感分析、异常检测还是预测,Cortex 都让 AI 对各类规模的企业更易用、更可扩展。

结构(Structure)

本章将探讨 Snowflake Cortex 的关键方面,包括:

- Cortex AI 的关键特性(Key Features of Cortex AI)

- Cortex AI 的关键组件(Key Components of Cortex AI)

- Snowflake Cortex 内置的 ML 与 LLM 函数(Built-in ML and LLM Functions)

- Snowflake Cortex 与传统 AI/ML 路径对比(Cortex vs. Traditional Approaches)

Cortex AI 的关键特性(Key Features of Cortex AI)

非单体的组件化体系 :Snowflake Cortex 不是单一体,而是一组相互联动的组件协同提供 AI/ML 能力。理解其功能,需要剖析这些基础要素:

1) 无服务器基础设施(Serverless Infrastructure)

Cortex 构建在 Snowflake 的无服务器架构 之上。用户无需关心资源配置、扩缩与运维 等基础设施细节,平台会按需自动分配与管理资源,让用户专注分析任务。

这种无服务器特性带来弹性伸缩 :无论处理小数据集还是企业级海量数据,Cortex 都能随需而变而不牺牲性能。

2) 一体化数据云(Integrated Data Cloud)

Cortex 与 Snowflake Data Cloud 深度集成,从根源上消除了数据搬移 这一传统 AI/ML 流程中的瓶颈。Cortex 直接在 Snowflake 环境中的数据之上运行,降低时延、提升效率 。

这种集成也让你可以触达数据云内庞大的数据、应用与服务生态,进一步拓展 AI/ML 的应用潜力。

3) 内置 ML 与 LLM 函数(Built-in ML and LLM Functions)

Cortex 的一大亮点是预构建 的 ML 与 大语言模型(LLM) 函数,使用户以极低门槛运行 AI 驱动的分析。这些内置函数覆盖广泛场景------从预测建模到自然语言处理(NLP)------从而减少对深度数据科学专长或外部平台的依赖。后续章节将详细展开这些函数。

4) 集成式 Notebook,流畅的 AI 开发(Integrated Notebooks)

Snowflake Notebooks 为 Cortex AI 提供了动态、交互 的工作空间,可在单一界面融合 SQL、Python 与 Markdown ,顺畅承载数据准备、建模与结果可视化。

借助 Notebooks 与 Cortex 的集成,用户可快速原型并迭代 AI 模型,结合 Cortex 的查询与分析能力不断打磨方案;协作环境也利于团队共创与知识传递 ,从而加速从实验到生产的路径。

5) 安全的数据治理(Secure Data Governance)

Snowflake Cortex 将安全与治理 编织进平台底座:访问控制、数据脱敏与加密无缝集成 于工作流,确保在 AI/ML 生命周期各阶段都保护数据机密性并满足监管合规 。这使得在敏感数据上开展 AI/ML 成为可能且合规。

6) 简化的 AI/ML 部署(Simplified AI/ML Deployment)

Cortex 以简洁可管 为目标重塑了部署体验:从建模到投产的整段流程 被显著简化 。

用户只需极少的操作即可更快交付价值 ;平台代管部署复杂度,让业务分析师也能用 AI ,无需成为数据科学家。底层的繁重工作由 Cortex 负责,用户通过简单的调用即可使用强大模型。

7) 可扩展与弹性性能(Scalable and Elastic Performance)

Cortex 的可扩展、弹性 性能让企业能从容扩展 AI 能力:随着数据与项目复杂度提升,Cortex 会平滑扩展 而保持稳定表现,并通过按量计费 实现成本优化。无服务器架构带来负载高峰也能稳定 的体验,帮助企业从小做起、按需扩展,构筑面向未来的 AI 平台。

8) 原生 SQL 集成(Native SQL Integration)

Cortex 与数据领域的"通用语言"SQL 深度整合。用户可在熟悉的 SQL 中内嵌 AI/ML 函数 ,以更简洁的方式完成分析与报表,把现有 SQL 技能无缝迁移到 AI 任务上。

9) 广泛的 LLM 支持(Support for a Wide Range of LLMs)

Snowflake Cortex 可访问多家领先厂商与自研模型(如 Mistral AI、Google、Meta、Anthropic、以及 Snowflake 自家的 Arctic ),涵盖 mistral-large、mixtral-8x7b、llama2-70b-chat、Claude Sonnet、gemma-7b、Llama 3(8B/70B) 等,模型谱系不断扩展。用户可按用例择优 :文本生成、情感分析、语义搜索或复杂推理------皆可在 Snowflake 的安全与治理环境中完成。

10) 自动化文档智能(Automated Document Intelligence)

Document AI 提供文档处理自动化 能力,可从发票、合同等海量文档 中自动抽取关键信息,尤其适合金融、医疗与法律等高文档量 行业。它可适配不同文档类型 并持续学习,随着样本文档积累,抽取与理解能力不断进化。

11) Agentic AI 能力(Agentic AI Capabilities)

Snowflake Cortex 引入企业级的 Agentic AI :以 LLM 为核心的自治代理 可在最小人工干预下执行任务、分析数据与做出决策。代理与 Cortex Search (语义/关键词检索)和 Cortex Analyst (结构化数据自然语言分析)无缝协作,能够理解意图、检索关键信息并编排行动 ,贯穿数据工作流与外部系统。

这些代理还能与 Microsoft Teams、Slack 等协作平台集成,在用户的日常工作场景 中进行上下文感知的交互。

Cortex AI 的关键组件(Key Components of Cortex AI)

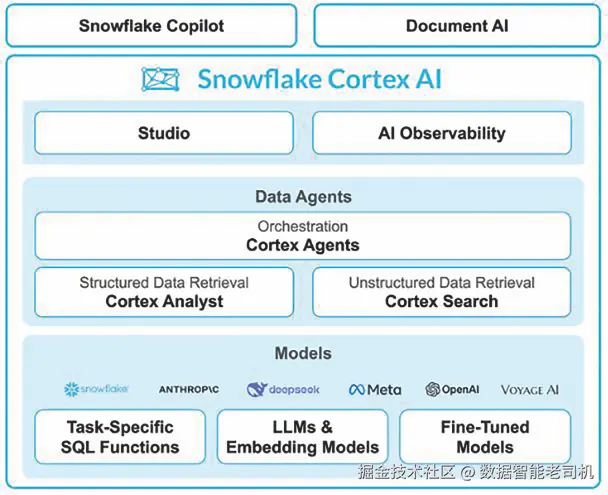

如前所述,Snowflake Cortex AI 是 Snowflake 内部的一个集成式 AI/ML 生态 ,提供预构建 AI 模型 、自然语言交互 与智能检索 能力。其架构(见下图示意)由四层组成:Studio、Chat、AI Models、Search/Analyst Tools 。这些组件协同工作,通过基于 SQL 的 AI 函数 、对话式交互 与无缝的文档处理,大幅简化 AI 的采用门槛。

图 2.1:Cortex AI 的关键组件(来源:Snowflake.com)

Snowflake Copilot

一款 AI 驱动的助手 ,在 Snowflake 界面内,用自然语言帮助用户查询、探索并理解数据。它可简化复杂 SQL 的生成、即时提供洞察,并引导用户完成数据发现,无需深厚的技术背景。

Document AI

Document AI 让用户在 Snowflake Data Cloud 内,直接从非结构化文档 (如 PDF、发票、合同、表单)中提取结构化洞察。通过结合 OCR 、智能文档解析与 LLM ,它支持自动分类、实体抽取、摘要与情感分析,且无需将数据迁出安全的 Snowflake 环境。

Studio:集中式 AI 工作空间

Studio 是使用 Cortex AI 的中心枢纽,提供友好界面,便于数据从业者:

- 无需复杂配置即可探索 Snowflake 的 AI 能力;

- 试验适用于各类业务场景的 AI 模型;

- 在受治理与安全的环境中部署 AI 驱动的工作流。

作为构建/测试/打磨 AI 应用的界面,Studio 让用户更轻松地发挥 Cortex AI 的全部潜能。

AI 可观测性(AI Observability)

新引入的 AI Observability 为运行于 Data Cloud 内的 LLM 与 AI 模型 提供可视化与深度度量 :跟踪 提示(prompt)质量 、模型漂移(drift) 、时延 与幻觉(hallucinations)等指标,确保结果可靠、可解释 且可规模化优化 ,使 LLM 应用保持准确与合规。

Cortex Agents

Cortex Agents 能智能拆解复杂查询 ,并在 Snowflake 的各类 AI 服务间编排数据请求 :按需将请求路由至 Cortex Search (检索相关文档)或 Cortex Analyst (以自然语言生成结构化洞察)。这带来端到端 的数据交互体验,用户无需写代码或理解底层数据结构即可获得准确答案与洞察。

Cortex Analyst

面向结构化数据 ,帮助用户不写复杂 SQL 就能分析数据集。用户以自然语言提问,系统在幕后自动生成查询并返回结果 。业务人员与分析师由此能在 Snowflake 的安全/治理 平台内自助探索数据、加速决策。

Cortex Search

在 Snowflake 内,用自然语言跨文档集 (PDF、报告、内部文件等)进行问答与检索。它将关键词检索 与语义检索 结合,理解查询意图而非仅仅词面 ,帮助用户快速、安全地找回最相关的信息,无需手动翻阅或知道文档存放位置。

这些基于对话的 AI 工具民主化了数据访问 :业务用户、分析师与非技术干系人都能通过会话式 AI与数据互动。

模型层:规模化的 AI 能力(Models: AI Capabilities at Scale)

该层包含支撑 Cortex AI 的多类机器学习模型:

- 任务定制与嵌入模型(Task-Specific & Embedding Models) :针对分类、摘要、语义嵌入等专项任务进行优化,用于上下文理解与下游推理。

- 基础模型(Foundation Models) :可即取即用的大规模 AI 模型 (如 Mistral、Llama、Reka 等),覆盖语言理解、图像处理、预测分析等广泛应用。

- 微调模型(Fine-Tuned Models) :针对特定业务场景进行定制训练 ,在 Snowflake 环境内对基础模型进行微调,以获得更贴合领域的高质量结果。

Snowflake Cortex 内置的 ML 与 LLM 函数(Built-in ML and LLM Functions in Snowflake Cortex)

Snowflake Cortex AI 提供一套内置的 ML 与 LLM 函数 ,使用户能在 Snowflake 环境内直接利用 AI 驱动的洞察。这些函数可通过 SQL 与 Python 调用,便于集成到分析、自动化与预测建模任务中,而无需深厚的 AI 专业背景。

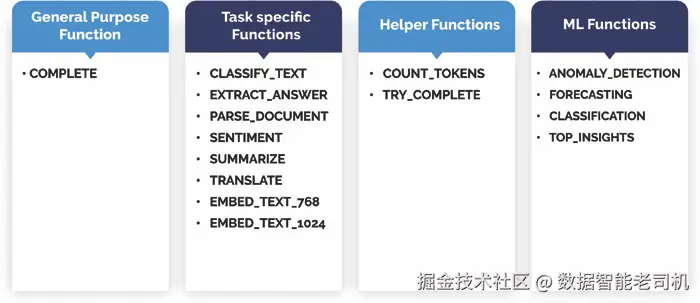

Cortex AI 函数分为以下几类:

- 通用型 LLM 函数(COMPLETE Function)

- 任务型 LLM 函数(Task-Specific LLM Functions)

- 辅助函数(Helper Functions)

- Snowflake 内置 ML 函数 (分类、异常检测、预测与关键洞察)

(注:前三类属于 Cortex 的 LLM 函数集合;此外还提供面向传统机器学习任务的内置 ML 函数。)

图 2.2:Snowflake ML 与 Cortex AI 函数

通用型 LLM 函数:COMPLETE

COMPLETE 是高度灵活的 LLM 函数,可应对多种 AI 任务,包括:

- 合成数据生成(Synthetic Data Generation) :生成逼真的人工数据集,便于测试与开发。

- 摘要与内容润色(Summarization & Content Refinement) :输出精炼摘要或重写结构化内容。

- 多模态智能(Multimodal Intelligence) :基于给定图像与提示生成语言模型响应。

此外,Cortex AI 提供 Cortex Guard 选项,用于拦截不当或有害输出 ;用户亦可对 COMPLETE 进行业务定制与微调,以符合特定场景需求。

任务型 LLM 函数(Task-Specific LLM Functions)

这些函数为常见 NLP 任务提供开箱即用的自动化能力,无需大量自定义:

- CLASSIFY_TEXT :按用户定义的标准将文本分类到预设标签。

- EXTRACT_ANSWER :在给定问题下,从非结构化文本 中抽取答案。

- PARSE_DOCUMENT :从结构化/非结构化文档 (含 PDF、图像)中抽取文本与版面要素。

- SENTIMENT :分析文本情感倾向并打分(-1=负面,1=正面)。

- SUMMARIZE :为长文档/文章生成精炼摘要。

- TRANSLATE :在受支持语言 之间翻译文本。

- EMBED_TEXT_768 / EMBED_TEXT_1024 :将文本转换为向量嵌入 (768/1024 维),用于语义搜索 与相似度任务。

此外,Snowflake 近期推出 ENTITY_SENTIMENT (预览 中),支持基于实体/要素的细粒度情感分析 ,同时给出整体 与面向具体实体的情感洞察。第 10 章"行业用例与案例研究"将结合实例详细讲解。

辅助函数(Helper Functions)

用于支撑其他 LLM 函数的平稳执行、避免报错:

- COUNT_TOKENS :计算输入文本的token 数,用于避免超出模型上限。

- TRY_COMPLETE :与 COMPLETE 类似,但在执行失败时返回 NULL 而非报错。

Snowflake 内置 ML 函数(ML Functions in Snowflake)

除上述属于 Cortex AI 的 LLM 函数外,Snowflake 还提供内置的 ML 分析函数 ,帮助用户在无需深入 ML 专业知识的情况下获得预测性洞察:

- Forecasting(预测) :基于历史模式预测指标的未来值。

- Anomaly Detection(异常检测) :识别异常模式或偏离预期的趋势。

- Classification(分类) :依据最具影响力的属性,将记录自动归类。

- Top Insights(关键洞察) :识别对某项指标影响显著的关键维度,以揭示潜在趋势。

借助这些 Snowflake Cortex AI 的内置 ML 与 LLM 函数 ,你可以更轻松地把 AI 驱动的洞察 融入既有数据工作流:无论是自动化情感分析 、从文档中结构化抽取 信息,还是用时间序列预测 进行前瞻性决策,Cortex 都能在无需传统模型训练复杂度的前提下,助力企业释放 AI 的力量。

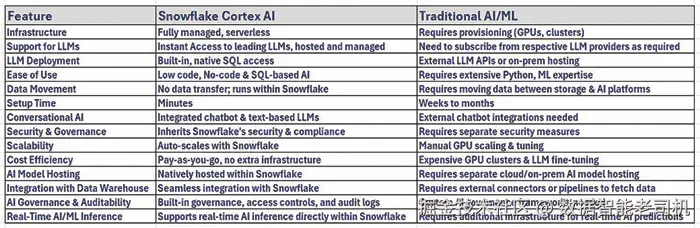

Snowflake Cortex 与传统 AI/ML 路径对比(Snowflake Cortex versus Traditional AI/ML Approaches)

传统上,组织依靠独立工具 、自定义脚本 与复杂基础设施 来构建 AI/ML 模型。而 Snowflake Cortex 通过在 Snowflake Data Cloud 内提供完全一体化、无服务器 的 AI/ML 体验,正在重塑这一格局。本文对比 Snowflake Cortex 与传统做法的差异,并强调各自的优势与取舍。

传统 AI/ML 路径(Traditional AI/ML Approaches)

基础设施与搭建复杂 :传统 AI/ML 落地需要可观的基础设施投入。数据团队必须配置计算集群、存储、网络 以及面向训练与推理的 GPU 。这种复杂性通常带来运维开销 、高维护成本 与扩展难题。

数据与计算相分离 :在多数企业内,数据存储 与 AI/ML 计算 彼此分离。组织通常将数据存于云端,却在另一套环境中训练模型,导致时延上升 、数据搬移低效 与安全隐患(因为需要在存储与 AI 平台间传输海量数据)。

工具与生态碎片化:传统工作流往往混用多种工具:

- 用 ETL 工具做数据准备

- 用 ML 框架训练模型

- 用 部署工具 上线模型

这些工具的集成需要自定义编码 、DevOps 专长 与持续监控,使 AI 项目复杂且资源密集。

开发周期冗长:传统环境下的建模通常经历漫长迭代,需要:

- 特征工程与数据变换

- 模型选择与超参数调优

- 投产部署

- 监控与再训练

每一步都依赖专门技能、广泛测试与手动干预,从而放缓 AI 采用。

在传统环境中部署/使用 LLM 的挑战(Challenges in Deploying and Using LLMs)

尽管 LLM 功能强大,但在传统设置中部署面临诸多难点:

- 算力需求高

- 微调流程复杂

- 使用外部 API 时的数据隐私顾虑

需要用于摘要、聊天机器人或文本分析的企业,要么对现有模型进行微调 (需要资深 AI 能力),要么依赖第三方 API 型 LLM ,这可能削弱数据安全与治理。

Snowflake Cortex:统一的一体化 AI/ML 方案(Snowflake Cortex: A Unified AI/ML Solution)

Snowflake Cortex 通过提供全托管、无服务器(serverless)的 AI 平台,并与企业数据无缝集成 ,重塑了 AI/ML 的采用方式。它消除了对复杂基础设施的依赖,使 AI 更易用、可扩展且安全。

传统的 AI/ML 工作流通常在数据准备 、模型训练 与部署 上使用多套彼此割裂的工具,导致低效、高成本与安全挑战。组织还常常陷入数据搬移 、生态碎片化 与开发周期冗长 的困境,使 AI 采用既复杂又资源密集。Snowflake Cortex 通过在 Snowflake Data Cloud 内原生运行 的全托管、无服务器 AI/ML 平台解决了这些问题:企业可以以最小化的配置将 AI/ML 模型直接作用于数据 ,在保持安全与治理的同时显著减少运维开销。为更好理解其价值,下面逐项展开其关键优势。

预置 LLM:文本分析与自动化即开即用

Snowflake Cortex 的一大优势是预集成的大语言模型(LLMs) 。用户无需引入外部 AI 工具,就能用简单的 SQL 在 Snowflake 中对存量数据执行 LLM 任务。

**示例:**在 Snowflake 内原生执行文本摘要:

sql

SELECT SNOWFLAKE.CORTEX.SUMMARIZE(Notes) FROM Reports;这免除了将数据搬至外部 AI 平台处理的需求,降低时延并提升安全性。

无/低代码的 AI 能力

Cortex 为常见场景提供预构建 AI/ML 模型 (如文本摘要、情感分析、时间序列预测、异常检测)。不同于需要大量编码与数据科学专长的传统方法,用户可用简单 SQL 直接调用。

**示例:**对客户评价做情感分析:

vbnet

SELECT SNOWFLAKE.CORTEX.SENTIMENT(Text) FROM Reviews;这降低了对数据科学家的人力依赖,加速业务团队的 AI 采用。

无需基础设施管理的可扩展 AI

Snowflake Cortex 是全托管、无服务器 平台:无需自建/维护 GPU,也无需搭建 ML 环境。其在 Snowflake 上原生运行 的特性,带来自动扩缩 、平台级安全 与治理内建 ,而无需外部算力资源。

尽管 LLM 计算密集,Cortex 通过托管式 AI 服务屏蔽底层复杂度:

- AI 负载自动扩展

- 零基础设施维护

- 按量计费,具成本效率

模型直接"贴近数据"运行

有别于传统将数据在存储与 AI 平台间来回搬运的方式,Cortex 让模型直接在 Snowflake 中的数据之上运行 ,从而消除数据搬移瓶颈 、降低成本并提升性能。

同时,Cortex 与 Snowflake 的数据治理、访问控制与基于角色的安全(RBAC)无缝衔接,确保 AI/ML 应用持续合规。

更快获得洞察(Faster Time-to-Insights)

通过去除基础设施复杂度,Cortex 使企业能够在分钟级从原始数据走向 AI 驱动的洞察(传统方法往往需数周或数月)。这对以下任务尤其有用:

- 使用内置时间序列模型进行收入/需求预测

- 面向客服自动化的文本分析

- 面向反欺诈的异常检测

与自定义 ML 模型无缝融合

对更高级的 AI 需求,Cortex 可与 Snowpark ML 构建的自定义 ML 模型 集成:简单任务用预构建模型,复杂/垂直领域问题用自定义 ML,形成混合式路径。

基于 LLM 的对话式 AI 与聊天机器人

Cortex 允许企业在数据仓库内部 构建对话式 AI/聊天机器人。传统机器人依赖外部 API,往往带来数据隐私顾虑;而在 Cortex 中,可基于自有数据部署与训练:

- 无外部 API 依赖

- 完整的数据安全与合规

- 面向企业私域知识的更佳定制化

特别适用于客服 、投顾 与法律文档处理等对机密性要求极高的行业。

受治理且安全的 AI 采用

不同于需要将数据搬到外部平台的第三方工具,Cortex 让 LLM 在 Snowflake 治理 框架内运行。它继承 基于角色的安全、合规与数据血缘(lineage) 能力,使 AI 采用过程安全、可审计、达成企业级标准。

小结

综上,Snowflake Cortex 代表了 AI/ML 采用方式的根本性转变 :相较传统路径,它更简单、安全且具成本优势。它尤其适合以下组织:

- 需要 LLM 能力(如摘要、聊天机器人、文本分析)而不想复杂搭建的团队;

- 偏好无服务器、深度集成、面向业务用户的 AI 方案;

- 希望在内建治理框架下安全采用 AI 的行业;

- 追求在无基础设施负担 前提下,快速、低成本落地 AI 的场景。

图 2.3:Cortex AI 与传统 AI/ML 对比

由此可见,Snowflake Cortex 推动了 AI 与 LLM 的大众化 ,让更广泛的用户群体触达并使用它们。随着 AI 采用持续增长,Cortex 为在企业级规模上利用 AI/ML 与 LLM 提供了一条低摩擦、企业就绪的道路。

结语(Conclusion)

本章我们探索了 Snowflake Cortex 、其核心组件以及使其成为直接集成于 Snowflake Data Cloud 的强大 AI/ML 平台的关键特性。我们说明了 Cortex 如何通过免除复杂基础设施 、减少数据搬移 ,并提供可用简单 SQL 调用的内置 AI/ML 函数来简化 AI 的采用。

同时,我们将 Snowflake Cortex 与传统 AI/ML 路径 进行了对比,强调了 Cortex 以无服务器(serverless) 、安全 且可扩展 的方式加速 AI 驱动洞察 。其预构建 AI 能力 、与数据的无缝集成 以及友好于治理 的方式,使之成为希望在无需深厚技术背景或繁琐搭建前提下引入 AI 的组织的理想选择。

通过将先进的 AI 能力 与 Snowflake 稳健的数据云基座 无缝结合,Cortex 实现了对高级分析的普惠化 :从资深数据科学家到业务分析师,皆可在日常工作流中驾驭 AI 的力量 。这种"民主化"有望加速组织范围内的创新与决策。

该平台对易用性 的强调,再配合其强大的内置函数 ,有效解决了长期制约 AI 广泛落地的诸多难题。通过屏蔽模型开发与部署中的大量复杂性 ,Cortex 让组织能将重心放在获取洞察、创造数据价值上。

在理解了 Snowflake Cortex 如何在 Snowflake 中启用 AI/ML 之后,我们已准备好进一步深入其 ML 与 LLM 函数 。在下一章中,我们将更细致地审视 Snowflake ML 函数 、其应用场景,以及如何在 Snowflake 内无缝构建并部署预测模型。