引言:为什么说空间渲染是 AR 体验的 "灵魂"?

聊到 AR(增强现实),"空间渲染" 绝对是个绕不开的话题。你可以把它想象成一座连接"虚拟数字世界"和"真实物理世界"的桥梁。它到底干了啥?说白了,它决定了你放进现实里的虚拟东西,到底能不能"以假乱真"。

比方说:你放一个虚拟台灯在桌上,它的影子和周围环境搭不搭?你戴着眼镜,左右眼看到的画面能不能合成一个有立体感的东西?你走快了,那个虚拟物体会不会像个"幽灵"一样飘来飘去?这些都得靠空间渲染来搞定。

Rokid 新一代的空间计算系统 YodaOS-Master ,在空间渲染这块儿,主打的就是"沉浸"和"自然"。它的看家本领有两个:双目立体显示 (解决"3D 视觉感")和 光照模拟(解决"真实融入感")。这篇文章,咱们就从技术原理、SDK 实战,再到避坑指南,三个角度把这事儿聊透。我会结合 Rokid 官方文档和社区里的常见问题,带你不仅知道怎么做,还明白为啥要这么做。

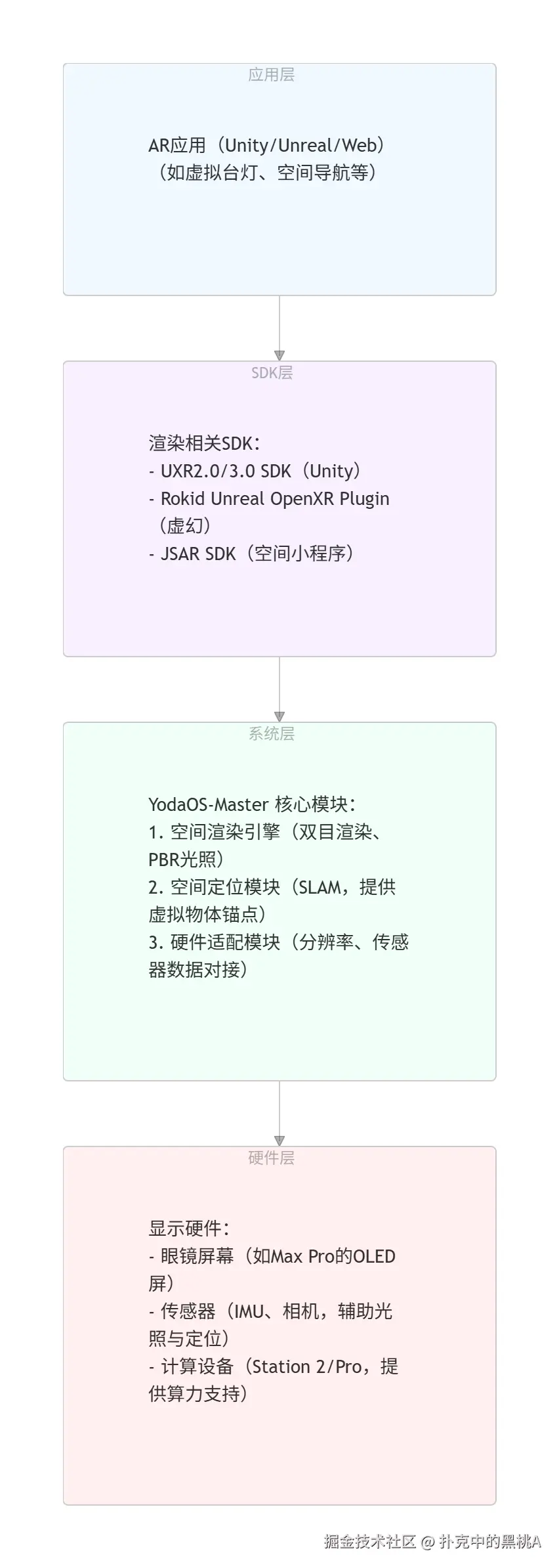

一、YodaOS-Master 空间渲染技术架构,先看个全景

动手之前,咱们先通过一张架构图,搞明白 YodaOS-Master 的渲染逻辑是怎么一回事。你可以把它看成一个"分工明确"的团队,从应用到硬件,每一层都干好自己的活儿,大家紧密配合,这样渲染效果才能又稳又快。

YodaOS-Master 空间渲染架构图(分层结构)

你看这张图就明白了:所有渲染效果的实现,说白了,都是"SDK 层喊话系统层,系统层调用硬件资源"这么个逻辑。举个例子,咱们想实现双目显示,就得通过 UXR SDK 去调用系统层的"双目渲染引擎",然后这个引擎再去跟 Max Pro 眼镜的屏幕"对个话",搞定分辨率适配。

二、双目立体显示:让虚拟物体 "立起来"

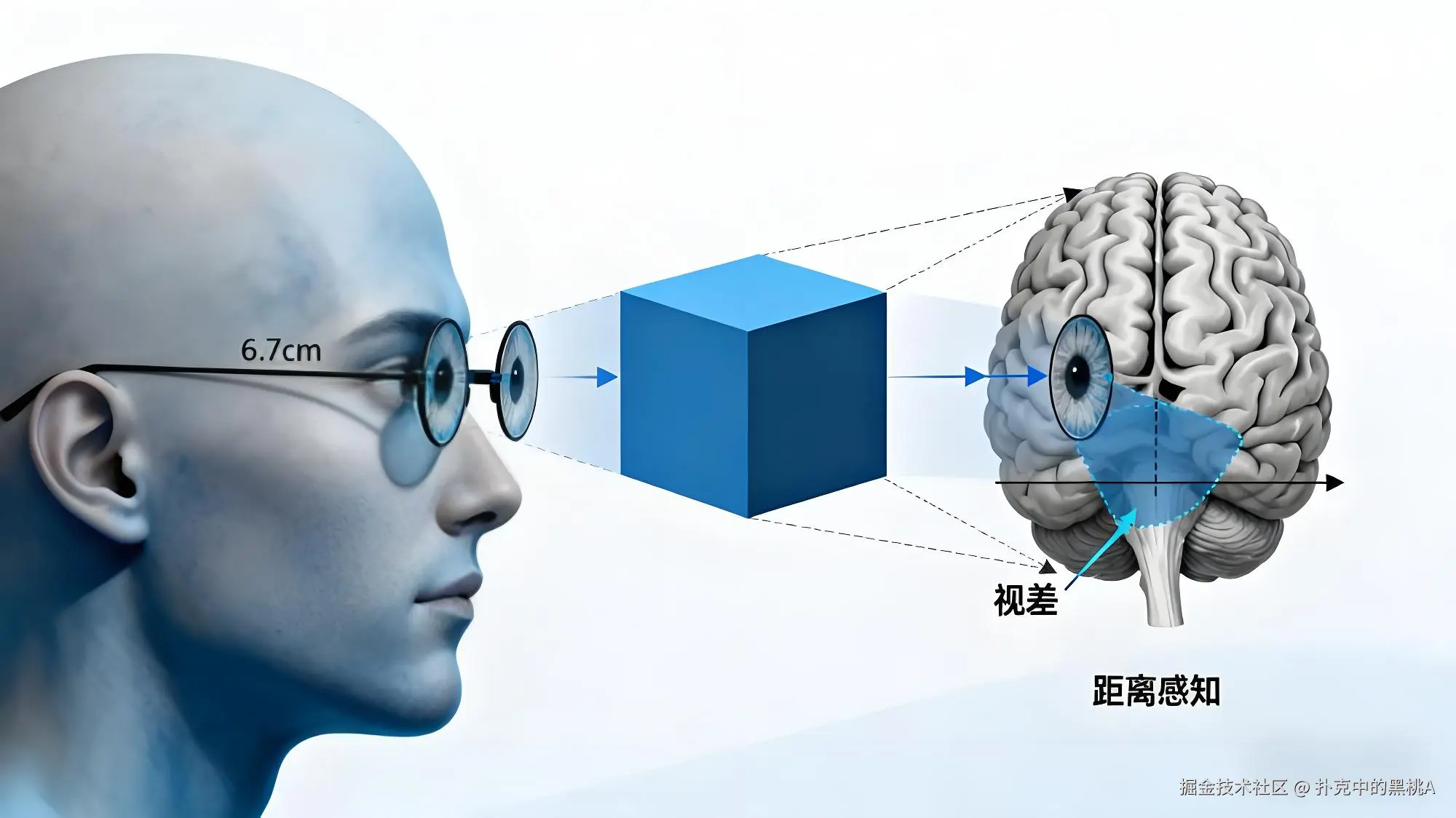

AR 的 3D 感觉,全靠双目立体显示来撑场面。这玩意儿其实就是在模仿咱们人眼的"左右眼视差"------左眼和右眼看到的画面不是一模一样的,有点小差别,大脑就把这两个画面一合成,嘿,一个有深度的 3D 图像就出来了。

2.1 原理:人眼视差与 YodaOS 的双目渲染逻辑

为啥我们能看到立体的世界?就是因为咱们的左眼和右眼之间有大概 6-7 厘米的距离(也就是瞳距),看东西的角度总会有点不一样,这就形成了"视差"。大脑就靠着这点视差,算出了东西的远近。

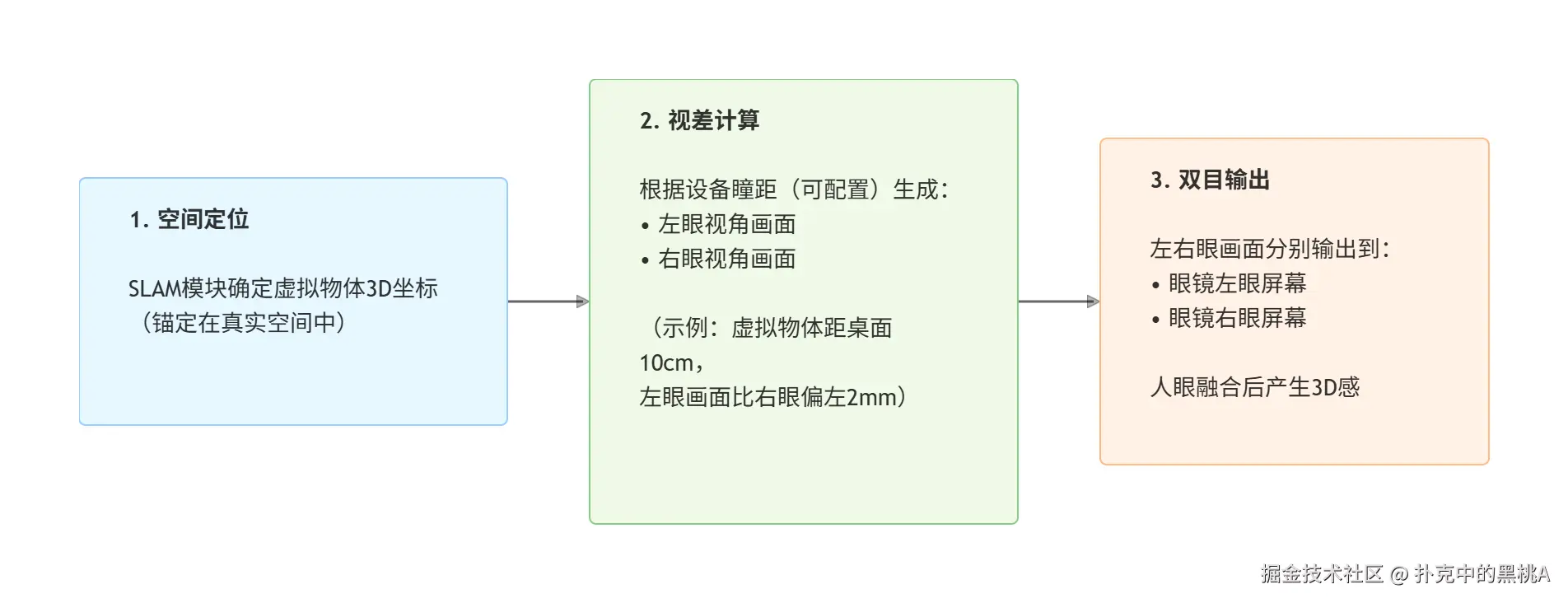

YodaOS-Master 的双目渲染,就是把人眼这个工作原理"复刻"了一遍,主要分三步走(可以对照下面的图看):

图 2:双目立体显示流程图

2.2 硬件适配:不同设备的分辨率与显示差异

要让双目渲染在不同设备上都好使,就得先搞定屏幕参数的适配问题。下面是几种常见设备的参数差异:

划个重点:3D 模式下的分辨率,其实是"左眼分辨率 + 右眼分辨率"。比如 Air 眼镜的 3D 模式是 3840×1080,意思就是给左眼和右眼各一个 1920×1080 的画面。所以开发的时候,UI 适配一定要注意,不然画面可能就被切掉一块。

2.3 SDK 实战:在 Unity 中实现双目立体显示

下面,咱们就拿 UXR2.0 SDK(Rokid 官方推荐在 AR Studio 里用的,FAQ Q15 里有提)开刀,分成"环境配置→代码实现→避坑指南"三步,一步步教你怎么在 Unity 里把双目渲染给做出来。

步骤 1:环境准备(核心依赖)

-

开发工具:Unity 2020/2021/2022 LTS(这些是 UXR2.0 支持的版本,文档里有写)

-

SDK 版本:UXR2.0 SDK(用 Unity 的 UPM 导入就行,FAQ Q22 有教)

-

测试设备:Station Pro + Max Pro 眼镜(这套组合拳才支持双目渲染)

步骤 2:关键配置(解决 "左右眼分裂" 问题)

很多新手一上来就踩坑:打包后发现画面在左右眼里是"分裂"的(FAQ Q12 里的老问题了)。这十有八九是 XR 插件没配对,正确的姿势是这样的:

-

打开 Unity →

Window→Package Manager,先把 "UXR2.0 SDK" 导进来; -

进入

Edit→Project Settings→XR Plug-in Management:

-

一定勾选 "Rokid Cardboard XR Plugin"(千万别选错了,得用 Rokid 自家的插件);

-

确认 "Rendering Mode" 设置成 "Multi Pass"(多通道渲染,这样左右眼才能分开画);

- 在场景里,把 SDK 自带的 "RKCameraRig" 预制体拖进去(它里面已经帮你把左右眼相机准备好了)。

步骤 3:代码实现:利用 SLAM 实现空间锚定

双目渲染的相机控制(如瞳距、投影矩阵等)完全由 Rokid UXR SDK 根据设备硬件自动处理,开发者无需也禁止手动干预左右相机,否则会破坏 SDK 的正常渲染流程。

我们代码实现的核心任务,是利用 SLAM 技术将虚拟物体精准地"锚定"在真实空间中。这样,即使用户走动,物体也能保持稳定,仿佛真实存在一般。

csharp

using UnityEngine;

using Rokid.UXR; // 别忘了引用 UXR SDK 的命名空间

// 脚本文件名建议修改为更能反映其功能的名称,例如 SpatialObjectPlacer.cs

public class StereoRenderController : MonoBehaviour

{

[Tooltip("你要显示的虚拟物体(比如台灯模型)")]

[SerializeField] private Transform _virtualObject;

void Start()

{

// 双目渲染的相机控制由Rokid UXR SDK自动完成,开发者无需手动编写代码。

// 我们要做的,是使用SLAM来保证虚拟物体的空间位置稳定

// 1. 确保 SLAM 服务已启动。在 UXR SDK 中,这通常是自动完成的。

// 下面的调用是一个简化的示例,实际开发中建议检查SLAM的初始化状态。

SLAMManager.Instance.InitSLAM();

// 2. 获取一个由 SLAM 识别并创建的空间锚点(例如桌面)。

Transform desktopAnchor = SLAMManager.Instance.GetDesktopAnchor();

if (desktopAnchor != null && _virtualObject != null)

{

// 3. 将虚拟物体"钉"在 SLAM 锚点上,使其父节点为该锚点。

// 这样,虚拟物体的位置就会跟随锚点更新,实现空间锁定,避免漂移。

_virtualObject.parent = desktopAnchor;

_virtualObject.localPosition = Vector3.zero; // 可选:将物体置于锚点中心,确保相对位置正确

}

else

{

Debug.LogWarning("未能找到桌面锚点,物体可能无法正确定位。");

}

}

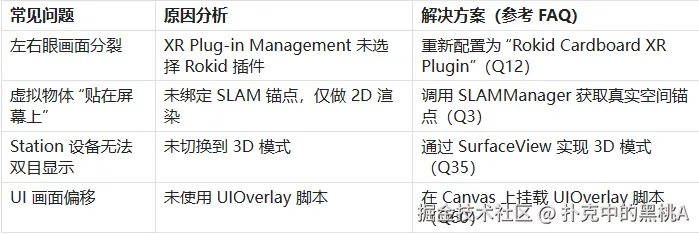

}步骤 4:避坑指南(高频问题解决方案)

三、光照模拟:让虚拟物体 "融入" 真实环境

如果说双目显示解决了"3D 感",那光照模拟解决的就是"真实感"。啥意思呢?比如,外面是个阴天,那你放的虚拟台灯影子就应该淡一点;屋里左边的灯开着,那你虚拟物体右边就该有个影子。

YodaOS-Master 是怎么做到的呢?关键就在于"基于物理的渲染(PBR)"和"环境光感知"这两招的组合拳,让虚拟物体的光影能跟着真实环境走。

3.1 原理:PBR 渲染与环境光感知的协同

(1)基于物理的渲染(PBR):还原真实材质

PBR(Physically Based Rendering)可以说是 YodaOS-Master 光照模拟的"地基"。它模拟的是真实世界里,光和物体是怎么"互动"的,比如:

-

金属材质会反射周围的环境,而塑料只会反射光本身;

-

光打到物体表面,会分成"漫反射"(让东西有颜色)和"镜面反射"(亮晶晶的高光)。

好消息是,YodaOS-Master 的 SDK 已经把 PBR 材质模板给你准备好了(比如 "Rokid PBR Material"),你不用从头写物理逻辑,调调"金属度"、"粗糙度"这些参数就行。

(2)环境光感知:让虚拟光照 "随现实变化"

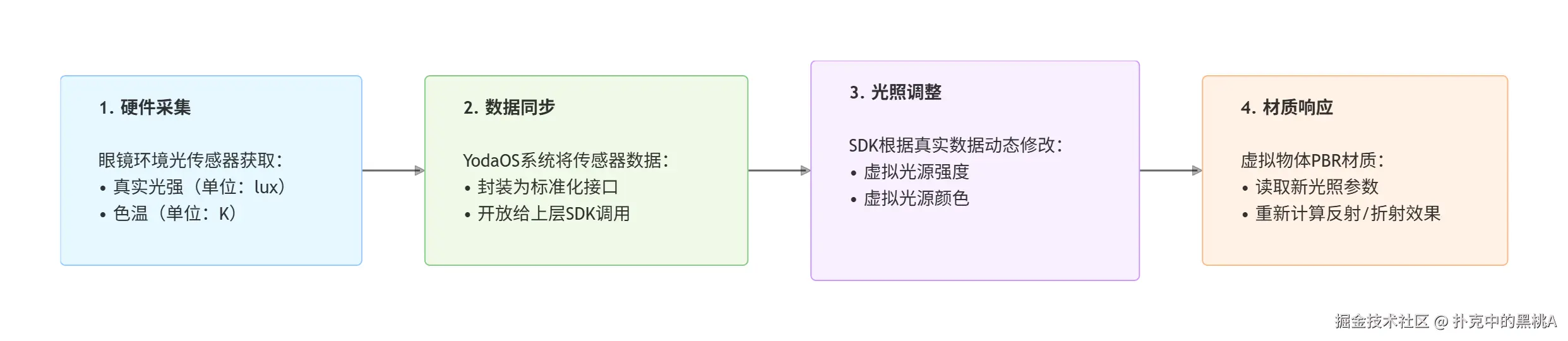

YodaOS-Master 会用眼镜上的环境光传感器(比如 Max Pro 前面的那个),去"感受"真实环境的光有多亮、色调是冷是暖,然后把这些信息"告诉"虚拟光源。它的工作流程大概是这样(看下图):

图 3:光照模拟流程图

3.2 SDK 实战:Unity 中实现 "光影联动"

理论说完了,继续实战。还是用 UXR2.0 SDK,这次配上 Unity 的 URP 渲染管线,咱们来做一个能"看天吃饭"的虚拟台灯。

步骤 1:URP 管线配置(这一步必须先做)

-

打开 Unity →

Window→Rendering→Render Pipeline Converter; -

选择 "Universal Render Pipeline",直接点 "Convert"(转换器会自动帮你把材质适配好);

-

在

Project Settings→Quality里,把 "Render Pipeline Asset" 设置成 "URP-High Quality"(这样 PBR 的效果才能拉满)。

步骤 2:代码实现:环境光驱动的光照调整

这里的思路是,用 UXR SDK 提供的 EnvironmentLightManager 接口拿到真实环境的光照数据,然后拿这个数据去动态调整我们虚拟台灯的光。

csharp

using UnityEngine;

using Rokid.UXR;

public class LightSyncController : MonoBehaviour

{

[SerializeField] private Light _virtualLampLight; // 你的虚拟台灯光源(一般是点光源)

[SerializeField] private Material _lampPBRMaterial; // 台灯用的 PBR 材质

private EnvironmentLightManager _lightManager;

private float _baseLightIntensity = 5f; // 先给台灯一个基础亮度

void Start()

{

// 初始化环境光管理器

_lightManager = EnvironmentLightManager.Instance;

if (!_lightManager.IsSensorAvailable())

{

Debug.LogWarning("这台设备不支持环境光传感器,只能用默认光照了");

return;

}

// 每隔 0.5 秒更新一次光照,没必要太频繁,省点性能

InvokeRepeating("SyncRealLightToVirtual", 0, 0.5f);

}

/// <summary>

/// 把真实环境光同步到虚拟台灯上

/// </summary>

void SyncRealLightToVirtual()

{

// 1. 获取真实环境数据(光强单位是 lux,色温单位是 K)

float realLightIntensity = _lightManager.GetLightIntensity(); // 真实光强

float realColorTemperature = _lightManager.GetColorTemperature(); // 真实色温

// 2. 调整虚拟光源的强度:我们做个"补光"效果,真实环境越暗,台灯就越亮

float virtualIntensity = _baseLightIntensity * (10000 / (realLightIntensity + 1000));

_virtualLampLight.intensity = Mathf.Clamp(virtualIntensity, 2f, 10f); // 给亮度加个上下限

// 3. 调整虚拟光源的颜色:让它跟真实色温匹配(色温低偏黄,色温高偏蓝)

_virtualLampLight.color = ColorTemperatureToRGB(realColorTemperature);

// 4. 调整 PBR 材质的反射效果:真实光越强,材质反射应该越明显

_lampPBRMaterial.SetFloat("_Metallic", Mathf.Lerp(0.3f, 0.8f, realLightIntensity / 10000));

}

/// <summary>

/// 把色温值(开尔文)转换成 RGB 颜色(一个很实用的小工具函数)

/// </summary>

Color ColorTemperatureToRGB(float kelvin)

{

kelvin = Mathf.Clamp(kelvin, 2700f, 6500f);

float x = kelvin / 1000f;

float red, green, blue;

if (x <= 0.664f)

{

red = 1f;

green = x - 0.055f / (0.61f - 0.055f);

blue = 0f;

}

else if (x <= 1.129f)

{

red = 1.129f - x / (1.129f - 0.664f);

green = 1f;

blue = x - 0.664f / (1.129f - 0.664f);

}

else

{

red = 0f;

green = 2.185f - x / (2.185f - 1.129f);

blue = 1f;

}

return new Color(red, green, blue);

}

}

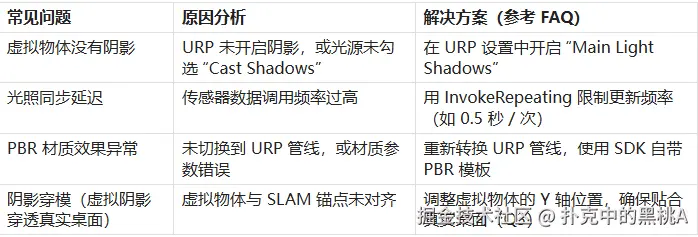

步骤 3:避坑指南(光照模拟高频问题)

四、实战案例:打造 "光影联动" 的 AR 虚拟台灯

学了这么多,是时候把"双目立体显示"和"光照模拟"这两大招合在一起,搞个完整的 AR 应用了。我们就来做一个虚拟台灯,让它实现下面这几个效果:

-

双目 3D 显示:台灯像是真的"立"在桌子上,有深度感;

-

光影联动:天黑了,台灯会自动变亮;环境光变暖了,台灯光也跟着变黄;

-

稳定无漂移:台灯就"钉"在桌面上,不管你怎么晃脑袋,它都不会乱跑。

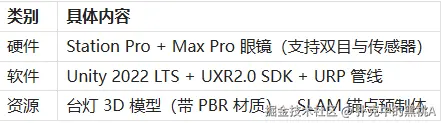

4.1 环境准备

4.2 核心步骤(代码直接用前面的就行)

- 场景搭建:

-

先把 "RKCameraRig"(双目相机)、"SLAMAnchor"(SLAM 锚点)和你的 "VirtualLamp"(台灯模型)拖进场景;

-

在台灯模型底下,给它加个 "Point Light" 作为虚拟光源,然后把我们前面写的

LightSyncController脚本挂上去; -

在 RKCameraRig 上,挂上

StereoRenderController脚本,再把台灯模型绑定过去。

- 参数配置:

-

台灯的 PBR 材质:金属度可以设成 0.5,粗糙度设成 0.3,看起来会比较有质感;

-

虚拟光源:基础亮度设为 5f,照射范围设为 2m(模拟真实台灯的感觉);

-

SLAM 锚点:用

SLAMManager.Instance.GetDesktopAnchor()来拿到真实的桌面位置。

- 打包测试:

-

平台切换到 "Android",把 "Minimum API Level" 设置成 Android 10(YodaOS 的要求);

-

打包出 APK,用 Station Pro 装上,戴上 Max Pro 眼镜看看效果怎么样。

五、总结与进阶学习资源

5.1 核心要点回顾

-

双目立体显示:这玩意的核心就是"算视差"和"做适配"。记住,一定要用 UXR SDK 把 Rokid 自家的 XR 插件配上,不然左右眼画面就"劈叉"了。

-

光照模拟:想让光影真实,就得靠"PBR 材质"加"环境光同步"。强烈推荐上 URP 管线,然后用传感器数据来实时调整虚拟光。

-

稳住,别飘:想让虚拟物体不乱跑,关键就是把它"钉"在 SLAM 锚点上。这样才能保证它和真实空间老老实实地待在一起。

5.2 进阶学习资源

-

若琪学院 (t.rokid.com/j04a6n2):有视频教程手把手教你做第一个 AR 应用,对新手特别友好。

-

开发文档 (ar.rokid.com/doc):想深入了解 YodaOS-Master 的渲染引擎、SLAM 原理,可以啃这个。

-

SDK 下载 (ar.rokid.com/sdk):这里能下到最新的 UXR3.0 版本(2025.02 更新的,支持图像识别了)。

-

FAQ 汇总 (forum.rokid.com/post/detail...):开发中 90% 的渲染问题(比如左右眼分裂、光照延迟),这里都有人帮你踩过坑了。

看到这里,相信你已经对 YodaOS-Master 的空间渲染有了一套自己的理解了。理论和实战都有了,接下来就看你的了!不妨动手试试做个 AR 导航或者虚拟试衣间之类的酷应用,去挖掘空间渲染更大的潜力吧!