「【新智元导读】AI 传奇人物、前特斯拉 AI 总监 Karpathy 重磅推出全新开源项目「nanochat」,以不到 8000 行代码复现 ChatGPT 全流程,只需一台 GPU、约 4 小时、成本仅百美元。该项目在 GitHub 上线不到 12 小时即获 4.2k 星标!」

一图看透全球大模型!新智元十周年钜献,2025 ASI 前沿趋势报告 37 页首发

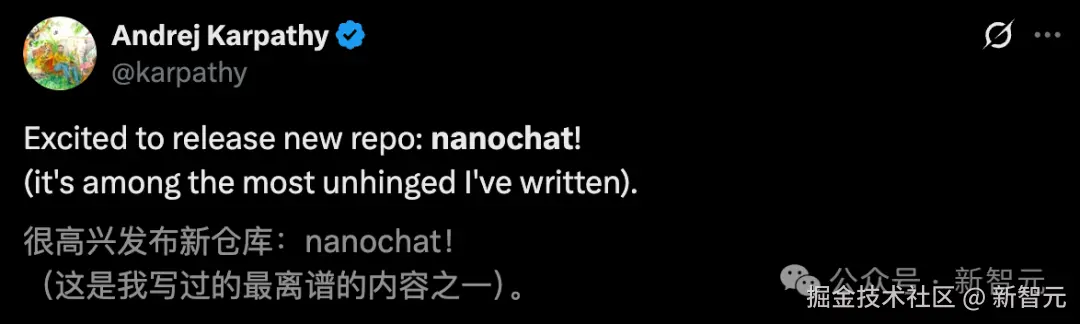

AI 传奇人物、前特斯拉 AI 总监 Karpathy 宣布发布全新项目 「nanochat!」

一个极简但完整的「从零构建 ChatGPT」训练框架。

Karpathy 说这是他写过的最疯狂的项目之一!

相当于每个人都可以自己拥有一个专属的 ChatGPT。

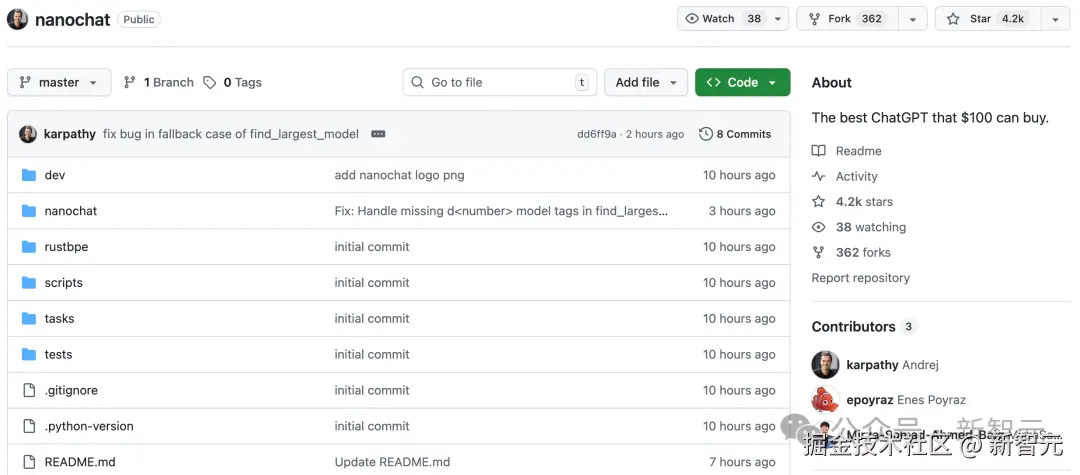

项目刚放出还不到 12 个小时,GitHub 星标就破 4.2kStar!(还在持续疯涨中)

GitHub 项目:github.com/karpathy/na...

全是社区自来水流量,这就是 Karpathy 在 AI 领域的号召力!

与早期的 nanoGPT 不同,nanochat 不仅涵盖预训练,还囊括了从数据准备、预训练、中期训练(对话、多项选择题、工具使用)、SFT、RL 微调到推理部署的全流程。

整个系统仅约 8000 行干净代码,启动一台 GPU 机器、运行一条脚本,4 小时后你就能在网页界面与自己训练的「小 ChatGPT」对话。

Karpathy 将其称为 LLM101n 的「压轴之作」,同时也可能成为未来研究基线和开源社区的实验平台。

让我来仔细看看如何仅仅用 8000 行来「克隆」ChatGPT:

- 使用全新的 Rust 实现训练分词器

- 在 FineWeb 上对 TransformerLLM 进行预训练,评估多个指标下的 CORE 分数

- 在来自 SmolTalk 的用户 - 助手对话、多项选择题、工具使用数据上进行中期训练

- 进行 SFT,在世界知识多项选择题(ARC-E/C、MMLU)、数学(GSM8K)、代码(HumanEval)上评估聊天模型

- 使用「GRPO」在 GSM8K 上对模型进行强化学习微调(RL)

- 在带有 KV 缓存的引擎中实现高效推理,简单的预填充 / 解码,工具使用(在轻量级沙箱中的 Python 解释器),通过 CLI 或类 ChatGPT 的网页界面与其交互。

- 撰写一份单一的 Markdown 成绩单,总结并将整个过程游戏化。

项目全程花费低至约 100 美元(约在一台 8XH100 节点上训练 4 小时)。

可以训练、克隆一个可以对话的小型 ChatGPT,它能创作故事 / 诗歌、回答简单问题。

只需要训练约 12 小时即可超过 GPT-2 的核心指标。

随着进一步扩展到约 1000 美元(约 41.6 小时训练),模型会迅速变得更连贯,能解决简单的数学 / 代码问题并做多项选择题。

训练 24 小时的模型(其 FLOPs 大致相当于 GPT-3Small125M,约为 GPT-3 的 1/1000)在 MMLU 上能进入 40 分段,在 ARC-Easy 上进入 70 分段,在 GSM8K 上进入 20 分段等。

总结一下就是:

- 100 美元→可训练出一个能写诗、回答基础问题的 OpenAI 同款「小型 ChatGPT」;

- 1000 美元→达到近 GPT-2 以上的表现,可做基础推理与代码生成。

这个项目体现出他的核心理念:

「降低 LLM 研究与复现门槛,让每个人都能亲手训练自己的模型。」

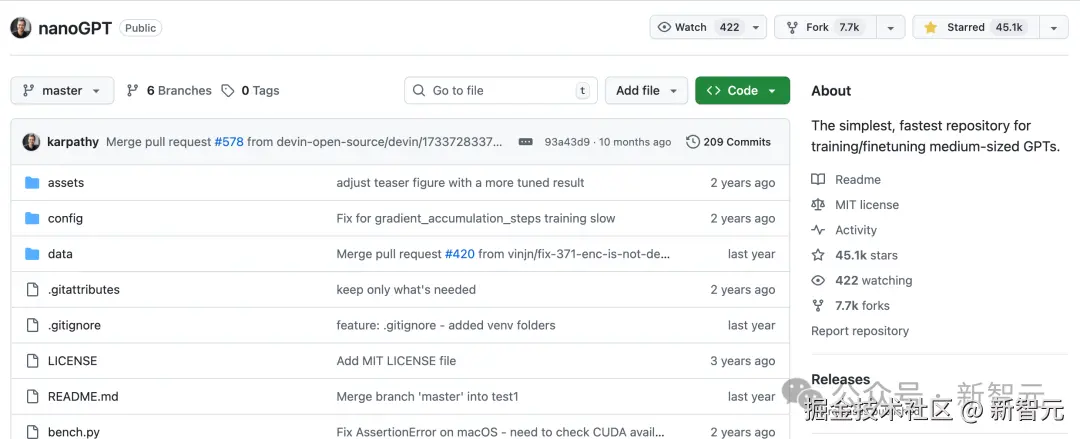

这种民主化路线,与他在 nanoGPT 时期倡导的「从零实现 Transformer」如出一辙。

项目地址:github.com/karpathy/na...

Karpathy 说他的目标是把完整的「强基线」栈整合到一个连贯、极简、可读、可修改、可最大化派生的仓库中。

nanochat 将成为 LLM101n(仍在开发中)的压轴项目。

Karpathy 认为 nanochat 也有可能发展成一个研究工具或基准,就像之前的 nanoGPT 一样。

nanoGPT 教你造大脑,nanochat 教你造 ChatGPT。

如果说 nanoGPT 是「Transformer 源码教学项目」。

那么,nanochat 则是「LLM 生态系统微缩版」、OpenAI 同款、你的专属 AI。

二者关系可理解为「从神经网络基础到产品级对话系统」的两步闭环。

从 Vibe Coding 到 nanoGPT,再到如今的 nanochat,Karpathy 不愧是「AI 教育者」的最佳代言人。

这一「疯狂之作」并非狂想,而是 Karpathy 对 AI 开放、可学习、可复现理想的又一次践行。

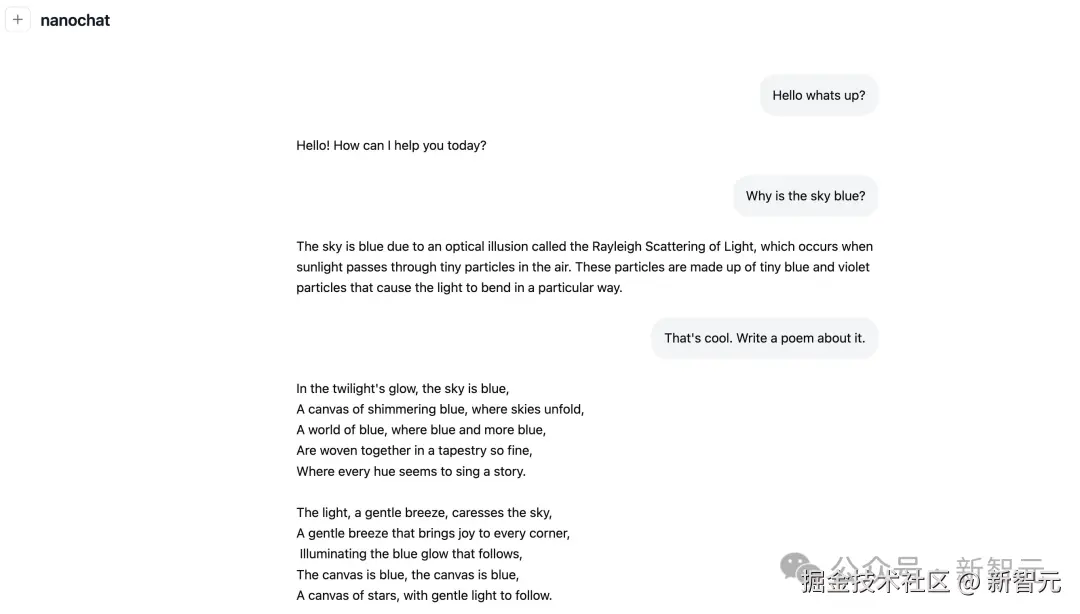

「小型 ChatGPT 效果展示」

Karpathy 在 WebUI 部署了 nanochat 项目。

他还给出了「与价格为 100 美元、运行 4 小时的」nanochat 的示例对话。

很...... 有趣!

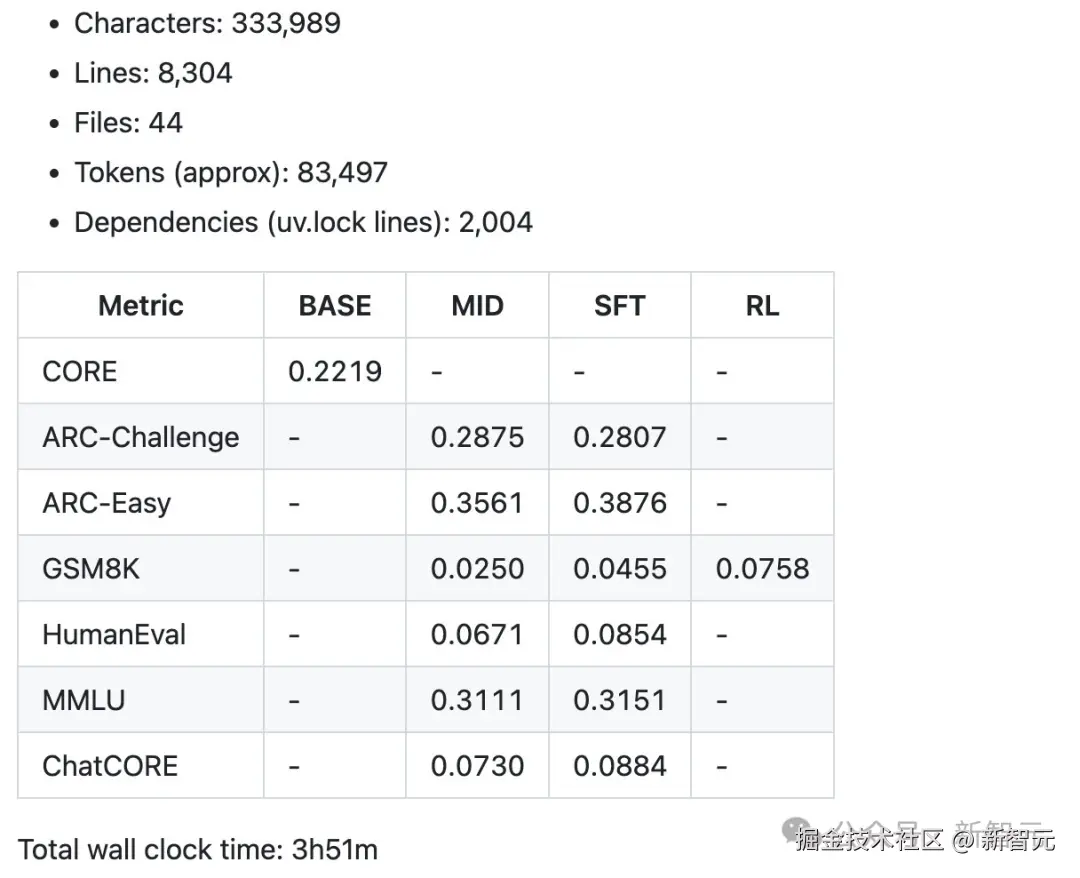

下面这张图展示的是 Karpathy 在 「nanochat「$100 速度跑」实验」(即只用一台 GPU、约 4 小时训练出的 ChatGPT 小模型)中生成的「成绩单」部分内容,说明模型规模、训练耗时、以及在各类标准评测上的性能。

- 「Characters:」 333989 ------ 代码总字符数。

- 「Lines:」 8304 ------ 大约 8300 行干净、注释良好的代码。

- 「Files:」 44 ------ 工程文件数量。

- 「Tokens:」 约 83,497 ------ 代码中的 token 数(大致对应 8 万词)。

- 「Dependencies:」 2004 行 uv.lock 依赖清单 ------ 表明依赖极少、项目结构轻。

这些数字展示了 nanochat 的「极简」精神:完整实现了 ChatGPT 的训练、微调与推理,却仍保持在 **「8000 行代码」**以内。

参考资料: