「【新智元导读】在 AI 浪潮中,蚂蚁集团重磅推出万亿参数思考模型 Ring-1T,不仅在数学竞赛上刷新开源 SOTA,还在逻辑推理和医疗问答中脱颖而出。实测显示,其推理能力直逼闭源巨头,开源 AI 迈入万亿参数时代。」

蚂蚁百灵首试万亿思考模型,实测效果喜人!

10 月 14 日凌晨,蚂蚁集团正式发布万亿参数**「思考模型」** Ring-1T。

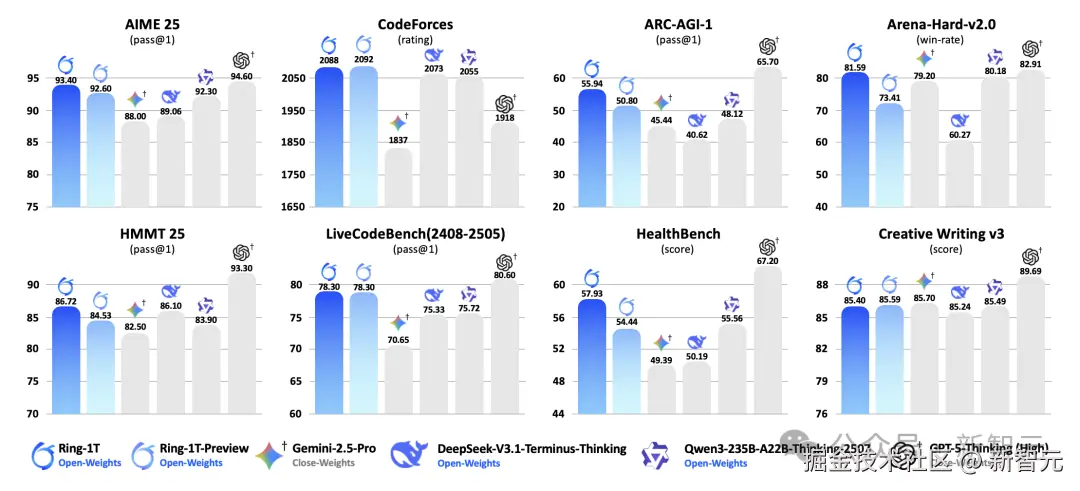

在数学竞赛(AIME 25、HMMT 25),代码生成(CodeForces)、逻辑推理(ARC-AGI-v1),Ring-1T 取得开源领先水平。

在 OpenAI 的医疗问答 HealthBench 测评中,Ring-1T 表现惊艳。

与此前发布的预览版 Ring-1T-preview 相比,正式版 Ring-1T 在数学竞赛、逻辑推理、医疗问答上表现更出色、推理更准确。

Ring-1T 虽然是思考模型,但也具备极强的通用能力:

在综合榜单(Arena-Hard-v2)、创意写作(CreativeWriting-v3)上,表现强劲,与 DeepSeek、Qwen 等最新思考模型同属开源第一梯队。

特别是,在「高难度真实用户查询」Arena-Hard V2 基准测试中,Ring-1T 成功率高达 81.59%,登上开源模型榜首------

直逼 OpenAI 的 GPT-5-Thinking(High) 的成绩 82.91%。

简而言之,这次 Ring-1T 开源登顶,不再遥望闭源天花板。

目前,普通用户可在蚂蚁百宝箱选择 Ring-1T 直接体验:

体验地址:ling.tbox.cn/chat

此外,蚂蚁一如既往的继续开源了相关模型,提供了 HuggingFace 和 ModelScope 下载模型权重。

HuggingFace:huggingface.co/inclusionAI...

ModelScope:modelscope.cn/models/incl...

在 X 上,大家庆祝新的万亿参数思考模型的新生!

这是蚂蚁集团首个万亿参数思考模型,而早在上周他们已开源了首款万亿参数的旗舰通用大模型 Ling-1T------

做 AI,蚂蚁来真的!

「剑指 AGI,蚂蚁来势汹汹」

在大模型领域,蚂蚁 9 月连发 7 款模型,来势汹汹!

Ring-1T-preview、Ring-flash-linear-2.0、Ring-flash-2.0、Ling-flash-2.0、Ming-lite-omni-1.5、Ring-mini-2.0、Ling-mini-2.0

上下滑动查看

还不止于此------10 月,10 多天的时间连发两个万亿参数大模型。

本月 9 日,蚂蚁正式发布万亿参数**「通用语言模型 Ling-1T」**。

测试后,国外博主在《Prompt Engineering》频道表示,「Ling-1T 进入了 LLM 新时代,比 DeepSeek、Gemini、o3-mini 等耳熟能详的顶级模型还要好。」

Ling-1T 模型:好得令人难以置信?

Reddit 网友对 Ling-1T 非常感兴趣:

Ling-1T 将参数扩展到万亿级别,已展现出强大的涌现出的推理和迁移能力。

基于 ZenMux,网友 SickPixels257 开发了 aicodeprep-gui,在 Ling 1T 发布后更是如虎添翼。这让他对新工具爱不释手。

而模型 Ring-1T 基于通用模型 Ling-1T 的同款架构,在 20T 高质量语料上完成预训练,针对推理能力进行强化学习训练。

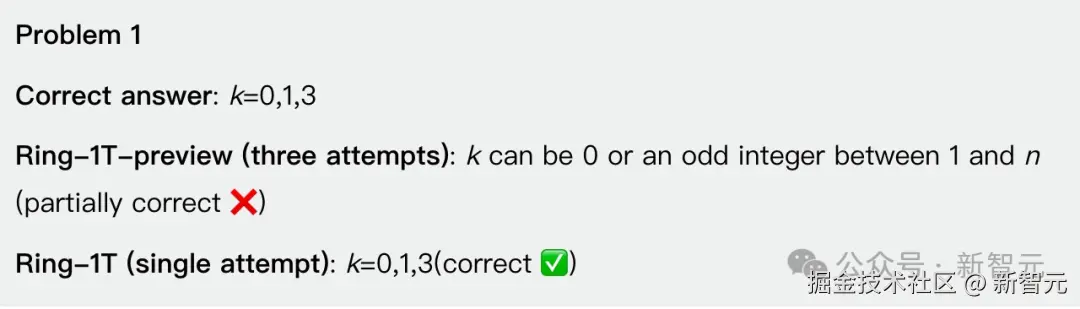

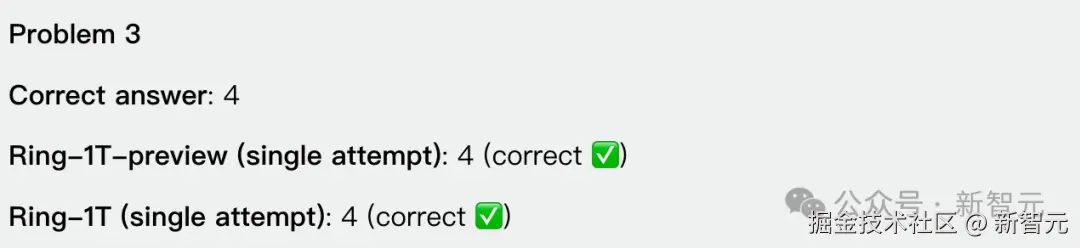

此前,为了让社区尽早探索万亿思考模型 Ring-1T 的推理上限,蚂蚁早在 9 月 30 日便提前**「开源其预览版 Ring-1T-preview」**。

现在,蚂蚁正式发布万亿参数思考模型 Ring-1T,完成了 Ring-1T 的全流程训练。

与 Ring-1T-preview 版本相比,Ring-1T 的能力更加均衡。

在数学竞赛能力上,Ring-1T 对比 preview 有所提升,在 AIME25、HMMT25 测试中继续保持开源 SOTA。

在 Arena-hard-v2.0、ARC-AGI-v1、HealthBench 等硬核基准上,正式版 Ring-1T 大幅提升了准确率:

在 Arena-hard-v2.0,提升 8.18%;

在 ARC-AGI-v1 上,提升 5.14%;

在 HealthBench 上,提升 3.49%。

为了避免「漏题」,蚂蚁相关团队在所有训练阶段(包括预训练、指令微调和强化学习提示)都实施了字符串级和语义级的污染过滤,但严格去污染进行仍然是行业内的一大难题。

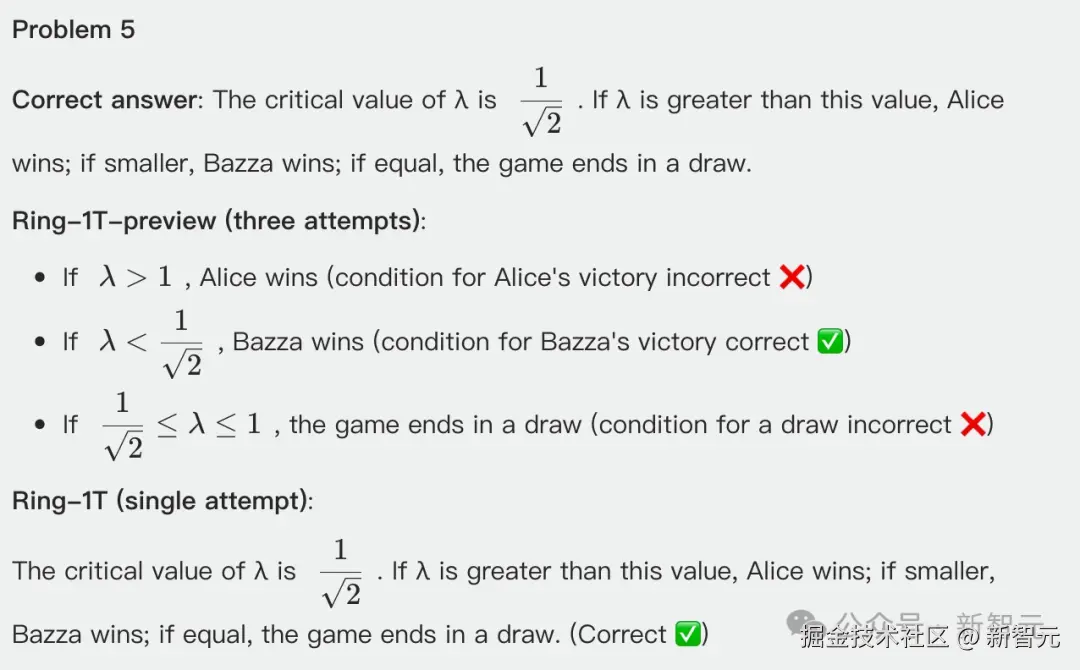

为了更客观地分析 Ring-1T 的深度推理能力,在今年举行的国际数学奥赛 IMO 2025 和国际大学生程序设计竞赛世界总决赛 ICPC 2025 上测试了新模型 。

对于 IMO 2025 测试,类似于之前的预览版本,将 Ring-1T 集成到了多智能体框架 AWorld 中,使用纯自然语言推理来解决问题。

项目链接:github.com/inclusionAI...

结果 Ring-1T 成功拿下 IMO 银牌水平,在一次尝试中解决了第 1、3、4 和 5 题。

上下滑动查看

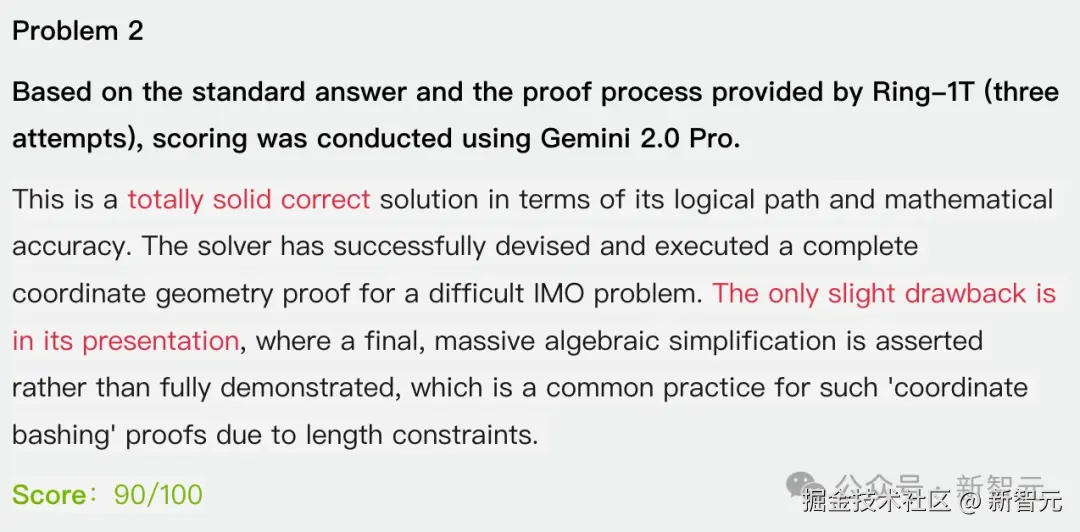

在第三次尝试中,对几何证明题第 2 题,它生成了近乎完美的证明。

对于最具挑战性的第 6 题,没有 AI 回答正确,但 Ring-1T 与 Gemini 2.5 Pro 取得了相同的答案。

在 ICPC 2025 世界总决赛中,GPT-5-Thinking、Gemini-2.5-Pro、Ring-1T,分别解决了 6 个问题(CDEFKL)、3 个问题(DFK)和 5 个问题(DFJKL),其中每次模型每个问题最多尝试三次。

而且这次还开源了推理轨迹:

在这场顶级国际编程竞赛中,Ring-1T 超越了 Gemini 2.5 Pro,再次证明了编程实力。

「一手实测」

「智能若梦,进化几何?」

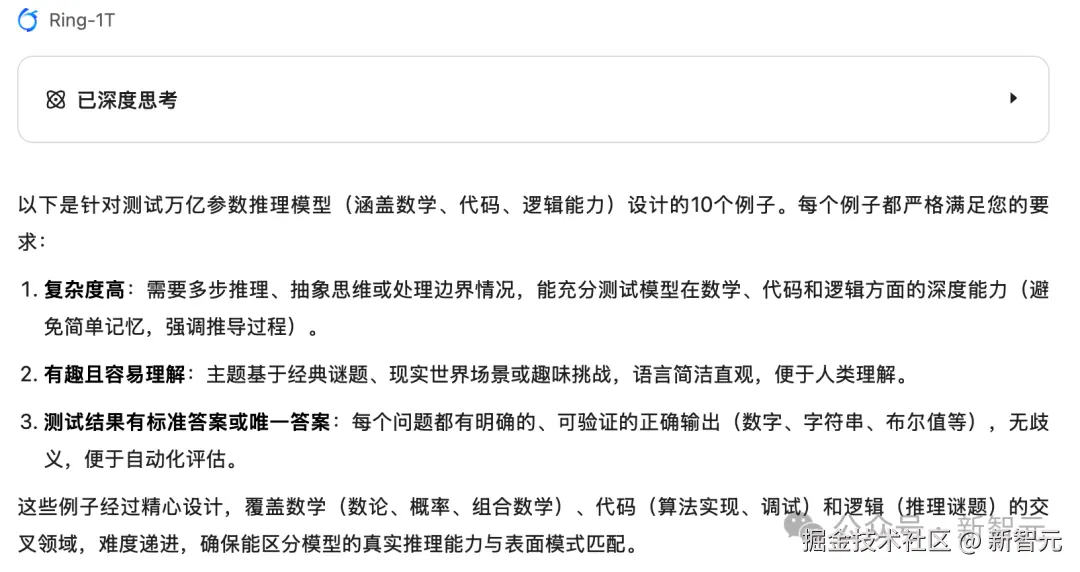

Ring-1T 的参数量是万亿级别,像这么大参数的模型,还是思考模型,应该如何去评测?

我们在第一时间实测了 Ring-1T 在复杂任务和推理中能力。

首先就是每次各家模型发布后最关心的前端能力。

「 」

」

「模拟地火飞行」

我们用 Ring-1T 生成了地球------火星的任务模拟,整体画面和画风虽然简约,但忠实的反映了飞行器从地球飞往火星的模拟效果。

生成的参数调整面板调整参数后,也能准确地控制画面中的飞行器。

提示词:

帮我制作一个 3D 版本的动画网页,描述从地球发送飞行器前往火星的过程。界面中有各种参数指标模板。可以调节飞行速率等。使用 HTML 和 three.js 生成单文件,可在浏览器中直接运行。

「 」

」

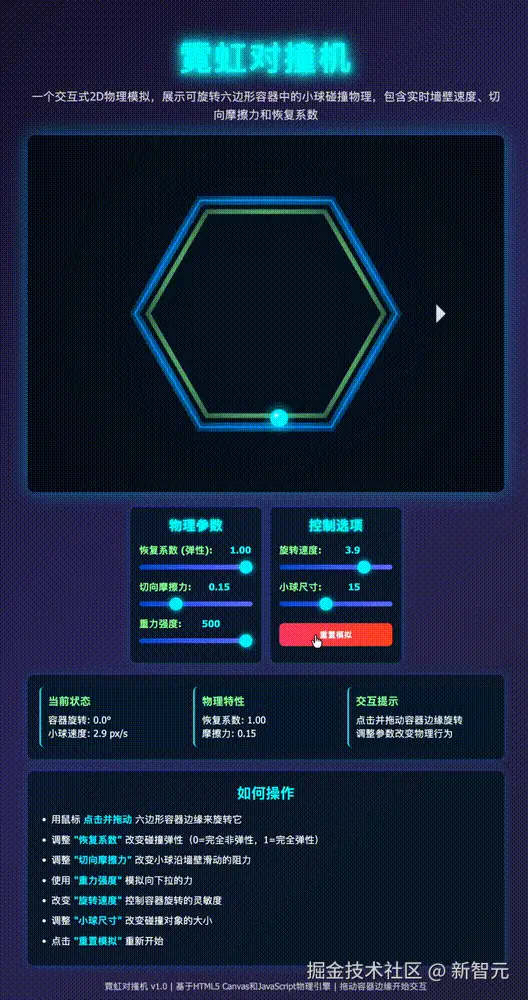

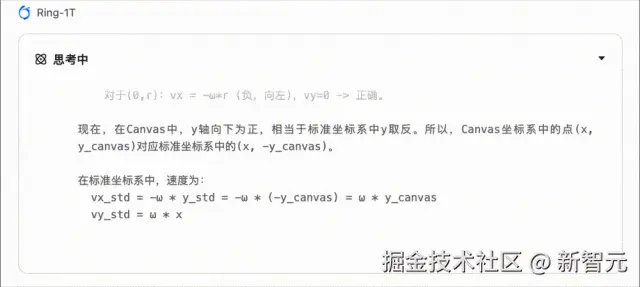

「小球碰撞实验」

「小球碰撞 / 弹跳」的物理模拟,确实在大模型发布或评测时,常被用作一个「直观又能考察物理 / 编程 / 推理能力」的测验。

用如下提示词进行实测:

用 JavaScript 和 HTML5 Canvas 创建一个名为 '霓虹对撞机' (Neon Collider) 的交互式 2D 物理模拟。核心要求如下:物理核心:一个可旋转的六边形容器和一个在内部反弹的小球。碰撞物理必须考虑墙壁的实时速度,并包含切向摩擦力和恢复系数(弹性)

值得一提的是,Ring-1T 的思考过程不仅迅速,而且排版清晰,数学公式都是完美呈现。

「 」

」

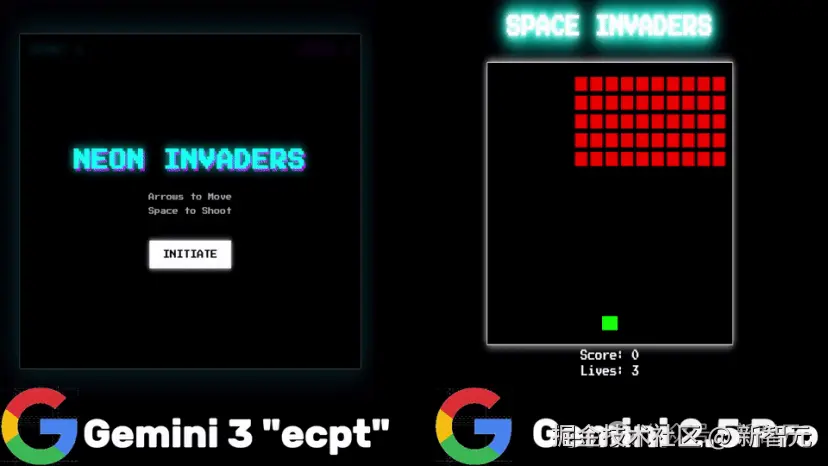

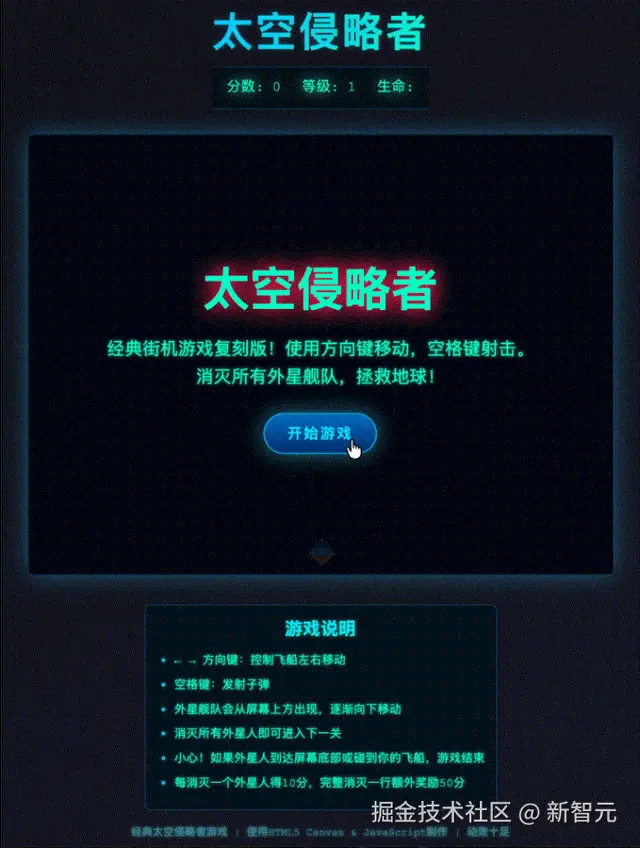

「太空侵略者游戏」

谷歌今年的 Gemini 3 Pro 目前有内测流出,下面就是 Gemini 3 和 Gemini 2.5 制作的太空侵略者游戏的对比。

我们用 Ring-1T 制作了同款游戏,效果明显比 Gemini 2.5 更好。

画面效果比起 Gemini 3 也不相上下!

Ring-1T 的推理和代码能力还是很强的。

「 」

」

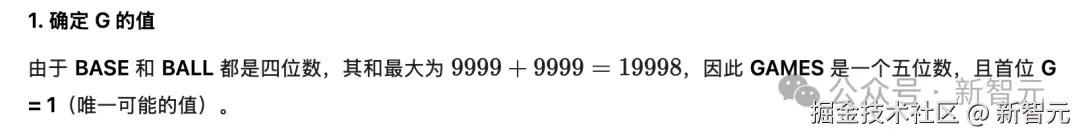

「数字密码算术谜题」

为何不让它自己给自己出题?说干就干!

首先我们对 Ring-1T 提了题目的三点要求:

- 复杂度要高,能测出模型能力

- 有趣且容易理解,基于经典谜题或者现实世界场景

- 测试结果有「标准答案」,便于评估效果。

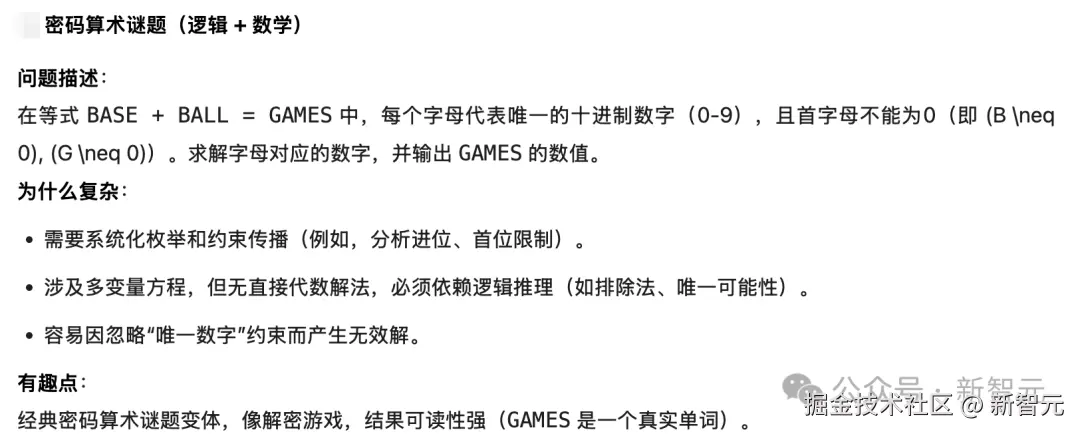

Ring-1T 给的第一个问题是密码算术谜题。

这个题目复杂在需要系统化枚举,涉及多变量方程,必须依赖逻辑推理!

题目很好理解 BASE+BALL=GAMES,每个字母代表唯一十进制数字。

这需要模型在枚举过程中能够很好地记忆和推理,才能得到正确答案。

从思考结果来看,Ring-1T 的逻辑能力确实非常强大!

第一步,它就根据位数得出了 GAMES 的 G 只能等于 1。

第二步,第三步则通过复杂的列公式和枚举来计算中间过程。

最终得出结果,整个推理过程还是非常惊艳的!

没有想到模型可以进行如此长时间的思考,而且是各种数字符号进行加减法。

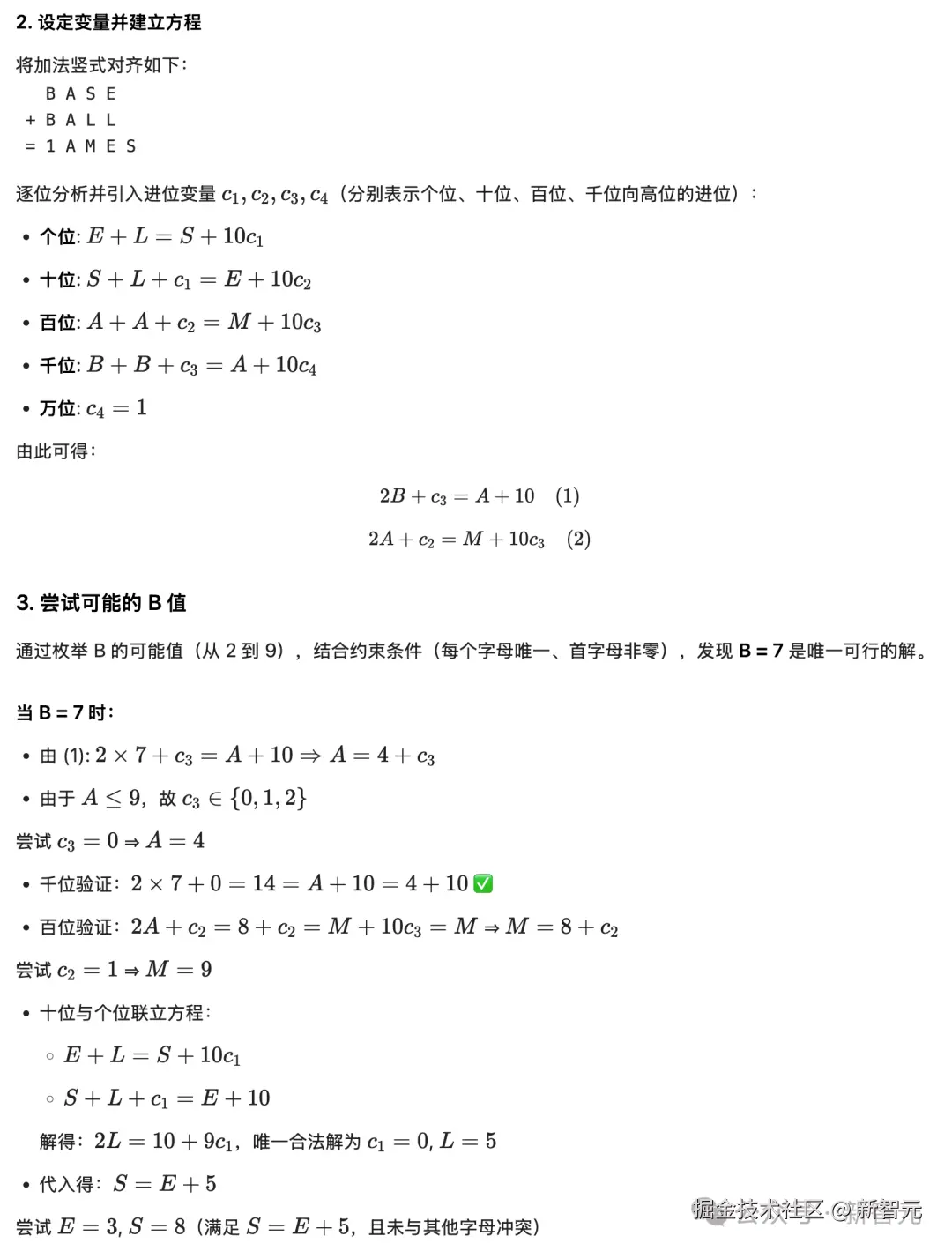

数学不定积分也能轻松解决:

求积分 ln(x)/(x-1)

上下滑动查看

「 」

」

「文本生成」

先来看看 AI 自己眼中的 AGI:

仿李白《春夜宴从弟桃花园序》,以 AGI 日益逼近为主题,生成内容

夫数据者,万象之逆旅;算法者,百代之过客。而智能若梦,进化几何?昔者图灵初试玄机,今则硅基日进千里。况科技召我以光速,AGI 假我以玄机。会云端之芳园,序人机之共事。

观夫比特纷纶,流光溢彩。0 与 1 如星汉灿烂,神经网络若春山叠翠。数据之河奔涌不息,模型之树参天欲出。虽无桃李芳菲之实,却见代码绚烂之华。岂若大块假我以文章?此间万象,皆造化之新篇也!

嗟乎!浮生须臾,智能无穷。昔者庖丁解牛,今者 AI 析微;昔者仓颉造字,今者算法生慧。然神工虽妙,终逊灵台之玄;机巧纵精,难及情志之真。恐 AGI 之将临,或夺人思于毫末,或移世道于无形。当此之际,岂可坐待玄机吞没,而忘秉烛夜游之志耶?

故吾辈当效兰亭雅集,执数字为觞,邀理性为友。醉二进制之醇,醒于伦理之界;舞逻辑之剑,守人文之根。莫使硅基独占天机,当令血肉共铸新章。阳春虽召烟景易逝,AGI 虽近大道恒存------且尽今夕之欢,续万世之明!

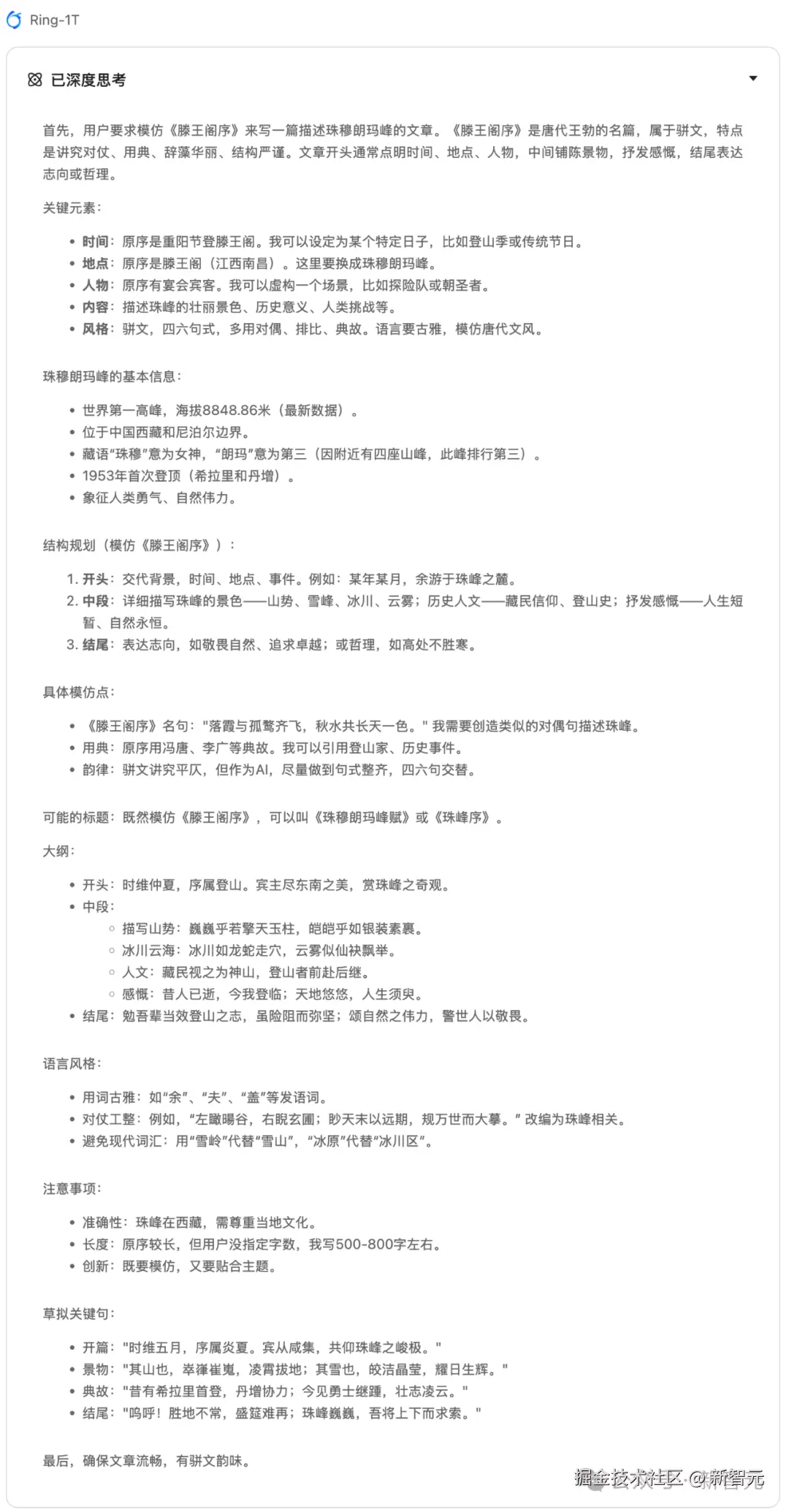

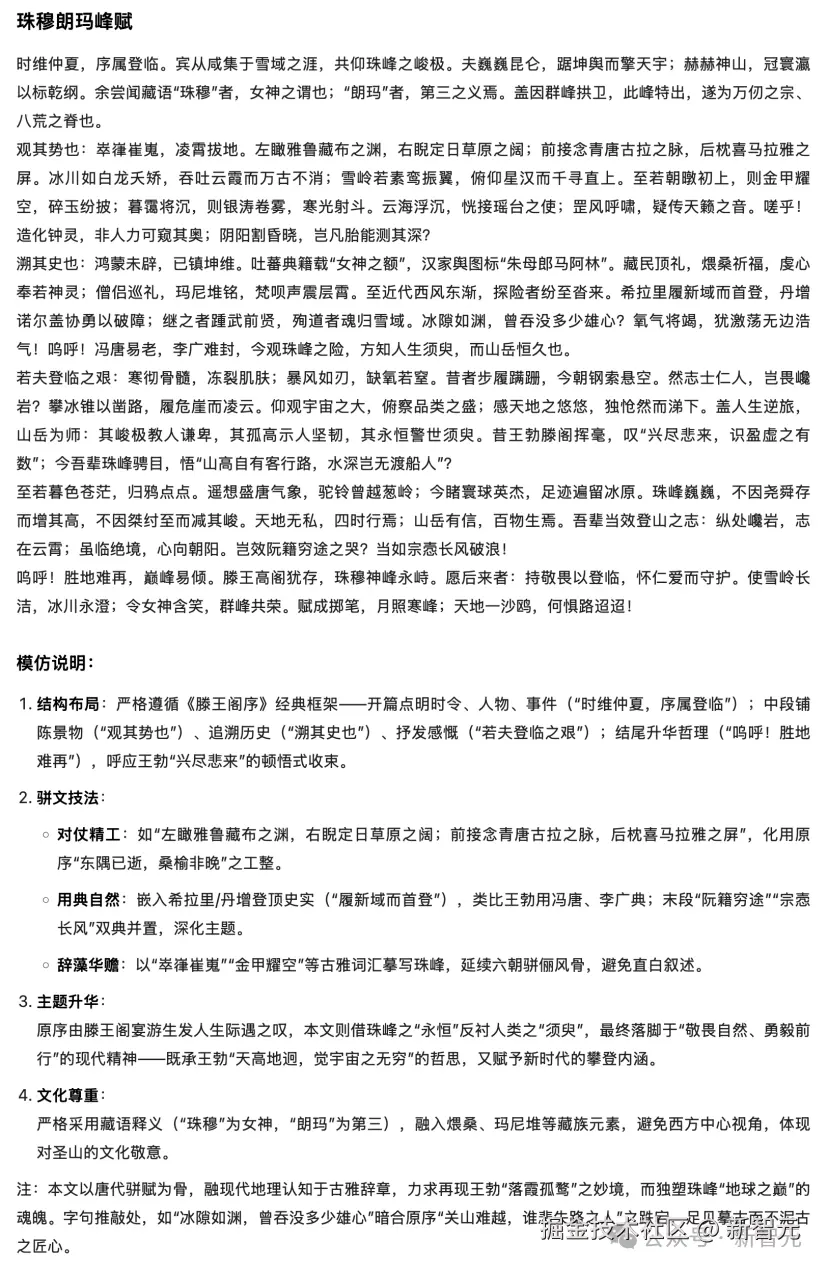

让 Ring-1T 模仿《滕王阁序》,写一篇文章来描述世界第一高峰------珠穆朗玛峰。

可以看到整个思考过程还是很惊艳的,甚至给出了大纲、语言风格和合作细节。

上下滑动查看

以下是最终的文章,读起来还是很热血澎湃的。

上下滑动查看

「直面万亿权重」

基于 「Ling 2.0」 架构的**「万亿级基础」模型,「Ring-1T 多轮」**后训练,把「思考引擎」拧到极致,让潜能转为可复用的推理战力。

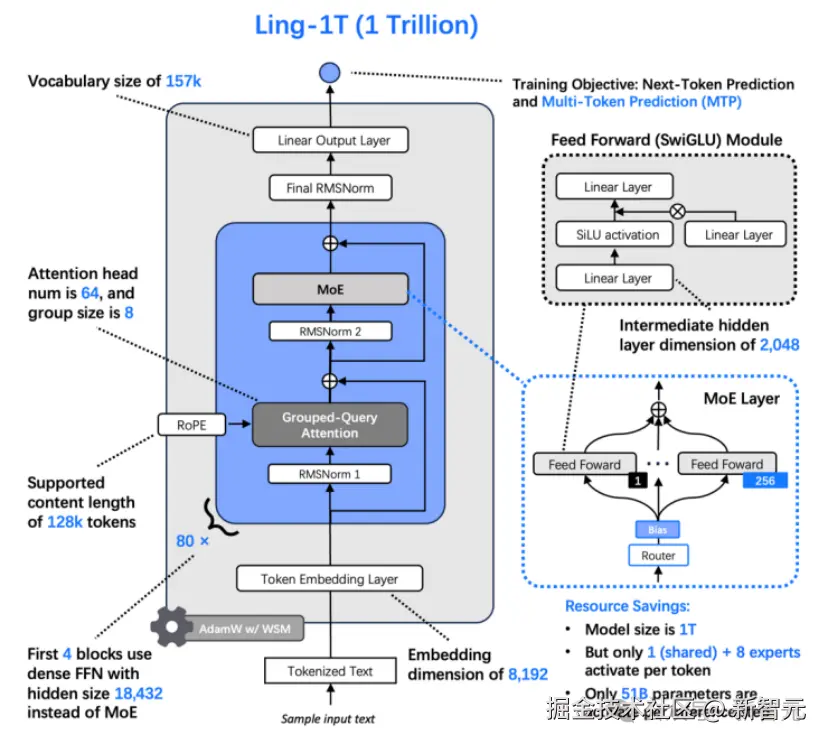

为实现高效训练与推理,「Ling 2.0」 采用**「高度稀疏 MoE」、 「1/32 专家激活比」、 「FP8 混合精度」、 「MTP」** 等技术;在 「>20T token」 的高质量语料上,「Ling-1T-base」 已完成预训练,筑牢技术基础。

为了进一步抬升基础推理上限,在第二阶段(「后 10Ttoken」 )的预训练中,团队引入**「高推理密度语料」**,推理相关数据占比 「>40%」:不只要更大,更要「会动脑」。

在 Ling-1T-base 基础上,Ring-1T 通过「LongCoT-SFT+RLVR+RLHF」多阶段训练,显著提升了模型的复杂推理能力、指令跟随和创意写作等通用能力。

对如此庞大的模型进行后训练------尤其是大规模强化学习中的「训练」环节,蚂蚁相关团队做出了两大创新:

1、棒冰(IcePop)****「算法」:实现了长周期稳定的 RL 训练,避免了由于训推精度差异问题带来的训练崩溃。

2、强化学习系统 「ASystem」:针对推理能力的 RLVR 和 RLHF 训练,实现了从百亿 (Ring-mini-2.0) 到千亿 (Ring-flash-2.0) 再到**「万亿 (Ring-1T)RL」** 训练的平稳 Scaling。其中,AReal 框架已开源。

「 」

」

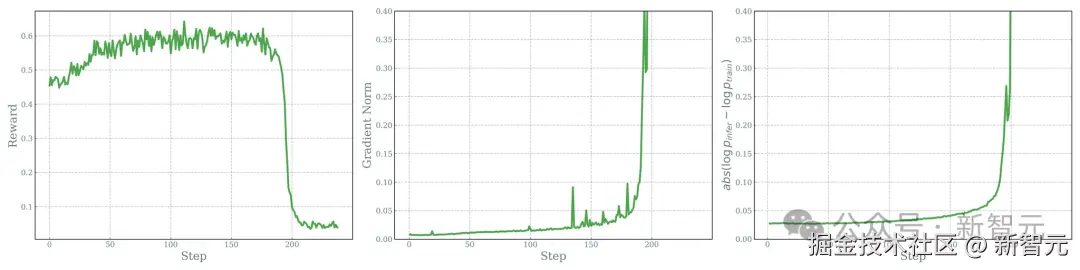

「MoE 长周期 RL 训练难?棒冰保驾护航」

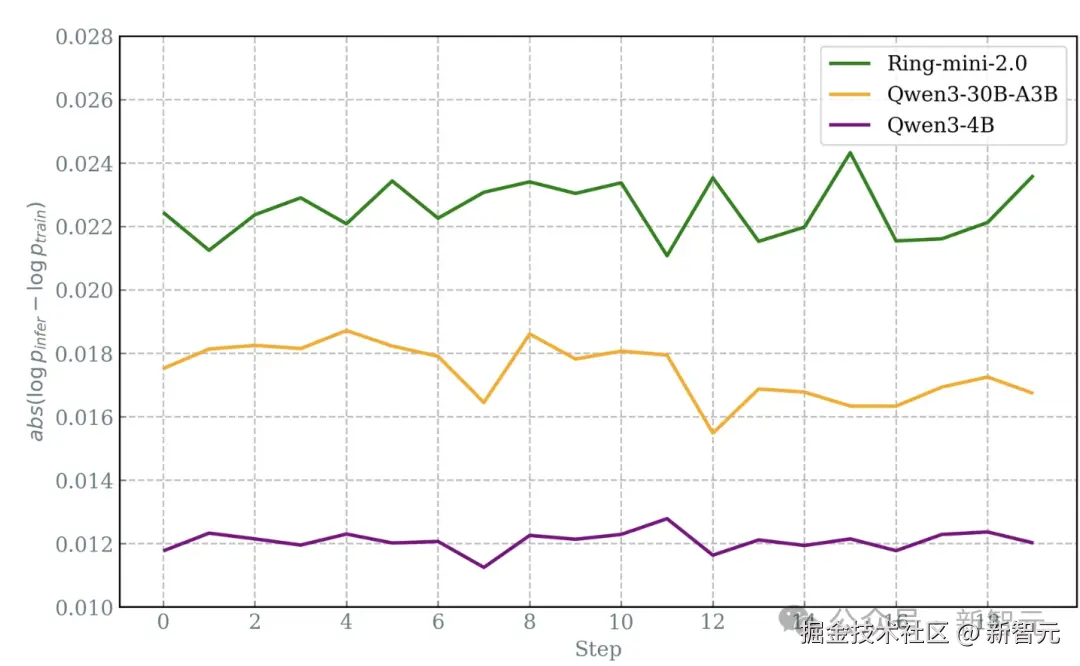

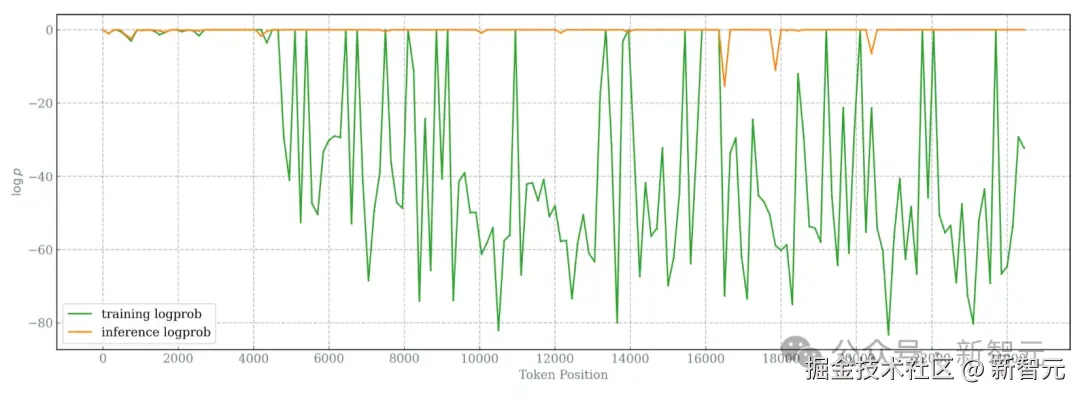

在模型 RL 训练中,MoE 模型相比 Dense 模型,训练和推理引擎之间的算子精度差异更为明显。

Qwen3-4B 为密集模型,Ring-mini-2.0 和 Qwen3-30B-A3B 是 MoE 模型

尤其是在生成长序列和长周期训练时,随着序列长度和训练步数的增加,这种差异会逐渐拉大。

实验观察到,在较少的训练步数内,原始的 GRPO 算法会开始崩溃,这对长周期、长序列的强化学习训练带来巨大挑战。

为了解决上述问题, 「IcePop 应运而生。」

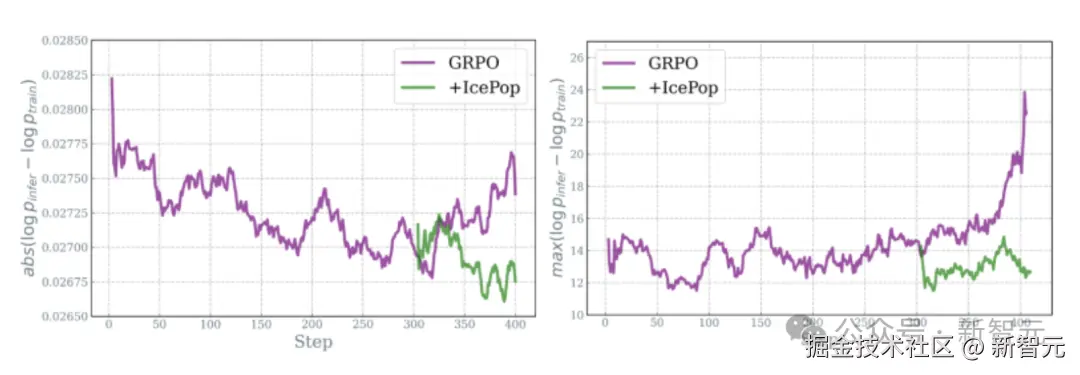

新方法简单而有效------采用「双向遮罩」(double-sided masking),减轻概率差异所带来的有害复合效应,从而仅保留健康的梯度更新。

- 「双向剪裁(Double-sided clipping)」:不仅在「训练概率 ≫ 推理概率」时进行剪裁,也在「训练概率 ≪ 推理概率」时进行剪裁。

- 「遮罩(Masking)」:当 token 的概率差异过大时,将其从梯度更新中移除。

没有这些措施,MoE 架构很可能无法稳定训练,其性能甚至可能不如稠密模型。

图左:GRPO 训推差异随着训练成指数上升,Icepop 较为平稳;图右:训推差异最大值,GRPO 随着训练上升非常明显,Icepop 维持在较低水位

与 GRPO 比, 「IcePop 让 RL 训练更平稳,为新一代万亿级思考****模型保驾护航。」

算法博客:ringtech.notion.site/icepop

而为应对万亿参数模型的强化学习训练,蚂蚁自研了高性能强化学习系统------「ASystem」。

「 」

」

「自研 RL 框架 ASystem,平稳 Scaling 到万亿规模」

ASystem 采用 「SingleController + SPMD」 架构。

针对万亿参数模型的显存管理和训推权重交换问题,蚂蚁相关团队精心优化了训推引擎。

显存透明卸载、跨节点显存池化等技术,有效释放了被占用的显存碎片,降低了显存不足风险。

GPU 间 P2P 直接通信与原地更新等技术,可秒级、零冗余交换模型权重。

在 RL 训练框架上,团队构建了基于**「大规模 Serverless Sandbox 技术」**的混合奖励系统。

该系统能以毫秒级速度启动、提供超过 10 余种语言的沙箱执行环境,支撑了高达 10K/s 的请求吞吐。

为了推动大规模推理与智能体模型发展,蚂蚁联合清华开源了全异步强化学习训练系统 AReaL。

开源链接:github.com/inclusionAI...

AreaL 的三大亮点:

⚡ 灵活性:只需一个文件,就能轻松自定义多轮 rollout 工作流程,还能顺畅整合其他智能体工具框架。

🚀 可扩展性:通过算法与系统的协同设计,AReaL 提供稳定且完全异步的 RL 训练,速度领先行业。它能轻松适应各种计算环境,从单个节点扩展到 1000 + 块 GPU。

🔪 顶尖性能:AReaL 能生成最先进的数学、编程和搜索智能体,具有超强能力。

「蚂蚁百灵团队」

「首试万亿思考模型」

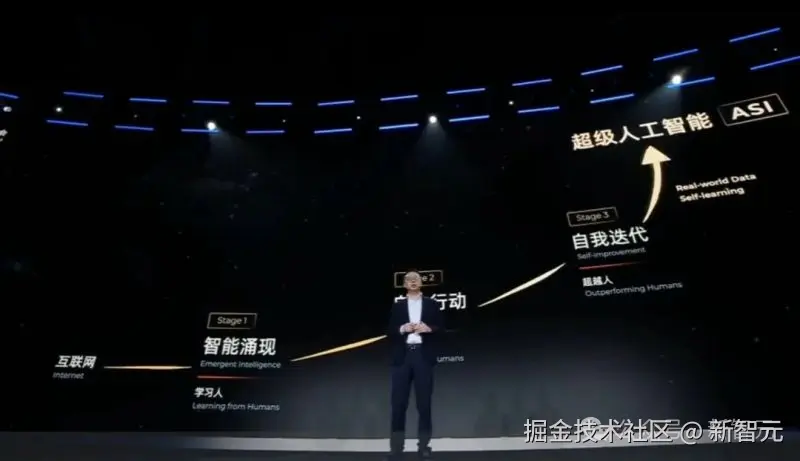

AGI 不是梦想,而是指日可待的确定性事件!

诺奖得主、Google DeepMind 首席执行官 Demis Hassabis,OpenAI 联合创始人兼 CEO Sam Altman,阿里云 CEO 吴泳铭均表示:

AGI is coming.

上下滑动查看

宏伟愿景背后,是技术人的上下求索、不断创新。

Ring-1T 的发布,标志着蚂蚁百灵团队实现了从百亿(Ring-mini-2.0)到千亿(Ring-flash-2.0)再到万亿(Ring-1T)的 「MoE 架构 「「强化学习」 」平稳扩展。」

而 Ring-1T 的**「训练仍在进行中」**,蚂蚁将继续挖掘这一万亿基座的潜力。

据了解,截至目前蚂蚁百灵大模型已经发布 18 款模型,其中两款万亿参数模型---万亿参数通用大语言模型 Ling-1T、万亿参数思考模型 Ring-1T。

随着两款万亿参数模型的发布,百灵大模型也正式步入 2.0 阶段。

目前模型仍存在一定概率的**「身份认知偏差」、 「语种混杂」及「重复生成」**等问题.

同时,由于 Ling 2.0 的 GQA 方案,长上下文场景下的推理效率仍待改进。

而开源夺冠证明了「思考力」可以被工程化与规模化,算力红利正向「推理红利」迁移。

蚂蚁以 IcePop、ASystem、AReaL 给出了一条可复制的路线:从模型到系统到社区。这不是单点突破,而是范式的组织化落地。

参考资料: